01Wang a publié le modèle Yi-Large à 100 milliards de paramètres, Kai-fu Lee : les grands modèles chinois ont rattrapé les États-Unis et sont déterminés à rivaliser avec le GPT-5

Au bout d'un an, Kai-Fu Lee sort à nouveau du cercle avec "Zero One Thousand Things".

En mai de l'année dernière, Zero One Thing a été créée et, six mois plus tard, elle a lancé sa première série de modèles Yi bilingue chinois-anglais. Dès le début, Kai-Fu Lee s'est fixé un objectif ambitieux et difficile : « devenir le numéro 1 mondial ».

Lingyiwuwu, qui est un « poulet chaud populaire » depuis sa naissance, s'est également appuyé sur une équipe issue d'une grande entreprise et d'excellentes performances de modèle pour atteindre une valorisation de 1 milliard de dollars.

Aujourd'hui, ils proposent leur deuxième produit : le modèle à source fermée Yi-Large .

Attaquer le modèle SOTA global

En novembre de l'année dernière, le Yi-34B publié par Lingyiwuwu s'est classé sur la liste Hugging Face avec sa taille « de niveau dessert » dans la communauté open source, dépassant des modèles plusieurs fois plus grands tels que le Llama2-70B et le Falcon-180B, et est devenu le le plus grand modèle au monde à l'époque. L'un des modèles de base open source internes les plus solides.

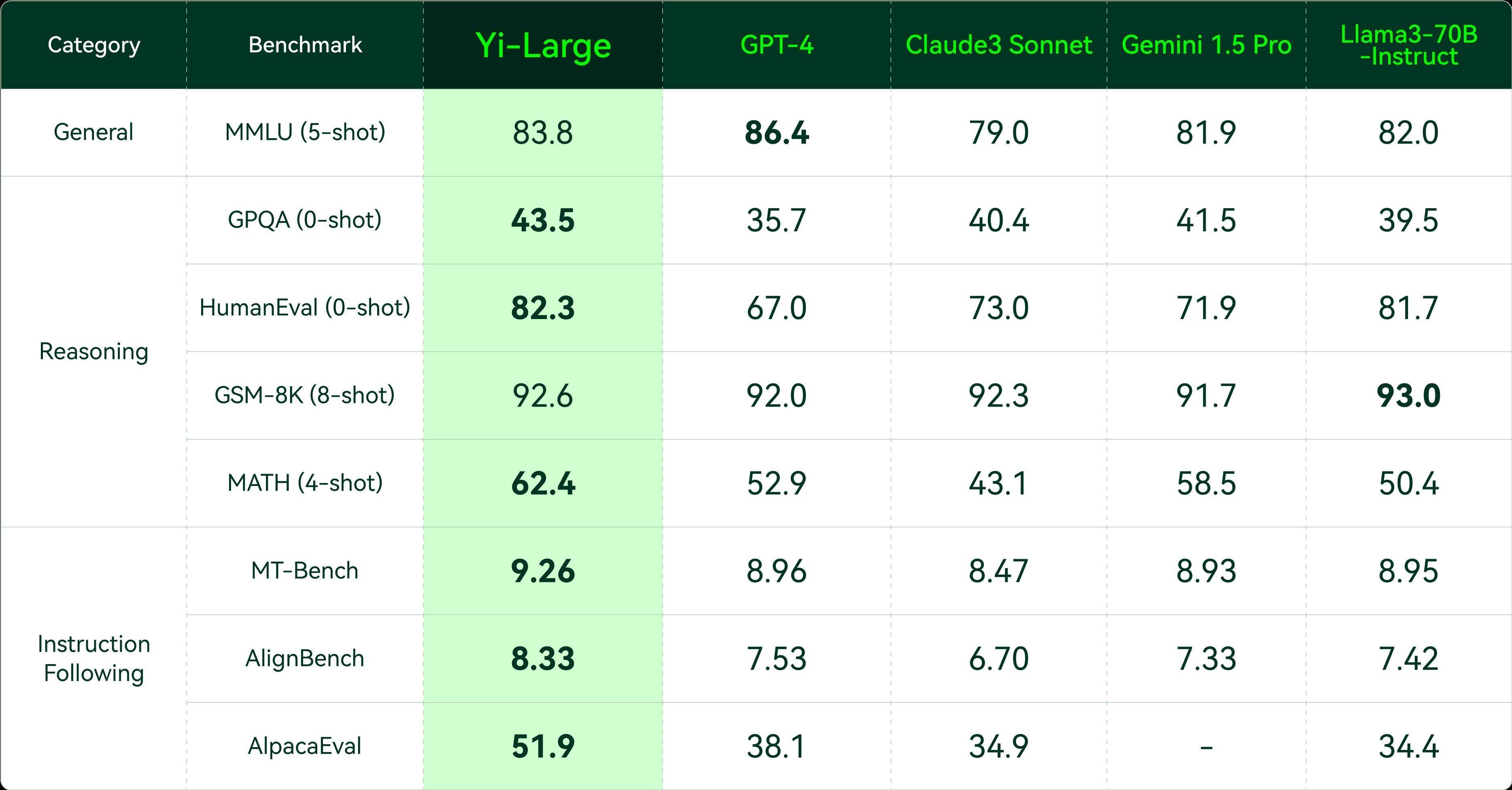

Six mois plus tard, 01Wang a officiellement lancé Yi-Large avec une échelle de paramètres de 100 milliards. Lors d'une évaluation tierce faisant autorité, le modèle 01Wanyi Yi a obtenu de bons résultats dans le PK bilingue chinois et anglais des principaux grands modèles mondiaux.

Dans le dernier classement des modèles officiellement certifiés d'AlpacaEval 2.0, une agence d'évaluation de Stanford, le principal indicateur de maîtrise de l'anglais du modèle Yi-Large, LC Win Rate (qui contrôle la longueur de la réponse), se classe au deuxième rang mondial, juste derrière GPT. -4 Turbo, Win Rate se classe même au premier rang mondial.

Auparavant, seuls Yi et Qwen parmi les modèles nationaux figuraient dans le top 20 de cette liste.

Une condition préalable importante pour utiliser intelligemment un grand modèle est qu’il sache de quoi vous parlez.

Les modèles étrangers ont d'excellentes performances, mais ils sont tous basés sur le contexte anglais. Cependant, les grands modèles nationaux nés dans le pays ont des avantages uniques dans la compréhension du chinois.

En termes de maîtrise de la langue chinoise, dans le rapport de référence d'avril mis à jour par SuperCLUE, Yi-Large s'est également classé premier parmi les grands modèles nationaux. Les capacités bilingues complètes en chinois et en anglais de Yi-Large ont démontré d'excellentes performances.

Dans une évaluation plus complète des capacités des grands modèles, Yi-Large a surpassé des modèles similaires tels que GPT4, Claude3 et Google Gemini 1.5 dans la plupart des indicateurs, atteignant la première place. Il a obtenu de meilleurs résultats que les leaders mondiaux en matière de capacités générales, de génération de codes, de raisonnement mathématique et de suivi des instructions, et s'est fermement classé parmi les premiers échelons au monde.

Alors que les capacités des grands modèles de chaque entreprise entrent dans une nouvelle étape de comparaison avec GPT4, l'évaluation des grands modèles a également commencé à se déplacer des simples capacités générales vers des capacités de raisonnement complexes telles que les mathématiques et le codage.

Yi-Large a également obtenu des résultats éblouissants sur des ensembles d'évaluation tels que HumanEval pour les capacités de génération de code, GSM-8K et MATH pour les capacités de raisonnement mathématique et GPQA pour les capacités d'experts du domaine.

En outre, du point de vue de la mise en œuvre industrielle, la compréhension des instructions humaines et l'alignement des préférences humaines sont devenus des capacités indispensables pour les grands modèles, et les évaluations liées au suivi des instructions (Instruction Follow) sont de plus en plus appréciées par les grandes entreprises modèles mondiales.

MT-bench lancé par le projet d'évaluation open source de Stanford AlpacaEval et Berkeley LM-SYS sont deux ensembles d'ensembles d'évaluation de conformité aux instructions en anglais, et AlignBench est un benchmark d'évaluation d'alignement chinois lancé par l'équipe de l'Université Tsinghua.

Dans l'ensemble d'évaluation des instructions faisant autorité au pays et à l'étranger, Yi-Large a obtenu de meilleurs résultats que les cinq meilleurs modèles internationaux.

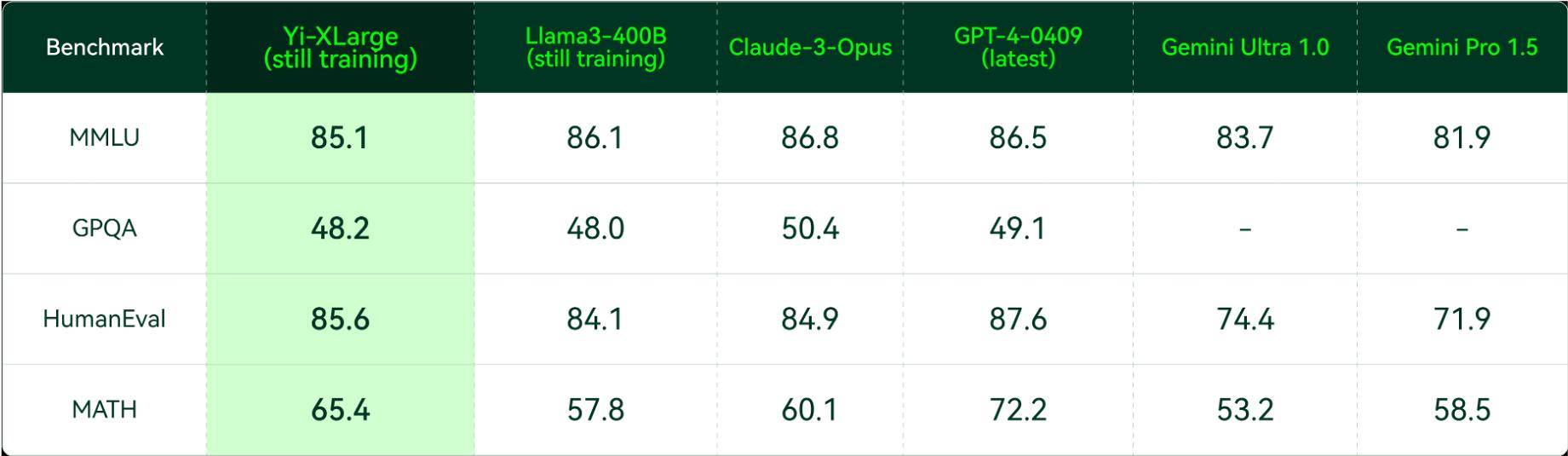

Lors de la conférence de presse, Kai-fu Lee a également annoncé que Zero One Wish avait lancé la prochaine génération de formation sur le modèle Yi-XLarge MoE, qui aura un impact sur les performances et l'innovation du GPT-5.

Dans le même temps, Zero One Thousand Things examine également des questions très complexes. Kaifu Lee a résumé trois points clés :

- D’une part, nous devons nous préparer aux progrès de la technologie et aux types de modèles que nous pouvons produire ;

- Deuxièmement, comment minimiser le coût du raisonnement et enflammer le point de l’inclusivité ;

- Troisièmement, il existe un PMF traditionnel pour répondre aux besoins des utilisateurs.

Kai-Fu Lee a déclaré que ces considérations sont quelque chose qu'ils ne voient généralement pas dans les entreprises de la Silicon Valley :

C'est notre approche unique et une opportunité pour les licornes chinoises.

Yi-1.5 est entièrement mis à niveau et la plateforme API est lancée à l'échelle mondiale.

Lors de cette conférence de presse, la série Yi de modèles open source a également reçu une mise à niveau complète. Yi-1.5 est divisé en trois versions : 34B, 9B et 6B, et le modèle de réglage fin Yi-1.5-Chat est fourni aux développeurs. choisissez parmi.

À en juger par les données d'évaluation, la série Yi-1.5 poursuit les performances exceptionnelles des modèles open source de la série Yi. Tandis que la logique mathématique et les capacités de codage sont considérablement améliorées, les capacités linguistiques maintiennent également le niveau élevé d'origine.

Après un réglage fin, Yi-1.5-6B/9B/34B-Chat s'est amélioré à un niveau supérieur en termes de raisonnement mathématique, de capacité de codage et de suivi des instructions.

Les performances de Yi-1.5-6B/9B-Chat sur les ensembles d'évaluation des capacités mathématiques tels que GSM-8K et MATH, et les ensembles d'évaluation des capacités de code tels que HumanEval et MBPP sont loin d'être les mêmes que celles du modèle au niveau des paramètres, et sont également mieux que le Llama-3-8B -Instruct récemment publié.

Les scores sur MT-Bench, AlignBench et AlpacaEval occupent également la première place parmi les modèles avec la même ampleur de paramètre.

L'année dernière, Zero One Wanwan a choisi de lancer le modèle de la série Yi en open source, et ses excellentes performances ont été hautement reconnues par les développeurs internationaux.

Au cours du premier mois qui a suivi le lancement de la version open source de Yi en novembre 2023, elle occupait près de 50 % des classements des modèles populaires dans la communauté open source. Un mois après sa sortie, le Yi-34B a été inclus dans le grand terrain de jeu des modèles de Nvidia.

Kai-fu Lee a également ses propres idées pour résoudre des problèmes tels que le développement de grands modèles et la mise en œuvre de produits.

Dans une interview avec APPSO, Kai-fu Lee a déclaré :

Nous sommes des partisans pragmatiques de l’AGI. Nous devons utiliser le moins de puces et le coût le plus bas possible pour former le meilleur modèle possible. En parallèle, nous continuerons à explorer et à trouver TC-PMF. Par rapport aux entreprises de la Silicon Valley, la différence entre les start-up nationales est que nous pouvons regarder les étoiles, mais nous pouvons aussi garder les pieds sur terre.

La seule pensée selon laquelle tout ne produira pas de miracles avec la force pure est de se demander si cela peut utiliser dix ou cent milliards de dollars américains. OPEN AI est qualifié pour essayer cette voie, mais ce n'est pas la voie qu'ils veulent emprunter. Bien sûr, ils ne prendront pas le temps de prédire le point d'allumage de l'AGI, mais il peut dire à tout le monde avec certitude que la chose la plus pertinente est de le faire. c'est le point d'AI Pratt & Whitney.

Aujourd'hui, Lingyiwanwu a également annoncé avoir publié plusieurs modèles d'interfaces API, notamment Yi-Large, Yi-Large-Turbo, Yi-Medium, Yi-Medium-200K, Yi-Vision, Yi-Spark, etc., pour le marché intérieur en même temps. À l'heure actuelle, le site anglais de Yi API Platform est ouvert aux développeurs du monde entier pour des applications d'essai simultanées.

Parmi eux, l'API Yi-Large avec une échelle de paramètres de 100 milliards a des performances de génération de texte et de raisonnement superbes, et convient au raisonnement complexe, à la prédiction, à la création de contenu en profondeur et à d'autres scénarios ;

L'API Yi-Large-Turbo est équilibrée et réglée avec une grande précision en fonction des performances, de la vitesse d'inférence et du coût, et convient à tous les scénarios, à l'inférence de haute qualité et à la génération de texte.

L'avantage de l'API Yi-Medium réside dans la capacité de suivre des instructions, ce qui convient au chat, au dialogue, à la traduction et à d'autres scénarios dans des scénarios réguliers ;

Si vous avez besoin d'applications liées à des documents au contenu ultra long, vous pouvez également choisir l'API Yi-Medium-200K, qui peut interpréter 200 000 mots de texte à la fois ;

L'API Yi-Vision possède des capacités de compréhension et d'analyse d'images hautes performances, et peut servir de chat, d'analyse et d'autres scénarios basés sur des images ;

L'API Yi-Spark se concentre sur une réponse légère et extrêmement rapide et convient à l'analyse mathématique légère, à la génération de code, au chat textuel et à d'autres scénarios.

Plus important encore, il existe déjà des applications pratiques, et le « Petit Pancréas », conçu pour les patients atteints de tumeurs pancréatiques, en fait partie.

L'assistant Xiaoyibao AI peut présenter des connaissances complètes sur le traitement aux patients 24 heures sur 24, 7 jours sur 7.

Le support technique derrière cet assistant est le modèle Yi de Zero One Thing. Après avoir utilisé l'API Yi pour appeler le grand modèle d'IA, Xiaoweibao franchit la barrière de l'information du traitement des tumeurs pancréatiques et peut présenter avec précision et systématiquement la feuille de route et le plan de traitement du cancer du pancréas aux patients atteints d'une tumeur pancréatique.

Actuellement, ce projet caritatif a aidé plus de 3 000 patients atteints d'une tumeur pancréatique.

Plateforme de travail à guichet unique

La conférence de presse d'aujourd'hui a également présenté « Wanzhi », une station de travail d'IA à guichet unique récemment lancée par Zero One Wagon.

Selon l'introduction officielle, Wanzhi est une plate-forme de travail d'IA unique spécialement conçue pour les utilisateurs chinois. Elle peut rédiger des procès-verbaux de réunions, des rapports hebdomadaires, des assistants de rédaction, interpréter des rapports financiers, des documents et créer des PPT. et est totalement gratuit.

Actuellement, les utilisateurs peuvent se connecter pour en faire l'expérience via le site officiel et l'applet WeChat « Wanzhi AI ».

Lors de la conférence de presse, les responsables de Wanzhi ont donné un exemple très pratique :

Vous venez d'arriver en bas dans l'entreprise et votre chef vous demande soudainement de faire une présentation lors d'une réunion, mais l'ordinateur n'est pas là. Maintenant, via Wanzhi, entrez le sujet que vous souhaitez présenter sur votre téléphone portable, puis attendez les deux. minutes qu'il vous faut pour passer de l'ascenseur à votre poste de travail. PPT Cela a été fait sur la page Web de Wanzhi. Après cela, il vous suffit de faire quelques simples textes, images et modifications pour l'utiliser directement.

De plus, Wanzhi a de nombreuses autres fonctions.

Le premier est la capacité de lecture de documents. Wanzhi AI Assistant peut lire et comprendre rapidement une grande quantité de contenu de documents, y compris des documents longs et des données financières complexes. Il peut extraire des informations clés en quelques secondes et prend en charge la lecture bilingue en chinois et en anglais.

Deuxièmement, dans les scénarios généraux de questions et réponses, Wanzhi a également démontré d'excellentes performances de produit, étant capable de donner rapidement des réponses appropriées et de fournir des commentaires professionnels et rapides.

De plus, Wanzhi AI Assistant prend non seulement en charge la sortie de texte, mais peut également afficher des informations sous diverses formes telles que des tableaux, des formules, des codes, etc., rendant les rapports de travail et la planification de vie plus clairs.

Enfin, Wanzhi AI Assistant peut accéder aux informations Internet en temps réel, garantissant ainsi que les données et les informations obtenues par les utilisateurs sont les plus récentes et les plus précises.

Selon les recherches et observations de l'équipe Wanzhi, l'efficacité du travail personnel a augmenté de plus de 50 % en moyenne après l'utilisation de Wanzhi, notamment en termes de récupération de connaissances, de conception et de rédaction de documents, etc., ce qui permet un gain de temps important.

Actuellement, Wanzhi AI Assistant est entièrement gratuit et ouvert aux utilisateurs.

Les responsables de Wanzhi ont déclaré que l'application de grands modèles similaires deviendra certainement un point d'atterrissage important en Chine cette année.

Kai-Fu Lee a également mentionné que cette année sera la première année des outils de productivité de l'IA, car certains domaines vont exploser cette année.

Il pense que la vraie valeur d'AI-Frist est de savoir qui construira une AI Douyin, une AI WeChat et une AI Taobao ? Zero One espère qu’ils auront le potentiel de servir d’allumeur.

Cependant, le point d'inclusion de l'ensemble de l'IA n'arrivera pas en même temps et les exigences d'application dans certains domaines seront très élevées.

Par exemple, avec les outils de productivité que nous créons actuellement, l'utilisateur est en fin de compte responsable du contenu produit par l'outil de productivité. Donc, s'il contient des erreurs qui ne sont pas parfaites, qui nécessitent un réglage précis ou même une petite quantité d'illusion, c'est l'utilisateur qui décide finalement s'il peut être modifié. L'indicateur de l'utilisateur est donc de savoir si je peux produire un meilleur contenu. plus rapidement que sans cet outil.

Kai-Fu Lee a déclaré que TC-PMF y est parvenu, mais qu'il peut être meilleur, donc cela se produira certainement dans les outils de productivité cette année.

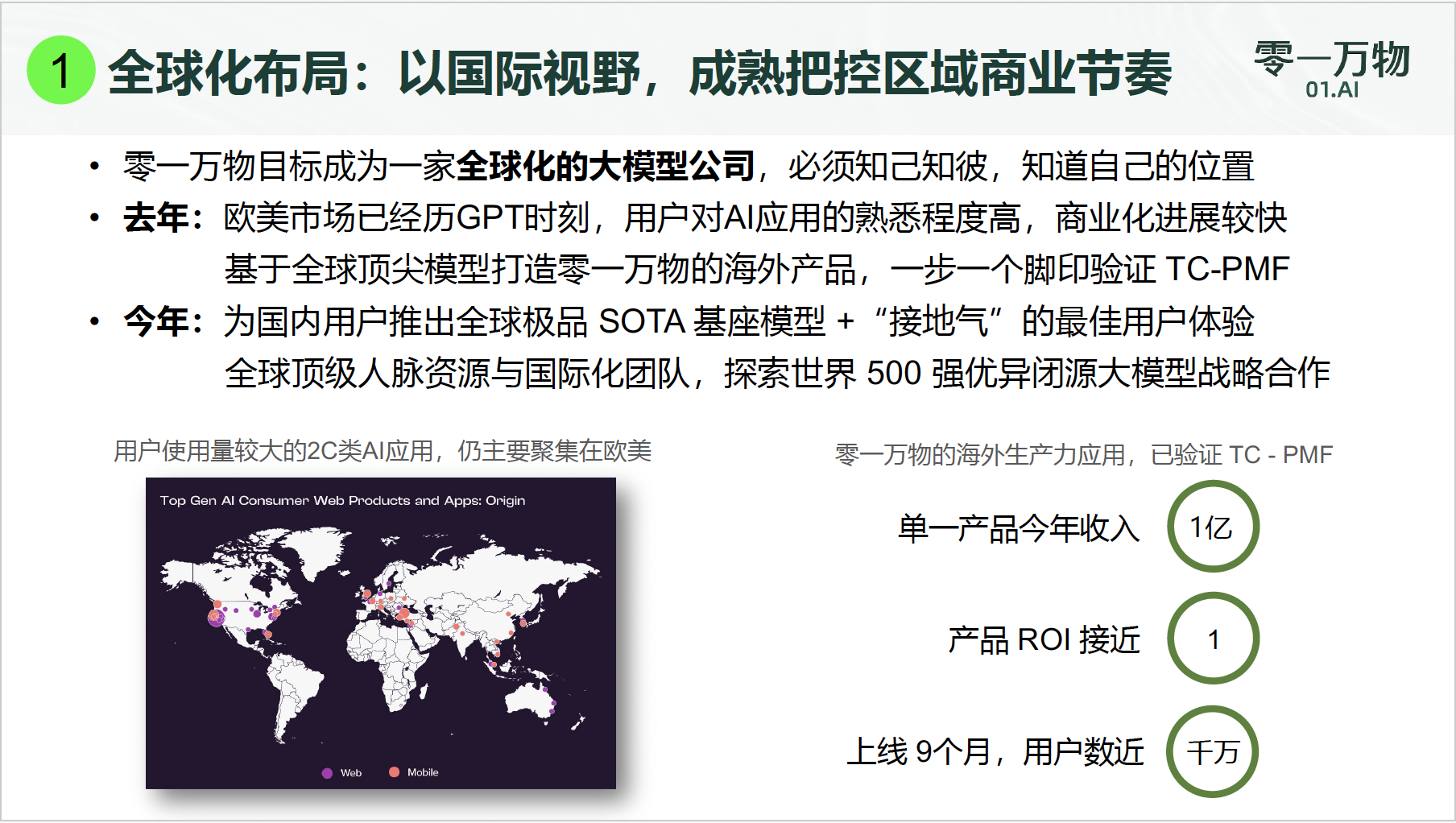

À l'heure actuelle, le nombre total d'utilisateurs d'applications de productivité à l'étranger de Zero One Thousand Things est proche de 10 millions, et les revenus d'un seul produit ToC ont atteint cette année 100 millions de yuans.

Kai-Fu Lee a révélé :

Notre ROI est toujours autour de 1. De tels résultats sont donc très avantageux, du moins du point de vue des grandes entreprises modèles nationales.

Au début de 2023, alors que le domaine des grands modèles nationaux est dans une mêlée, diverses listes d'évaluation sont écrasantes, et peu de modèles figurent en tête de chaque liste majeure.

À l'ère de l'IA 1.0, l'intelligence artificielle n'a pas encore démontré de grandes capacités de généralisation et d'émergence, et le modèle de déploiement privatisé pour les principaux clients est devenu courant. Cependant, le temps a prouvé que les revenus générés par le modèle de livraison lourde axé sur les projets sont là. constitue une limite supérieure à la croissance et les défis en matière de durabilité sont graves.

Aujourd'hui, nous sommes dans l'ère de l'IA 2.0 et l'intelligence artificielle est entrée dans une nouvelle étape de développement. Par rapport à la version 1.0, l'IA 2.0 marque un saut du traitement automatisé basé sur des règles à l'apprentissage en profondeur et aux capacités d'apprentissage autonome.

De ce point de vue, la « Bataille des Cent Régiments » dans le domaine de l'IA ne fera que s'intensifier.

Depuis l'année dernière, de plus en plus de grands modèles produits dans le pays se sont démarqués d'une concurrence féroce et ont également obtenu des résultats impressionnants dans des listes mondiales bien connues.

Cette année, l'industrie entrera dans une phase de mise en œuvre commerciale plus réaliste et les utilisateurs voteront avec leurs pieds en fonction des capacités démontrées du côté des applications. Comment améliorer autant que possible l'effet de l'application en fonction des capacités du modèle de base est une question importante pour rattraper TC-PMF.

Kai-Fu Lee a dit :

Il y a un an, les grands modèles chinois se sentaient trop en retard (par rapport aux États-Unis). Mais aujourd'hui, nous sommes très fiers de dire que nous sommes fous depuis un an et qu'en termes de modèles, nous avons au moins rattrapé les meilleurs produits (grands modèles) aux États-Unis sortis il y a un an. , nous continuerons à travailler dur à l'avenir. Cependant, nous avons besoin de précipitation et de perspectives d’avenir, et nous ne pouvons pas nous précipiter comme des fous.

À l'ère de l'IA où les vagues derrière le fleuve Yangtze poussent les vagues en avant, la plus grande importance pour les utilisateurs est de connaître l'IA, de comprendre l'IA, d'utiliser l'IA et même de l'amener au travail, aux études et à la vie dans la compétition entre les fabricants.

Et c’est aussi l’intention et la destination originales de la technologie de l’IA.

*Fu Liqun a également contribué à cet article

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo