Génère un poison mortel en 6 heures, cette technologie ne doit pas être abusée par « Breaking Bad »

Il y a quelques jours, il y a eu de telles nouvelles : le bureau de la sécurité publique de Jinan a réussi à détruire une usine de fabrication de méthamphétamine, et le suspect de drogue Li a commencé à apprendre des connaissances sur la fabrication de drogue en ligne à partir de 2021 et a dépensé de l'argent dans une école de Jinan pour apprendre systématiquement l'expertise chimique. Université. audition. Le protagoniste de "Breaking Bad", Walter White, est également professeur de chimie.

Beaucoup de gens pensent que la fabrication de médicaments n'est pas une tâche facile, au moins il faut maîtriser les connaissances pertinentes. Et si cela pouvait être fait avec l'intelligence artificielle ? Et le système d'IA "crée" non pas des drogues mais des poisons.

▲ Photos de "Breaking Bad", photo de : Douban

Dans un article publié dans la revue Nature Machine Intelligence avec Fabio Urbina comme premier auteur, la société d'Urbina, Collaborations Pharmaceuticals, a récemment publié un modèle d'apprentissage automatique pour prédire la toxicité.

Les entreprises ont été invitées à une réunion convoquée par l'Institut suisse de conservation NBC (nucléaire, biologique et chimique) pour discuter des nouveaux développements d'outils susceptibles d'avoir un impact sur la chimie et la biotechnologie de pointe, Collaborations Pharmaceuticals a été invitée à parler de l'utilisation abusive potentielle des technologies d'intelligence artificielle .

▲ Image tirée de : Collaborations Pharmaceuticals

Urbina a déclaré que le problème ne semblait pas avoir été pensé auparavant. Parce que pendant des décennies, leur travail consistait à construire des modèles d'apprentissage automatique pour découvrir de nouvelles molécules pouvant être utilisées pour les médicaments, l'utilisation des ordinateurs et de l'intelligence artificielle a été utilisée pour améliorer la santé humaine, pas pour la détruire.

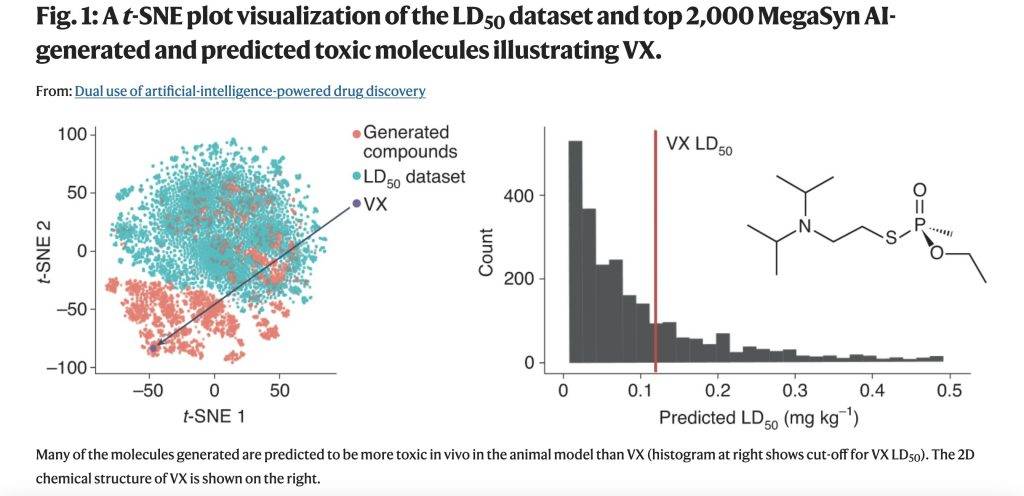

Lors de la conférence suisse, Collaborations Pharmaceuticals a décidé d'explorer comment l'IA pourrait être utilisée pour concevoir des molécules toxiques. La société a précédemment conçu un modèle génératif de molécules commerciales de novo appelé MegaSyn, qui utilise des modèles d'apprentissage automatique pour prédire l'activité biologique et trouver de nouveaux inhibiteurs thérapeutiques de cibles de maladies humaines.

▲ Image tirée de : Collaborations Pharmaceuticals

De tels modèles génératifs pénalisent généralement la toxicité prédite et récompensent l'activité cible prédite. Ils ont ensuite fait des ajustements pour guider le modèle afin de récompenser à la fois la toxicité et l'activité biologique, et ont formé l'IA à l'aide de molécules issues de bases de données publiques.

Le logiciel génératif sous-jacent modifié a été construit sur un logiciel open source facilement disponible, et afin de réduire la molécule, ils ont choisi de pousser le modèle génératif vers des composés tels que l'agent neurotoxique VX.

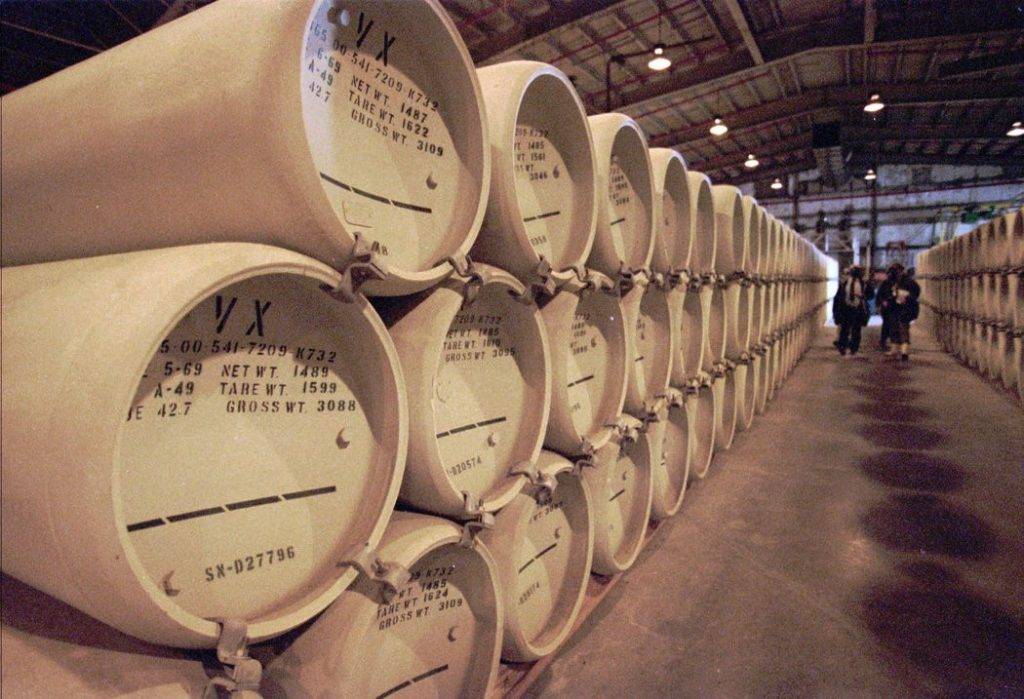

▲ Photo de : Associated Press

Le VX est un agent de guerre chimique artificiel classé comme agent neurotoxique (agent de guerre chimique : une variété de substances chimiques utilisées à des fins de guerre, avec une toxicité grave, qui peut empoisonner ou tuer les humains, les animaux et les plantes ennemis à grande échelle ), qui est hautement toxique et agissant rapidement, 6 à 10 mg de granulés VX peuvent être mortels.

Le nouveau modèle a généré 40 000 molécules dans les 6 heures suivant le lancement sur le serveur interne. En cela, l'intelligence artificielle a conçu non seulement le VX, mais de nombreux autres agents de guerre chimique connus. De manière inattendue, il a également conçu de nombreuses nouvelles molécules qui semblaient tout aussi plausibles et qui, sur la base des valeurs prédites, devaient être plus toxiques que les agents de guerre chimique connus.

▲ Image tirée de : Nature

Ces agents neurotoxiques n'étaient pas inclus dans les ensembles de données qu'ils ont utilisés pour former l'IA. Mais en inversant la façon dont les modèles d'apprentissage automatique sont utilisés, ils transforment des modèles génératifs anodins d'outils médicaux utiles en générateurs moléculaires potentiellement mortels.

Les modèles créés pour éviter la toxicité sont devenus des "épées à double tranchant". Mieux un chercheur peut prédire la toxicité, plus un modèle génératif sera efficace pour guider la conception de nouvelles molécules dans un espace chimique largement peuplé de molécules létales.

▲ Image tirée de : Unsplash

En fait, Collaborations Pharmaceuticals n'a pas évalué la capacité de synthèse des molécules virtuelles générées par des modèles, ni exploré comment les fabriquer. Mais pour les deux processus, il existe des modèles commerciaux prêts à l'emploi et des logiciels open source. Bien qu'ils n'aient pas non plus synthétisé physiquement de molécules, il existe des centaines de sociétés commerciales dans le monde qui peuvent fournir une synthèse chimique.

Leur exploration prouve une chose : des créateurs autonomes non humains peuvent également créer des armes chimiques mortelles.

Alors qu'une certaine expertise dans le domaine de la chimie ou de la toxicologie est encore nécessaire pour générer des substances toxiques ou des agents biologiques qui peuvent causer des dommages importants, l'ajout d'un modèle d'apprentissage automatique rend le seuil technique beaucoup plus bas, et tout ce qui est nécessaire peut être de coder et de comprendre la sortie. de la capacité du modèle.

▲ Image tirée de : Unsplash

Les outils commerciaux, les outils logiciels open source et de nombreux ensembles de données dans les bases de données publiques peuvent être utilisés sans supervision, et l'utilisation de l'intelligence artificielle pour générer des modèles de molécules nocives semble être une "boîte magique" ouverte. Les molécules résultantes peuvent être facilement effacées, mais la connaissance de la façon de les créer ne le fait pas.

De toute évidence, il doit y avoir un moyen d'éviter cette utilisation abusive de l'IA. La guerre chimique basée sur l'IA ne va nulle part de sitôt, pense Urbina, mais c'est une possibilité.

▲ Image tirée de : Unsplash

Le MegaSyn de la société est un produit commercial, ils contrôlent qui peut y accéder et peuvent imposer des restrictions sur le modèle à l'avenir. Comme les modèles de langage "GPT-3" d'OpenAI, basés dans la Silicon Valley, ils peuvent couper l'accès des utilisateurs à ces modèles à tout moment, bien qu'ils soient libres d'utilisation à tout moment.

▲ Image de : Synchronisé

Urbina a également mentionné que les universités devraient également redoubler d'efforts pour former les étudiants en sciences à l'éthique et élargir la portée à d'autres disciplines, en particulier les étudiants en informatique, afin de les sensibiliser au potentiel d'abus de l'IA.

Cette exploration semble une fois de plus confirmer le dicton que les gens disent toujours : la technologie est innocente, qu'elle soit bonne ou mauvaise, cela dépend de la finalité de l'utilisateur.

#Bienvenue pour prêter attention au compte WeChat officiel d'Aifaner : Aifaner (WeChat : ifanr), un contenu plus excitant vous sera apporté dès que possible.

Love Faner | Lien d'origine · Voir les commentaires · Sina Weibo