Une photo qui a failli détruire un père

Alors qu'il discutait au travail, Mark a été soudainement approché par la police.

Mark était soupçonné d'être un délinquant sexuel ciblant des enfants parce que son téléphone contenait une photo des organes sexuels d'un enfant. Et la police a découvert que cette photo venait en fait du fils de Mark…

Une image pervertie d'un pédophile commence probablement à s'accumuler dans votre esprit.

Ne vous précipitez pas pour vous fâcher, les choses se sont vite retournées. Il s'est avéré que cette photo a été prise après que le fils de Mark soit tombé malade, afin d'informer le médecin de son état, et Mark n'a jamais publié cette photo publiquement.

Alors, comment la police a-t-elle su que c'était le système d'intelligence artificielle de Google qui avait détecté les photos sur le téléphone Android de Mark, l'avait identifié comme suspect, l'avait signalé à la police et avait désactivé son compte Google.

Aux États-Unis, la popularité du seau familial de Google est à peu près équivalente à celle de WeChat, ce qui signifie que l'opération de Google tue directement Mark d'en ligne à hors ligne.

Ce qui est encore plus effrayant, c'est que, comme Mark, il y a bien plus d'une personne qui a été détectée par la plateforme comme des anomalies et signalée en passant.

Des photos de la consultation en ligne d'un enfant le conduisent à être identifié comme un criminel

L'enfant de Mark a développé une inflammation de l'aine en apprenant à marcher. En raison de la grave épidémie, la plupart des gens ont été mis en quarantaine à la maison à ce moment-là. Mark ne pouvait choisir que la consultation en ligne et fournir des photos de l'aine de l'enfant, essayant d'aider le médecin à établir un meilleur diagnostic. Le médecin a également prescrit la maladie en fonction de la description état et les photos montrées prescription.

Mais il y a un problème avec ces photos. Les photos du téléphone Android sont automatiquement synchronisées avec le cloud et le système Google reconnaît ces photos comme CSAM (Child Sexual Abuse Material).

Après avoir été identifié, l'utilisation d'Internet de Mark a été réduite de moitié car il a été bloqué. Gmail, la boîte aux lettres du compte que les utilisateurs utilisent pour se connecter à d'autres plateformes ; Google Fi, l'opérateur virtuel mobile de l'utilisateur, qui peut être utilisé pour passer des appels et surfer sur Internet ; Google Photos, qui n'est plus accessible, contient des photos de votre membres de la famille… Scellé. Parce que Google pense que vous êtes suspecté de crimes sexuels sur des enfants, il a bloqué votre compte et a appelé la police "pour vous" – après l'interdiction de la plateforme, un rapport a été soumis au National Center for Missing and Exploited Children (NCMEC), ce qui a déclenché la police enquête.

Dix mois plus tard, le père a été averti par le département de police de San Francisco, qui a mené une enquête complète sur lui sur la base d'un reportage photo fourni par Google.

Afin de mieux enquêter sur les agresseurs sexuels d'enfants potentiels, la police a également délivré un mandat de perquisition à Google pour toutes les informations sur le compte de Mark, les vidéos, les photos, les données de localisation, les rapports de recherche sur Internet, etc. Pour Mark, c'est vraiment une catastrophe, et si l'enquête policière était plus fanatique, j'ai bien peur que même le travail ne soit pas fait.

Heureusement, après une enquête minutieuse, la police a confirmé que le père n'avait commis aucun crime sexuel contre des enfants.

Le père est innocent, mais Google est rigide. Même fournir un rapport d'innocence prouvé par la police ne lui a pas permis de faire appel avec succès à Google pour récupérer son compte. Les informations photo qu'il a laissées sur son compte ont été complètement verrouillées et ne peuvent plus être vues. Tout ce que je peux voir, ce sont les rappels de Google –

Votre compte a été désactivé, car il contient du contenu préjudiciable qui enfreint gravement les règles de Google et peut être illégal.

Il est inutile de faire une demande de déblocage, vous ne pouvez que changer votre adresse mail, changer votre numéro de téléphone, et repartir de zéro dans le monde numérique. Le New York Times a fait état de deux utilisateurs ordinaires qui ont tous deux pris des photos des organes sexuels d'enfants pour les consultations en ligne de leurs enfants et ont été condamnés à des comptes illégaux. Jusqu'à aujourd'hui, ils n'ont pas pu récupérer leurs comptes.

Ils ne sont même pas exceptionnels. En 2021, Google a signalé 621 583 cas à la CyberTipLine du NCMEC (le Child Sexual Abuse Reporting Project). Le NCMEC a informé les forces de l'ordre locales de 4 260 victimes potentielles, demandant à la police d'aider à l'enquête et de secourir les enfants s'ils sont davantage blessés.

Cela ressemble à une bonne histoire de technologie pour arrêter et prévenir le crime à temps, mais lorsque cette liste comprend des mineurs qui demandent juste une consultation comme les enfants de Mark, c'est une triste histoire de "attrapez mille et attrapez un par erreur".

De tous les domaines d'enquête technique, la seule exception concerne les crimes sexuels sur des enfants

C'est juste que bien qu'il y ait une erreur, Google n'a évidemment pas l'intention de la changer. Non seulement il ne débloque pas les comptes d'utilisateurs innocents certifiés par la police, mais il n'a pas non plus l'intention d'arrêter ce mécanisme de censure défectueux.

La porte-parole de Google, Christa Muldoon, a déclaré : "Nous suivons la loi américaine pour définir ce qu'est un CSAM, et utilisons une combinaison de technologie de correspondance de hachage et d'intelligence artificielle pour l'identifier et le supprimer de notre plate-forme. Notre équipe d'experts en sécurité des enfants l'examinera. Le contenu est signalé pour son exactitude et les pédiatres sont consultés pour s'assurer que nous pouvons identifier les situations dans lesquelles les utilisateurs peuvent demander un avis médical.

Le problème est que l'équipe d'examen de Google n'a pas de formation médicale et ne consulte pas nécessairement un pédiatre spécialisé lors de l'examen de chaque cas. Par conséquent, on peut dire que l'erreur de jugement est inévitable dans ce processus. La seule chose qui peut réduire l'influence d'une telle erreur de jugement est le jugement des institutions professionnelles et l'examen secondaire des forces de l'ordre.

Mais pour ceux qui ont été mal jugés, c'est vraiment une catastrophe. À cause de cette erreur de jugement, votre compte important a été verrouillé ; à cause de cette erreur de jugement, vous avez fait l'objet d'une enquête de la police ; à cause de ces erreurs de jugement, les gens autour de vous peuvent également porter des lunettes teintées lorsqu'ils vous voient.

Jon Callas, directeur des programmes technologiques à l'Electronic Frontier Foundation EFF, a déclaré aux médias que l'approche de Google était intrusive. "C'est le cauchemar que nous craignons tous – ils vont scanner nos albums de famille et nous allons avoir des ennuis."

Mais ce n'est pas seulement un problème pour Google, car presque tous les géants de la technologie ont été inhabituellement agressifs en ce qui concerne le contenu CSAM. Comme Facebook et Google, Amazon dispose d'un mécanisme d'intelligence artificielle + examen humain. Il s'avère que les utilisateurs suspects suppriment ou désactivent les URL, les images et les fonctions de chat, le cas échéant, et interdisent sévèrement les comptes. En 2021, Amazon a également soumis 33 848 rapports CSAM au NCMEC . Quant à la vie privée, elle semble être ignorée dans cette histoire de crime de combat technologique.

Parmi les histoires de défense de la vie privée des utilisateurs, le refus d'Apple d'"aider au déverrouillage" est le plus impressionnant.

À cette époque, un grave attentat terroriste a eu lieu dans une institution sociale aux États-Unis et le meurtrier a été tué alors qu'il fuyait. Au cours de l'enquête, la police a découvert que le meurtrier communiquait avec le groupe extrémiste "État islamique" au Moyen-Orient par le biais d'une communication cryptée sur le téléphone portable, mais comme le téléphone portable avait un mot de passe, le tribunal ne pouvait que demander au fabricant d'iPhone Apple de aider le gouvernement à le débloquer. Mais Apple a annoncé publiquement son refus de se conformer à l'ordonnance, invoquant la protection de la vie privée des utilisateurs : « Si le gouvernement utilise le All Writs Act pour faciliter le déverrouillage de l'iPhone, il a la capacité de pirater l'appareil de n'importe qui et d'obtenir ses données, et le gouvernement le fera. Cette atteinte à la vie privée peut être étendue.

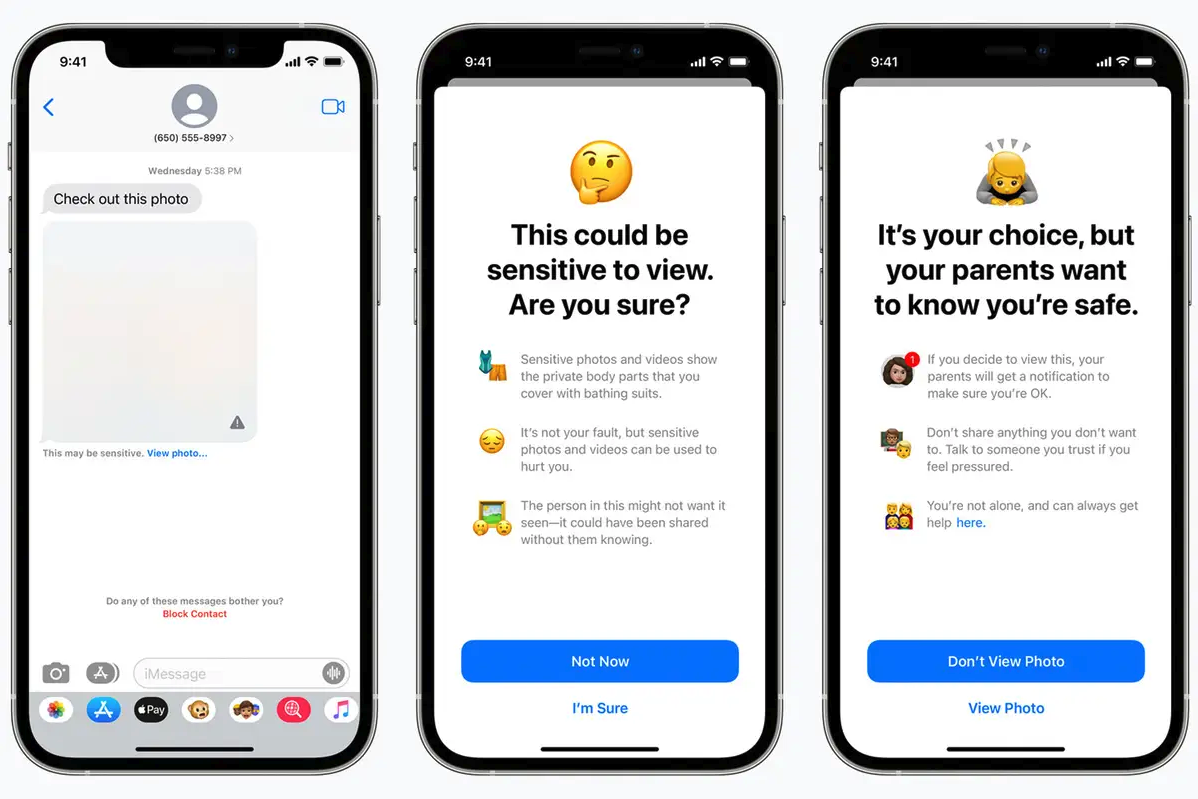

Mais même Apple, qui a justement refusé de déverrouiller les iPhones des utilisateurs, n'a pas été ébranlé dans le domaine des crimes sexuels contre les enfants. Comme Google, Apple a pensé à utiliser un nouvel outil pour numériser les photos iCloud d'un utilisateur, qui correspondrait à la base de données d'images existante du NCMEC, et si suffisamment d'images similaires étaient trouvées, elles seraient remises à un opérateur pour examen, ce qui informez ensuite le NCMEC.

Apple prévoyait également à l'époque d'introduire une nouvelle fonctionnalité iMessage conçue pour "alerter les enfants et leurs parents lorsque [les enfants] reçoivent ou envoient des photos sexuellement explicites". Les enfants de moins de 13 ans recevant ou envoyant des images avertiront leurs parents, et tous les enfants utilisateurs recevront également un avertissement lorsqu'ils sont sur le point de recevoir ou d'envoyer des images pornographiques suspectes.

Cette tendance au changement s'est arrêtée peu de temps après, car l'opposition était trop forte. L'EFF pense que le nouveau changement pourrait "ouvrir une porte dérobée à votre vie privée… moins, pas mieux, la confidentialité pour tous les utilisateurs d'iCloud Photos." Même Snowden a déclaré que "peu importe à quel point la pornographie juvénile peut être scannée , Numérisez n'importe quoi demain."

Apple a finalement mis de côté la section de numérisation d'images, mais a conservé la possibilité facultative d'inclure les comptes des enfants dans le plan de partage familial. Les parents peuvent activer de manière sélective la fonction d'analyse des images pour les images nues pour leurs enfants. Si une image nue est détectée, elle sera floue.

Même Apple souhaite ajouter la reconnaissance CSAM à ses propres produits, en grande partie parce qu'il s'agit d'une ligne rouge – que ce soit pour les utilisateurs ordinaires, les forces de l'ordre ou les plates-formes, ils ont une tolérance extrêmement faible à cet égard.

Cela signifie également que lorsque vous avez vraiment besoin de la coopération technique des entreprises technologiques, choisir de coopérer d'abord avec les affaires de crimes sexuels contre des enfants obtiendra plus de soutien public.

Une mise à jour de la loi britannique sur la sécurité en ligne prévoit d'obliger les fournisseurs de services d'utilisateur à utilisateur à s'efforcer de signaler tout contenu partagé d'exploitation et d'abus sexuels d'enfants à la National Crime Agency. L'amendement législatif indique clairement que les entreprises doivent développer un logiciel capable d'inspecter les informations, y compris les appels cryptés de bout en bout, afin de détecter de manière proactive le matériel pédophile et de le signaler aux autorités – sous peine de sanctions.

C'est juste que l'histoire de Google nous dit que même si cette fonction fonctionne bien, il y a un risque de "tuer par erreur", et chaque blessure par erreur causera du tort à des utilisateurs innocents. La technologie n'est peut-être pas en mesure de résoudre tous les problèmes, l'intelligence artificielle et les algorithmes que nous connaissons sont encore trop "simples" face à des problèmes sociaux difficiles, et il est difficile de s'appuyer sur une seule technologie pour détecter des délits potentiels ou existants. .

L'intervention de la technologie peut même apporter de nouveaux problèmes à l'environnement initialement difficile.Ce n'est pas nécessairement un bon résultat si l'intention initiale est bonne. Après tout, le chemin de l'enfer est parfois pavé de bonnes intentions.

L'image du titre provient de "Internet Purgatory: Expose Room N"

#Bienvenue pour prêter attention au compte WeChat officiel d'Aifaner : Aifaner (WeChat : ifanr), un contenu plus excitant vous sera apporté dès que possible.

Love Faner | Lien d'origine · Voir les commentaires · Sina Weibo