Non, ChatGPT ne va pas provoquer une autre pénurie de GPU

ChatGPT explose et l'épine dorsale de son modèle d'IA repose sur les cartes graphiques Nvidia. Un analyste a déclaré qu'environ 10 000 GPU Nvidia ont été utilisés pour former ChatGPT, et à mesure que le service continue de se développer, le besoin de GPU augmente également. Quiconque a vécu la montée en puissance de la crypto en 2021 peut sentir une pénurie de GPU à l'horizon.

J'ai vu quelques journalistes construire cette connexion exacte, mais c'est malavisé. L'époque des pénuries de GPU de type crypto est derrière nous. Bien que nous assistions probablement à une augmentation de la demande de cartes graphiques à mesure que l'IA continue de prospérer, cette demande n'est pas dirigée vers les meilleures cartes graphiques installées dans les plates-formes de jeu.

Pourquoi les GPU Nvidia sont conçus pour l'IA

Tout d'abord, nous expliquerons pourquoi les cartes graphiques Nvidia sont si bonnes pour l'IA. Nvidia a parié sur l'IA au cours des dernières années, et cela a porté ses fruits avec la flambée du cours de l'action de la société après la montée en puissance de ChatGPT. Il y a deux raisons pour lesquelles vous voyez Nvidia au cœur de la formation à l'IA : les cœurs tensoriels et CUDA.

CUDA est l'interface de programmation d'applications (API) de Nvidia utilisée dans tout, des GPU de centre de données les plus chers aux GPU de jeu les moins chers. L'accélération CUDA est prise en charge dans les bibliothèques d'apprentissage automatique telles que TensorFlow, ce qui accélère considérablement la formation et l'inférence. CUDA est le moteur du retard d'AMD en matière d'IA par rapport à Nvidia.

Cependant, ne confondez pas CUDA avec les cœurs CUDA de Nvidia. CUDA est la plate-forme sur laquelle une tonne d'applications d'IA s'exécutent, tandis que les cœurs CUDA ne sont que les cœurs des GPU Nvidia. Ils partagent un nom et les cœurs CUDA sont mieux optimisés pour exécuter des applications CUDA. Les GPU de jeu de Nvidia ont des cœurs CUDA et ils prennent en charge les applications CUDA.

Les cœurs Tensor sont essentiellement des cœurs AI dédiés. Ils gèrent la multiplication matricielle, qui est la sauce secrète qui accélère la formation à l'IA. L'idée ici est simple. Multipliez plusieurs ensembles de données à la fois et entraînez des modèles d'IA de manière exponentielle plus rapidement en générant des résultats possibles. La plupart des processeurs gèrent les tâches de manière linéaire, tandis que les cœurs Tensor peuvent générer rapidement des scénarios en un seul cycle d'horloge.

Encore une fois, les GPU de jeu de Nvidia comme le RTX 4080 ont des cœurs Tensor (et parfois même plus que des GPU de centre de données coûteux). Cependant, pour toutes les spécifications que les cartes Nvidia doivent accélérer les modèles d'IA, aucune d'entre elles n'est aussi importante que la mémoire. Et les GPU de jeu de Nvidia n'ont pas beaucoup de mémoire.

Tout se résume à la mémoire

"La taille de la mémoire est le plus important", selon Jeffrey Heaton, auteur de plusieurs livres sur l'intelligence artificielle et professeur à l'Université de Washington à St. Louis. "Si vous n'avez pas assez de RAM GPU, l'ajustement/l'inférence de votre modèle s'arrête simplement."

Heaton, qui a une chaîne YouTube dédiée au bon fonctionnement des modèles d'IA sur certains GPU, a noté que les cœurs CUDA sont également importants, mais la capacité de mémoire est le facteur dominant en ce qui concerne le fonctionnement d'un GPU pour l'IA. Le RTX 4090 a beaucoup de mémoire selon les normes de jeu – 24 Go de GDDR6X – mais très peu par rapport à un GPU de classe centre de données. Par exemple, le dernier GPU H100 de Nvidia dispose de 80 Go de mémoire HBM3, ainsi que d'un énorme bus mémoire de 5 120 bits.

Vous pouvez vous débrouiller avec moins, mais vous avez toujours besoin de beaucoup de mémoire. Heaton recommande aux débutants d'avoir au moins 12 Go, tandis qu'un ingénieur en apprentissage automatique typique aura un ou deux GPU Nvidia professionnels de 48 Go. Selon Heaton, "la plupart des charges de travail tomberont davantage dans la gamme A100 simple à huit A100". Le GPU A100 de Nvidia dispose de 40 Go de mémoire.

Vous pouvez également voir cette mise à l'échelle en action. Puget Systems montre un seul A100 avec 40 Go de mémoire fonctionnant environ deux fois plus vite qu'un seul RTX 3090 avec ses 24 Go de mémoire. Et cela malgré le fait que le RTX 3090 a presque deux fois plus de cœurs CUDA et presque autant de cœurs Tensor.

La mémoire est le goulot d'étranglement, pas la puissance de traitement brute. En effet, la formation de modèles d'IA repose sur de grands ensembles de données, et plus vous pouvez stocker de données en mémoire, plus vous pouvez former un modèle rapidement (et avec plus de précision).

Différents besoins, différentes filières

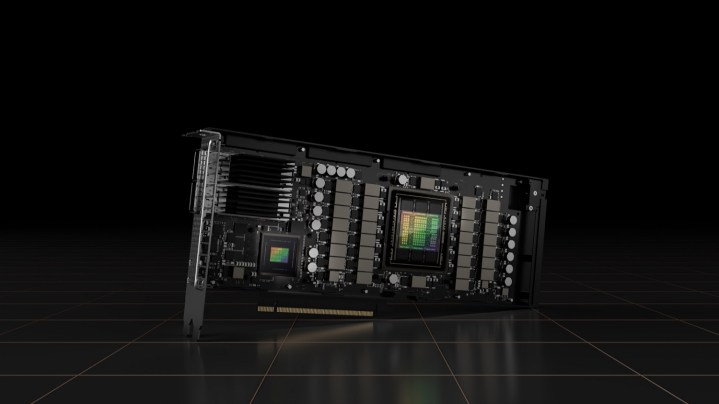

Les GPU de jeu de Nvidia ne conviennent généralement pas à l'IA en raison du peu de mémoire vidéo dont ils disposent par rapport au matériel de niveau entreprise, mais il y a aussi un problème distinct ici. Les GPU de station de travail de Nvidia ne partagent généralement pas de puce GPU avec ses cartes de jeu.

Par exemple, l'A100 auquel Heaton fait référence utilise le GPU GA100, qui est un dé de la gamme Ampere de Nvidia qui n'a jamais été utilisé sur les cartes axées sur les jeux (y compris le RTX 3090 Ti haut de gamme). De même, le dernier H100 de Nvidia utilise une architecture complètement différente de celle de la série RTX 40, ce qui signifie qu'il utilise également une matrice différente.

Il y a des exceptions. Le GPU AD102 de Nvidia, qui se trouve à l'intérieur des RTX 4090 et RTX 4080, est également utilisé dans une petite gamme de GPU d'entreprise Ada Lovelace (les L40 et RTX 6000). Dans la plupart des cas, cependant, Nvidia ne peut pas simplement réutiliser une puce GPU de jeu pour une carte de centre de données. Ce sont des mondes séparés.

Il existe des différences fondamentales entre la pénurie de GPU que nous avons constatée en raison de la crypto-extraction et la popularité croissante des modèles d'IA. Selon Heaton, le modèle GPT-3 nécessitait plus de 1 000 GPU A100 Nvidia pour les trains et environ huit pour fonctionner. Ces GPU ont également accès à l'interconnexion NVLink à large bande passante, contrairement aux GPU RTX série 40 de Nvidia. Il compare un maximum de 24 Go de mémoire sur les cartes de jeu de Nvidia à plusieurs centaines sur des GPU comme l'A100 avec NVLink.

Il existe d'autres problèmes, tels que les matrices de mémoire allouées aux GPU professionnels plutôt qu'aux GPU de jeu, mais les jours où vous vous précipitiez vers votre Micro Center local ou Best Buy pour avoir la chance de trouver un GPU en stock sont révolus. Heaton a bien résumé ce point : "On estime que les grands modèles de langage, tels que ChatGPT, nécessitent au moins huit GPU pour fonctionner. Ces estimations supposent les GPU A100 haut de gamme. Ma spéculation est que cela pourrait entraîner une pénurie de GPU haut de gamme, mais pourrait ne pas affecter les GPU de classe gamer, avec moins de RAM.