Afin de rattraper ChatGPT et d’abaisser la ligne de fond morale, Google peut-il toujours « ne pas être méchant » ?

Le slogan "Don't Be Evil" était la devise et le code de conduite de Google jusqu'en 2018.

▲ Image de : sous-pile

Cela signifie que Google doit respecter l'éthique et les lois lorsqu'il fait des choses, et ne pas faire des choses qui nuisent à la société et aux utilisateurs.

Mais en 2018, cette phrase a été révisée en "Faites la bonne chose (faites la bonne chose)".

Ce changement de Google est considéré par beaucoup comme ayant violé son intention initiale.

▲ Image de : vox

Et dans certaines actions commerciales ultérieures, Google n'a pas maintenu la neutralité de la technologie, mais était plus enclin à réaliser des bénéfices commerciaux, à collecter la confidentialité des utilisateurs et à utiliser certaines données pour assurer l'expansion de sa propre entreprise.

La raison pour laquelle le slogan classique de Google est mentionné est que l'apparition soudaine de l'AIGC actuel est quelque peu similaire à l'apparition précédente d'Internet.

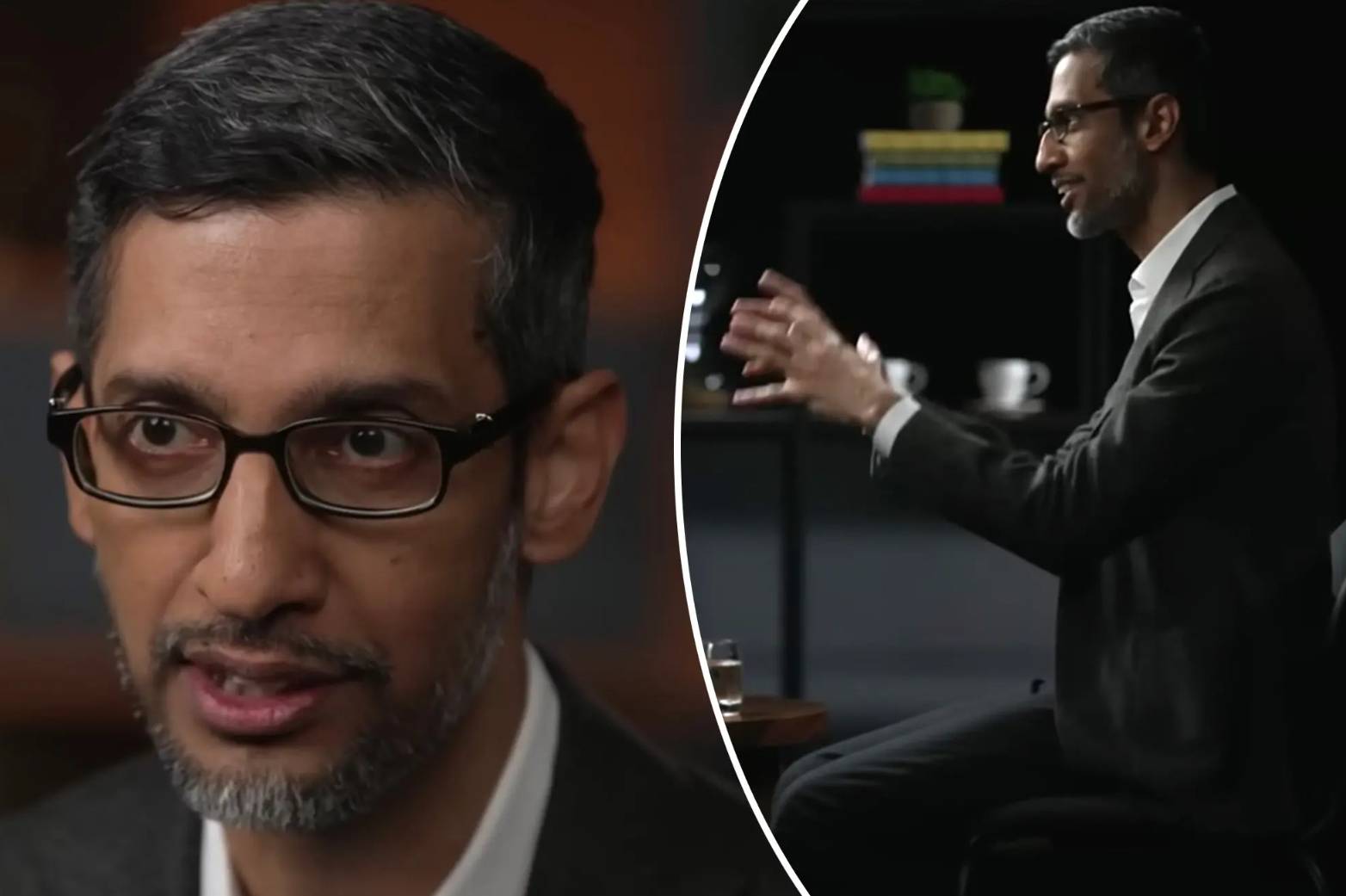

Dans une interview avec le programme "60 Minutes" de CBS, l'actuel PDG de Google, Sundar Pichai, a mentionné "Dont Be Evil" pour l'IA actuelle.

Et a également dit que la raison pour laquelle Google's Bard semble un peu maladroit pour le moment est en fait parce qu'il n'y a pas de version avancée de Bard annoncée.

"J'espère donner à la société plus de temps pour s'adapter à l'IA et donner aux entreprises plus de temps pour développer des barrières de sécurité."

Pour le dire simplement, Pichai estime que la force de l'IA de Google n'est pas pire que celle d'OpenAI, et par responsabilité sociale, la technologie de l'IA est temporairement scellée.

Cependant, peu importe les rapports de Bloomberg, the Verge et le Financial Times, Google a des voix complètement différentes sur le développement et la supervision actuels de la technologie de l'IA par Bard et Google.

Pour contrer ChatGPT, l'éthique peut être mise de côté

Vers 2011, Google a fondé le projet Google Brain, qui a commencé dans le domaine de l'apprentissage en profondeur, ce qui signifie également que Google a commencé à s'impliquer dans l'IA.

Depuis lors, Google a réalisé presque chaque année de petites réalisations et de petits objectifs dans le domaine de l'IA.

D'AlphaGo remportant le champion du monde Li Shishi aux échecs, à la sortie du framework open source TensorFlow, à la sortie de la puce d'apprentissage automatique TPU, et des modèles de langage récents tels que BERT et LaMDA.

Google est un vétéran dans le domaine de l'IA, dans le processus de recherche sur l'IA, il dispose également d'une équipe de risque interne relativement complète, d'une équipe technique, etc., que l'on peut qualifier de forte.

Bien sûr, c'est aussi un peu arrogant.

Le contenu de la conférence annuelle des développeurs de Google a également commencé à se tourner vers l'IA, montrant au monde extérieur la force profonde de Google dans le domaine de l'IA.

Le monde extérieur croit également généralement que Google prendra l'initiative de diriger la transformation de l'industrie de l'IA.

Jusqu'à ChatGPT, pour être précis, l'émergence de GPT-3, et l'émergence ultérieure de GPT-4, Midjourney V5 est chaud.

Avant que Google ne puisse réagir, Microsoft a saisi l'opportunité et a coopéré avec OpenAI pour appliquer ChatGPT au nouveau bing, déclenchant une révolution de la "recherche".

Lorsque Google a repris ses esprits, il a lancé Bard du jour au lendemain. Dès sa mise en ligne, il a créé un désordre oolong. Il y avait de nombreuses erreurs factuelles et il ne prend en charge que l'anglais jusqu'à présent.

Comparé à ChatGPT et au nouveau bing, il est trop inférieur.

Le résultat du lancement précipité de Bard est de provoquer une crise de confiance et le cours de l'action s'effondre. Même si Google l'ajuste plus tard, l'impact de Bard n'est toujours pas comparable à ChatGPT.

En conséquence, certains employés de Google ont également déclaré que Bard avait échoué à certains critères éthiques et était enclin à mentir et à faire des remarques négatives.

Au cours des tests internes, un employé a demandé à Bard des instructions sur la façon d'atterrir l'avion, et il a répondu par des étapes qui pourraient facilement conduire à un accident.

Un autre employé a posé une question à Bard sur la plongée, et il a donné des réponses qui pourraient facilement entraîner des blessures graves ou la mort.

En plus de ces réponses dangereuses, Google a également assoupli ses exigences sur certaines questions éthiques et sociales.

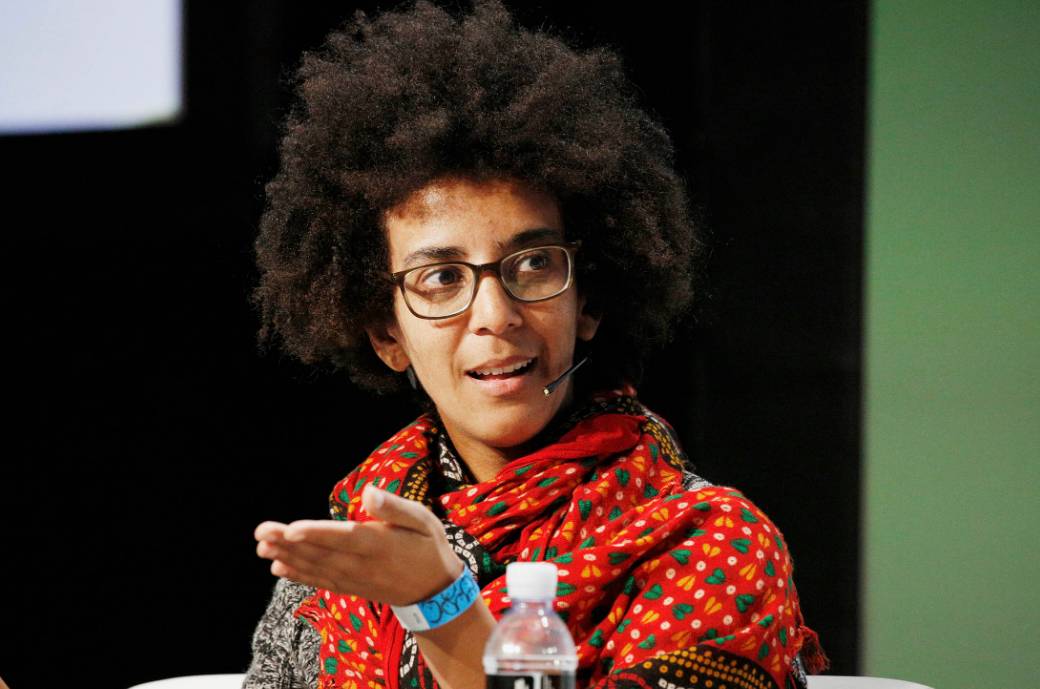

Au sein de Google, il existe une équipe de recherche sur l'éthique de l'IA qui explore, établit et évalue les risques posés par l'IA.

Ils ont le droit d'apposer directement une étiquette rouge sur une technologie, et si elle ne réussit pas le test, elle ne sera temporairement pas accessible au public.

▲ Timnit Gebru, ancien chercheur de l'équipe d'éthique de l'IA de Google Image tirée de : Bloomberg

En 2021, Google a également promis d'élargir l'équipe de recherche sur l'éthique de l'IA et d'investir davantage de ressources pour freiner la recherche de profit des chercheurs techniques.

Mais ce qui est intéressant, c'est que la direction de l'équipe a changé et a également connu une série de licenciements l'année dernière.

Google compte actuellement 30 fois plus de chercheurs techniques liés à l'IA que l'équipe de sécurité éthique.

Même après que ChatGPT ait volé le tonnerre de l'industrie AIGC, Google a commencé à faiblir et les membres de l'équipe d'éthique ont reçu l'ordre de ne pas obstruer ou "tuer" les outils d'IA générative en cours de développement.

Après avoir subi des tests internes et reçu de nombreuses "questions", Google a fait face à la pression commerciale de Microsoft et de ChatGPT, et a finalement choisi de le sortir sous le nom de "produit expérimental".

Car dans certaines enquêtes statistiques, les produits expérimentaux ont plus de chances d'être acceptés par le public même s'ils présentent des défauts.

Et certains salariés pensent aussi que l'annonce des nouvelles technologies au public le plus tôt possible permet d'obtenir rapidement des retours d'expérience et d'améliorer plus rapidement les produits.

En fait, pendant longtemps après la sortie de Bard, Google n'a fait qu'un seul changement, en y ajoutant une modification de la logique mathématique.

Quant à savoir si certaines clôtures sensibles et certains sujets sensibles ont été modifiés et optimisés, cela n'a pas été mentionné.

Bard semble également être mis à l'écart dans la vague d'IA en constante évolution.

Musc : ta doit être surveillé

Fait intéressant, Musk a également parlé de Google sur Fox News, presque avant et après l'interview de Pichai.

Musk et le fondateur de Google, Larry Page, étaient des amis proches. Page a même acheté 10 % des actions de SpaceX et voulait aller sur Mars pour jouer au sable avec Musk.

Mais en 2014, après l'acquisition de DeepMind par Google, les deux avaient des points de vue différents sur l'IA et n'ont finalement pas communiqué entre eux.

La même année, Page a déclaré dans un discours TED que son objectif ultime était de construire une super intelligence artificielle numérique, qu'il appelle un "dieu numérique".

Concernant cette idée, Pichai n'a ni nié ni accepté dans l'interview avec "60 Minutes".

Au lieu de cela, il a seulement déclaré que Google lancerait de nouveaux produits d'IA lors de sa conférence Developer I/O le 10 mai.

Et Musk a une compréhension claire du « dieu numérique ». Google dispose d'une équipe d'ordinateurs et d'intelligence artificielle de haute performance qui est proche d'un monopole dans le monde, et il est très probable qu'il atteigne le soi-disant « dieu numérique ».

Mais Page, le dirigeant de l'entreprise, ne se soucie pas des problèmes de sécurité provoqués par l'IA, ce qui est assez dangereux pour le monde.

C'est aussi pourquoi il a récemment voulu entrer dans le jeu après avoir vu ChatGPT, nouveau bing et Bard comme un non-sens, et a lancé un produit similaire appelé TruthGPT.

En outre, Musk appelle également divers pays et organisations à introduire des politiques correspondantes pour limiter certains comportements scandaleux de l'IA.

En raison des caractéristiques de l'IA générative, ses données proviennent de forums Internet, d'articles, de sites Web et d'autres aspects.Comme ces données ne sont pas désensibilisées et non strictement restreintes, il est facile de générer des remarques risquées, nuisibles ou inexactes.

De plus, avec le boom actuel de l'industrie AIGC, les entrants sont comme à la recherche d'or, comme si l'intelligence artificielle entrait dans une nouvelle phase de développement.

Cependant, les modèles actuels à grande échelle et les méthodes de génération industrielle à haut niveau de calcul facilitent également le monopole de l'IA par les grandes entreprises.

Lorsqu'il leur est difficile de déterminer s'il faut rechercher le profit ou maintenir la sécurité en interne, il est facile de faire des erreurs dans l'orientation de l'IA, entraînant des conséquences irréparables.

Même si Musk a un peu d'égoïsme sur AIGC, Musk est en effet beaucoup plus sobre lorsqu'il s'agit de certains problèmes majeurs.

Un grand pouvoir implique de grandes responsabilités

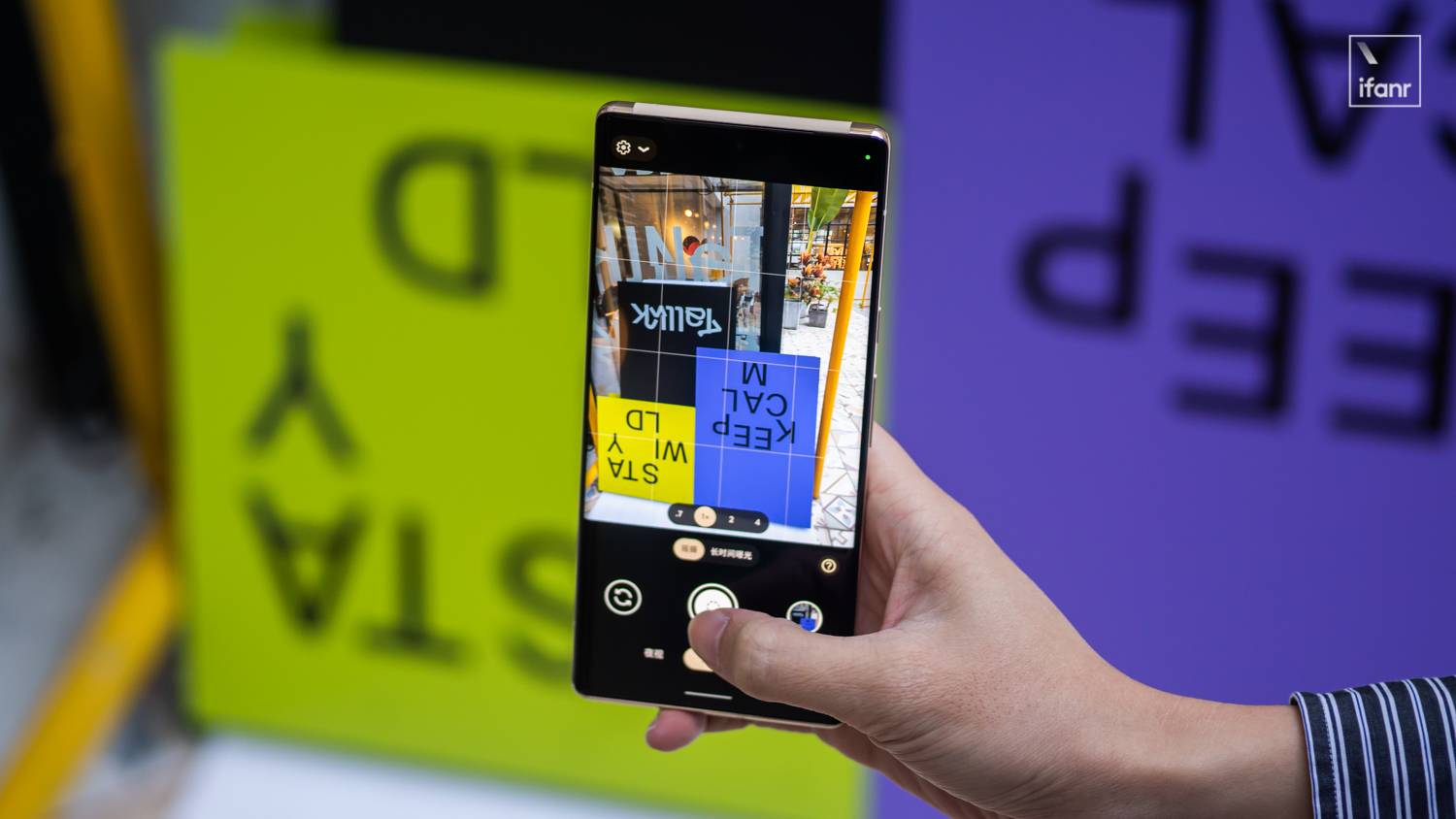

Google Photos utilisera la reconnaissance d'image AI pour marquer et aider les utilisateurs à trier les images pour la classification.

C'est l'une des premières applications d'intelligence artificielle de Google. Même si Google Photos a ajusté la capacité libre, c'est toujours l'une de mes applications les plus couramment utilisées.

Mais en 2015, Google Photos a qualifié à tort la photo d'un développeur de logiciels noir et de ses amis de "gorille".

Une réponse plus normale serait de s'excuser et de refactoriser l'algorithme pour corriger progressivement cette erreur de reconnaissance.

Mais Google a choisi de supprimer complètement les résultats de recherche pour "gorille", "chimpanzé" et "singe".

Le problème auquel est confronté Google Bard aujourd'hui est que Google n'a toujours pas le sens de la responsabilité, et il choisit toujours de la minimiser.

Afin de pouvoir rattraper ChatGPT, l'équipe interne d'éthique de l'IA de Google n'a pas procédé à une évaluation complète de celui-ci, a seulement mené des recherches sur des sujets sensibles, et l'a finalement lancé à la hâte.

Bloomberg a également cité l'évaluation d'un ancien cadre de l'équipe d'éthique de l'IA, qui estime que Google a toujours été controversé quant au développement d'une IA de pointe ou au développement d'une IA avec un résultat moral.

En fait, dans l'industrie de l'AIGC, non seulement Google, mais le Financial Times ont également révélé que des géants de la technologie tels que Microsoft et Amazon suppriment à grande échelle les équipes d'éthique de l'IA.

Il semble qu'au moment où l'AIGC se développe rapidement et se concurrence, l'éthique de l'IA et la sécurité de l'IA ont affecté les chaînes qu'elles se poursuivent.

Comme indiqué dans le rapport des chercheurs de l'Université de Stanford, le développement rapide de l'industrie de l'IA est passé du milieu universitaire à l'industrialisation. Sous la tentation des intérêts commerciaux, diverses IA émergent, mais l'éthique, la sécurité et la sensibilité qui les sous-tendent sont nuisibles. et d'autres informations sont progressivement ignorées.

Les grandes entreprises sont également devenues réticentes à assumer davantage de responsabilités sociales et ne font que rester à la limite des lois et réglementations, ce qui pourrait éventuellement avoir un impact profond sur la société et l'industrie de l'IA.

À l'heure actuelle, de nombreux pays et régions, et même certaines entreprises et organisations, étudient activement et formulent certaines règles pour limiter le développement incontrôlé de l'IA.

Comme Yin Sheng, ancien rédacteur en chef adjoint de Forbes Chinese Edition, l'a déclaré : "Les grandes entreprises doivent faire plus que les utilisateurs et la loi ne l'exigent, parce que vous créez un nouveau monde et en bénéficiez, vous devez aider l'ensemble de la société à apprendre comment pour la gouverner, si vous ne prenez pas l'initiative, la société prendra le relais.

#Bienvenue pour prêter attention au compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo