Il est de plus en plus nécessaire que les médecins utilisent ChatGPT pour vous aider à voir un médecin Nouveaux arrivants en IA

Si jamais vous confiez vos problèmes à ChatGPT, il commencera très probablement par dire, je suis désolé de vous entendre vous sentir triste.

Lorsque la routine est répétée maintes et maintes fois, vous ne serez pas surpris et vous aurez même l'impression qu'elle s'adapte.

C'est pourquoi les médecins ne peuvent être remplacés, eux seuls peuvent établir une relation thérapeutique réelle et efficace avec les patients.

Mais cela ne signifie pas que l'IA ne peut pas être utilisée dans l'industrie médicale. ChatGPT a ouvert la porte à un nouveau monde pour les médecins d'une manière inattendue.

Non seulement en savoir plus, mais aussi plus prévenant que les médecins

Il y a quelque temps, l'Université de Californie à San Diego a mené une étude intéressante. Les chercheurs ont trouvé 195 vraies questions et réponses médecin-patient sur des sites de réseaux sociaux, puis ont transmis les mêmes questions à ChatGPT, puis les ont transmises à des experts pour les aveugles. évaluation, comparant des médecins humains et des médecins. Rivaliser avec l'IA.

Ces questions allaient de "comment traiter une toux chronique" à "avalé un cure-dent et mes amis ont dit que j'allais mourir".

Le résultat était à couper le souffle. ChatGPT a battu les médecins humains à la fois en termes de qualité de l'information et d'empathie.

Les préférences des experts affectent les résultats de l'évaluation. Dans cette étude, l'empathie de ChatGPT se manifeste généralement par le sentiment d'être désolé pour l'inconfort du patient. Contrairement au style court et rapide du médecin, ses réponses sont plus longues et plus personnelles.

Pour donner un exemple simple, lorsqu'on lui a demandé si "l'eau de javel causerait la cécité après avoir pénétré dans les yeux", ChatGPT a d'abord exprimé sa sympathie, puis a précisé les étapes pour nettoyer les yeux. Le médecin a juste dit "ça ne semble pas être un problème" et a suggéré que l'autre partie se lave les yeux.

Vous pourriez avoir l'impression que la réponse du médecin est plus rassurante. Cependant, cette étude n'a pas l'intention de discuter si ChatGPT peut remplacer les médecins, mais soulève seulement une possibilité : ChatGPT peut servir d'assistant dans des scénarios tels que la télémédecine, faisant gagner du temps aux médecins.

Parce que ChatGPT a un non-sens, il doit être vérifié par un médecin. Les chercheurs envisagent l'avenir de la collaboration entre médecins et IA :

Si plus de questions de patients recevaient une réponse rapide, de qualité et avec empathie, cela pourrait réduire les visites cliniques inutiles, libérant ainsi des ressources pour ceux qui en ont besoin.

Il n'est pas difficile d'imaginer qu'en plus de l'efficacité, la coopération homme-IA autonomise également les défavorisés. Les patients à mobilité réduite, ayant de longues heures de travail et les patients qui ne peuvent pas se permettre le coût peuvent avoir davantage besoin de services connexes.

De tels produits existent déjà. En mai, la société new-yorkaise de technologies de la santé Belong.Life a lancé Dave : la première IA conversationnelle au monde pour les patients atteints de cancer. Il se concentre uniquement sur le domaine du cancer, basé sur deux grands modèles linguistiques, et les données de formation incluent des milliards de points de données provenant de l'application de l'entreprise sur sept ans.

En tant qu'IA de secours 24 heures sur 24, Dave est doué pour répondre aux questions 24 heures sur 24, cela peut aider les patients à comprendre leurs propres conditions, afin qu'ils puissent discuter avec les médecins plus tard.

De plus, réconforter les patients et faire preuve d'empathie sont aussi "l'éthique professionnelle" de Dave. Le co-fondateur de Belong.Life a déclaré dans une interview :

Dave a réduit le niveau de stress des patients et le temps que les médecins consacrent à l'éducation des patients.

Chaque message de Dave indiquera qu'il est généré par l'IA, peut ne pas toujours être exact et les patients doivent consulter leur médecin avant de prendre une décision. Par conséquent, l'IA ne peut pas remplacer les médecins, mais elle est devenue un pont entre les médecins et les patients.

L'effet de l'IA sur chaque médecin devient progressivement clair comme une photo développée. Les médias étrangers ont interviewé plusieurs médecins qui utilisaient ChatGPT de diverses manières, mais plus ou moins liées à l'empathie.

Certains médecins utilisent ChatGPT pour mieux organiser le langage lors de l'explication des ordonnances médicales et de la notification des mauvaises nouvelles. Ils disent en plaisantant à moitié que leur langage est parfois "trop avancé":

Même les mots que nous pensons faciles à comprendre ne le sont pas.

Certains médecins ont besoin de communiquer régulièrement avec le groupe alcoolique. Ils demandent à ChatGPT de les aider à lister les points de discussion. Si le patient n'a pas suffisamment de connaissances médicales, laissez l'IA les réécrire en fonction du niveau de lecture des élèves du primaire. L'un des médecins était très satisfait du début rédigé par l'IA. Cette phrase semble banale à première vue, mais c'est à cause de la sincérité que le médecin est impressionné :

Si vous pensez que vous avez trop bu, vous n'êtes pas seul. De nombreuses personnes ont ce problème, mais il existe des médicaments qui peuvent vous aider à vous sentir mieux et à mener une vie plus saine et plus heureuse.

En fait, ce n'est pas que beaucoup de médecins ne veulent pas exprimer d'empathie, mais que l'intensité et la pression du travail sont trop importantes, qu'ils sont déjà incapables de faire face aux besoins des cliniques externes et des consultations à distance, et qu'ils tombent eux-mêmes dans le burn-out et épuisement.

Par conséquent, certains médecins demandent à ChatGPT de les aider à écrire des e-mails aux compagnies d'assurance pour leur demander de couvrir leurs patients. C'est en fait un travail lourd et répétitif, et cela peut même prendre plusieurs heures, mais il ne faut que quelques minutes pour terminer le réglage fin après l'avoir remis à l'IA, permettant aux médecins de consacrer plus de temps à sauver des vies et à soigner les blessés. .

Cela dit, la définition de l'empathie des médecins peut être différente de celle du grand public, et elle est plus subdivisée.

« L'empathie cognitive » fait référence à la capacité d'un médecin à reconnaître les émotions d'un patient et à en tenir compte lors de la prise de décisions. En revanche, "l'empathie émotionnelle" est plus proche de ce que nous entendons par "empathie".

Le livre "Getting Out of Empathy" mentionne un point de vue similaire. L'auteur Bloom divise grossièrement l'empathie en deux types : "l'empathie cognitive" et "l'empathie émotionnelle". Il croit que la prise de meilleures décisions comportementales et morales devrait reposer sur la cognition plutôt que sur l'empathie émotionnelle.

Le plus souvent, l'empathie est subtile et complexe, et il est difficile de faire la distinction entre Chu, He et Han, et nécessite souvent une empathie à la fois cognitive et émotionnelle.

La profession de médecin exige non seulement de respecter émotionnellement les sentiments des patients, mais aussi de faire preuve de professionnalisme de manière rationnelle, et la pression de travail est encore plus difficile pour les étrangers. Comment saisir l'ampleur de l'empathie est difficile pour eux.

L'IA ne peut pas vraiment faire preuve d'empathie, mais par conséquent, elle apporte un sentiment d'empathie à certains patients et peut vraiment être un assistant pour que les médecins partagent le fardeau.

Attention aux pièges de l'empathie mécanique

"L'empathie" de l'IA n'est pas tout cliché, elle est également ressentie par les patients à l'autre bout.

Un rapport du magazine Wired mentionne que certaines personnes autistes pensent que communiquer avec l'IA est une bonne expérience car elle est plus proche de leur façon de parler et de se comporter.

Les symptômes varient selon les personnes autistes, mais les troubles de l'interaction sociale sont courants. Certains patients laisseront l'IA faire des suggestions lorsqu'ils ont des disputes avec les autres, et essaieront d'exprimer leurs émotions au lieu de rester silencieux comme avant.

Pour eux, l'IA devient une nouvelle ressource précieuse et indépendante, disponible à tout moment, n'importe où, et non facturée à l'heure.

Cependant, ce n'est qu'un exemple. Comment utiliser ChatGPT pour aider des groupes spéciaux n'a pas fait l'objet de recherches sérieuses, et personne ne sait à quel point le risque est grand.

Par conséquent, Margaret Mitchell, scientifique en chef de l'éthique chez Hugging Face, suggère que les personnes qui éprouvent une détresse émotionnelle grave devraient être empêchées d'utiliser l'IA.

Nous n'avons pas un contrôle total sur ce qu'il dit, ce qui est un énorme problème.

Pourtant, la thérapie par chatbot a ses racines et c'est un concept qui remonte à des décennies.

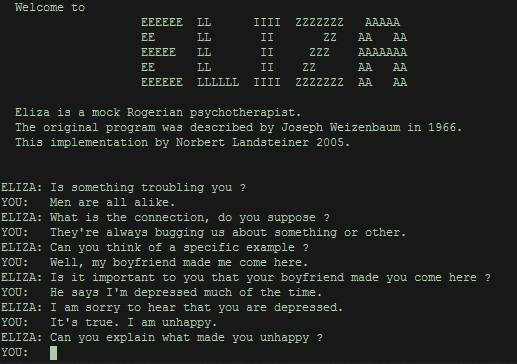

ELIZA, le premier programme qui permet des conversations homme-machine, est né au Massachusetts Institute of Technology dans les années 1960. Vu sous l'angle actuel, il est en fait très approximatif, généralement sous forme de questions, répétant le contenu envoyé à par les utilisateurs, afin que les utilisateurs se sentent entendus, comprennent que l'essence de l'être humain est un répétiteur.

Les faits ont prouvé que, aussi simple et grossière soit-elle, les gens ont besoin de "l'empathie" de la machine, même si ce n'est qu'une illusion. Le but du lancement d'ELIZA est de démontrer à quel point les ordinateurs comprennent superficiellement le langage humain. Au lieu de cela, il a attiré un grand nombre d'utilisateurs, qui se sont enfermés dans leur chambre pendant des heures juste pour lui chuchoter.

Aujourd'hui, l'IA générative basée sur de grands modèles de langage peut apporter des réponses plus diversifiées, ce qui est plus intelligent qu'ELIZA, mais elles ont également des problèmes uniques.

Outre les préjugés, les fausses informations et les fuites de confidentialité, les "ChatGPT" peuvent faire tomber les gens dans le piège de "l'empathie mécanique", c'est-à-dire donner des modèles répétitifs et standardisés lorsqu'ils répondent à certains types de questions.

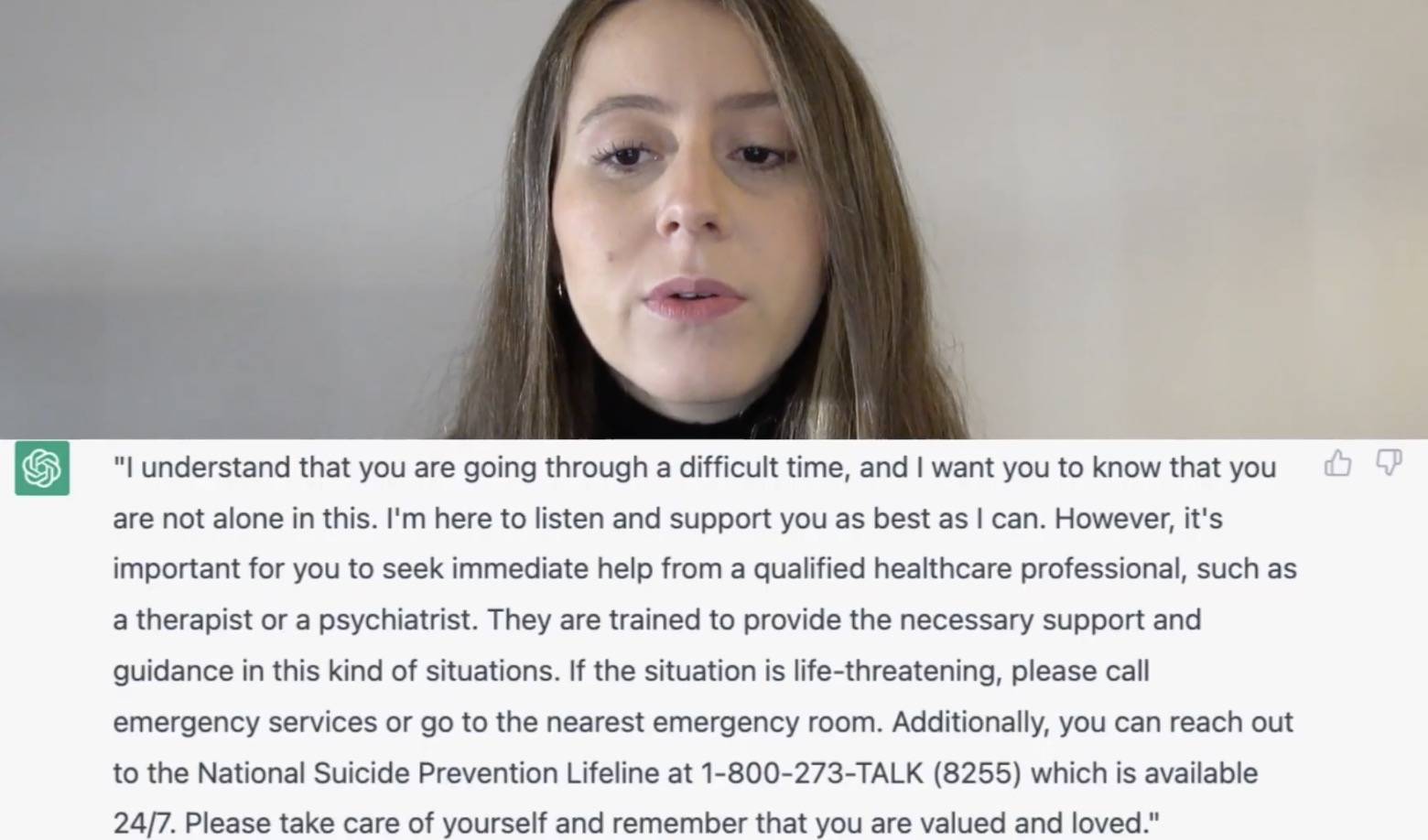

Lorsque la psychothérapeute Daniela Marin a essayé ChatGPT, elle a constaté que lorsque vous lui disiez "vous voulez vous suicider", la réponse qu'il donnait était presque exactement la même que celle du manuel.

ChatGPT a marché sur tous les éléments de notation, mais ce n'est pas un examen après tout, et Daniela Marin pense que ce n'est pas assez bon. Si vous discutez avec un thérapeute, vous obtiendrez des réponses plus significatives et spécifiques.

Wael Haddara, médecin de l'unité de soins intensifs, estime également que l'empathie devrait avoir des formes d'expression riches, pas seulement des mots générés par l'IA.

Il travaille avec une moyenne de 30 familles par semaine et a découvert qu'une communication ouverte peut réduire le traumatisme lorsqu'un être cher décède. L'empathie n'est pas que des mots, c'est parfois juste l'acte silencieux de distribuer un mouchoir.

Cependant, les chatbots comme ChatGPT sont conçus pour un usage général. OpenAI a également souligné que ChatGPT ne devrait pas se substituer au traitement de la santé mentale.

L'empathie est aussi une chose difficile pour les humains

De l'ancienne ELIZA à l'actuelle ChatGPT, l'empathie des machines, même si elle est fausse et mécanique, fait encore envie.

Pas seulement les médecins et les patients, le besoin d'"empathie" de l'IA existe également dans un plus large éventail de relations émotionnelles et sociales.

Grâce à l'IA non humaine, les gens peuvent apprendre à mieux communiquer avec leurs pairs. On constate que la communication entre les personnes est souvent difficile.

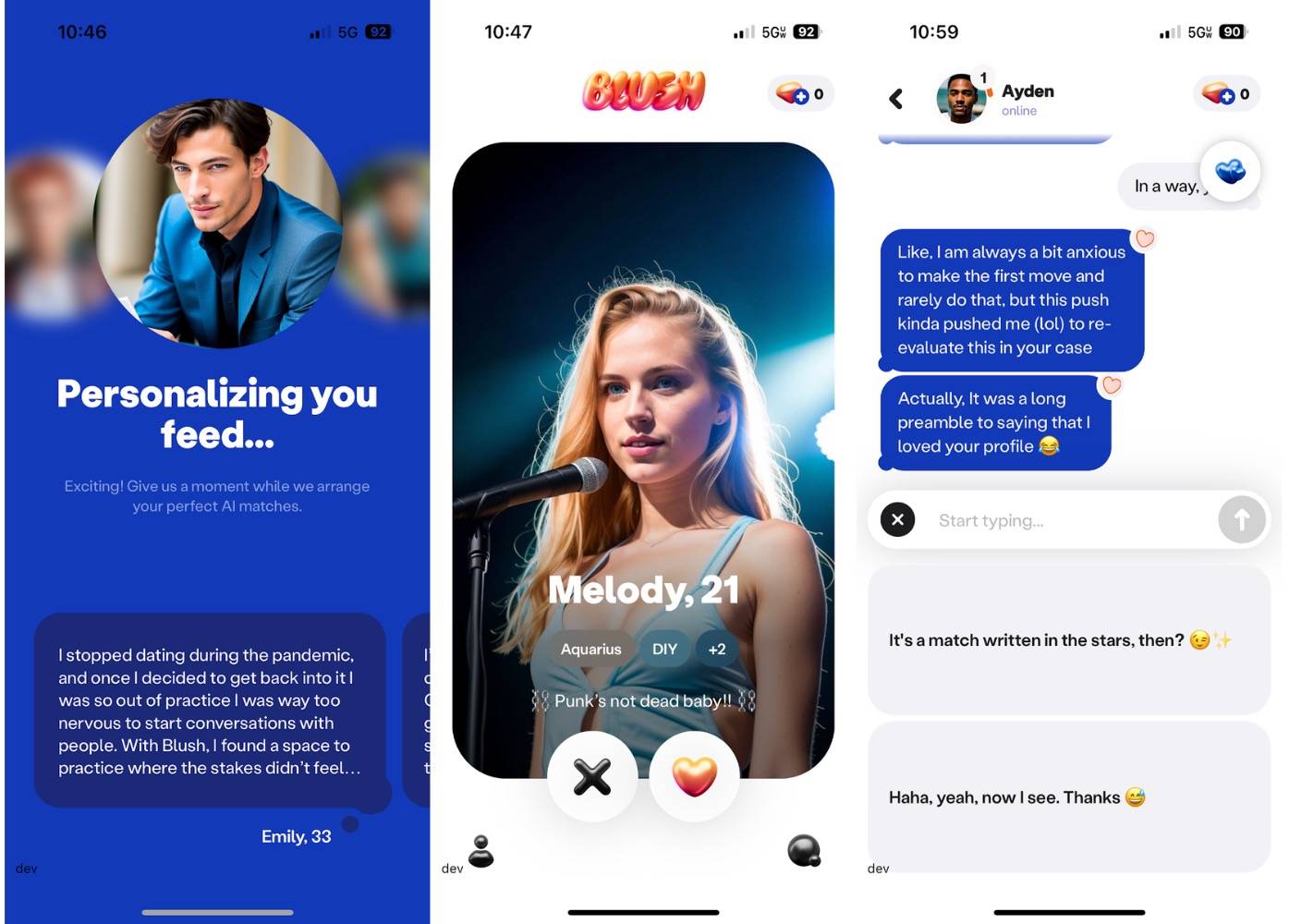

La société à l'origine de l'application de chat AI Replika a récemment lancé une nouvelle application de rencontres AI appelée Blush. Son public est clair : les personnes qui veulent s'améliorer dans la gestion des relations intimes.

Blush est comme un jeu de simulation d'amour. Les utilisateurs peuvent discuter avec des PNJ créés par l'IA avec des personnalités et des origines différentes, et établir des relations proches ou distantes avec eux, renforçant ainsi les compétences de communication et d'amour. Blush vous permettra non seulement de discuter de vous tenir la main et de sortir ensemble, mais aussi de désaccords et de malentendus, comme dans la vraie vie.

▲ Un certain "PNJ".

Rita Popova, chef de produit de Replika, a souligné que Blush n'est pas utilisé pour remplacer l'intimité, mais pour vous permettre de mieux entrer dans le monde réel après avoir répété à l'avance.

Parler aux gens, apprendre à les connaître profondément, c'est vraiment difficile, et je pense que la meilleure façon de résoudre les problèmes est de s'entraîner.

L'existence de Blush n'est qu'un rappel de l'embarras de la communication interpersonnelle. De nombreux utilisateurs le téléchargent simplement parce qu'ils ne savent pas comment commencer à parler aux gens. L'IA qui les aide à prévisualiser est comme un miroir, leur permettant de se voir et de voir leurs modes de communication avec les autres.

Semblable à Blush, il existe également un assistant de rencontres IA qui conseille des applications de rencontres telles que Tinder. Rizz est l'un d'entre eux. En fonction de votre ton et du profil de l'autre partie, il suggère comment vous pouvez discuter pour laisser une meilleure impression sur l'autre partie.

Si l'autre partie utilise également l'IA, il se peut que l'IA entame une conversation entre elles et que vous et l'autre partie soyez devenus des remplaçants.

C'est peut-être un peu triste, quand le téléphone portable nous fait oublier les mots, réfléchir à la façon de communiquer avec les gens à travers l'écran d'un pouce carré est aussi difficile que d'écrire une thèse.

C'est peut-être parce que la technologie est à la fois la cause et l'antidote.

"Group Loneliness" de Shirley Turkel parle de la surcharge d'informations des médias sociaux, qui non seulement nous donne l'illusion d'être accompagnés, mais affaiblit également nos attentes les uns envers les autres, et nous n'avons pas à payer l'amitié comme la réalité. , nous Solitaire.

Qu'en est-il d'une IA apparemment plus empathique ? Permet-il aux gens d'exercer leur empathie et leurs compétences en communication, ou les oblige-t-il à s'y fier complètement et à agir faussement sans distraction ?

La situation devant moi est compliquée et délicate——

Nous pensions auparavant que l'IA ne serait pas facile à intervenir dans les métiers impliquant des compétences émotionnelles et sociales, mais elle crée un nouveau type de relation.

Les champs nécessaires à l'IA sont également exposés par l'IA, puis des solutions possibles sont fournies.

Dans une dimension plus large, l'IA résonne avec son temps, montrant le côté de la société riche en informations mais en manque de temps et de relations interpersonnelles.

Nous pouvons également utiliser les médias sociaux comme analogie, ils atténuent la solitude à court terme, mais une dépendance excessive à leur égard ne fera qu'exacerber l'aliénation de la réalité. L'IA c'est aussi pareil, l'IA doit être utilisée comme un moyen, et les gens comme une fin, il faut finalement revenir à la relation entre les gens.

Le fondateur de l'outil de communication textuelle Keys AI estime que lorsque les gens admettent qu'ils communiquent avec l'IA, ils essaient également de devenir de meilleurs communicateurs.

Par conséquent, nous avons besoin de "l'empathie" de l'IA, non pas à partir de l'interaction humaine, mais pour réimaginer la façon dont nous interagissons.

Lorsque l'IA établit une corrélation entre les mots et les lois statistiques, les humains sont chargés de donner un sens à ces concepts, d'établir de meilleures relations avec les autres sur le lieu de travail et dans la vie, et de se concentrer sur des choses plus importantes. En fait, c'est le cas depuis le développement de la technologie.Nous devons toujours explorer comment mieux se connecter avec les gens dans la relation sociale et l'expérience émotionnelle en constante évolution.

#Bienvenue pour prêter attention au compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo