En dépensant 10 milliards de dollars pour construire, quelle est la force de la puce d’IA la plus puissante de l’histoire ?

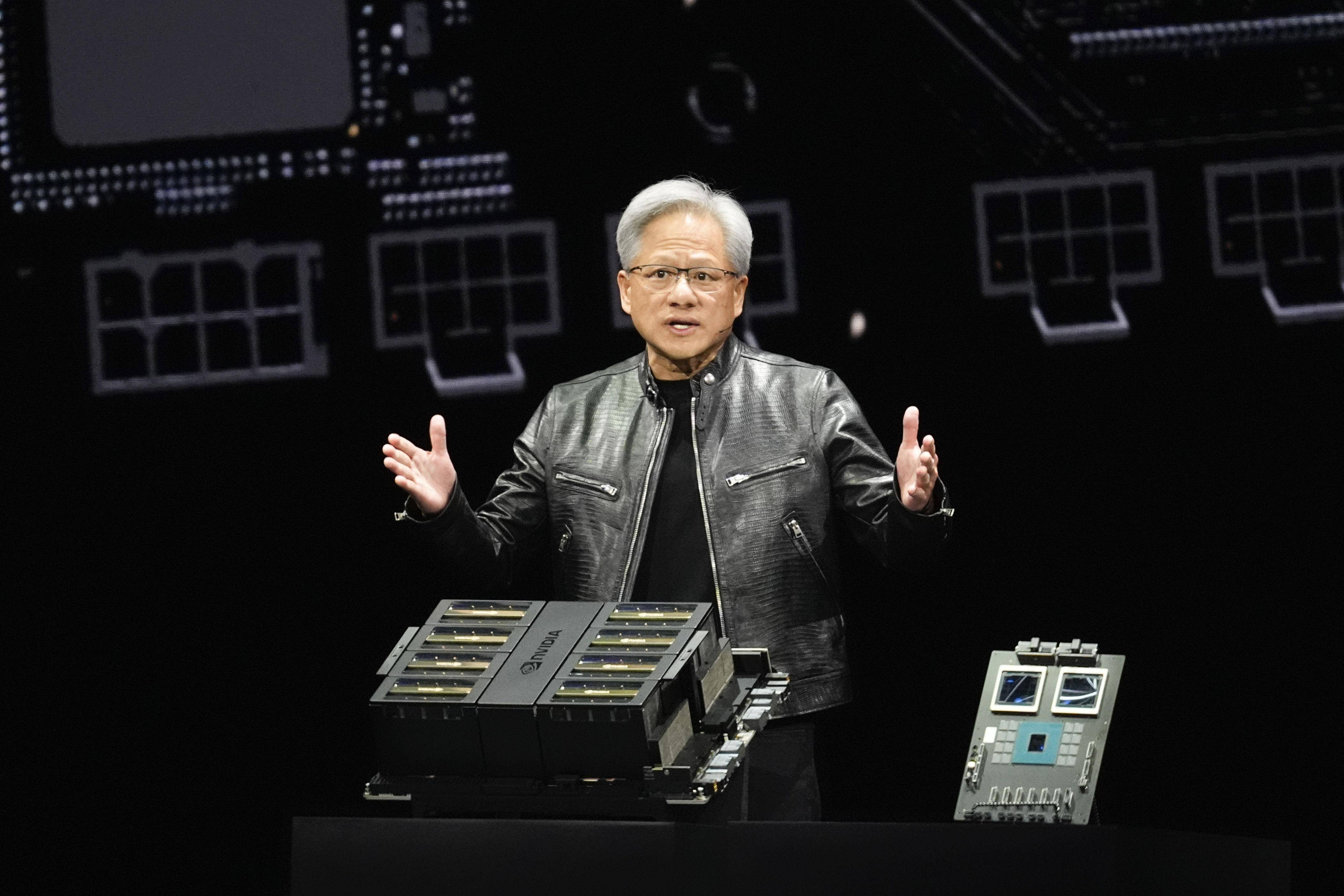

Au cours des deux derniers jours, nous avons de nouveau examiné le discours de Huang Renxun au GTC 2024. Lorsque nous avons procédé à une analyse et une interprétation plus approfondies du produit, nous avons découvert certains points forts que nous avions manqués en veillant tard à ce moment-là.

Premièrement, le style de discours de Huang est humoristique, naturel et très communicatif. Il n’est pas étonnant qu’il puisse transformer une conférence de lancement de produit technologique en concert.

La seconde consiste à examiner la nouvelle architecture Blackwell et la série de GPU en combinaison avec les générations précédentes de produits. Je peux seulement dire que ses performances de calcul, son coût et ses performances futures dépassent de loin mon imagination.

Tout comme le nom NVIDIA, les deux premières lettres N et V de NVIDIA représentent Next Version « nouvelle génération ».

Comme GTC les années précédentes, Nvidia a lancé la prochaine génération de produits comme prévu, avec des performances plus élevées et de meilleures performances ; mais c'est complètement différent d'avant, car Blackwell représente non seulement la prochaine génération de produits, mais aussi la prochaine ère.

Redécouvrez le GPU le plus puissant au monde

L’auto-présentation commence généralement par votre nom, alors commençons ici par la puce IA la plus récente et la plus puissante.

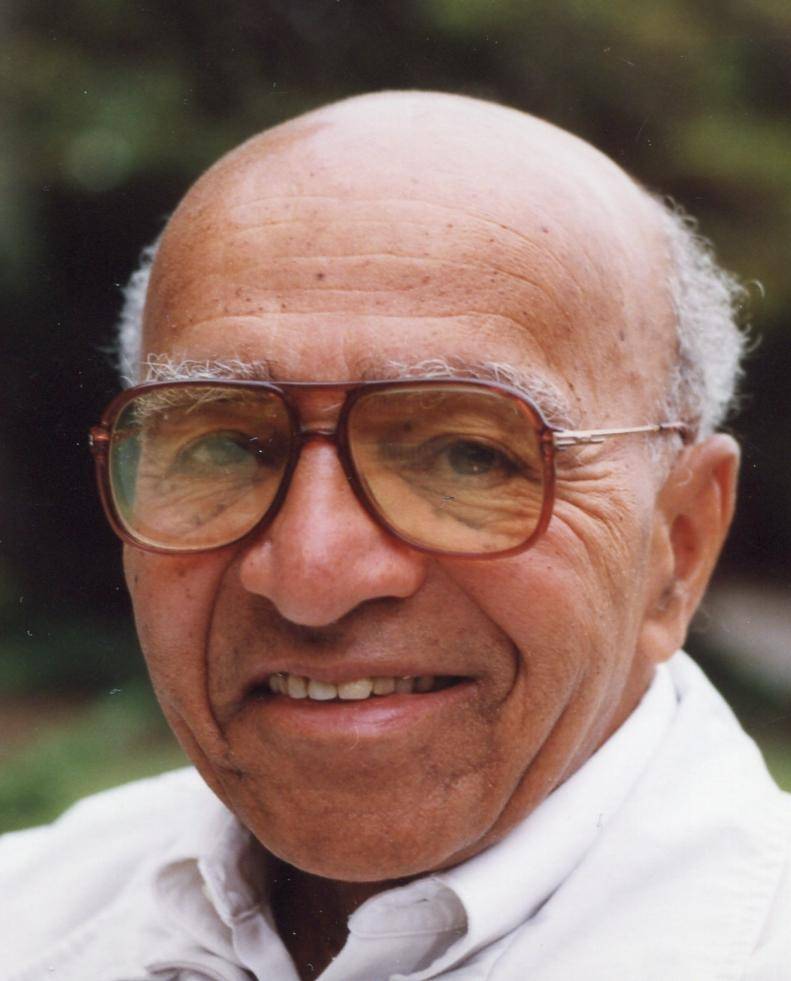

Le nom complet de Blackwell est David Harold Blackwell. C'est un statisticien américain et l'un des proposants du théorème de Rao-Blackwell. Plus important encore, il fut le premier membre noir de l’Académie nationale des sciences et le premier membre noir titulaire du corps professoral de l’Université de Californie à Berkeley.

C'est de là que vient le "Blackwell" présenté au GTC 2024. Ce n'est pas que Blackwell lui-même ait apporté des contributions exceptionnelles à NVIDIA, mais que dans le système de nommage de NVIDIA, les noms de certains scientifiques (ou mathématiciens) célèbres de l'histoire sont utilisés. devenir une convention pour nommer les microarchitectures GPU par leurs noms.

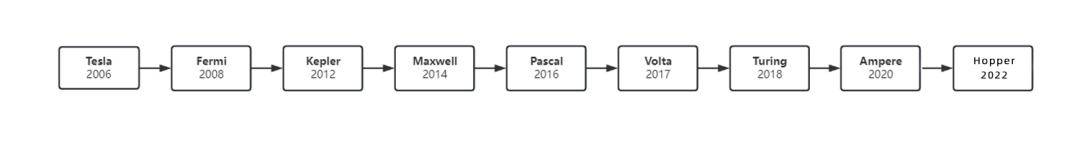

Depuis 2006, NVIDIA a lancé successivement les architectures Tesla, Fermi, Kepler, Maxwel, Pascal, Volta, Turing et Ampere, correspondant à Tesla, Fermi, Kepler, Maxwell, Pascal, Volta, Turing, Ampere et ces leaders académiques.

L'une est qu'il est célèbre, et l'autre est qu'il a des matériaux. Quant à savoir s'il correspond un à un au produit désigné, ce n'est en fait pas une corrélation si forte.

Il convient de souligner ici que les objets nommés mentionnés ci-dessus ne sont pas des puces individuelles, mais font référence à l'ensemble de l'architecture GPU (Huang Renxun l'appelle une plate-forme).

L'architecture de la puce fait référence à la conception de base et à la structure organisationnelle de la puce. Différentes architectures déterminent les performances, l'efficacité énergétique, la puissance de traitement et la compatibilité de la puce, et affectent également la méthode d'exécution et l'efficacité des applications.

Pour faire simple, vous possédez désormais un stade (la matière première pour fabriquer des chips) et vous envisagez de le transformer complètement. L'utilisation du terrain pour des concerts ou des matchs sportifs (la fonction de la puce) détermine l'aménagement du lieu, l'embauche du personnel, la décoration et le mode d'annonce (architecture des puces).

Par conséquent, l’architecture et la conception des puces sont interdépendantes et déterminent conjointement les performances des puces.

Par exemple, x86 et ARM, dont on entend souvent parler, sont deux architectures grand public conçues pour les processeurs. La première offre des performances puissantes et la seconde un excellent contrôle de la consommation d'énergie. Chacune a ses propres atouts.

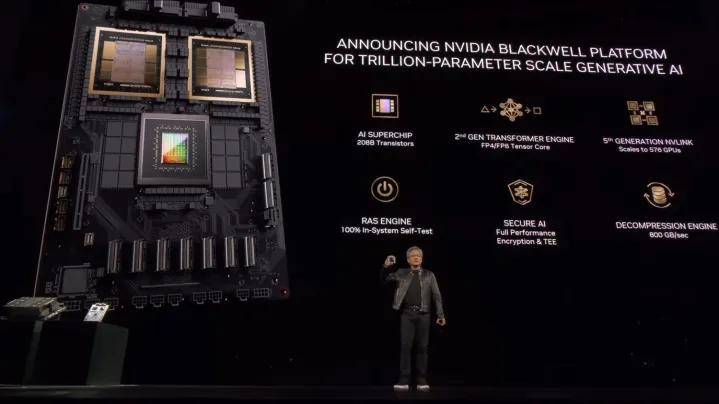

Construites sur plusieurs générations de technologie NVIDIA, les puces B200 et B100 sous l'architecture Blackwell offrent des performances, une efficacité et une évolutivité exceptionnelles, et ouvrent également un nouveau chapitre pour l'AIGC.

Mais pourquoi est-on appelé « bombe nucléaire IA » ? Quelle est la puissance du nouveau GPU ? Par rapport au produit de la génération précédente, nous aurons une sensation plus intuitive.

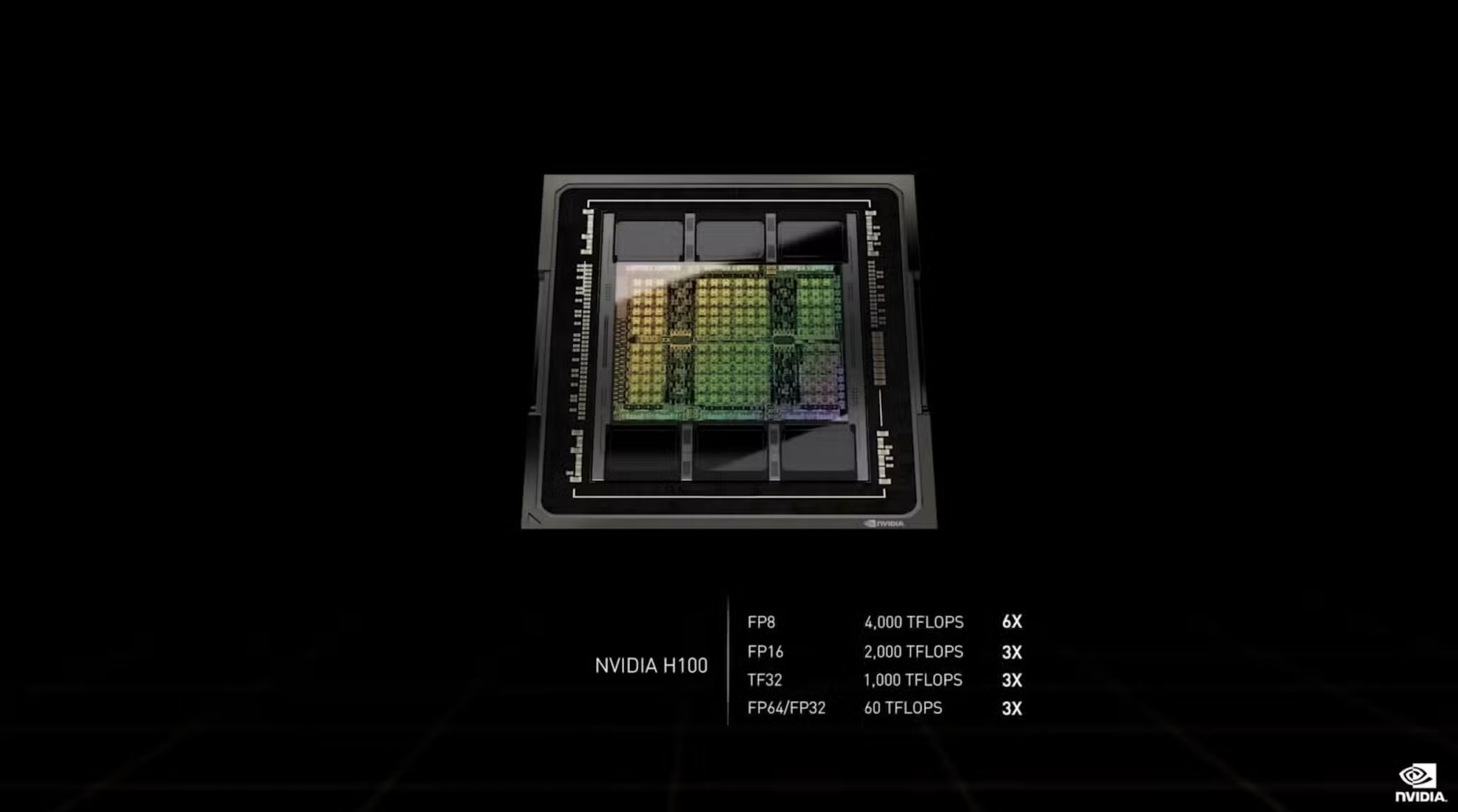

Lors du GTC 2022, Huang Renxun a dévoilé une nouvelle architecture Hopper et une nouvelle puce H100 :

1. Il est fabriqué selon le procédé 4 nm de TSMC et intègre 80 milliards de transistors, soit 26 milliards de plus que la génération précédente A100.

2. Les performances FP16, TF32 et FP64 du H100 sont 3 fois supérieures à celles du A100, soit respectivement 2 000 TFLOPS, 1 000 TFLOPS et 60 TFLOPS. Il ne faut qu'un jour pour former un grand modèle avec 395 milliards de paramètres. Selon les mots originaux de Lao Huang, "20 les images peuvent transporter le « trafic Internet » de données du monde entier.

3. La sortie du H100 a porté la valeur marchande de NVIDIA à plus de 2 000 milliards de dollars, ce qui en fait la troisième plus grande entreprise technologique après Microsoft et Apple.

Selon l'analyse statistique de la société de suivi du marché Omdia, Nvidia a vendu environ 500 000 GPU H100 et A100 au troisième trimestre de l'année dernière, et le poids total de ces cartes graphiques s'élevait à près de 1 000 tonnes.

Jusqu’à présent, le Hopper H100 reste de loin le GPU le plus puissant du marché.

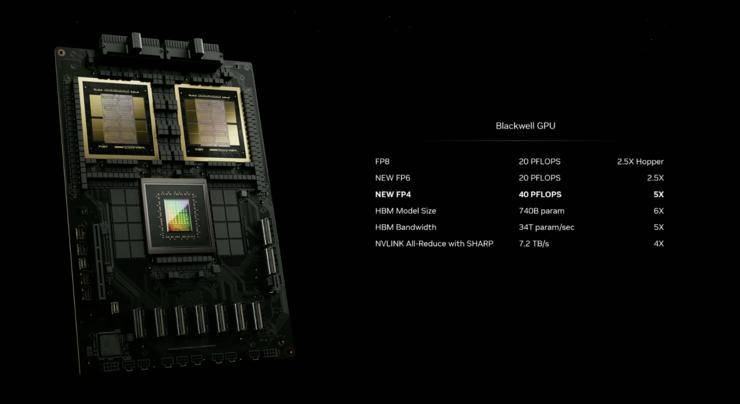

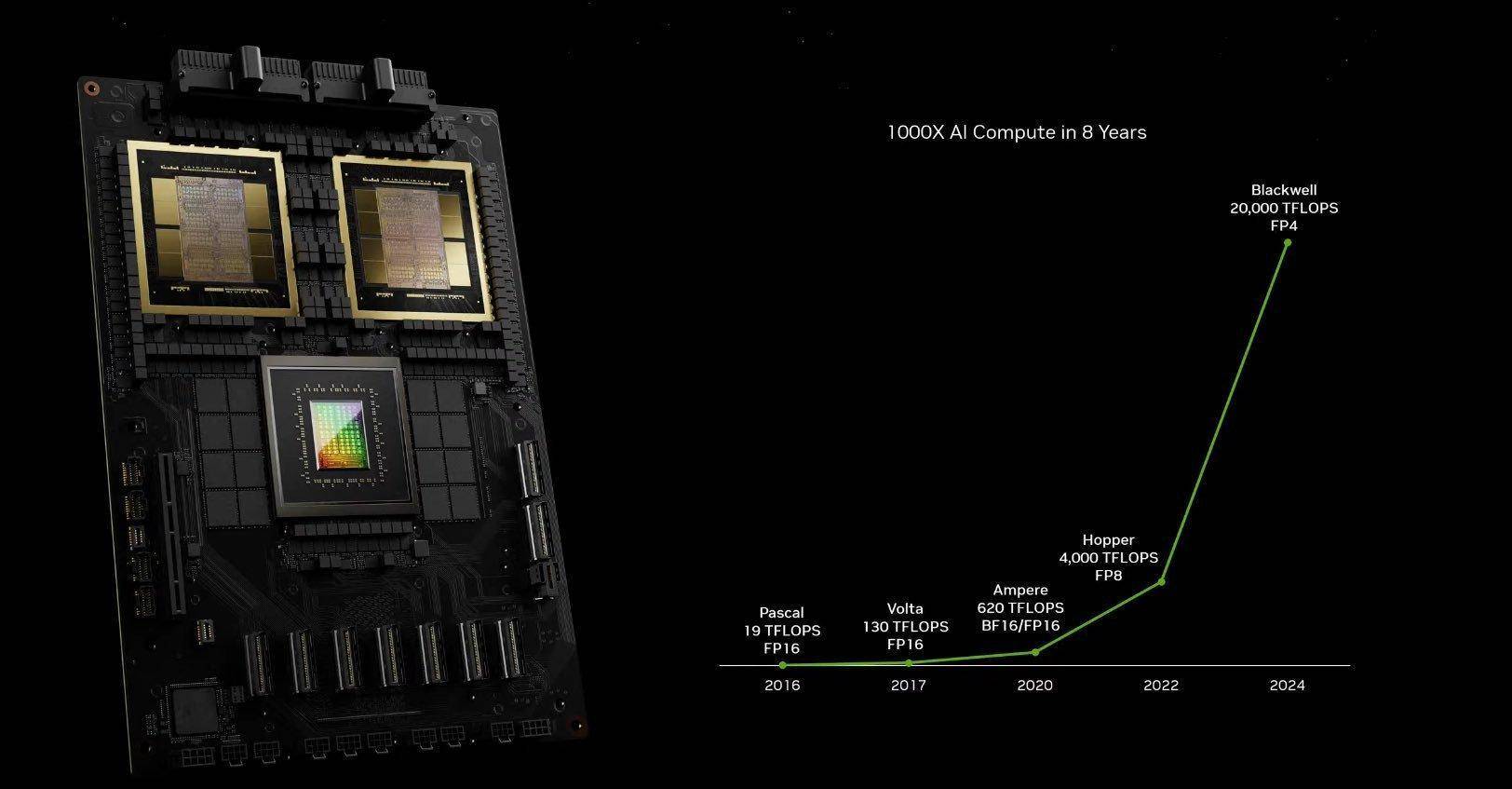

Le Blackwell B200 a une fois de plus établi un nouveau record du « plus fort », avec des améliorations de performances bien au-delà des itérations de produits conventionnels.

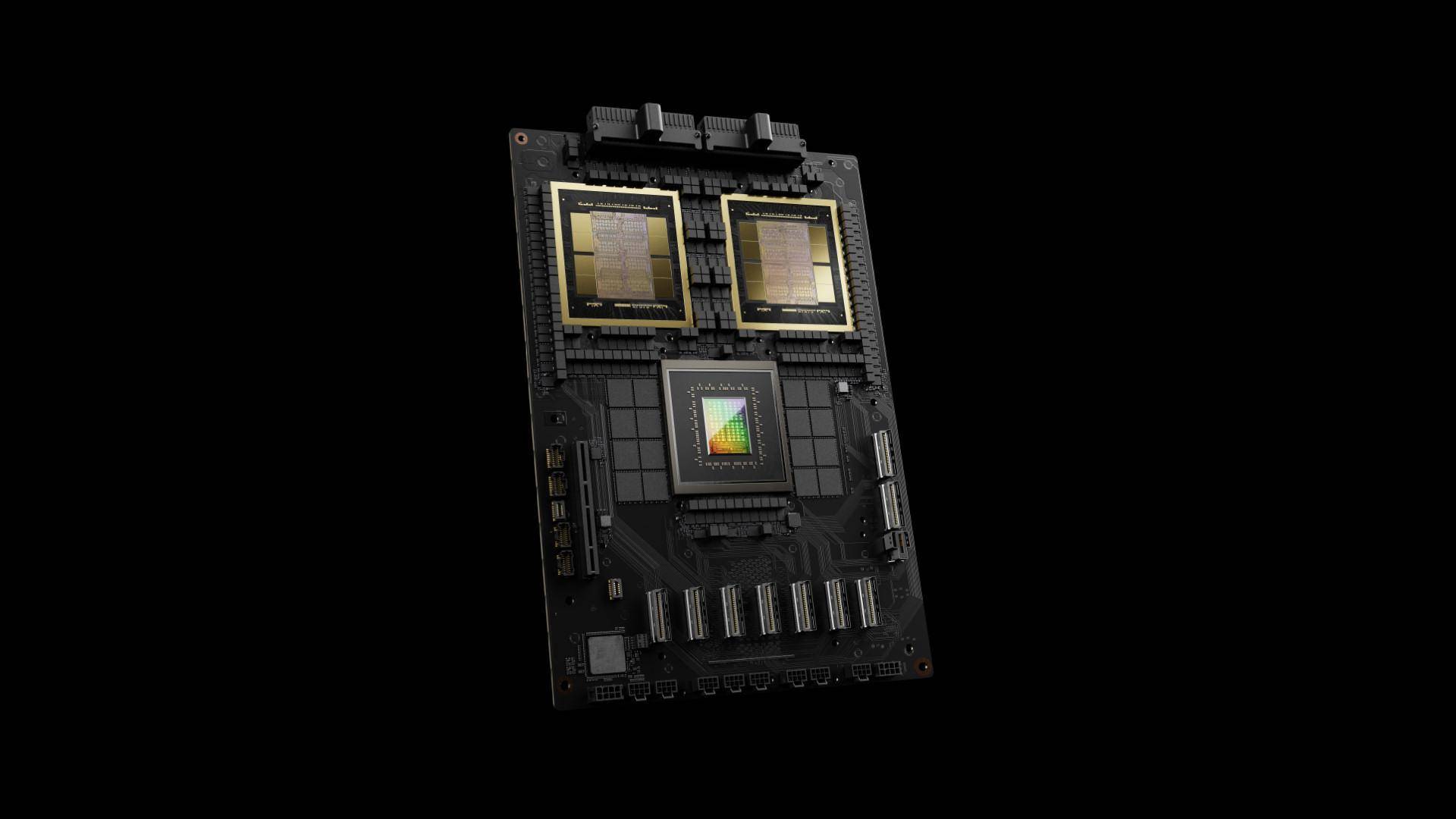

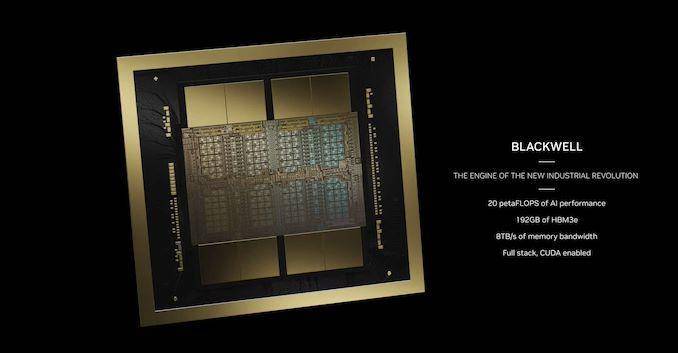

Du point de vue de la technologie des processus, le GPU B200 utilise le processus TSMC 4 nm de deuxième génération, utilisant des tranches nues avec une taille double de la limite de photolithographie, et est connecté via une technologie d'interconnexion inter-puces de 10 To/s pour former un GPU unifié, avec un total de 208 milliards de transistors (une seule puce équivaut à 104 milliards), par rapport à la technologie N4 utilisée pour fabriquer le Hopper H100, les performances sont améliorées de 6 %. , les performances globales sont améliorées d'environ 250 %.

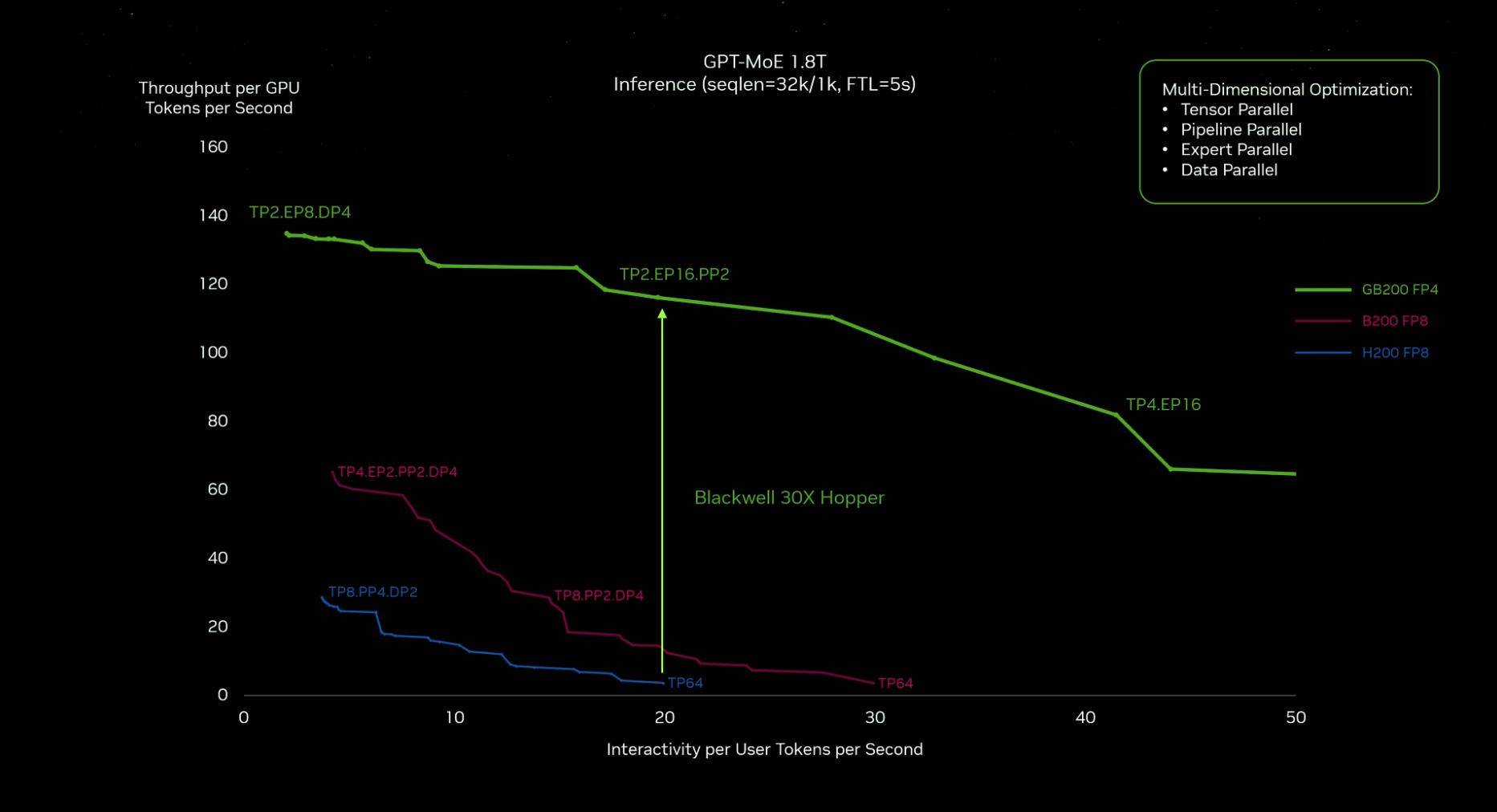

En termes de performances, le moteur Transformer de deuxième génération permet à Blackwell de prendre en charge le double des capacités de calcul et de raisonnement de la taille du modèle grâce à la nouvelle IA à virgule flottante 4 bits. Les performances de l'IA monopuce atteignent 20 PetaFLOPS (peut effectuer 20 × 10 ^ 15 flotteurs par seconde).Opération ponctuelle), ce qui est 4 fois supérieur à celui de la génération précédente Hopper H100, et les performances d'inférence de l'IA sont 30 fois supérieures à celles de la génération précédente.

Du point de vue du contrôle de la consommation d'énergie, dans le passé, la formation d'un modèle de 1,8 billion de paramètres nécessitait 8 000 GPU Hopper et 15 mégawatts de puissance. Aujourd'hui, 2 000 GPU Blackwell peuvent le faire, et la consommation d'énergie n'est que de 4 mégawatts, ce qui réduit directement 96 %.

Par conséquent, la déclaration de Huang Renxun selon laquelle « Blackwell deviendra la puce la plus puissante du monde » n’est pas seulement un mensonge, mais est devenue un fait.

Pas bon marché, pas simple à utiliser

Les analystes de la société de services financiers Raymond James avaient estimé le coût du B200.

Le coût de fabrication de chaque H100 de Nvidia est d'environ 3 320 dollars américains, et le prix se situe entre 25 000 dollars américains et 30 000 dollars américains. Sur la base de la différence de performances entre les deux, on estime que le coût du B200 sera 50 à 60 % plus élevé que celui du H100, soit environ 6 000 $ US.

Dans une interview exclusive avec CNBC après la conférence de presse, Huang Renxun a révélé que le prix du GPU Blackwell est d'environ 30 000 à 40 000 dollars américains, et que la recherche et le développement de l'ensemble de la nouvelle architecture coûtent environ 10 milliards de dollars américains.

Nous avons dû inventer une nouvelle technologie pour rendre cela (la nouvelle architecture) possible.

Selon le rythme passé, Nvidia lancera une nouvelle génération de puces IA environ tous les deux ans. Par rapport aux générations précédentes de produits, le dernier Blackwell a considérablement amélioré les performances de calcul et le contrôle de la consommation d'énergie. De manière plus intuitive, il combine les deux GPU Blackwell est presque deux fois plus grand que le Hooper.

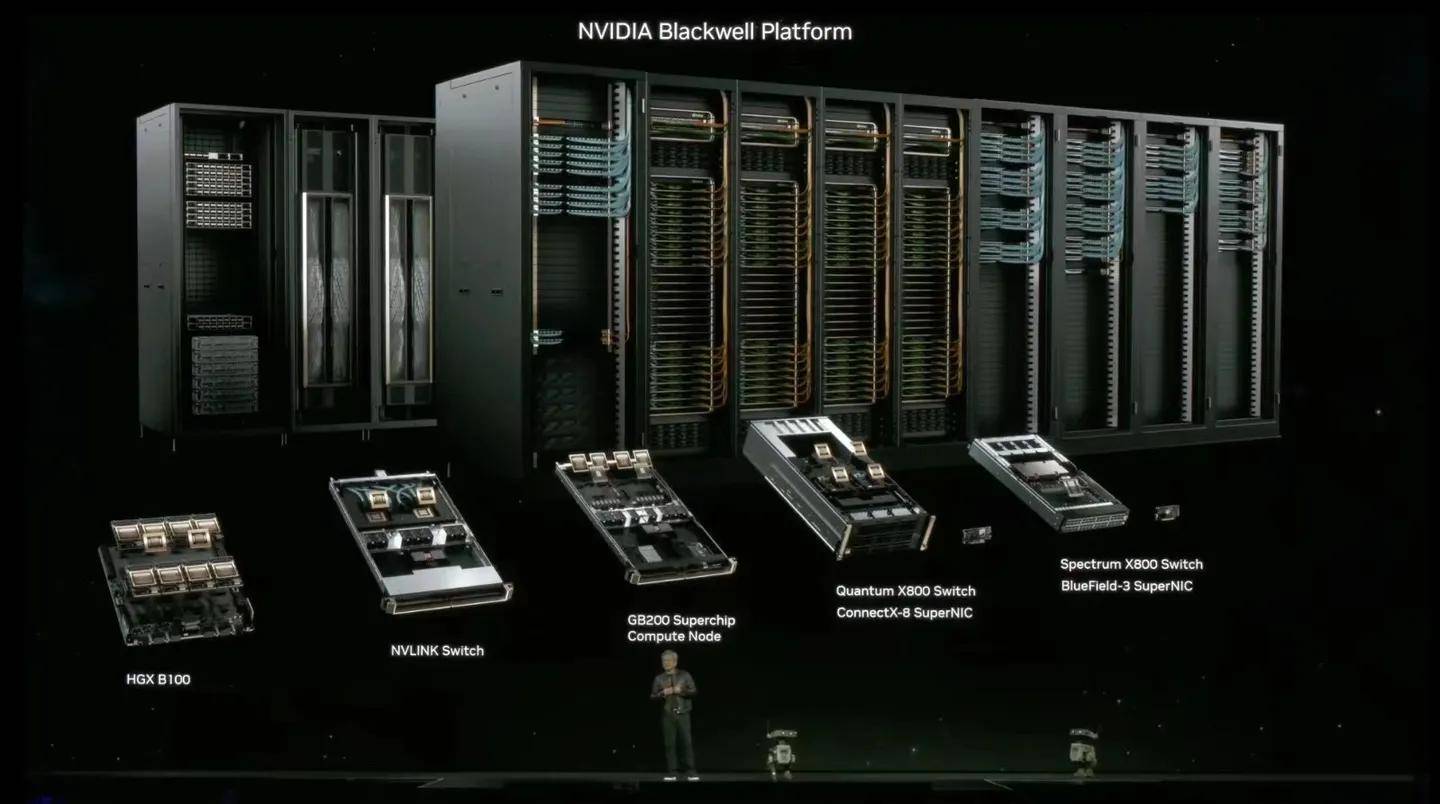

Le coût élevé n'est pas seulement lié aux puces, mais aussi à la conception des centres de données et à leur intégration dans les centres de données d'autres sociétés, car selon Huang Renxun, Nvidia ne fabrique pas de puces, mais construit des centres de données.

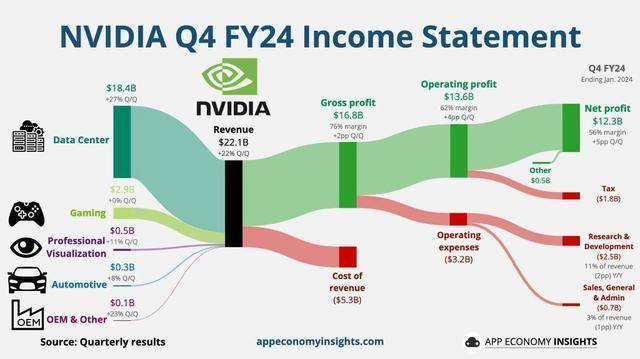

Selon le dernier rapport financier de Nvidia, le chiffre d'affaires du quatrième trimestre a atteint un record de 22,1 milliards de dollars, soit une augmentation de 265 % sur un an. Le bénéfice net du quatrième trimestre s'est élevé à 12,3 milliards de dollars, soit une augmentation de 765 % sur un an.

Le segment des centres de données, la plus grande source de revenus, a atteint un montant record de 18,4 milliards de dollars, soit une augmentation de 27 % par rapport au troisième trimestre et une augmentation de 409 % par rapport à la même période de l'année dernière.

Les coûts de R&D sont élevés, mais les rendements positifs sont plus élevés.

Le centre de données que NVIDIA construit actuellement comprend un système full-stack et tous les logiciels. Il s'agit d'un système complet dont Blackwell ou GPU n'est qu'une partie.

Le centre de données est décomposé en plusieurs modules. Les utilisateurs peuvent choisir librement les services logiciels et matériels correspondants en fonction de leurs propres besoins. NVIDIA ajustera le réseau, le stockage, la plate-forme de contrôle, la sécurité et la gestion en fonction des différentes exigences et dispose d'une équipe dédiée. pour fournir un support technologique.

Qu'une telle vision globale et des services personnalisés soient bons ou non, les données peuvent tout dire : depuis le 5 mars, la valeur marchande de Nvidia a dépassé des géants comme Alphabet et Amazon, et a dépassé Saudi Aramco pour devenir la troisième plus grande entreprise au monde. juste derrière Les deux grands géants de la technologie, Microsoft et Apple, ont une valeur marchande combinée de 2,4 billions de dollars américains.

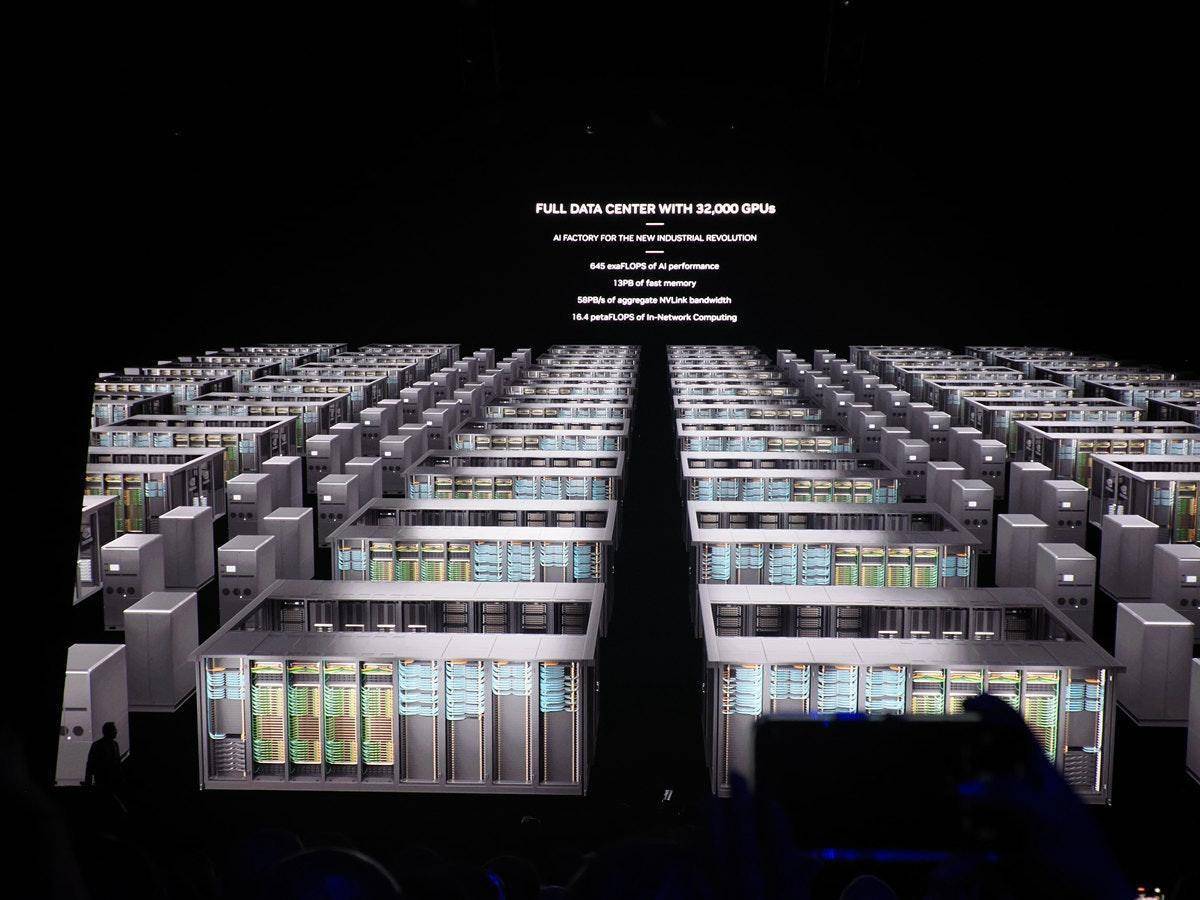

Actuellement, le marché mondial des centres de données représente environ 200 milliards d'euros (environ 787,3 milliards de RMB), et NVIDIA en fait partie. Huang Renxun prédit que ce marché devrait atteindre 1 à 2 000 milliards de dollars à l'avenir.

Analyse du directeur financier de Nvidia Kress :

Les revenus des centres de données au quatrième trimestre fiscal ont été principalement tirés par l'IA générative et la formation associée. Nous estimons qu'environ 40 % des revenus des centres de données au cours de l'année écoulée provenaient de l'IA.

Il y a moins d'un mois, Huang Renxun a également déclaré dans le rapport financier

L’informatique accélérée et l’IA générative ont atteint un point critique, avec une demande croissante dans les entreprises, les secteurs et les pays du monde entier.

En effet, la personnalisation n'est pas exclusive à NVIDIA, mais à l'ère de l'IA, rares sont les entreprises capables de fournir des services « de la tête aux pieds », et NVIDIA en fait partie.

Pour que les cochons s'envolent, ils doivent d'abord être face au vent

À l’intersection de la réalité virtuelle, du calcul haute performance et de l’intelligence artificielle, les GPU remplacent même les processeurs en tant que cerveau des ordinateurs IA.

La principale raison pour laquelle l'IA générative a suscité des discussions animées dans diverses industries est qu'elle commence à travailler et à apprendre comme un « humain », depuis le chat, la rédaction, le dessin, la réalisation de vidéos, l'analyse des conditions, la recherche et la synthèse… tout cela. dont des résultats passionnants. Des résultats étonnants nécessitent des quantités astronomiques d'échantillons de données pour les étayer.

Par exemple, si vous vous souvenez du nom « Ai Fan'er », c'est peut-être parce que les informations transmises chaque jour par le compte public ont renforcé votre mémoire en le répétant ; c'est peut-être aussi parce que vous n'avez jamais vu la combinaison de " Ai" et "Fan'er" avant, ce qui est nouveau. Son sens vous laisse une profonde impression ; ou peut-être que le logo orange laisse un symbole visuel unique dans votre esprit.

Chaque petit détail simple consolide l'image de "Faner" dans votre esprit, mais lorsque les informations des médias technologiques nationaux sont mélangées, davantage de symboles sont nécessaires pour approfondir l'impression et éviter toute confusion.

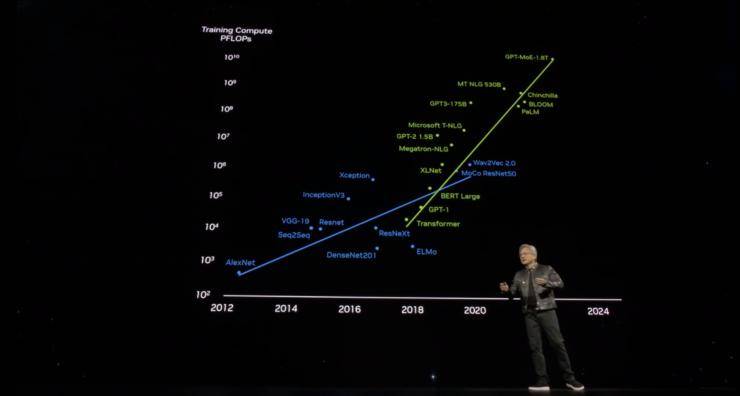

L’apprentissage profond de l’IA suit probablement cette logique, et le GPU est le meilleur choix pour traiter d’énormes quantités d’informations.

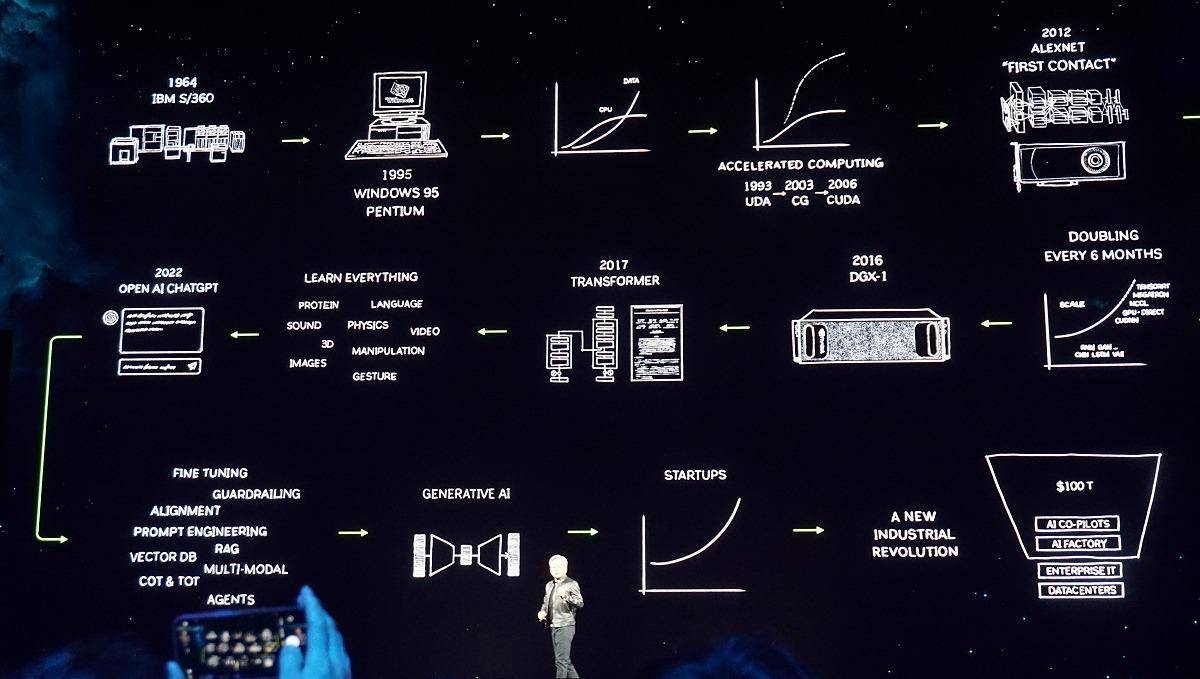

Depuis qu'OpenAI a lancé l'AIGC, la plupart des entreprises connues ont commencé à mettre rapidement leurs propres modèles, petits et grands, sur les étagères. Les voitures intelligentes, les logiciels de traduction, les documents électroniques, les assistants mobiles et même les robots de balayage sont tous dotés d'IA.

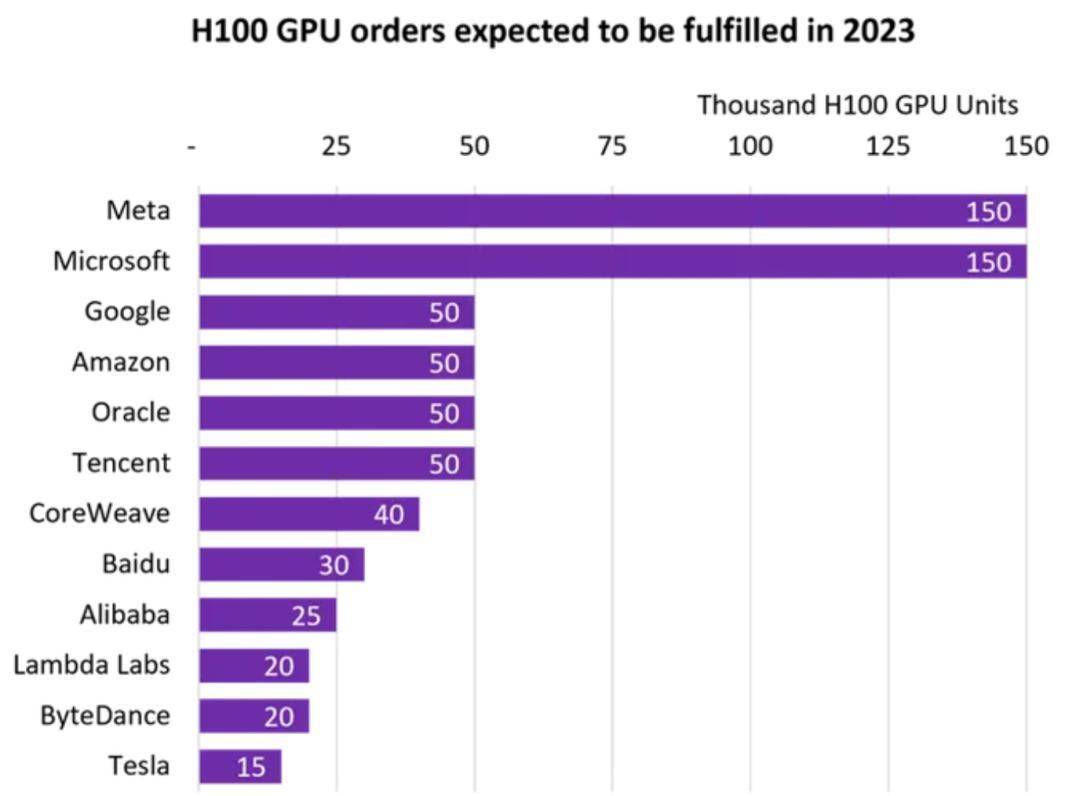

Les GPU sont devenus l’objet d’une concurrence mondiale du jour au lendemain : selon les statistiques de la société de suivi du marché Omdia, Tencent, Alibaba, Baidu, ByteDance, Tesla, Meta et Microsoft ont chacun acheté 150 000 GPU H100 (la puce la plus puissante de l’année dernière).

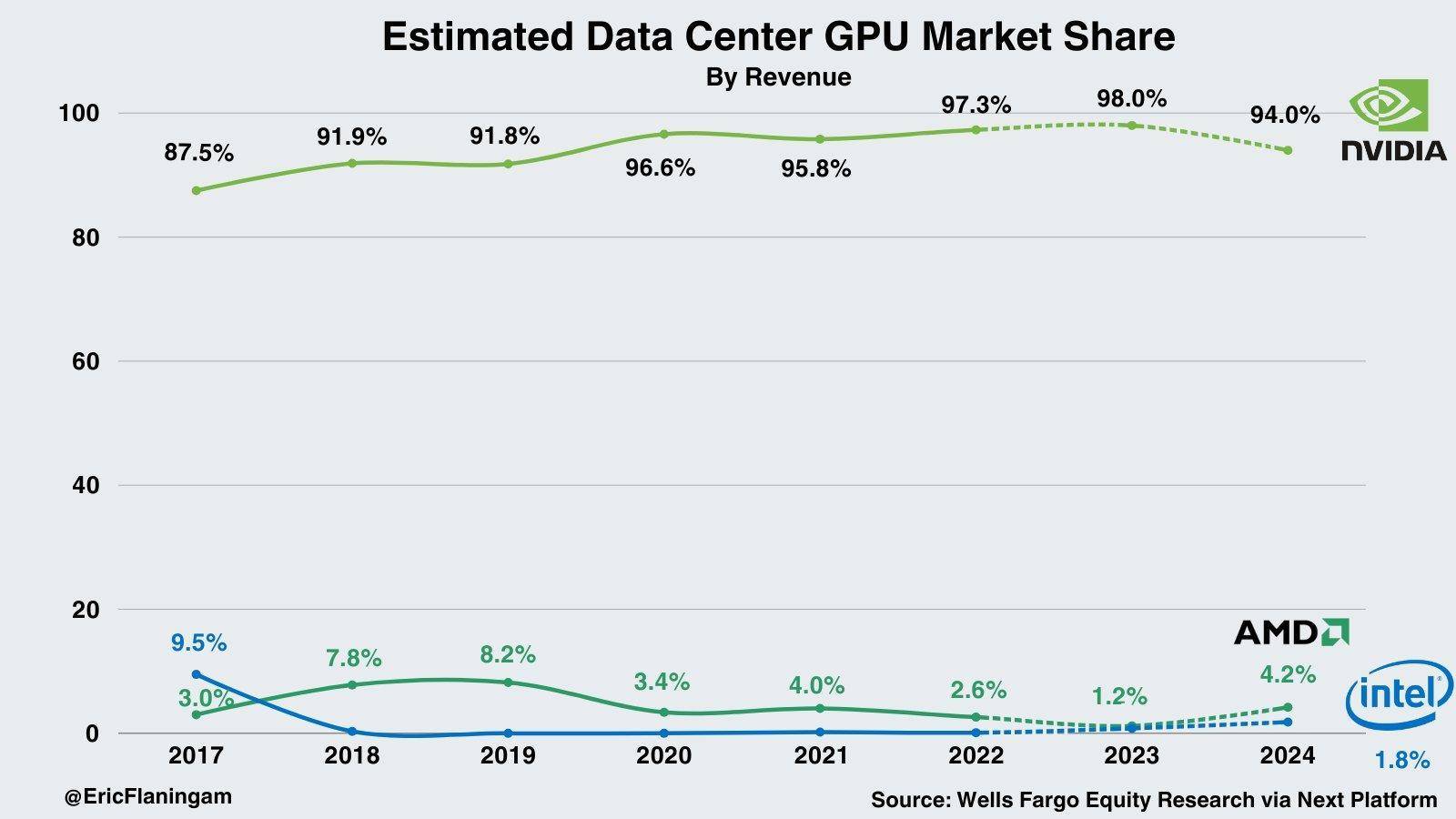

Les principes techniques et l'histoire de l'époque ont conjointement favorisé l'explosion des GPU et créé « l'empire des cartes graphiques » appartenant à Nvidia. Selon les statistiques de Wells Fargo, Nvidia détient actuellement 98 % de part de marché sur le marché de l’IA pour centres de données.

Debout sur la sortie d'air, même un cochon peut voler.

Mais lorsque la part d'une entreprise dans un secteur est proche de 100 %, il doit y avoir une raison aussi importante que d'être à l'avant-garde.

En 1999, NVIDIA a pris les devants en proposant le concept de GPU et a lancé CUDA en 2006. Ce fut un tournant technologique important dans l'histoire du développement de NVIDIA. Il a abaissé le seuil d'application du GPU. Les développeurs peuvent utiliser C/C++ et d'autres langages pour s'appuyer sur le GPU. En écrivant des programmes, le GPU s'est éloigné du seul objectif de traitement d'image et le calcul haute performance est entré dans le monde des cartes graphiques.

La victoire d'AlphaGo en 2016, l'essor du Bitcoin en 2017 et le boom minier, durant cette période, on mise sur le marché de la conduite autonome. Jusqu'à l'avènement des grands modèles d'IA comme ChatGPT en 2023, NVIDIA a inauguré un moment de récolte pour les graines qu'il a semées il y a de nombreuses années.

Le débouché est important, mais une configuration tournée vers l'avenir du marché, des domaines d'application diversifiés, des investissements et des innovations massifs, tout lien déplacé ne créera pas le mythe actuel du marché des scores proches de la perfection.

Cependant, pour Nvidia, la question la plus importante est de savoir comment maintenir sa position de leader à la croisée des temps.

Blackwell constitue une étape clé dans la consolidation des résultats : avant que de nombreux constructeurs n'aient reçu le H100 commandé, les chaînes d'assemblage du B200 et du B100 ont déjà démarré.

Dans son discours, Huang Renxun a réitéré le point qu'il avait avancé dans des rapports financiers précédents, selon lequel « l'informatique à usage général a atteint un goulot d'étranglement ».

Nous avons donc maintenant besoin de modèles plus gros, de GPU plus gros et nous devons empiler les GPU ensemble.

Il ne s’agit pas de réduire les coûts, mais d’augmenter l’échelle.

Il y a une certaine humilité là-dedans, mais bien sûr, il existe également une demande énorme sur le marché.

À l'heure actuelle, le plus grand modèle d'OpenAI compte déjà 1,8 T (billions) de paramètres et doit gérer des milliards de jetons (chaînes). Même avec un GPU de niveau PetaFLOP (pétaflops), la formation d'un modèle aussi grand nécessite 1 000 ans.

Hopper est génial, mais nous avons besoin d'un GPU plus puissant.

La première vague de discussions suscitée par le GTC 2024 s'est lentement estompée ces derniers jours. Il est prévisible que la série de GPU Blackwell, le NVLink de cinquième génération et les moteurs RAS présents à la conférence apporteront davantage lorsqu'ils seront commercialisés. ; il est difficile de prédire combien de surprises et de changements « le point de bascule atteint par l'IA générative » apportera au monde ?

Au moment où éclate l'AIGC et à la veille de l'arrivée de l'AGI, la ribambelle de pétards IA déclenchés par Nvidia n'explose que pour la première fois.

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo