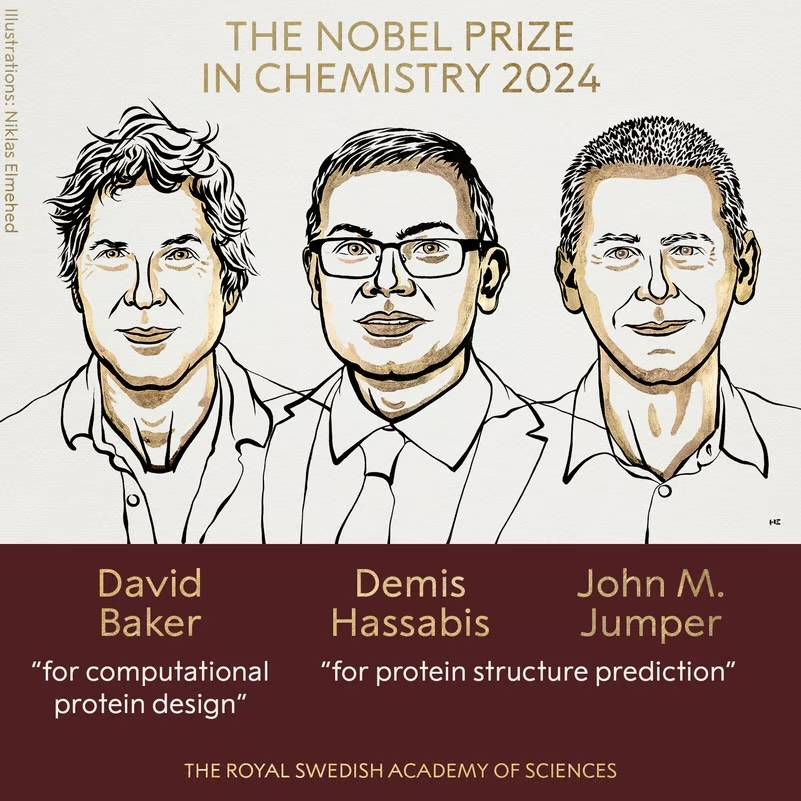

juste! Le PDG de Deepmind remporte le prix Nobel de chimie 2024. En parlant de l’IA, il a déclaré : Il y a une exagération, mais elle est toujours sous-évaluée.

Le prix Nobel de cette année sera remporté par l'IA.

Le prix Nobel de chimie qui vient d'être publié a été remporté conjointement par David Baker, John M. Jumper et Demis Hassabis. Le nom de famille devrait être familier à tout le monde, il s'agit du fondateur de Deepmind.

Il n'y a pas si longtemps, Demis Hassabis était l'invité de la chaîne podcast de DeepMind. Face à Hannah Fry (la nouvelle directrice de l'Institut de mathématiques appliquées de la British Mathematical Society), il a non seulement expliqué les recherches de l'équipe sur la structure des protéines, mais a également abordé le sujet. en profondeur sur le travail de DeepMind, Gemini et ce qui attend AGI, et plus important encore : comment devenir plus équilibré à mesure que la technologie devient plus puissante.

Ce qui suit est un extrait de la conversation, qui a été modifié pour le contenu.

Hannah Fry : Bienvenue sur Google DeepMind, mon hôte est le professeur Hannah Fry. Lorsque nous avons commencé à envisager de produire ce podcast en 2017, DeepMind était un laboratoire de recherche relativement petit axé sur l’IA. Lorsqu’ils ont été rachetés par Google, ils travaillaient sur leur propre projet à Londres. Au dernier trimestre, Google a reconfiguré toute sa structure pour placer son équipe IA au cœur de sa stratégie.

Demis Hassabis : Non, absolument pas (rires).

Hannah Fry : Eh bien, merci beaucoup d'être venu. Je me demande : maintenant que l’intérêt du public pour l’IA explose, votre travail est-il plus facile ou plus difficile ?

Demis Hassabis : Je pense que c'est une arme à double tranchant, n'est-ce pas. C'est définitivement plus difficile parce qu'il y a tellement de contrôle, d'attention et pas mal de bruit dans tout le peloton. En fait, je préfère quand il y a moins de monde et que je peux me concentrer davantage sur la science. Mais c'est aussi une bonne chose maintenant, car cela montre que la technologie est prête à avoir un impact sur le monde de différentes manières et à avoir un impact positif sur la vie quotidienne des gens. Donc je pense que c'est excitant aussi.

Hannah Fry : Êtes-vous surpris de la rapidité avec laquelle l'IA a attiré l'attention du public ? Même si je suppose que vous vous y attendiez aussi.

Demis Hassabis : Oui, exactement, à un moment donné (déjà attendu). Nous travaillons là-dessus depuis des années, voire des décennies. Je pense donc qu’à un moment donné, tout le monde réalisera l’importance de l’IA. Mais c’est quand même assez surréaliste de voir tout cela se concrétiser. Je suppose que c’est l’avènement des chatbots et des modèles linguistiques, après tout, tout le monde utilise le langage et tout le monde peut comprendre le langage. Il s’agit donc d’un moyen simple pour le public de comprendre et éventuellement de juger où se situe l’IA.

Hannah Fry : Je vous ai entendu décrire ces chatbots comme étant « déraisonnablement utiles », et j'aime vraiment ça. Nous parlerons de la technologie des transformateurs dans une minute, et je suppose que c'est cette grande avancée qui nous a donné ces outils. Mais maintenant, je veux d’abord vous demander : qu’entendez-vous par « déraisonnablement utile » ?

Demis Hassabis : Je veux dire, je pense que si l'on remonte 5 ou 10 ans en arrière et dit que nous allons faire quelque chose, la façon dont cela se passera sera de construire une architecture étonnante, puis d'évoluer à partir de là, plutôt que de construire à partir de là. un concept ou une abstraction – c'est un débat que nous aurions eu il y a 5 ou 10 ans, avons-nous besoin d'une manière particulière d'abstraire ? Parce que c’est exactement ce que semble faire le cerveau.

Mais d'une manière ou d'une autre, si vous fournissez suffisamment de données aux systèmes, disons à l'ensemble d'Internet, ils semblent en tirer des leçons et généraliser, pas seulement par cœur, mais, dans une certaine mesure, comprendre réellement à quoi ils ont affaire. Et cela fonctionne d'une manière qui est plutôt perceptuelle, quelque peu irrationnelle, je pense que personne n'aurait imaginé il y a cinq ans que cela fonctionnait.

Hannah Fry : Oui, des choses comme la compréhension conceptuelle et l'abstraction, cela se produit naturellement plutôt que (d'être conçu).

Demis Hassabis : Oui, nous parlions auparavant de choses comme les concepts et la mise à la terre, enracinant le langage dans une expérience du monde réel, peut-être dans un environnement simulé, peut-être dans un robot intelligent incarné, ce qui est vraiment important pour vraiment comprendre le monde qui nous entoure. Le monde est nécessaire. Bien entendu, ces systèmes ne sont pas encore mis en œuvre. Ils ont fait beaucoup d’erreurs et n’avaient pas vraiment de modèle du monde, un bon modèle du monde. Mais ils ont appris plus que ce à quoi on s’attendait simplement en apprenant la langue.

Hannah Fry : Nous devrons peut-être encore expliquer ce qu'est l'ancrage pour les téléspectateurs qui ne le savent pas. Parce que c'est un concept très important.

Demis Hassabis : Bien sûr, c’est la raison pour laquelle le système classique de recherche sur l’IA a été établi dans des endroits comme le MIT dans les années 1980 et 1990. Vous pouvez les considérer comme des bases de données géantes connectées à d’autres mots. Le problème est que vous pouvez dire que "un chien a des pattes" existe dans la base de données, mais lorsque vous lui montrez une photo d'un chien, il ne sait pas que la collection de pixels pointe vers cette phrase. C’est le problème auquel les travaux de mise à la terre doivent faire face. Vous avez cette représentation abstraite de symboles, mais dans le monde réel – le monde réel désordonné – qu’est-ce que cela signifie réellement ? Nous essayons de le comprendre, mais ce n'est jamais tout à fait correct.

Bien entendu, ce n’est pas le cas des systèmes actuels, qui apprennent directement des données. Donc, d’une certaine manière, ils formaient ce lien depuis le début. Mais ce qui est intéressant, c’est que si vous apprenez simplement la langue, en théorie, vous devriez manquer une grande partie des bases dont vous avez besoin. Il s’avère que beaucoup de choses peuvent être déduites.

Hannah Fry : Pourquoi théorique ?

Demis Hassabis : D’où vient cet ancrage ? Ces systèmes, du moins les premiers grands modèles de langage, n’existaient pas vraiment dans le monde réel auparavant. Ils ne sont pas connectés à l'émulateur, ils ne sont pas connectés au bot, ils n'ont même pas accès à Internet. Ils ne sont pas non plus multimodaux au départ, ils n'ont aucune capacité visuelle ou quoi que ce soit, ils vivent simplement dans un espace linguistique, un domaine abstrait, il est donc plutôt surprenant qu'ils puissent déduire quelque chose sur le monde réel à partir de ces choses.

Hannah Fry : Si les gens s'impliquent et interagissent avec le système et disent clairement : « C'est une réponse nulle », « C'est une bonne réponse », cela peut donner une perception.

Demis Hassabis : Exactement, donc certainement si les choses tournent mal, cela est dû en partie au manque de fondement dans les premières versions. Par exemple, si vous interrogez un chien sur la façon dont il aboie et qu'il répond de manière incorrecte, vous le corrigerez si vous donnez votre avis. Une partie des retours provient de nos propres connaissances, qui s’infiltrent peu à peu dans le modèle.

Hannah Fry : Je me souviens d'avoir vu un très bon exemple de cela, entre « traverser la Manche » et « traverser la Manche à pied ».

Demis Hassabis : Oui, c'est ce genre de chose, s'il répond mal, vous lui dites que c'est faux, et ensuite il doit comprendre, vous ne pouvez pas traverser la Manche à pied.

Hannah Fry : J'aimerais en quelque sorte demander : pensez-vous que l'étape dans laquelle nous nous trouvons actuellement, à ce stade, est-ce que les choses sont surfaites ou sous-faites ? Ou est-ce que cela est exagéré dans la mauvaise direction ?

Demis Hassabis : Je pense que c’est plutôt cette dernière solution. Je dirais qu’à court terme, c’était surfait. Certains prétendent être capables de faire toutes sortes de choses qui ne peuvent pas être faites ; il y a toutes sortes de startups et de capital-risque qui les poursuivent, mais ils ne sont pas encore prêts. D’un autre côté, je pense que c’est encore sous-évalué, j’ai toujours l’impression que les gens ne comprennent pas pleinement ce qui va se passer lorsque nous arriverons à l’AGI et au post-AGI. Ce serait une chose tellement énorme, alors comprenez également cette responsabilité. Donc, les deux sont un peu exagérés et je pense que nous traversons un tel cycle.

Hannah Fry : Par rapport à toutes ces startups et capitaux-risques potentiels, vous (l'équipe) vivez et respirez la recherche sur l'IA depuis des décennies et êtes bien placé pour identifier lesquels sont des objectifs réalistes et lesquels ne le sont pas. Mais pour d’autres, comment font-ils la différence entre ce qui est réel et ce qui ne l’est pas ?

Demis Hassabis : Je pense qu'il faut évidemment faire preuve de diligence raisonnable au niveau technique et avoir une certaine compréhension de la technologie et des dernières tendances. Je pense que cela dépend aussi de la personne qui parle, de son parcours, de son degré de technicité. Ont-ils commencé à s’intéresser à l’IA seulement l’année dernière ? Avant l’année dernière, ils s’intéressaient à la crypto-monnaie ? Ce sont peut-être quelques indices.

Lorsqu'un lieu attire soudainement l'attention et que l'argent vient avec, tout le monde craint de rater quelque chose. Cela crée un environnement opportuniste qui est en quelque sorte contraire à celui de ceux d’entre nous qui travaillent de manière profondément technique et scientifique depuis des décennies.

Hannah Fry : Oui, l'un de nos grands sujets est Gemini, et il vient de cette approche scientifique très approfondie. En quoi Gemini diffère-t-il des autres grands modèles de langage publiés par d’autres laboratoires ?

Demis Hassabis : Dès le début, nous voulions que Gemini soit multimodal. Il peut gérer non seulement la langue, mais aussi l’audio, la vidéo, les images, le code, n’importe quoi. La raison pour laquelle nous voulons faire cela est, tout d’abord, que nous pensons que de cette manière, ces systèmes peuvent véritablement comprendre le monde qui les entoure et construire de meilleurs modèles du monde. Cela nous ramène donc au sujet dont nous venons de parler, nous sommes encore en train de construire les fondations, mais cette fois, c'est au-dessus du langage.

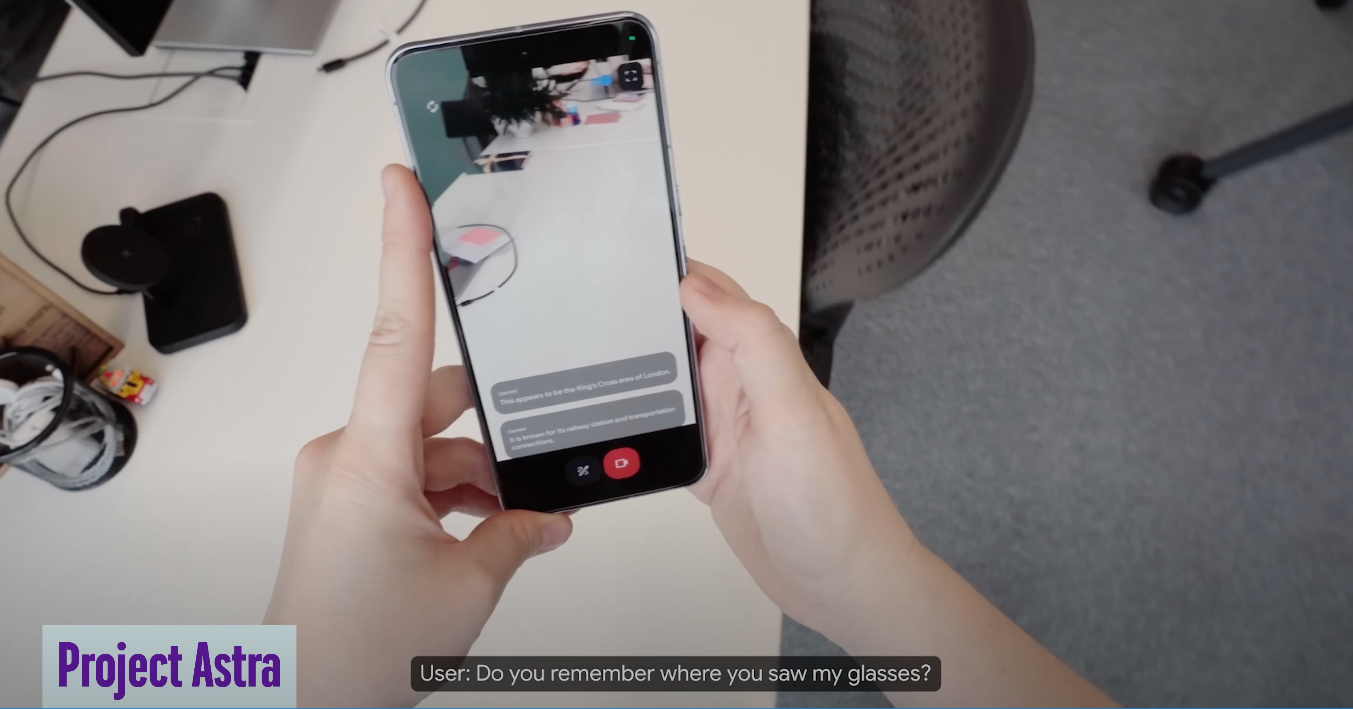

Et puis nous avons également eu cette vision d'avoir un assistant universel et avons prototypé quelque chose appelé Astra, dont je pense que nous parlerons, qui comprend non seulement ce que vous tapez, mais aussi l'environnement dans lequel vous vous trouvez.

Si vous imaginez un assistant personnel ou un assistant numérique, plus il comprend le contexte, plus l'aide qu'il peut fournir sera utile. Nous avons toujours pensé qu'un tel système serait plus utile. Nous avons donc intégré la multimodalité dès le début. C’est un aspect du problème : être intrinsèquement multimodal. Et à l’époque, c’était le seul modèle capable de faire cela. Maintenant, d'autres modèles tentent de rattraper leur retard

Et puis nous avons également de grandes innovations en matière de mémoire, comme le contexte long, qui peut désormais mémoriser un million ou deux millions de jetons, et vous pouvez les considérer à peu près comme la mémorisation d'un million ou deux cents milliers de mots. Vous pouvez lui confier une œuvre comme Guerre et Paix ou même, grâce à la multimodalité, vous pouvez désormais lui confier une vidéo entière, un film entier ou une conférence, et lui faire répondre à des questions ou trouver dans le flux vidéo le contenu dont vous avez besoin.

Hannah Fry : Je me souviens que vous avez donné un exemple d'Astra vous aidant à vous rappeler où vous mettez vos lunettes. Mais je suis curieux de connaître le développement de ces technologies. S'agit-il simplement d'une version avancée de ces anciennes lunettes Google ?

Demis Hassabis : Bien sûr, Google a une longue histoire de développement d'appareils de type Glass, qui remonte en fait à environ 2012. Ils sont donc très en avance dans ce domaine, mais ce qui manque probablement, c'est ce type de technologie qu'Astra représente. Grâce à cette technologie, vous pouvez véritablement comprendre un agent intelligent ou un assistant intelligent qui comprend ce qu'il voit. Nous sommes enthousiasmés par les assistants numériques qui peuvent vous accompagner et comprendre le monde qui vous entoure. Lorsque vous l’utilisez, cela semble être une utilisation très naturelle.

Hannah Fry : D'accord, je veux revenir un peu sur les origines de Gemini. Il vient de deux départements différents, n'est-ce pas.

Demis Hassabis : Oui, nous avons effectivement fusionné les deux départements de recherche d'Alphabet l'année dernière. En d'autres termes, fusionner DeepMind et Google Brain d'origine en un super département, réunissant tous les meilleurs talents de notre entreprise et de Google, et combinant les meilleures connaissances dans toutes les recherches, en particulier dans l'aspect des modèles de langage. Nous avons des projets comme Chinchilla et Gopher, qui ont construit les premiers modèles de langage comme Palm et Lambda, chacun ayant ses propres forces et faiblesses. Nous les avons tous réunis pour former Gemini, le premier projet phare lancé par l'équipe combinée. Une autre chose importante est que nous rassemblons également toutes les ressources informatiques pour faire des formations à très grande échelle et centraliser les ressources informatiques. Donc je pense que c'est vraiment cool.

Hannah Fry : Je pense que les objectifs de Google Brain et DeepMind sont différents à bien des égards, n'est-ce pas ?

Demis Hassabis : En effet. Je pense que les deux se concentrent sur la pointe de l’IA, et même s’il existe déjà beaucoup de collaboration au niveau des chercheurs individuels, peut-être pas tellement au niveau stratégique. Aujourd’hui, après la fusion, je décris Google DeepMind comme la « salle des machines » de Google. Nous avons en réalité plus de similitudes que de différences dans notre manière de travailler. Nous continuons de maintenir et de doubler nos atouts en recherche fondamentale. Par exemple, d’où viendra l’architecture Transformer de nouvelle génération ? Nous voulons l'inventer. De toute évidence, Google Brain a inventé l'architecture de la génération précédente, et nous l'avons combinée avec l'apprentissage par renforcement profond dont nous avons été les pionniers. Je continue de penser qu’il faudra davantage d’innovation à l’avenir, et je crois que nous pouvons y parvenir, comme nous l’avons fait au cours des 10 dernières années, ce qui est passionnant.

Hannah Fry : Revenons donc au Gemini lui-même, quelle est sa qualité par rapport aux autres modèles ?

Demis Hassabis : Je pense qu'il existe certains critères [qui témoignent de ses capacités], mais ce n'est pas le problème, le problème est que l'ensemble du domaine a besoin de meilleurs critères. Il existe des références académiques bien connues, mais elles sont désormais un peu saturées et ne permettent pas vraiment de distinguer les différences subtiles entre les différents modèles haut de gamme. Je dirais qu'il y a trois modèles qui sont à l'avant-garde en ce moment : notre Gemini, le GPT d'OpenAI et le Claude d'Anthropic. Bien entendu, il existe d’autres bons modèles, comme ceux développés par Meta, Mistral et d’autres sociétés, qui ont leurs propres atouts dans différents domaines. Selon vos besoins, par exemple, Claude peut être plus fort pour l'encodage, GPT peut être meilleur pour le raisonnement, et en termes de traitement de la mémoire, de contexte long et de compréhension multimodale, c'est Gemini. Bien entendu, nous améliorons tous constamment nos modèles. Donc, étant donné que Gemini n’a qu’un an, je pense que nous sommes sur une très bonne trajectoire. La prochaine fois que nous aborderons ce sujet, j'espère que nous serons au premier plan, car nous le sommes.

Hannah Fry : Il semble qu'il y ait encore un long chemin à parcourir, je veux dire, il y a encore certaines choses pour lesquelles ces modèles ne sont pas très bons.

Demis Hassabis : Oui, certainement. En fait, c’est le grand débat du moment. Ce dernier ensemble de choses semble donc émerger d’une technologie inventée il y a 5 ou 6 ans. Le problème, c'est qu'il leur manque encore des tonnes de choses. Donc, en fait, vous savez, ils produisent ce que nous appelons des hallucinations. Ils ne sont pas non plus très doués en planification.

Hannah Fry : Quel sens envisagent-ils ? Je veux dire.

Demis Hassabis : Oui, c'est là que se situe le débat en ce moment. Cette série récente de développements s’appuie en réalité sur une technologie inventée il y a 5 ou 6 ans. Le problème, cependant, c'est qu'il leur manque encore beaucoup de choses. Par exemple, il y a des problèmes avec leur exactitude factuelle et nous savons qu’ils peuvent halluciner. De plus, ils ne sont pas assez bons en planification.

Hannah Fry : Que signifie exactement « planification » ?

Demis Hassabis : Par exemple, en termes de planification à long terme, vous lui donnez un objectif, et ils ne peuvent pas encore effectuer d'opérations à votre place dans le monde réel. Il s’agit donc encore de systèmes de questions et réponses très passifs. Vous devez les activer en posant des questions, puis ils donnent une sorte de réponse, mais ils ne peuvent pas vraiment résoudre le problème à votre place.

Si vous vouliez qu'il s'agisse d'un assistant numérique, vous pourriez dire « réservez-moi des vacances en Italie et organisez tous les restaurants, musées, etc. » Même s'il connaissait vos préférences, il ne serait pas en mesure de les réserver. . Billets et traitement de ces questions. Il ne peut donc pas le faire actuellement.

Mais je pense que nous sommes dans la prochaine ère – ces systèmes qui ont un comportement plus agentique, ce que nous appellerions des systèmes d'agents ou des systèmes qui ont la capacité d'agir en tant qu'agents. C'est ce dans quoi nous excellons. C'est ce que nous avons fait avec tous nos agents de jeu, AlphaGo et d'autres projets dont nous avons parlé dans le passé. Nous associons ces ouvrages prestigieux à de nouveaux modèles multimodaux à grande échelle. Je pense que c’est là que ira la prochaine génération de systèmes. Vous pouvez considérer cela comme une combinaison d’AlphaGo avec Gemini.

Hannah Fry : Oui, je pense qu'AlphaGo est déjà très bon.

Demis Hassabis : Oui, c'est très bon en planification, juste dans le monde du jeu vidéo bien sûr. Nous devons donc l’intégrer dans des domaines communs tels que le travail quotidien et la langue.

Hannah Fry : Vous venez de mentionner que Google DeepMind est désormais la salle des machines de Google. C'est un changement assez important, j'ai également demandé il y a quelques années : Google prend-il un pari assez important ?

Demis Hassabis : Oui, je pense que oui. Je pense que Google a toujours compris l'importance de l'IA. Sundar a déclaré lorsqu'il a pris ses fonctions de PDG que Google était une entreprise axée sur l'IA. Nous avons discuté de cette question au début de son mandat. Il a vu le potentiel de l'IA comme le prochain grand changement de paradigme après l'Internet mobile, encore plus grand. Mais je pense qu'au cours des deux dernières années, nous avons vraiment commencé à être à la hauteur de cette philosophie, non seulement du point de vue de la recherche, mais également du point de vue du produit et d'autres aspects. C'est très excitant et je pense que c'est le bon choix pour nous de coordonner tous les talents et de faire de notre mieux pour aller de l'avant.

Hannah Fry : Et l'inverse ? Parce que je pense que, du point de vue de DeepMind, avec ses fortes capacités de recherche, cela signifie-t-il qu'il est désormais devenu la « salle des machines » de Google et que vous devez accorder plus d'attention aux intérêts commerciaux plutôt qu'à la recherche scientifique pure ?

Demis Hassabis : Nous devons accorder davantage d'attention aux intérêts économiques, ce qui fait désormais partie de nos responsabilités. Il y a cependant quelques points à aborder.

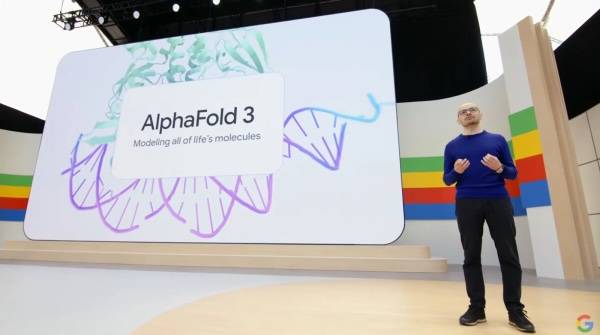

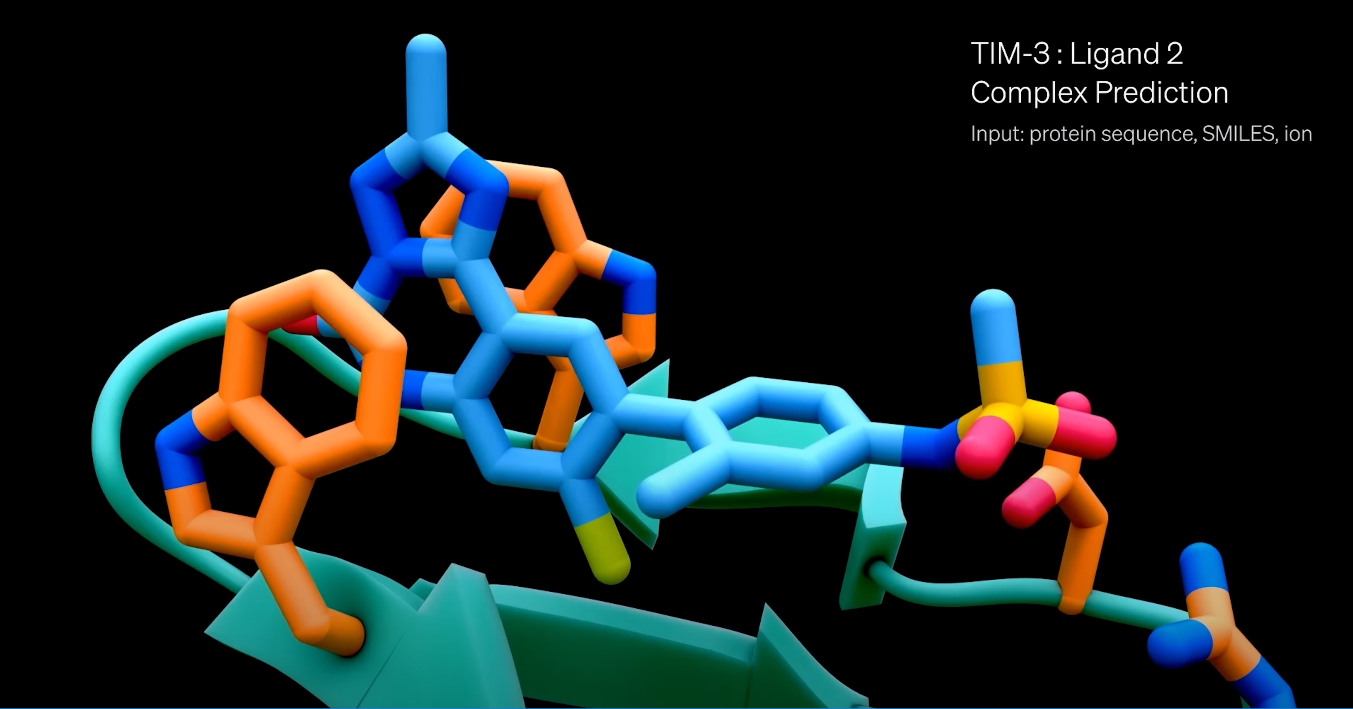

Tout d’abord, nous poursuivons toujours nos recherches scientifiques, comme AlphaFold 3 qui est sorti récemment, et nous doublons notre investissement dans ce domaine. Je pense qu'il s'agit d'une fonctionnalité unique de Google DeepMind. Même nos concurrents la considèrent comme la « richesse universelle » apportée par l'IA. Les progrès vont très bien sur ces fronts. Nous avons également étendu Isomorphic à la découverte de médicaments, ce qui est très excitant. Nous continuerons à faire progresser ces efforts.

En plus de créer de grands modèles, Gemini, etc., nous construisons également une équipe produit pour apporter toutes ces technologies étonnantes aux différentes plates-formes de Google. C'est un privilège incroyable dans la mesure où ce que nous inventons peut avoir un impact immédiat sur un milliard de personnes, et c'est vraiment motivant.

En fait, il existe désormais une plus grande convergence entre le développement de technologies d’IA destinées à être utilisées dans des produits et celles requises pour la recherche pure en AGI. Il y a cinq ans, vous auriez peut-être besoin de créer une IA spéciale pour un produit. Il reste encore du travail à faire sur des produits spécifiques, mais cela ne représente peut-être que 10 % de l'effort. Ainsi, maintenant que la tension entre le développement de produits d’IA et la construction d’AGI a disparu, je dirais que 90 % du plan de recherche est le même.

Enfin, bien sûr, si vous lancez un produit et le mettez en pratique, vous en apprendrez beaucoup. L'utilisation par les utilisateurs peut révéler beaucoup de choses qui ne correspondent pas exactement à votre jugement interne, vous pouvez donc mettre à jour et améliorer l'étude, ce qui est très utile.

Hannah Fry : Tout à fait d'accord. Dans ce podcast, nous parlons davantage des avancées réalisées grâce à l’application de l’IA à la science. Mais je voudrais poser une question sur la date à laquelle les résultats seront rendus publics. Au sein de DeepMind, ces outils, comme les grands modèles de langage, sont davantage utilisés à des fins de recherche que considérés comme des produits commerciaux potentiels, n'est-ce pas.

Demis Hassabis : Oui, exactement. Nous avons toujours pris la responsabilité et la sécurité très au sérieux, depuis nos débuts en 2010, et Google a adopté certaines de nos chartes éthiques dans ses principes d'IA. Nous sommes donc très alignés sur Google en tant que l'un des leaders dans ce domaine et nous nous engageons à déployer la technologie de manière responsable.

Il est vraiment intéressant maintenant de commencer à commercialiser des produits dotés de l’IA générative. Nous apprenons rapidement, ce qui est une bonne chose car la technologie en est encore à un stade relativement peu risqué. À mesure que la technologie devient plus puissante, nous devons être plus prudents. Apprendre à tester la technologie d’IA générative est important pour les équipes produit. Cela diffère des tests de technologies normales car l’IA générative ne fait pas nécessairement toujours la même chose. C'est presque comme tester un jeu en monde ouvert, et les choses que vous pouvez essayer sont presque illimitées. Alors, comment mener une équipe rouge devient très intéressant.

Hannah Fry : Dans ce cas, l'équipe rouge est-elle en compétition contre vous-mêmes ?

Demis Hassabis : Oui, le red teaming consiste à mettre en place une équipe indépendante de l'équipe de développement pour effectuer des tests de résistance et essayer de briser la technologie de toutes les manières possibles. En réalité, vous avez besoin d'outils pour automatiser ces tests, car même si des dizaines de milliers de personnes participent, cela ne se compare toujours pas à l'utilisation réelle par des milliards d'utilisateurs. Lorsque la technologie sera lancée, les utilisateurs essaieront diverses choses. C'est donc amusant d'appliquer ces apprentissages à l'amélioration de nos processus afin de garantir que les futures versions se déroulent aussi bien que possible. Nous devons le faire par étapes, en commençant par une phase expérimentale, puis une bêta fermée, et enfin une sortie progressive, tout comme nous l'avons fait avec les versions de jeux précédentes. Apprenez chaque étape du processus.

En outre, nous devrions également utiliser davantage l’IA elle-même pour nous aider à effectuer des tests en équipe rouge, à découvrir automatiquement certaines erreurs ou à effectuer une classification préliminaire, afin que nos développeurs et testeurs humains puissent se concentrer sur la gestion de ces situations complexes.

Hannah Fry : L'une des choses qui est vraiment intéressante, c'est que vous vous trouvez maintenant dans un espace plus incertain. Si la probabilité que quelque chose se produise est très faible, mais si vous essayez suffisamment de fois, quelque chose finira par mal tourner. Je pense qu'il y a peut-être eu quelques erreurs médiatisées.

Demis Hassabis : Oui, c'est pourquoi j'ai mentionné que les équipes produit s'adaptent à cette approche de test. Bien qu’ils aient testé ces systèmes, ils étaient par nature aléatoires et incertains. Ainsi, dans de nombreux cas, s'il s'agit d'un logiciel ordinaire, vous pouvez dire que j'ai testé 99,99 % des cas et en déduire que cela suffit. Mais ce n’est pas le cas de ces systèmes génératifs, qui peuvent réagir de toutes sortes de manières inattendues, inattendues et inédites.

Cela peut être difficile si quelqu’un d’intelligent ou d’adversaire, comme un hacker, décide de tester et de repousser ses limites. En raison du caractère aléatoire du système de génération, même s'il contient tout ce que vous lui avez dit auparavant, ils peuvent être dans un état spécial, ou leur mémoire est remplie d'informations spécifiques, de sorte que sa sortie sera anormale. Cela est donc très complexe, mais ce n'est pas infini. Bien qu'il existe des moyens de gérer ces situations, ces solutions sont beaucoup plus complexes et nuancées que les versions technologiques traditionnelles.

Hannah Fry : Je me souviens que vous aviez dit que nous devions considérer cela comme une manière de calculer complètement différente, de l'informatique déterministe que nous comprenons parfaitement à cette méthode de calcul plus compliquée, probabiliste et chargée d'erreurs. Pensez-vous que le public doit ajuster un peu sa réflexion sur les types d'informatique que nous faisons ?

Demis Hassabis : Je pense que oui. Peut-être qu'avant de publier quelque chose, nous pourrions envisager de publier un document de principe ou quelque chose de similaire pour clarifier quelles sont les attentes du système, quel est l'objectif de la conception, quels sont les scénarios applicables et quelles sont les tâches qui ne peuvent pas être accomplies. beaucoup de sens. Nous devons éduquer les utilisateurs, comme dans certains cas, vous pouvez l'utiliser de cette façon, mais n'essayez pas ces autres choses car cela pourrait ne pas fonctionner. Je pense que c'est un domaine dans lequel nous devons faire mieux et dans lequel les utilisateurs doivent être plus expérimentés. C'est en fait assez intéressant.

C’est peut-être la raison pour laquelle les chatbots sont apparus de façon quelque peu inattendue. Même ChatGPT a surpris OpenAI. Nous avons notre propre chatbot, tout comme Google. En les regardant, j’ai aussi remarqué qu’ils ont encore de nombreux défauts et souffrent encore d’erreurs, d’illusions et de bien d’autres problèmes. Mais ce que nous n’avions pas réalisé, c’est que malgré cela, il existe encore de très bons cas d’utilisation des chatbots que les gens trouvent très utiles, comme résumer des documents, rédiger des e-mails, remplir des formulaires, etc. Dans ces scénarios d'utilisation, cela ne dérange pas les utilisateurs, même s'il y a quelques erreurs mineures, car elles peuvent être facilement corrigées et gagner beaucoup de temps. C'est la surprise que l'on trouve lorsqu'on met ces technologies entre les mains du grand public. Malgré les nombreux défauts connus de ces systèmes, il existe encore des cas d'utilisation précieux.

Hannah Fry : La prochaine question que je souhaite poser concerne l'open source. Parce que lorsque la technologie est entre les mains du grand public, comme vous l’avez mentionné, des choses vraiment étonnantes se produisent. Je sais que DeepMind a mené de nombreux projets de recherche en open source dans le passé, mais j'ai l'impression que cela a changé avec le temps.

Demis Hassabis : Nous avons toujours été très favorables à l'open source et à la science ouverte. Comme vous le savez, nous open source et publions presque tous les projets de recherche que nous réalisons, y compris des projets comme Transformer et AlphaGo, que nous publions dans les revues Nature et Science. AlphaFold est également open source, comme nous en avons discuté la dernière fois.

En effet, le partage d’informations est le moyen par lequel la technologie et la science progressent rapidement, c’est pourquoi nous pensons presque toujours qu’il est bénéfique de le faire. C’est ainsi que progresse la science en général. La seule exception concerne l’IA ou l’AGI puissante, où nous sommes confrontés au problème de la technologie à double usage.

La question est donc de soutenir tous les bons cas d’utilisation et ces scientifiques et technologues bien intentionnés, et de les encourager à s’appuyer sur ces idées, à les critiquer, etc. C’est le moyen le plus rapide pour faire progresser la société. Cependant, le problème est de savoir comment limiter simultanément l’accès aux acteurs malveillants qui pourraient utiliser ces systèmes à des fins indésirables, les utiliser à mauvais escient, les transformer en systèmes d’armes, etc.

Ces systèmes généraux peuvent en effet être exploités de cette manière, d'autres manières. Cela ne ferait pas de mal de le faire aujourd’hui, car je ne pense pas que le système actuel soit suffisamment robuste. Mais après deux ou trois ans, surtout quand on commence à ressembler à des systèmes d'agents automatisés ou à un comportement d'agent, si ces systèmes sont abusés par certaines personnes ou même par des escrocs, cela peut causer de graves dommages. Je pense donc qu'en tant que collectif, nous devons réfléchir à ce que cela signifie pour l'open source.

Peut-être que les modèles de pointe nécessitent une inspection plus approfondie, peut-être un an ou deux après leur sortie avant d'être open source. C'est le modèle que nous suivons actuellement car nous avons nos propres modèles open source, comme Gemma, qui sont plus petits et ne sont donc pas des modèles de pointe. Bien que leurs capacités soient bien comprises à l’heure actuelle, ils restent très utiles aux développeurs car ils peuvent également être facilement exécutés sur des ordinateurs portables. En résumé, les capacités de ces modèles sont toujours précieuses, mais pas aussi puissantes que les derniers modèles de pointe (comme le modèle Gemini 1.5). Je pense donc que nous finirons probablement par adopter cette approche où nous aurons des modèles open source, mais ils seront en retard d'environ un an par rapport aux modèles de pointe afin que nous puissions vraiment évaluer leurs performances. dans un environnement ouvert.

Hannah Fry : Les capacités des modèles les plus récentes et les plus avancées pourraient en effet repousser les limites.

Demis Hassabis : Nous pouvons examiner les capacités et les limites de ces modèles. Le problème avec l’open source est que si quelque chose ne va pas, vous ne pouvez pas l’annuler. Avec un modèle propriétaire, vous pouvez désactiver l’accès si des acteurs malveillants commencent à l’utiliser de manière inappropriée. Dans des cas extrêmes, vous pouvez le désactiver complètement. Mais une fois que vous avez ouvert quelque chose, vous ne pouvez plus le reprendre. Il s'agit d'une porte à sens unique, vous devez donc être très prudent lorsque vous êtes open source.

Hannah Fry : Alors, est-il possible de contrôler AGI dans les limites d'une organisation ?

Demis Hassabis : Je ne sais pas encore comment faire ça. Surtout lorsqu’il s’agit d’une puissante intelligence artificielle au niveau de l’AGI, qui est une IA similaire aux niveaux humains.

Hannah Fry : Quelle est la place des institutions dans l’écosystème idéal que vous décrivez ? Si nous atteignons le stade où l’AGI soutient toute la recherche scientifique, les institutions traditionnelles auront-elles encore de la valeur ?

Demis Hassabis : Je pense que les institutions comptent toujours. Avant d’atteindre l’AGI, une collaboration doit avoir lieu entre la société civile, le monde universitaire, le gouvernement et les laboratoires industriels. Je crois sincèrement que c’est la seule façon d’arriver à ce stade.

Hannah Fry : L'informaticien Stuart Russell m'a dit un jour qu'il craignait un peu qu'une fois que nous aurons atteint l'AGI, nous pourrions nous retrouver dans une situation où nous ressemblerions tous aux princes d'antan – des gens qui n'ont pas besoin de se connecter. Des gens qui sont assis. sur le trône et ne faites aucun travail, vivez simplement une vie de luxe effréné, sans aucun objectif.

Demis Hassabis : Oui, c'est une question intéressante. Peut-être qu'il ne s'agit pas seulement d'AGI, mais plutôt de superintelligence artificielle (Artificial Superintelligence) ou d'un autre concept, parfois les gens l'appellent ASI (Artificial Superintelligence). Dans ce cas, nous pourrions connaître un état fondamental d’abondance, dans lequel nous pourrons avoir plus de liberté dans ce que nous choisissons de faire, à condition que nous veillions à ce que les ressources soient distribuées de manière équitable et rationnelle.

Le sens devient alors une grande question philosophique. Je pense que nous aurons besoin de philosophes, voire de théologiens et de spécialistes des sciences sociales, pour commencer à réfléchir à cela. Qu'est-ce qui apporte du sens ? Je pense toujours que la réalisation de soi est importante. Je ne pense pas que nous allons tous rester assis là à méditer, peut-être à jouer à des jeux informatiques, qui sait ? Mais est-ce vraiment mauvais ? Peut-être devons-nous aussi redéfinir ce qu’est une « bonne » vie.

Hannah Fry : Je pense que les princes d’autrefois n’auraient rien ressenti de mal.

Demis Hassabis : Si vous regardez ceux qui pratiquent des sports extrêmes, comme l’ascension du mont Everest, ce sont tous des défis aux limites humaines. Les motivations derrière ces activités peuvent être liées à la recherche de sens et à la réalisation de soi. Comme vous l’avez mentionné, même si ces questions n’ont pas encore été abordées en profondeur, elles changeront considérablement notre monde.

Même si les technologies les plus avancées ont apporté de grands changements, comme le traitement des maladies, la résolution des problèmes énergétiques, la réponse au changement climatique, etc., nous sommes toujours confrontés au problème profondément enraciné du « sens ». Cette recherche de sens ne se situe pas seulement au niveau technique, mais implique également les niveaux philosophique, psychologique et même culturel. Nous devons réfléchir à la façon dont l’existence et le comportement humains seront redéfinis dans le cadre du futur boom technologique.

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo