Zuckerberg, un nouveau produit qui ne sortira pas, explore à nouveau la forme ultime des lunettes IA

Depuis que Zuckerberg a renommé FaceBook en Meta, l'entreprise est complètement en concurrence avec les lunettes.

Il y a un peu de connaissance qui est à la fois chaude et froide. Le nom Meta est tiré des quatre premières lettres de « métaverse ». Lorsque le nom a été changé en 2021, Zuckerberg lui-même a dit avec beaucoup d'assurance :

Le Metaverse touchera un milliard de personnes au cours de la prochaine décennie, et le Metaverse touchera tous les produits que nous développons.

▲ Photo de : Google

Quatre années ont passé et le Metaverse est devenu un élément fréquent dans les romans de science-fiction, les animations créatives et les œuvres cinématographiques et télévisuelles, mais il s'éloigne de plus en plus du monde réel. Les rares choses qui attirent l'attention des gens sont ces choses ennuyeuses qui font parfois la une des journaux sur les recherches de tendances et utilisent l'apparence du Metaverse et des actifs virtuels pour escroquer.

En termes de vulgarisation et de diffusion du métaverse, Meta n'a pas beaucoup changé comme il y a quatre ans, mais ils ont apporté de nombreuses nouveautés intéressantes sur les casques VR/AR, l'entrée du métaverse.

Meta Quest, positionnée comme une nouvelle console de jeu, a ouvert un nouveau monde de jeux interactifs VR. En 2024, la série Meta Quest occupera 73 % des parts de marché, loin devant.

Ray-Ban Meta est devenu un accessoire tendance à l'ère de l'IA. Après deux générations d'efforts en matière de produits, ses livraisons ont officiellement dépassé les 2 millions d'unités en février de cette année. Il intègre des lunettes traditionnelles, des logos de marque, des casques Bluetooth, des assistants vocaux et des caméras Vlog. Il remplit non seulement le rôle décoratif d'une paire de lunettes traditionnelles, mais intègre également discrètement la technologie dans la vie quotidienne.

En apparence, Meta a lancé plusieurs produits à succès sur le marché grand public ; en privé, ils travaillent également discrètement sur la piste toB, et ces lunettes intelligentes destinées aux entreprises et aux institutions professionnelles ont commencé avant même de changer de nom.

L'accord de cinq ans est arrivé et Meta a remis les papiers

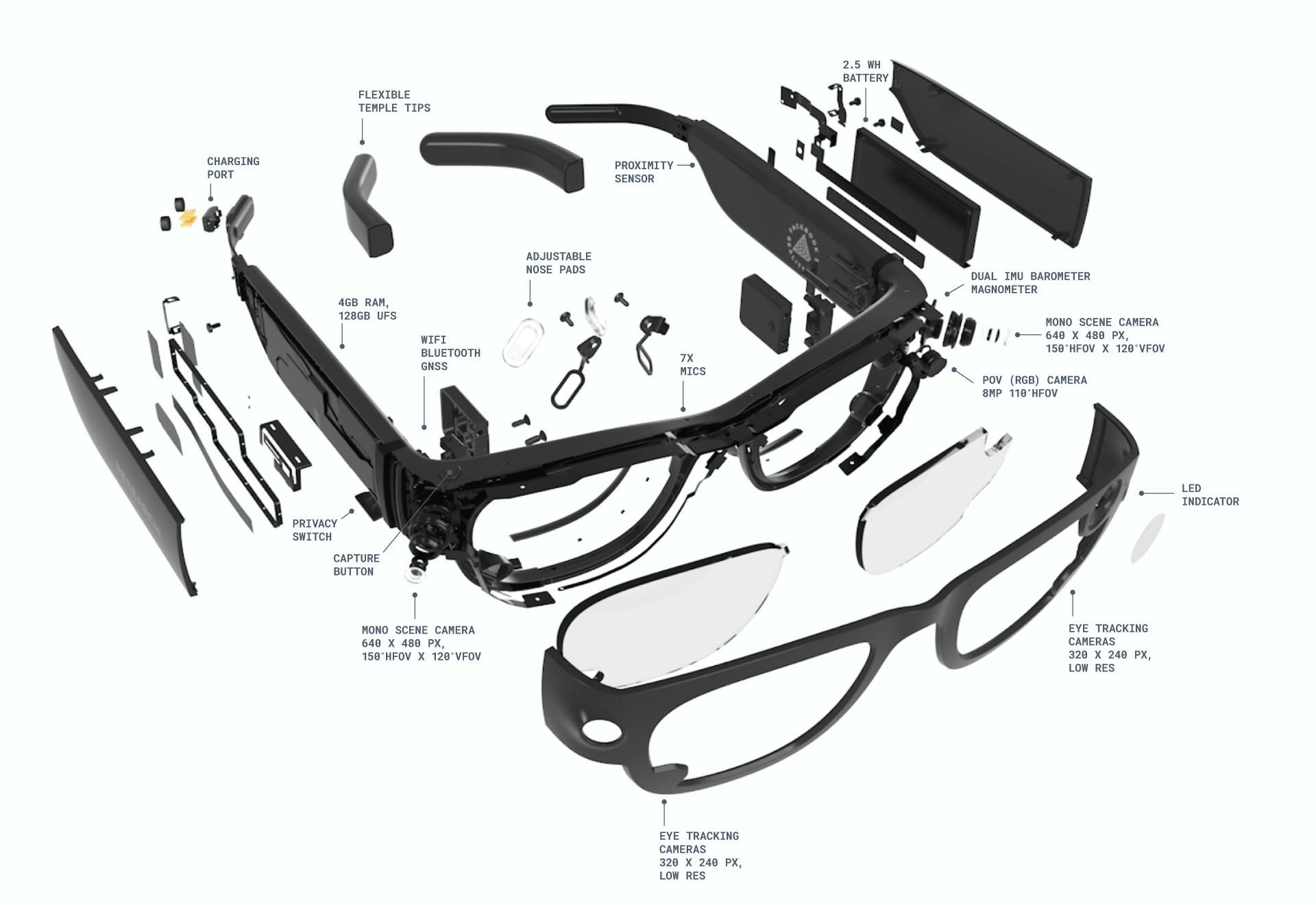

En 2020, Meta a lancé ses premières lunettes intelligentes expérimentales, Meta Aria Gen 1. Par rapport aux lunettes traditionnelles, Aria Gen 1 est légèrement gonflée, notamment les deux branches épaissies, qui sont très visibles.

▲ Photo de : Google

L'énorme apparence n'est pas seulement une décoration, elle contient un grand nombre de capteurs, tels que des caméras RVB, des caméras de suivi de positionnement, des unités de mesure inertielle (IMU), des baromètres, des magnétomètres, etc. La fonction principale de ces composants est de collecter des données visuelles, de mouvement et spatiales du point de vue de la première personne.

Théoriquement, Aria Gen 1 est spécialement conçue pour la recherche sur les systèmes de perception automatique, l'intelligence artificielle et la robotique. En intégrant des capteurs multimodaux, elle aide les chercheurs à surmonter les principaux problèmes techniques des lunettes AR, tels que la perception environnementale, le positionnement spatial, etc.

En ce qui concerne l'expérience réelle, Aria Gen 1 a une mission très lointaine et passionnante :

Imaginez un jour où nous pourrons profiter de tous les avantages d’être connectés sans avoir à baisser la tête et à regarder nos appareils. Imaginez appeler un ami et discuter avec un avatar réaliste de l'autre côté de la table.

Imaginez un assistant numérique suffisamment intelligent pour détecter les dangers de la route, fournir des statistiques lors de réunions de travail, ou encore vous aider à mieux entendre dans des environnements bruyants.

Nous vivons dans un monde où les appareils eux-mêmes disparaissent complètement dans les hauts et les bas de la vie quotidienne.

En tant que prototype de cette expérience et produit de première génération, Aria Gen 1 n'a pas fait grand bruit. Après cinq ans de développement, Meta a officiellement publié Aria Gen 2 cette semaine. Par rapport à la première génération, une mise à niveau complète a été réalisée.

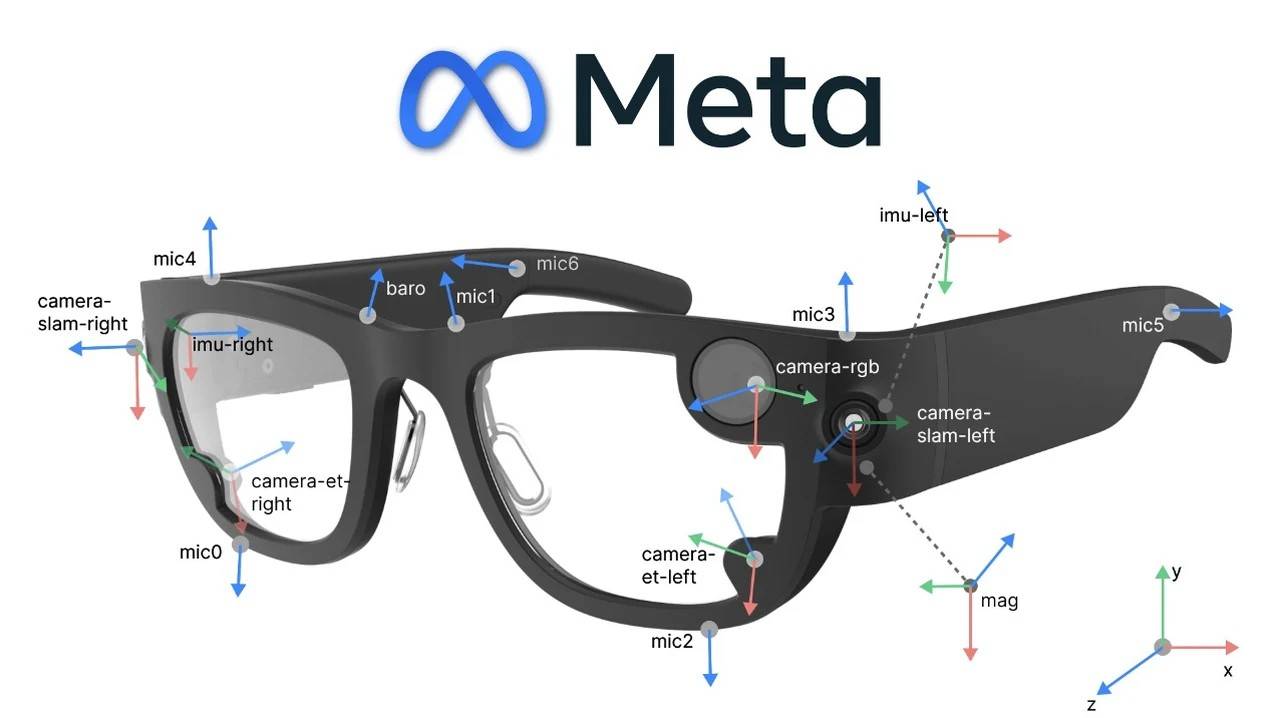

Le changement le plus évident concerne le système de capteurs. La machine de première génération utilise les composants de détection environnementale les plus élémentaires, uniquement des caméras et des capteurs inertiels. Sur cette base, Aria Gen 2 ajoute de nombreux nouveaux accessoires, notamment des caméras RVB, des caméras SLAM 6DOF, des caméras de suivi oculaire, des microphones spatiaux, des IMU, des baromètres, des magnétomètres et des GNSS.

La nouvelle génération de produits dispose notamment de deux capteurs innovants intégrés dans les plaquettes nasales : un capteur PPG pour mesurer la fréquence cardiaque et un microphone de contact pour distinguer la voix de l'utilisateur de celle des spectateurs.

Si l'on compare la première génération à "voir le monde avec seulement des lunettes", on peut dire qu'Aria Gen 2 a tous les sens ouverts. Elle peut percevoir, observer et collecter des informations externes à partir de plus de dimensions, elle peut obtenir des données de plus en plus précises en même temps, et l'efficacité de fonctionnement et d'apprentissage de la machine sera plus élevée.

En outre, il y a un changement qualitatif dans le traitement des données. , c'est très irréprochable.

Aria Gen 2 utilise la puce auto-développée par Meta, qui peut traiter les données côté appareil. La vitesse de réponse est très rapide, elle n'est pas limitée par le réseau et l'expérience interactive a également été considérablement améliorée.

D'une manière générale, les équipements dotés de puces auto-développées ont des capacités informatiques finales, mais cela augmente également le poids de l'équipement. Mais Meta parle de lui-même avec les données, et ils ont été très occupés au cours des cinq dernières années : Aria Gen 1 pèse 98 g et Aria Gen 2 pèse 75 grammes. Augmentez la dose sans augmenter le poids et faites-en l'expérience longtemps sans prendre de poids.

Aria Gen 2 est également connue pour ses méthodes interactives. Basée sur l'interaction vocale de première génération, la machine de deuxième génération a ajouté « suivi oculaire + geste + opération de contact ». L'interaction vocale est très directe et le chemin de récupération sera considérablement raccourci, mais elle ne convient pas à tous les scénarios de la vie, comme les stations de métro aux heures de pointe et les bureaux ultra-silencieux.

Il va de soi qu'à mesure que le nombre de capteurs et de fonctions interactives augmente, la durée de vie de la batterie sera affectée. La puce auto-développée affecte la durée de vie de la batterie de l'Aria Gen 2, mais de manière positive. Les autorités affirment qu'il peut durer jusqu'à 6 à 8 heures d'utilisation. Sur la base de la durée d'utilisation actuelle des casques sans fil, Aria Gen 2 peut essentiellement disposer de fonctions intelligentes tous temps.

Une fois les bases matérielles posées, il y aura plus de possibilités d'expériences d'utilisation ultérieures. La mise à niveau d'Aria Gen 2 reflète les deux orientations stratégiques de Meta pour la mise en œuvre de la technologie AR :

La première est l'intégration furtive : réduire la présence de l'appareil grâce à une conception légère et au masquage des capteurs (par exemple, lorsque le voyant de la caméra est éteint, l'apparence est similaire à celle des lunettes ordinaires) ; la seconde passe par un écosystème ouvert qui fournit des interfaces API sous-jacentes et des capacités d'extension modulaires pour encourager les universitaires à développer des boîtes à outils personnalisées et à accélérer la transformation technologique.

Par conséquent, les scénarios d'application d'Aria Gen 2 sont également passés de la navigation intérieure et de la recherche fondamentale en RA vers des domaines plus dimensionnels. Les soins médicaux, l'industrie, l'urbanisme, etc. pourraient tous devenir le terrain de croissance d'Aria Gen 2.

À ce stade, résumons les progrès et l’importance d’Aria Gen 2 :

- Mises à niveau du matériel de perception pour réaliser la fusion des données biologiques et une compréhension approfondie de l'environnement ;

- Équipé d'une puce auto-développée pour améliorer les performances en temps réel et prendre en charge les scénarios extérieurs sans réseau ;

- Enrichir les méthodes d'interaction, réduire les interférences acoustiques et s'adapter aux environnements expérimentaux complexes ;

- La durée de vie de la batterie couvre toute la journée, prolongeant la durée d'utilisation continue et améliorant le confort de port ;

- Élargissez les scénarios d’application et promouvez l’intégration et la standardisation des technologies interdisciplinaires.

Le « côté obscur » de Zuckerberg

Si vous avez lu l’interprétation et l’introduction de Meta Aria, vous êtes encore un peu confus quant à son application sur le marché de consommation. C’est normal, car Meta a clairement déclaré que ce produit « ne sera pas vendu aux consommateurs ». Alors vous voudrez peut-être demander à quoi sert-il ? Pour clarifier le but de sa création, il faut remonter il y a plus de dix ans.

En 2014, Zuckerberg a expérimenté les derniers équipements VR et divers scénarios de jeu au Stanford Virtual Human Interaction Laboratory (VHIL). Il a marché sur un pont à une seule planche, a survolé la ville et a abattu quelques arbres avec des lunettes VR.

Cody Woputz, alors responsable du laboratoire VHIL, a révélé un jour qu'en voyant la scène de chute d'une haute altitude, il (Zuckerberg) avait tellement peur qu'il a mis sa main sur sa poitrine.

Cette expérience a laissé une profonde impression sur Zuckerberg. D'une part, parce que la réalité virtuelle en était encore à ses débuts, le système de positionnement était instable, provoquant des interruptions de l'expérience à plusieurs reprises, et l'équipement devait être arrêté et recalibré. De plus, la réalité virtuelle à cette époque n'était pas une machine tout-en-un.

▲ Photo de : Google

D'un autre côté, Zuckerberg a également vu les énormes possibilités de cette technologie révolutionnaire dans le futur. C'est cette expérience qui l'a déterminé à acquérir Oculus pour 2 milliards de dollars. Zuckerberg a expliqué les raisons de l'acquisition dans l'annonce :

Le mobile est la plateforme actuelle, et l'acquisition d'Oculus prépare la plateforme de demain.

Après cela, Zuckerberg a demandé à Facebook de commencer à explorer la technologie et les équipements AR/VR/MR. Avec l'accumulation d'objectifs et de technologies matérielles, en 2020, Meta a officiellement lancé le projet Aria, dont le but est « d'accélérer la RA et l'IA d'un point de vue humain ».

▲ Photo de : Google

C'est un peu mystérieux de voir les choses de cette façon. Une explication légèrement populaire est que les lunettes sont utilisées comme un pont, permettant à l'appareil d'observer et de comprendre le monde d'un point de vue humain, et d'apprendre la relation interactive entre les personnes et l'environnement. Cela favorisera le développement de la technologie logicielle et matérielle, et permettra finalement aux machines de partir des personnes et de les servir.

Les lunettes du projet Aria peuvent aider les chercheurs à collecter des informations du point de vue de l'utilisateur grâce à une technologie révolutionnaire, en particulier les nouveaux capteurs d'Aria Gen 2, qui peuvent capturer l'audio et la vidéo de l'environnement du porteur, ainsi que ses mouvements oculaires et ses informations de localisation.

En partant du premier point de vue de l'utilisateur, il est plus facile pour les chercheurs de comprendre comment la RA peut jouer un rôle réel dans le monde réel et la vie quotidienne, plutôt que de se limiter à des fonctions fantaisistes mais peu pratiques.

De plus, il est très important pour l’IA multimodale de collecter des informations du monde réel d’un point de vue humain. Cette méthode de formation peut simuler les méthodes cognitives multimodales humaines.

Nous percevons le monde à travers de multiples sens tels que la vision, l’ouïe, le toucher, etc., et l’IA multimodale peut se rapprocher du modèle cognitif naturel de l’humain en intégrant du texte, des images, de l’audio, de la vidéo et d’autres données. De plus, la capacité d’intégration intermodale des informations ne peut pas être obtenue par l’IA monomodale.

La collecte et la formation multimodales peuvent également améliorer la précision de la prise de décision de l'IA dans des scénarios complexes.Si le monde n'est pas compris à travers des informations multidimensionnelles, il y aura inévitablement des différences entre les « expositions des acheteurs » et les « expositions des vendeurs ». Le monde numérique n'a que des 0 et des 1, mais dans le monde réel, en plus du noir et blanc, il existe également des zones grises difficiles à comprendre.

▲ Photo de : Google

L'interaction elle-même est en réalité multimodale. Outre le langage utilisé lorsque l'on parle à des amis, les expressions, les gestes, le ton et même les vêtements affectent notre compréhension. Par conséquent, l’IA multimodale peut créer une expérience interactive plus naturelle en traitant simultanément le texte, les images et l’audio.

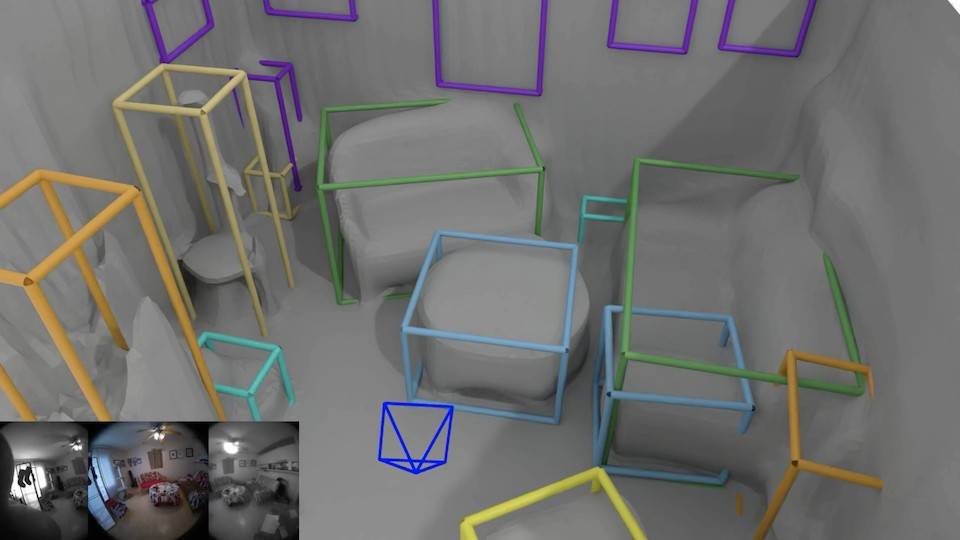

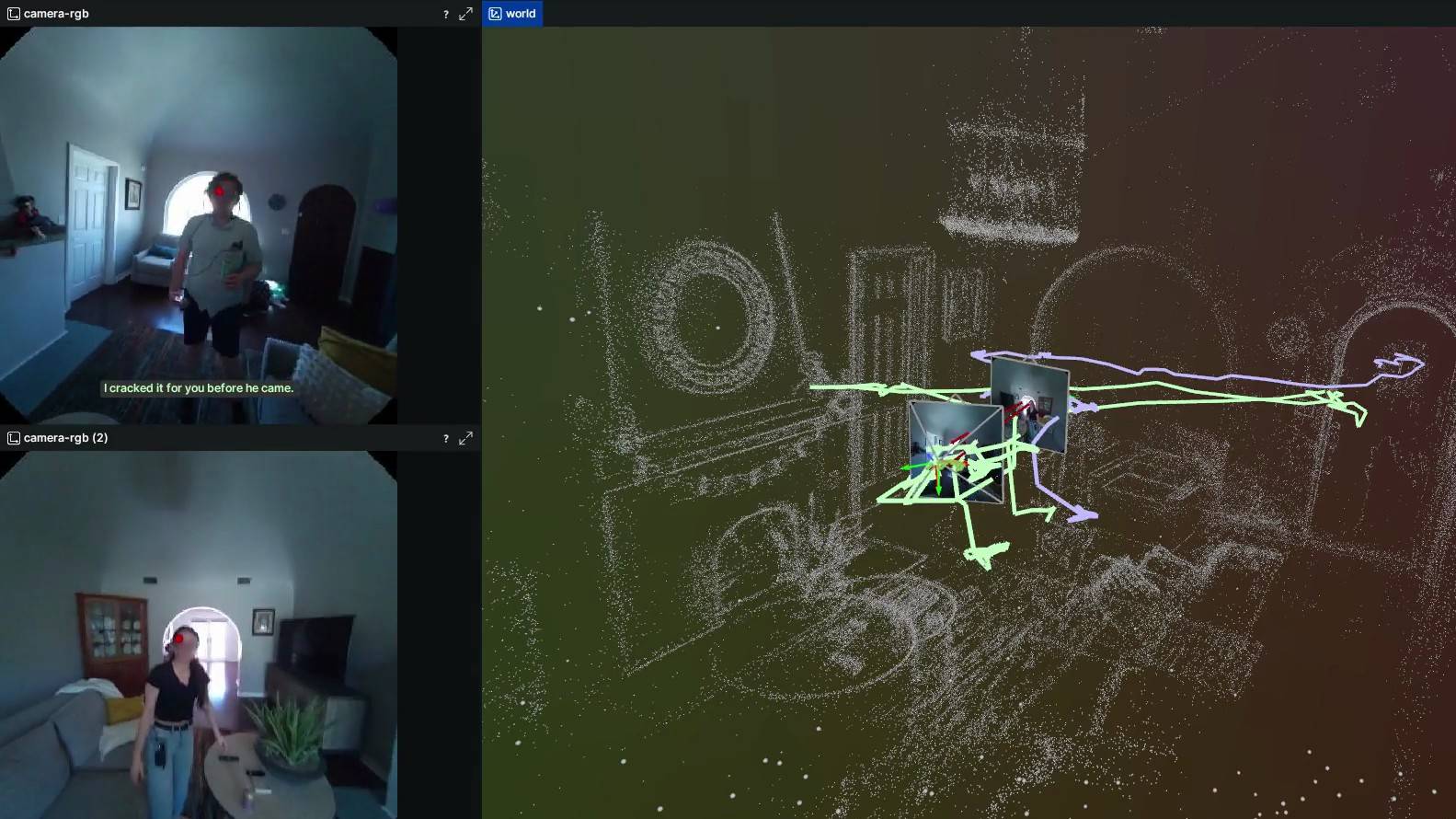

Meta a également donné quelques détails sur ses recherches dans le cadre du projet Aria. Dans le cadre du projet Aria, la manière dont les lunettes intelligentes comprennent le monde est très simple et rudimentaire : la numérisation. La technologie, appelée SceneScript, est une méthode permettant de représenter et de déduire la géométrie d'une scène à l'aide de modèles de langage structurés autorégressifs et d'un apprentissage de bout en bout.

▲ Photo de : Meta

Pour faire simple, toutes les scènes et objets vus à la première personne peuvent être transformés en numéros et noms spécifiques par les lunettes. Quelle est la longueur de la table ? Les trous transparents et réguliers sur le mur sont appelés « fenêtres ».

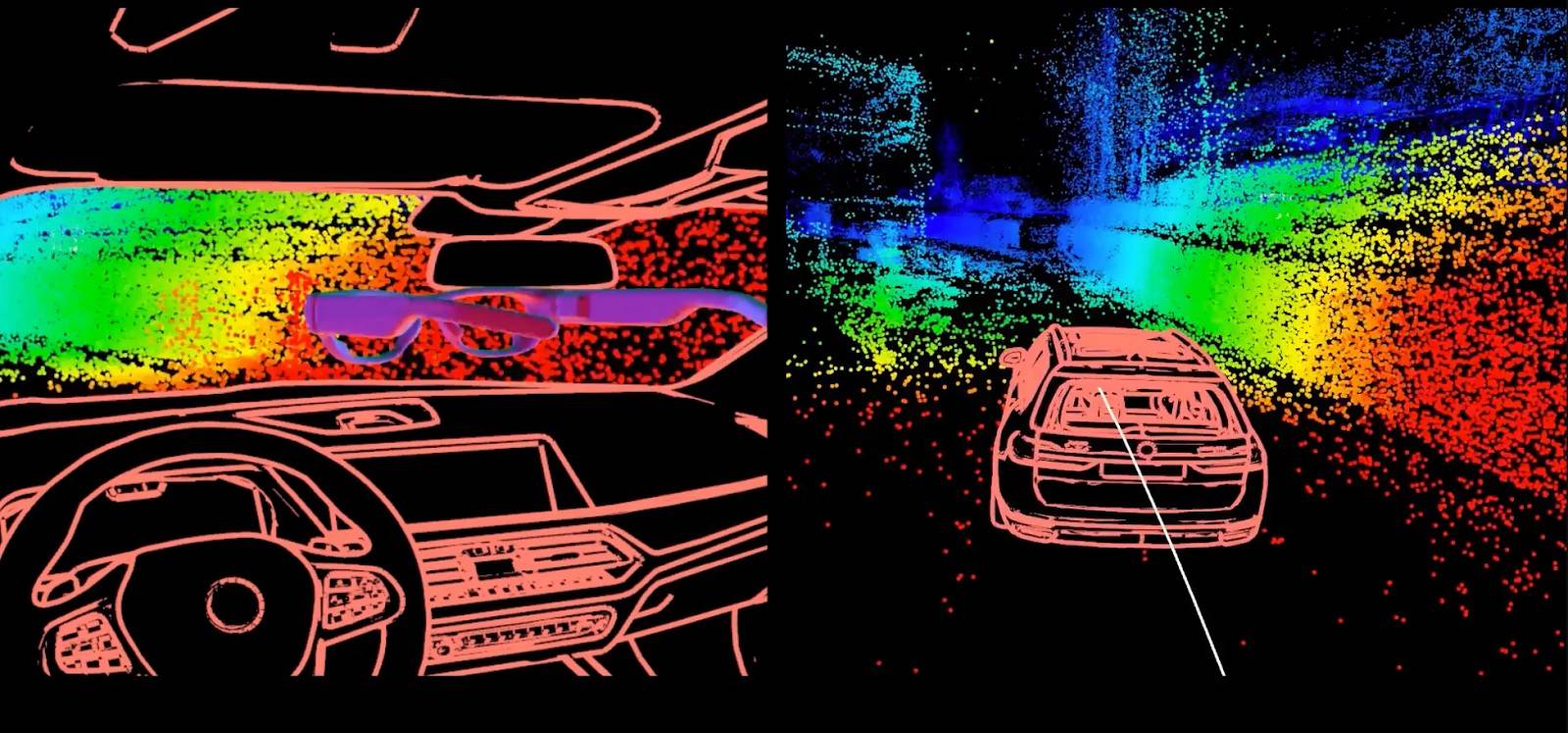

Afin de permettre au modèle intégré aux lunettes non seulement de voir le monde, mais aussi de mieux comprendre le monde, Meta utilise la technologie d'imagerie tridimensionnelle auto-développée EMF3D pour « marquer clairement » tous les objets du monde réel avec des segments de lignes de couleurs différentes, unifiant ainsi les poids et mesures des objets de différents matériaux, formes et tailles.

▲ Photo de : Meta

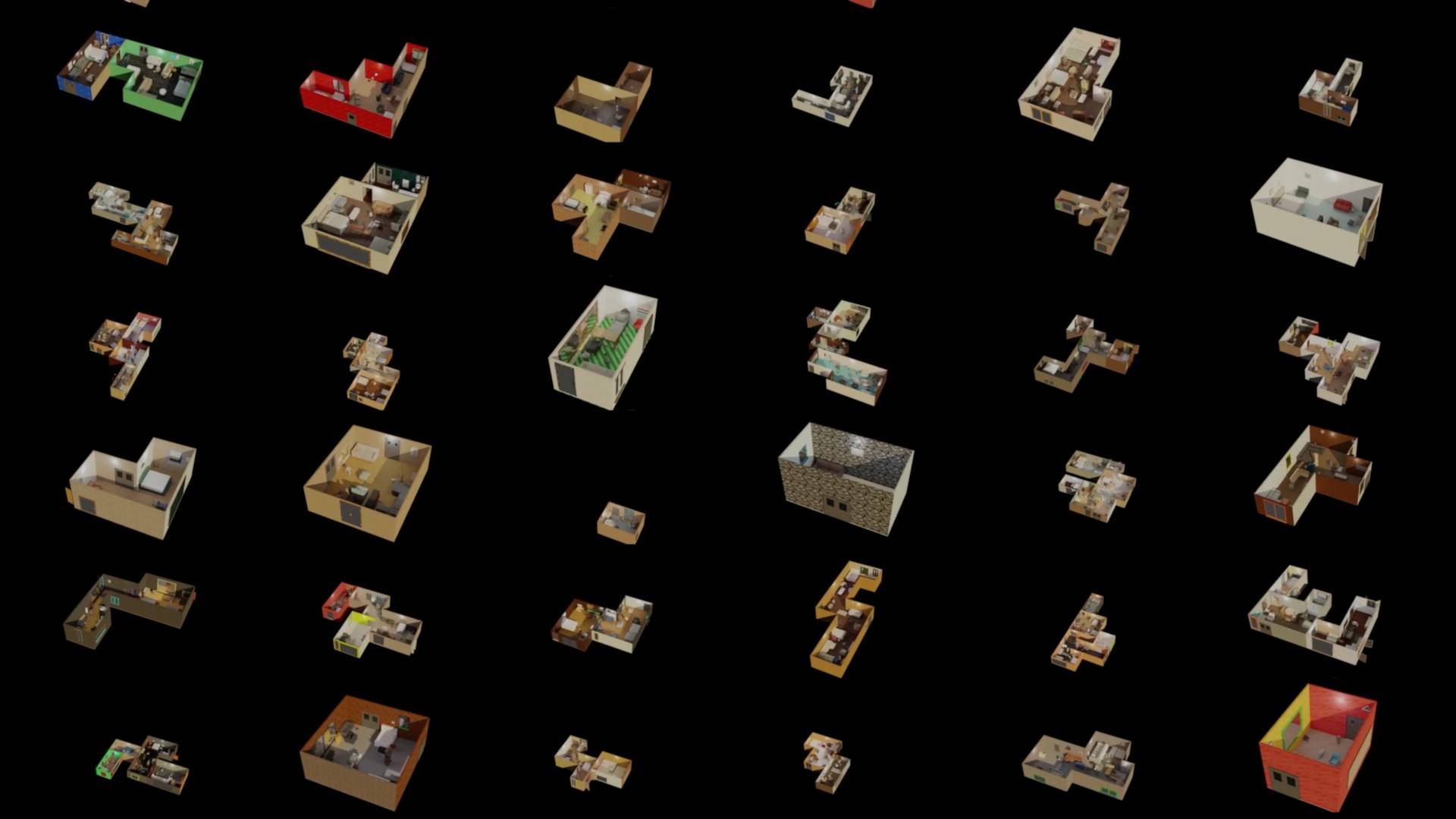

Lorsque les lunettes peuvent lire et enregistrer l’environnement, il devient plus possible de recréer un monde virtuel. La technologie de synthèse environnementale du projet reproduit un ensemble de données de scènes intérieures entièrement simulées à grande échelle, générées par un programme grâce à une grande quantité de données collectées. Elle établit également une nouvelle norme pour les « jumeaux numériques » et accélère la recherche sur des défis tels que la détection d'objets 3D, la reconstruction de scènes et l'apprentissage de la simulation à la réalité.

▲ Photo de : Meta

Cette méthode d'apprentissage "système de développement" a ses avantages et ses inconvénients. La bonne nouvelle est qu'une fois l'apprentissage très solide, la difficulté est que si l'on veut être solide, il faut parcourir des quantités massives de données. Il faut donc beaucoup de bénévoles pour participer au Projet Aria et porter des lunettes Meta pendant longtemps.

Plutôt que de trouver des personnes, il est plus important de savoir comment les inciter à les utiliser en toute confiance, car la collecte de données et la protection de la vie privée sont deux ennemis difficiles à concilier. La solution proposée par Meta est un nouveau modèle d'IA « auto-flou » qui protège la vie privée en détectant et en floutant les informations personnelles dans les images, et en codant directement les informations sensibles telles que les visages et les plaques d'immatriculation.

▲ Photo de : Meta

L'apprentissage massif peut également permettre au modèle de mieux comprendre les intentions de l'utilisateur. Par exemple, en analysant et en résumant les scènes de la vie quotidienne de l'utilisateur, il peut déterminer ce que l'utilisateur est le plus susceptible de faire à quel moment ? Qu'il s'agisse de descendre pour faire de l'exercice, d'aller au salon pour jouer à des jeux ou d'aller à la cuisine pour cuisiner. Être capable de prédire le comportement des gens peut fournir à l'avance des fonctions plus pratiques.

Ceci est similaire à la fonction de l'assistant intelligent de notre téléphone mobile, qui ouvre une fenêtre à une heure précise pour nous rappeler les conditions de circulation à la maison et la météo du lendemain.

▲ Photo de : Meta

Au cours des cinq années qui ont suivi la création du projet Aria, ils ont produit des résultats tels que l'ensemble de données Ego-Exo4D collecté à l'aide des lunettes Aria de première génération, qui sont devenues un outil fondamental dans la vision par ordinateur moderne et dans le domaine en constante évolution de la robotique.

Certaines entreprises ont également commencé à étudier comment Aria devrait-elle être utilisée dans leur flux de travail ? BMW, par exemple, cherche à intégrer des systèmes de réalité augmentée et de réalité virtuelle dans les voitures intelligentes.

▲ Photo de : Meta

Des chercheurs du Georgia Institute of Technology ont également récemment démontré comment Aria peut aider à éliminer le stress des tâches ménagères chez vous.

▲ Photo de : Meta

Il y a longtemps, nous avons conclu dans un article d'expérience sur les assistants intelligents mobiles : du point de vue actuel, la plus grande importance de la combinaison de l'intelligence artificielle et de divers appareils électroniques devrait être d'aider les personnes âgées et handicapées à mieux s'intégrer dans la nouvelle ère et la nouvelle vie. Aria a également réalisé certains progrès dans le développement de technologies sans obstacle :

L'Université Carnegie Mellon utilise la première génération de lunettes Aria dans un projet visant à développer une technologie pour aider les personnes aveugles et malvoyantes à se déplacer à l'intérieur.

▲ Photo de : Meta

La fonction vocale AI de l'Aria de deuxième génération a également été intégrée par Envision dans son propre Ally AI et son audio spatial pour améliorer la navigation intérieure et l'expérience sans obstacle.

▲ Photo de : Envision

Si je devais utiliser une phrase pour décrire la relation entre Project Aria, Meta et ses produits, je pense que ce serait comme les racines, le tronc et les branches d'un arbre. Le projet Aria est au fond. Il est généralement invisible et intangible, mais les réalisations techniques accumulées au fil des années finiront par donner du pouvoir à l'entreprise et à divers produits de diverses manières.

Fin septembre de l'année dernière, lors d'une conférence de presse, Zuckerberg a sorti du coffre-fort des lunettes intelligentes Meta Orion qui semblaient ordinaires mais qui étaient en réalité un projet top secret depuis dix ans. À en juger par l'écran de démonstration lors de la conférence de presse, il peut réaliser des fonctions interactives très similaires à celles de Vision Pro. Plus important encore, Orion est une véritable paire de lunettes AR holographiques.

Elles semblent un peu plus épaisses que les lunettes ordinaires, mais après les avoir portées, vous pouvez voir à la fois le monde réel à travers les lentilles et l'image projetée.

Bien que la clarté ne soit pas aussi bonne que celle des téléviseurs et projections traditionnels, elle est plus que suffisante pour voir des images et du texte. Ce qui est étonnant, c'est que nous n'avons pas trouvé de gros prismes sur les yeux. L'effet de réalité si proche de la réalité et qui apparaît de nulle part consiste en fait à projeter l'image sur la lentille en carbure de silicium à travers le projecteur LED autour de la lentille.

Les 7 caméras et capteurs autour du cadre permettent à Meta Orion de véritablement réaliser la capacité de mettre la réalité virtuelle en réalité et de l'intégrer dans la réalité. Il peut survoler avec précision des images holographiques dans les airs et peut également identifier les éléments devant vous. Par exemple, il peut personnaliser une recette pour vous en fonction des ingrédients sur la table.

▲ Photo de : Meta

Il n'est pas exagéré de dire qu'Orion est aussi bon que Vision Pro en termes d'expérience interactive, car il prend réellement en charge le suivi des mains et des yeux, et les mains sont les poignées. Le bracelet neuronal correspondant peut également transformer la main en souris. Il peut identifier les signaux nerveux du corps en détectant les changements dans le courant musculaire, et ainsi distinguer différents mouvements des doigts :

- Pincez avec le pouce et l'index pour sélectionner

- Le pouce et le majeur appellent ensemble le menu

- Serrez le poing et faites glisser votre pouce pour faire défiler l'écran

Lors de la conférence de presse, nous avons également vu le véritable démontage du Meta Orion. La structure interne très complexe et extrêmement précise, et le corps final assemblé ne pesait que 98 g.

Il n'est pas difficile de constater que la relation entre Meta Aria Gen 2 et Meta Orion se ressemble dans le miroir. Cependant, Zuckerberg avait déclaré dans une interview à l'époque qu'en raison du coût élevé (chaque unité coûte environ 10 000 dollars américains, soit environ 70 000 yuans), l'entreprise avait dû arrêter le plan de production de masse et n'avoir produit que 1 000 unités pour la recherche et le développement interne.

Cependant, Meta prévoit également d'intégrer progressivement la technologie d'Aria dans les lunettes AR grand public, dont Orion, après 2026. L'objectif est de réaliser la transformation des lunettes AR grâce à l'interaction de l'interface neuronale et à l'affichage holographique, ouvrant ainsi la voie au « moment iPhone » des lunettes intelligentes.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo