AMD est en train de perdre la bataille de l’IA, et il est temps qu’il commence à s’inquiéter

AMD et Nvidia fabriquent toutes deux certaines des meilleures cartes graphiques du marché, mais il est difficile de nier que Nvidia est généralement en tête. Je ne parle pas seulement de la grande différence de part de marché. Dans cette génération, c'est Nvidia qui a le GPU géant qui est meilleur que toutes les autres cartes, tandis qu'AMD n'a pas encore de réponse au RTX 4090 .

Une autre chose à laquelle AMD n'a pas de réponse solide pour le moment est l'intelligence artificielle. Même si je passe à AMD pour un usage personnel , il est difficile d'ignorer les faits : Nvidia est en train de gagner la bataille de l'IA. Pourquoi y a-t-il une différence si marquée, et cela deviendra-t-il plus un problème pour AMD sur toute la ligne ?

Tout n'est pas qu'une question de jeu

La plupart d'entre nous achetons des cartes graphiques en fonction de deux choses : le budget et les capacités de jeu. AMD et Nvidia savent tous deux que la grande majorité de leurs cartes grand public haut de gamme se retrouvent dans des plates-formes de jeu, bien que les professionnels les récupèrent également. Pourtant, les joueurs et les utilisateurs occasionnels constituent la plus grande partie de ce segment du marché.

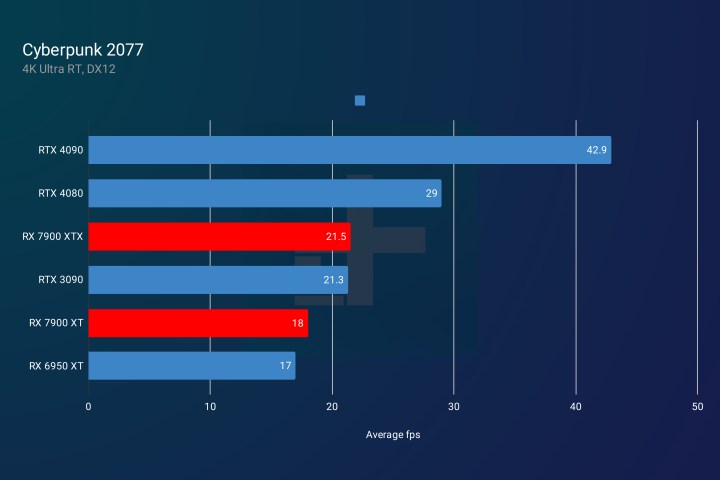

Pendant des années, le paysage GPU était entièrement consacré à Nvidia, mais au cours des dernières générations, AMD a fait de grands progrès, à tel point qu'il échange maintenant des coups avec Nvidia. Bien que Nvidia domine le marché avec le RTX 4090, les deux produits phares RDNA 3 d'AMD (le RX 7900 XTX et le RX 7900 XT ) sont des cartes graphiques puissantes qui surpassent souvent les offres similaires de Nvidia, tout en étant moins chères que le RTX 4080 .

Si nous prétendons que le RTX 4090 n'existe pas, alors comparer les RTX 4080 et 4070 Ti aux RX 7900 XTX et XT nous dit que les choses sont assez stables en ce moment ; du moins en ce qui concerne les jeux.

Et puis, nous arrivons au lancer de rayons et aux charges de travail de l'IA, et c'est là qu'AMD tombe d'une falaise.

Il n'y a aucun moyen d'enrober cela – Nvidia est tout simplement meilleur pour exécuter des tâches générées par l'IA qu'AMD en ce moment. Ce n'est pas vraiment une opinion, c'est plutôt un fait. Ce n'est pas non plus le seul atout dans sa manche.

Tom's Hardware a récemment testé l'inférence IA sur les cartes Nvidia, AMD et Intel, et les résultats n'étaient pas du tout favorables à AMD.

Pour comparer les GPU, le testeur les a comparés dans Stable Diffusion, qui est un outil de création d'images AI. Lisez l'article source si vous voulez connaître tous les détails techniques qui sont entrés dans la mise en place des benchmarks, mais pour faire court, Nvidia a surpassé AMD et Intel Arc A770 a fait si mal qu'il mérite à peine une mention.

Même faire fonctionner Stable Diffusion en dehors d'un GPU Nvidia semble être tout un défi, mais après quelques essais et erreurs, le testeur a pu trouver des projets qui étaient quelque peu adaptés à chaque GPU.

Après les tests, le résultat final était que les séries RTX 30 et RTX 40 de Nvidia s'en sortaient assez bien (bien qu'après quelques ajustements pour ce dernier). La gamme RDNA 3 d'AMD a également bien résisté, mais les cartes RDNA 2 de dernière génération étaient assez médiocres. Cependant, même la meilleure carte d'AMD était à des kilomètres derrière Nvidia dans ces benchmarks, ce qui montre que Nvidia est tout simplement plus rapide et meilleur pour s'attaquer aux tâches liées à l'IA.

Les cartes Nvidia sont la référence pour les professionnels qui ont besoin d'un GPU pour les charges de travail d'IA ou d'apprentissage automatique. Certaines personnes peuvent acheter l'une des cartes grand public et d'autres peuvent choisir un modèle de station de travail à la place, comme le RTX 6000 au nom confus , mais il n'en reste pas moins qu'AMD n'est souvent même pas sur le radar lorsque de telles plates-formes sont construites.

Ne négligeons pas le fait que Nvidia a également une forte avance sur AMD dans des domaines tels que le lancer de rayons et le super échantillonnage en profondeur (DLSS) . Dans nos propres benchmarks, nous avons constaté que Nvidia mène toujours la charge en matière de lancer de rayons sur AMD, mais au moins Team Red semble faire des pas dans la bonne direction.

Cette génération de GPU est la première où l'écart de traçage de rayons se réduit. En fait, le RX 7900 XTX d'AMD surpasse le RTX 4070 Ti de Nvidia à cet égard. Cependant, les GPU Ada Lovelace de Nvidia ont un autre avantage sous la forme de DLSS 3 , une technologie qui copie des images entières, au lieu de seulement des pixels, en utilisant l'IA. Encore une fois, AMD prend du retard.

Nvidia a une longue histoire d'IA

Les cartes graphiques AMD et Nvidia sont très différentes au niveau architectural, il est donc impossible de les comparer complètement. Cependant, une chose que nous savons, c'est que les cartes de Nvidia sont optimisées pour l'IA au niveau de leur structure même, et c'est le cas depuis des années.

Les derniers GPU de Nvidia sont équipés de cœurs CUDA (Compute Unified Device Architecture), tandis que les cartes AMD ont des unités de calcul (CU) et des processeurs de flux (SP). Nvidia dispose également de Tensor Cores qui facilitent les performances des algorithmes d'apprentissage en profondeur, et avec Tensor Core Sparsity, ils aident également le GPU à éviter les calculs inutiles. Cela réduit le temps dont le GPU a besoin pour effectuer certaines tâches, telles que la formation de réseaux de neurones profonds.

Les cœurs CUDA sont une chose, mais Nvidia a également créé une plate-forme informatique parallèle du même nom, qui n'est accessible qu'aux cartes graphiques Nvidia. Les bibliothèques CUDA permettent aux programmeurs d'exploiter la puissance des GPU Nvidia afin d'exécuter des algorithmes d'apprentissage automatique beaucoup plus rapidement.

Le développement de CUDA est ce qui distingue vraiment Nvidia d'AMD. Alors qu'AMD n'avait pas vraiment de bonne alternative, Nvidia a investi massivement dans CUDA, et à son tour, la plupart des progrès de l'IA au cours des dernières années ont été réalisés à l'aide de bibliothèques CUDA.

AMD a fait du travail sur ses propres alternatives, mais c'est assez récent quand on le compare aux années d'expérience de Nvidia. La plate-forme Radeon Open Compute (ROCm) d'AMD permet aux développeurs d'accélérer les charges de travail de calcul et d'apprentissage automatique. Dans le cadre de cet écosystème, il a lancé un projet appelé GPUFORT .

GPUFORT est l'effort d'AMD pour aider les développeurs à passer des cartes Nvidia aux propres GPU d'AMD. Malheureusement pour AMD, les bibliothèques CUDA de Nvidia sont beaucoup plus largement prises en charge par certains des frameworks d'apprentissage en profondeur les plus populaires, tels que TensorFlow et PyTorch.

Malgré les tentatives d'AMD pour rattraper son retard, l'écart ne fait que se creuser chaque année alors que Nvidia continue de dominer le paysage de l'IA et du ML.

Le temps presse

L'investissement de Nvidia dans l'IA était certainement judicieux. Cela a laissé Nvidia avec une gamme de GPU de jeu en plein essor aux côtés d'une gamme puissante de cartes capables d'effectuer des tâches liées à l'IA et au ML. AMD n'en est pas encore là.

Bien qu'AMD semble essayer d'optimiser ses cartes côté logiciel avec des cœurs AI encore inutilisés sur ses derniers GPU, il ne dispose pas de l'écosystème logiciel que Nvidia a construit.

AMD joue cependant un rôle crucial en tant que seul concurrent sérieux de Nvidia. Je ne peux pas nier qu'AMD a fait de grands progrès sur les marchés des GPU et des CPU au cours des dernières années. Il a réussi à sortir de sa non-pertinence et à devenir une alternative solide à Intel, faisant de certains des meilleurs processeurs disponibles actuellement. Ses cartes graphiques sont désormais également compétitives, même si ce n'est que pour le jeu. Sur le plan personnel, je me suis penché vers AMD au lieu de Nvidia parce que je suis contre l'approche tarifaire de Nvidia au cours des deux dernières générations. Pourtant, cela ne compense pas le manque de présence d'IA d'AMD.

Il est très visible dans des programmes tels que ChatGPT que l'IA est là pour dire , mais il est également présent dans d'innombrables autres choses qui passent inaperçues pour la plupart des utilisateurs de PC. Dans un PC de jeu, l'IA travaille en arrière-plan en effectuant des tâches telles que l'optimisation en temps réel et les mesures anti-triche dans les jeux. Les non-joueurs voient également beaucoup d'IA au quotidien, car l'IA se trouve dans les chatbots omniprésents, les assistants personnels vocaux, les applications de navigation et les appareils domestiques intelligents.

Alors que l'IA imprègne de plus en plus notre vie quotidienne et que les ordinateurs sont nécessaires pour effectuer des tâches dont la complexité ne fait qu'augmenter, les GPU devraient également suivre le rythme. AMD a une tâche difficile à accomplir, mais s'il ne prend pas au sérieux l'IA, il pourrait être condamné à ne jamais rattraper son retard.