Ces nouvelles technologies de Meta AI permettent aux robots d’avoir du « toucher »

Avec le développement actuel des robots à intelligence artificielle, il n’est plus étrange qu’ils aient une « vision » ou une « ouïe ». Après tout, ces deux sens sont presque les canaux les plus importants par lesquels les humains perçoivent le monde physique.

La nouvelle technologie récemment annoncée par l’équipe de recherche sur l’intelligence artificielle de base (FAIR) de Meta AI donne une « touche » aux robots. À cet égard, la vision de Meta est de permettre à l’IA de « mieux comprendre le monde » et de « mieux comprendre et simuler le monde physique ».

Il ne fait aucun doute que ces nouvelles technologies offrent aux robots une autre façon d'interagir avec le monde, et leur permettent également de faire un pas de plus vers la « ressemblance humaine ».

▲Photo de : NewsBytes

Meta travaille avec la société américaine de capteurs GelSight et la société coréenne de robotique Wonik Robotics pour développer une série de nouvelles technologies et s'engage à commercialiser des capteurs tactiles et à les utiliser dans l'intelligence artificielle.

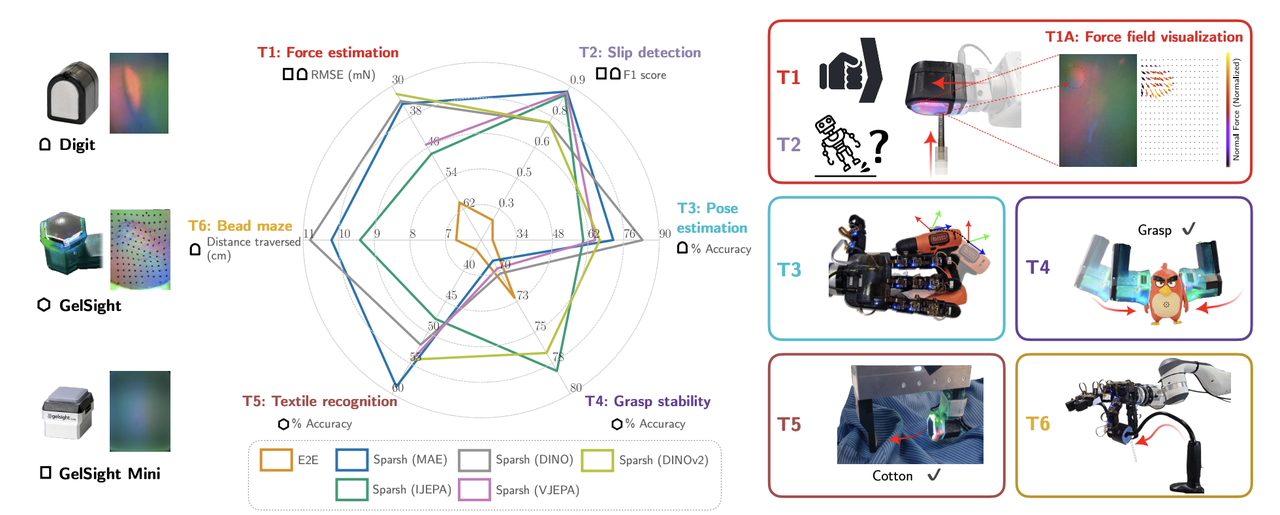

Ces nouvelles technologies comprennent trois outils de recherche – " Sparsh ", " Digit 360 " et " Digit Plexus " – axés sur la perception tactile, la dextérité robotique et l'interaction homme-machine. De plus, Meta introduit également « PARTNR », une nouvelle référence pour évaluer la planification et le raisonnement dans la collaboration homme-machine.

Il est important de noter que ces nouvelles technologies ne sont pas actuellement déployées auprès des consommateurs, mais s’adressent plutôt aux scientifiques et aux chercheurs.

▲Photo de : Techopedia

Sparsh est le premier modèle d'encodeur universel pour la perception tactile basée sur la vision , développé en collaboration entre l'Université de Washington et l'Université Carnegie Mellon.

Cela semble un peu abstrait Puisque c'est « tactile », pourquoi est-ce « basé sur la vision » ?

En fait, les méthodes traditionnelles s'appuient sur des modèles manuels de tâches et de capteurs spécifiques, qui nécessitent que les « paramètres tactiles » des objets (tels que la force, la friction, etc.) soient regroupés dans des « étiquettes de sensation » et transmises au robot, qui est équivalent à dire au robot ce qu'est la « légèreté » « Prends-le doucement » ou « Pousse-le fort ».

Cependant, cette méthode est lourde car de nombreuses données de balises doivent être collectées pour chaque tâche différente et pour différents capteurs.

Sparsh apprend de manière autonome à partir de l'expérience grâce à l'apprentissage auto-supervisé (SSL) , sans lui indiquer le label correspondant à chaque action. Il est pré-entraîné sur un vaste ensemble de données contenant plus de 460 000 images tactiles, ce qui revient à laisser le robot voir de nombreux objets et scènes différents, puis apprendre à reconnaître et à traiter ces objets par lui-même.

Pour faire simple, Sparsh revient à laisser le robot apprendre à « sentir » des objets en regardant un grand nombre d'images et de vidéos , au lieu d'étiqueter manuellement sa « sensation ». De cette façon, il sera plus facile pour le robot d’apprendre à utiliser différents capteurs tactiles pour différentes tâches.

Il est intéressant de noter que le nom « Sparsh » vient du sanskrit, signifiant « expérience sensorielle du toucher ou du contact », ce qui est très approprié pour sa fonction de traitement des signaux tactiles numériques et d'obtention de la perception tactile.

▲Photo de : Méta

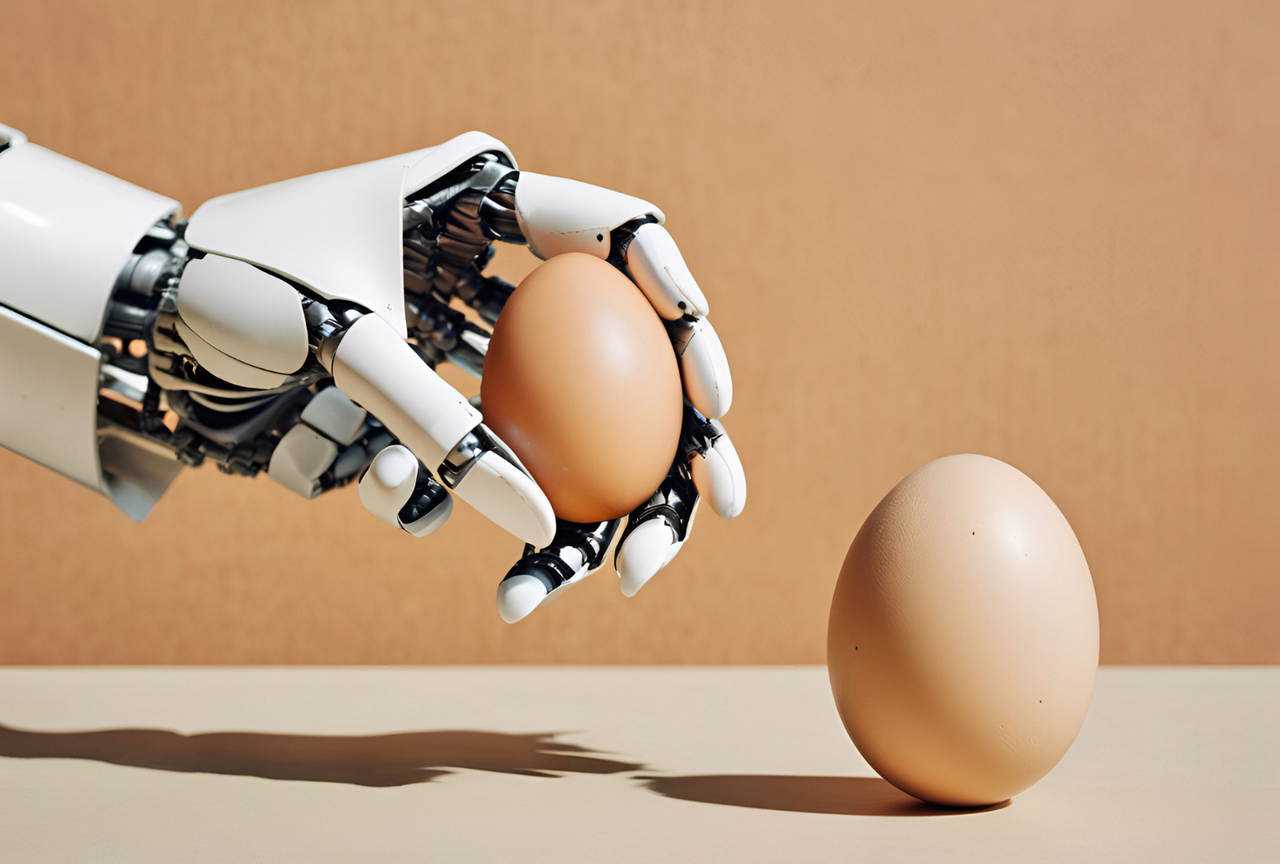

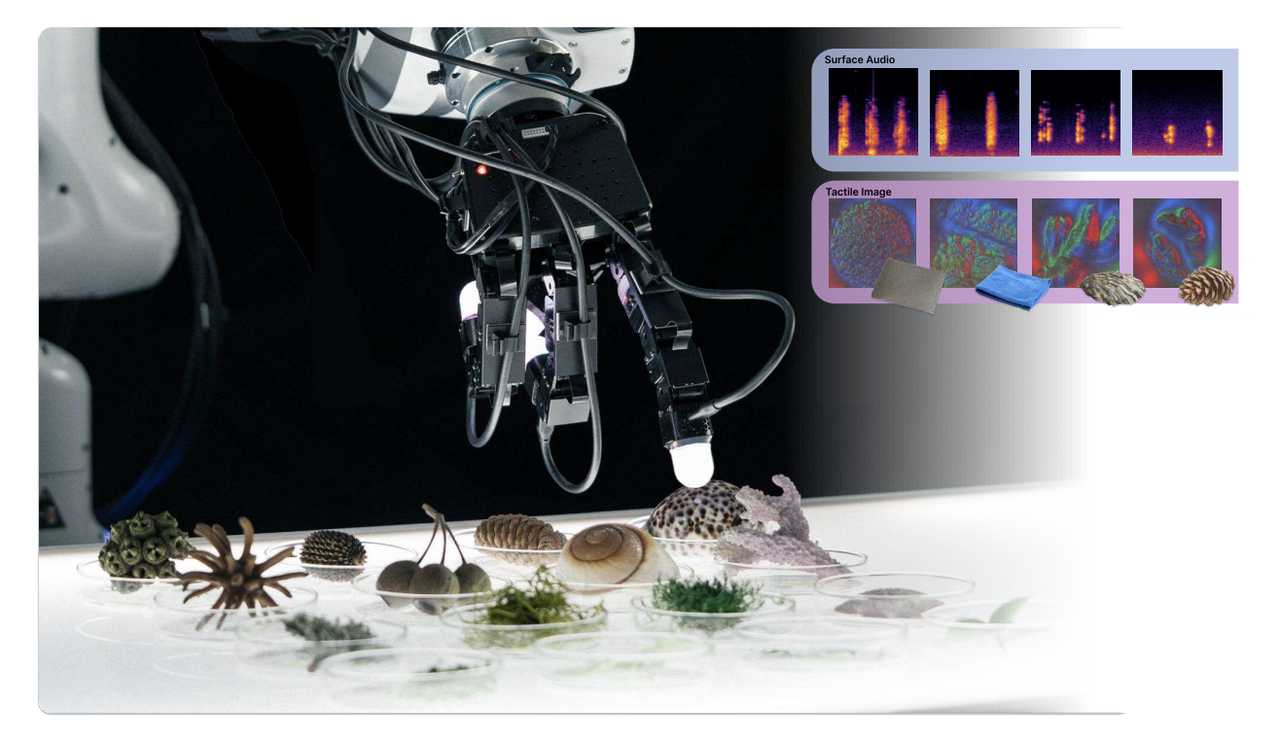

Digit 360 , un capteur tactile artificiel en forme de doigt développé par Meta en partenariat avec GelSight, fournit des données tactiles riches et détaillées en numérisant le toucher avec une précision de niveau humain.

Equipé de plus de 18 capacités de détection, Digit 360 permet aux chercheurs de combiner diverses technologies de détection ou d'isoler des signaux individuels pour une analyse approfondie de chaque mode.

Il peut détecter des changements infimes dans les détails spatiaux, capturer des forces aussi petites que 1 millinewton et comprend plusieurs modes de détection capables de détecter les vibrations, la chaleur et même les odeurs, surpassant considérablement les capteurs précédents.

▲Capteur tactile Digit 360 (à droite).

L’équipe Meta AI a également développé un système optique dédié à la détection tactile à grand champ, composé de plus de 8 millions d’unités de capteur (taxels), pour capturer la déformation omnidirectionnelle de la surface du bout du doigt.

De plus, grâce aux accélérateurs d’IA intégrés à l’appareil, Digit 360 est capable de traiter rapidement les informations, de répondre aux stimuli tactiles et de faire office de système nerveux périphérique du robot. Le design s'inspire des arcs réflexes des humains et des animaux .

Bien évidemment, en plus d’améliorer la flexibilité des robots, ce capteur a de larges perspectives d’application dans des domaines tels que la médecine, la prothèse, la réalité virtuelle et l’interaction à distance.

▲Photo de : Méta

Meta a déclaré sur un blog :

La main humaine est très efficace pour envoyer des informations tactiles sur la peau, du bout des doigts à la paume, jusqu'au cerveau, ce qui lui permet d'activer les muscles de la main lors de la prise de décisions, par exemple sur la façon de taper sur un clavier ou d'interagir avec un objet surchauffé. La réalisation d’une IA intégrée nécessite une coordination similaire entre la détection tactile et l’actionnement moteur dans les mains du robot.

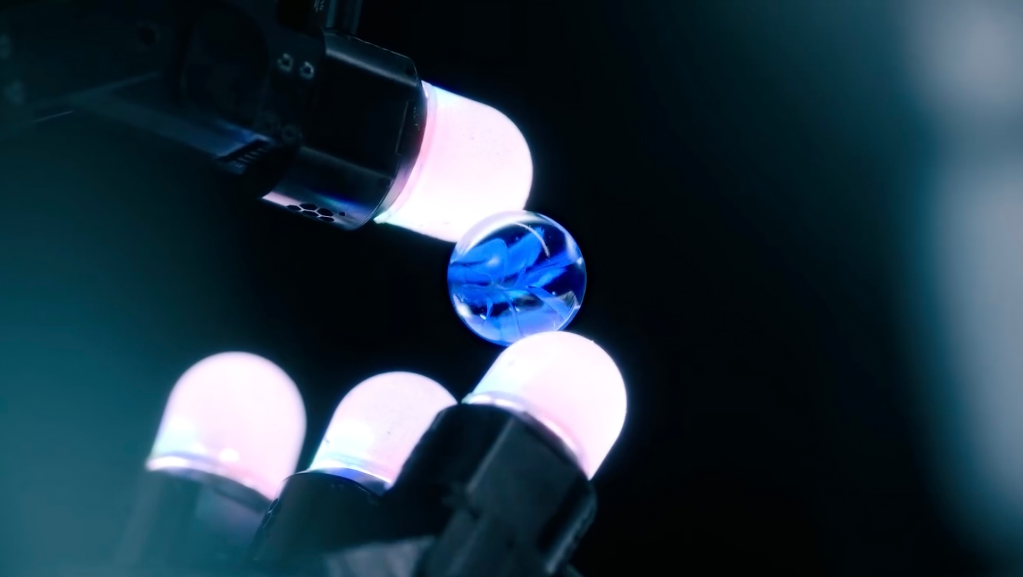

Sur la base de ce concept, Meta AI a coopéré avec Wonik Robotics pour proposer et établir une plate-forme logicielle et matérielle standardisée Digit Plexus .

Il permet d'intégrer une variété de capteurs tactiles du bout des doigts et de la peau (tels que Digit, Digit 360 et ReSkin) dans une main robotique, avec des données tactiles codées et transmises à un ordinateur hôte via un seul câble pour une collecte, un contrôle et une analyse transparents des données. .

Le système Plexus est conçu pour simplifier le développement d'applications robotiques, notamment celles nécessitant un retour tactile sophistiqué. En utilisant Plexus, les développeurs peuvent intégrer plus facilement la technologie des capteurs tactiles dans leurs projets robotiques, améliorant ainsi la dextérité des robots et leur perception du monde physique.

▲Image de : Techcrunch

Il convient de mentionner que la prochaine étape de la coopération entre Meta et Wonik consiste à se concentrer sur le développement de la nouvelle génération Allegro Hand de Wonik, une main robot équipée de capteurs tactiles tels que Digit 360, qui fonctionnera sur la plateforme Digit Plexus.

▲Photo de : XELA

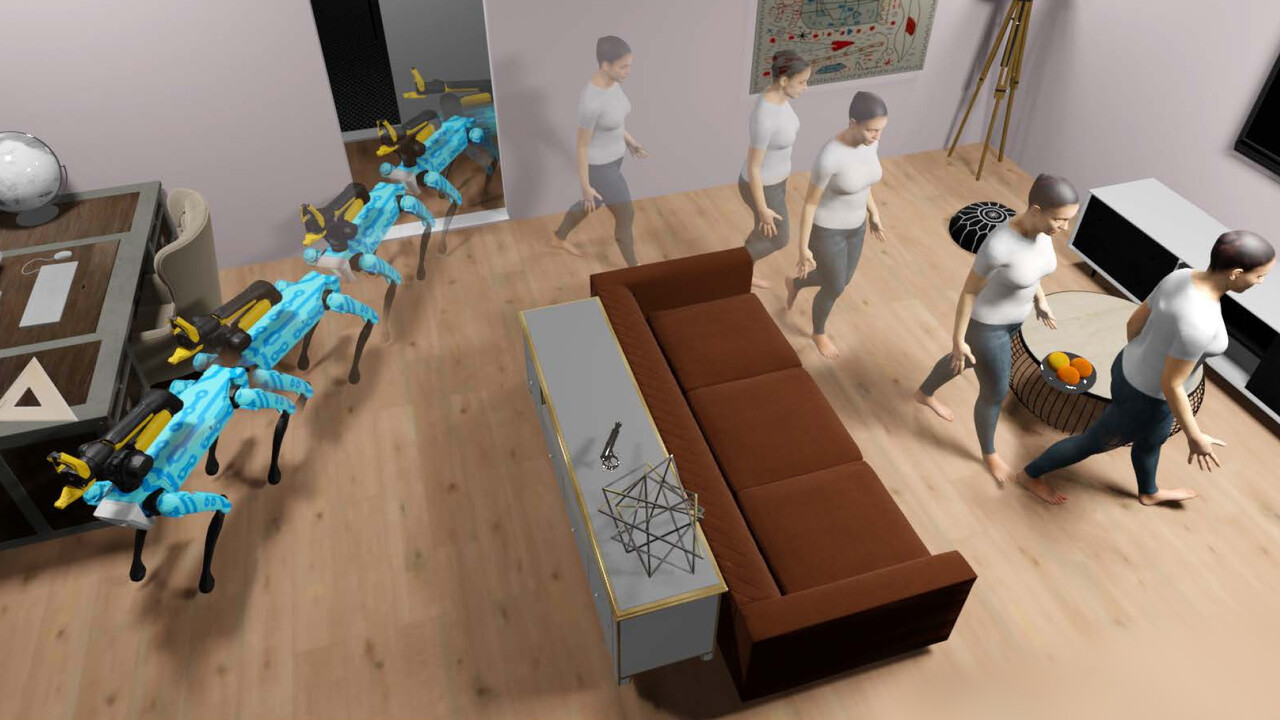

Afin d'étudier la collaboration homme-machine dans les activités domestiques, Meta a publié PARTNR, une référence pour les tâches de planification et de raisonnement de collaboration homme-machine , basée sur Habitat 3.0, une plateforme de simulation pour étudier les tâches de collaboration homme-machine dans les environnements domestiques.

PARTNR est le plus grand benchmark du genre, composé de 100 000 tâches en langage naturel couvrant 60 maisons et plus de 5 800 objets uniques. L'objectif de ce benchmark est d'évaluer les performances de grands modèles de langage et de vision (LLM/VLM) en collaboration avec des humains via des outils d'interaction homme-machine.

En fournissant des références et des ensembles de données standardisés, Meta "espère que cela permettra à la recherche sur les robots de fonctionner non seulement de manière indépendante, mais également en présence d'humains, les rendant ainsi plus efficaces, plus fiables et adaptables aux préférences de chaque individu".

▲Photo de : LinkedIn

Permettre aux robots d'avoir un « contact » n'est pas un « château en l'air ».

Ces robots sont beaucoup plus sensibles aux changements externes que les humains. Grâce à des systèmes de collaboration logiciels et matériels efficaces, ils seront d'une grande utilité dans les opérations chirurgicales ou les scénarios de fabrication d'instruments de précision .

En fait, non seulement la « vision », « l'audition » et le « toucher », des chercheurs de la Pennsylvania State University ont simulé le « goût » dans un modèle d'intelligence artificielle, mais une société appelée Osmo a enseigné au modèle d'intelligence artificielle comment ; Imitez Yuanyou. Sur l' odorat humain.

Peut-être que les futurs robots seront capables de « reproduire » complètement les humains en termes de sens. C’est juste qu’ils feraient mieux de ne plus avoir d’« humanoïdes » réalistes, sinon l’étrange effet de vallée se produira.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo