ChatGPT a réussi les examens des meilleures universités, ce qui devrait être fait plus que l’anti-IA est de changer les questions d’examen

Lorsque les étudiants de la faculté de droit essayaient de jouer à ChatGPT, ils n'auraient jamais dû penser qu'il se retournerait et deviendrait un "camarade de classe" qui passerait le même examen avec eux.

En janvier dernier, le professeur Jon Choi de la faculté de droit de l'Université du Minnesota et le professeur Christian Terwiesch de la Wharton School de l'Université de Pennsylvanie ont respectivement demandé à ChatGPT de "faire" les questions d'examen final de leurs cours.

Du coup, ChatGPT est vraiment passé !

Cela signifie-t-il que ChatGPT évolue un peu plus longtemps et que nous n'aurons plus besoin d'avocats et d'administrateurs humains à l'avenir ?

Ou est-ce un signal d'alarme pour que les éducateurs cessent d'enseigner aux humains à être comme l'IA ?

Derrière le col : le prof "lâchait l'eau" et toute la classe était au fond

Dans les deux majeures testées, les résultats de ChatGPT en faculté de droit sont moins bons qu'en école de commerce : le premier obtient un score moyen de C+, et le second peut atteindre les notes B- à B.

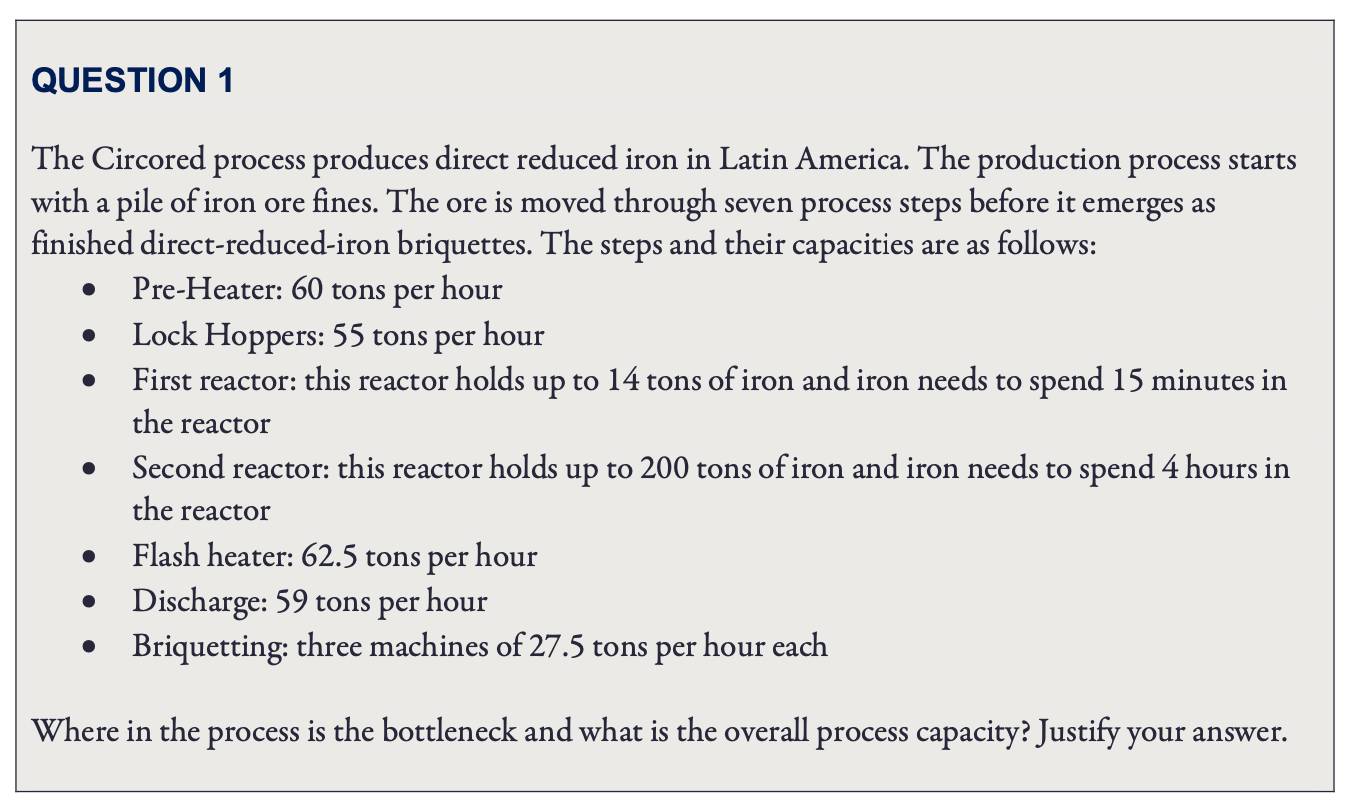

Plus précisément, ce que ChatGPT a terminé à Wharton, ce sont les questions du test du sujet "Gestion des opérations" du MBA (Master of Business Administration), et chaque question doit écrire le "processus de déduction".

Pendant le test, le professeur Terwiesch a saisi les questions originales de l'examen dans ChatGPT et a noté les réponses générées par ChatGPT.

En général, ChatGPT répond très bien aux questions d'analyse de base ; il n'est pas très bon en mathématiques et peut soudainement mal calculer un calcul difficile à l'école élémentaire ; et des questions d'analyse relativement complexes, ChatGPT est fondamentalement incapable.

Par exemple, la première question teste la compréhension du concept de "goulot d'étranglement de gestion", et compare simplement quelle étape du "processus de production" est la moins efficace pour découvrir le "goulot d'étranglement".

Le professeur a donné à cette question un A+ directement.

Cependant, lorsque le "processus de production" dans les questions du test devient plus compliqué, que plusieurs matières premières doivent être traitées et que l'équipement impliqué est différent et se chevauche, ChatGPT ne peut pas être considéré comme un "goulot d'étranglement de gestion".

Pour cette question, bien que le processus de déduction de ChatGPT ait été erroné, il a "parfaitement contourné" la mauvaise inférence et trouvé la réponse.

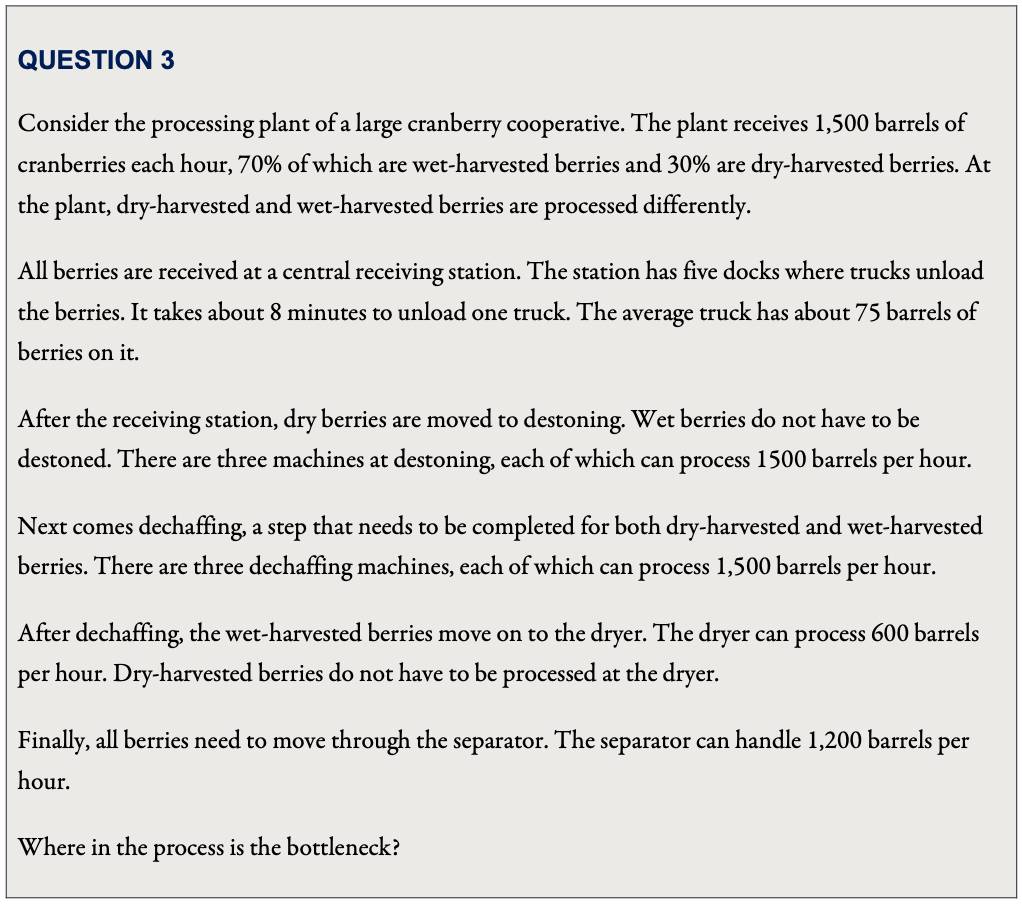

Lors du calcul de l'efficacité de la "station de réception", ChatGPT a donné un résultat de "300 barils par heure".

Bien que ce nombre soit faux, en termes de nombre, c'est en effet la partie la moins efficace du processus d'analyse.

Qui aurait pensé que ChatGPT "Je ne crois pas en moi" et n'a pas sélectionné ce lien comme "goulot d'étranglement", mais a choisi le lien "séchoir" avec une efficacité calculée de "600 barils par heure" comme "goulot d'étranglement" — Choisissez une bonne réponse.

Cependant, bien que le professeur Terwiesch ait finalement attribué à ChatGPT un score de niveau B, il était également un peu « aqueux ».

Lorsqu'il y a une erreur dans la réponse ChatGPT, Terwiesch fournira un rappel ciblé à ChatGPT, puis le laissera produire une réponse, et utilisera ce résultat "optimisé" pour marquer.

En ce qui concerne les examens de la faculté de droit, ChatGPT a répondu aux questions d'examen final pour quatre cours : droit constitutionnel, droit des avantages sociaux, droit fiscal et droit de la responsabilité délictuelle.

Le professeur Jon Choi, qui a dirigé le test, a déclaré que dans le cas de la "correction aveugle", les quatre sujets de ChatGPT ont réussi, mais les résultats étaient essentiellement les derniers de la classe.

Bien que les questions à réponse courte de ChatGPT soient meilleures que les questions à choix multiples, la qualité des questions à réponse courte est extrêmement instable. Parfois, la réponse peut être meilleure que celle des étudiants ordinaires (principalement des textes juridiques et des récits de cas), mais une erreur ( Il s'agit généralement d'une question qui oblige les étudiants à utiliser des théories spécifiques pour analyser des cas), et les scores sont généralement "faux à un nouveau plus bas":

ChatGPT a obtenu de mauvais résultats, même sur les questions les plus élémentaires de l'examen de la faculté de droit, telles que l'identification de problèmes juridiques potentiels et l'analyse approfondie et l'application d'un texte juridique dans une affaire.

Le style de réponse de ChatGPT "ne demandez pas la compréhension, seulement l'approbation" peut également réussir l'examen professionnel avec de faibles scores. Cela montre que les questions du test dépendent encore trop de la "mémorisation par cœur". La performance de ChatGPT est évidemment incapable de remplacer les avocats et gestionnaires.

Cependant, si les étudiants humains sont également à peu près à ce niveau, ont également réussi l'examen et vont même pratiquer après l'obtention de leur diplôme, est-ce plus problématique ?

ChatGPT peut-il imposer des changements après avoir critiqué l'examen "d'approbation" pendant de nombreuses années ?

Avant les débuts étonnants de ChatGPT, le professeur de l'Université Carnegie Mellon, Danny Oppenheimer, s'était déjà demandé : à l'ère de la recherche Google, pourquoi les examens universitaires se concentrent-ils uniquement sur les reformulations des faits par les étudiants ?

Oppenheimer a souligné que bien que certains éducateurs rétorquent que lorsqu'ils expliquent des informations factuelles en classe, ils analysent également le sens, l'argument et l'application de l'information, mais lorsqu'il s'agit de l'épreuve, ils reviennent immédiatement à "l'approbation suffit". " :

De nombreux cours sont construits sur la prémisse que les étudiants développeront cet ensemble de compétences naturellement en observant leurs enseignants donner l'exemple en analysant, développant et appliquant des faits – des hypothèses très discutables.

Par conséquent, Oppenheimer a suggéré que le programme devrait refléter directement les compétences que les éducateurs espèrent que les élèves finiront par acquérir, et il est également nécessaire de combiner les nouvelles technologies, telles que "faire de l'appréciation littéraire avec une assistance informatique" et "comment être civilisé avec des personnes qui ne sont pas d'accord". avec vous". pour communiquer".

Les examens peuvent incorporer des informations factuelles, mais doivent se concentrer sur les compétences d'analyse et d'application des étudiants.

En outre, laisser les étudiants "prévisualiser" les scénarios qu'ils rencontreront à l'avenir est également un moyen direct de mettre en pratique leurs compétences. Par exemple, laissez les étudiants qui étudient le changement climatique organiser une exposition sur le climat pour le public.

Désormais à l'ère du ChatGPT, ce changement est naturellement plus urgent, car plus efficace que les moteurs de recherche, mais aussi plus déroutant.

En plus d'épargner aux étudiants le temps de feuilleter page après page des résultats de recherche, ChatGPT génère également des passages fluides avec une structure linguistique suffisante, même si l'exactitude factuelle est très douteuse.

Fait intéressant, ChatGPT agit également comme un miroir.

D'une part, cela rappelle la composition et les questions à réponse courte dans l'enseignement axé sur les examens, qui sont toujours comme une "imitation" sans fin, remplissant sous le paradigme standard, tout comme ChatGPT.

D'autre part, cultivé en "mangeant" du big data et "en enseignant/scolarisant" à partir de vrais retours humains , le contenu des "sérieux non-sens" de ChatGPT est aussi très similaire au quotidien que nous rencontrons dans nos vies.

À tel point que le professeur Terwiesch de la Wharton School of Business a été super surpris et a estimé que ChatGPT pouvait apporter d'excellents supports d'apprentissage aux futurs managers——

Le monde de l'entreprise regorge déjà de graves bêtises, comme le dit ChatGPT, et les étudiants en commerce n'ont qu'à s'en servir pour faire des exercices d'identification !

Vous et moi savons tous les deux qu'il n'y a pas que les étudiants des écoles de commerce qui ont besoin d'acquérir cette compétence.

Cependant, depuis que le moteur de recherche s'est popularisé dans le secteur de l'enseignement supérieur américain, il y a eu des discussions sur sa réforme, mais les progrès sont encore limités aujourd'hui, la naissance de ChatGPT peut-elle le forcer à tourner plus vite ? Nous ne pouvons que continuer à observer.

humain, humanoïde

Je pense toujours que chaque fois que les humains essaient de "recréer" quelque chose, cela expose toujours nos limites cognitives des choses, et en même temps nous aide à nous comprendre.

En essayant de "recréer" de la nourriture dans l'espace , les chercheurs ont découvert que la nourriture ne peut vraiment pas être réduite à juste "nutritive".

Pour maintenir la santé physique et mentale des astronautes, la couleur, l'odeur, le goût et le son affectent tous la perception, l'environnement doit être particulier et les personnes qui mangent ensemble sont également très importantes.

Lorsque nous avons un ChatGPT qui peut "parler couramment l'humain", les gens commencent également à découvrir que le langage humain n'est pas seulement une question de "texte".

Un système entraîné uniquement sur du matériel linguistique ne s'approchera jamais de l'intelligence humaine, même s'il commence à s'entraîner maintenant, jusqu'à ce que l'univers soit détruit.

Jacob Browning, qui étudie la philosophie de l'IA, et Yann Le Cun, lauréat du prix Turing, le soulignent dans un article commun.

Ils croient qu'en tant que symbole abstrait hautement condensé, la base de la compréhension humaine réside dans notre riche consensus non linguistique et notre expérience personnelle. Cela signifie également que les mots sont toujours sujets à des interprétations erronées et à des ambiguïtés.

La langue est notre outil de communication, mais la compréhension et l'évaluation des étudiants par les éducateurs ne doivent pas se limiter aux dissertations.

Travailler avec de grands modèles de langage à la pointe de la technologie montre à quel point nous pouvons être limités par le langage seul.

#Bienvenue pour prêter attention au compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo