Nvidia a construit un double GPU massif pour alimenter des modèles comme ChatGPT

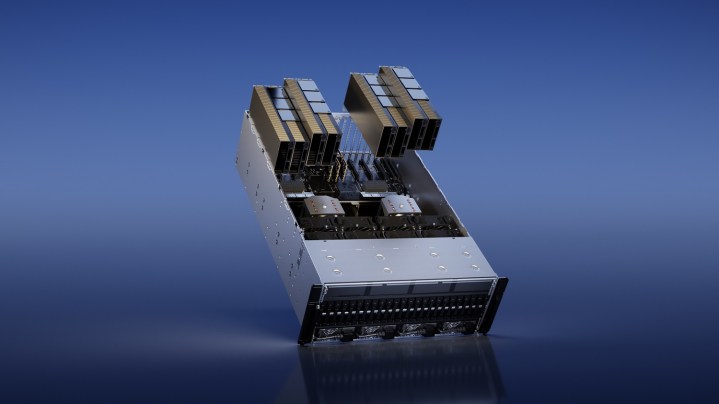

La conférence semestrielle sur la technologie GPU (GTC) de Nvidia se concentre généralement sur les progrès de l'IA, mais cette année, Nvidia répond à la montée massive de ChatGPT avec une liste de nouveaux GPU. Le principal d'entre eux est le H100 NVL, qui assemble deux des GPU H100 de Nvidia pour déployer des grands modèles de langage (LLM) comme ChatGPT.

Le H100 n'est pas un nouveau GPU. Nvidia l'a annoncé il y a un an au GTC, arborant son architecture Hopper et promettant d'accélérer l'inférence de l'IA dans une variété de tâches. Le nouveau modèle NVL avec son énorme mémoire de 94 Go fonctionnerait mieux lors du déploiement de LLM à grande échelle, offrant une inférence jusqu'à 12 fois plus rapide par rapport à l'A100 de dernière génération.

Ces GPU sont au cœur de modèles comme ChatGPT. Nvidia et Microsoft ont récemment révélé que des milliers de GPU A100 ont été utilisés pour entraîner ChatGPT , un projet qui a duré plus de cinq ans.

Le H100 NVL fonctionne en combinant deux GPU H100 sur une interconnexion NVLink à large bande passante Nvidia. C'est déjà possible avec les GPU H100 actuels – en fait, vous pouvez connecter jusqu'à 256 H100 ensemble via NVLink – mais cette unité dédiée est conçue pour des déploiements plus petits.

Il s'agit d'un produit conçu pour les entreprises plus que tout, alors ne vous attendez pas à voir le H100 NVL apparaître sur l'étagère de votre Micro Center local. Cependant, Nvidia affirme que les clients d'entreprise peuvent s'attendre à le voir vers le second semestre de l'année.

En plus du H100 NVL, Nvidia a également annoncé le GPU L4, spécialement conçu pour alimenter les vidéos générées par l'IA. Nvidia affirme qu'il est 120 fois plus puissant pour les vidéos générées par l'IA qu'un processeur et offre une efficacité énergétique 99 % supérieure. En plus de la vidéo IA générative, Nvidia affirme que le GPU offre des capacités de décodage et de transcodage vidéo et peut être exploité pour la réalité augmentée.

Nvidia affirme que Google Cloud est parmi les premiers à intégrer le L4. Google prévoit d'offrir des instances L4 aux clients via sa plate-forme Vertex AI plus tard dans la journée. Nvidia a déclaré que le GPU sera disponible ultérieurement auprès de partenaires, notamment Lenovo, Dell, Asus, HP, Gigabyte et HP, entre autres.