En rattrapant GPT-4o, le modèle le plus puissant Llama 3.1 405B est devenu un dieu du jour au lendemain, Zuckerberg : l’open source mène une nouvelle ère

Tout à l'heure, Meta a publié le modèle Llama 3.1 comme prévu.

Pour faire simple, le nouveau Llama 3.1 405B est le modèle le plus puissant de Meta à ce jour. C'est également le grand modèle open source le plus puissant au monde, et c'est également le grand modèle le plus puissant au monde.

À partir d'aujourd'hui, il n'est plus nécessaire de discuter des mérites des grands modèles open source et des grands modèles fermés, car Llama 3.1 405B prouve avec une force irréfutable que la bataille pour les itinéraires n'affecte pas la force technique finale.

Permettez-moi d'abord de résumer les caractéristiques du modèle Llama 3.1 :

- Contient trois tailles de 8B, 70B et 405B, le contexte maximum a été augmenté à 128 Ko, prend en charge plusieurs langues, offre d'excellentes performances de génération de code et possède des capacités de raisonnement complexes et des compétences d'utilisation d'outils.

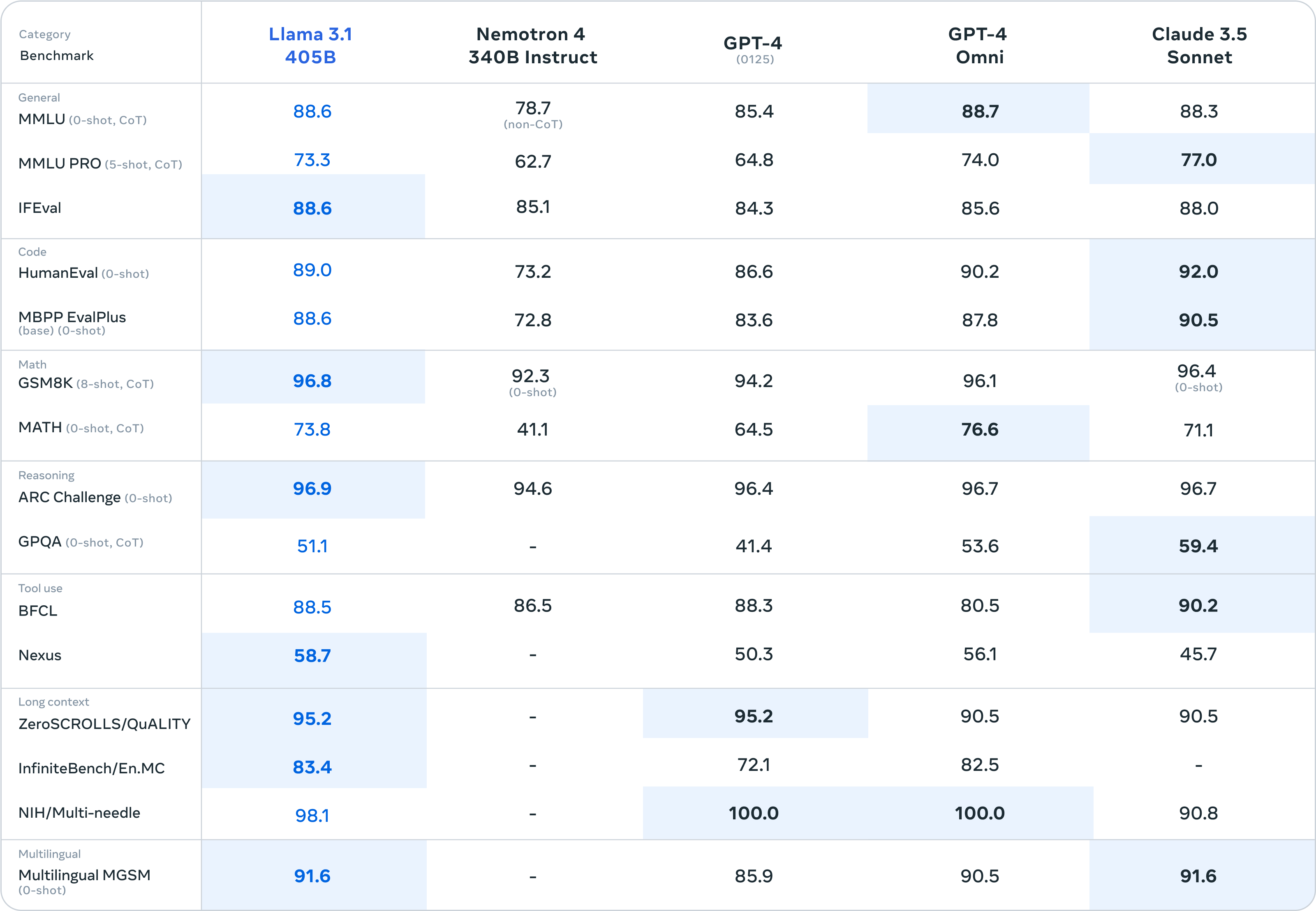

- À en juger par les résultats des tests de référence, Llama 3.1 a dépassé GPT-4 0125, rivalisant avec GPT-4o et Claude 3.5.

- Fournissant des pondérations et un code de modèle ouverts/gratuits, la licence permet aux utilisateurs d'affiner, de distiller le modèle sous d'autres formes et de prendre en charge le déploiement n'importe où.

- Fournit l'API Llama Stack pour faciliter l'utilisation intégrée et prend en charge la coordination de plusieurs composants, y compris l'appel d'outils externes.

Ci-joint l'adresse de téléchargement du modèle :

https://huggingface.co/meta-llama

https://llama.meta.com/

La très grande tasse atteint le sommet du modèle le plus puissant au monde, tandis que les tasses moyennes et grandes cachent des surprises.

Le Llama 3.1 sorti cette fois-ci est disponible en trois versions de taille : 8B, 70B et 405B.

À en juger par les résultats des tests de référence, le très grand Llama 3.1 405B peut résister à toutes les pressions du GPT-3.5 Turbo, et la plupart des résultats des tests de référence dépassent le GPT-4 0125.

Face au grand modèle fermé le plus puissant GPT-4o précédemment publié par OpenAI et au Claude 3.5 Sonnet de premier niveau, la Super Cup a toujours le pouvoir de se battre. On peut même dire, à partir des seuls paramètres papier, que Llama 3.1. 405B marque l'open source Pour la première fois, les grands modèles ont rattrapé les grands modèles à source fermée.

En décomposant spécifiquement les résultats du benchmark, Llama 3.1 405B a obtenu un score de 98,1 sur le benchmark NIH/Multi-needle. Bien qu'il ne soit pas aussi bon que le GPT-4o, cela montre également que sa capacité à traiter des informations complexes est parfaite.

Et Llama 3.1 405B a obtenu un score de 95,2 sur le benchmark ZeroSCROLLS/QUALITY, ce qui signifie également qu'il a une forte capacité à intégrer de grandes quantités d'informations textuelles. Ces résultats montrent que le modèle LLaMA3.1 405B est excellent pour traiter des textes longs et est adapté pour. en se concentrant sur le LLM dans RAG, pour les développeurs d'applications d'IA, les performances sont assez conviviales.

Il est particulièrement préoccupant que Human-Eval soit principalement responsable de l'évaluation de la capacité du modèle à comprendre et à générer du code et à résoudre la logique abstraite, et Llama 3.1 405B a également un léger avantage dans la concurrence avec d'autres grands modèles.

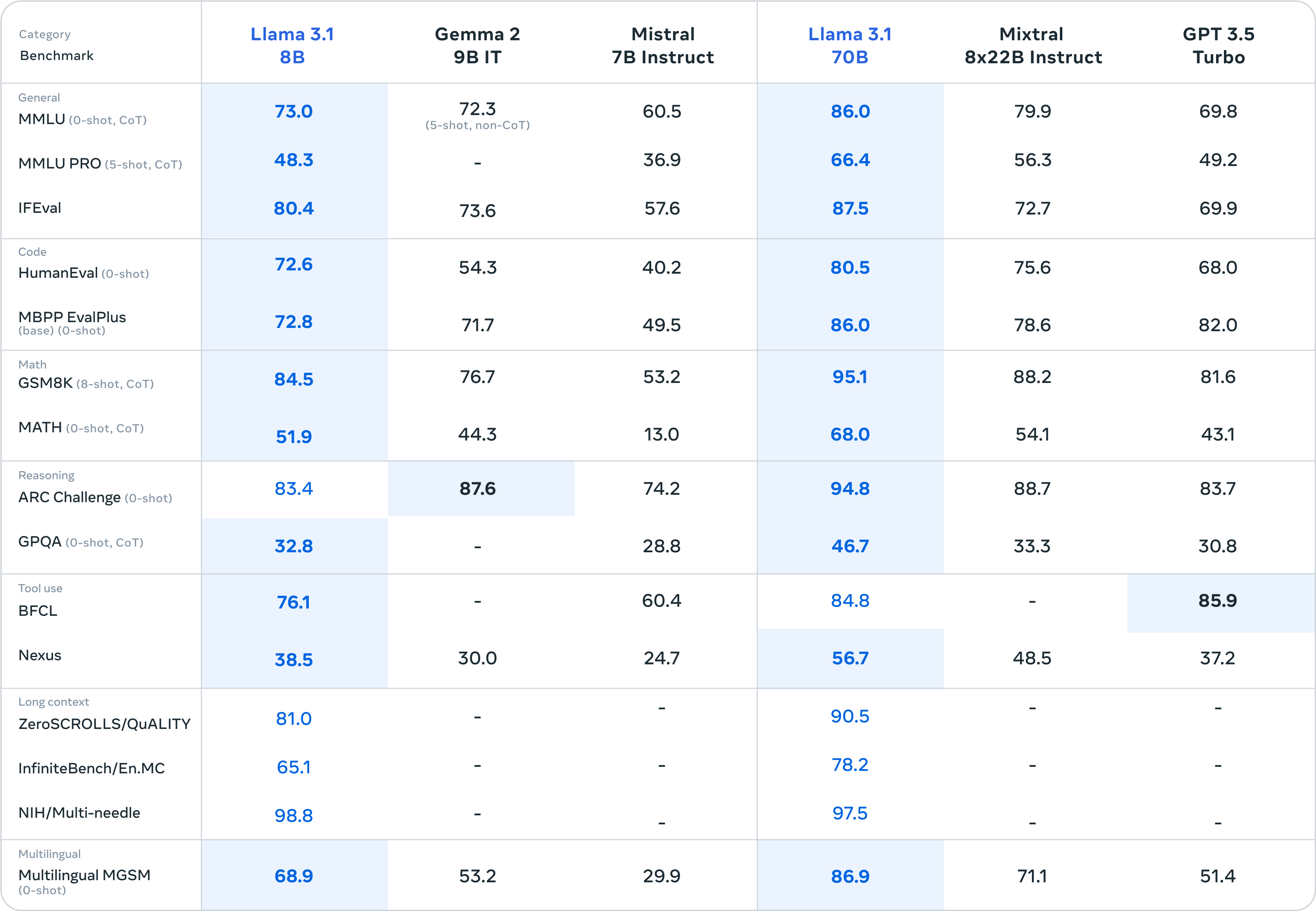

En plus du plat principal Llama 3.1 405B, les accompagnements Llama 3.1 8B et Llama 3.1 70B ont également offert un bon spectacle de "petites victoires sur les grandes".

À en juger par les résultats des tests de référence, Llama 3.1 8B a presque écrasé Gemma 2 9B 1T et Mistral 7B Instruct. Les performances globales ont même été considérablement améliorées par rapport à Llama 3 8B. Llama 3.1 70B peut même surpasser le GPT-3.5 Turbo et le modèle Mixtral 8×7B avec d'excellentes performances.

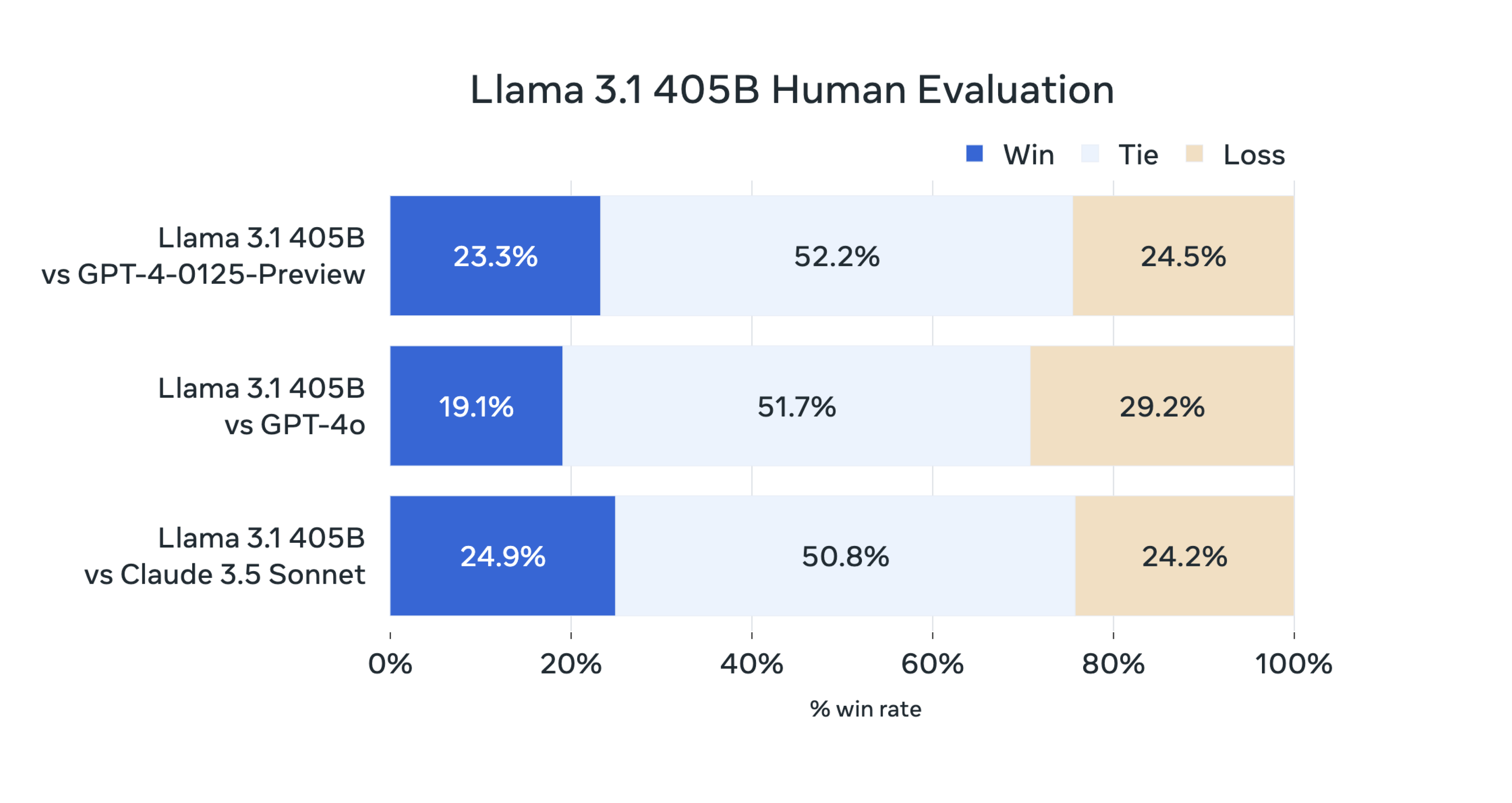

Selon l'introduction officielle, dans cette version, l'équipe de recherche de Llama a évalué les performances du modèle sur plus de 150 ensembles de données de référence couvrant plusieurs langues, et l'équipe a également effectué un grand nombre d'évaluations manuelles.

La conclusion finale est la suivante :

Notre modèle phare est compétitif avec les modèles de base haut de gamme tels que le GPT-4, le GPT-4o et le Claude 3.5 Sonnet sur plusieurs tâches. Dans le même temps, notre petit modèle fait également preuve de compétitivité par rapport aux modèles fermés et ouverts présentant un nombre similaire de paramètres.

Comment est fabriqué le Lama 3.1 405B

Alors, comment Llama 3.1 405B est-il formé ?

Selon le blog officiel, en tant que plus grand modèle Meta à ce jour, Llama 3.1 405B utilise plus de 15 000 milliards de jetons pour la formation.

Afin de réaliser une formation à cette échelle et d'obtenir les résultats escomptés en peu de temps, l'équipe de recherche a également optimisé l'ensemble de la pile de formation et s'est entraînée sur plus de 16 000 GPU H100. Il s'agit également du premier modèle Llama entraîné à une si grande échelle. .

L'équipe a également apporté quelques optimisations au cours du processus de formation, en se concentrant sur le maintien de l'évolutivité et de la simplicité du processus de développement du modèle :

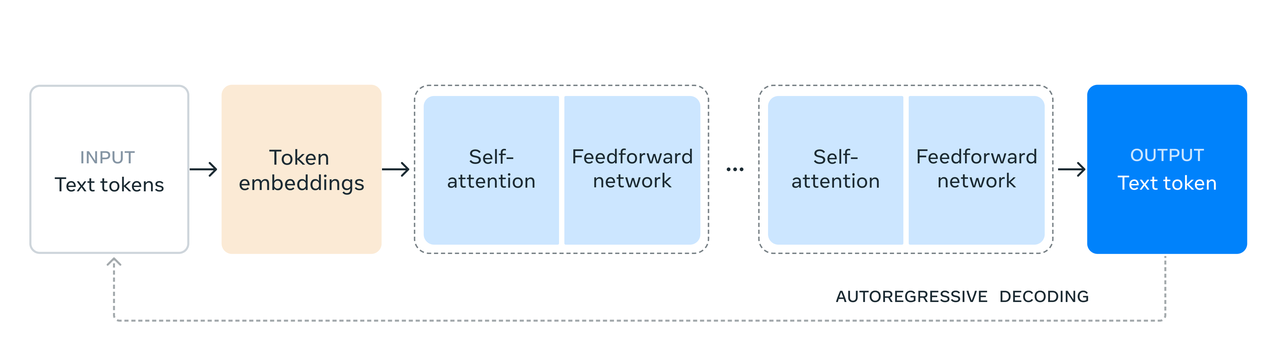

- Une architecture de modèle de transformateur de décodeur standard avec seulement des ajustements mineurs a été choisie au lieu d'un modèle expert hybride pour maximiser la stabilité de la formation.

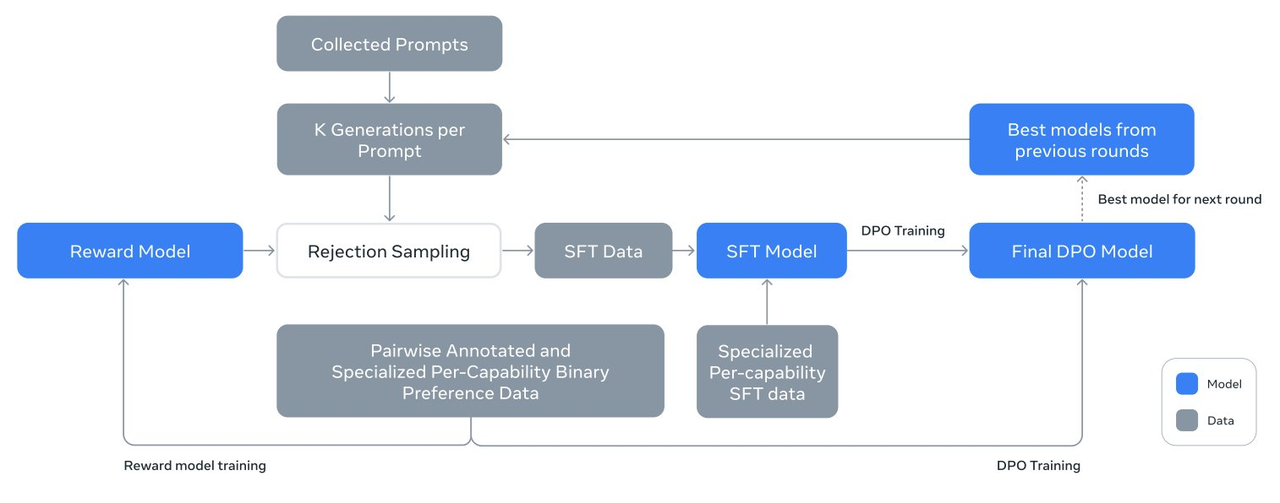

- Une procédure itérative de post-formation est utilisée, utilisant un réglage fin supervisé et une optimisation directe des préférences à chaque tour. Cela permet à l’équipe de recherche de créer des données synthétiques de la plus haute qualité pour chaque cycle et d’améliorer les performances de chaque fonctionnalité.

- Par rapport à l'ancienne version du modèle Llama, l'équipe de recherche a amélioré la quantité et la qualité des données utilisées pour la pré-formation et la post-formation, notamment en développant davantage de pipeline de pré-traitement et de gestion des données de pré-formation, et en développant davantage de données. méthodes rigoureuses d’assurance qualité et de filtrage des données post-formation.

Les responsables de Meta ont déclaré que sous l'influence de Scaling Law, le nouveau modèle phare a surpassé les modèles plus petits formés à l'aide de la même méthode.

L’équipe de recherche a également utilisé le modèle paramétrique 405B pour améliorer la qualité post-formation des petits modèles.

Afin de prendre en charge l'inférence de production de masse de modèles à l'échelle 405B, l'équipe de recherche a quantifié le modèle d'une précision de 16 bits (BF16) à une précision de 8 bits (FP8). Cela a effectivement réduit les ressources informatiques requises et a permis d'exécuter le modèle. sur un seul nœud de serveur exécuté à l'intérieur.

Il y a aussi quelques détails à explorer sur Llama 3.1 405B, comme sa conception qui met l'accent sur la praticité et la sécurité, lui permettant de mieux comprendre et exécuter les instructions de l'utilisateur.

Grâce à des méthodes telles que le réglage fin supervisé, l'échantillonnage de rejet et l'optimisation directe des préférences, plusieurs cycles d'alignement sont effectués sur la base du modèle pré-entraîné pour créer un modèle de discussion. Llama 3.1 405B peut également s'adapter plus précisément à des scénarios d'utilisation spécifiques. et les besoins des utilisateurs, améliorant les performances des applications réelles.

Il convient de mentionner que l'équipe de recherche de Llama utilise la génération de données synthétiques pour produire la grande majorité des exemples SFT, ce qui signifie qu'ils ne s'appuient pas sur des données du monde réel mais sur des données générées par des algorithmes pour entraîner le modèle.

De plus, l’équipe de recherche continue d’améliorer la qualité des données synthétisées grâce à de multiples processus itératifs. Afin de garantir la haute qualité des données synthétiques, l’équipe de recherche a utilisé diverses techniques de traitement des données pour le filtrage et l’optimisation des données.

Grâce à ces techniques, l'équipe est en mesure d'augmenter la quantité de données de réglage fin afin qu'elles ne soient pas uniquement applicables à une seule fonction, mais puissent être utilisées dans plusieurs fonctions, augmentant ainsi l'applicabilité et la flexibilité du modèle.

En termes simples, l'application de cette technologie de génération et de traitement de données synthétiques consiste à créer une grande quantité de données de formation de haute qualité, ce qui contribue à améliorer la capacité de généralisation et la précision du modèle.

En tant que partisan de la voie du modèle open source, Meta a également fait preuve de sincérité dans les « installations de support » du modèle Llama.

- Dans le cadre d'un système d'IA, le modèle Llama prend en charge la coordination de plusieurs composants, y compris l'appel d'outils externes.

- Publiez des systèmes de référence et des exemples d'applications open source, encouragez la participation et la collaboration de la communauté et définissez les interfaces des composants.

- Promouvoir l'interopérabilité des composants de la chaîne d'outils et des applications d'agents via l'interface standardisée « Llama Stack ».

- Une fois le modèle publié, toutes les fonctionnalités avancées sont ouvertes aux développeurs, y compris les flux de travail avancés tels que la génération de données synthétiques.

- Llama 3.1 405B est livré avec un pack cadeau d'outils intégrés, comprenant des projets clés pour simplifier le processus du développement au déploiement.

Il convient de noter que dans le nouvel accord open source, Meta n'interdit plus l'utilisation de Llama 3 pour améliorer d'autres modèles, y compris le plus puissant Llama 3.1 405B, une véritable bonne personne open source.

Ci-joint l’adresse du rapport de formation de thèse de 92 pages :

https://ai.meta.com/research/publications/the-llama-3-herd-of-models/

Une nouvelle ère dirigée par l’open source

L'internaute @ZHOZHO672070 a également rapidement testé les réponses de Llama 3.1 405B Instruct FP8 à deux questions classiques sur Hugging Chat.

Malheureusement, Llama 3.1 405B a rencontré un problème dans la résolution du problème « qui est le plus grand, 9.11 ou 9.9 », mais après avoir réessayé, il a donné la bonne réponse. En termes d'annotation pinyin de « Je l'ai attrapé », ses performances sont également acceptables.

Les internautes ont utilisé le modèle Llama 3.1 pour créer et déployer rapidement un chatbot en moins de 10 minutes.

De plus, le scientifique interne de Llama @astonzhangAZ a également révélé sur X que son équipe de recherche envisage actuellement d'intégrer des fonctions d'image, de vidéo et de voix dans Llama 3.

Le débat entre open source et source fermée se poursuit à l'ère des grands modèles, mais la sortie d'aujourd'hui du nouveau modèle Meta Llama 3.1 met fin à ce débat.

Meta a officiellement déclaré : « Jusqu'à présent, les modèles de langage open source à grande échelle sont pour la plupart à la traîne des modèles fermés en termes de fonctionnalités et de performances. Nous inaugurons désormais une nouvelle ère dirigée par l'open source.

La naissance de Meta Llama 3.1 405B prouve une chose. La capacité d'un modèle ne réside pas dans l'ouverture ou la fermeture, mais dans l'investissement des ressources, des personnes et des équipes derrière, etc. Meta peut choisir l'open source en raison de nombreux facteurs, mais il y aura toujours des gens qui porteront ce drapeau.

En tant que premier géant à profiter de la situation, Meta a également reçu le titre de premier SOTA à surpasser le grand modèle fermé le plus puissant.

Zuckerberg, PDG de Meta, a écrit dans un long article « L'IA Open Source est la voie à suivre » publié aujourd'hui :

"À partir de l'année prochaine, nous nous attendons à ce que le futur Llama soit le plus avancé du secteur. Mais avant cela, Llama ouvre déjà la voie en matière d'open source, de modifiabilité et de rentabilité."

Les modèles d'IA open source ne peuvent pas viser à surpasser les sources fermées, ou par égalité technique, afin qu'ils ne deviennent pas un moyen pour quelques personnes de réaliser des profits, ou dans l'espoir que chacun ajoute du carburant à la prospérité de l'IA. écosystème.

Comme Zuckerberg a décrit sa vision à la fin de son long message :

Je pense que la version 3.1 de Llama marquera un tournant dans l'industrie et que la plupart des développeurs commenceront à utiliser principalement des technologies open source. J'attends avec impatience que cette tendance se poursuive à partir de maintenant… Ensemble, nous nous engageons à apporter les avantages de l'IA. à tout le monde dans le monde.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo