Construire une « carte graphique bombe nucléaire » ne peut plus satisfaire Nvidia

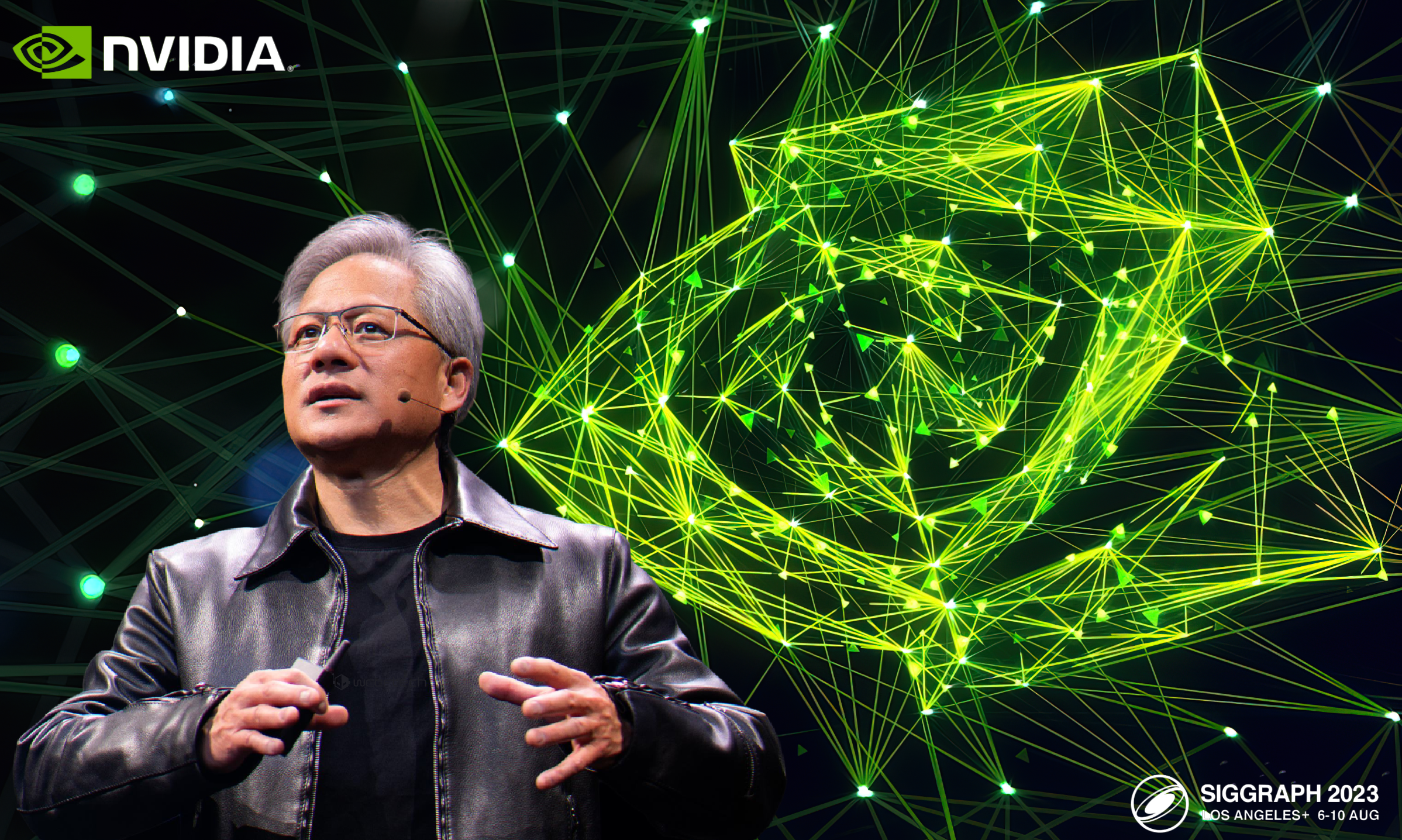

Chaque mois d'août, Nvidia montrera ses "muscles" à SIGGRAPH, la plus importante conférence d'infographie au monde.

Il y a cinq ans, le PDG de Nvidia, Huang Renxun, a lancé Quadro RTX, la première carte graphique prenant en charge le lancer de rayons, au SIGGRAPH 2018. Il s'agit du produit le plus important de Nvidia depuis le G80, faisant passer les GPU Nvidia de l'ère GTX à l'ère RTX.

A cette époque, Nvidia était encore un fabricant de puces de calcul graphique très pur, et son esprit était plein de comment pousser le rendu 3D à l'extrême.Sa valeur marchande était d'environ 81,4 milliards de dollars américains, et il n'était pas encore entré dans le club des 100 milliards. .

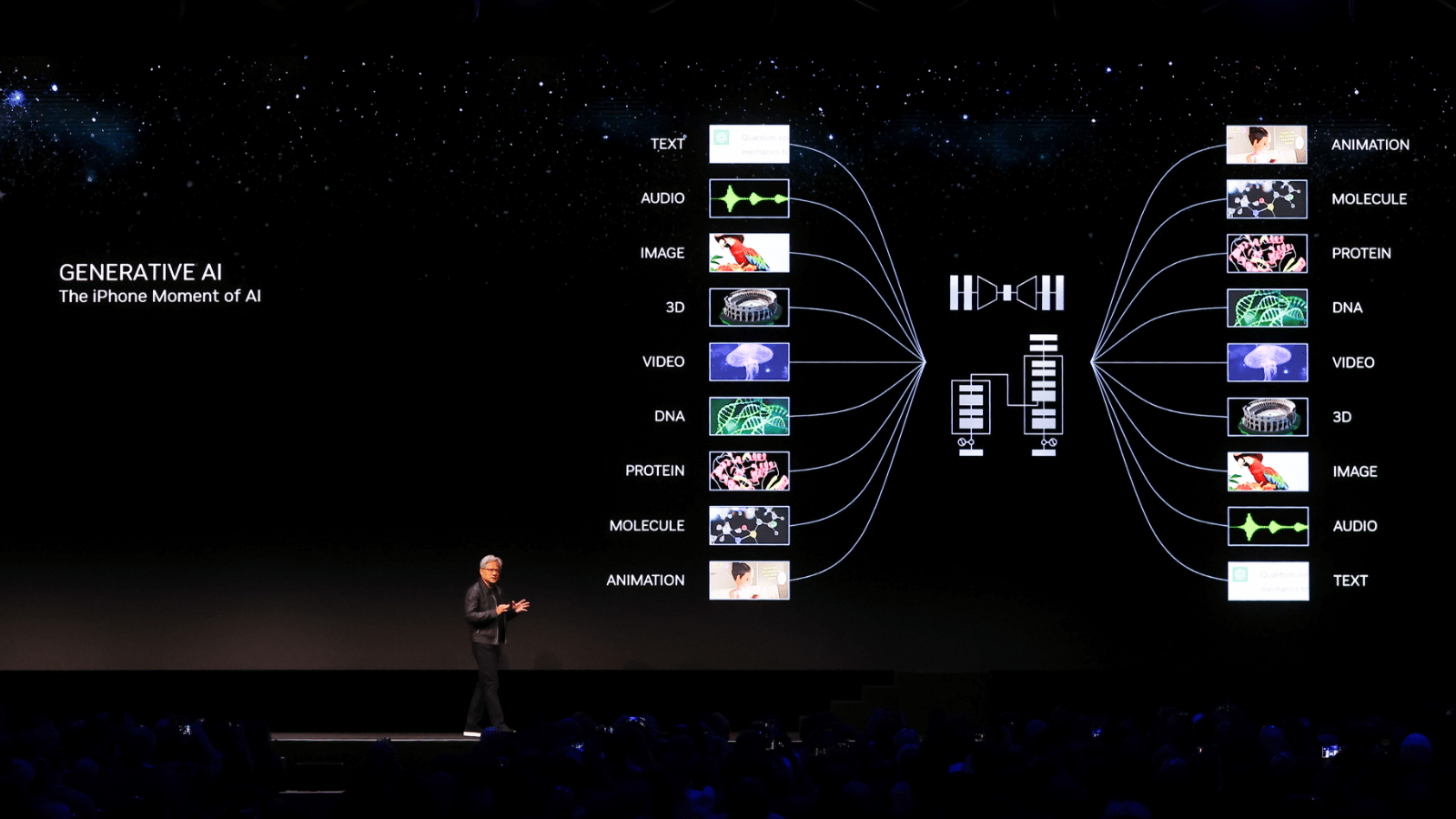

Mais en 2023, Nvidia a subi un changement radical. Lors de la conférence GTC en mars, après que Lao Huang ait lancé la phrase d'or "Le temps de l'iPhone d'IA est venu", le cours de l'action Nvidia a commencé à augmenter régulièrement, établissant constamment de nouveaux sommets historiques.

Au cours des cinq dernières années, le cours de l'action Nvidia a été multiplié par près de 10 et sa valeur marchande actuelle a dépassé 1 100 milliards de dollars, ce qui en fait la première société de puces au monde dont la valeur marchande dépasse 1 000 milliards de dollars américains. marché boursier.

Les cartes graphiques de Nvidia sont toujours populaires sur le marché, mais ce ne sont plus les joueurs qui recherchent l'image ultime, mais les géants de la technologie tels que Microsoft et Meta qui sont impatients de déployer et de former de grands modèles.

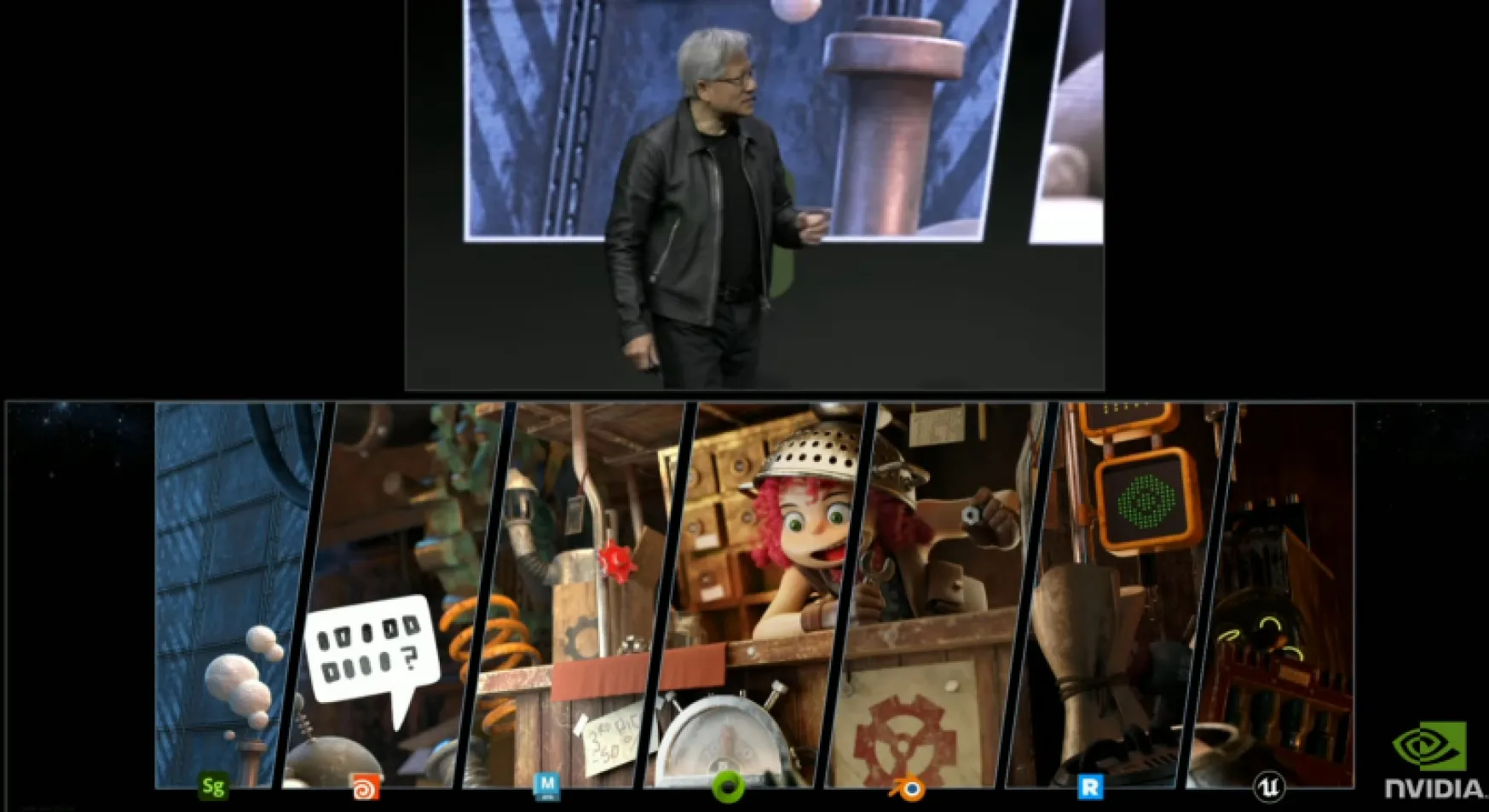

Lors du SIGGRAPH 2023 hier soir, il était difficile pour vous d'entendre Lao Huang prononcer des mots-clés familiers tels que jeux, rendu en temps réel et 3D, et les remplacer par des concepts tels que l'IA générative, les centres de données et l'informatique accélérée.

C'est un nouveau Nvidia, et une nouvelle ère.

Nvidia a changé

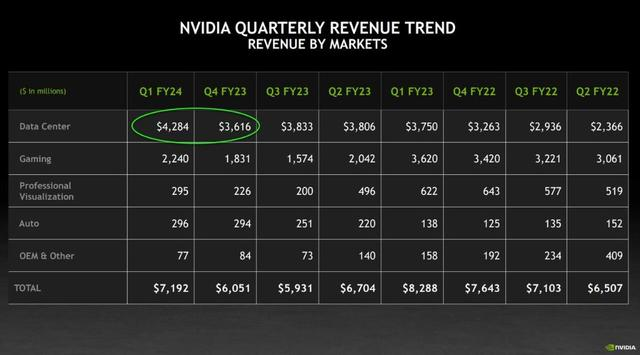

Nous pouvons interpréter de quel type d'entreprise il s'agit à partir du rapport financier de Nvidia.

Longtemps, l'activité jeux a été l'activité principale de Nvidia.Jusqu'au premier trimestre fiscal 2023, sous la double influence de la baisse de la consommation sur le marché des PC et de la montée en puissance de l'IA computing, l'activité data center de Nvidia a finalement rattrapé et est devenu le n° 1 de Nvidia Cela marque également la transformation officielle de Nvidia d'un fournisseur traditionnel de GPU en l'un des plus grands fournisseurs de puissance de calcul au monde.

Après cela, les centres de données de Nvidia ont commencé à monter en flèche, et ses cartes graphiques H100, A100 et autres sont devenues une monnaie forte dans l'industrie de l'IA, et il y avait une grave pénurie à un moment donné. Certains analystes pensent que le monde pourrait avoir besoin de 432 000 H100 pour répondre à la demande du marché.

Le dernier rapport financier trimestriel de Nvidia montre que grâce à la forte demande des entreprises, le chiffre d'affaires des centres de données de Nvidia au premier trimestre était d'environ 4,2 milliards, une augmentation en glissement annuel de 14% et une augmentation mensuelle de 18%, dépassant Les attentes de Wall Street.

Mais si vous pensez que Nvidia est juste le chanceux qui a été touché par l'argent chaud de l'IA, alors vous sous-estimez Lao Huang.

Pour Nvidia, construire un "GPU bombe nucléaire" et investir dans l'IA ne sont que des "travaux préparatoires" pour concrétiser leur vision ultime.Ce que Nvidia veut vraiment faire, c'est construire un véritable métaverse.

La "houe" la plus avancée

Si un travailleur veut faire du bon travail, il doit d'abord affûter ses outils, et Nvidia l'a bien compris.

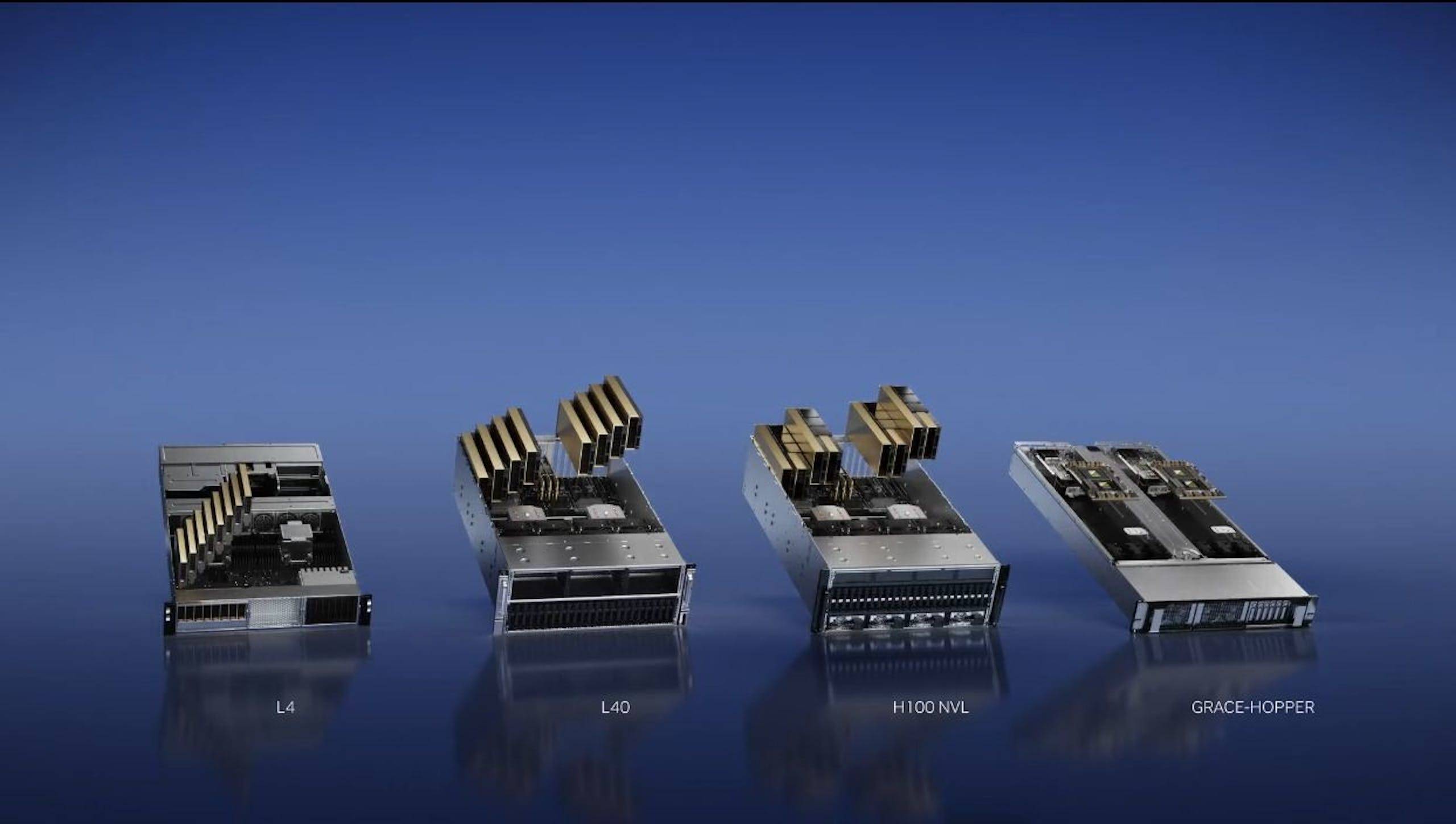

En mars de cette année, Nvidia a lancé quatre puces d'inférence IA, le GPU H100 NVL, le GPU L4 Tensor Core, le GPU L40 et NVIDIA Grace Hopper, pour répondre aux besoins croissants en puissance de calcul des entreprises.

Au Taipei Computer Show en mai, Lao Huang a sorti le supercalculateur DGX GH200 composé de 256 superpuces NVIDIA GH200 Grace Hopper.

Et pas plus tard qu'hier, Lao Huang a publié une nouvelle version de GH200 équipée de la mémoire HBM3e.Même la génération précédente de GH200 n'a pas encore été officiellement expédiée et la vitesse de mise à jour est effrayante.

Les différences entre l'ancien et le nouveau GH200 résident principalement dans la mémoire.

Le GH200 Grace Hopper est la première puce GPU au monde avec mémoire HBM3e, une augmentation de 50 % de la capacité de mémoire de 96 Go à 144 Go par GPU.

La mémoire HBM3e est un nouveau type de technologie de mémoire à large bande passante. En termes de vitesse de calcul, HBM3e peut être 50 % plus rapide que la vitesse de calcul HBM3, offrant un taux de transmission maximal de 5 To/s. Cela permet à la nouvelle version du GH200 d'exécuter des modèles d'IA 3,5 fois plus rapidement que les modèles actuels.

Parmi eux, la mémoire GH200 à double configuration peut atteindre 282 Go de mémoire HBM3e, soit une capacité multipliée par 3,5 et une bande passante multipliée par 3 par rapport à la génération précédente. Par rapport au populaire H100, la mémoire a augmenté de 1,7 fois et la bande passante a augmenté de 1,5 fois.

Comme la génération précédente, le nouveau GH200 a également une évolutivité exagérée.

Grâce à la technologie d'interconnexion NVLink de Nvidia, le GH200 peut être combiné dans des formes de différentes tailles selon les besoins des entreprises, telles que des serveurs monocarte, double carte, multicartes, des armoires et même des supercalculateurs.

En fin de compte, les GH200 peuvent être combinés dans le supercalculateur DGX GH200 SuperPod à 256 cartes, qui dispose de 144 To de mémoire rapide et peut effectuer 1018 opérations en virgule flottante par seconde.

Si cela ne vous suffit pas, vous pouvez également connecter plusieurs SuperPods Nvidia DGX GH200 avec un commutateur Nvidia Quantum-2 InfiniBand.

Lao Huang a dit en plaisantant: "Cela devrait pouvoir déplacer" Crysis "."

Une forte évolutivité offre des possibilités illimitées pour l'avenir du GH200.

En d'autres termes, si vous souhaitez augmenter la vitesse de calcul, il vous suffit d'ajouter plus d'armoires de serveurs. Ceci est très bénéfique à l'avenir. Huang Renxun estime que le scénario d'application typique du GH200 à l'avenir est le grand modèle de langage, et que le "calcul accéléré" et le "calcul IA" remplaceront progressivement le "calcul général" des GPU x86 traditionnels.

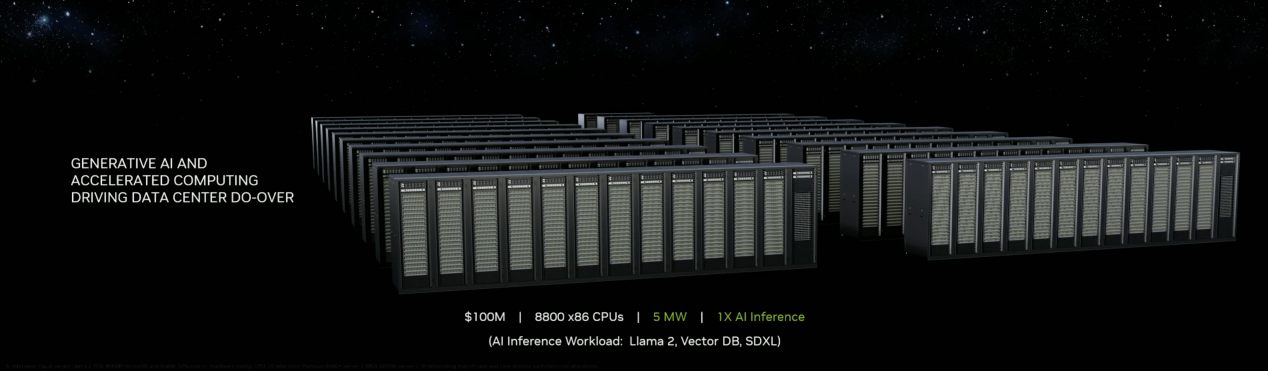

Par exemple, dans le dernier budget de 100 millions de dollars, il n'était possible que de construire un petit centre de données, d'acheter 800 GPU x86 et d'utiliser 5 mégawatts d'électricité pour fonctionner.

Mais avec le même budget, Grace Hopper, qui choisit le calcul accéléré, n'a besoin de consommer que 3 mégawatts d'électricité, et le débit de données peut être augmenté d'un ordre de grandeur. Et si le calcul est basé sur la même charge de travail, le plan de calcul de Grace Hopper n'a besoin que de 8 millions de dollars américains.

En parlant de cela, Lao Huang a lancé son célèbre dicton : "Plus vous achetez, plus vous économisez".

Les responsables prévoient que le nouveau GH200 devra attendre le deuxième trimestre de 2024 pour être lancé. Le GH200 équipé de la mémoire HBM3 sera livré au second semestre de cette année comme initialement prévu.

Bien sûr, pour les développeurs individuels et les petites équipes, il n'est pas réaliste de construire un centre de données valant des centaines de millions.Pour cette raison, Nvidia a "intimement" lancé une nouvelle génération de cartes graphiques pour stations de travail intégrant la technologie RTX avancée : NVIDIA RTX 5000. , NVIDIA RTX 4500 et NVIDIA RTX 4000.

Parmi eux, en tant que GPU phare, NVIDIA RTX 5000 adopte le Tensor Core de 4e génération et le RT Core de 3e génération.32 Go de mémoire vidéo GDDR6, prend en charge la vérification des erreurs ECC, convient aux stations de travail haut de gamme, aux centres de données et aux jeux en nuage.

En tant que GPU moyen à haut de gamme, NVIDIA RTX 4500 est équipé d'une mémoire vidéo GDDR6 de 24 Go et prend également en charge la vérification ECC.

Par rapport à la génération précédente de produits, NVIDIA RTX 4500 double les performances du ray tracing et double les performances du traitement de l'IA.

NVIDIA RTX 4000 utilise le même cœur GPU que RTX 4500, équipé d'une mémoire vidéo GDDR6 de 20 Go, et ses performances de traçage de rayons et de calcul AI ont été considérablement améliorées.

Le nouveau GPU NVIDIA RTX 5000 est actuellement en vente et les GPU NVIDIA RTX 4500 et RTX 4000 seront expédiés au cours du second semestre de cette année.

La "terre" la plus fertile

En appliquant les mots publicitaires de Nongfu Spring, nous pouvons présenter la dernière stratégie d'IA de Nvidia comme suit :

Nous ne produisons pas d'IA, nous ne sommes que des porteurs d'IA.

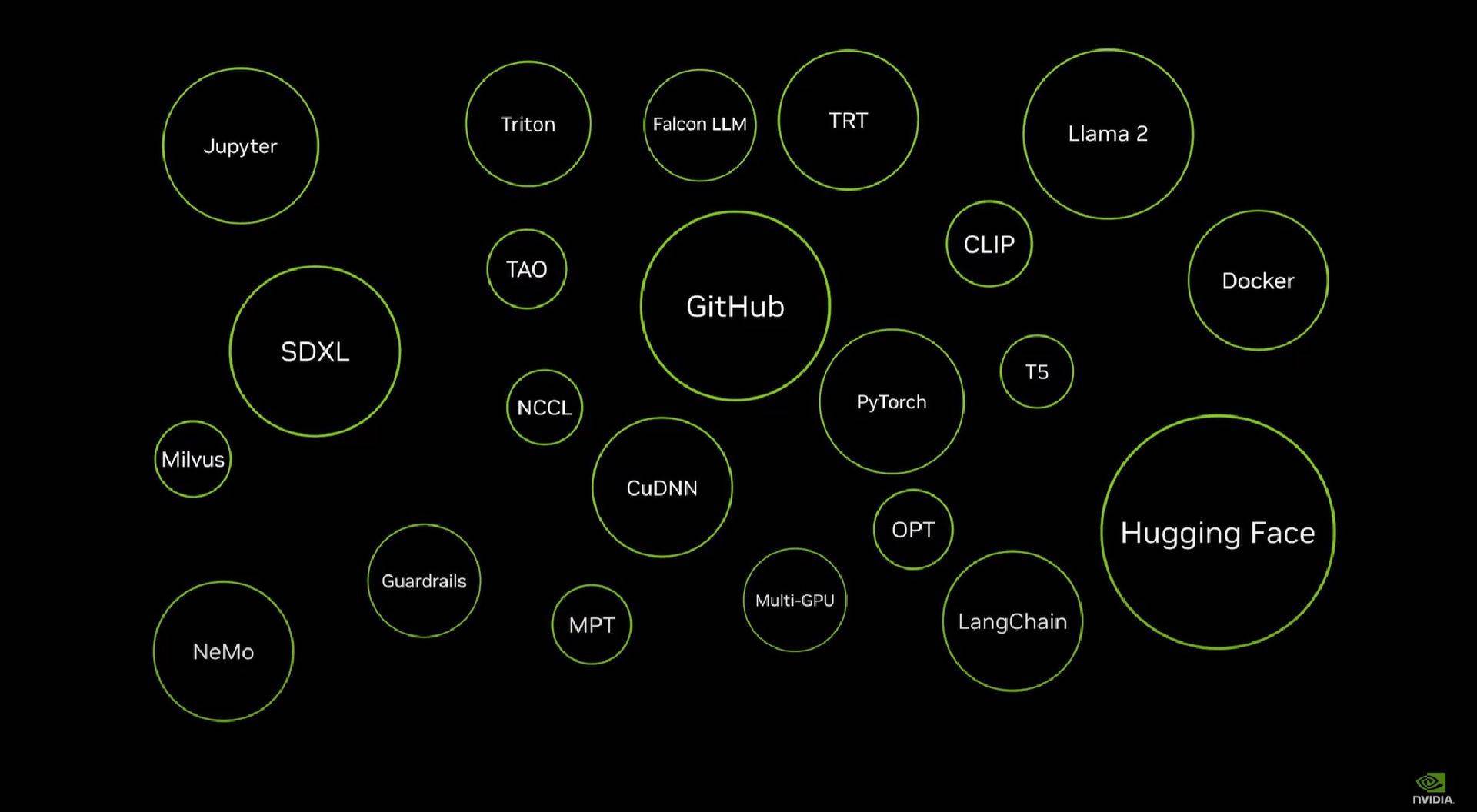

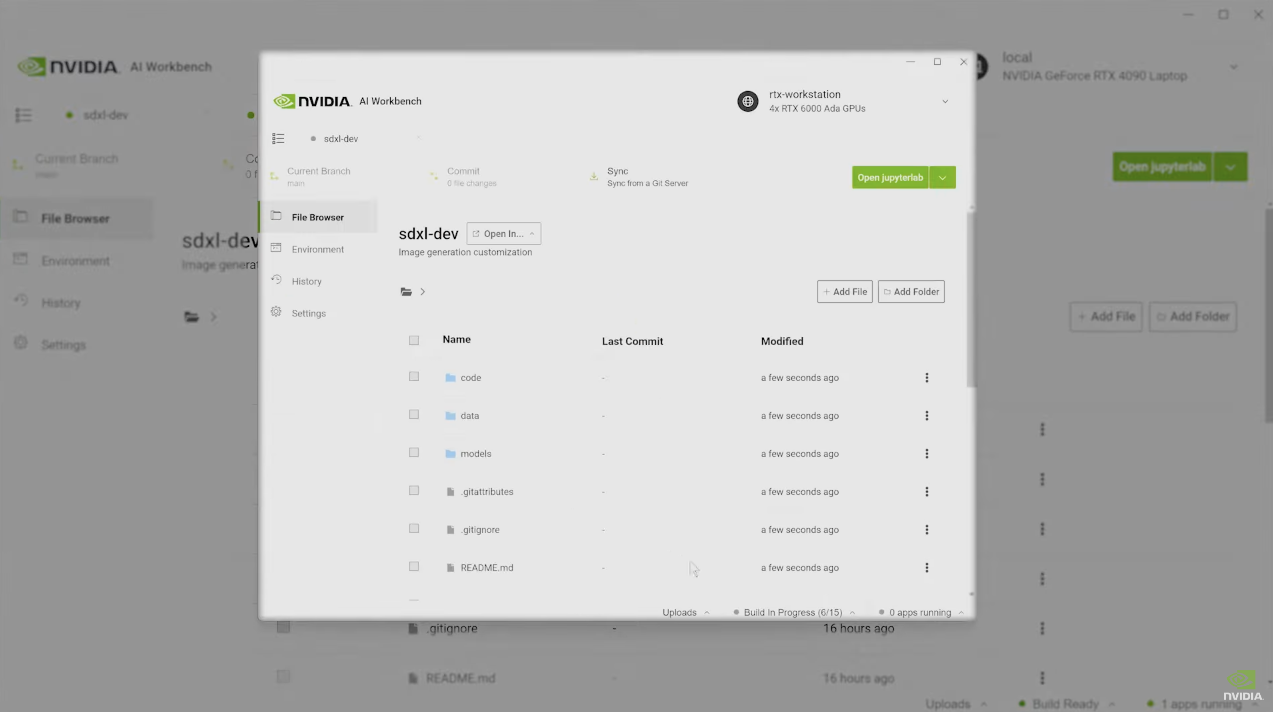

Comme nous le savons tous, configurer localement des modèles d'IA est une tâche fastidieuse et compliquée.Afin d'aider les développeurs à résoudre ce problème, Lao Huang a annoncé que Nvidia lancerait "AI Workbench".

Pour le dire simplement, AI Workbench peut fournir aux développeurs le cadre, le kit de développement d'outils et d'autres environnements nécessaires pour configurer les modèles d'IA de manière unique, et ils peuvent commencer à créer des projets directement.

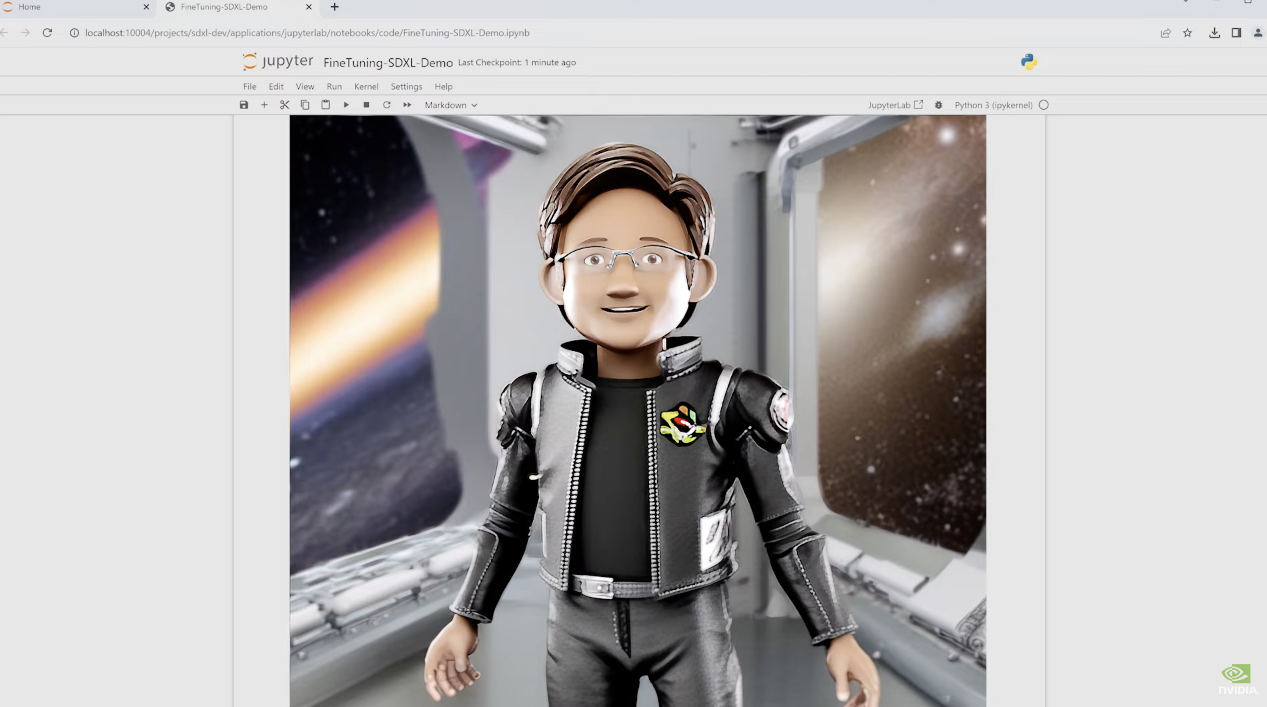

Lao Huang a donné un exemple très frappant sur les lieux.

Par exemple, l'entreprise doit configurer un modèle de diffusion stable pour la peinture, mais vous n'avez pas de matériel ni ne savez comment configurer le modèle.

Ne vous inquiétez pas, pour le moment, il vous suffit d'ouvrir AI Workbench, de choisir un poste de travail cloud avec 4 GPU RTX 6000 Ada, puis de configurer le modèle Stable Diffusion en un clic.

Si vous n'êtes pas satisfait des images générées, vous pouvez également télécharger les images vous-même, recycler le modèle et les générer à nouveau.

En moins d'une minute, une image décente est générée et vous n'avez pas à vous soucier d'autres problèmes tout au long du processus, car AI Workbench a déjà préparé tout le reste.

Nvidia a annoncé qu'elle établirait un partenariat stratégique avec Hugging Face, une plate-forme d'IA open source, et appliquerait cette technologie au côté de l'entreprise.

En quelques clics sur la plate-forme Hugging Face, les développeurs peuvent facilement déplacer des projets d'IA générative d'ordinateurs portables vers des stations de travail, puis vers des centres de données ou des clouds, et enfin utiliser les ressources de supercalcul d'IA NVIDIA DGX pour former des modèles d'IA.

Lao Huang a souligné que grâce à la coopération avec Hugging Face, la technologie d'intelligence artificielle la plus avancée de Nvidia peut fournir une assistance à tous les horizons. Les entreprises peuvent également utiliser la puissance de la communauté open source pour promouvoir la formation à l'IA en fonction des besoins de planification de l'entreprise.

Plus grand rêve"

Après avoir présenté la mise à jour de la plate-forme logicielle et matérielle, Lao Huang a déclaré avec un long souffle : "Parlons du sujet le plus important ce soir, OpenUSD."

OpenUSD devrait être un terme inconnu pour la plupart des gens. OpenUSD est un framework open source de Pixar (oui, le Pixar qui a fait l'animation) en 2015. Avant cela, Pixar utilisait ce framework depuis plus de 10 ans.Beaucoup d'animations que nous avons vues sont basées sur le framework OpenUSD.

OpenUSD peut être compris comme une norme universelle pour la création de mondes 3D à des fins de description, de combinaison, de simulation et de coopération. Huang l'a comparé à "la signification du HTML pour les pages Web 2D" et à "réunir vraiment le monde entier".

Pas plus tard que la semaine dernière, Pixar, Adobe, Apple, Autodesk, Nvidia et JDF ont annoncé la formation de l'OpenUSD Alliance (AOUSD) pour promouvoir la normalisation, le développement, l'évolution et la croissance d'OpenUSD.

Pourquoi ce nom méconnu rassemble-t-il autant de géants dans des domaines différents ? Cela commence par le flux de travail du travail 3D.

Les flux de travail 3D sont très granulaires et complexes, par exemple les concepteurs, les artistes et les ingénieurs se spécialisent tous dans une certaine partie du flux de travail 3D comme la modélisation, la texturation, les matériaux, la simulation physique, l'animation, la scénographie et la composition.

Étant donné que les outils qu'ils utilisent (PS, AutoCAD, Blender, etc.) sont développés par différentes sociétés, de nombreux formats de fichiers ne sont pas compatibles entre eux, ce qui oblige les utilisateurs à fréquemment exporter, convertir des formats et importer, ce qui est fastidieux et facile à endommager. le contenu.

OpenUSD est une technologie créée pour résoudre ces problèmes. Grâce à OpenUSD, des outils tels qu'Adobe Stager, Houdini, Maya, Blender, Renderman, Minuteman de Pixar et Unreal Engine d'Epic peuvent tous échanger des données et jouer un rôle plus puissant.

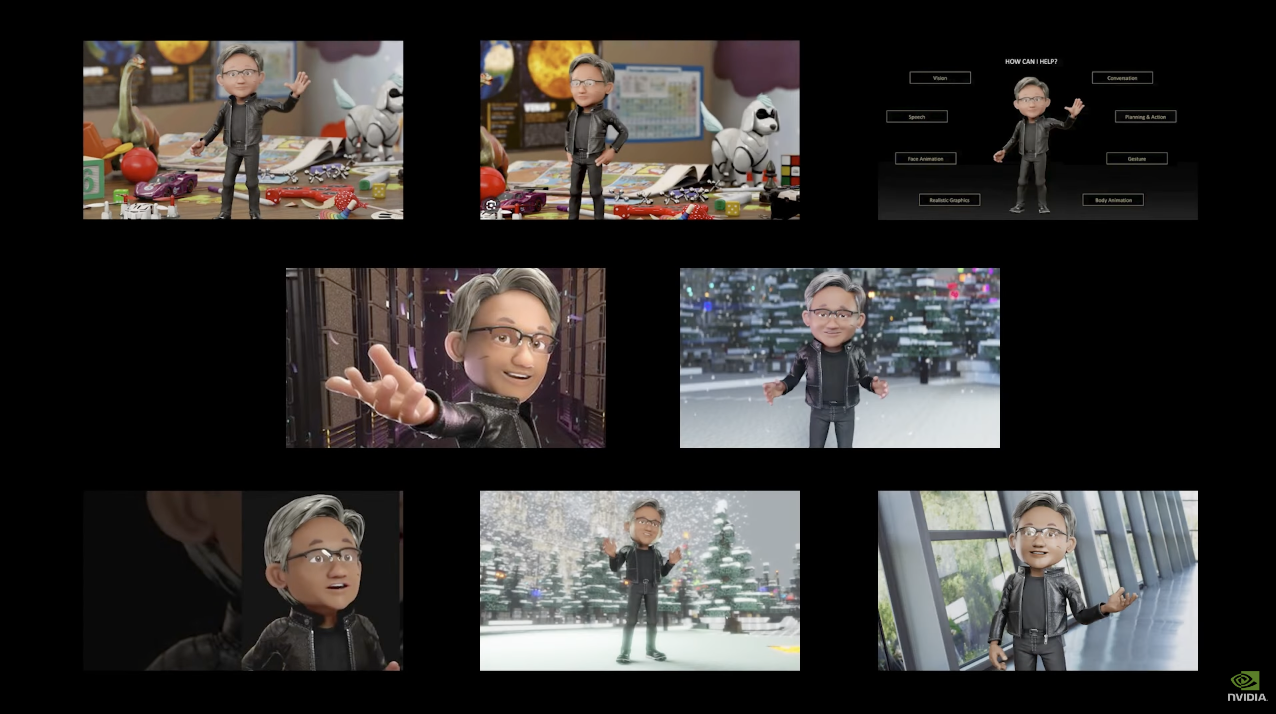

Plus tard, Lao Huang a solennellement annoncé que l'Omniverse de Nvidia deviendrait la première plate-forme entièrement conçue pour OpenUSD.De la base de données sous-jacente au système moteur, chaque ligne de code est conçue autour d'OpenUSD.

Non seulement cela, Nvidia a également lancé des API telles que RunUSD, ChatUSD et DeepSearch, qui réduiront encore le seuil permettant aux développeurs de créer des applications basées sur OpenUSD, permettant aux flux de travail 3D d'être combinés avec l'IA et d'autres technologies.

Par exemple, la publicité produite par WPP, la plus grande société de publicité au monde, pour le Denza N7 de BYD a été filmée dans "Metaverse".

WPP a téléchargé les données CAO de haute précision de Denza N7 sur Omniverse pour créer une voiture jumelle numérique, puis les artistes WPP peuvent créer dans l'environnement Omniverse.

Par exemple, vous pouvez appeler l'API ChatUSD et n'avoir qu'à saisir une description en une phrase pour permettre à l'IA de générer différents environnements d'arrière-plan, créant ainsi des milliers de clips de contenu personnalisés pour les activités de marketing mondiales.

Le métaverse et l'IA générative sont comme une paire naturelle. Lorsque les deux se rencontrent, leur valeur sera amplifiée de façon exponentielle, et la technologie OpenUSD rend tout cela possible.

Lao Huang estime qu'à l'avenir, de plus en plus d'industries devront subir une transformation numérique, et l'omniverse et l'intelligence artificielle deviendront bientôt le flux de travail le plus important pour ces entreprises pour mener à bien la transformation numérique.

Pour construire l'Omnivers et l'intelligence artificielle, il est naturellement indissociable d'un support à forte puissance de calcul, c'est la vraie forme de Nvidia :

Avec le GPU comme épine dorsale et l'IA comme peau, il constitue la main la plus puissante pour promouvoir la transformation numérique industrielle.

#Bienvenue pour prêter attention au compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo