Dialogue avec Jiang Daxin, fondateur de Step Star : les modèles multimodaux n’ont pas encore atteint le moment GPT-4 et nous insistons sur la poursuite de la « limite supérieure de l’intelligence »

La question de savoir si l’IA parviendra à la seconde période peut être discutable, mais il est certain que les grands modèles parviendront aux huitièmes de finale.

Après l’émergence de DeepSeek R1, la tendance s’est intensifiée. Rien que cette année, OpenAI, Anthropic, Google, Meta et Grok ont publié au moins 8 nouveaux modèles. Certains tigres nationaux de l’IA ont également commencé à abandonner la pré-formation et à mettre de côté l’idéalisme de l’AGI.

Parmi elles, Step Star est une entreprise un peu particulière. Il y avait peu de nouvelles de financement avant la fin de l'année dernière, mais il est devenu le « roi du volume » des modèles multimodaux. Elle a publié 22 modèles de base auto-développés au cours de ses 2 années d'existence, devenant ainsi la licorne IA la plus discrète et la plus mystérieuse.

Jiang Daxin, fondateur et PDG de Step Star, est aussi discret que l'entreprise et apparaît rarement dans le domaine animé de l'opinion publique de l'industrie de l'IA.

Hier, Jiang Daxin a tenu une réunion de communication approfondie avec l'APPSO et d'autres médias. Il a partagé avec nous son point de vue sur les voies AGI, les modèles multimodaux et d'autres technologies, ainsi que sur les projets futurs de Step Star.

Les modèles multimodaux ne sont pas encore apparus dans GPT-4, poursuivant la « limite supérieure de l'intelligence »

L’involution actuelle dans le domaine des grands modèles d’IA n’a pas de fin, et des drames féroces de « versions rapprochées » sont constamment mis en scène parmi les grandes entreprises.

Cependant, Jiang Daxin estime toujours que « la poursuite de la limite supérieure de l'intelligence est toujours au centre de l'industrie de l'IA à ce stade. » En d'autres termes, bien qu'il existe actuellement de nombreux modèles sur le marché, et qu'ils semblent tous tout à fait capables, ils sont encore loin d'être vraiment « intelligents ».

Tout le monde se précipite pour sortir de nouveaux modèles, et cela a l'air vivant, mais si vous bricolez simplement le niveau actuel, ce ne sera qu'une « involution » de l'immobilité.

Jiang Daxin estime que le plus important maintenant est de trouver un moyen d'augmenter le « QI » de l'IA, sinon elle sera encore loin de l'AGI (intelligence artificielle) à laquelle tout le monde pense.

Après le lancement de DeepSeek R1 et l’entrée très médiatisée de grands fabricants, de nombreuses start-up ont commencé à abandonner le développement de modèles de base. Cependant, Jiang Daxin a déclaré dans une interview avec APPSO :

La technologie dans l’industrie de l’IA se développe très rapidement et se situe encore dans une fourchette très abrupte. Nous ne voulons pas abandonner la croissance dominante ou la tendance à l'avenir dans ce processus, c'est pourquoi nous continuerons à nous en tenir à la recherche et au développement de modèles de base.

Dans le même temps, Jiang Daxin a déclaré que les applications et les modèles se complètent. Le modèle peut déterminer la limite supérieure de l'application, et l'application fournit au modèle des scénarios et des données d'application spécifiques.

Alors, comment pouvons-nous rendre l’IA plus intelligente ? Une voie clé donnée par Jiang Daxin est la suivante : « La multimodalité est le seul moyen d'atteindre l'AGI. »

Beaucoup de gens disent que cette année est la première année d'Agent. Jiang Daxin estime que l'épidémie d'Agent nécessite deux conditions nécessaires, l'une est la capacité multimodale et l'autre est la capacité de réfléchir lentement .

La multimodalité, pour parler franchement, signifie que l’IA peut non seulement comprendre du texte, mais aussi voir des images, écouter des sons et comprendre des vidéos.

Si l’on y réfléchit, les gens n’ont besoin que de leurs yeux, de leurs oreilles, de leur bouche et de leur nez pour comprendre pleinement le monde. L'IA doit également être ainsi, devenir une « polyvalente » capable d'écouter, de voir et de parler.

Step Star peut être considéré comme le « roi des volumes » des modèles multimodaux. Elle sort un grand modèle de base presque tous les mois, dont 16 modèles multimodaux. Il couvre la compréhension et la génération d'images, de vidéos, de discours et de musique. Selon les mots de Jiang Daxin, il adhère au « concept multimodal natif ».

Cependant, Jiang Daxin est également très honnête. Il a franchement déclaré qu '" il n'y a pas encore eu de moment GPT-4 dans le domaine des modèles multimodaux".

Même si la multimodalité est désormais très populaire et que tout le monde en fait la promotion, il n’existe pas encore de produit de référence comme GPT-4 dans le domaine du texte. Quand il sortira, il dira « Wow » et fera penser à tout le monde « Ça y est ». Il reste encore de nombreux os durs à ronger techniquement.

Trilogie de combat de monstres améliorée par l'IA

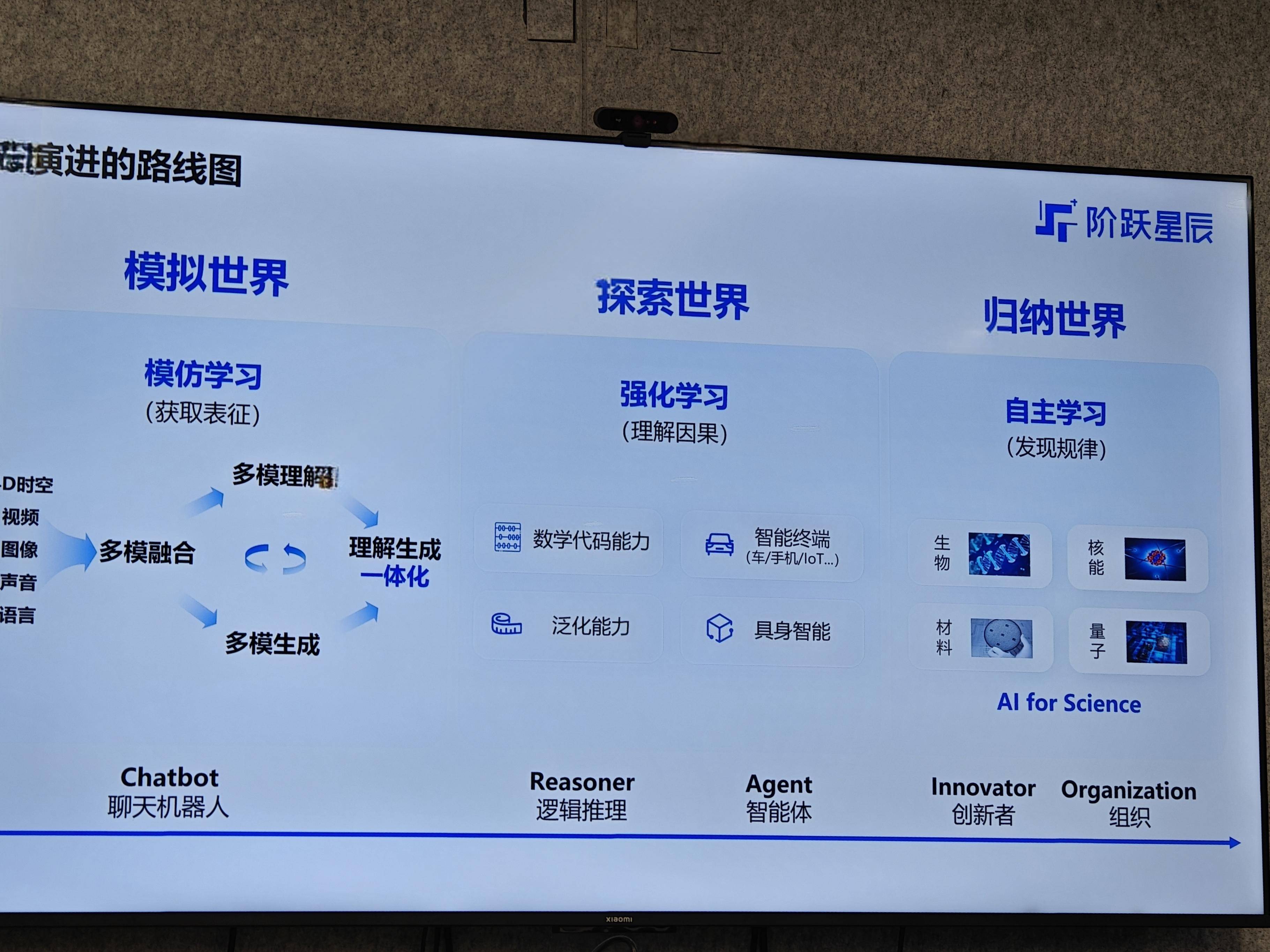

Concernant la façon dont le modèle approche étape par étape la limite supérieure de l'intelligence, Jiang Daxin a tracé une feuille de route d'évolution claire en « trilogie ». On peut également dire que c'est la direction d'évolution de l'AGI comprise par Step Star.

Monde simulé (étape d'apprentissage par imitation) : L'IA à ce stade est comme un enfant qui vient d'apprendre à parler. Donnez-lui une grande quantité de données et il apprendra. La tâche principale est de « prédire le prochain jeton » (prédire le mot suivant) ou « prédire la prochaine image » (prédire la prochaine image). Le but est de permettre à l’IA d’apprendre d’abord à quoi ressemble le monde et quelles sont les caractéristiques de diverses choses.

Explorer le monde (étape d'apprentissage par renforcement) : Il ne suffit pas d'être capable d'imiter, il faut aussi développer la capacité à résoudre des problèmes complexes. Par exemple, résoudre un problème de l'Olympiade mathématique ou écrire un morceau de code complexe nécessite une « réflexion lente ». À l'heure actuelle, un apprentissage par renforcement est nécessaire, afin que l'IA puisse apprendre à résoudre le problème étape par étape grâce à des essais et des erreurs continus.

Monde inductif (étape d'apprentissage autonome de la machine) : C'est l'état le plus élevé. L’IA peut non seulement résoudre des problèmes connus, mais aussi découvrir par elle-même de nouvelles lois et créer des innovations auxquelles les humains n’avaient pas pensé. Par exemple, dans le domaine de la recherche scientifique, nous aidons les scientifiques à découvrir de nouveaux matériaux, de nouveaux médicaments, etc.

Ces trois étapes coïncident avec les concepts fondamentaux des cinq niveaux AGI proposés par OpenAI. Le développement actuel de l’ensemble de l’industrie de l’IA progresse essentiellement selon ce scénario.

Pourquoi « comprendre l'intégration des générations » est-il si important ?

En termes de multimodalité, notamment d'images et de vidéos, Jiang Daxin a souligné à plusieurs reprises lors de la réunion de communication un mot : l'intégration de la compréhension et de la génération.

Comprendre l'intégration générative est une question centrale dans le domaine de la vision par ordinateur et est cruciale pour réaliser l'AGI.

Pour parler franchement, cela signifie que le modèle peut non seulement comprendre ce que signifie une image ou une vidéo, mais également créer de nouvelles images et vidéos pertinentes sur la base de cette compréhension. De nos jours, il s'agit souvent de « utiliser le modèle A pour voir des images et utiliser le modèle B pour dessiner des images », ce qui équivaut à deux départements qui ne peuvent pas coopérer.

Il a donné un exemple, comme celui d'un enseignant écrivant au tableau. Désormais, Sora peut imiter les mouvements d'écriture du professeur, mais ce à quoi le professeur pense et ce qu'il va écrire ensuite dépend de la « compréhension ». Si la compréhension et la génération sont deux systèmes, alors il sera difficile pour le modèle de vraiment vous « comprendre », et les éléments générés peuvent également ne pas être pertinents.

Les modèles de langage comme ChatGPT ont fait du bon travail à cet égard, mais dans le domaine visuel, les données sont trop complexes, ce problème n'est donc pas encore entièrement résolu. Step Star a continué à investir dans ce domaine et souhaite surmonter ce goulot d'étranglement technique.

En fin de compte, de puissantes capacités de modèle doivent être appliquées pour incarner la valeur. Step Star adopte la stratégie du « super modèle et super application à deux roues motrices ».

Au niveau des applications, Step Star considère « l'agent terminal intelligent » comme sa direction clé de développement. Jiang Daxin estime que les terminaux intelligents, qu'il s'agisse de téléphones portables dans nos poches, de voitures que nous conduisons quotidiennement ou de robots qui pourraient être populaires à l'avenir, ne sont pas seulement du matériel froid, mais aussi « une extension de la perception et de l'expérience des utilisateurs ».

Cela signifie que si l’IA peut être profondément intégrée à ces terminaux, elle pourra mieux « comprendre les besoins des utilisateurs et le contexte des tâches ».

Par exemple, le produit phare d'OPPO, le Find X8 Ultra, a officiellement lancé sa première fonction de « mémoire flash en un clic ». L'IA peut identifier intelligemment le contenu sur l'écran du téléphone, générer des résumés pour les utilisateurs et classer les informations fragmentées dans différentes collections de mémoire.

Derrière cela se cache en fait le modèle multimodal Step Star, qui peut comprendre le contenu affiché à l'écran, qu'il s'agisse d'images ou de texte, et les utilisateurs peuvent poser des questions à ce sujet. L'IA peut non seulement répondre, mais également effectuer un traitement d'image et même aider les utilisateurs à effectuer certaines opérations dans l'application, comme accéder directement à la page de réservation de vol et remplir les informations.

Ce type de coopération intègre plus profondément les capacités des grands modèles et systèmes et les intègre dans les scénarios d'utilisation des téléphones mobiles les plus fréquents par les utilisateurs. L’intérêt de choisir les téléphones mobiles comme point d’entrée réside dans les propriétés naturelles d’interaction multimodale des téléphones mobiles et dans l’énorme base d’utilisateurs, qui fournit des données réelles riches et un retour instantané pour l’itération du modèle.

En général, l'idée de Step Star est assez claire : viser techniquement l'AGI et se concentrer sur des questions fondamentales telles que la multimodalité et l'intégration de la compréhension et de la génération. En termes d'application, nous devons identifier le point de rupture des terminaux intelligents et travailler avec les fabricants de matériel pour bien comprendre le scénario.

Ce chemin n'est pas facile à parcourir, mais Jiang Daxin et son équipe semblent assez déterminés. Après tout, pour utiliser l’IA pour résoudre des problèmes du monde réel, vous devez d’abord être reconnu par les utilisateurs sur le marché avant d’avoir la possibilité d’explorer le plafond de l’AGI. Voyons quelles nouvelles choses le roi multimodal des Step Stars peut proposer.

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (WeChat ID : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo