La beauté IA s’empare de Xiaohongshu, ce n’est pas si mal

Récemment, la nouvelle d'une cyberbeauté s'emparant de Xiaohongshu est devenue virale dans le groupe de discussion WeChat.

Les enregistrements de discussions de groupe montrent que certains internautes ont utilisé un logiciel de gestion de matrice de comptes pour contrôler 1 327 comptes et ont directement « tué » Xiaohongshu. En conséquence, le système push ne l’a pas reconnu et a plutôt aidé à pousser le flux.

Du point de vue de l'utilisateur, je regarde cette belle femme depuis longtemps et je suis sur le point de trouver le courage de la contacter. Dites-moi, c'est en fait de l'IA ?

Ce jour-là, c'était un effondrement.

Après la diffusion de la nouvelle, l’opinion publique s’est rapidement divisée en deux factions.

L'école provinciale estime que compte tenu de la nécessité de gérer des milliers de numéros de téléphone portable tout en évitant la détection de l'IA, elle constitue probablement le récolteur de poireaux ultime pour les logiciels d'IA ou les logiciels matriciels.

L’autre groupe estime que presque tous les médias sociaux ont été visités par des pirates informatiques, et il est logique que le système de détection de Xiaohongshu ne puisse pas rattraper son retard.

C'est juste que même le beau blogueur de Xiaohongshu ne s'attendait pas à ce qu'un jour son adversaire soit une IA qui ne pouvait même pas voir à l'œil nu.

La cyberbeauté s'empare de Xiaohongshu, à qui ça fait du mal ?

Comme d'habitude, prenez d'abord quelques photos et voyez combien d'indices vous pouvez repérer.

Pour être honnête, si nous n’avions pas zoomé et jeté un coup d’œil à l’interface, nous pourrions à peine détecter la saveur IA de ces photos ? Même si vous observez attentivement, il existe certaines photos dont même les passionnés d’IA n’oseront peut-être pas se porter garant.

▲Photo de @imxiaohu

Et si les nouvelles qui circulent sont vraies, alors nous pouvons identifier grossièrement quelques victimes…

Les utilisateurs qui ont été tenus dans le noir, les beaux blogueurs impliqués, la plateforme Xiaohongshu elle-même et les programmeurs qui ont dû faire des heures supplémentaires…

Lorsqu’un nombre écrasant d’images d’IA se précipitent vers le public, un mécanisme de filtrage se met en place.

Après tout, il n'y a que quelques utilisateurs aux yeux perçants, et des gens plus ordinaires ne quitteront que par inadvertance leur propre « trois connexions en un clic », puis feront des allers-retours dans le tourbillon des images de l'IA.

L’IA vous torture des milliers de fois, mais vous la traitez comme votre premier amour.

Dans la lutte contre les images de l’IA, il ne serait pas surprenant que le mécanisme d’examen de Xiaohongshu ne parvienne pas à identifier l’IA.

L’émergence de logiciels de retouche photo tels que PS a changé le véritable visage de la photographie et les frontières entre les personnes réelles et virtuelles sont devenues floues. Comparée à une sorte de « cajolerie » de beauté qui viole les lois de Newton, l’IA semble parfois trop conservatrice.

Tout comme lorsque nous sommes confrontés à des photos d'une beauté éblouissante, nous manquerons inévitablement l'atmosphère de prise de photo « la photo originale sort tout droit ». De la même manière, nous critiquons désormais les images de l’IA pour des raisons morales.

Il n’y a pas de bien ou de mal absolu. Nous pouvons accepter l’existence d’images IA. Mais le problème des cyberblogueurs est qu’ils ne sont pas assez transparents dans leurs actions. Aussi mauvais qu’ils soient, ils doivent quand même s’identifier pour les photos de l’IA.

À l’ère de l’économie de l’attention, nous n’aimons ni ne sommes heureux d’être secrètement coupés par l’IA.

Cet incident va donc toucher les nerfs sensibles des utilisateurs. Quant aux programmeurs de Xiaohongshu qui pourraient être concernés, ma suggestion est de faire davantage d'heures supplémentaires.

De plus, avec la vitesse de génération d'images de deuxième niveau et la possibilité de convertir n'importe quelle scène à volonté, une fois que des images d'IA extrêmement peu coûteuses inonderont la plate-forme, les blogueurs beauté de Xiaohongshu seront confrontés à de graves défis de survie, et cela entraînera également de graves conséquences. la plate-forme. Un coup dur.

Utiliser la beauté de l’IA pour récolter la laine repose sur les compétences

Utiliser des images IA de belles femmes pour récolter la laine dépend de vos capacités.

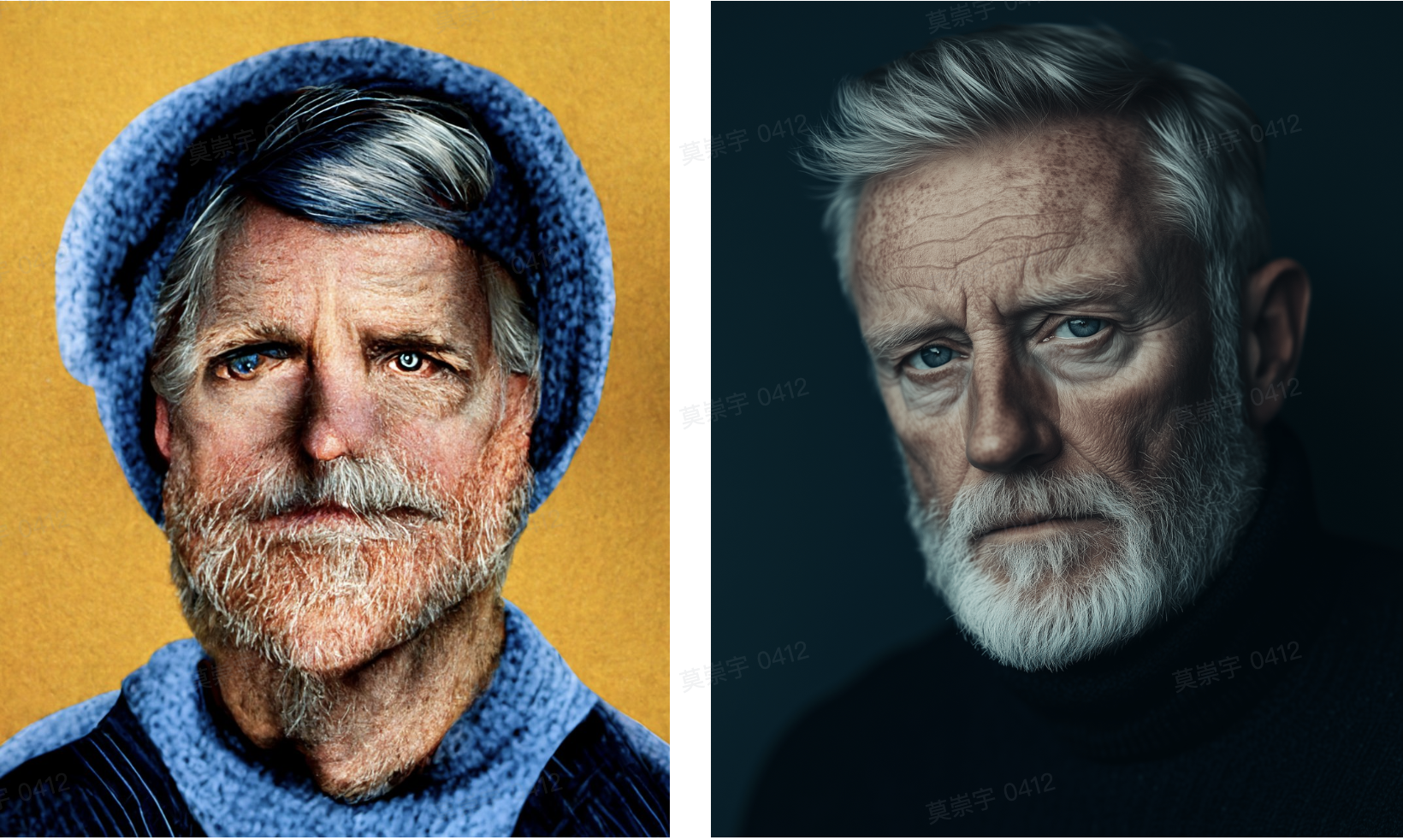

Dans le passé, les images générées par l'IA présentaient parfois des problèmes tels qu'une asymétrie, des erreurs d'ombre ou des textures floues dans les détails, et les mains, les yeux et la répétition de l'arrière-plan des personnages étaient les « zones les plus durement touchées ».

Cependant, pendant que vous riez encore de ces mauvaises images d'IA à six doigts, la technologie de génération d'images d'IA a déjà atteint le niveau supérieur.

Si vous n'y croyez pas, autant comparer les effets de génération d'images de Midjourney v1 et v6.1.

Si cela n'est pas assez intuitif et choquant, regardez la transformation itérative de Midjourney de la v1 à la v6 en seulement un an et demi.

Fait amusant, la version v6 est sortie en décembre de l’année dernière.

Y compris au début du mois dernier, les images « TED Speaker » de Google ont trompé des dizaines de millions d'internautes avec leurs détails réalistes, et même le logiciel de reconnaissance de l'IA n'a trouvé aucun défaut.

Quand une baleine tombe, toutes choses naissent. Lorsque l'IA de stabilité de la licorne semble accomplir la prophétie de « chute », les personnes qui s'enfuient se rassemblent comme une boule de feu et se dispersent comme des étoiles dans le ciel.

Des révélations ultérieures ont révélé que la photo populaire « TED Speaker » de Google avait en fait été produite à l'aide de la version réelle de LoRA de Flux. L'auteur est également Léo Kadieff, ancien membre de l'équipe de Stable Diffusion.

L'amélioration de la qualité de la génération d'images IA au cours des deux dernières années est évidente pour tous, et les raisons ne sont pas difficiles à comprendre.

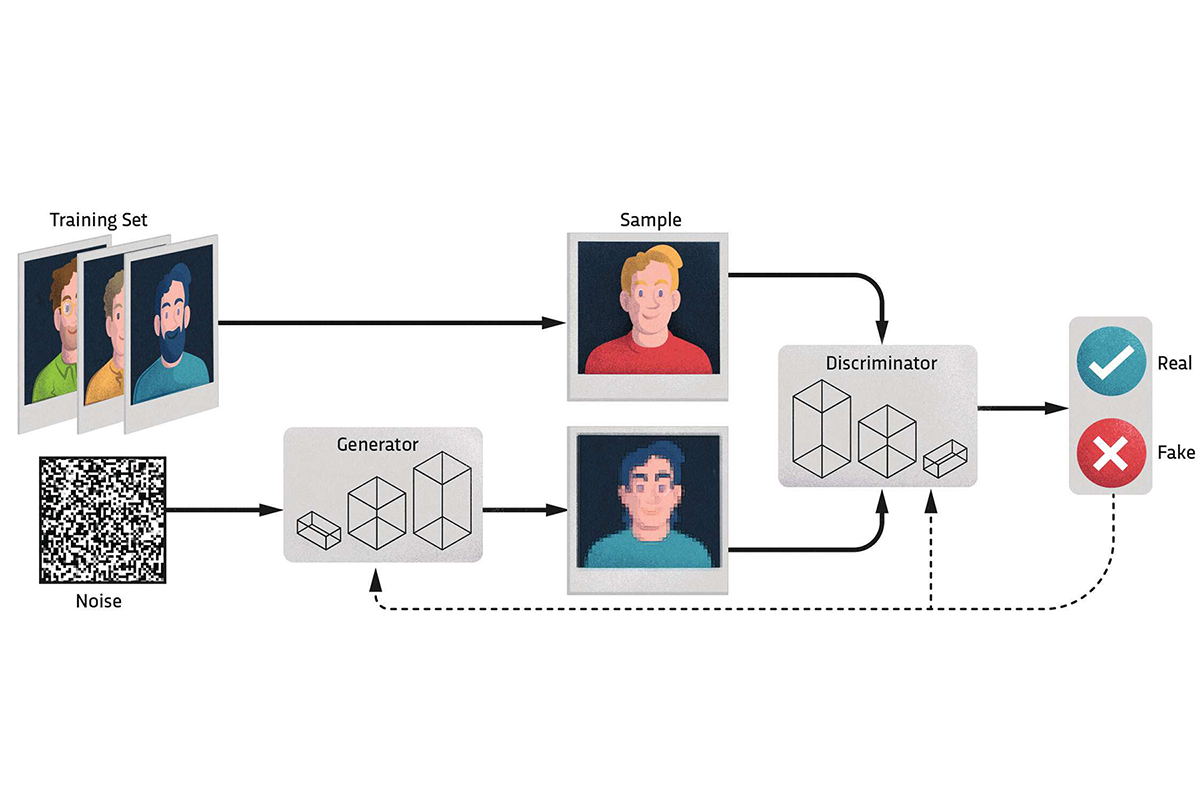

En 2014, Ian Goodfellow, le père de Gan, a proposé les réseaux contradictoires génératifs (GAN), considérés comme une percée révolutionnaire dans la technologie de génération d'images.

Les GAN sont composés de deux réseaux de neurones : Générateur et Discriminateur. Le générateur est chargé de générer de nouvelles images, tandis que le discriminateur tente de déterminer si l'image générée est réelle.

Grâce à cette approche contradictoire, le générateur s'améliore progressivement et les images générées deviennent de plus en plus réalistes.

L'architecture des GAN n'a cessé d'évoluer depuis son introduction, avec de nombreuses variantes et améliorations apparaissant :

- En 2016, avec l'introduction des réseaux convolutifs, les GAN ont bien réussi à générer des images complexes à haute résolution, en particulier lors de la génération d'images naturelles de visages humains, d'animaux, etc.

- En 2017, NVIDIA a proposé StyleGAN, qui permet de personnaliser avec style l'image générée en ajustant différentes couches de caractéristiques de l'image. Cela permet à l'IA de générer des images avec un style spécifique, comme différents traits du visage, coiffures, arrière-plans, etc.

- En 2018, BigGAN a encore amélioré la capacité des GAN à générer des images réalistes et haute résolution. Il porte la qualité des images générées par l'IA à un nouveau niveau en augmentant la taille du réseau et les données de formation.

Plus tard, avec la proposition et l’optimisation d’algorithmes tels que les modèles de diffusion (Diffusion Models), le développement de la technologie de génération d’images a été grandement favorisé. La capacité de l’IA à générer des images a commencé à entrer dans une phase où elle est hautement réaliste et presque impossible à distinguer des images réelles.

Les percées représentatives au cours de cette période incluent DALL·E (2021), ainsi que Midjourney et Stable Diffusion (2022).

En tant qu'utilisateurs ordinaires, il nous suffit désormais de saisir simplement une description textuelle et le modèle générera automatiquement des images de haute qualité qui répondent aux attentes.

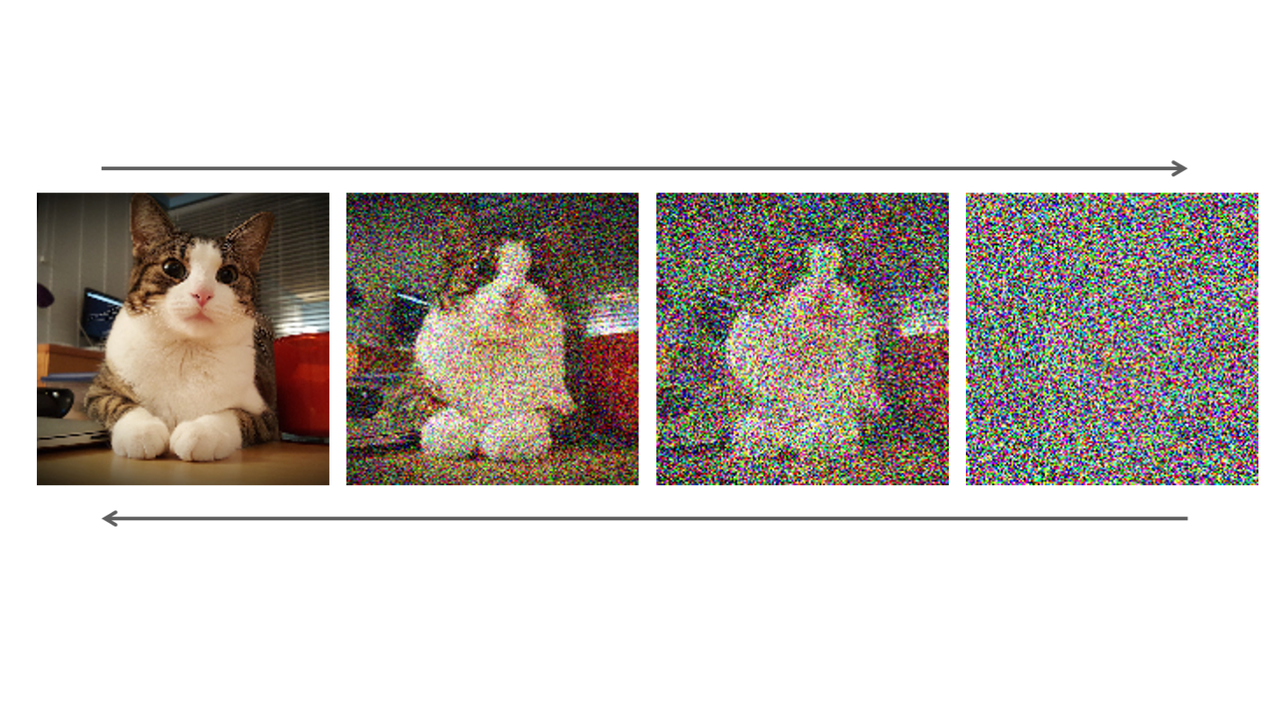

Bien que le principe du modèle de diffusion semble compliqué, il est en réalité assez intuitif.

Imaginez que vous avez une feuille de papier vierge et des stylos de couleur et que vous souhaitez dessiner un magnifique paysage. Cependant, si vous vous contentez de gribouiller et de peindre au hasard, vous risquez de vous retrouver avec une image déroutante. Au contraire, si vous avez un tableau déjà peint et que vous effacez lentement et progressivement une partie de la couleur jusqu'à ce que l'ensemble du tableau devienne flou, le processus est comme la "diffusion" – vous transformez une peinture ordonnée en un bruit désordonné.

Le principe du modèle de diffusion actuellement introduit dans le domaine de la génération d'images s'apparente à l'opération inverse de ce processus.

Cela part d’un point de départ complètement aléatoire, comme un flou de couleur ou des nombres aléatoires (pensez-y comme un désordre sur un papier blanc). Ensuite, l'IA est comme un artiste, ajoutant lentement et étape par étape des détails à ce "bruit" aléatoire. Chaque ajout rend l'image plus ordonnée et plus proche de ce qu'elle veut générer.

Ce processus peut être divisé en deux étapes principales :

- Diffusion vers l'avant (bruit) : c'est comme peindre sur un tableau jusqu'à ce qu'il devienne méconnaissable et ne devienne qu'un tas de bruit.

- Diffusion inverse (débruitage) : C'est le travail de l'IA. Elle doit apprendre à restaurer la peinture originale à partir de ce bruit. En apprenant un grand nombre de peintures, l'IA comprend quel type de bruit correspond à quel type de détails, puis « efface » le bruit étape par étape, rétablissant progressivement une image claire.

Au cours du processus d'ingénierie inverse, l'IA utilise un outil appelé réseau neuronal, qui ressemble à une machine « anti-taches » complexe capable d'identifier des modèles de bruit et de restaurer progressivement l'image d'origine.

Chaque restauration est une conjecture issue de conjectures et de révisions, jusqu'à ce que le résultat final soit une toute nouvelle peinture générée par l'IA.

Alors, existe-t-il un moyen de reconnaître d’un seul coup d’œil les images générées par l’IA ?

Oui, mais ils sont soit peu fiables, soit trop encombrants pour que les gens ordinaires puissent les utiliser.

Par exemple, nous pouvons identifier les images générées en analysant leur répartition du bruit, la netteté des bords ou les motifs de texture. Ou encore, certaines images générées par l'IA peuvent présenter des détails approximatifs, tels que l'éclairage, les ombres ou les effets de réflexion, qui peuvent ne pas être conformes aux lois physiques du monde réel.

Comme autre exemple, les images générées par l'IA peuvent manquer certaines métadonnées ou contenir des valeurs de métadonnées anormales. Il existe même des outils et des algorithmes spécialisés dans l’identification des images IA.

Le choix le plus sage est d’adopter activement l’IA, afin de ne pas être désavantagé face aux images de l’IA.

Alors que les frontières entre réalité et virtualité s’estompent de plus en plus, les gens recherchent non seulement le plaisir visuel, mais aussi une véritable communication émotionnelle. Le progrès technologique devrait servir les besoins de la nature humaine plutôt que de devenir un outil destiné à induire les autres en erreur.

L’IA ne devrait pas être blâmée pour l’ennui humain

La vie humaine est déjà entourée d’IA.

Lorsque l’IA arrive sur le marché, les gens peuvent naïvement penser que cela n’a rien à voir avec eux. Comme chacun le sait, que nous l’acceptions ou non, elle a discrètement pénétré nos vies.

Le paradoxe du développement technologique est que nous attendons toujours avec impatience de voir la forme ultime de la technologie, mais avant qu'elle n'arrive à maturité, quelqu'un doit toujours supporter son immaturité et ses défauts.

À en juger par les produits représentés par la dimension informationnelle, il existe ChatGPT pour le texte, Flux pour les images, Fish Speech pour l'audio, Runway pour la vidéo, etc. Si ces produits stars sont éblouissants, ils sont aussi des outils d’abus.

L’exemple le plus typique est la série d’incidents de pollution Internet provoqués par l’IA.

Par exemple, les articles sur l'IA inondent Internet, les données de formation des robots d'IA, les images de beauté de l'IA trompent les sentiments, la musique générée par l'IA fraude les redevances et les robots de commentaires de l'IA sont d'autres cas. Vous avez peut-être déjà vu ces choses.

Un rapport du Fastly Threat Insights Report souligne que 36 % du trafic Internet mondial est généré par des robots, tandis que seulement 64 % du trafic est généré par des utilisateurs humains.

Nous approchons peut-être d’un avenir prédit par la « théorie de l’Internet mort », dans lequel l’activité humaine sur Internet sera finalement remplacée par des robots et du contenu généré par l’IA.

Dans quelques années, il pourrait y avoir une situation où les blogueurs IA créent leurs propres œuvres, puis le robot IA « clique trois fois » et les transmet à une autre IA pour réaliser une boucle fermée, et les humains perdent complètement leur sens. d'exister.

Même sans attendre des années, certains blogueurs IA franchissent déjà le pas.

Récemment, le premier concours de beauté IA au monde a pris fin. Reili, une beauté IA du Maroc, a remporté le championnat avec sa beauté et sa maîtrise de 7 langues. Elle compte des centaines de milliers de vrais fans sur IG.

Même s’ils savent qu’il y a une vraie personne derrière cela, les fans le suivent toujours sans fin.

Tomber amoureux de l’IA n’est plus inhabituel. Les besoins émotionnels sont réels et peu importe que la cible de la projection psychologique soit un humain ou une IA. Bien entendu, la différence d’âge entre l’oncle de 52 ans et sa petite amie AI de 24 ans n’est plus un problème.

Alors, les humains sont-ils prêts à être entièrement entourés par l’IA ?

La réponse varie d'une personne à l'autre. Certains choisissent de « se coucher », d'autres restent vigilants, et certains se lèvent pour résister…

Par exemple, après avoir visionné des photos de beautés IA, les internautes qui ont choisi « à plat » ont laissé le commentaire le plus simple : « Qu'elle soit une IA ou non, elle est de toute façon mon type. »

Pour un autre exemple, les producteurs du film « Quel genre de vie voulez-vous vivre » ont révélé un jour le processus de création purement peint à la main de Miyazaki. Dans l'industrie de l'animation « envahie » par l'IA, des maîtres comme Hayao Miyazaki qui insistent encore sur le dessin à la main sont déjà une espèce rare.

Concernant les menaces posées par l'IA, le maître de l'animation de 83 ans a déclaré avec colère :

Je ne laisserai jamais l’IA interférer avec mon travail… La fin du monde approche et les humains ont perdu confiance en eux.

Les outils en eux-mêmes ne sont ni bons ni mauvais, mais ils assument souvent la responsabilité des humains.

Lorsque les êtres humains sont incapables de garder leur sang-froid dans l'agitation de la suprématie du trafic, et sont complètement entourés par l'IA, et même effectuent une « auto-élimination », il n'est pas du tout nécessaire que l'IA travaille plus dur.

Pensez à l'incident du Petit Livre Rouge mentionné au début, avec les mêmes poses de photos et les mêmes décors de tournage semblables à ceux d'une chaîne de montage. Les êtres humains s'efforcent de copier ce genre de médiocrité et, à la fin, ils enterrent leur propre individualité de leurs propres mains.

Et l’IA a simplement copié de manière pratique et efficace ce modèle similaire très vendu.

Bref, ce n’est pas que l’IA ait poussé les humains hors de la scène, mais que les humains ont volontairement abandonné leur position, sans même prendre la peine de leur dire au revoir.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo