La raison pour laquelle il est difficile pour les ChatGPT de se répliquer est qu’outre la consommation des cartes graphiques, il y a aussi le fait que les factures d’eau et d’électricité sont trop chères ?

Quand je me suis réveillé, le monde a encore changé.

Après que ChatGPT soit devenu public, l'industrie AIGC a déclenché une explosion, en particulier le mois dernier, comme si chaque jour pouvait être un jour "historique".

L'IA générative représentée par ChatGPT semble avancée, mais elle apparaît au public sous une forme interactive extrêmement "classique".

Il n'a pas d'icônes fantaisistes, ni une conception d'interface utilisateur profondément enracinée, mais utilise la boîte de dialogue la plus simple pour "choquer" le monde.

![]()

Cependant, une forme aussi simple est devenue le sujet le plus brûlant sur Internet et dans la réalité. Comme prévu, "les belles peaux sont les mêmes, mais les âmes intéressantes sont une sur un million".

Il existe simplement dans une page Web et une simple question et réponse, ce qui nous fait souvent ignorer de nombreux problèmes.

Une à une des "réponses" qui semblent être sans fardeau, mais derrière elles se cachent une poignée de puissance de cloud computing dans le monde.

Au fur et à mesure que ChatGPT est devenu la norme, ces coins cachés derrière ChatGPT ont été progressivement signalés.

Brûler de l'argent et de l'électricité, mais aussi boire de l'eau

Le fait que l'IA générative consomme des cartes graphiques est quelque peu similaire au "minage".

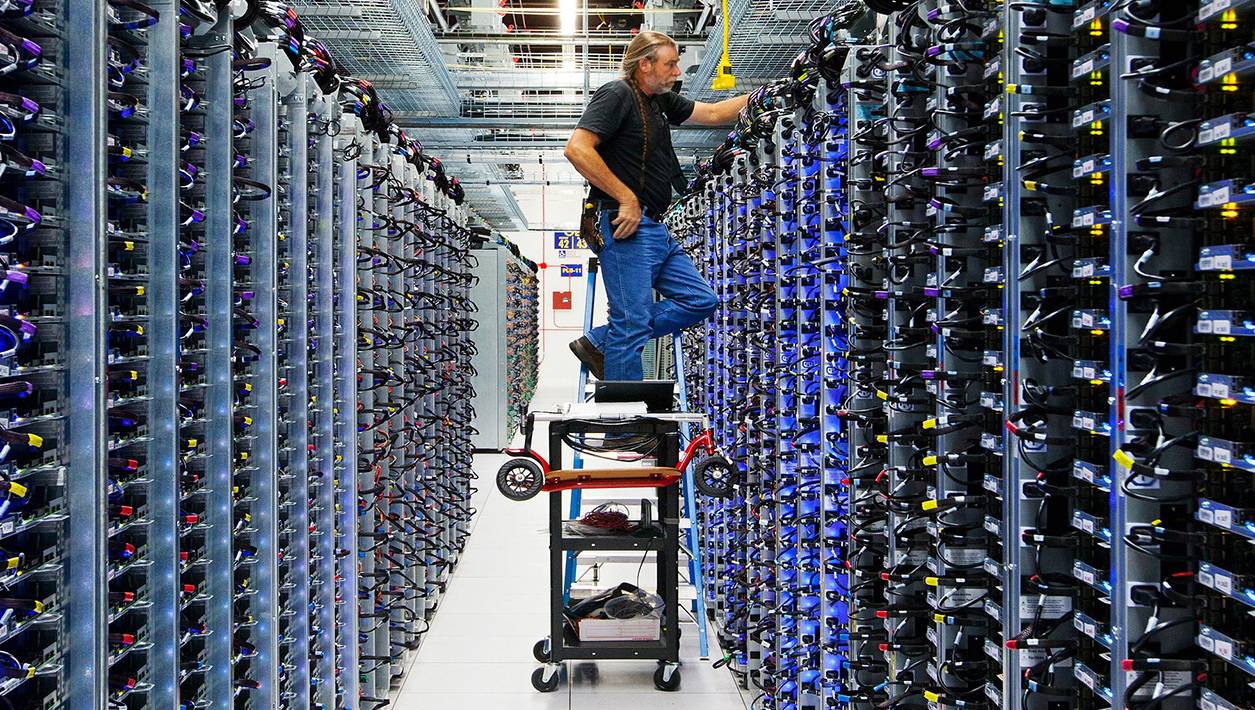

▲ Image du Google Machine Learning Center composé de TPU v4 de : Google

Pour la formation de grands modèles de langage (LLM), plus il y a de paramètres, meilleures sont les performances. Le LLM en 2018 a environ 100 millions de paramètres, et maintenant, il doit former environ 200 milliards de paramètres.

Leur fonctionnement nécessite des GPU avec une puissance de calcul plus élevée.Nvidia a également lancé le GPU hautes performances A100 correspondant en 2020, et peut également emballer huit A100 pour former un serveur DGX A100.

▲ La nourriture spirituelle de l'IA

Ces serveurs informatiques, ou cartes graphiques, sont éventuellement placés dans des centres dits de cloud computing, comme le service cloud Azure de Microsoft.

Non seulement l'entraînement d'un grand modèle de langage nécessite beaucoup de puissance de calcul, mais lorsque chaque utilisateur fait une requête et que les ChatGPT y répondent une fois, une partie de la puissance de calcul doit être appelée.

Le trafic c'est de l'argent, je pense qu'OpenAI et Microsoft devraient vivre une expérience inoubliable.

Selon Similarweb, ChatGPT a attiré 1,6 milliard de visites dans le monde le mois dernier, soit près de trois fois plus qu'en janvier.

Dans ce cas, même si Microsoft était prêt à préparer plus de 10 000 A100 pour ChatGPT, face à un tel trafic, OpenAI n'a toujours pas pu tenir le coup, et il y a eu des temps d'arrêt, des interdictions de compte et la suspension de l'activation de l'adhésion Plus.

Certaines personnes ont estimé que pour consommer le trafic actuel, Microsoft devra acheter des dizaines de milliers de cartes graphiques A100 et H100, et la puissance de calcul actuelle d'Azure est loin d'être suffisante.

Mais acheter plus de cartes graphiques, en plus de brûler de l'argent, causera également de nombreux problèmes.

Le serveur DGX A100 composé de huit A100 coûte environ 199 000 USD et a une puissance maximale de 6,5 kW.

Calculé sur la base de 10 000 pièces, Microsoft dépensera 250 millions de dollars américains rien que pour le matériel, et il consommera 5,85 millions de kilowattheures d'électricité pour un mois de fonctionnement, et la facture d'électricité devra être payée.

Selon les données publiées par le Bureau national des statistiques, la consommation mensuelle d'électricité des résidents chinois est d'environ 69,3 kWh. ChatGPT fonctionne pendant un mois, ce qui équivaut à peu près à la consommation d'électricité de nos 80 000 personnes.

En plus de la valeur de la carte graphique elle-même et de la puissance nécessaire pour les entretenir, créez-leur un environnement frais et configurez un dispositif de refroidissement par évaporation.

Le principe est aussi relativement simple, qui consiste à utiliser de l'eau évaporée pour dissiper la chaleur, mais il faut consommer beaucoup d'eau propre pour fonctionner, et dans le processus de circulation, environ 1% à 2% de l'eau sera soufflée par le vent sous forme de fine brume d'eau.

Bien que d'un point de vue macro, l'eau maintienne toujours un équilibre dynamique, mais dans le petit environnement de la tour de refroidissement, c'est une consommation invisible.

Combiné au centre de calcul de l'AIGC qui nécessite une énorme puissance de calcul, des chercheurs de l'Université du Colorado et de l'Université du Texas ont estimé dans l'article l'eau consommée pendant le processus de formation.

Dans le cas du GPT-3, la quantité d'eau douce propre requise pour la formation est équivalente à celle requise pour remplir les tours de refroidissement d'un réacteur nucléaire. Effectivement, l'IA finira par être liée à l'énergie nucléaire.

S'il est plus précis, il consomme environ 700 000 litres, et ils ont également calculé que la conversation d'un utilisateur avec ChatGPT pour 25 à 50 questions équivaut à peu près à demander à ChatGPT de boire 500 ml d'eau.

Dans le même temps, ils ont également constaté que lorsque la tour de refroidissement par évaporation fonctionne, en moyenne, un gallon d'eau (3,78 L) disparaît pour chaque kilowattheure d'électricité consommée.

En fait, il n'y a pas que Microsoft : Google a utilisé plus de 2,3 milliards de gallons d'eau propre pour ses trois centres de données en 2019.

▲ Image du centre de calcul de données de Google de : Google

Aux États-Unis continentaux, Google dispose de 14 centres de données qui fournissent la puissance de calcul pour sa recherche et maintenant LaMDA et Bard. Et le processus de formation du modèle de langage LaMDA consomme plus d'énergie et d'eau que GPT-3.

Il s'avère que l'IA ne se contente pas de dépenser en cartes graphiques. Elle vit dans une grande maison à température constante et a un appétit étonnamment bon. Elle mange de l'électricité et boit de l'eau.

Le gouffre de l'IA partout

Dans l'industrie AIGC, une simple boîte de dialogue qui peut répondre avec précision démontre non seulement la force technique, mais également la solidité financière.

Le Dr Sasha Luccioni a déclaré que pour les modèles linguistiques volumineux et complexes, seules quelques entreprises et organisations dans le monde disposent des ressources nécessaires pour les former.

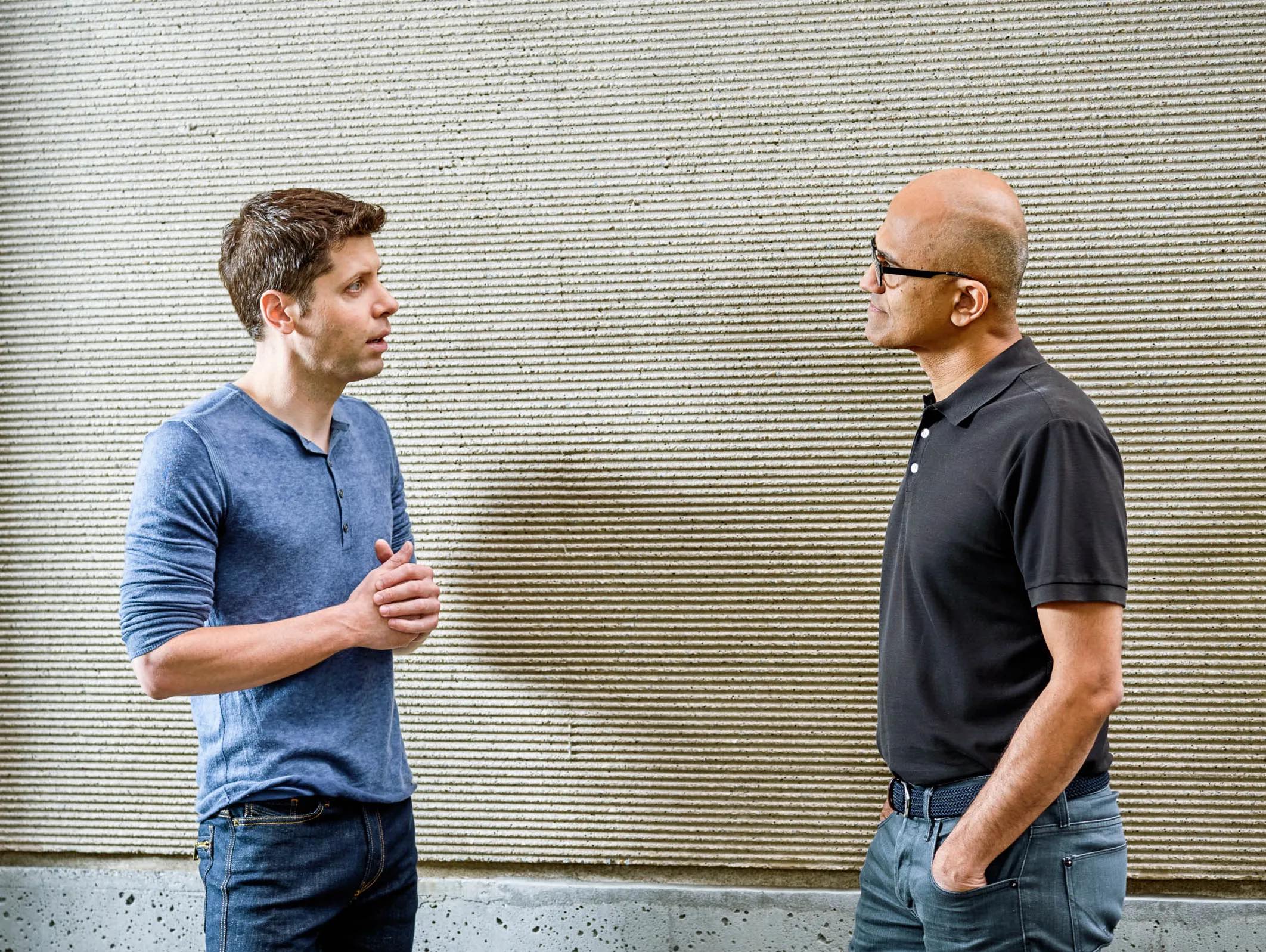

▲ Sam Altman (à gauche) et le PDG de Microsoft, Satya Nadella (à droite) Photo de : Wired

Toujours en prenant GPT-3 comme exemple, le coût de la formation de 180 milliards de paramètres est d'environ 4,6 millions de dollars américains, sans compter l'exploitation ultérieure et la maintenance itérative, etc.

Ces coûts matériels et immatériels engendrés lors de l'exploitation sont difficiles à supporter pour de nombreuses entreprises.

En conséquence, dans la vague AIGC, il existe un tel écart d'IA de manière invisible, et il est probablement divisé en deux types d'entreprises.

L'une est une grande entreprise technologique qui peut se permettre de dépenser de l'argent et peut former de grands modèles de prédiction avancés et complexes. L'autre est les organisations à but non lucratif et les petites entreprises qui ne peuvent pas se permettre le coût.

Dans de nombreux rapports de recherche sur la consommation d'énergie et de ressources de l'AIGC, la plupart d'entre eux utilisent GPT-3 ou utilisent des mots tels que "estimé".

Tout comme dans la recherche sur la quantité d'eau utilisée pour former GPT-3, puisque OpenAI n'a pas divulgué la durée requise pour la formation GPT-3, les chercheurs ne peuvent estimer qu'à partir des données de la tour de refroidissement du Azure Computing Center publiées par Microsoft.

Une série de données de référence telles que les émissions de carbone sont principalement prédites à partir du modèle d'entraînement Bert en 2019.

En plus de la puissance dure telle que les fonds, les GPU, les centres de données, la bande passante du réseau, etc., Google et Microsoft ont également répertorié l'algorithme de formation, le processus, le temps, les paramètres, etc. du grand modèle de langage comme top secrets.

Nous voulons l'utiliser et le comprendre, uniquement via l'API fournie, ou demander directement à ChatGPT ou à Bard lui-même.

Invisiblement, cela est également devenu un "écart d'IA".

L'AIGC se développe si rapidement, et ses capacités s'étendent également à l'infini, de nombreux pays, régions et organisations réfléchissent à la manière de mettre en place des normes pour l'AIGC, de peur qu'il (génère la conscience de soi, commence à s'éveiller…) agisse imprudemment.

Mais tout comme les chercheurs apparentés, AIGC (comme GPT-4) n'a presque aucune information publique à l'heure actuelle, et il ressemble plus à une boîte noire.

Il est vrai que pour les grandes entreprises, l'AIGC peut être le début d'une nouvelle ère, et il est compréhensible de façonner des barrières technologiques.

Mais concernant la consommation des ressources, que ce soit pour le législatif ou pour le grand public, une certaine transparence doit être maintenue,

C'est pourquoi les chercheurs continuent de creuser et que la TD paie pour cela tandis que l'IA offre la commodité.

Le développement de l'IA est en fait un alunissage pour l'humanité

Les recherches sur la consommation d'énergie de l'IA, les émissions de carbone et la dernière consommation d'eau ne condamnent ni ne s'opposent au développement de l'AIGC, qui utilise des ressources en échange d'améliorations technologiques.

Ces données offrent en fait une autre perspective de l'industrie de l'AIGC. Derrière les réponses humaines, qu'avons-nous ou les grandes entreprises technologiques payées pour cela ?

Il ne s'agit pas d'appeler Google et Microsoft à faire immédiatement la neutralité carbone, et à payer la consommation des ressources en eau, en électricité et certains problèmes environnementaux indirects, pour qu'ils puissent devenir Google Green ou green soft.

L'éclosion de l'AIGC n'est pas un cluster, ni une simple explosion technologique, elle recouvre pas mal de filières industrielles derrière elle, et s'apparente plutôt à une « réussite ».

L'amélioration de la puissance de calcul du centre de cloud computing des grandes entreprises, le calcul efficace d'algorithmes complexes par le GPU et la complexité des paramètres du grand modèle de langage, couplés à l'entreprise AIGC elle-même, ont investi quel que soit le coût.

▲ Les centres de calcul de données à grande échelle ne sont qu'une partie de l'industrie AIGC

Avant l'émergence du GPT-3, les capacités des IA étaient relativement immatures et le public ne se rendait pas compte que l'IA pouvait changer le monde.

Mais avec l'émergence de GPT-4, Midjourey V5, etc., AIGC est enfin devenu le chouchou de la Silicon Valley.

À l'heure actuelle, de grandes entreprises telles que OpenAI, Microsoft et Google ont également obtenu des résultats préliminaires en matière de consommation de ressources et d'utilisation d'une grande puissance de calcul.

▲ Photos de "Pour toute l'humanité"

De même, le nœud AIGC actuel est quelque peu similaire au moment où Armstrong a marché pour la première fois sur la lune.

Atterrir sur la lune a utilisé des ressources financières et financières considérables à l'époque, mais il n'y avait pas de soi-disant eau et de ressources disponibles sur la lune (temporairement).

Mais on ne peut nier qu'aller sur la lune n'a pas de sens, tout comme dépenser beaucoup de ressources et de ressources financières pour alimenter l'IA et développer l'AIGC.

Cependant, personne ne peut dire comment AIGC peut se développer, cela peut être comme Skynet dans "Terminator", ou CP30 dans "Star Wars", avec des possibilités infinies.

#Bienvenue pour prêter attention au compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo