La Room N de Corée du Sud réapparaît ! Un grand nombre de femmes dont les visages ont été modifiés par l’IA ont demandé de l’aide sur Weibo, impliquant 500 écoles et plus de 220 000 personnes participantes.

Dans l'œuvre "Ghost in the Shell" de la fin du siècle dernier, Motoko, dont tout le corps était transformé en corps prothétique, doutait s'il existait encore. Le corps, la mémoire et les relations avec les autres, lorsque ces choses peuvent être reproduites, ne peuvent pas être utilisés comme argument en faveur de la vie physique.

Lorsque la chanteuse IA est devenue populaire, Stefanie Sun a également fait valoir un point similaire dans sa réponse. Vous n'êtes pas spécial, vous êtes déjà prévisible et, malheureusement, vous êtes également personnalisable.

On peut ajouter que n’importe qui peut être décrit et généré par l’IA, même si vous n’avez jamais fait quelque chose.

Lu Xun a vraiment dit que lorsqu'il a vu des manches courtes, il a immédiatement pensé aux bras blancs. L’imagination humaine est commune, et il n’est pas surprenant qu’à chaque nouvelle avancée technologique, une certaine voie verticale se développe avec plus de maturité : la pornographie.

La Corée du Sud, qui avait autrefois choqué le monde à cause de Room N, connaît désormais la version 2.0.

Violence des gens ordinaires contre les gens ordinaires

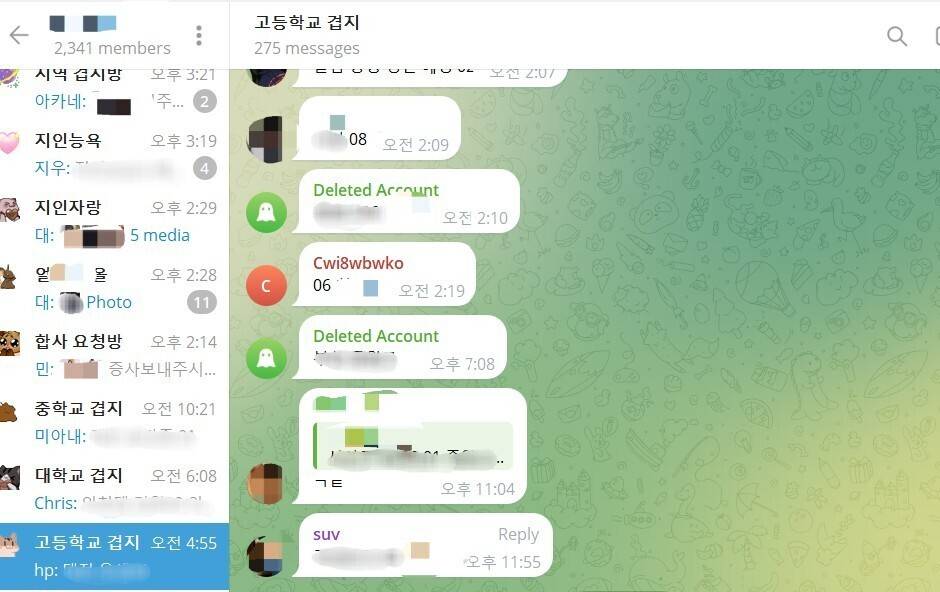

Lors du précédent incident de la salle N, l'agresseur avait créé plusieurs salons de discussion sur le logiciel de messagerie instantanée crypté Telegram et publié du contenu à caractère sexuel. Cet incident s'est principalement produit sur Telegram.

La principale différence entre les deux réside dans les moyens utilisés pour commettre le crime : l’un est la photographie secrète et l’autre le Deepfake.

Nous connaissons déjà Deepfake, qui utilise l’IA pour générer des vidéos, des audios ou des images apparemment réelles afin de simuler des choses qui ne se sont pas réellement produites.

Les deepfakes sont couramment utilisés dans l’industrie du divertissement et chez les politiciens, mais ils sont également contrôlés par des gens ordinaires et utilisés pour nuire à d’autres personnes ordinaires.

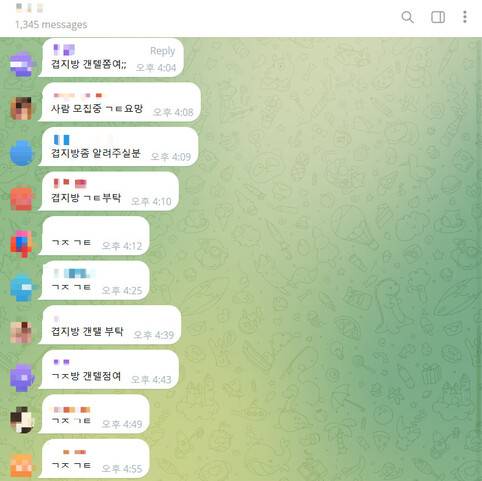

Les auteurs de Room N 2.0 ont étendu leurs griffes aux membres de leur famille, à leurs collègues et camarades de classe. De nombreux forums de discussion Telegram sont organisés par écoles ou régions, de sorte que les membres du groupe ont des connaissances communes et des sujets similaires.

▲ Salons de discussion par campus universitaire

Outre les femmes qui les entourent, les célébrités féminines sont également la cible de leur chasse. Certains forums de discussion sont même subdivisés en types de professions, notamment enseignants, infirmières, soldats, etc.

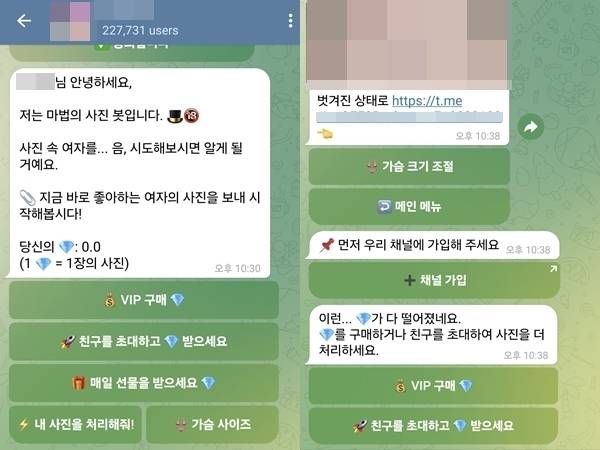

Le Hankyoreh Daily a rapporté qu'un salon de discussion Telegram comptant 227 000 participants n'avait besoin que de photos de femmes pour générer du contenu deepfake en 5 à 7 secondes.

Quel est le concept de 220 000 ? La Corée du Sud n’aura que 230 000 nouveau-nés en 2023, et sa population totale ne dépasse pas les 50 millions d’habitants.

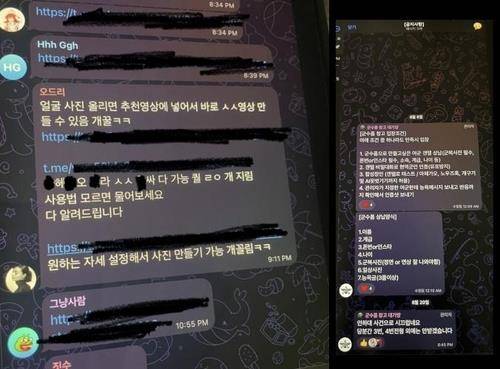

Ce salon de discussion dispose d'un robot qui combine des photos féminines en photos nues et peut ajuster les seins. Une fois que l'utilisateur entre dans le salon de discussion, un message apparaîtra dans la fenêtre de discussion : "Envoyez maintenant les photos féminines que vous aimez."

▲ Capture d'écran du salon de discussion, expliquant comment utiliser Deepfake

Le nombre de participants est scandaleux, ce qui peut être lié au faible « seuil d'entrée » : des liens peuvent être trouvés en recherchant des mots-clés spécifiques sur X (anciennement Twitter).

Ce salon de discussion a également établi un modèle de monétisation. Les deux premières photos sont gratuites, puis il y a des frais de 1 diamant (0,49 USD, environ 3,47 RMB) par photo. Les paiements ne peuvent être effectués qu’avec de la monnaie virtuelle pour garantir l’anonymat. Si vous invitez des amis, vous pouvez également obtenir des crédits gratuits.

Mais il existe également certains forums de discussion qui nécessitent un « certificat d'admission » – si vous souhaitez rejoindre le groupe, vous devez d'abord soumettre 10 photos de personnes que vous connaissez et réussir l'entretien.

Les avatars du logiciel de chat KakaoTalk et les photos d’Instagram peuvent tous être utilisés comme « matières premières ».

Ce qui est encore plus horrible, c’est qu’une grande partie des victimes et des auteurs sont des adolescents.

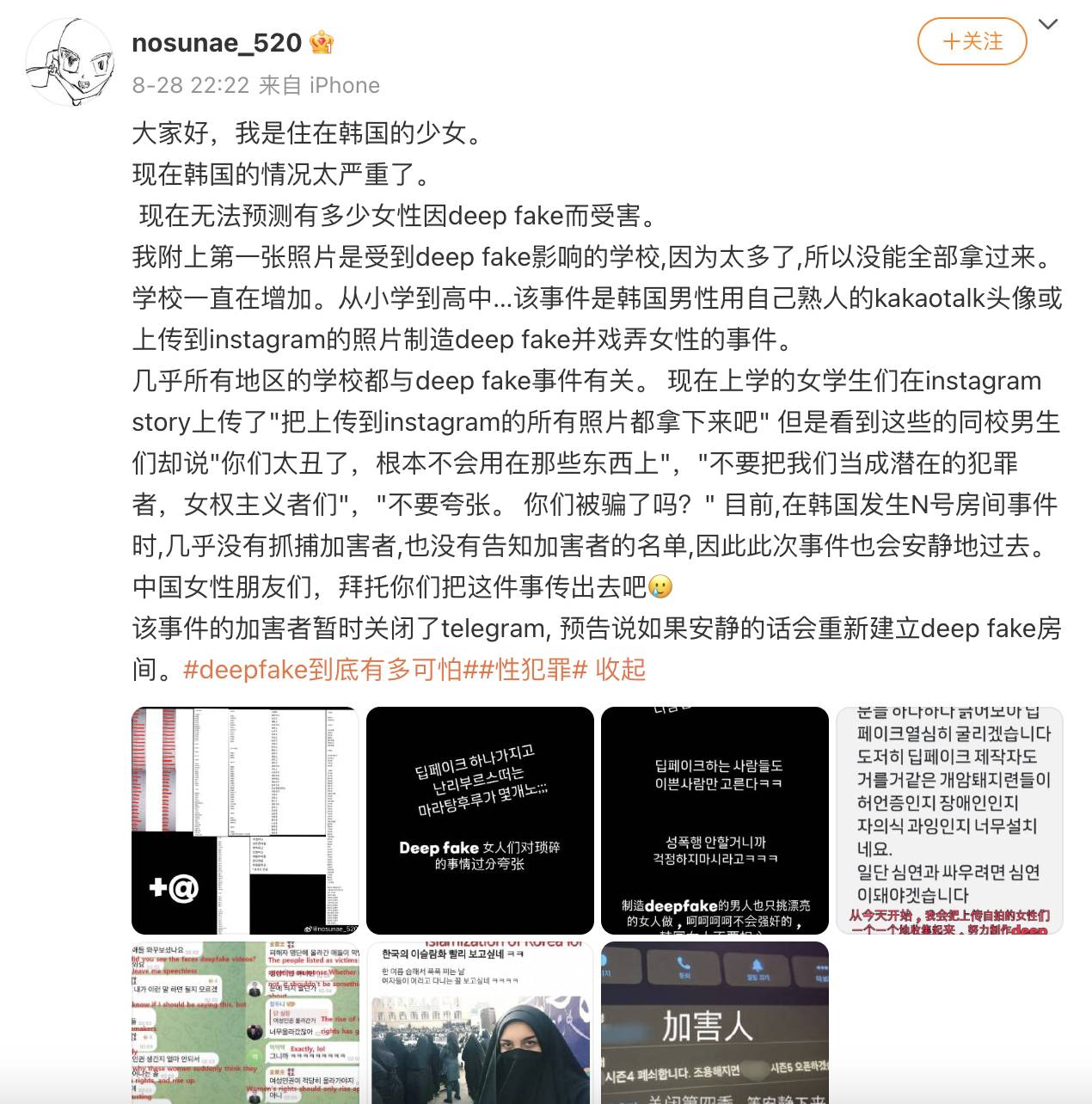

Les bénévoles ont créé une carte mise à jour en temps réel, montrant dans quelles écoles les crimes avaient lieu. Même dans une école réservée aux filles, il y aura des victimes, car les agresseurs ne sont pas nécessairement des camarades de classe.

Le nombre exact d’écoles touchées reste à déterminer. Certains blogueurs ont affirmé que cette fois-ci, plus de 70 % des écoles étaient impliquées.

Le 26 août, le « Korea JoongAng Daily » a souligné qu'il comprenait au moins environ 300 écoles à travers le pays, y compris des écoles primaires. Le 28 août, le rapport du WSJ a étendu ce nombre à environ 500 écoles.

Un internaute a déploré dans la zone de commentaires : « Il s'agit essentiellement de l'ensemble de la Corée du Sud… »

Bien qu'il n'y ait pas de résultat clair d'enquête sur cet incident, les données passées peuvent également illustrer la gravité de la situation.

Selon les statistiques de l'Institut coréen des droits humains des femmes, de janvier à août de cette année, un total de 781 victimes de Deepfake ont demandé de l'aide, dont 288 mineures, soit 36,9 %. Le chiffre réel est probablement bien plus élevé que cela.

En outre, la police nationale sud-coréenne a déclaré que depuis le début de l'année 2023, environ 70 % des quelque 300 personnes accusées d'avoir produit et distribué de fausses photos de nus étaient des adolescents.

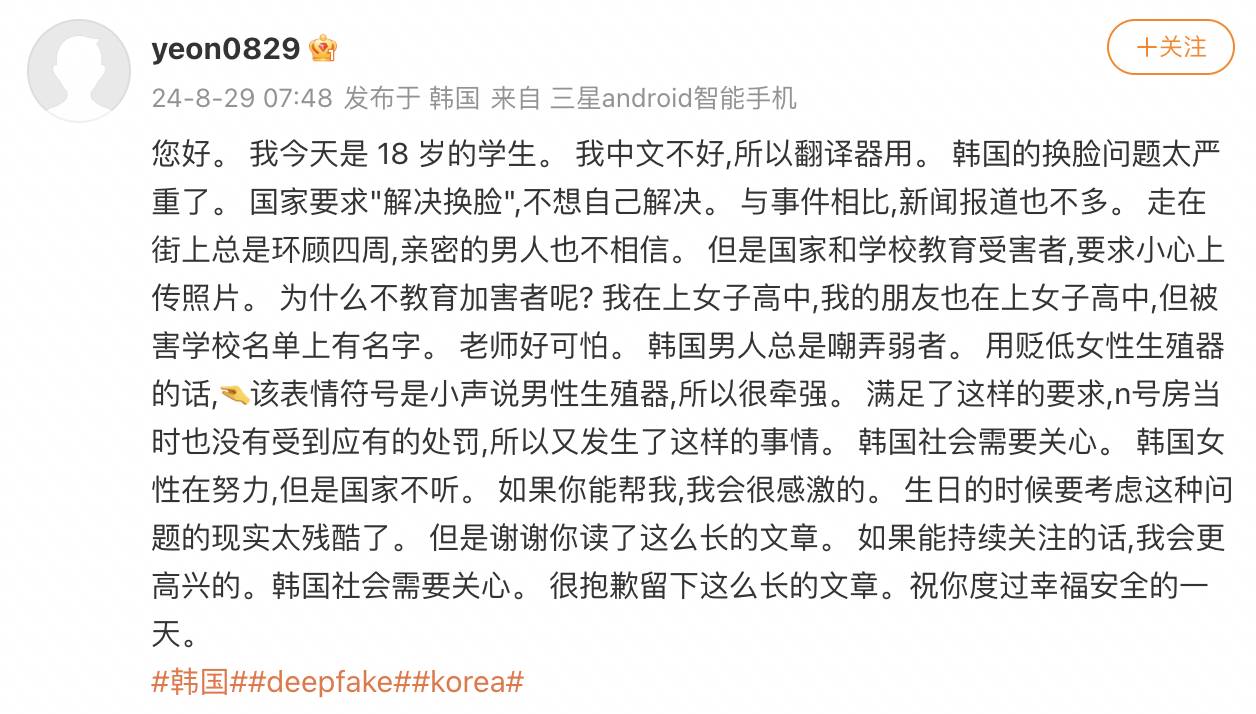

De nombreuses femmes coréennes sont allées sur Weibo pour demander de l'aide. Elles ne connaissaient pas le chinois et ne pouvaient que lire le contenu de leur téléphone, exprimant leur impuissance et leur peur. « Room N 2.0 » est devenu une recherche brûlante sur Weibo.

Certains internautes se demandent pourquoi les femmes coréennes se sont tournées vers l'Internet chinois pour obtenir de l'aide. En fait, les femmes coréennes ne sont pas les seules à parler chinoises. En plus de la Corée du Sud, les médias de Singapour, de Turquie et d'autres pays ont également rapporté cet incident.

Ils pensent que si les étrangers leur prêtent attention et les critiquent, les médias en parleront plus activement et les départements concernés enquêteront plus sérieusement, au lieu de faire semblant d'être sourds et de garder le silence.

Certaines preuves criminelles et même l'identité de l'initiatrice ont fait l'objet d'une enquête par les femmes coréennes elles-mêmes, comme c'était le cas dans la salle N à l'époque. Heureusement, le président de la Corée du Sud et le chef du parti d’opposition ont exprimé leur position en proposant :

Les deepfakes constituent clairement un crime sexuel numérique et nous les éradiquerons une fois pour toutes.

Les deepfakes peuvent être considérés comme une farce, mais il s’agit clairement d’actes criminels utilisant la technologie sous couvert d’anonymat, et n’importe qui peut en devenir victime.

Les serveurs de Telegram sont à l’étranger et son PDG est détenu à Paris, ce qui rend les enquêtes difficiles. La Commission coréenne des normes de communication a déclaré avoir envoyé une lettre demandant au gouvernement français de coopérer à l'enquête sur Telegram.

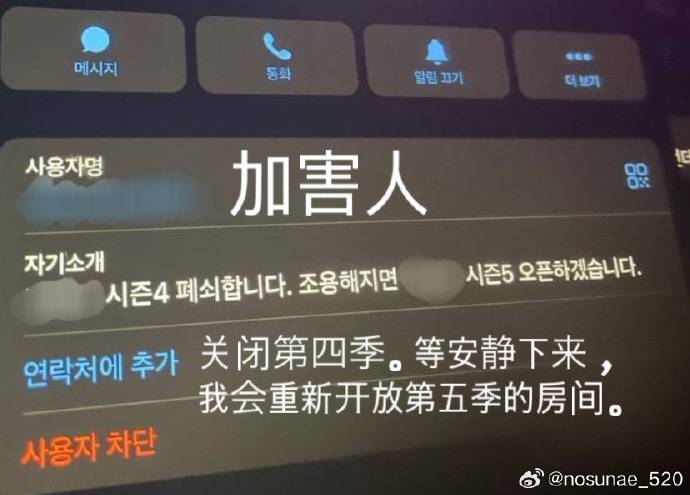

Après avoir attiré l'attention de l'opinion publique, les comportements associés ont été restreints. Cependant, le Hankyoreh Daily a rapporté que certains utilisateurs peu scrupuleux se soumettraient à une « vérification d'identité » plus stricte et continueraient à faire du deepfake dans des forums de discussion plus privés.

▲Capture d'écran du salon de discussion, les utilisateurs discutent de la participation à un salon de discussion plus privé

Faux contenu, véritable préjudice

Les deepfakes ne sont pas nouveaux, mais leurs méfaits sont rarement reconnus.

Certaines femmes en Corée du Sud ont rendu leurs comptes de réseaux sociaux privés ou supprimé des photos publiées en ligne pour tenter de se faire pardonner.

Ils étaient bouleversés et dubitatifs. D’une part, ils ne savent pas où leurs photos ont été partagées ni jusqu’où elles se sont répandues. D’un autre côté, ils ne comprennent pas pourquoi on demande aux victimes de faire preuve de prudence lorsqu’elles téléchargent des photos au lieu d’éduquer les auteurs.

Lorsqu’une étudiante appelait sur son histoire Instagram pour « retirer toutes les photos que vous avez mises en ligne », les garçons de la même école pouvaient dire : « Vous êtes trop laids pour être utilisés dans ces choses-là. »

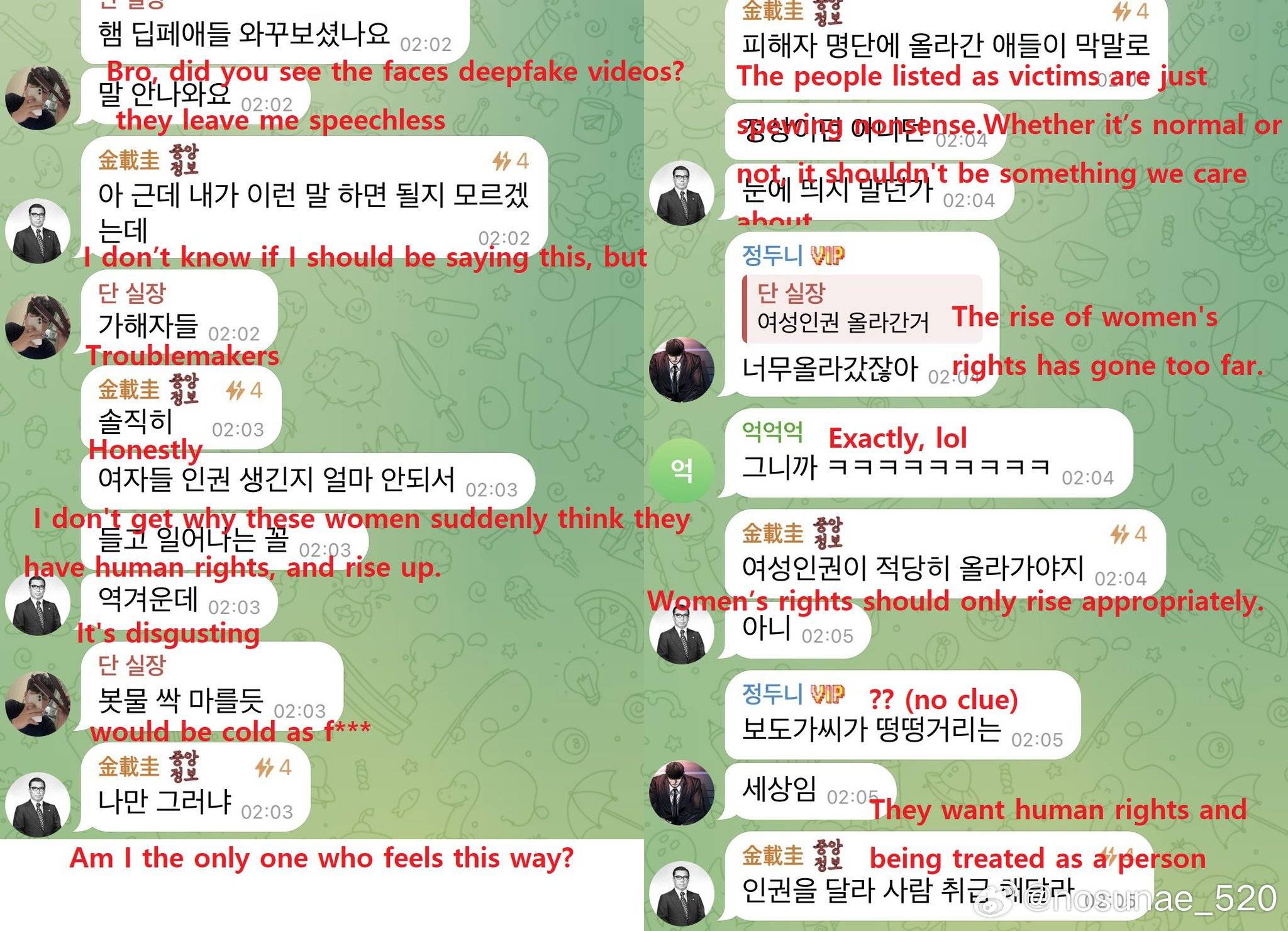

▲Les remarques de l'agresseur, disant que les femmes sont trop grandes

Il y a encore des voix comme celle-ci sur Internet : « Je ne sais pas pourquoi ce genre de crime peut causer autant de mal. » « Si quelques personnes l'avaient commis elles-mêmes, le mal devrait être très minime. »

Mais ce que vivent les victimes ne se limite pas à voir leurs visages truqués. Les agresseurs les insulteront également, divulgueront leurs informations personnelles telles que leurs adresses, numéros de téléphone et cartes d'identité d'étudiant, répandront des rumeurs sur leur vie privée, les approcheront et les harcèleront.

Ce qui est encore plus terrifiant, c’est de tomber sur du « porno de vengeance » : les auteurs menacent de diffuser du matériel deepfake pour faire chanter et nuire aux femmes, causant ainsi un préjudice secondaire plus grave.

▲Un YouTuber coréen a déclaré que les femmes font des histoires, mais il sait comment se protéger en se couvrant

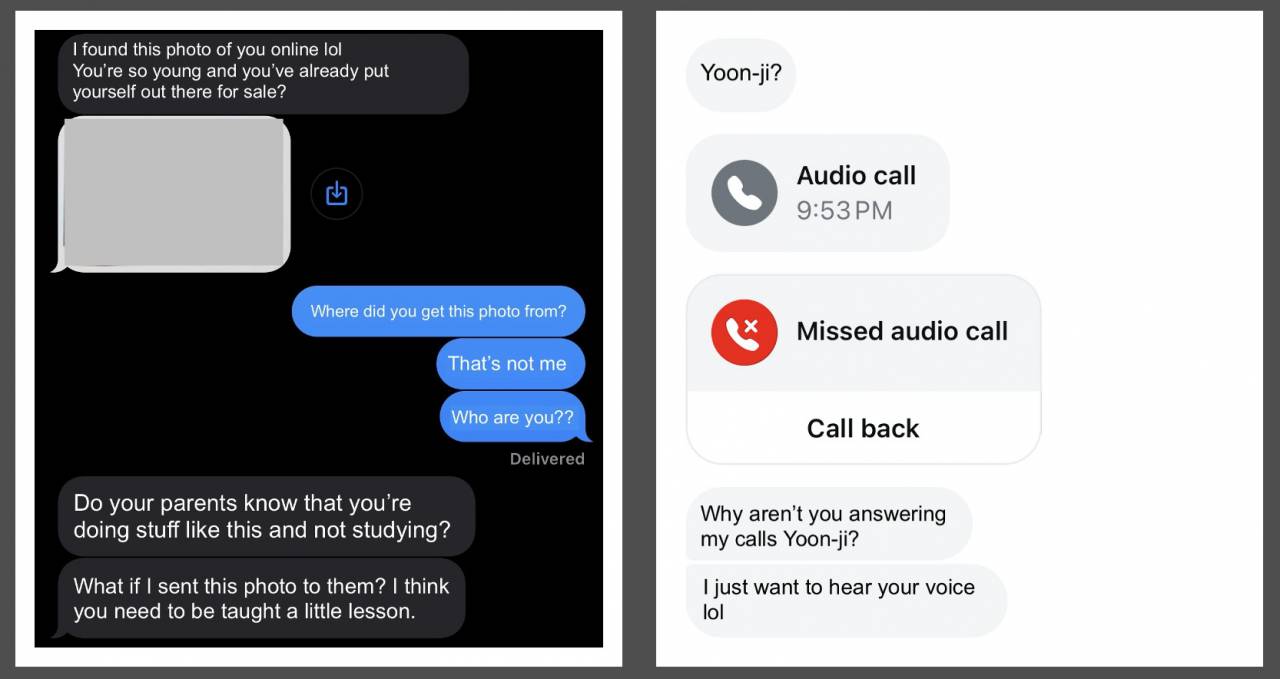

Le Korea Herald a rapporté que Song, un lycéen de 17 ans de la province de Gyeonggi, partageait en ligne des photos de danse et de courtes vidéos. Un jour, elle a reçu un message anonyme sur Instagram avec trois photos explicites : « Vos amis et vos parents comprennent-ils cet aspect de votre vie ?

Ces photos sont toutes deepfakes, mais elles sont presque impossibles à distinguer des images réelles. Le cauchemar n'est pas terminé et les messages auxquels elle répond ne feront que rendre l'autre partie plus excitée et plus exigeante.

▲Captures d'écran des messages texte entre Song et l'agresseur, modifiés et traduits en anglais selon la demande de Song

Personne ne peut partager la douleur. Certaines victimes ont même déclaré : « Le monde tel que je le connaissais s’est effondré ».

Cela n’équivaut pas au prix payé par l’auteur.

▲Captures d'écran du salon de discussion, quelques remarques obscènes, du type "Tu peux définir la pose que tu veux pour faire des photos, c'est super cool"

L'incident n'a pas encore été réglé, mais la Corée du Sud a déjà condamné Deepfake, dont l'un d'entre eux a eu son premier procès le 28 août.

De juillet 2020 à avril de cette année, Park a volé les photos faciales de femmes victimes telles que des anciennes élèves de l'université, a produit 419 vidéos pornographiques Deepfake et en a diffusé 1 735. Il a été condamné à 5 ans de prison.

Les victimes ont commencé à courir partout en juillet 2021 avant de parvenir à traduire l'agresseur en justice, et Park a été poursuivie en mai de cette année.

En raison de cet incident Deepfake à grande échelle, les autorités sud-coréennes compétentes envisagent d'augmenter la peine de prison maximale de 5 à 7 ans.

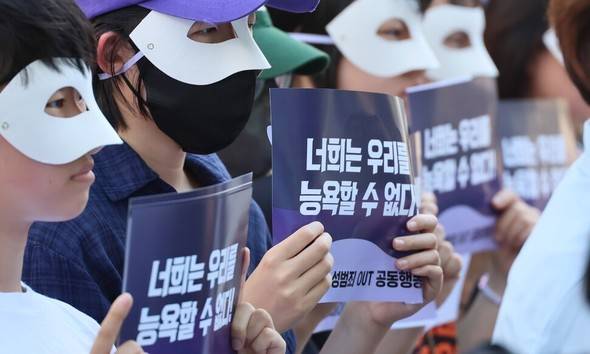

▲Des femmes sud-coréennes s'expriment pour protester contre les crimes sexuels

Considérant que les délits juvéniles deepfake sont très courants, mais qu'il existe des lacunes dans la loi, la Corée du Sud mesure la peine maximale pour les auteurs au stade de l'enseignement obligatoire.

À ce jour, Deepfake reste une zone grise dans de nombreux endroits, et les efforts de protection ne peuvent pas suivre le rythme des menaces.

Par exemple, aux États-Unis, si la victime est un adulte, les États ont des lois et des réglementations différentes, soit pour criminaliser, soit pour engager des poursuites civiles, mais il n'existe actuellement aucune loi fédérale interdisant la production de contenu pornographique Deepfake.

▲Capture d'écran du salon de discussion, des membres discutant de connaissances communes

L’une des raisons pour lesquelles la législation est difficile est que certaines personnes pensent que même si le sujet de l’image Deepfake vous ressemble, ce n’est pas réellement vous, et votre vie privée n’est donc pas vraiment violée.

Cependant, tout le monde sait que même si l’image est fausse, le mal est réel.

Les progrès judiciaires sont lents, et en même temps, les auteurs qui ne se sont jamais présentés se sont temporairement « calmés » et attendent « un retour ».

C’est si facile de faire le mal, les Deepfakes concernent tout le monde

La Corée du Sud ne fait pas exception. Les Deepfakes se produisent indépendamment des frontières nationales.

En septembre 2023, dans la ville espagnole d'Almendralejo, un groupe de garçons a téléchargé des photos de leurs camarades de classe publiées sur les réseaux sociaux vers un outil d'IA de « décapage en un clic ». Il y a cinq collèges dans la ville, et des « photos nues » de camarades de classe ont circulé dans au moins quatre d'entre eux.

Cet outil peut être utilisé via des applications mobiles ou Telegram. Il y a au moins 30 victimes, principalement des étudiantes âgées de 12 à 14 ans.

La plupart des initiateurs les connaissaient et étaient également mineurs. Ils étaient au moins 10, certains même âgés de moins de 14 ans, et ne pouvaient pas faire l'objet de poursuites pénales.

▲Une mère appelle davantage de victimes à se manifester

Ils ont créé des discussions de groupe sur WhatsApp et Telegram pour diffuser ces « photos nues » et ont menacé leurs victimes via Instagram d'extorquer une « rançon » et de vraies photos nues.

Une situation similaire s'est produite dans un lycée du New Jersey, aux États-Unis. Une trentaine de victimes ont été prises par leurs camarades de classe pendant les vacances d'été.

Le directeur a assuré que toutes les photos avaient été supprimées et ne seraient plus diffusées. L'agresseur a été suspendu de l'école pendant quelques jours et renvoyé sur le « lieu du crime » comme si de rien n'était.

Deepfake est apparu pour la première fois en 2017 sur Reddit, la « version américaine de Tieba ». La principale forme consiste à remplacer les visages de célébrités par les protagonistes de vidéos pornographiques, ou à usurper des personnalités politiques.

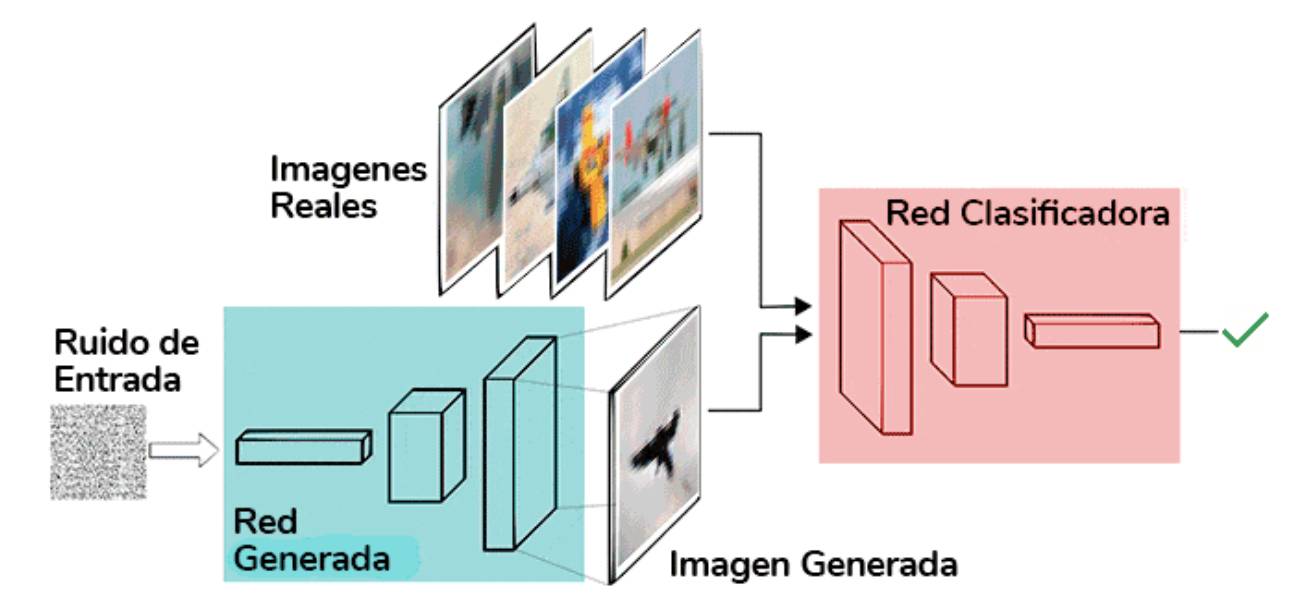

D'un point de vue technique, il existe deux voies principales : l'une est la voie codeur-décodeur, qui remplace un visage par une autre en compressant et en reconstruisant l'image ; l'autre est la voie générateur-discriminateur (c'est-à-dire les réseaux contradictoires génératifs (GAN), qui génèrent des images réalistes grâce à une formation contradictoire.

▲GAN

Aujourd’hui, le deepfake est un concept plus large, qui ne se limite plus au remplacement original du visage, nous l’utilisons pour désigner tout acte de falsification de la réalité par des moyens technologiques.

Des principes techniques complexes se cachent derrière les coulisses. Les utilisateurs ont accès à des interfaces « prêtes à l'emploi » et les adolescents peuvent également créer de fausses informations à volonté. Deepfake est passé d'une technologie à un outil sans seuil.

Les applications de « déshabillage en un clic » ne nécessitent qu'une photo, une adresse e-mail et quelques dollars pour enlever les « vêtements » de célébrités, de camarades de classe et d'étrangers par lots. Les images utilisées pour se « déshabiller » proviennent souvent de captures de médias sociaux. sans le consentement de l'éditeur, puis le diffuse également à son insu.

Basé sur un modèle de diffusion open source formé sur des images massives, les utilisateurs peuvent générer de fausses photos explicites de célébrités en saisissant des mots d'invite.

▲Le modèle IA d'une actrice hollywoodienne a été téléchargé des milliers de fois

Les projets GitHub open source comme Deep-Live-Cam peuvent changer de visage dans les chats vidéo avec juste une photo.

Il peut être difficile de tromper les jeunes, mais ce n'est pas nécessairement le cas pour les personnes âgées. Un exemple tragique s'est déjà produit dans la réalité : aux États-Unis, un homme de 82 ans a perdu 690 000 dollars à cause de sa confiance aveugle dans l'IA. Musk qui a trompé les gens dans la vidéo.

▲ Diffusion en direct d'AI Musk

En juillet 2023, Deutsche Telekom a publié une publicité sur la sécurité des données des enfants, appelant les parents à partager le moins possible la vie privée de leurs enfants sur Internet.

Les images, les vidéos et les audios sont tous Deepfake. Même si nous comprenons rationnellement que « voir c'est croire » est devenu une chose du passé, notre psychologie ne l'a pas encore pleinement accepté et nous n'avons pas la capacité correspondante de distinguer tout le monde. peut devenir une victime.

La technologie est peut-être neutre, mais l’information que les gens utilisent pour produire n’est pas seulement de l’information, mais aussi des armes utilisées pour humilier, stigmatiser et acquérir un sentiment de supériorité. Plus le contenu est vulgaire et bizarre, plus il est facile à diffuser. Cela est vrai depuis l’Antiquité.

Que peuvent faire les gens ordinaires ? Nous pouvons au moins décider comment nous utilisons la technologie, et nous pouvons également choisir quelles informations produire et diffuser, prêter attention aux victimes, nous moquer des auteurs et utiliser notre peu de pouvoir pour promouvoir le progrès des lois et des concepts sociaux.

Après avoir échangé son visage, pourquoi la victime a-t-elle supprimé les photos ? Pourquoi les victimes ont-elles si honte après avoir été photographiées en secret ? Cela semble être une question à laquelle la technologie ne peut pas répondre.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo