L’artefact vidéo IA si populaire sur Xiaohongshu, cette nouvelle activité m’empêche de m’arrêter.

La cohérence multi-sujets des vidéos d’IA a toujours été un problème. Il n’est pas difficile de laisser l’IA générer des modèles et des vêtements à partir de rien, mais si la Partie A exige que Musk approuve et porte un manteau en peluche, l’IA pourrait ne pas être en mesure de le faire.

Le modèle 2.0 récemment mis à jour de Pika propose une solution très intéressante : nous téléchargeons plusieurs images, et Pika se référera avec précision aux éléments des images pour générer des vidéos.

Collectez des photos de personnages, de produits et de scènes, et une vidéo publicitaire très basique sera produite, et ces matériaux auront le même aspect dans la vidéo que dans les photos.

Cela signifie-t-il que le problème de cohérence des vidéos IA a été résolu et que les amis du secteur de la publicité seront à nouveau inquiets ? En fait, ce n’est pas le cas. Après des tests réels, Pika est très jouable, mais en termes de praticité, ce n’est pas assez pratique.

Musk et Altman regardent des films et mangent des frites avec des tableaux célèbres. Il n'a jamais été aussi simple d'être dans le même cadre.

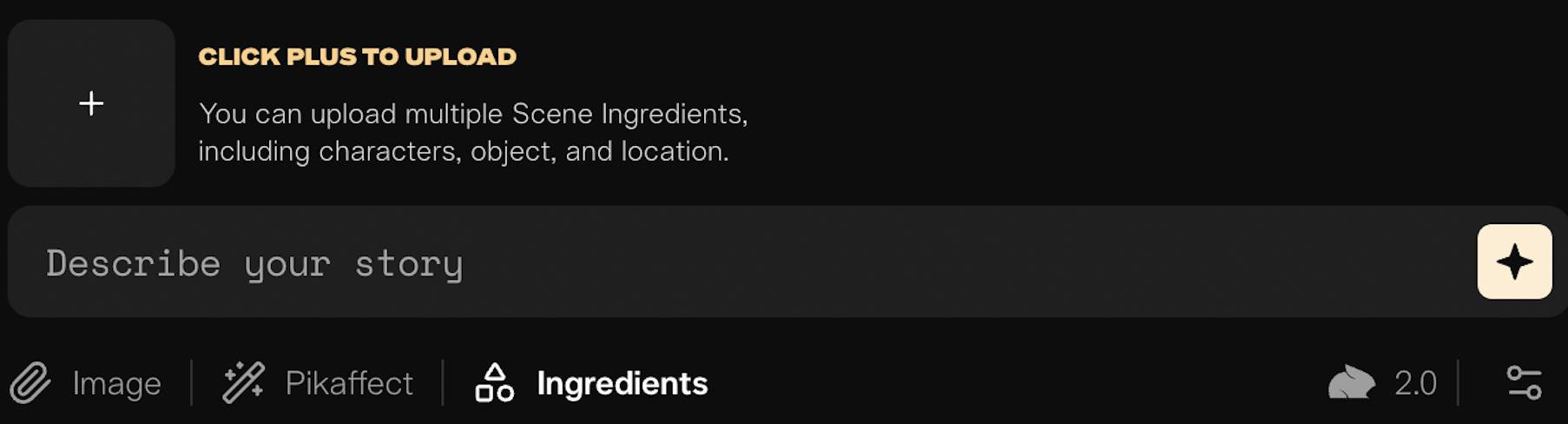

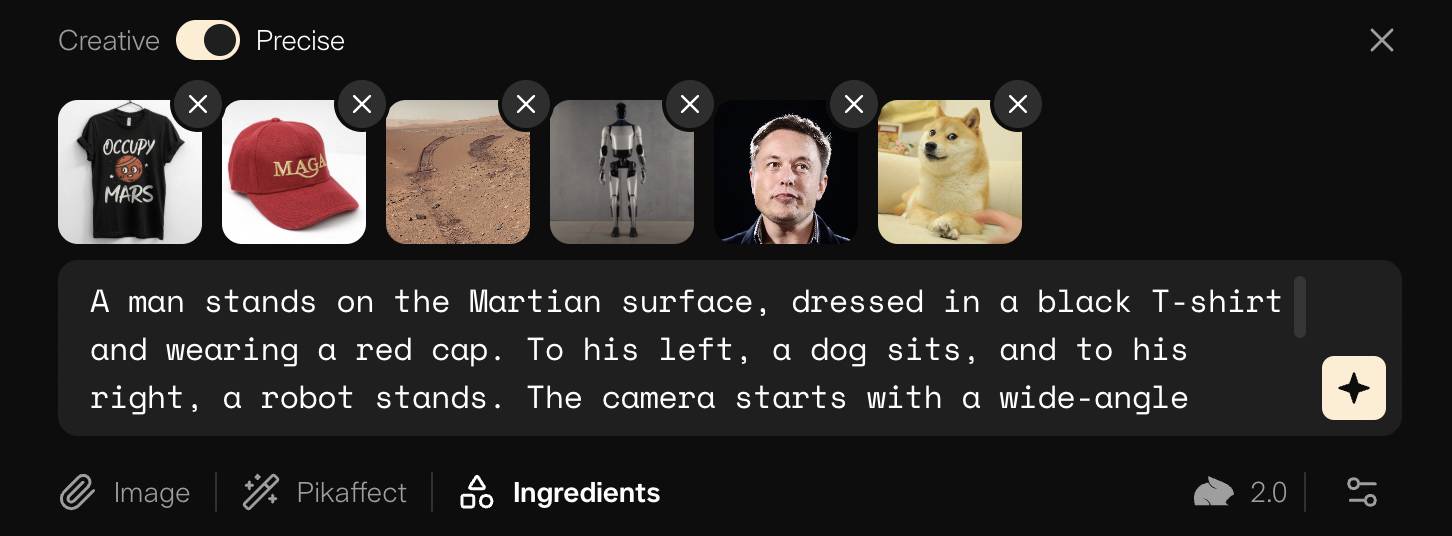

La fonction de Pika consistant à télécharger plusieurs images de référence est appelée « Ingrédients de scène ».

C'est très simple à utiliser : 1. Cliquez sur « + » pour télécharger des images, jusqu'à 6 images ; 2. Dans la zone de texte, écrivez un simple mot d'invite.

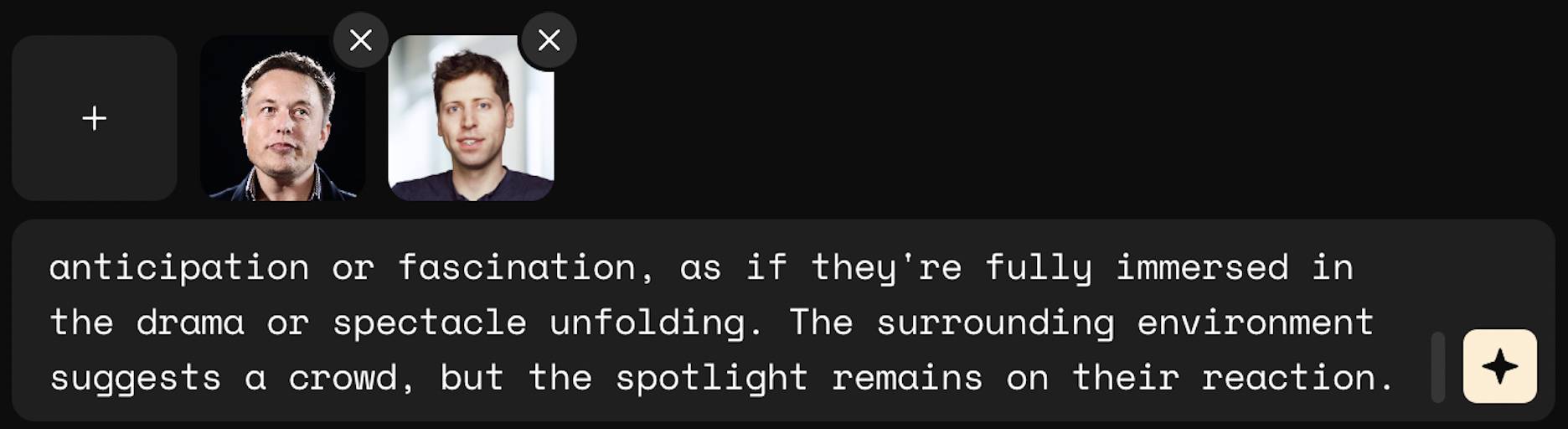

Passons ensuite à l'opération proprement dite : laissez Musk et Ultraman, qui sont en grande difficulté, transformer leur hostilité en amitié et regarder un film ensemble.

▲ Mots rapides : deux personnes sont assises dans un auditorium sombre. Ils tenaient un seau de pop-corn dans leurs mains, en mettaient une poignée dans leur bouche et mâchaient, se concentrant sur la scène devant eux. Leurs yeux écarquillés traduisent une impatience ou une fascination, comme s’ils étaient complètement immergés dans le drame ou la scène qui se déroule. Les environs suggèrent une foule nombreuse, mais l'accent reste mis sur leurs réactions

Il suffit de télécharger des photos de vous deux et le public peut écrire des mots rapides.

Pour Musk, l’IA est stable. Mais Ultraman ressemble à un fils de propriétaire idiot, sans compter qu'il a l'air horrible et que ses yeux sont si grands qu'ils sont sur le point de tomber.

Ce qui est intéressant avec Pika, c'est que les matériaux peuvent être « réutilisés ».

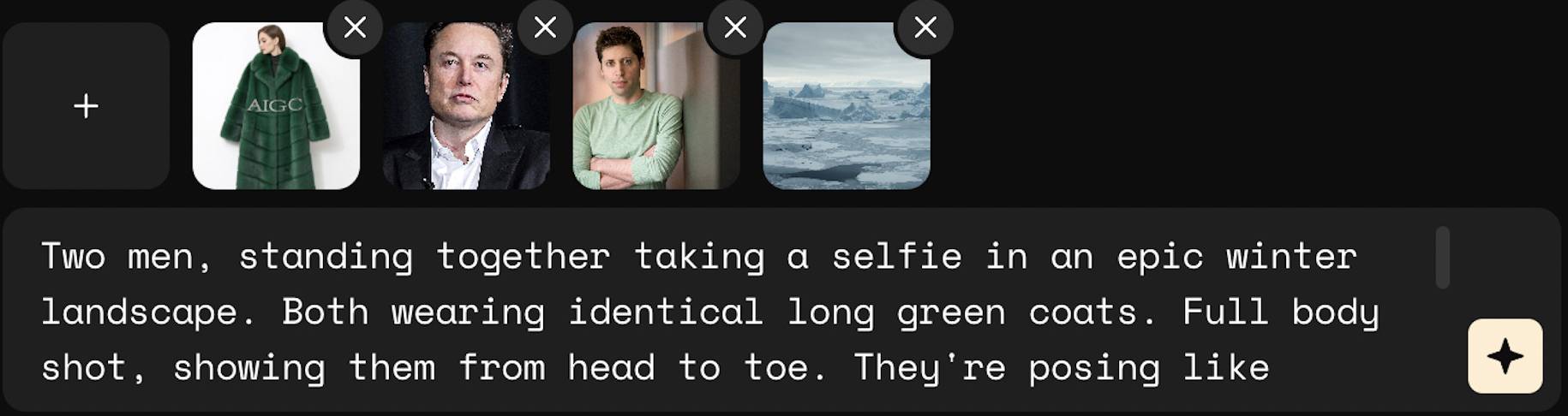

Nous pouvons donc laisser Musk et Altman devenir accros aux modèles. Téléchargez simplement une photo de vêtements, puis utilisez des mots rapides pour leur demander de porter le même manteau vert et de prendre un blockbuster de mode.

▲Mot rapide : deux hommes se sont tenus ensemble et ont pris un selfie dans le magnifique paysage hivernal. Tous deux portaient le même long manteau vert. Des photos de tout le corps, les montrant de la tête aux pieds. Ils posent comme des mannequins professionnels avec des sourires confiants sur leurs visages. Un éclairage cinématographique accentue leurs visages et la texture luxueuse de leur pelage. Style de photographie de mode haut de gamme, qualité d'appareil photo professionnelle, esthétique des magazines de mode

Les photos d'eux deux étaient toutes prêtes. Le manteau vert et le fond glacé et enneigé ont été générés séparément à l'aide de l'IA. Le « AIGC » sur les vêtements était une question supplémentaire pour tester Pika.

En conséquence, la cohérence de la scène et du manteau a été bien maintenue, les mots « AIGC » étaient vaguement identifiables et les mouvements des deux modèles suivaient également les mots d'invite.

Mais la grande question est : qui sont ces deux-là ? On ne peut pas dire que les visages dans la vidéo et les photos soient exactement les mêmes, on peut dire qu’ils n’ont absolument aucun rapport.

Si vous ne croyez pas au mal, continuez à laisser Pika se déguiser.

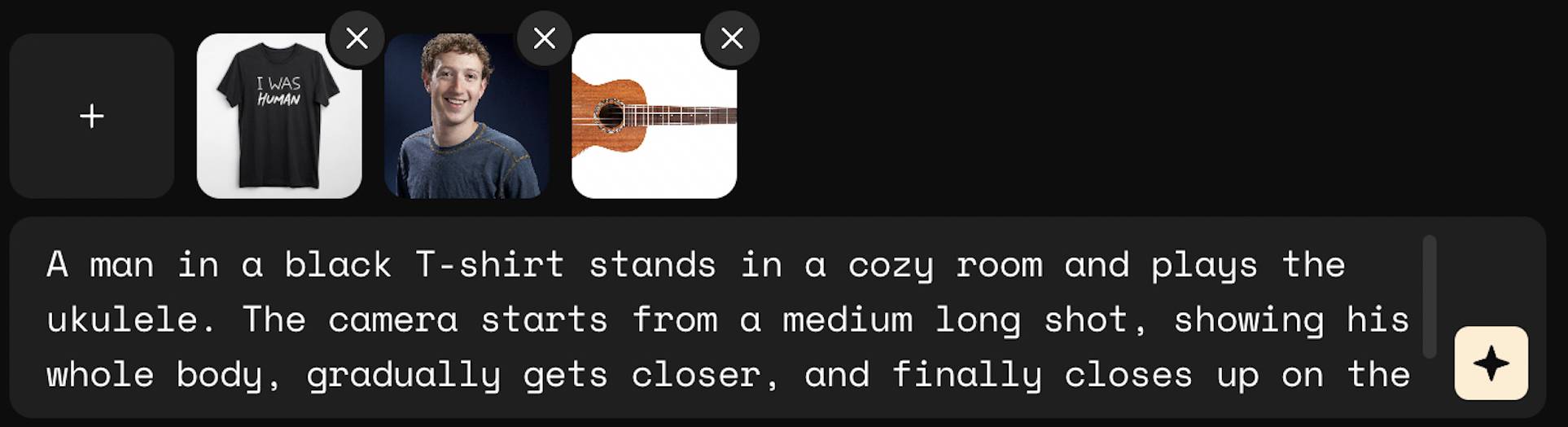

Cette fois, nous avons invité Zuckerberg à utiliser les outils d'image de l'IA pour générer des vêtements comme d'habitude, avec les mots « J'étais humain » écrits dessus, faisant écho au mème classique du robot.

Ensuite, trouvez une photo de Zuckerberg et une photo d'un ukulélé, et laissez Zuckerberg jouer de la musique.

▲Mot rapide : un homme portant un T-shirt noir se tient dans une pièce chaude et joue du ukulélé. La caméra part d'un plan moyen long, montrant tout son corps, zoome progressivement et se concentre enfin sur l'écriture sur le T-shirt.

Pika suit les instructions et bouge très bien la caméra, et les vêtements s'enfilent sans problème, mais sa main droite, en particulier son pouce, n'est toujours pas parfaite.

Par rapport à Google Veo, OpenAI Sora, etc., les capacités du modèle de Pika ne sont pas excellentes. Une fois un problème résolu, d'autres bugs sont découverts.

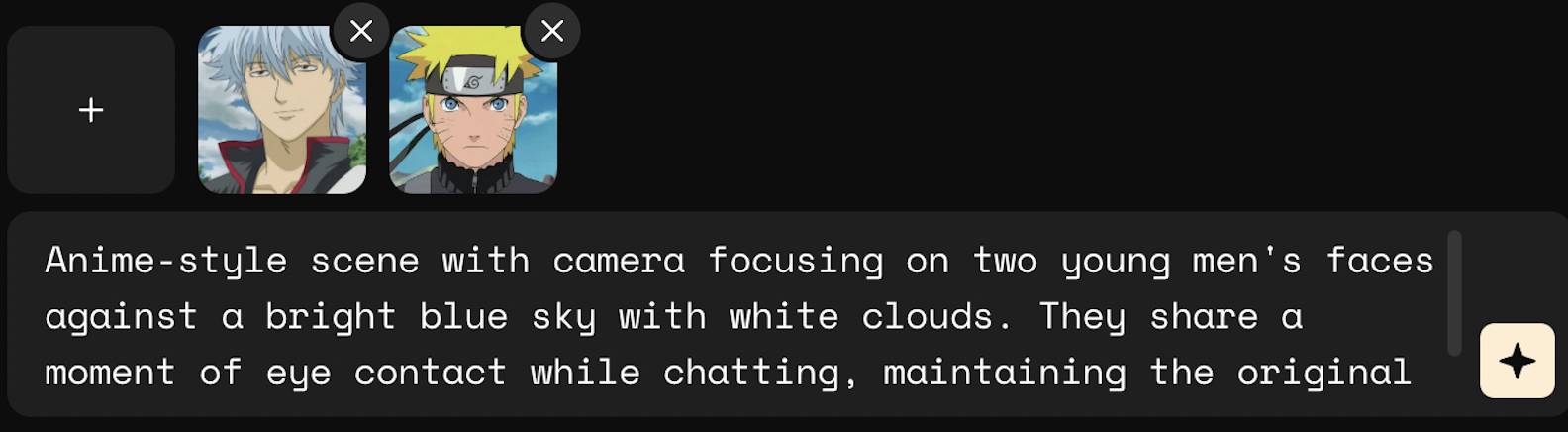

J'ai essayé le réalisme, puis le style de peinture en deux dimensions. Afin de mettre Sakata Gintoki et Uzumaki Naruto dans le même cadre, j'ai spécialement sélectionné deux images avec un ciel bleu et des nuages blancs en arrière-plan.

▲Conseils : Scène de style anime, la caméra se concentre sur les visages de deux jeunes hommes, avec le ciel bleu et les nuages blancs en arrière-plan. Ils ont établi un contact visuel tout en discutant, conservant le style artistique original de l'anime.

Le fond se mélange très naturellement, les deux expressions frontales sont bien jouées et le vent qui souffle sur les cheveux et les vêtements est juste. Cependant, se retourner était tout simplement trop effrayant. Gintoki a les yeux morts, il ne lève pas vraiment les yeux au ciel.

Les murs dimensionnels ont été brisés et, bien sûr, des peintures célèbres peuvent interagir à travers les générations – la Joconde et la jeune fille à la boucle d'oreille en perle mangeant des frites dans un restaurant McDonald's.

▲ Mot rapide : Mona Lisa et la fille à la boucle d'oreille en perle dînent dans un restaurant McDonald's. Ils étaient assis l'un en face de l'autre, avec des jetons sur la table. Alors qu'ils discutent et dégustent des frites, la caméra les capture de côté, les deux personnages regardant de temps en temps la caméra, créant une atmosphère décontractée et conviviale.

L'effet est difficile à décrire. Quand j'ai vu la Joconde, je me suis demandé si Léonard de Vinci avait envie de soulever la planche du cercueil. Les deux étaient placés dans la vidéo comme des autocollants, et leurs têtes bougeaient très étrangement.

Parfois, en revenant à la simplicité et en suivant la voie naturelle, les résultats dépassent les attentes.

▲ Mot rapide : gros plan, des bulles apparaissent à la surface de l'étang, puis la tasse de café sort de l'eau.

Téléchargez une photo de Starbucks ou une photo des nénuphars de Monet, et vous pourrez obtenir une tasse de café avec « de l'hibiscus germant à l'eau claire ».

Modèle domestique PK, le seuil de contrôle de la vidéo AI est plus bas

Dans une certaine mesure, Pika améliore la contrôlabilité des vidéos. Je ne peux pas en dire assez, car d'un point de vue pratique, Pika maintient une meilleure cohérence dans les scènes, les costumes et les objets, et le visage du personnage est facile à effondrer, quelle que soit sa dimension.

Dans le même temps, Pika doit également améliorer les capacités de base du modèle. Des problèmes surgiront toujours lors du mouvement des objets, comme manger et jouer du piano. Ces problèmes peuvent-ils être atténués en tirant des cartes ?

Trois mots : je ne peux pas me le permettre.

Pika 2.0 n'est actuellement disponible que pour les utilisateurs Pro et Fancy. Si vous vous abonnez sur une base mensuelle, cela vous coûtera au moins 35 $ par mois et il n'y a pas de limite d'essai gratuit.

De plus, les utilisateurs Pro ne disposent que de 2 000 points par mois, mais pour utiliser la fonction Scene Ingredients, une vidéo coûtera 100 points.

▲interface vidéo

En fait, le modèle vidéo d'IA domestique Vidu a implémenté la fonction « référence multi-images » plus tôt que Pika. Ce qui est encore plus intéressant pour les utilisateurs, c’est qu’il propose des points pour un essai gratuit.

J'ai également géré quelques caisses de Pika à Vidu. La Joconde et la Fille à la perle mangent des frites. Elles viennent d'être déterrées, mais la Joconde est plus restaurée que le Pika.

Musk et Ultraman ont regardé un film ensemble. Le visage de Musk était similaire à 70 à 80 %, mais le visage d'Ultraman était toujours désastreux.

Sakata Gintoki et Uzumaki Naruto sont dans le même cadre. Vidu peut en fait générer une face latérale basée sur la face avant, mais le style de peinture est différent de l'image originale.

De plus, en termes de fonctionnalités, Vidu est un peu inférieur à Pika : vous ne pouvez télécharger que trois images maximum. Ainsi, lorsque j’ai demandé à Vidu de réaliser une séance photo de mode pour Musk et Ultraman, je n’ai pas téléchargé l’arrière-plan, seulement les photos d’eux deux et de leurs manteaux verts.

Les deux se sentent très étranges. On voit que la stabilité des visages humains reste un problème.

Par rapport à Pika, l'efficacité de Vidu est une question d'opinion. Pika utilise la version Pro et Vidu utilise la version gratuite, ce qui entraînera objectivement des différences entre les deux.

Mais les idées de Pika et Vidu sont similaires : générer des objets relativement stables avec seulement quelques images et un simple mot d'invite.

Dans la génération de vidéos IA, pour maintenir la cohérence du sujet, la solution LoRA qui est actuellement relativement fiable consiste à utiliser une certaine quantité de matériel spécifique au sujet pour affiner le modèle. Avec une quantité appropriée de matériel et de formation, le modèle peut progressivement maîtriser l'apparence et les caractéristiques de ce personnage.

Mais pour que les vidéos IA soient utilisées par davantage de personnes et aient une plus grande valeur commerciale, le seuil doit être abaissé. Au moins, chez Vidu et Pika, nous voyons des possibilités.

Fiez-vous aux courtes vidéos de l’IA pour sortir du cercle et vous ne reviendrez jamais sur le chemin d’une vie saine.

Quelques jours seulement après la sortie du modèle 2.0 de Pika, les internautes étrangers sont devenus fous.

En prenant vos propres photos et en générant à plusieurs reprises des vidéos de différentes scènes, vous pouvez réaliser « l'univers instantané ».

▲ Photo de : X@EladRichardson

Grâce à l'ajustement en un clic via l'IA, les modèles et les vêtements s'enchaînent sans problème et la scène n'a pas besoin d'être modifiée, ce qui permet d'économiser de l'argent sur la prise de vue réelle.

▲ Photo de : X@martgent

En jouant, Pika m'a donné l'impression de jouer à "QQ Show" et aux Sims. Nous décidons comment habiller les personnages de la vidéo.

Il serait facile pour Musk de « réaliser son rêve ». Tout d’abord, il a utilisé d’autres outils d’IA pour générer un T-shirt « Occupy Mars » et un chapeau rouge avec « MAGA » écrit dessus.

Ensuite, téléchargez ces images, des scènes de Mars, des photos de Musk, de son robot humanoïde Optimus Prime et le prototype Doge de son package d'émoticônes de célébrités Internet préféré, le tout sur Pika.

▲Mot rapide : Un homme se tient à la surface de Mars, vêtu d'un T-shirt noir et d'un chapeau rouge. Un chien est assis à sa gauche et un robot à sa droite. La caméra commence par un plan large, capturant les corps entiers d’hommes, de chiens et de robots. Alors que la caméra zoomait régulièrement, l'homme faisait un signe joyeux vers la caméra, son expression remplie de joie et d'esprit aventureux.

Finalement, un garçon ensoleillé et joyeux est apparu. Il tenait une main jaune sur sa main gauche et un ciel bleu sur sa main droite. Il était honnête et honnête, mais il ne ressemblait tout simplement pas à Musk.

Cela ne semble pas être la même chose. Tant que vous avez l'esprit ouvert, il existe une infinité de façons de jouer.

La chasse aux étoiles peut être indolore sur la base de photos de nous-mêmes et de personnes célèbres. Téléchargez des chapeaux, des vêtements et des instruments de musique pour vous habiller de la tête aux pieds. Collectionnez les scènes, les produits et les modèles, et vous obtenez un film publicitaire d'effets spéciaux de 5 mois…

Photos + images AI + Pika 2.0 + mots d'invite peuvent générer de nombreuses images intéressantes. Dans le même temps, cette méthode de génération évite également certains défauts du modèle vidéo, tels que l'écriture, qui peuvent être résolus par le modèle d'image.

Ni comparé aux capacités robustes du modèle de Google, ni comparé à des concurrents comme Runway qui poursuivent des rêves hollywoodiens, Pika a sa propre façon de dépasser dans les virages.

En fait, Pika a toujours été d'une grande aide en matière d'édition et de créativité. La précédente série de fonctions d'effets spéciaux d'IA Pikaffect a explosé sur Internet, balayant les écrans de Xiaohongshu et de TikTok, poussant les utilisateurs de Pika à dépasser les 11 millions.

▲ Pincement AI Photo de : Pika.

▲AI coupe le gâteau Photo de : Pika.

Pika touche un groupe d'utilisateurs qui ont une forte demande de courtes vidéos en direct. Même si ces vidéos sont modélisées et éphémères, tant qu'elles sont intéressantes, les gens y afflueront.

Qui a dit que le gagnant remportait tout ? Le marché de l'IA est vaste et simuler le monde physique est certainement un rêve noble. D'abord, atteindre le petit objectif de rendre les courtes vidéos d'IA intéressantes n'est peut-être pas une solution réussie.

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo