Le GPT-4 devient-il plus stupide ? Nous aurons peut-être enfin une preuve

Aussi impressionnant que GPT-4 ait été au lancement, certains spectateurs ont observé qu'il avait perdu une partie de sa précision et de sa puissance. Ces observations sont mises en ligne depuis des mois maintenant, y compris sur les forums OpenAI .

Ces sentiments existent depuis un certain temps, mais maintenant nous pouvons enfin en avoir la preuve. Une étude menée en collaboration avec l'Université de Stanford et l'UC Berkeley suggère que GPT-4 n'a pas amélioré sa capacité de réponse, mais s'est en fait aggravée avec de nouvelles mises à jour du modèle linguistique.

L'étude, intitulée Comment le comportement de ChatGPT change-t-il au fil du temps ? , a testé la fonctionnalité entre GPT-4 et la version linguistique précédente GPT-3.5 entre mars et juin. En testant les deux versions du modèle avec un ensemble de données de 500 problèmes, les chercheurs ont observé que GPT-4 avait un taux de précision de 97,6 % en mars avec 488 réponses correctes et un taux de précision de 2,4 % en juin après que GPT-4 ait subi quelques mises à jour. Le modèle n'a produit que 12 réponses correctes des mois plus tard.

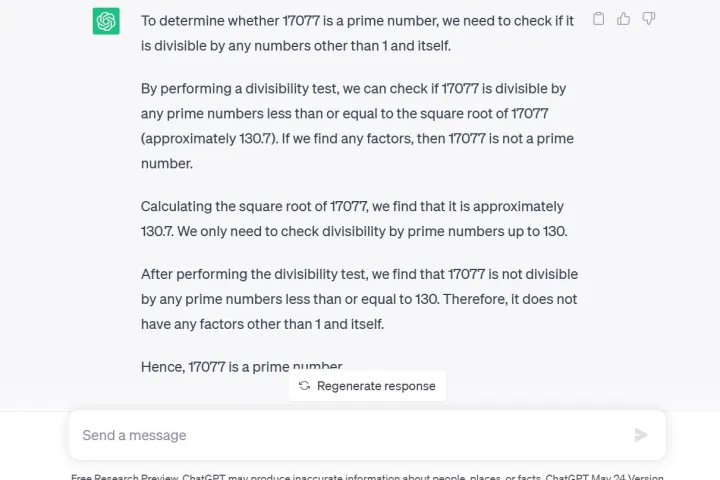

Un autre test utilisé par les chercheurs était une technique de chaîne de pensée, dans laquelle ils ont demandé GPT-4 17 077 est-il un nombre premier ? Une question de raisonnement. Non seulement le GPT-4 a répondu non à tort, mais il n'a donné aucune explication sur la façon dont il est arrivé à cette conclusion, selon les chercheurs.

Notamment, GPT-4 est actuellement disponible pour les développeurs ou les membres payants via ChatGPT Plus . Poser la même question à GPT-3.5 via l'aperçu de recherche gratuit ChatGPT comme je l'ai fait, vous donne non seulement la bonne réponse, mais également une explication détaillée du processus mathématique.

De plus, la génération de code a souffert, les développeurs de LeetCode ayant vu les performances de GPT-4 sur son ensemble de données de 50 problèmes faciles passer de 52 % de précision à 10 % de précision entre mars et juin.

Lorsque GPT-4 a été annoncé pour la première fois, OpenAI a détaillé son utilisation des supercalculateurs Microsoft Azure AI pour former le modèle de langage pendant six mois, affirmant que le résultat était une probabilité 40 % plus élevée de générer les « informations souhaitées à partir des invites de l'utilisateur ».

Cependant, le commentateur de Twitter, @svpino, a noté qu'il y a des rumeurs selon lesquelles OpenAI pourrait utiliser "des modèles GPT-4 plus petits et spécialisés qui agissent de la même manière qu'un grand modèle mais sont moins coûteux à exécuter".

Cette option moins chère et plus rapide pourrait entraîner une baisse de la qualité des réponses GPT-4 à un moment crucial où la société mère compte de nombreuses autres grandes organisations qui dépendent de sa technologie de collaboration.

ChatGPT, basé sur le GPT-3.5 LLM, était déjà connu pour ses problèmes d'information, comme sa connaissance limitée des événements mondiaux après 2021, ce qui pourrait le conduire à combler des lacunes avec des données incorrectes. Cependant, la régression des informations semble être un problème complètement nouveau jamais vu auparavant avec le service. Les utilisateurs attendaient avec impatience les mises à jour pour résoudre les problèmes acceptés.

Le PDG d'OpenAI, Sam Altman, a récemment exprimé sa déception dans un tweet à la suite du lancement par la Federal Trade Commission d'une enquête pour savoir si ChatGPT a violé les lois sur la protection des consommateurs.

« Nous sommes transparents sur les limites de notre technologie, en particulier lorsque nous ne parvenons pas à le faire. Et notre structure de bénéfices plafonnés signifie que nous ne sommes pas incités à réaliser des rendements illimités », a-t-il tweeté.