Le moment iPhone de Nvidia AI est là

Lors de la conférence GTC en mars aujourd'hui, le PDG de Nvidia, Huang Renxun, a lancé la phrase d'or "L'heure de l'iPhone pour l'IA est venue".

Maintenant, après un laps de temps de 5 mois, il est plus exact de dire que la phrase d'or de Huang Renxun peut peut-être être réécrite comme suit : « L'heure de l'iPhone de Nvidia AI est arrivée ».

L’explosion de l’IA générative a donné aux gens un aperçu du prochain débouché, et d’innombrables géants de la technologie se bousculent pour entrer dans la voie de l’IA générative, essayant d’ouvrir cette porte technologique pleine d’opportunités.

Mais les idées sont très subjectives, la réalité est très objective. La puissance de calcul, les modèles et les données ont toujours été les trois éléments majeurs du développement de l'IA. La puissance de calcul représentée par les puces d'IA n'est pas seulement la pierre angulaire sous-jacente de l'intelligence artificielle, mais aussi la clé pour ouvrir la porte à cette technologie.

Et désormais, la clé de l’avenir est entre les mains de Nvidia.

Il y a cinquante-huit ans, Gordon Moore, l'un des fondateurs d'Intel, proposait la célèbre loi de Moore basée sur les données collectées de 1959 à 1965 sur le nombre de transistors sur les circuits intégrés.

Le nombre de transistors pouvant être logés sur un circuit intégré double environ tous les deux ans.

Puis de nouvelles extrapolations ont émergé et l’intervalle de deux ans a été ramené à 18 mois.

Sous l'effet de la loi de Moore, les performances de traitement des CPU et GPU ont connu une croissance exponentielle. Après 2000, les CPU sont passés du monocœur au multicœur et le nombre de cœurs a été considérablement augmenté.

La formation et le raisonnement de l'apprentissage profond de l'IA reposent largement sur des calculs matriciels et des calculs à virgule flottante, ce qui impose des exigences extrêmement élevées en matière de puissance de calcul. Les GPU sont capables de calculs parallèles à grande échelle, dépassant de loin les processeurs en calcul matriciel et vectoriel, et sont devenus la "plateforme de calcul haute performance". chérie".

En outre, les avantages d'une bande passante mémoire à haut débit, d'un pool de puissance de calcul évolutif, d'un cadre d'apprentissage en profondeur spécialement optimisé et de la prise en charge du déploiement dans le cloud ont également fermement établi la position centrale de la puissance de calcul GPU à l'ère de l'IA.

Fondée en avril 1993, Nvidia a débuté avec les GPU et est progressivement devenue un leader dans le domaine du calcul haute performance grâce à une innovation et un développement continus.

Selon le rapport sur les statistiques du marché des GPU publié par Jon Peddie Research, Nvidia se classe premier avec une part de marché de 84 %, suivi d'AMD avec 12 % et d'Intel avec 4 %.

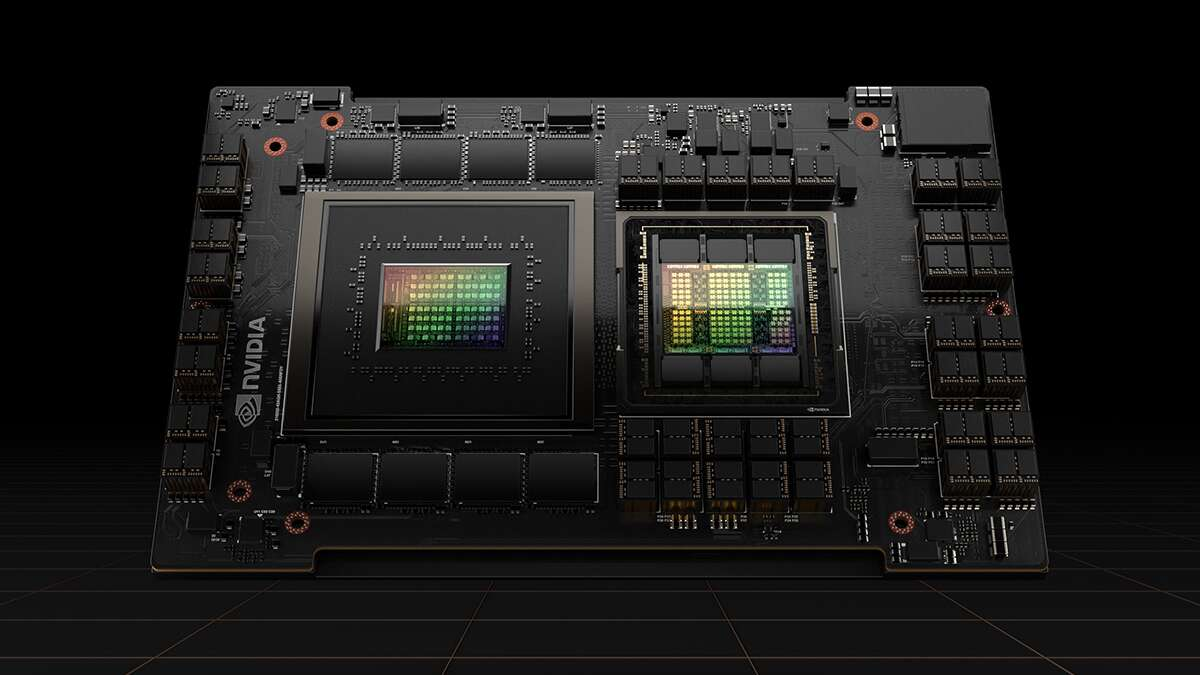

Les A100 et H100 sont tous deux des GPU de centre de données de haut niveau de Nvidia, spécialement conçus pour le calcul de l'IA. En termes de formation et de raisonnement des réseaux neuronaux à grande échelle, leurs performances dépassent de loin celles des autres concurrents. Les deux puces phares entre les mains de Nvidia.

Depuis le début de cette année, Nvidia s'est concentré sur "plus vous achetez, plus vous économisez", et a lancé divers GPU mis à jour de manière itérative de manière très habile et "intime".

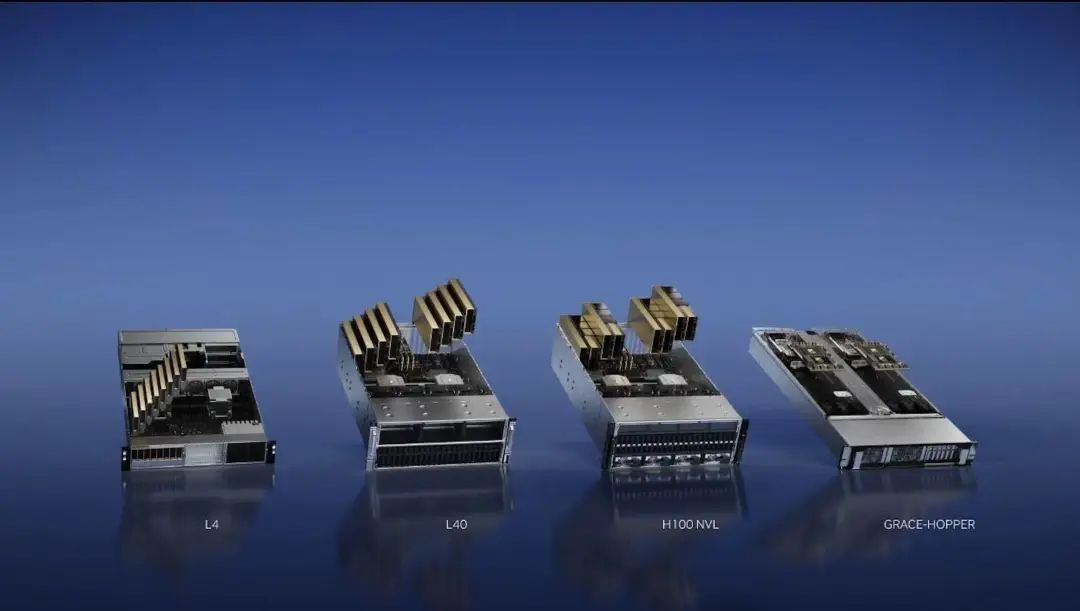

En mars, Nvidia a publié quatre puces d'inférence IA, le GPU H100 NVL, le GPU L4 Tensor Core, le GPU L40 et NVIDIA Grace Hopper.

Deux mois plus tard, au Taipei Computer Show en mai, Huang Renxun a présenté le supercalculateur DGX GH200 composé de 256 superpuces NVIDIA GH200 Grace Hopper.

Il y a à peine deux semaines, Huang Renxun a publié une nouvelle version du GH200 Grace Hopper équipé de la mémoire HBM3e, qui est également la première puce GPU au monde équipée de la mémoire HBM3e.

La mémoire HBM3e est un nouveau type de technologie de mémoire à large bande passante. En termes de vitesse de calcul, HBM3e peut être 50 % plus rapide que la vitesse de calcul HBM3, offrant un taux de transmission maximal de 5 To/s.

La formation et le raisonnement sont deux étapes très importantes des grands modèles d’IA, et c’est précisément pour cela que le GH200 est bon. Selon Huang Renxun, le scénario d'application typique du GH200 à l'avenir est le grand modèle de langage, et le « calcul accéléré » et le « calcul IA » remplaceront progressivement le « calcul général » des GPU x86 traditionnels.

De nombreux cas dans le passé ont prouvé qu’une fois qu’un excellent écosystème est construit dans un fossé, les étrangers prennent le dessus dans la compétition.

Le solide écosystème de Nvidia nécessite naturellement la certification du label de ses concurrents. Naveen Rao, un scientifique des réseaux neuronaux, a déjà été vice-président et directeur général de la division des plates-formes d'intelligence artificielle chez Intel.

Il a découvert que le plus grand avantage de Nvidia n'est pas seulement la puce elle-même, mais que Nvidia dispose d'une vaste communauté et d'un centre de distribution avec un grand nombre d'excellents programmeurs d'intelligence artificielle.

CUDA est une plate-forme de calcul parallèle et un modèle de programmation basés sur des GPU produits par Nvidia, dont le but est de permettre à davantage de personnel technique de participer au développement.

Les développeurs peuvent appeler les API CUDA via des langages de haut niveau tels que C/C++ et Fortan pour effectuer une programmation parallèle et effectuer un calcul haute performance. La création de cet écosystème incite de nombreux développeurs à s'appuyer sur CUDA.

Auparavant, Huang Renxun a révélé au monde extérieur que CUDA compte plus de 4 millions de développeurs et plus de 3 000 applications dans le monde, et que les téléchargements cumulés de CUDA ont atteint 40 millions de fois. Il y a 40 000 grandes entreprises dans le monde qui utilisent les produits NVIDIA pour calcul accéléré. 15 000 startups sont construites sur la plateforme NVIDIA.

Ce nombre énorme reflète l'avantage significatif de Nvidia en tant que premier arrivé : si d'autres adversaires veulent lancer du nouveau matériel, ils doivent également envisager de rattraper cet écosystème d'innovation en matière d'intelligence artificielle déjà formé.

Les deux extrémités de la transaction, une extrémité est connectée au vendeur et l’autre extrémité est connectée à l’acheteur.

En avril, le « double standard » Musk a signé conjointement une interdiction de la formation de l'IA, tout en balayant secrètement 10 000 GPU pour développer de grands modèles, et a même déposé des plaintes publiques sur X : « Il semble que tout le monde et chaque chien achètent un GPU. ".

Le mois dernier, le président d'Oracle a déclaré publiquement qu'Oracle dépenserait des milliards de dollars pour acheter des GPU de Nvidia afin d'étendre les services de cloud computing à une nouvelle vague d'entreprises d'intelligence artificielle.

Ceux qui obtiennent la puissance de calcul gagnent le monde. Sur la piste de l'IA générative où l'on se poursuit, il y a aussi l'angoisse de chercher des « puces » dans le pays.

Selon le rapport britannique du « Financial Times », les géants chinois de l'Internet se démènent pour s'emparer des puces d'IA hautes performances de Nvidia, avec des commandes pouvant atteindre 5 milliards de dollars cette année et l'année prochaine.

Parmi eux, Baidu, Tencent, Alibaba et ByteDance ont passé des ordres de paiement à Nvidia pour un total d'un milliard de dollars cette année, achetant un total de 100 000 A800, soit l'équivalent d'un prix de 10 000 dollars par puce A800, et livrant les 400 000 puces restantes. l’année prochaine, cent millions de dollars américains.

Il convient de noter que l'A800 est essentiellement une « version castrée » de l'A100. En raison de l'impact de la politique d'août de l'année dernière, Nvidia ne peut lancer qu'une version alternative sans restriction pour le marché chinois continental.

De nombreuses personnes dans l'industrie pensent que les GPU sont devenus une denrée rare sur le marché et que la situation des puces difficiles à trouver sera encore difficile à améliorer au cours des deux prochaines années.

Par conséquent, face à la recherche continue de GPU en pénurie, les GPU de Nvidia sont même devenus une monnaie forte pour certaines start-ups d'IA.

En tant que startup de cloud computing, il n'a pas été facile pour CoreWeave d'obtenir un prêt de démarrage. Mais « ne regardez pas le visage du moine pour voir le visage du Bouddha », grâce au statut d'investisseur de Nvidia, CoreWeave peut même utiliser le GPU H100 comme garantie, et a facilement obtenu un prêt de 2,3 milliards de dollars américains.

Du point de vue du prêteur, il ne s’agira naturellement pas d’une activité déficitaire.

D'une part, ce prêt permettra à CoreWeave d'étendre rapidement sa taille et sa puissance de calcul et d'améliorer sa capacité à rembourser le prêt. D'autre part, Nvidia lancera davantage de GPU itératifs l'année prochaine. Grâce aux prêts, CoreWeave peut également saisir l'opportunité de prenez des GPU.

Comme mentionné précédemment, étant donné que les principaux fabricants ne peuvent pas s'emparer des GPU sur le marché, la situation des start-ups d'IA qui ne sont pas fortes est évidemment encore plus préoccupante.

Depuis, certaines startups d’IA intelligente ne peuvent que choisir de trouver une autre voie, de se serrer les coudes et d’investir dans les bras de Nvidia.

En juin de cette année, la startup d'intelligence artificielle Inflection AI a officiellement annoncé avoir bouclé un nouveau tour de financement de 1,3 milliard de dollars américains. Il convient de noter que NVIDIA est apparu pour la première fois dans la toute nouvelle liste d'investissement.

Inflection AI a annoncé qu'elle construirait le plus grand cluster d'IA au monde avec ses partenaires CoreWeave et NVIDIA.

Cette alliance apparemment heureuse s'apparente davantage à un choix impuissant. Le PDG d'Inflection AI, Mustafa Suleyman, a déclaré dans une interview au New York Times : "La société n'est pas obligée d'utiliser les produits de Nvidia, mais les concurrents n'ont pas proposé d'alternatives viables."

En fait, Inflection AI met tout en œuvre pour construire un supercalculateur avancé composé de près de 700 processeurs Intel Xeon dans un serveur rack à quatre nœuds équipé de 22 000 GPU H100.

Un si grand nombre de GPU est enviable pour les autres, mais il est difficile de ne pas rappeler aux gens la stratégie de fourniture prioritaire des GPU de Nvidia consistant à "ne pas laisser la graisse et l'eau couler vers les étrangers".

Bien sûr, avec la brise printanière de l'IA générative, l'offre mondiale de GPU est rare et les prix augmentent. Nvidia gagne également beaucoup d'argent dans cette vague d'IA.

À la fin de l'année dernière, des sources ont révélé à Raymond James de la banque d'investissement que le coût du GPU H100 était de 3 320 dollars (actuellement environ 24 181 yuans), tandis que Nvidia a choisi de le vendre entre 25 000 et 30 000 dollars (actuellement environ 182 000 yuans). à 219 000 yuans). Vendez ces GPU.

Bien que cette déclaration ne prenne pas en compte d'autres coûts tels que le transport et la logistique, mais uniquement du rapport coût de production/prix de vente, le GPU NVIDIA H100 est simplement une « super vache à lait ».

Par ailleurs, selon le média étranger Tomshardware, Nvidia prévoit de vendre plus de 550 000 GPU H100 cette année. Si cela est vrai, cela signifie que les revenus de Nvidia provenant du seul GPU H100 sont déjà astronomiques.

L’IA générative a apporté plus de surprises à Nvidia que cela.

Cette année, c'est le « trentenaire » de Nvidia. Le dernier jour du mois de mai, Nvidia est devenue la première entreprise de puces au monde avec une valeur marchande de plus de 1 000 milliards de dollars. C'est également la neuvième entreprise technologique de l'histoire à entrer dans la valeur marchande de 1 000 milliards de dollars. club.

Le rapport financier du premier trimestre de l'exercice 2024 montre que le chiffre d'affaires de Nvidia au premier trimestre s'est élevé à 7,192 milliards de dollars, soit une augmentation de 19 % par rapport aux 6,051 milliards de dollars du trimestre précédent, et que son bénéfice net était de 2,043 milliards de dollars. et les revenus ont tous deux dépassé les attentes des analystes de Wall Street.

En outre, le rapport sur les résultats du deuxième trimestre fiscal publié le 24 de ce mois devrait également dépasser les 10 milliards de dollars de revenus. Au moment de mettre sous presse, la valeur marchande de Nvidia a atteint 1,16 billion de dollars et son ratio cours-bénéfice a atteint 244,09. La dynamique de croissance reste optimiste.

En juin de cette année, Jen-Hsun Huang, qui portait une toge de remise des diplômes, a été invité à participer au discours de remise des diplômes de l'Université nationale de Taiwan et a utilisé son expérience de vie passée pour envoyer un message aux diplômés !

Quoi qu’il en soit, poursuivons-le de toutes nos forces, courons ! Ne marchez pas lentement.

Qu'il s'agisse de courir pour se nourrir ou de ne pas être traité comme de la nourriture par les autres.

Souvent, vous ne savez pas dans quelle situation vous vous trouvez, alors continuez à courir quoi qu'il arrive.

L’opportunité de l’histoire est éphémère et la piste GPU est destinée à être une piste où le vainqueur remporte tout.

Huang Renxun, qui a couru à toute vitesse, a saisi l'opportunité de l'IA et a fait entrer Nvidia, qui est né dans une chaîne de restaurants en bordure de route, avec succès dans le club des mille milliards de dollars, devenant ainsi le plus grand gagnant de cette vague d'IA, et continuera à diriger cette époque.

#Bienvenue pour suivre le compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo