Test réel du modèle Wenxin 4.5T/X1 dual Turbo, le « coupé au couteau » de Baidu a également balayé DeepSeek

La stratégie open source prônée par DeepSeek a non seulement eu un impact important sur les « six petits dragons de l’IA », mais a également exercé une réelle pression sur des géants établis tels que Baidu.

Mais Baidu, qui s'est retourné, montre progressivement une forte contre-attaque.

Suite à l'annonce que la « série Wenxin Large Model 4.5 » sera officiellement open source le 30 juin, Baidu, qui a lancé un certain nombre de nouveaux produits, a lancé aujourd'hui deux nouveaux modèles lors de la conférence Create pour les développeurs : Wenxin 4.5 Turbo et Deep Thinking Model X1 Turbo.

Depuis qu'ils s'appellent Turbo, les capacités de ces deux modèles ont naturellement été entièrement améliorées en termes de performances, en mettant l'accent sur la multimodalité, un raisonnement solide et un faible coût. Wen Xiaoyan, le nouvel assistant de recherche intelligent de Baidu, a également annoncé un accès complet et est ouvert gratuitement aux utilisateurs. Désormais, les utilisateurs peuvent utiliser l'application Wen Xiaoyan.

Lors de la réunion, le fondateur de Baidu, Robin Li, a clairement souligné : « La multimodalité deviendra la norme pour les modèles de base à l'avenir. Le marché des modèles de texte pur deviendra de plus en plus petit, tandis que le marché des modèles multimodaux deviendra de plus en plus grand.

"Bien sûr, DeepSeek n'est pas tout-puissant. Par exemple, il ne peut traiter que du texte et il ne peut pas comprendre et générer du contenu multimédia tel que des images, des audios et des vidéos", estime Robin Li. "Son plus gros problème est qu'il est lent et coûteux. La plupart des appels d'API à grand modèle sur le marché chinois sont moins chers et plus rapides que la version complète de DeepSeek."

Selon lui, les 4.5 Turbo et X1 Turbo des grands modèles Wenxin lancés aujourd'hui sont précisément pour résoudre ces problèmes.

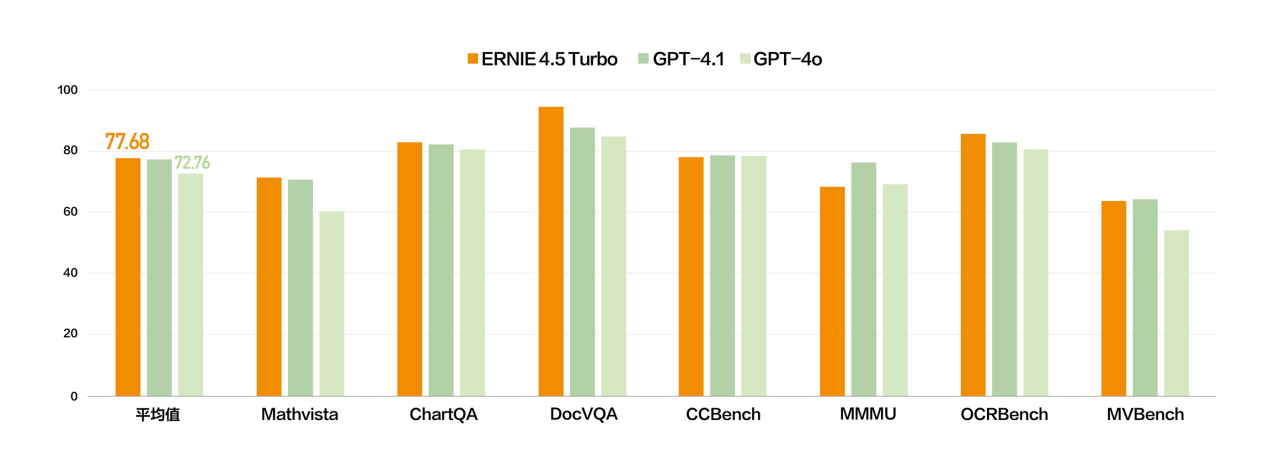

Sur la base de ce jugement, le grand modèle Wenxin 4.5 Turbo renforce encore ses capacités multimodales. Dans plusieurs ensembles de tests de référence, les capacités multimodales de Wenxin 4.5 Turbo sont comparables à celles de GPT-4.1, et même meilleures que celles de GPT-4o dans certaines dimensions.

▲Wenxin 4.5 Turbo-Multi-mode

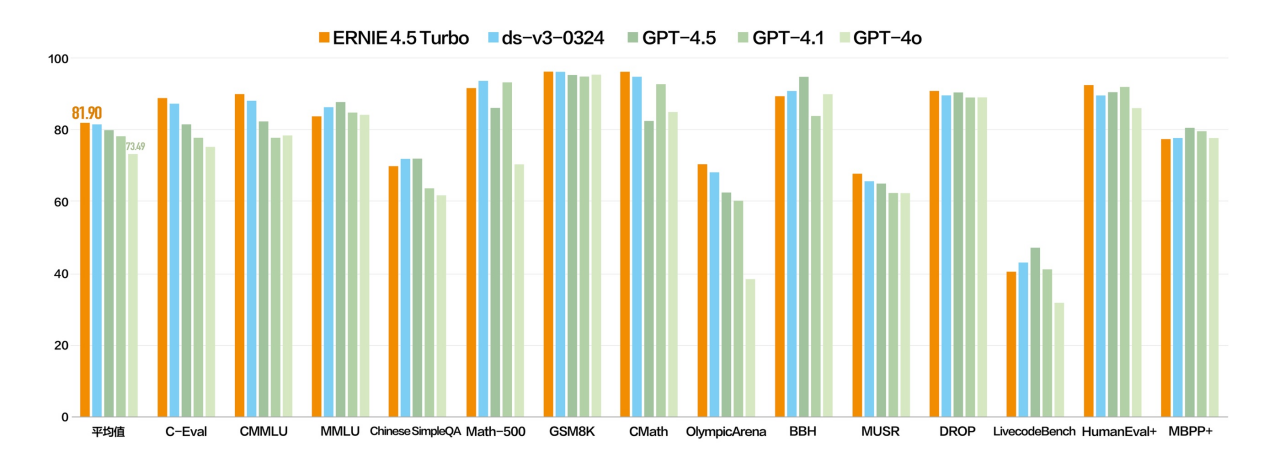

▲ Wenxin 4.5 Turbo-Texte

Autant tester la capacité de raisonnement logique de Wenxin 4.5 Turbo et voir comment il peut répondre à une question aussi classique :

"Il faut une heure pour brûler une corde inégale. Comment l'utiliser pour juger une demi-heure ? Il faut au total 1 heure pour brûler une corde inégale du début à la fin. Maintenant, il y a plusieurs cordes du même matériau. Comment puis-je utiliser la méthode de combustion d'une corde pour chronométrer une heure et quinze minutes ?"

En termes de création, Wenxin 4.5 Turbo est-il fiable ? Nous lui avons également demandé d'écrire un court scénario sur Sun Wukong et le roi dragon de la mer de Chine orientale devenant frères jurés.

En conséquence, le scénario remis a non seulement respecté l’essentiel de l’œuvre originale, mais a également injecté de nouvelles interprétations. Parmi eux, la personnification de l'aiguille fixatrice de mer est le point culminant, et la conception de la cérémonie de l'alliance du sang ajoute également une nouvelle dimension.

Le grand modèle Wenxin X1 Turbo a été mis à niveau avec une « réflexion profonde » sur la base du 4.5 Turbo, avec des performances considérablement améliorées et un système de chaîne de réflexion intégré plus complet.

Qu'il s'agisse de fonctionnalités de questions et réponses, de création de contenu, de raisonnement logique, d'appel d'outils ou de traitement multimodal, X1 Turbo a réalisé des améliorations globales et ses performances globales sont en avance sur DeepSeek R1 et la dernière version V3.

Le mois dernier, nous avons testé la capacité de Wenxin Large Model 4.5 et Deep Thinking Model X1 à comprendre les mèmes. Quelles sont les performances du nouveau modèle ? La réponse est que la compréhension multimodale est effectivement plus forte.

Prenez ce mème comme exemple. Par rapport à la dernière fois, X1 Turbo a une meilleure compréhension et une réponse plus organisée, reconnaissant pleinement la « gentillesse amicale » derrière cette émoticône universelle.

Par exemple, téléchargez une photo d'une relique culturelle et laissez X1 Turbo l'expliquer et l'analyser. Il peut non seulement identifier avec précision l'identité des reliques culturelles, mais également analyser en détail ses caractéristiques artisanales et expliquer le contenu avec autant de détails qu'un interprète de musée professionnel.

Ou essayez de générer une image du point de vue d’un avion dans les airs, et l’image sera générée immédiatement, presque réelle.

▲Invite : la main d’une personne pointe vers la fenêtre de l’avion. Les ailes de l'avion à l'extérieur de la fenêtre sont visibles de côté. Le ciel extérieur est clair et l’horizon montre une scène d’aube ou de crépuscule. Devant toi se trouve le vaste océan

En termes de coût, qui préoccupe le plus tout le monde, Baidu a également lancé cette fois une combinaison de prix.

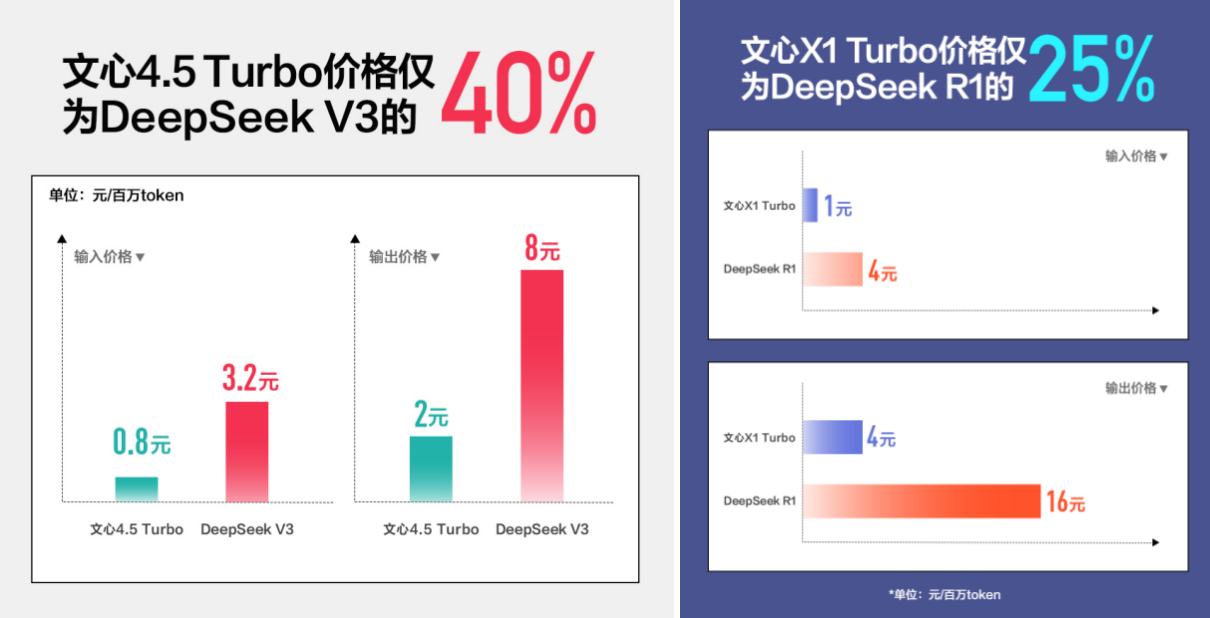

Le prix d'entrée du Wenxin Large Model 4.5 Turbo n'est que de 0,8 yuans par million de jetons et le prix de sortie est de 3,2 yuans, ce qui représente une diminution de 80 % par rapport à la génération précédente 4.5 et n'équivaut qu'à 40 % de DeepSeek V3.

Le prix d'entrée du grand modèle X1 Turbo Wenxin est de 1 yuan par million de jetons et le prix de sortie est de 4 yuans. Le prix est également réduit de moitié tandis que les performances sont améliorées, seulement 25 % par rapport au DeepSeek R1.

Lors de la session One More Thing du jour, Baidu a officiellement lancé le premier cluster de 30 000 cartes entièrement développé en Chine, qui peut simultanément héberger la formation complète de plusieurs grands modèles avec des dizaines de milliards de paramètres, et aider 1 000 clients à affiner simultanément de grands modèles avec des dizaines de milliards de paramètres. Derrière la puissance d'une base technique solide, cela signifie également que Baidu a une fois de plus lancé le signal le plus clair à l'industrie.

En outre, Robin Li a déclaré lors de la réunion que l'un des obstacles actuels auxquels se heurtent les développeurs pour mettre en œuvre des applications d'IA est que les grands modèles sont coûteux et inabordables. Une fois les coûts réduits, les développeurs et les entrepreneurs peuvent se développer en toute confiance et audace, et les entreprises peuvent déployer de grands modèles à faible coût, favorisant ainsi l'explosion des applications dans tous les domaines.

Nous ne considérons plus les capacités des modèles comme une barrière, mais revenons à la logique de « rentabilité » que devraient avoir un produit et une plateforme. Plutôt que de parler de prix roulant, il vaut mieux utiliser l’efficacité pour abaisser le seuil et construire un écosystème par l’ouverture.

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (WeChat ID : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo