Musk a annoncé la création d’un concurrent ChatGPT ! Le PDG d’OpenAI lui a versé de l’eau froide, GPT-5 pourrait changer radicalement

Lorsque vous entrez une question dans ChatGPT ou nouveau bing, l'IA appellera son cerveau cloud, y réfléchira et générera une réponse plus raisonnable.

Lorsque OpenAI a développé GPT, il a été mentionné à plusieurs reprises que les paramètres devenaient énormes et que l'échelle du modèle devenait de plus en plus complexe de génération en génération.

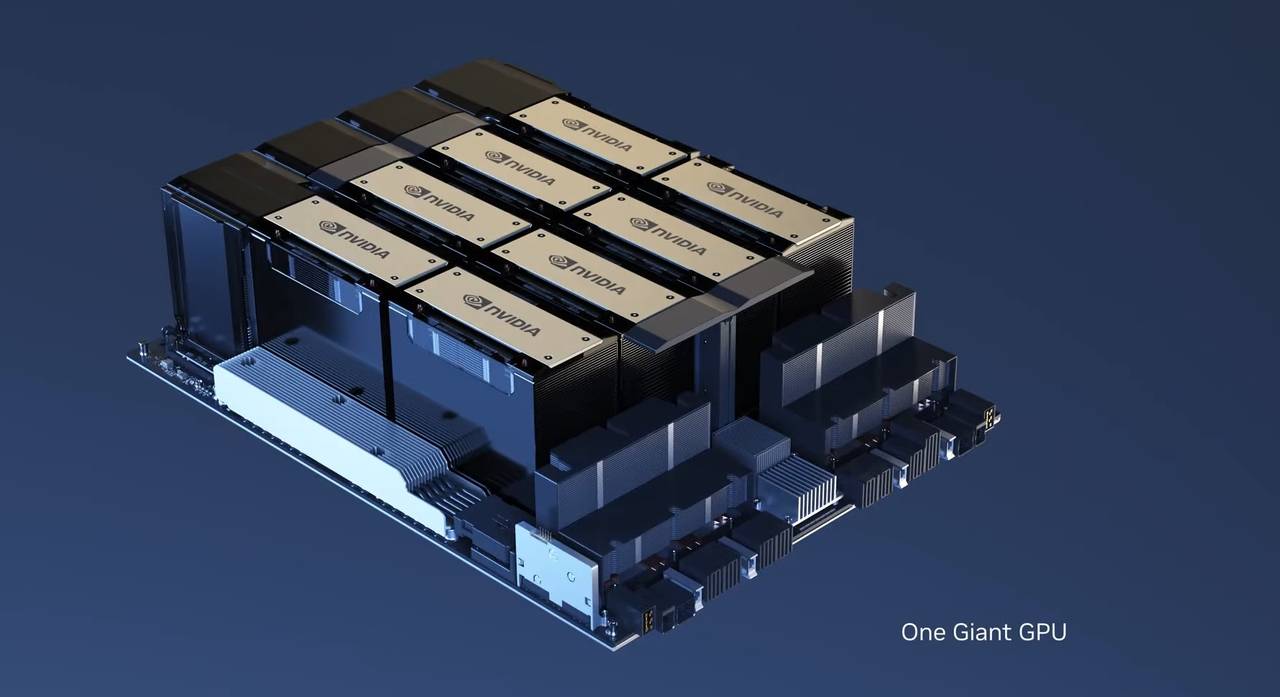

La formation de modèles de langage à grande échelle nécessite des clusters GPU dotés d'une énorme puissance de calcul, et comme le nombre d'utilisateurs augmente de façon exponentielle, leur exécution nécessitera également une puissance de calcul considérable.

Chaque entreprise qui souhaite entrer dans l'AIGC réfléchit d'abord à la manière de déployer un centre de cloud computing à grande échelle, comme si la concurrence de l'AIGC était devenue une lutte pour les ressources matérielles.

▲ Sam Altman, PDG d'OpenAI

Avec un centre de calcul doté d'une plus grande puissance de calcul, il pourra exécuter des modèles de langage et des algorithmes à plus grande échelle, et le produit final de l'IA pourrait également devenir plus "intelligent".

Cependant, dans un récent discours du PDG d'OpenAI, Sam Altman, au Massachusetts Institute of Technology, il a versé de l'eau froide sur ces retardataires qui veulent "faire des miracles avec une grande force".

Altman : la mise à l'échelle du modèle est obsolète

"L'ère des modèles à grande échelle est révolue. Nous devons utiliser de nouvelles idées et méthodes pour faire de nouveaux progrès dans l'AIGC."

L'extension de la taille du modèle, l'utilisation de paramètres plus complexes et l'appel à une plus grande puissance de calcul sont essentiellement les méthodes itératives qu'OpenAI a utilisées sur GPT ces dernières années.

GPT-2 a environ 1,5 milliard de paramètres, tandis que GPT-3 en a 175. Bien que GPT-4 n'ait pas de vérification numérique officielle, de nombreuses institutions ont émis l'hypothèse qu'il utilise des milliards de mots de texte et des dizaines de milliers d'unités. , le coût de la formation a dépassé 100 millions de dollars.

Au fur et à mesure que l'influence de ChatGPT grandissait, Microsoft a également utilisé sa technologie sous-jacente pour lancer un nouveau bing.

Par la suite, Google a lancé Bard, et Adobe a lancé Firefly.En plus de ces grandes entreprises, de nombreuses start-up bien financées de la Silicon Valley, telles que Anthropic, AI21, Cohere et Character.AI, investissent également frénétiquement pour construire à plus grande échelle. Des algorithmes pour rattraper ChatGPT et OpenAI.

▲ La piste de deuxième génération est un blockbuster généré en une phrase

L'énorme demande de ressources matérielles a également provoqué une ruée vers l'achat de GPU NVIDIA A100 et H100.

Sur eBay, le H100 de Nvidia est devenu une denrée rare, et le prix s'est envolé jusqu'à 40 000 dollars américains, alors que son prix de vente officiel n'est que de 33 000 dollars américains. De plus, le H100 est généralement conditionné avec 8 feuilles pour former un serveur à vendre.

À l'heure actuelle, il n'y a pas d'autre GPU tiers qui rivalise avec Nvidia.Sous la vague de l'IA, celui qui a plus de GPU Nvidia semble avoir la clé de la victoire dans l'industrie AIGC.

Semblable au monopole du capital et au monopole des grandes entreprises dans les industries traditionnelles, la poursuite de la puissance de calcul a également donné naissance au "monopole de la puissance de calcul".

Et Sam Altman a également déclaré qu'OpenAI n'avait pas l'intention de développer GPT-5. L'implication est que l'expansion sans cervelle de l'échelle du modèle ne permettra pas à GPT de maintenir des itérations infinies.

À l'heure actuelle, ChatGPT et le nouveau bing de Microsoft ont rencontré de nombreux temps d'arrêt et des services instables en raison d'une puissance de calcul insuffisante.

Dans le même temps, le nouveau bing n'est pas ouvert à tous les utilisateurs et la situation de "faire la queue" existe toujours.

Et c'est l'une des raisons pour lesquelles Google n'a pas été en mesure d'apporter pleinement une IA générative similaire à sa recherche.

Nick Frosst, qui a travaillé sur l'IA chez Google et est maintenant le fondateur de Cohere, a également déclaré qu'Altman était prémonitoire et a également déclaré que de nouvelles conceptions ou architectures de modèles d'intelligence artificielle pourraient être ajustées en fonction des commentaires humains.

Selon cette idée, OpenAI pourrait déjà concevoir GPT-5 avec de nouvelles idées.

Musk : braconnez des gens, achetez des cartes graphiques et formez une équipe

Même si Sam Altman a déclaré publiquement qu'il continuerait à suivre l'ancienne voie d'OpenAI à ce stade et s'améliorerait en élargissant la taille du modèle, il sera difficile de rattraper ChatGPT.

Mais Musk, qui était un vieil ami d'Altman, s'est résolument consacré à l'industrie AIGC.

Selon le Wall Street Journal, Musk a discrètement enregistré une société appelée X.AI Crop, a débauché plusieurs chercheurs de Google et a acheté des milliers de cartes graphiques à Nvidia.

Le but de Musk est très clair, c'est de concurrencer OpenAI et Google.

Juste après la publication des rapports pertinents, Musk a admis dans une interview avec Fox News qu'il souhaitait lancer un produit similaire à ChatGPT, nommé TruthGPT.

Les intentions de Musk sont claires, TruthGPT va "maximiser l'IA à la recherche de la vérité" et essayer de comprendre la nature de l'univers, en espérant apporter plus de bien que de mal.

L'interview et la réponse de Musk sont en fait un peu absurdes.Après tout, selon l'échelle du grand modèle de langage actuel, X.AI Crop n'est peut-être pas aussi bon que certaines équipes de start-up de la Silicon Valley.

Et le nom TruthGPT semble protester contre ChatGPT.

Musk a toujours cru que l'IA générative telle que GPT-4 comporterait des risques considérables, appelant à un moratoire de six mois sur le développement et appelant à l'introduction de réglementations correspondantes.

Il a même dit que "ta a le potentiel de détruire la civilisation".

C'est juste qu'en parlant de suspendre la recherche, j'ai créé X.AI Crop et j'ai commencé à entrer dans l'AIGC, difficile de ne pas croire que c'est du battage médiatique.

De plus, suspendre six mois de recherche et développement revient plus à sceller OpenAI, se donner six mois pour rattraper les progrès.

Il est indéniable que SpaceX et Tesla de Musk ont tous deux renversé une industrie et sont devenus les entreprises les plus célèbres du moment.

▲ Musc et vaisseau spatial

Mais quand il a quitté OpenAI, a vu les réalisations actuelles et a utilisé des remarques controversées, cela a montré la réticence de Musk à manquer l'occasion il y a longtemps.

Quant à savoir si TruthGPT peut faire ce qu'il a dit, nous ne pouvons attendre que six mois pour voir.

Jensen Huang : Nous avons besoin d'une application

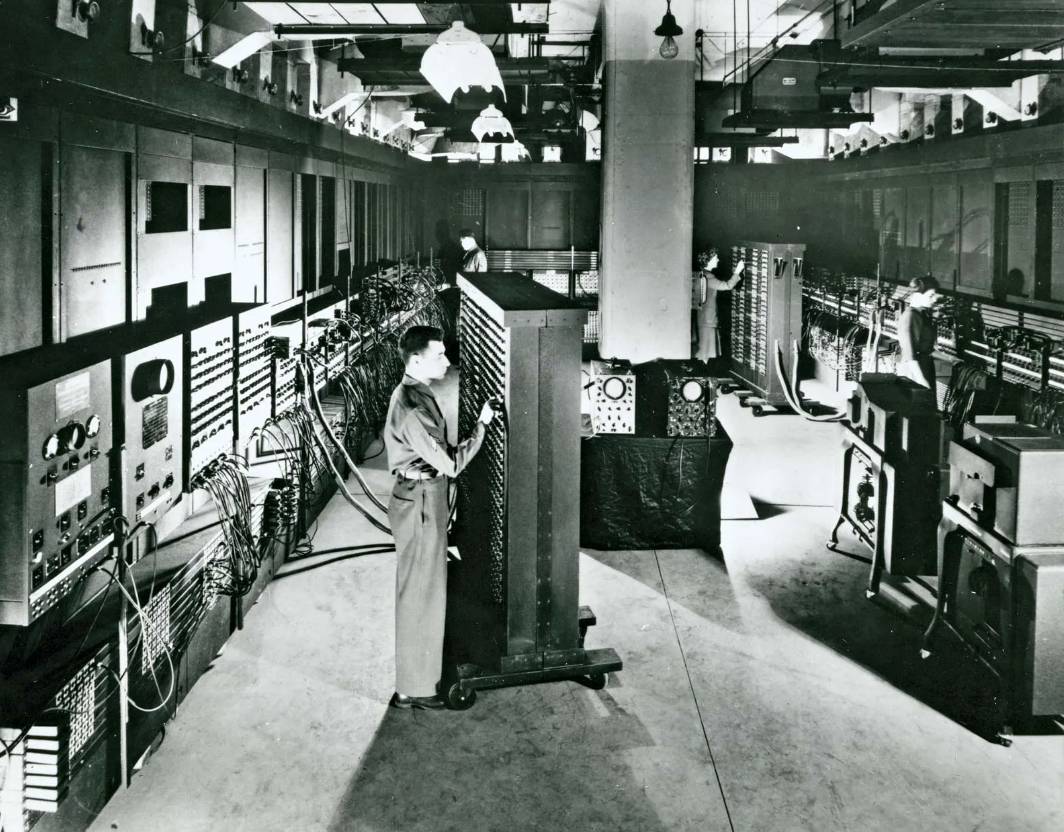

À l'heure actuelle, l'IA générative n'existe que dans les boîtes de dialogue et apparaît dans tous les appareils intelligents sous une forme très classique.

Qu'il s'agisse d'un plug-in ou d'une application tierce, ce avec quoi le public interagit à la fin est une boîte de dialogue.

![]()

C'est aussi le moyen le plus élémentaire d'interaction homme-machine lorsque les ordinateurs sont apparus pour la première fois.

Dans un podcast de Nicolai Tangen, il s'est entretenu avec le PDG de Nvidia, Huang Renxun, sur la façon dont l'IA changera la façon dont les gens vivent et travaillent.

Le développement rapide actuel de l'IA est indissociable de l'aide du GPU de Nvidia, et Nvidia a presque monopolisé le marché de la puissance du cloud computing.

Comme du point de vue d'Altman, l'IA actuelle ne peut toujours pas se débarrasser de la puissance de calcul ultra-élevée, et le modèle super-large est déjà pris en charge par d'énormes algorithmes.

C'est un défi pour les startups, mais c'est aussi vrai pour Nvidia.

Nvidia doit continuellement développer et fabriquer des GPU plus puissants pour s'adapter au développement de l'IA. Et actuellement, l'IA existe toujours dans d'énormes centres de données et nécessite plusieurs superordinateurs pour fournir une puissance de calcul.

Ce n'est pas comme n'importe quelle application ou logiciel précédent. GPT-3 a 175 milliards de paramètres. Face à un tel calcul, le GPU AI de Nvidia a été entièrement repensé.

Mais actuellement, il faut encore des semaines pour traiter des données à grande échelle et apprendre de grands modèles. Il ne peut pas encore être condensé dans une application ou un PC personnel.

En fait, cela explique également la promotion de l'IA dans les logiciels jusqu'à présent, qui existent en fait sous la forme de cloud et de plug-ins.

Nvidia a également déclaré que l'IA a commencé à pénétrer dans la conception de ses propres puces : "Lorsque l'architecte de la puce dort, l'IA continue d'itérer, d'optimiser et d'améliorer l'architecture correspondante."

"Cela peut nous aider à mieux concevoir et fabriquer des puces."

En d'autres termes, l'IA intervient dans la production de puces, et les puces produites sont utilisées dans la puissance du cloud computing pour faire fonctionner l'IA.

De plus, Huang Renxun pense également que l'IA déclenchera également la prochaine révolution industrielle, et qu'elle ne s'éveillera pas pour remplacer les humains pour le moment.

Au contraire, cela libérera grandement la main-d'œuvre et augmentera la productivité de chacun. Les gens peuvent utiliser le langage naturel pour programmer directement sans avoir à apprendre les langages compliqués Python, Java et C.

De plus, il a également pris les ingénieurs logiciels de Nvidia comme exemple : avec l'aide de l'IA, environ 40 à 50 % du code et des logiciels sont complétés par l'IA générative, et les ingénieurs n'ont qu'à fournir des suggestions et des idées.

Huang Renxun a également estimé que l'ajout de l'IA augmentera de 10 fois la productivité des ingénieurs logiciels actuels de Nvidia.

▲ Fonction copilote de Github

L'intervention de l'IA peut permettre aux gens d'accomplir de nombreuses tâches fastidieuses à une vitesse de 10 000 fois, améliorant indirectement la productivité.

Avant l'émergence de GPT-4, l'industrie de l'IA pouvait simplement compter sur l'expansion de la taille du modèle et l'augmentation du déploiement du matériel pour maintenir des itérations à grande vitesse.

Avec l'émergence de goulots d'étranglement de puissance de calcul, OpenAI a dû repenser comment optimiser et trouver la prochaine direction de développement de l'IA.

De même, Huang Renxun a également clairement réalisé que la demande actuelle d'IA en puissance de calcul est trop importante et qu'elle doit exister dans un endroit avec un espace immense et de nombreuses puces.L'IA actuelle semble être comme l'ENIAC de première génération d'ordinateurs au monde.

La prochaine étape de l'IA, tout en réduisant la demande de ressources, doit également être allégée et peut exister indépendamment dans une application ou un logiciel.

Du point de vue actuel, ce n'est pas réaliste, mais la bonne nouvelle est qu'OpenAI a commencé à recruter des ingénieurs Android et iOS, et l'application correspondante devrait bientôt arriver.

#Bienvenue pour prêter attention au compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo