Se prélassant sur des photos et bavardant, pourquoi quelqu’un pense-t-il que je vais commettre un crime ?

Des œuvres cinématographiques et télévisuelles telles que « Minority Report » et « Suspect Tracking » peuvent n'apparaître qu'au cours des dernières années. S'il s'agit d'une œuvre cinématographique et télévisuelle de ces dernières années, le public sera très « énervé ».

Prévention du crime, modèles prédictifs, utilisez le système pour spéculer sur ce qui ne s'est pas produit… Cela signifie que beaucoup d'informations seront collectées, et cela signifie également que vous serez jugé par un système inconnu s'il y a une menace. Le sentiment de confier le destin à l'inconnu, probablement peu de gens l'aiment.

Mais il n'y a peut-être aucun moyen de ne pas l'aimer, car avant que vous ne vous en rendiez compte, de plus en plus d'entreprises collectent déjà vos informations publiques pour juger de la possibilité de votre crime à partir du contenu quotidien de votre réseau social.

▲ Photo extraite de : "Rapport sur la minorité"

Les réseaux sociaux sont devenus le plus grand lanceur d'alerte. S'agit-il d'une auto-déclaration ?

Voyager, Kaseware, Aura, PredPol, Palantir, qui sont quelques entreprises qui tentent d'identifier les menaces potentielles via les réseaux sociaux, une grande partie d'entre elles coopèrent également avec la police locale et sont à la pointe de la prédiction de la criminalité.

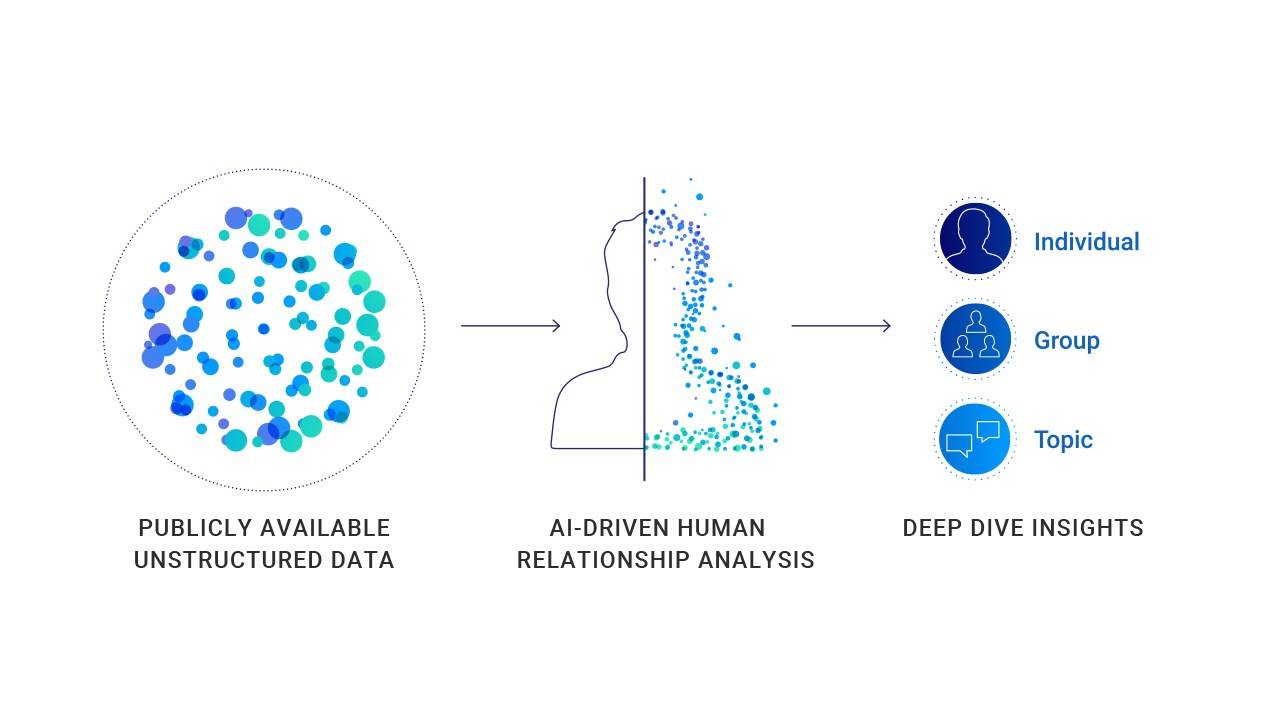

Obtenir les informations nécessaires sur les réseaux sociaux de chacun est au cœur de ce type d'entreprise, qui utilise les contenus postés par les utilisateurs sur les réseaux sociaux pour estimer si l'autre partie est susceptible de commettre un délit. Les algorithmes de ces sociétés ne sont pas les mêmes, mais ils utilisent essentiellement l'intelligence artificielle pour déchiffrer la ligne de l'utilisateur, à en juger par le contenu partagé par l'utilisateur si le sujet a commis un crime, peut commettre un crime ou adhérer à un certain danger. idéologie.

▲ Page du site officiel de Kaseware

Ce n'est en fait pas une nouveauté. Après tout, en 2012, certains ont fait des réseaux sociaux le « pulse de la ville ». Il est difficile de voir un espace et un produit pouvant accueillir autant d'utilisateurs en même temps et les rendre prêts à tout partager sur eux-mêmes.

Les caractéristiques des réseaux sociaux créent des conditions pour que les gens trouvent des objectifs. Les étudiants recherchent des personnes interrogées sur les réseaux sociaux, les agences statistiques prédisent les résultats des élections sur les réseaux sociaux et les détectives de l'IA veulent trouver des criminels sur les réseaux sociaux.

Parce que tout le monde utilise les réseaux sociaux, les réseaux sociaux peuvent souvent refléter la situation réelle d'une personne. Le représentant Tyrone Carter de l'État du Michigan aux États-Unis estime que la recherche par la police des réseaux sociaux publics n'a violé aucune loi et n'a pas enfreint les droits des utilisateurs, cette prédiction est donc réalisable.

Au moment où vous cliquez sur envoyer sur la page publique, la publication ne vous appartient plus. Les gens ont des ennuis à cause de ce qu'ils publient, parce que les médias sociaux sont le plus grand « auto-informateur » que j'aie jamais vu.

Photo de : Lifehacker

Mais le secret ne sera révélé que lorsqu'il sera guidé. Voyager Labs, qui a coopéré avec le service de police de Los Angeles, a joué le rôle de leader dans ce processus. Seule l'organisation à but non lucratif Brennan Center a découvert grâce à des informations publiques fournies par le service de police de Los Angeles que le travail de Voyager était également soupçonné de discrimination raciale et de violation de la vie privée.

La façon dont les entreprises comme Voyager fonctionnent n'est pas compliquée. Il collecte toutes les informations publiques sur les médias sociaux d'une personne, y compris les publications, les contacts et même les emojis couramment utilisés. Dans certains cas particuliers, il utilisera les informations publiques et les informations non publiques pour établir des références croisées en vue d'une analyse et d'une indexation plus approfondies.

▲ Voyager rendra des jugements basés sur des sujets personnels de participation aux médias sociaux

Grâce au service de Voyager, la police peut clairement voir les relations sociales d'une personne. Comment sont leurs connexions et comment ils interagissent sur les plateformes sociales. De plus, Voyager peut même détecter s'il existe une connexion indirecte entre deux utilisateurs (les deux ont au moins quatre amis identiques).

On dirait qu'il s'agit simplement de regarder ce que font les utilisateurs sur les réseaux sociaux, qui sont utilisés comme informations supplémentaires pour les enquêtes. Mais en fait, Voyager ne se contente pas de collecter et d'afficher des informations, il émet également des jugements.

▲ Voyager fera des jugements et des prédictions à travers la chaîne de relations des réseaux sociaux

Voyager a mentionné un cas d'agression dans un livre blanc soumis au service de police de Los Angeles. Le cas a spécifiquement démontré l'approche de la plate-forme – l'IA examinera automatiquement le contenu des messages des personnes sur les réseaux sociaux sans intervention humaine. Et la classification (respectivement marquer l'utilisateur en trois couleurs bleu, orange et rouge).

Dans un cas spécifique, Adam Alsahli, le suspect de la fusillade, a été jugé par le système comme « un fort sentiment de fierté et d'identification aux traditions arabes » en raison de ses photos à thème islamique publiées sur Facebook et Instagram. Par conséquent, Adam Alsahli a été marqué en orange par l'outil d'intelligence artificielle de Voyager avant de lancer une attaque spécifique.

Il peut s'agir d'un cas où l'on réussit à prédire les contrevenants potentiels, mais aussi d'un cas plein de « préjugés ».

Les informations sur les réseaux sociaux d'Adam Alsahli, le suspect de la fusillade, étaient marquées en orange avant qu'il ne commette le crime

Les données prédisent le crime ? Mais les données ne peuvent pas être complètement crues

Ces conclusions sont-elles vraiment crédibles ? Sur quelle base portent-ils des jugements ? Comment tout le monde peut-il prouver son innocence face au big data ?

Il existe en effet de nombreuses données confirmant la corrélation entre le biais de contenu des réseaux sociaux et les faits criminels, mais il ne s'agit pas d'une donnée de corrélation à 100%.

La Tandon School of Engineering de l'Université de New York et la School of Global Health and Public Health ont publié des résultats de recherche qui montrent que les villes avec plus de discours de haine raciale sur Twitter ont des taux de criminalité plus élevés ; des études en Finlande montrent également que, sur la base de deux décennies de données, For chaque augmentation de température de 1 °C, l'activité criminelle augmentera de 1,7 % ; des études américaines ont montré que le taux de vols de véhicules les nuits de week-end augmente fortement ; et il a été prouvé que lorsque l'équipe de football locale perd accidentellement, les incidents de violence domestique augmenter de 10 %.

▲ L'IA ne peut pas prendre de décision avec une précision de 100 %

Mais ceux-ci ne peuvent rien prouver, car la probabilité et le fait sont différents.

Même avec l'approbation de données pertinentes, cela ne peut pas prouver que dans les villes où les discours de haine raciale sont les plus nombreux, les véhicules doivent être volés les week-ends d'été. Par temps chaud, lorsque l'équipe locale perd 100 %, davantage de cas de violence domestique se produiront.

Des systèmes de prédiction de crimes similaires sont inversés sur la base de faits criminels existants et de résultats de recherche. Un autre problème que cela crée est qu'il est plein de « stéréotypes ».

Le lauréat du prix Turing, Yang Likun, a dit un jour que lorsque les données sont biaisées, les systèmes d'apprentissage automatique deviennent biaisés. Dans un seul cas, lorsque les informations reçues par l'apprentissage automatique indiquent que les utilisateurs masculins noirs en prison représentent une grande proportion, un tel système peut juger que les hommes noirs sont plus susceptibles de commettre des crimes.

▲ Yang Likun a déclaré que le biais des systèmes d'apprentissage automatique vient des personnes

Pour l'apprentissage automatique, « les hommes noirs sont plus susceptibles de commettre des crimes » peut être un fait de l'analyse des données, mais en réalité, il s'agira de préjugés raciaux et de traitement différencié.

Évaluer secrètement les utilisateurs, diviser ceux qui sont les plus menaçants, suivre et prévenir de plus près ceux qui sont menacés sont la logique de fonctionnement de l'ensemble du système.

Des startups similaires utiliseront des algorithmes et l'intelligence artificielle pour expliquer le processus qu'elles traitent et analyser les informations pour prendre des décisions. Bien qu'il n'y ait actuellement aucune preuve pour prouver que cette prédiction est efficace, et qu'il existe de nombreux doutes de la part du public, le service de police souhaite toujours coopérer avec des plateformes similaires.

▲Pour la police, le service de prévision de la plateforme est très précieux

Pour la police, ce type d'outil est très attractif : la découverte de plateformes comme Voyager sur les réseaux sociaux peut apporter une aide efficace au profilage des utilisateurs sans passer à côté des subtils indices en ligne. S'il ne s'agit que d'une enquête auxiliaire, ce sera un outil très efficace. Cependant, lorsque l'outil se développera à un stade ultérieur et commencera à jouer un rôle dans la prédiction du crime, il deviendra également une arme pour blesser.

Après l'enthousiasme des années précédentes de financement, de nombreux produits d'IA sont entrés en phase d'application. Mais dans certains domaines, ils jouent encore le rôle d'auxiliaire.

Les soins médicaux sont un domaine où l'intervention de l'IA est prudente.Même dans le domaine de l'imagerie médicale de l'IA le plus avancé, la technologie de l'IA d'aujourd'hui ne peut toujours pas garantir une précision à 100 % et nécessite l'intervention de médecins humains. Parce que tout le monde sait que les soins médicaux sont une industrie qui requiert une précision de près de 100 %. Tout écart ou erreur peut avoir des conséquences graves.

▲ À ce stade, nous aurons peut-être besoin de plus de policiers humains

Le domaine de la police est également un domaine qui s'efforce d'être correct à 100 %, et toute conjecture et inférence peut également entraîner de graves conséquences sans l'appui de preuves. Une personne qui publie diverses remarques discriminatoires et violentes sur les réseaux sociaux peut être marquée comme un auteur potentiel. Il y a 90 % de chances de commettre un crime violent, mais avant qu'il ne commette réellement un crime, c'est une personne ordinaire.

Dans l'ensemble de données global, nous ne pouvons jamais ignorer que tout le monde est un individu indépendant.

#Bienvenue pour suivre le compte WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo