Transcription de l’interview de 20 000 mots de Jen-Hsun Huang : J’espère que Nvidia aura 50 000 employés et 100 millions d’assistants IA

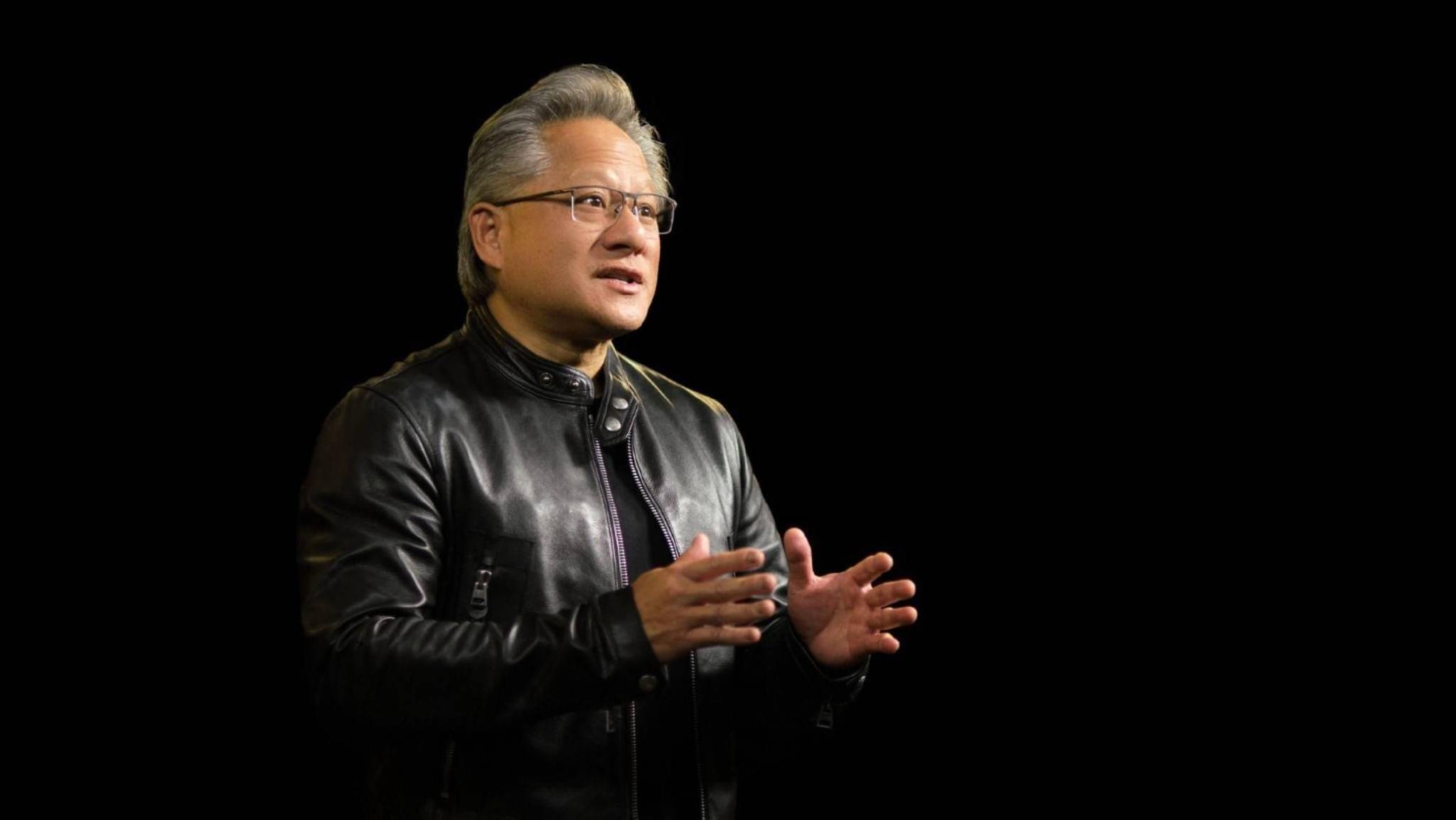

Le PDG de NVIDIA, Jen-Hsun Huang, a récemment visité le dialogue bihebdomadaire « Open Source » et a discuté avec Brad Gerstner et Clark Tang, partenaire d'Altimeter, du thème de la promotion du développement de l'intelligence vers l'intelligence artificielle générale (AGI) .

Ayant été profondément impliqué dans le domaine de l’IA et de l’apprentissage automatique depuis de nombreuses années, l’évaluation de Huang Renxun de l’état actuel et des perspectives de développement de l’IA est juste : il s’agit d’une révolution complète.

Le raisonnement connaît une croissance explosive, la demande de modèles open source est en plein essor et une infrastructure d'IA entièrement compatible est constamment mise en œuvre… À l'ère de la popularité de l'IA, Huang Renxun a une idée audacieuse, espérant que NVIDIA comptera 50 000 employés et 100 millions d’assistants IA dans le futur.

En ce qui concerne les barrières concurrentielles et le positionnement de NVIDIA dans le monde actuel de l'IA, Huang Jen-Hsun est très confiant dans ses propres avantages et a des ambitions considérables : NVIDIA est le meilleur en matière d'algorithmes, et notre mission est de construire une IA omniprésente pour le nouveau monde. plateforme informatique.

Bien entendu, contrairement à la compétition pour les parts de marché, cette ambition ne concerne que « l’exploitation ».

Dans une interview qui a duré près d'une heure et demie, Huang a donné une analyse approfondie de la manière dont l'apprentissage automatique remodèle le monde informatique, de la manière dont l'IA provoque une révolution technologique sans précédent et, finalement, déclenche une énorme vague de révolution. De plus, des sujets tels que la sécurité de l’IA et les controverses open source sont également abordés.

Sous la veste en cuir apparemment froide se cache l'intention originale passionnée de Huang Renxun pour le domaine de l'IA : je prendrai au sérieux mon travail, mes responsabilités, ma contribution sociale et l'époque dans laquelle nous vivons.

La densité d'informations de cette interview est assez élevée et la discussion sur l'industrie de l'IA est d'une profondeur sans précédent.

Lien vidéo original de l’interview :

Nous résumons brièvement les principaux points de Huang Jenxun dans cette interview, comme suit :

- Les assistants personnels d’IA apparaîtront bientôt et continueront d’évoluer au fil du temps ;

- Nous sommes passés de la programmation humaine à l'apprentissage automatique, avec une innovation et une croissance qui se produisent dans l'ensemble de la pile technologique ;

- Promouvoir l’évolution accélérée de l’IA nécessite d’accélérer chaque partie du « volant d’inertie » ;

- L’avenir de l’informatique (développement d’applications) dépendra fortement de l’apprentissage automatique et de l’IA, et il y aura des agents pour aider les humains à utiliser ces applications ;

- L’IA ne remplacera pas les emplois, elle les transformera et aura un impact profond sur la façon dont les gens perçoivent le travail ;

- La sécurité de l’IA constitue le fondement. Elle ne nécessite pas nécessairement une législation distincte pour chaque technologie importante, et elle ne permet pas non plus d’étendre excessivement la réglementation à des domaines inutiles ;

- Il doit y avoir un modèle open source pour promouvoir la création de l’IA. L’open source est nécessaire à l’activation de nombreuses industries ;

Voici le texte intégral de l’entretien compilé par APPSO :

Passer de la programmation humaine à l’apprentissage automatique

Brad Gerstner : Nous sommes le vendredi 4 octobre et nous sommes au siège de Nvidia, juste en bas de la rue d'Altimeter. Nous tiendrons notre réunion annuelle des investisseurs lundi pour discuter de tous les impacts de l’IA et de nos progrès sur la rapidité avec laquelle nous pouvons faire évoluer l’intelligence.

Je ne peux vraiment pas penser à une meilleure personne avec qui entamer cette conversation que vous, à la fois en tant qu'actionnaire et en tant que partenaire intellectuel, et rebondir sur des idées avec vous nous rend toujours plus intelligents. Nous sommes reconnaissants pour cette amitié, alors merci de votre visite.

Jen-Hsun Huang : Je suis heureuse d'être ici.

Brad Gerstner : Le thème de cette année est Étendre l’intelligence à l’intelligence artificielle générale (AGI).

Ce qui est choquant, c'est que lorsque nous avons fait cela il y a deux ans, le thème était l'ère de l'IA, et c'était deux mois avant la sortie de ChatGPT. C'est vraiment surprenant de penser à tous ces changements. J’ai donc pensé que nous pourrions commencer par une expérience de pensée et peut-être faire une prédiction.

Si je comprends l'intelligence artificielle générale (AGI) simplement comme un assistant personnel dans ma poche, telle que je la comprends, elle sait tout de moi, a une mémoire parfaite de moi, peut communiquer avec moi, peut me réserver un hôtel, et même pris rendez-vous chez le médecin pour moi. À votre avis, le monde évolue si vite aujourd’hui, quand pensez-vous que nous pourrons avoir ce genre d’assistant personnel dans notre poche ?

Jensen Huang : Cela arrivera bientôt sous une forme ou une autre. Cet assistant s'améliore de plus en plus avec le temps. C’est la beauté de la technologie telle que nous la connaissons. Je pense donc que cela va être très utile au début, mais ce n'est pas parfait. Et puis avec le temps, ça va de mieux en mieux. Comme toute technologie.

Brad Gerstner : Lorsque nous regardons le taux de changement, je me souviens qu'Elon disait que la seule chose qui compte est le taux de changement. Nous pensons que le rythme du changement s'est considérablement accéléré, c'est le rythme de changement le plus rapide que nous ayons jamais vu sur ces questions, car nous travaillons dans le domaine de l'IA depuis environ une décennie et vous travaillez encore plus longtemps. Est-ce le rythme de changement le plus rapide que vous ayez jamais vu dans votre carrière ?

Jensen Huang : Oui, parce que nous avons réinventé l'informatique. Ces changements sont en grande partie dus au fait que nous avons réduit le coût marginal de l'informatique d'un facteur 100 000 au cours des 10 dernières années. Si l'on calcule selon la loi de Moore, ce processus représente une amélioration d'environ 100 fois, mais nous avons réalisé bien plus que cela. Nous y parvenons de plusieurs manières.

Tout d’abord, nous avons introduit le calcul accéléré pour transférer le travail qui n’est pas efficace sur le CPU vers le GPU.

Deuxièmement, nous avons inventé une nouvelle précision numérique, développé de nouvelles architectures, conçu des cœurs d'intégration, amélioré la façon dont les systèmes sont construits, MVLink a ajouté une mémoire ultra-rapide (HBM) et implémenté une expansion full-stack via MVLink et InfiniBand. Fondamentalement, tous les détails que j'ai décrits sur la façon dont Nvidia fait les choses contribuent à un taux d'innovation qui dépasse la loi de Moore .

Ce qui est vraiment étonnant, c'est que grâce à cela, nous sommes passés de la programmation humaine à l'apprentissage automatique.

Et le plus surprenant à propos de l’apprentissage automatique, c’est qu’il s’avère qu’il apprend très rapidement. Ainsi, à mesure que nous redéfinissons la façon dont le calcul est distribué, nous avons de nombreuses formes de traitement parallèle : le parallélisme tensoriel, le parallélisme pipeline et toutes sortes de méthodes de calcul parallèle. Nous avons inventé de nouveaux algorithmes et développé de nouvelles méthodes de formation sur cette base. Toutes ces inventions ont eu un effet cumulatif les unes sur les autres.

À l’époque, si vous regardez comment fonctionnait la loi de Moore, les logiciels étaient statiques. Il est conçu pour exister de manière statique comme un produit packagé, tandis que le matériel évolue au rythme de la loi de Moore. Aujourd’hui, l’ensemble de notre pile technologique se développe et l’ensemble de la pile innove. Je pense que c’est le statu quo.

Tout d’un coup, nous assistons à une expansion incroyable et, bien sûr, à un changement extraordinaire. Mais ce dont nous parlions auparavant, c'était des modèles pré-entraînés et de la mise à l'échelle à ce niveau, comment en doublant la taille du modèle, on doublait également de manière appropriée la quantité de données.

La puissance de calcul nécessaire est donc multipliée par quatre chaque année. C'était une grosse affaire à l'époque. Mais maintenant, nous constatons une expansion dans la phase post-formation, nous constatons également une expansion dans la phase d'inférence, n'est-ce pas ? Les gens pensaient que la pré-formation était difficile et que la déduction était relativement facile.

L’idée selon laquelle tout est plus difficile aujourd’hui est en réalité raisonnable, car il serait absurde de réduire toute la pensée humaine à un processus ponctuel. Par conséquent, des concepts tels que la pensée rapide et la pensée lente, le raisonnement, la réflexion, l'itération, la simulation, etc. doivent exister dans la pensée, et maintenant ces concepts sont progressivement intégrés.

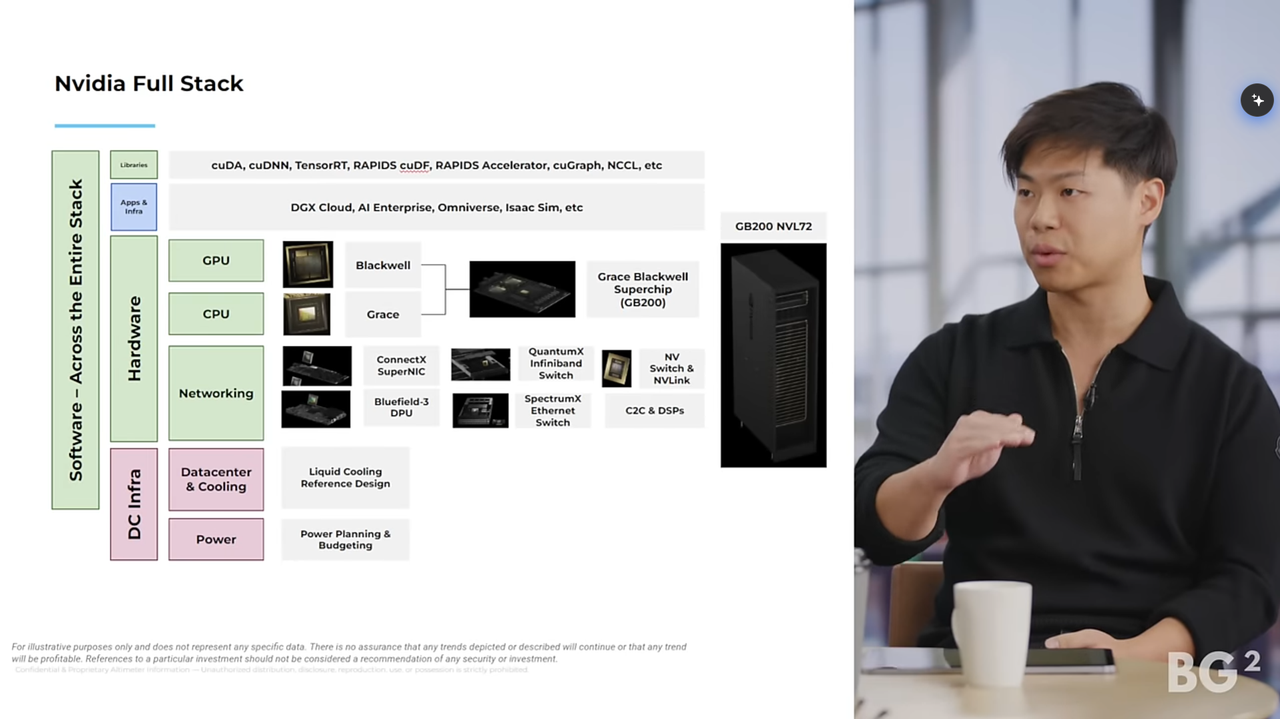

Clark Tang : Je pense que l'une des choses les plus mal comprises à propos de Nvidia à ce stade est le véritable avantage technologique de Nvidia, n'est-ce pas ? Je pense qu'il existe une perception selon laquelle une fois que quelqu'un invente une nouvelle puce ou une meilleure puce, il a gagné.

Mais le fait est que vous avez construit l'ensemble de la pile technologique au cours de la dernière décennie, des GPU aux CPU en passant par les réseaux, en particulier les logiciels et les bibliothèques qui permettent aux applications de s'exécuter sur les plates-formes NVIDIA. Pensez-vous que l’avantage technologique de Nvidia est plus grand ou plus faible aujourd’hui qu’il ne l’était il y a trois ou quatre ans ?

Jensen Huang : J'apprécie que vous soyez conscient du fait que l'informatique a changé. En fait, la raison pour laquelle les gens pensaient (et beaucoup pensent encore) qu'il suffirait de concevoir une meilleure puce était parce qu'elle avait plus de flotteurs, plus de flips, d'octets et de bits, vous voyez ce que je veux dire ? Si vous regardez leurs diapositives principales, elles regorgent d'opérations de retournement et de virgule flottante, ainsi que de divers graphiques à barres, graphiques, etc.

Tout cela est bon, je veux dire, bien sûr, les performances comptent, donc celles-ci comptent fondamentalement. Malheureusement, il s’agit là d’une vieille façon de penser. Parce qu'à l'époque, le logiciel n'était qu'une application fonctionnant sous Windows, le logiciel était statique, ce qui signifiait que la meilleure façon d'améliorer votre système était de créer des puces de plus en plus rapides.

Mais nous sommes conscients que l’apprentissage automatique n’est pas une programmation humaine. L’apprentissage automatique ne concerne pas seulement les logiciels, il concerne l’ensemble du chemin des données. En fait, le volant d’inertie au cœur de l’apprentissage automatique est la chose la plus importante. Alors, comment pensez-vous permettre aux data scientists et aux chercheurs de travailler efficacement au sein de ce volant d’inertie tout en le faisant avancer ? Et ce volant d’inertie démarre dès les premiers stades.

Beaucoup de gens ne réalisent même pas qu’une IA est réellement nécessaire pour organiser les données afin d’enseigner à une autre IA. Et l’IA elle-même est déjà assez complexe.

▲Les assistants personnels d'IA apparaîtront bientôt d'une manière ou d'une autre (Source : NITCO)

Accélérez chaque pas du volant

Brad Gerstner : Alors, est-ce que ça s'améliore ? Est-ce que ça accélère aussi ? Vous savez, quand nous pensons à nouveau à l’avantage concurrentiel, n’est-ce pas ? C'est vraiment l'effet combiné de tous ces facteurs.

Jen-Hsun Huang : Tout à fait raison, précisément grâce à une IA plus intelligente pour organiser les données, nous disposons désormais même de la génération de données synthétiques et de diverses manières différentes d'organiser et de présenter les données. Ainsi, avant de suivre une formation, de nombreux traitements de données sont déjà nécessaires. Et les gens considèrent toujours PyTorch comme le début et la fin du monde entier.

C'est vraiment important, mais n'oubliez pas qu'il y a beaucoup de travail avant d'utiliser PyTorch, et qu'il y a beaucoup de travail après avoir utilisé PyTorch. Et l’idée d’un volant d’inertie est en fait la façon dont vous devriez y penser. Vous savez, comment devrais-je penser à tout ce volant d'inertie ? Comment puis-je concevoir un système informatique, une architecture informatique, qui vous aide à faire fonctionner ce volant d'inertie aussi efficacement que possible ? Il ne s’agit pas d’une seule étape dans l’application de la formation, n’est-ce pas ? Ce n'est qu'une étape, d'accord ?

Chaque étape du volant d'inertie est difficile, donc la première chose à laquelle vous devriez penser n'est pas de savoir comment faire fonctionner Excel plus rapidement, ou comment faire fonctionner Doom plus rapidement, c'est l'ancienne façon de faire les choses, n'est-ce pas ?

Il ne vous reste plus qu’à penser à comment rendre ce volant d’inertie plus rapide. Et il y a beaucoup d'étapes différentes dans ce volant, et comme vous le savez, rien dans l'apprentissage automatique n'est simple, et rien n'est simple dans ce que fait OpenAI, ou ce que fait X, ou ce que font l'équipe Gemini et DeepMind.

Nous avons donc décidé que c'était à cela que vous devriez vraiment penser. C'est tout le processus et vous devez accélérer chaque partie. Vous devez respecter la loi d'Amdahl. La loi d'Amdahl vous dira que si cette partie prend 30% du temps et que je l'accélère 3 fois, je n'accélère pas vraiment tout le processus, compris ?

Vous devez vraiment créer un système qui accélère chaque étape, et ce n'est qu'en accélérant l'ensemble du processus que vous pourrez réellement améliorer ce temps de cycle de manière significative, et ce volant d'inertie du taux d'apprentissage est en fin de compte ce qui conduit à une croissance exponentielle.

Ce que je dis, c'est que le point de vue d'une entreprise se reflète réellement dans ses produits. Remarquez que je continue de parler de ce volant d'inertie.

Clark Tang : Vous voulez dire le cycle entier.

Jensen Huang : C’est vrai, et nous accélérons tout maintenant. L'accent principal est désormais mis sur la vidéo. Beaucoup de gens se concentrent sur l’IA physique et le traitement vidéo. Pensez simplement au front-end : des téraoctets de données entrent dans le système chaque seconde. Donnez-moi un exemple de la façon dont fonctionne le pipeline de traitement de ces données, de l'ingestion des données à la préparation à la formation, et tout cela est accéléré par CUDA.

Clark Tang : Aujourd'hui, les gens ne pensent qu'aux modèles de texte, mais à l'avenir, cela inclura également des modèles vidéo et utilisera également certains modèles de texte, tels que o1, pour traiter une grande quantité de données avant de commencer le traitement.

Jen-Hsun Huang : Les modèles linguistiques concerneront tous les domaines. L'industrie consacre beaucoup de technologie et d'efforts à la formation de modèles linguistiques pour former ces grands modèles linguistiques. Nous utilisons désormais un coût de calcul inférieur à chaque étape. C'est vraiment remarquable.

Brad Gerstner : Je ne veux pas trop simplifier les choses, mais c'est une question que nous entendons beaucoup de la part des investisseurs, n'est-ce pas ? Oui, mais qu’en est-il des puces personnalisées ? Oui, mais leurs barrières concurrentielles seront-elles ainsi détruites ?

Ce que je vous entends dire, c'est que dans ce système combiné, les avantages augmentent avec le temps. Je vous entends donc dire que nous sommes plus avantagés aujourd’hui qu’il y a trois ou quatre ans parce que nous améliorons chaque élément. Et cet effet de combinaison signifie, vous savez, en tant qu’étude de cas, qu’Intel dominait autrefois la pile technologique, et où en êtes-vous aujourd’hui par rapport à eux ?

Peut-être juste un bref résumé et comparez votre avantage concurrentiel d’aujourd’hui à ce qu’il était à son apogée.

Jensen Huang : Intel est extraordinaire. Intel est extraordinaire car ils ont probablement été la première entreprise à être extrêmement douée en matière d'ingénierie et de production de processus de fabrication, et la prochaine étape au-delà du processus de fabrication est la conception de puces, n'est-ce pas ? Ils ont conçu les puces, construit l’architecture x86 et continuent de fabriquer des puces x86 plus rapides. C'est leur intelligence. Ils combinent cela avec des processus de fabrication.

Notre entreprise est un peu différente car nous reconnaissons que le traitement parallèle ne nécessite pas, en fait, que chaque transistor soit parfait. Le traitement en série nécessite que chaque transistor soit parfait, tandis que le traitement en parallèle nécessite un grand nombre de transistors pour obtenir une plus grande rentabilité.

Je préfère avoir 10 fois plus de transistors et être 20 % plus lent que d'avoir 10 fois moins de transistors et être 20 % plus rapide. Est-ce que tu comprends? Ils préfèrent le contraire, donc les performances et le traitement monothread sont très différents du traitement parallèle. Nous réalisons donc que notre monde n’a pas pour objectif de s’améliorer. Nous voulons être aussi bons que possible, mais ce qui compte vraiment pour notre monde, c'est de s'améliorer.

Calcul parallèle, le traitement parallèle est difficile car chaque algorithme doit être refactorisé et repensé de différentes manières en fonction de l'architecture. Ce que les gens ne réalisent pas, c'est que vous pouvez avoir trois processeurs différents, chacun avec son propre compilateur C, et que vous pouvez compiler des logiciels sur l'ISA (architecture de jeu d'instructions) correspondante. Cela n’est pas possible en calcul accéléré, ni en calcul parallèle.

L'entreprise qui a développé l'architecture a dû développer son propre OpenGL. Nous avons donc révolutionné l’apprentissage profond grâce à une bibliothèque spécifique à un domaine appelée CUDNN. Sans CUDNN, il n’y aurait pas d’apprentissage profond aujourd’hui.

Personne ne parle de CUDNN car c'est une couche sous PyTorch et TensorFlow. Au début, il y avait Caffe et Theano, maintenant il y a Triton, et il existe de nombreux frameworks différents. Cette bibliothèque spécifique à un domaine, comme CUDNN, et Optics, une bibliothèque spécifique à un domaine appelée CuQuantum, Rapids et bien d'autres.

Brad Gerstner : Les algorithmes spécifiques à l'industrie se trouvent sous cette couche PyTorch sur laquelle tout le monde se concentre. Par exemple, j'entends souvent les gens dire que s'il n'y avait pas ces bibliothèques sous-jacentes…

Jensen Huang : Si nous ne l'avions pas inventé, aucune des applications de haut niveau ne pourrait fonctionner. Comprenez-vous ce que je dis ? Mathématiquement parlant, NVIDIA est vraiment bon dans les algorithmes, qui combinent une science de haut niveau et une architecture de niveau inférieur.

▲Huang Renxun en interview

Nous sommes entrés dans l'ère du raisonnement

Clark Tang : Désormais, toute l’attention est enfin portée sur le raisonnement. Mais je me souviens qu'il y a deux ans, Brad et moi avons dîné avec vous et nous vous avons posé une question : pensez-vous que l'avantage technologique de Nvidia sera aussi fort en inférence qu'en formation ?

Jensen Huang : J'ai définitivement dit que ce serait plus fort.

Clark Tang : Vous venez de mentionner de nombreux facteurs, tels que les combinaisons modulaires et différentes combinaisons d'assemblages, que nous ne comprenons parfois pas complètement. Il est important que les clients aient la possibilité de basculer entre ces deux options. Mais pouvez-vous en parler un peu plus maintenant que nous sommes entrés dans l’ère du raisonnement ?

Jen-Hsun Huang : Le raisonnement est un entraînement au raisonnement à grande échelle, n'est-ce pas ? Donc, si vous vous entraînez bien, il y a de fortes chances que votre raisonnement le soit aussi. Si vous vous entraînez sur cette architecture sans aucun ajustement, il pourra fonctionner sur cette architecture.

Bien sûr, vous pouvez toujours optimiser pour d'autres architectures, mais au moins, comme il est déjà construit sur l'architecture de NVIDIA, il fonctionnera sur l'architecture de NVIDIA.

L’autre aspect, bien entendu, est celui des investissements en capital. Lorsque vous entraînez un nouveau modèle, vous souhaiterez utiliser l’équipement d’entraînement le plus récent et le plus performant, qui laissera derrière lui l’équipement qui a été utilisé auparavant. Et ces appareils sont parfaits pour l’inférence. Par conséquent, il y aura un chemin d’accès libre aux appareils.

Derrière la nouvelle infrastructure se trouve une chaîne de périphériques d'infrastructure gratuits compatibles CUDA. Nous sommes donc très rigoureux pour assurer la compatibilité tout au long du processus afin que les équipements que nous laissons derrière nous puissent toujours conserver d'excellentes performances.

Parallèlement, nous avons également investi beaucoup d'énergie dans la réinvention constante de nouveaux algorithmes pour garantir que le moment venu, les performances de l'architecture Hopper seront 2 à 4 fois supérieures à celles de son premier achat, afin que l'infrastructure peut continuer à rester efficace.

Ainsi, tout le travail que nous effectuons en termes d'amélioration de nouveaux algorithmes, de nouveaux frameworks, aide non seulement chacune de nos infrastructures installées, Hopper est meilleur pour cela, Ampere est meilleur pour cela, et même Volt est meilleur pour cela.

Je me souviens que Sam vient de me dire qu'ils avaient récemment retiré leur infrastructure Volt d'OpenAI. Donc, je pense qu'on laisse des traces de ces infrastructures installées. Comme pour toute infrastructure informatique, il est important d’installer l’infrastructure.

Les produits NVIDIA sont présents dans tous les cloud, sur site et jusqu'aux appareils de périphérie. Par conséquent, le modèle de langage visuel Vela créé dans le cloud peut parfaitement fonctionner sur le robot Edge sans modification. À la base de tout cela se trouve CUDA. Je pense donc que la notion de compatibilité architecturale est très importante pour les grands projets. Ce n’est pas différent du concept de compatibilité pour les iPhones ou autres appareils.

Je pense que l'installation d'une infrastructure est très importante pour l'inférence, mais ce dont nous bénéficions réellement, c'est que parce que nous entraînons ces grands modèles de langage sur de nouvelles architectures, nous sommes en mesure de réfléchir à la manière de créer de très bonnes architectures d'inférence à l'avenir.

Nous avons donc réfléchi aux modèles itératifs et aux modèles d'inférence, à la manière de créer une expérience d'inférence très interactive pour votre agent personnel, par exemple à la manière d'interagir rapidement avec vous lorsqu'il a besoin de s'arrêter et de réfléchir un moment.

Alors, comment y parvenir ? La réponse est NVLink. Vous savez, NVLink nous permet d'utiliser ces systèmes adaptés à la formation, mais une fois la formation terminée, ses performances d'inférence sont également très bonnes. Ce que vous souhaitez optimiser, c'est le temps de réponse pour le premier jeton, et atteindre le temps de réponse pour le premier jeton est très difficile car cela nécessite beaucoup de bande passante.

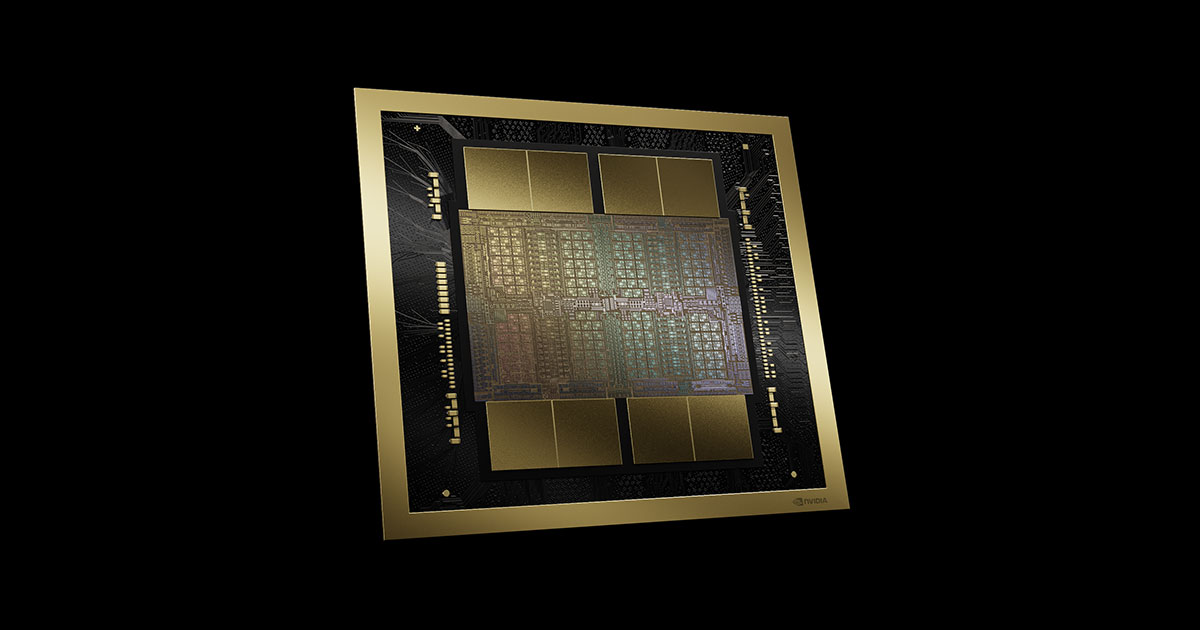

Si votre contexte est également très riche, alors vous avez également besoin de beaucoup de puissance de calcul. Vous avez donc besoin à la fois d’une bande passante et d’une puissance de calcul illimitées pour obtenir un temps de réponse de quelques millisecondes. Et ce genre d’architecture est très difficile à mettre en œuvre. C'est pour cette raison que nous avons inventé Grace Blackwell NVLink.

▲Architecture NVIDIA Blackwell (Source : NVIDIA)

NVIDIA construit une infrastructure d'IA complète et conforme

Brad Gerstner : Vous savez, j'ai dîné avec Andy Jassy plus tôt cette semaine, et Andy a dit : "Nous avons Tranium et Inferencia à venir." Je pense que la plupart des gens pensent encore que cela constitue un défi pour Nvidia.

Mais il a ensuite déclaré : "Nvidia est un partenaire très important pour nous, et continuera à l'être à l'avenir, du moins dans l'avenir que je peux prévoir."

Le monde fonctionne sur NVIDIA, n'est-ce pas ? Ainsi, lorsque vous pensez à ces ASIC personnalisés développés pour des applications spécifiques, comme les accélérateurs d'inférence de Meta, ou Tranium d'Amazon, ou les TPU de Google, et aux pénuries d'approvisionnement auxquelles vous êtes actuellement confrontés, ces facteurs changent la dynamique entre vous, ou sont-ils simplement en train de changer. complémentaire à votre système ?

Jensen Huang : Nous faisons simplement des choses différentes, nous essayons d'atteindre des objectifs différents. NVIDIA essaie de construire une plate-forme informatique pour ce nouveau monde, ce monde de l'apprentissage automatique, ce monde de l'IA générative, ce monde de l'IA agent.

Ce que nous voulons créer, c'est qu'après 60 ans d'informatique, nous ayons réinventé toute la pile informatique, de la manière de programmer à l'apprentissage automatique, de la manière dont les logiciels sont traités, des CPU aux GPU, de la façon dont les logiciels sont appliqués à l'intelligence artificielle, droite? Outils logiciels, intelligence artificielle : chaque aspect de la pile informatique, chaque aspect de la pile technologique a changé.

Ce que nous voulons, c'est créer une plateforme informatique omniprésente, et c'est là que réside véritablement la complexité de notre travail. Si vous réfléchissez à ce que nous faisons, nous construisons une infrastructure complète d’IA, et nous la considérons comme un ordinateur.

J'ai déjà dit que le centre de données est désormais l'unité fondamentale de l'informatique. Pour moi, quand je pense à un ordinateur, je ne pense pas à la puce, je pense au concept : c'est mon modèle mental, avec tous les logiciels, toute la programmation, toutes les pièces mécaniques. C'est ma mission, c'est mon ordinateur, et nous essayons de construire un tout nouvel ordinateur chaque année.

Ouais, c'est fou, personne n'a fait ça auparavant. Chaque année, nous essayons de construire un tout nouvel ordinateur et chaque année, nous apportons des améliorations de performances deux à trois fois supérieures. Chaque année, nous réduisons nos coûts de deux à trois fois et chaque année nous améliorons notre efficacité énergétique de deux à trois fois.

Nous disons donc à nos clients de ne pas acheter tout l'équipement en même temps, mais d'en acheter un peu chaque année, d'accord ? La raison en est que nous voulons qu’ils puissent évoluer vers un futur où toutes les architectures seront compatibles, d’accord ?

Maintenant, construire cette plate-forme à ce rythme est très difficile, et ce qui est doublement difficile, c'est que nous ne nous contentons pas de vendre des infrastructures ou des services, nous les démontons et les intégrons dans GCP, puis dans AWS, intégrés dans Azure. , intégré à d’autres plateformes, vous savez ?

L'intégration est différente pour chaque plateforme. Nous devons intégrer toutes les bibliothèques architecturales, tous les algorithmes et tous les frameworks dans leurs systèmes. Nous intégrons nos systèmes de sécurité dans leurs systèmes, nous intégrons nos réseaux dans leurs systèmes, n'est-ce pas ? Et puis nous effectuons environ 10 de ces intégrations par an. Et c’est là que réside la magie.

Brad Gerstner : C'est ça la magie, pourquoi ? Je veux dire, c'est fou. C’est vraiment fou que tu fasses ça chaque année. Pensez-y, qu’est-ce qui vous pousse à faire cela chaque année ?

Et pour en revenir à cela, vous savez, Clark vient de rentrer de Taiwan, de Corée et du Japon et a rencontré tous vos partenaires fournisseurs – ceux avec lesquels vous entretenez des relations depuis plus de dix ans. Quelle est l’importance de ces partenariats pour l’effet combiné de la construction de cette barrière concurrentielle ?

Jen-Hsun Huang : Oui, quand on le décompose systématiquement, et plus on le décompose, il est surprenant de voir à quel point l'ensemble de l'écosystème de l'industrie électronique s'engage à travailler avec nous aujourd'hui pour finalement construire ce cube d'ordinateur et l'assembler en tous les différents écosystèmes ? Et la coordination est si transparente. De toute évidence, nous avons transmis l'API, la méthodologie, les processus métier et les règles de conception en arrière, et avons transmis la méthodologie, l'architecture et l'API en avant.

Brad Gerstner : Ceux-ci sont fortifiés depuis des décennies.

Jen-Hsun Huang : Elle s'est renforcée depuis des décennies, et elle est aussi en constante évolution. Mais ces API doivent être intégrées lorsque cela est nécessaire : tous ces éléments fabriqués à Taiwan et dans le monde finissent dans les centres de données Azure. Ils s'emboîteront.

Clark Tang : Quelqu'un appelle simplement l'API OpenAI et cela fonctionne.

Jen -Hsun Huang : Oui, c'est totalement ce sentiment de folie. C’est ce que nous avons inventé, nous avons inventé cette infrastructure informatique massive, et le monde entier la construit avec nous.

Il est intégré à tout, vous pouvez le vendre via Dell, vous pouvez le vendre via HPE, il est hébergé dans le cloud et s'étend aux appareils de pointe. Les gens l'utilisent désormais dans des systèmes robotiques, ils l'utilisent dans des robots humanoïdes, ils l'utilisent dans des voitures autonomes, ils sont tous compatibles sur le plan architectural, ce qui est vraiment fou.

Clark, je ne veux pas que tu penses que je n'ai pas répondu à ta question. En fait, j'ai répondu. Ce à quoi je fais référence concerne votre ASIC.

En tant qu'entreprise, nous faisons simplement des choses différentes. En tant qu’entreprise, nous souhaitons avoir une compréhension claire de l’environnement. Je suis très conscient de tout ce qui entoure notre entreprise et son écosystème, n'est-ce pas ?

Je connais tous les gens qui font des choses différentes et ce qu'ils font. Parfois, c'est une confrontation pour nous, parfois non. Je le sais très bien. Mais cela ne change rien aux objectifs de notre entreprise. Le seul objectif de l’entreprise est de construire une plateforme architecturale pouvant être utilisée partout, et c’est notre objectif.

Nous n’essayons pas de prendre des parts de marché à qui que ce soit. NVIDIA est un pionnier du marché, pas un concurrent en termes de parts de marché. Si vous regardez nos rapports d'entreprise, vous verrez que nous ne parlons jamais de part de marché. Il n'y a jamais un jour où nous parlons de part de marché au sein de l'entreprise.

Toutes nos discussions portaient sur la manière de créer la prochaine chose ? Comment résoudre le prochain problème du volant d’inertie ? Comment pouvons-nous faire mieux pour les gens ? Comment réduire un cycle de volant d’inertie qui prenait auparavant un an à seulement un mois ? Vous savez, c'est la vitesse de la lumière pour un volant d'inertie, n'est-ce pas ? Nous réfléchissons à toutes ces différentes questions, mais une chose est sûre, nous sommes conscients de tout ce qui nous entoure, mais nous sommes très clairs sur notre mission.

La seule question est de savoir si cette mission est nécessaire et significative. Toutes les grandes entreprises devraient avoir cette mission.

Fondamentalement, la question est : que faites-vous ? La seule question est : est-ce nécessaire, est-ce utile, a-t-il un impact et peut-il aider les autres ? Je suis presque sûr que si vous êtes un développeur, une startup d'IA générative et que vous décidez comment devenir une entreprise, le seul choix que vous n'avez pas à considérer est de savoir quel ASIC prendre en charge.

Si vous ne prenez en charge que CUDA, vous pouvez l'utiliser n'importe où et vous pourrez toujours changer d'avis plus tard, mais nous sommes le point d'entrée dans le monde de l'IA, n'est-ce pas ? Une fois que vous décidez de rejoindre notre plateforme, d'autres décisions peuvent être reportées et vous pourrez toujours développer votre propre ASIC plus tard, et cela ne nous dérange pas.

Lorsque je travaille avec GCP, des entreprises comme GCP, Azure, nous leur montrons notre feuille de route des années à l'avance. Ils ne vont pas nous montrer leur feuille de route ASIC et cela ne va pas nous offenser, d'accord ? Si vos objectifs sont clairs et significatifs et que votre mission est importante pour vous-même et pour les autres, vous pouvez être transparent.

A noter que ma feuille de route est publique sur GTC, tandis que ma feuille de route sera plus approfondie avec des partenaires comme Azure, AWS, etc. Nous n'avons aucune difficulté avec ceux-ci, même s'ils développent leurs propres ASIC.

▲La mission de NVIDIA est de construire une infrastructure d'IA complète et compatible (Source : The Brand Hopper)

L'IA change l'avenir de l'industrie

Brad Gerstner : Je pense que lorsque les gens regardent l'industrie, vous avez dit récemment que la demande pour Blackwell était « folle ». Vous dites également que la partie la plus difficile de votre travail est de supporter le fardeau émotionnel de dire « non » aux gens dans un monde où les ressources informatiques sont rares.

Mais les critiques affirment qu'il ne s'agit que d'un moment donné, et ils pensent que ce sera une expérience d'expansion et de récession, tout comme la construction excessive de fibres optiques par Cisco en 2000. Vous savez, je pense que lorsque nous dînions ensemble début 2023, les prévisions étaient que les revenus de Nvidia atteindraient 26 milliards de dollars en 2023, mais vous avez en réalité réalisé 60 milliards de dollars, n'est-ce pas ?

Jensen Huang : Admettez-le, c’est le plus grand échec de prédiction que le monde ait jamais connu.

Brad Gerstner : Nous étions particulièrement enthousiastes à cette époque, en novembre 2022, car des personnes comme Mustafa d'Inflection et Noam de Character sont venues dans notre bureau pour discuter d'investissement dans leur entreprise. Ils ont dit : si vous ne pouvez pas investir directement dans notre entreprise, alors achetez Nvidia, car le monde se démène pour obtenir les puces Nvidia afin de créer les applications qui vont changer le monde.

Bien sûr, avec l’émergence de ChatGPT, ce « moment cambrien » est arrivé. Cependant, même ainsi, ces 25 analystes sont toujours obsédés par « l'hiver des crypto-monnaies » et ne peuvent pas imaginer ce qui se passe dans le monde, n'est-ce pas ? Le résultat final a donc largement dépassé les attentes.

Vous avez clairement indiqué que la demande pour Blackwell est insensée et continuera de l’être. Bien sûr, l’avenir est inconnu et inconnaissable, mais pourquoi les critiques ont-elles si tort ? Il ne s’agira pas d’une situation de surconstruction comme celle de Cisco en 2000.

Jensen Huang : La meilleure façon de penser l’avenir est de raisonner à partir des premiers principes, n’est-ce pas ? La question est donc la suivante : quelle est la justification de ce que nous faisons maintenant ? D’abord, que faisons-nous ? Que faisons-nous ? Nous réinventons l'informatique, n'est-ce pas ?

Nous venons de dire que l’avenir de l’informatique dépendra fortement de l’apprentissage automatique, n’est-ce pas ? Presque toutes nos applications, que ce soit Word, Excel, PowerPoint, Photoshop, Premiere, AutoCAD, pour n'importe quel exemple, elles sont toutes conçues à la main. Je vous le garantis, ceux-ci dépendront fortement de l'apprentissage automatique à l'avenir, n'est-ce pas ?

Et, en plus de ces outils, vous disposerez d’agents pour vous aider à les utiliser.

Donc, maintenant, c’est un fait, non ? Nous avons réinventé l'informatique et nous ne regardons pas en arrière. L’ensemble de la pile technologique informatique est en train d’être redéfini.

D'accord, maintenant que nous en sommes arrivés à ce point, nous disons que les logiciels vont être différents, la façon dont les logiciels sont écrits va être différente, la façon dont les logiciels sont utilisés va être différente. Alors, admettons que ce sont mes faits fondamentaux. Oui, la question est donc : que se passe-t-il ensuite ?

Voyons donc comment les calculs étaient effectués dans le passé. Nous disposons d’un billion de dollars de matériel informatique. Si vous regardez le centre de données du passé, ouvrez la porte et regardez-le, diriez-vous que ce sont les ordinateurs que vous souhaitez utiliser pour affronter l’avenir ? La réponse est non.

Vous voyez ces processeurs, nous savons ce qu’ils peuvent et ne peuvent pas faire. Nous savons également qu’il existe désormais des centres de données d’une valeur de mille milliards de dollars qui ont besoin d’être modernisés. Donc, à l’heure actuelle, si nous voulons nous moderniser au cours des quatre ou cinq prochaines années, c’est tout à fait raisonnable et sensé.

Brad Gerstner : Nous avons donc discuté avec des personnes qui ont besoin de se moderniser, et elles le font avec des GPU, oui.

Jensen Huang : Je veux dire, faisons une hypothèse. Vous disposez de 50 milliards de dollars d’investissements, allez-vous choisir l’option A : construire des investissements pour l’avenir, ou l’option B : construire des investissements selon les modèles du passé ? Vous avez dépassé les dépenses d’investissement et elles restent là et elles ne vont pas s’améliorer de toute façon.

La loi de Moore est pour l’essentiel terminée, alors pourquoi la reconstruire ? Nous avons juste besoin d’investir ces 50 milliards de dollars dans l’IA générative, n’est-ce pas ? Votre entreprise s’en portera mieux ainsi. Alors, quelle part des 50 milliards allez-vous investir ? J'y mettrais 100 % des 50 milliards car j'ai une infrastructure vieille de quatre ans.

Alors maintenant, à partir des premiers principes, vous raisonnez simplement dans cette perspective, et c'est exactement ce qu'ils font. Les gens intelligents font des choses intelligentes.

Maintenant, la deuxième partie est la suivante : nous avons un billion de dollars de capacité à construire, n’est-ce pas ? Un billion de dollars d’infrastructures, peut-être 150 milliards de dollars investis, n’est-ce pas ? Nous allons donc construire des infrastructures pour un billion de dollars dans les 4 à 5 prochaines années.

La deuxième chose que nous avons observée est que la manière dont les logiciels sont écrits est différente, et la manière dont les logiciels seront utilisés à l’avenir sera différente. Nous allons avoir des agents intelligents, n'est-ce pas ?

Nous allons avoir des employés du numérique dans notre entreprise, et ils seront dans votre boîte de réception, et dans le futur, ces petits points, ces petits avatars deviendront des icônes de l'IA, n'est-ce pas ? Je leur enverrai des tâches. Je ne programme plus en C++, j'utilise des mots d'invite pour « programmer » l'IA, n'est-ce pas ? Ce n’est pas différent de lorsque j’ai écrit plusieurs e-mails ce matin.

J'ai donné des instructions à mon équipe, non ? J'ai décrit le contexte, exposé les limites fondamentales de ce que je connaissais et décrit leur mission. Je leur donne suffisamment de directives pour comprendre ce dont j'ai besoin et je veux être aussi clair que possible sur les résultats attendus. Mais je laisse aussi suffisamment de place à la créativité pour qu’ils puissent me surprendre, non ?

Ce n'est pas différent de la façon dont j'invite l'IA aujourd'hui, c'est exactement ainsi que j'invite l'IA. Ainsi, en plus de notre infrastructure modernisée, il y aura une toute nouvelle infrastructure. Cette nouvelle infrastructure est l’usine d’IA qui fera fonctionner ces humains numériques, et ils fonctionneront 24 heures sur 24.

Nous allons les avoir dans toutes les entreprises du monde, nous allons les avoir dans nos usines, nous allons les avoir dans nos systèmes automatisés, n'est-ce pas ? Le monde doit donc construire toute une couche de structures informatiques, ce que j’appelle l’infrastructure de l’usine d’IA, qui n’existe pas encore.

La question est donc : quelle est sa taille ? Nous ne le savons pas encore, mais cela pourrait se chiffrer en milliards de dollars, mais la beauté est que l’architecture modernisée du centre de données est la même que l’architecture de l’usine d’IA.

Brad Gerstner : C'est la beauté. Vous avez indiqué très clairement que vous disposez d'un billion de dollars d'infrastructures existantes qui doivent être modernisées, et que vous avez au moins un billion de dollars de nouvelles charges de travail d'IA à venir, ce qui représente environ 125 milliards de dollars de revenus cette année.

Vous savez, on vous a dit que cette entreprise ne vaudrait jamais plus d’un milliard de dollars. Et maintenant, vous êtes assis ici, si vous ne représentez que 125 milliards de revenus sur un marché total (TAM) de plusieurs milliards, quelle raison vous fait penser que vos revenus futurs ne seront pas 2 ou 3 fois ce qu'ils sont actuellement ? Y a-t-il une raison pour laquelle vos revenus ne continueront pas à augmenter ?

Jensen Huang : Non, c'est vrai. Vous savez, il ne s'agit pas du présent. L'entreprise n'est limitée que par la taille de « l'étang », vous savez, les poissons rouges ne peuvent grandir qu'en fonction de la taille de l'étang.

La question est donc : quelle est la taille de notre étang ? Cela demande beaucoup d’imagination, c’est pourquoi les pionniers du marché pensent à l’avenir plutôt qu’à se contenter de rivaliser sur le bassin existant.

Il est difficile de voir clairement l'avenir si l'on se contente de regarder le passé et d'essayer de conquérir des parts de marché. Les prétendants à des parts de marché ne peuvent atteindre une taille limitée, tandis que les pionniers du marché peuvent devenir très importants. Je pense donc que la chance de notre entreprise est que nous avons dû nous créer un espace de marché dès le premier jour.

Les gens ne s’en rendaient pas compte à l’époque, mais nous avons créé le marché des PC de jeu 3D presque à partir de zéro. En fait, nous avons inventé ce marché et tous les écosystèmes associés, y compris celui des cartes graphiques. Nous avons tout inventé. Créer un tout nouveau marché pour servir cela nous est donc très familier.

▲Brad Gerstner (à gauche) et Clark Tang (à droite) dans l'interview

Incroyables OpenAI et X.AI

Brad Gerstner : Oui, c'est vrai pour quelqu'un qui a inventé un nouveau marché. Changeons un peu de sujet et parlons de modèles et d’OpenAI. Vous savez, OpenAI a levé 6,5 milliards de dollars cette semaine, ce qui le valorise à environ 150 milliards de dollars. Nous avons tous participé à ce financement.

Jen -Hsun Huang : Je suis vraiment heureuse pour eux, je suis vraiment heureuse que tout se soit bien passé. Oui, ils ont fait un excellent travail et l’équipe a fait un excellent travail.

Brad Gerstner : Selon certains rapports, leurs revenus ou taux de revenus s'élèvent à environ 5 milliards de dollars cette année et pourraient atteindre 10 milliards de dollars l'année prochaine. Si vous regardez la taille de l’entreprise aujourd’hui, ses revenus sont à peu près le double de ceux de Google lors de son introduction en bourse.

Ils comptent 250 millions d'utilisateurs actifs hebdomadaires, ce qui, selon nous, représente le double du nombre d'utilisateurs lors de l'introduction en bourse de Google. Et si vous regardez son multiple commercial, si vous pensez qu'ils peuvent atteindre 10 milliards de dollars de chiffre d'affaires l'année prochaine, alors leur capitalisation boursière est environ 15 fois supérieure au chiffre d'affaires de l'année prochaine, ce qui est à peu près le même multiple que celui de Google et Meta lors de leur introduction en bourse, n'est-ce pas ? ? C'est assez stupéfiant si l'on considère que cette société n'avait aucun revenu et aucun utilisateur actif hebdomadaire il y a 22 mois.

Jensen Huang : Brad a une compréhension étrange de l'histoire.

Brad Gerstner : Quand vous y réfléchissez, parlez-nous d'OpenAI en tant que partenaire et de son importance pour sensibiliser le public et utiliser l'IA.

Jensen Huang : Eh bien, c'est l'une des entreprises les plus influentes de notre époque. Il s'agit d'une entreprise purement IA poursuivant la vision de l'intelligence artificielle générale (AGI).

Quelle que soit la définition de l’AGI, je ne crois pas que sa définition soit entièrement importante, ni à l’importance du timing. Une chose que je sais, c’est que l’IA continuera de démontrer toute une gamme de capacités au fil du temps. La feuille de route pour le développement de ces capacités sera étonnante. Avant d’arriver à la définition de l’AGI, nous allons l’appliquer largement.

Ce que vous devez faire maintenant, c'est aller parler à des biologistes numériques, des chercheurs en technologies climatiques, des chercheurs en matériaux, des physiciens, des astrophysiciens, des chimistes quantiques. Vous pouvez vous adresser aux concepteurs de jeux vidéo, aux ingénieurs de fabrication, aux experts en robotique, choisir un secteur que vous aimez, l'approfondir, parler à ces personnes importantes et leur demander si l'IA révolutionne leur façon de travailler ? Ensuite, vous ramenez ces points de données et vous vous demandez à quel point êtes-vous sceptique ?

Parce qu’ils ne parlent pas des avantages conceptuels de l’IA dans le futur, ils parlent de l’utiliser maintenant. Qu'il s'agisse de technologie agricole, de technologie des matériaux, de technologie climatique, choisissez votre domaine technologique ou scientifique, ils progressent et l'IA les aide à faire avancer leur travail.

À l’heure où nous parlons, chaque industrie, chaque entreprise, chaque université utilise l’IA. C’est incroyable, n’est-ce pas ? Cela va certainement changer les affaires d’une manière ou d’une autre, nous le savons, n’est-ce pas ? Je veux dire, ce changement est tellement réel et en train de se produire. Je pense donc que l’éveil de l’IA déclenché par ChatGPT est complètement incroyable. J'aime leur vitesse et leur objectif singulier de pousser le terrain, donc c'est vraiment impactant.

Brad Gerstner : Ils ont construit un moteur capable de financer la prochaine génération de modèles. Je pense qu'il existe un consensus croissant dans la Silicon Valley selon lequel l'ensemble de la couche modèle est en train de devenir une marchandise, et Llama permet à beaucoup de gens de construire des modèles à un coût très faible.

Donc au début, nous avions beaucoup de sociétés modèles, comme Character, Inflection, Cohere, Mistral, etc. Beaucoup se demandent si ces entreprises pourront atteindre la « vitesse de fuite » du moteur économique et continuer à financer la prochaine génération de modèles. J’ai l’impression que c’est la raison pour laquelle nous assistons à une consolidation du marché, n’est-ce pas ?

De toute évidence, OpenAI a atteint cette « vitesse de fuite » qui lui permet de financer son avenir. Mais je ne suis pas sûr que de nombreuses autres entreprises puissent faire cela. Est-ce un aperçu juste de l’état actuel de la couche modèle ? Comme nous l’avons vu sur de nombreux autres marchés, les leaders du marché disposeront d’un moteur économique et d’une application qui leur permettront de continuer à investir.

Jensen Huang : Tout d’abord, il existe une différence fondamentale entre les modèles et l’intelligence artificielle, n’est-ce pas ? Les modèles sont une composante nécessaire mais insuffisante de l’intelligence artificielle, n’est-ce pas ? L’intelligence artificielle est une capacité, mais pour quoi ? Quelle est la demande?

L’intelligence artificielle des voitures autonomes est liée à l’intelligence artificielle des robots humanoïdes, mais ce ne sont pas les mêmes. Ils sont liés à l’intelligence artificielle des chatbots, mais ce ne sont pas les mêmes, n’est-ce pas ? Vous devez donc comprendre la classification de cette pile. Il existe des opportunités à chaque niveau de la pile, mais tous les niveaux n'offrent pas des opportunités illimitées.

Je viens de dire quelque chose et il ne vous reste plus qu'à remplacer le mot "modèle" par "GPU". En fait, c'était la découverte majeure de notre entreprise il y a 32 ans : il existe une différence fondamentale entre les puces graphiques GPU et le calcul accéléré. Le calcul accéléré est différent de ce que nous faisons dans l’infrastructure d’IA, et bien que lié, ce n’est pas exactement la même chose. Ils sont construits les uns sur les autres, mais ne sont pas identiques. Chaque niveau d'abstraction nécessite des compétences complètement différentes.

Quelqu'un qui est très doué dans la construction de GPU n'a peut-être aucune idée de comment devenir une entreprise d'informatique accélérée. De nombreuses personnes construisent des GPU, et nous avons inventé le GPU, mais nous ne sommes pas les seuls à fabriquer des GPU aujourd'hui, n'est-ce pas ? Il existe de nombreux GPU dans le monde, mais tous ne sont pas des sociétés de calcul accéléré. Et il existe de nombreuses applications d’accélération, mais ce n’est pas la même chose que les entreprises de calcul accéléré. Par exemple, une application d’IA très spécialisée peut connaître un grand succès.

Brad Gerstner : Ici MTIA.

Jensen Huang : C'est vrai, mais il se peut qu'elle ne devienne pas une entreprise dotée d'une portée et de capacités étendues. Vous devez donc décider où vous voulez être. Il peut y avoir des opportunités dans ces différents domaines, mais tout comme pour la création d'une entreprise, vous devez prêter attention aux changements dans l'écosystème et à ce qui est banalisé au fil du temps, qu'est-ce qu'une fonctionnalité, qu'est-ce qu'un produit, qu'est-ce qu'une entreprise. certain. Eh bien, je viens d'aborder beaucoup de sujets différents.

Brad Gerstner : Bien sûr, il y a un nouvel entrant qui a l'argent, l'intelligence, l'ambition, et c'est X.AI, n'est-ce pas ? Des informations venant de l'extérieur indiquent que vous avez dîné avec Larry et Elon. Ils vous ont parlé de 100 000 H100, ils sont allés à Memphis et ont construit un énorme cluster de calcul intensif en quelques mois.

Jen-Hsun Huang : Tout d'abord, les trois points ne sont pas sur la même ligne. J'ai dîné avec eux. La relation causale est la suivante.

Brad Gerstner : Que pensez-vous de leur capacité à créer des clusters de supercalcul ? Il y a encore des discussions sur la volonté d'ajouter 100 000 H200 supplémentaires pour étendre la taille de ce super cluster.

Tout d’abord, parlez-nous des ambitions de l’entreprise X et de ce qu’elle a réalisé. En parallèle, sommes-nous entrés dans l’ère des 200 000 ou 300 000 clusters GPU ?

Jen-Hsun Huang : La réponse est oui. Commencez par reconnaître que leurs réalisations sont méritées. De la phase de conception jusqu'à la construction du centre de données et sa préparation pour l'arrivée des équipements NVIDIA, en passant par son alimentation, la connexion des équipements et la première formation.

Tout d'abord, construire une usine aussi immense, en utilisant la technologie de refroidissement liquide, en complétant l'approvisionnement en énergie, en obtenant les permis et en l'achevant dans un laps de temps si court. Je veux dire, c'est juste un exploit surhumain. Pour autant que je sache, il n'y a qu'une seule personne au monde qui peut faire cela. La compréhension d'Elon Musk de l'ingénierie, de l'architecture, des systèmes à grande échelle et de la mobilisation des ressources est unique et tout simplement incroyable.

Bien sûr, son équipe d'ingénierie est également très bonne, l'équipe logicielle, l'équipe réseau, l'équipe infrastructure sont toutes formidables. Elon le comprend profondément. Dès le moment où nous avons décidé de lancer le projet, notre équipe d’ingénierie, notre équipe réseau, notre équipe informatique d’infrastructure et notre équipe logicielle étaient parfaitement préparées.

Ensuite, toute l'infrastructure, la logistique, la quantité de données et d'équipements arrivés ce jour-là, ainsi que l'infrastructure et la technologie informatique de Nvidia, tout a été formé en 19 jours.

Savez-vous ce que cela signifie ? Est-ce que quelqu'un dort ? En travaillant 24 heures sur 24, personne ne dort, c'est certain. Tout d’abord, 19 jours, c’est incroyable, mais si vous prenez du recul et y réfléchissez, ce n’est qu’une question de semaines. La quantité d’équipements techniques que vous pouvez voir est tout simplement incroyable.

Tout le câblage et la mise en réseau, la mise en réseau avec les équipements Nvidia est complètement différente de la mise en réseau dans un centre de données hyperscale. Le nombre de fils sur un nœud, à l'arrière de l'ordinateur, est constitué de tous les fils. Le simple fait de rassembler ce sommet de la technologie, ainsi que tous les logiciels, est incroyable.

Je pense donc que ce qu'Elon et son équipe ont fait est incroyable, et je suis reconnaissant qu'il ait reconnu notre travail avec eux du côté de l'ingénierie et de la planification. Mais ce qu’ils ont réalisé était unique et sans précédent.

Pour vous donner une meilleure idée, avec 100 000 GPU, c'est sans aucun doute le supercalculateur le plus rapide de la planète. Ceci est juste un cluster. Normalement, lorsque vous construisez un supercalculateur, il faut trois ans pour le planifier, n'est-ce pas ? Ensuite, livrez l’équipement et passez un an à tout faire fonctionner. Et nous parlons de 19 jours.

▲Le réveil de l'IA provoqué par ChatGPT est incroyable (Source : artnet)

Le raisonnement est sur le point d'exploser

Clark Tang : Quels sont les avantages de la plateforme NVIDIA ? Tout son processus a été durci, n'est-ce pas ?

Jensen Huang : Oui, tout fonctionne déjà. Bien sûr, il existe de nombreux algorithmes X, frameworks X et piles X, et nous devons encore faire beaucoup d'intégration. Mais la pré-planification était si bonne que la pré-planification à elle seule était impressionnante.

Brad Gerstner : Elon est unique, mais lorsque vous venez de répondre, vous avez mentionné qu'il existe déjà 200 000 à 300 000 clusters GPU, n'est-ce pas ? Peut-il atteindre 500 000 ? Peut-il atteindre 1 million ? La demande pour votre produit dépend-elle de la capacité de ces clusters à atteindre des millions ?

Jensen Huang : La réponse à la dernière question est non. Mon point de vue est que la formation distribuée doit fonctionner et je pense que l’informatique distribuée sera inventée et qu’une certaine forme d’apprentissage fédéré et d’informatique distribuée et asynchrone sera découverte. Je suis très confiant et très optimiste à ce sujet.

Bien sûr, il est important de réaliser que dans le passé, les lois de mise à l’échelle concernaient principalement la pré-formation. Maintenant que nous sommes entrés dans la multimodalité, nous commençons la génération de données synthétiques. La phase post-formation évolue très rapidement, avec la génération de données synthétiques, les systèmes de récompense et la formation basée sur l'apprentissage par renforcement se développant tous rapidement. Aujourd’hui, l’expansion de l’étape d’inférence a également atteint sa limite.

L’idée est qu’avant que le modèle ne réponde à la question, il a effectué un raisonnement interne 10 000 fois, ce qui n’est probablement pas une exagération. Il a peut-être fait une recherche arborescente, il a peut-être fait un apprentissage par renforcement basé sur le problème, il a peut-être fait une sorte de simulation, il a dû faire beaucoup de réflexion, il a peut-être examiné certaines données et informations, n'est-ce pas ? Son contexte peut donc être assez vaste.

Je pense que le renseignement est ce que nous faisons, n'est-ce pas ? C'est ce que nous faisons. Donc, si vous faites le calcul sur cette mise à l'échelle, la taille du modèle et l'échelle de calcul sont multipliées par 4 par an, couplées à la demande croissante d'utilisation…

Pensons-nous que nous avons besoin de millions de GPU ? Sans aucun doute, oui. Il s’agit actuellement d’une question déterministe. La question est donc de savoir comment concevoir cela du point de vue du centre de données ? Tout dépend si le centre de données va atteindre des gigawatts d'un seul coup ou 250 mégawatts à la fois ? Mon opinion est que les deux scénarios se produisent.

Clark Tang : Je pense que les analystes se concentrent toujours sur les choix architecturaux actuels, mais je pense que l'un des principaux enseignements de cette conversation est que vous réfléchissez à l'ensemble de l'écosystème et à ce qui va se passer dans de nombreuses années.

Nvidia évolue donc, que ce soit verticalement ou horizontalement, pour préparer l'avenir, plutôt que de s'appuyer uniquement sur un monde de 500 000 ou 1 million de clusters GPU. Au moment où la formation distribuée arrive, vous avez déjà écrit le logiciel pour la prendre en charge.

Jen -Hsun Huang : Oui, souvenez-vous du Megatron que nous et nos partenaires avons développé il y a environ sept ans. Sans cela, la mise à l’échelle de ces tâches de formation à grande échelle ne serait pas possible. Nous avons inventé Megatron, nous avons inventé Nickel, GPU Direct et tout le travail que nous avons effectué avec RDMA, qui a rendu le traitement parallèle de pipeline beaucoup plus facile.

Tous les traitements parallèles de modèles, toutes les décompositions de formation distribuées, les traitements par lots et toutes ces technologies sont dus au fait que nous avons effectué les premiers travaux, et maintenant nous nous préparons également à la prochaine génération de technologies dans le futur.

Brad Gerstner : Parlons donc de Strawberry et de o1.

Tout d’abord, je pense que c’est cool qu’ils aient nommé le visa o1, non ? Le visa o1 vise à attirer aux États-Unis les meilleurs et les plus brillants talents du monde entier, et je sais que cela nous passionne tous profondément.

J'aime beaucoup l'idée de construire un modèle qui pense et nous pousse vers de nouveaux sommets de mise à l'échelle intelligente, rendant hommage aux génies qui sont venus en Amérique grâce à l'immigration et ont fait de nous ce que nous sommes aujourd'hui.

Jen -Hsun Huang : Ce doit être une intelligence extraterrestre.

Brad Gerstner : Bien sûr, ce projet est dirigé par notre ami Noah Brown, qui a travaillé sur Pluribus et Cicero, tous deux projets Meta. Dans quelle mesure est-il important que l’inférence en fonction du temps d’inférence soit une toute nouvelle dimension d’échelle de l’intelligence, par opposition à la simple construction de modèles plus grands ?

Jen-Hsun Huang : C'est très important, extrêmement important. Beaucoup de renseignements ne peuvent pas être obtenus à l'avance, vous savez ? Même de nombreux calculs ne peuvent pas être réorganisés à l'avance. Une exécution dans le désordre peut être effectuée à l'avance, mais de nombreuses choses ne peuvent être effectuées qu'au moment de l'exécution.

Donc , que ce soit du point de vue de l'informatique ou du renseignement, beaucoup de choses nécessitent du contexte et du contexte, et le type de réponses que vous recherchez, parfois une simple réponse rapide suffit, et les conséquences de cette réponse dépendent de ce que vous utilisez la nature de cette réponse.

Donc, certaines réponses peuvent prendre une soirée à réfléchir, et certaines réponses peuvent prendre une semaine, n'est-ce pas ? Je peux tout à fait m'imaginer envoyer un mot rapide à mon IA et le lui dire, y réfléchir du jour au lendemain et ne me le dire pas tout de suite, n'est-ce pas ? Je veux que vous y réfléchissiez toute la nuit, puis que vous me disiez votre meilleure réponse demain matin et que vous raisonniez pour moi.

Je pense donc que la superposition intelligente, du point de vue du produit, il y aura des versions uniques et certaines prendront cinq minutes à réaliser.

Brad Gerstner : Cette couche d'intelligence est capable d'associer ces problèmes aux modèles et scénarios d'utilisation appropriés. Hier soir, nous utilisions le mode vocal avancé et l'aperçu o1, et je donnais des cours particuliers à mon fils pour son examen d'histoire AP, et j'avais l'impression que le meilleur professeur d'histoire AP au monde était assis juste à côté de vous et réfléchissait ensemble à ces questions. C'était une expérience tellement extraordinaire.

Jen-Hsun Huang : Mon mentor est désormais l'IA.

Brad Gerstner : Bien sûr, ils existent aujourd'hui. Cela nous ramène également au fait que, vous savez, plus de 40 % de vos revenus proviennent aujourd'hui de l'inférence. Mais le raisonnement va exploser à cause des « chaînes de raisonnement », n’est-ce pas ?

Jen-Hsun Huang : La croissance du raisonnement sera multipliée par un milliard.

Brad Gerstner : Doublez-le, doublez-le un milliard de fois.

Jen-Hsun Huang : Oui. C’est la partie que la plupart des gens ne comprennent pas encore complètement. C’est exactement le changement industriel dont nous parlions plus tôt, c’est la révolution industrielle.

Brad Gerstner : C'est une production intelligente, n'est-ce pas ?

Jensen Huang : Cela va croître un milliard de fois.

Brad Gerstner : Tout le monde prête une attention particulière à NVIDIA, pensant qu'elle est principalement utilisée pour entraîner des modèles plus gros. N'est-ce pas vrai ? Si 50 % de vos revenus proviennent aujourd'hui de la formation, alors l'ampleur de l'inférence dépassera de loin la formation à l'avenir. La formation est importante, mais nous l’espérons, la croissance de l’inférence dépassera de loin celle de la formation, et il est presque impossible de faire autrement.

Jensen Huang : Nous l'espérons. Oui, aller à l'école est une bonne chose, mais le but ultime est de pouvoir contribuer à la société. Donc former ces modèles, c’est bien, mais le but ultime est de les rendre percutants.

Brad Gerstner : Utilisez-vous déjà Inference Chain et des outils comme o1 pour améliorer votre propre entreprise ?

Jen-Hsun Huang : Nos systèmes de sécurité réseau sont aujourd'hui indissociables de notre propre intelligence. Nous avons des agents qui aident à concevoir les puces, et sans ces agents, la puce Hopper ne serait pas possible, ni Blackwell, et encore moins Rubin.

Nous avons des concepteurs de puces IA, des ingénieurs logiciels IA et des ingénieurs en vérification IA, et nous les développons tous au sein de l'entreprise. Parce que nous avons cette capacité, nous préférons profiter de cette opportunité pour explorer cette technologie nous-mêmes.

▲La croissance de l'inférence sera un milliard de fois (Source : NVIDIA)

Nous avons besoin d’une IA plus efficace et plus sûre

Brad Gerstner : Vous savez, alors que j'entrais dans le bâtiment aujourd'hui, quelqu'un est venu vers moi et m'a dit, vous savez, interrogez Jensen sur la culture, tout est question de culture. Je regarde votre entreprise et nous parlons beaucoup d'adaptabilité et d'efficacité, de structures organisationnelles plates qui permettent une exécution rapide, de petites équipes fonctionnant.

Vous savez, NVIDIA est unique dans ce domaine, générant environ 4 millions de dollars de revenus par employé et environ 2 millions de dollars de bénéfices ou de flux de trésorerie disponibles par employé. Vous avez établi une culture d’efficacité qui libère véritablement la créativité, l’innovation, la responsabilité et l’appropriation, et vous avez brisé le modèle traditionnel de gestion fonctionnelle. Tout le monde aime parler du nombre de subordonnés directs que vous avez.

L’utilisation de l’IA est-elle essentielle pour vous permettre de rester très créatif tout en restant efficace ?

Jen-Hsun Huang : Sans aucun doute. J'espère qu'un jour, Nvidia compte aujourd'hui 32 000 employés et que nous avons 4 000 familles en Israël, j'espère qu'ils vont bien. J'espère qu'un jour Nvidia sera une entreprise avec 50 000 employés et 100 millions d'assistants IA.

Dans chaque équipe, nous aurons un répertoire d'IA avec un groupe d'IA capables de faire diverses choses. Nous aurons également une boîte de réception remplie d'un catalogue d'IA avec lesquelles nous avons travaillé et que nous savons être bonnes dans nos domaines de compétences. Par conséquent, l’IA recrute d’autres IA pour résoudre des problèmes. Les IA communiqueront également entre elles dans les canaux Slack.

Brad Gerstner : Et travailler avec des humains.

Jen-Hsun Huang : Travailler avec les humains. Nous serons donc un grand groupe d'employés, dont une partie est constituée d'employés du numérique et de l'IA, dont une partie est constituée d'employés humains biologiques, et j'espère qu'il y aura des employés en mécatronique à l'avenir.

Brad Gerstner : D'un point de vue commercial, je pense que cela est souvent mal compris. Vous venez de décrire une entreprise dont la production est équivalente à celle d'une entreprise comptant 150 000 employés, mais en réalité, vous n'avez utilisé que 50 000 employés. Vous ne dites pas que vous allez licencier tous vos employés, vous continuez à augmenter vos effectifs, mais la production de cette entreprise va augmenter considérablement, n'est-ce pas ?

Jen-Hsun Huang : C'est quelque chose qui est souvent mal compris. L’IA ne remplacera pas les emplois, elle transformera chaque emploi. L’IA va avoir un impact profond sur la façon dont les gens perçoivent le travail, nous devons l’admettre, n’est-ce pas ?

L’IA a le potentiel de faire à la fois du bien et du mal, et nous devons construire une IA sûre, oui, cela doit être la base. Mais ce qui est négligé, c’est que lorsque les entreprises utilisent l’IA pour accroître leur productivité, cela entraînera probablement de meilleurs bénéfices ou une meilleure croissance, ou les deux. Et lorsque cela se produit, il est peu probable que le prochain courriel du PDG soit un avis de licenciement.

Brad Gerstner : Absolument, car l'entreprise est en pleine croissance.

Jensen Huang : Oui, la raison est que nous avons plus d'idées que nous ne pouvons en explorer, et nous avons besoin de personnes pour nous aider à y réfléchir, puis à automatiser ces idées. Quant à la partie automatisation, l’IA peut nous aider à y parvenir.

Évidemment, cela nous aidera aussi à réfléchir, mais nous devons encore déterminer quel problème nous voulons résoudre. Il existe d’innombrables problèmes que nous pouvons résoudre, mais les entreprises doivent choisir ceux qui nécessitent le plus de solution, puis trouver un moyen de les automatiser et de les faire évoluer.

Ainsi, à mesure que nous devenons plus efficaces, nous embaucherons davantage de personnes. Les gens l’oublient souvent. Si l’on regarde l’histoire, il est clair que nous avons plus d’idées aujourd’hui qu’il y a 200 ans. C'est pourquoi le PIB et l'emploi augmentent, même si nous avons automatisé à un rythme effréné.

Brad Gerstner : C'est un point important alors que nous entrons dans cette période où la quasi-totalité de la productivité et de la prospérité humaines est un sous-produit de la technologie et de l'automatisation au cours des 200 dernières années. Si vous regardez la courbe de croissance du PIB par habitant au cours des 200 dernières années, depuis Adam Smith jusqu'à la destruction créatrice de Schumpeter, elle ne cesse de s'accélérer. Cela m'amène à une question.

Si vous regardez les années 1990, la croissance de la productivité aux États-Unis était d'environ 2,5 à 3 % par an. Puis, dans les années 2000, elle a ralenti jusqu'à environ 1,8 %. La dernière décennie a été la croissance de productivité la plus lente jamais enregistrée. Il s’agit de la croissance de notre production pour un apport fixe de travail et de capital, et c’est la croissance la plus lente jamais enregistrée.

Beaucoup de gens en ont discuté. Mais si le monde est tel que vous décrivez, et que nous allons exploiter et fabriquer de l’intelligence, sommes-nous sur le point d’une expansion massive de la productivité humaine ?

Jen-Hsun Huang : C'est notre espoir. C'est notre espoir, et bien sûr, vous savez, nous vivons dans ce monde, donc nous avons des preuves directes, n'est-ce pas ? Nous avons des preuves directes, comme celles des chercheurs individuels utilisant l’IA, qu’ils peuvent désormais explorer la science à une échelle sans précédent, ce qui reflète la productivité.

Ou bien nous concevons une puce si complexe et le faisons si rapidement et les effectifs de l'entreprise n'augmentent pas au même rythme, ce qui reflète également la productivité, n'est-ce pas ? Les logiciels que nous développons s’améliorent également car nous exploitons l’IA et les superordinateurs pour nous aider, et le nombre d’employés augmente de manière presque linéaire.

C'est une autre preuve de productivité. Ainsi, quel que soit le secteur dans lequel je me lance, je peux vérifier moi-même, je peux personnellement vérifier que ces manifestations sont répandues. Il ne fait aucun doute que le renseignement est la ressource la plus précieuse au monde, et nous allons désormais la produire à grande échelle.

Nous devons tous apprendre à vivre dans un environnement où nous sommes entourés d’une IA capable de faire les choses très bien, voire mieux que nous. Quand j'y réfléchis, je vois que c'est ma vie.

J'ai 60 subordonnés directs, n'est-ce pas ? Ce sont tous des gens de classe mondiale dans leur domaine et font bien mieux que moi. Je n’ai aucun problème à travailler avec eux, ni à les coacher et à communiquer avec eux. Je pense donc que ce que les gens vont apprendre, c’est qu’ils vont tous devenir PDG d’agents d’IA.

Ils doivent faire preuve de créativité, de détermination et d’une certaine connaissance de la manière de résoudre les problèmes pour pouvoir programmer ces IA afin de les aider à atteindre leurs objectifs, tout comme je dirige mon entreprise.

Brad Gerstner : Vous avez mentionné une question, qui concerne la discussion sur l'alignement et l'IA sûre. Vous avez également évoqué la tragédie qui se déroule au Moyen-Orient. Vous savez, il existe actuellement de nombreuses applications d’autonomie et d’IA dans différentes parties du monde.

Parlons donc des mauvais acteurs, de l’IA de sécurité et de la coordination avec Washington. Comment te sens-tu maintenant ? Sommes-nous sur la bonne voie ? Sommes-nous suffisamment coordonnés ? Je me souviens que Mark Zuckerberg a dit un jour que la façon de vaincre la mauvaise IA était d’améliorer la bonne IA. Comment décririez-vous la manière dont nous veillons à ce que l’IA ait un bénéfice net positif pour l’humanité, plutôt que de nous piéger dans un monde dystopique sans but ?

Jen-Hsun Huang : Le débat sur la sécurité est très important et significatif. La vision abstraite, qui consiste à traiter l’IA comme un vaste réseau neuronal, n’est pas une bonne vision. Et la raison est que nous savons que l’intelligence artificielle et les grands modèles de langage, bien que liés, ne sont pas identiques.

Il y a beaucoup de travail en cours en ce moment que je trouve génial. Premièrement, un modèle open source permet à chaque industrie, chaque entreprise et à l’ensemble de la communauté de recherche d’avoir accès à l’IA et d’apprendre à exploiter cette capacité dans leur domaine. très bien.

Deuxièmement, les forces technologiques de développement de l’IA se concentrent sur l’invention de moyens de rendre l’IA plus sûre. L'IA est utilisée pour trier les données, filtrer les informations, former d'autres IA, créer des IA alignées, générer des données synthétiques, élargir les connaissances en IA, réduire les hallucinations et toute l'IA créée pour les images vectorielles, les graphiques, etc., pour informer et surveiller d'autres systèmes d'IA qui n’ont pas encore reçu suffisamment de reconnaissance pour créer une IA sûre.

Brad Gerstner : Ces systèmes sont déjà en cours de construction.

Jensen Huang : Oui, nous construisons ces systèmes et tout le monde dans l'industrie le fait. Y compris les tests de l'équipe rouge, le contrôle des processus, les cartes modèles, les systèmes d'évaluation, les systèmes de référence, etc., tous ces mécanismes de sécurité sont construits à un rythme alarmant. Ces efforts n’ont pas reçu le crédit qu’ils méritent, vous savez.

Brad Gerstner : Oui, il n'existe actuellement aucune réglementation gouvernementale vous obligeant à le faire. Le moment est désormais venu où les acteurs de l’industrie prennent ces questions cruciales au sérieux et se coordonnent autour des meilleures pratiques.

Jensen Huang : Exactement, ces efforts ne sont pas suffisamment reconnus ni pleinement compris. Les gens doivent commencer à parler de l’IA comme d’un système composé de plusieurs IA et de sa nature de système bien conçu.

Concernant la réglementation, il faut rappeler que l’IA est une capacité et qu’elle peut être appliquée dans de nombreux domaines. Il n’est pas nécessairement nécessaire d’adopter une législation distincte pour chaque technologie importante, mais la réglementation ne devrait pas s’étendre à des domaines inutiles.

La majeure partie de la réglementation devrait être appliquée à des applications spécifiques. Par exemple, des agences telles que la FAA (Federal Aviation Administration), le NIH (National Institutes of Health) et la FDA (U.S. Food and Drug Administration) réglementent déjà les applications technologiques, et elles le sont désormais. ils Il est nécessaire de commencer à gérer les applications technologiques qui incluent l’IA.

Ne vous méprenez donc pas et n’ignorez pas la grande quantité de systèmes de réglementation existants que nous devrons activer. Ne comptez pas uniquement sur une seule commission mondiale sur l’IA, car chaque organisme de réglementation est créé pour une raison. La raison pour laquelle ces différentes agences de réglementation existent est de relever différents défis. Revenons à nouveau aux principes de base.

▲Clark Tang en interview

L’IA open source stimule l’activation de l’industrie

Brad Gerstner : Mon partenaire Bill Gurley (NDLR : Bill était absent de cette interview) m'en voudrait probablement si je ne revenais pas sur la question de l'open source. Vous avez récemment publié un modèle open source très important et très puissant. De toute évidence, Meta apporte également des contributions importantes à l'open source.

Quand je lisais Twitter, j'ai remarqué qu'il y avait beaucoup de discussions sur l'ouverture versus fermée. Que pensez-vous de l'open source, et en particulier la capacité de votre propre modèle open source à suivre le rythme de la technologie de pointe? C'est la première question.

La deuxième question est de savoir si votre vision de l'avenir, ayant un modèle open source ainsi qu'un modèle fermé qui alimente les opérations commerciales? Ces deux-là peuvent-elles créer une tension saine pour la sécurité de l'IA?

Jen-Hsun Huang: La discussion de l'open source et de la source fermée est liée à la sécurité, mais il ne s'agit pas seulement de la sécurité. Par exemple, avoir un modèle à source fermée comme moteur d'un modèle économique pour maintenir l'innovation est tout à fait très bien et je soutiens de tout cœur cela.

Je pense que la définition du problème simplement comme une source fermée par rapport à l'open source est une mauvaise façon de penser. Il devrait être fermé à source et open source, non? Parce que l'open source est nécessaire pour l'activation de nombreuses industries.

S'il n'y a pas d'open source maintenant, comment tous ces différents domaines scientifiques peuvent-ils être activés sur l'IA? Parce qu'ils doivent développer leur propre IA spécifique au domaine, et ils doivent tirer parti des modèles open source pour créer une IA spécifique au domaine. Les deux sont liés, mais pas les mêmes.

Ce n'est pas parce que vous avez un modèle open source que vous avez l'IA. Par conséquent, vous devez avoir des modèles open source pour conduire la création de l'IA. Ainsi, les services financiers, les soins de santé, les transports et de nombreux autres domaines de la science et de l'industrie sont activés par l'open source.

Brad Gerstner: Il est incroyable que votre modèle open source soit en forte demande, n'est-ce pas?

Jensen Huang: Notre modèle open source? Bien sûr, les téléchargements de lama, non? De toute évidence, le travail que MARK (Zuckerberg) et son équipe font est incroyable, à une énorme demande et en dynamisant complètement chaque industrie et tous les domaines de la science.

La raison pour laquelle nous avons créé Nemotron était pour la génération de données synthétiques. Intuitivement, il semble peu fiable de penser qu'une IA générera en permanence des données dans une boucle pour apprendre elle-même. Il est douteux combien de fois vous pouvez faire le tour dans cette boucle infinie. Cependant, j'ai une image dans mon esprit, qui est comme verrouiller une personne super intelligente dans une pièce douce.

Cependant, si deux ou trois personnes discutent ensemble, nous avons différents modèles d'IA, avons des distributions de connaissances différentes et pouvons nous remettre en question et nous répondre et communiquer dans les deux sens, alors nous deviendrons tous les trois plus intelligents. Par conséquent, l'idée d'échanger, d'interaction, de discussions de va-et-vient, de débats, d'apprentissage du renforcement et de génération de données synthétiques entre les modèles d'IA est intuitif.

Par conséquent, notre Nemotron 350B, 340B est les meilleurs modèles de systèmes de récompense au monde. C'est le meilleur modèle critique et est en effet excellent. Donc, c'est un outil fantastique pour améliorer tous les autres modèles, quelle que soit la qualité des autres modèles, je recommande d'utiliser le Nemotron 340b pour les améliorer et les rendre encore meilleurs. Et nous avons vu Llama s'améliorer, et tous les autres modèles en ont bénéficié.

▲ Meta apporte des contributions importantes à l'open source (Source: LinkedIn)

L'IA est une révolution complète

Brad Gerstner: En tant que personne qui a livré le premier DGX-1 en 2016, ce fut un voyage incroyable. Votre voyage est à la fois inhabituel et incroyable. Le fait que vous ayez réussi à passer ces moments difficiles initiaux est extraordinaire en soi.

Vous avez livré le premier DGX-1 en 2016 et nous avons inauguré ce "moment Cambrien" en 2022. Je veux donc poser une question qui me pose souvent, qui est, combien de temps pensez-vous que votre statut de travail actuel peut durer?

Avec 60 rapports directs, vous conduisez partout cette révolution. Aimez-vous le processus? Y a-t-il autre chose que vous préférez faire?