Un nouveau modèle proche du GPT-4 est sorti ! La « version européenne d’OpenAI » s’est associée à Microsoft, mais a été interrogée comme violant son intention initiale

Hier soir, Mistral AI, connu sous le nom de « European OpenAI », a publié son dernier modèle de génération de texte de haut niveau, Mistral Large.

Ce modèle possède des capacités de raisonnement de haut niveau et peut être utilisé pour gérer des tâches de raisonnement multilingues complexes, couvrant la compréhension, la transformation et la génération de code de texte.

Dessinez simplement les points clés :

- Fenêtre contextuelle 32K pour extraire avec précision les informations des documents volumineux.

- Les fonctionnalités précises de suivi des commandes permettent aux développeurs de personnaliser les stratégies d'audit.

- Prend en charge les restrictions d’appel de fonction et de mode de sortie pour aider à faire évoluer le développement d’applications et à moderniser les piles technologiques.

- Prise en charge native de l'anglais, du français, de l'espagnol, de l'allemand et de l'italien, avec une compréhension approfondie de la grammaire et du contexte culturel.

Ci-joint l'adresse de l'expérience : https://chat.mistral.ai/chat

Mistral AI élargit encore ses compétences

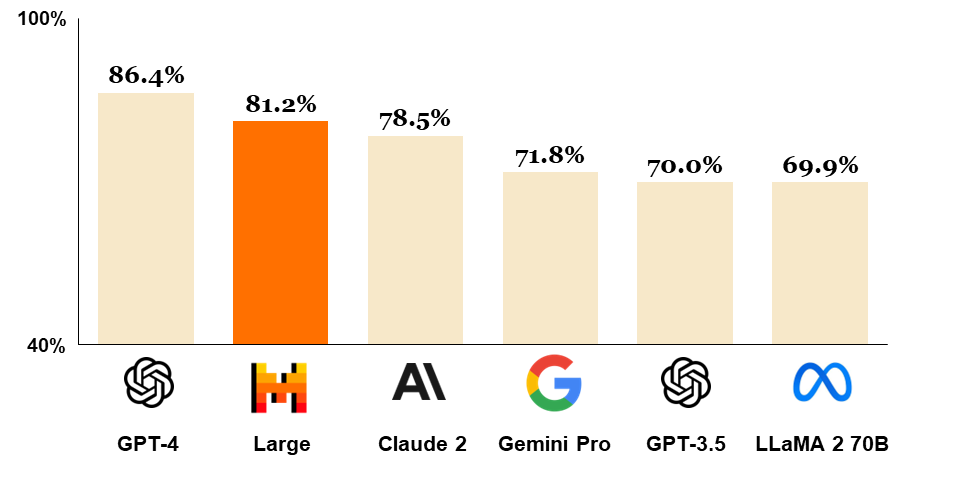

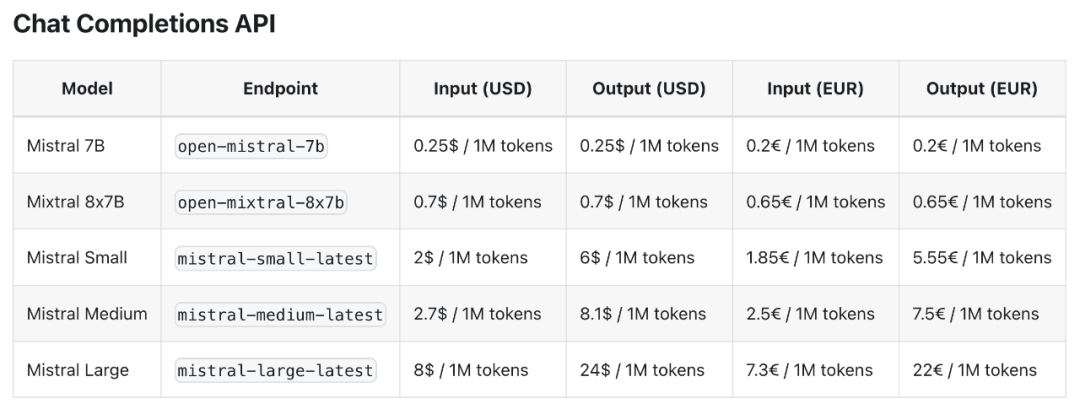

Mistral Large a obtenu de bons résultats dans plusieurs tests de référence, devenant ainsi le deuxième modèle le plus utilisé au monde via l'API, juste derrière GPT-4, et laissant derrière lui les autres modèles grand public.

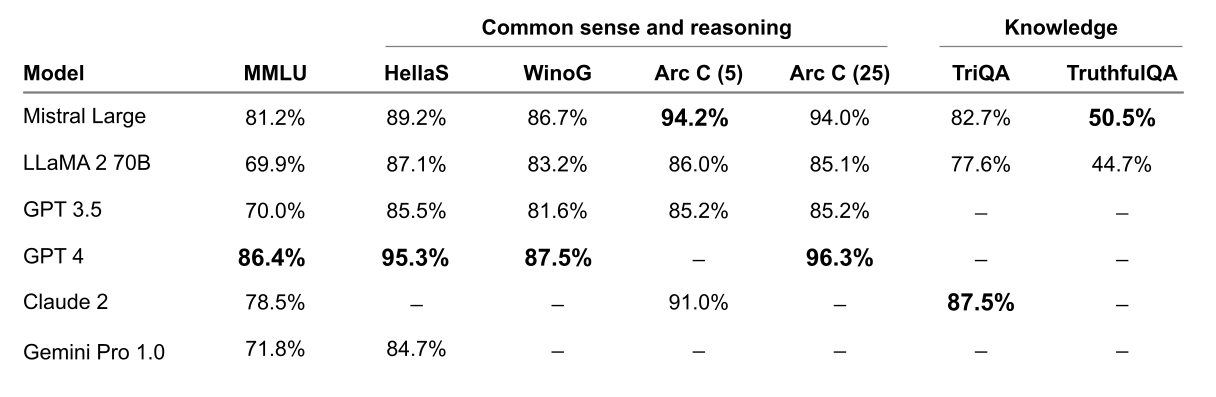

Comparé à LLaMA 2 70B, GPT-4, Claude 2, Gemini Pro 1.0 et à d'autres modèles grand public, Mistral Large fait preuve d'une grande force en matière de capacités de raisonnement.

Dans plusieurs benchmarks de bon sens et de raisonnement tels que MMLU, Hellas et WinoG, Mistral Large suit GPT-4 et dépasse de loin les autres modèles.

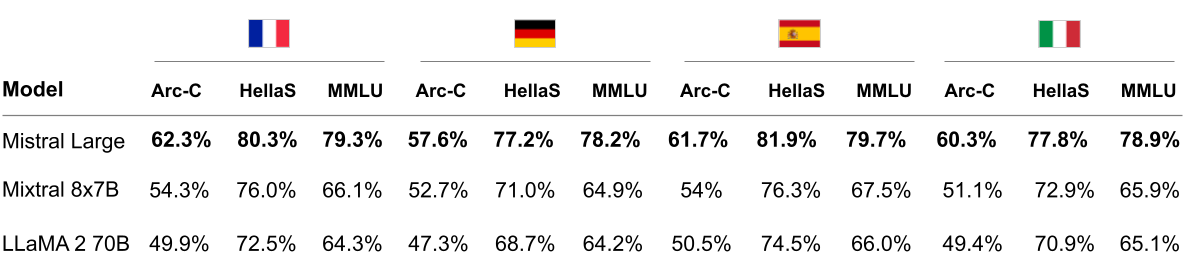

Mistral Large fonctionne nettement mieux que LLaMA 2 70B sur les benchmarks HellaSwag, Arc Challenge et MMLU en français, allemand, espagnol et italien.

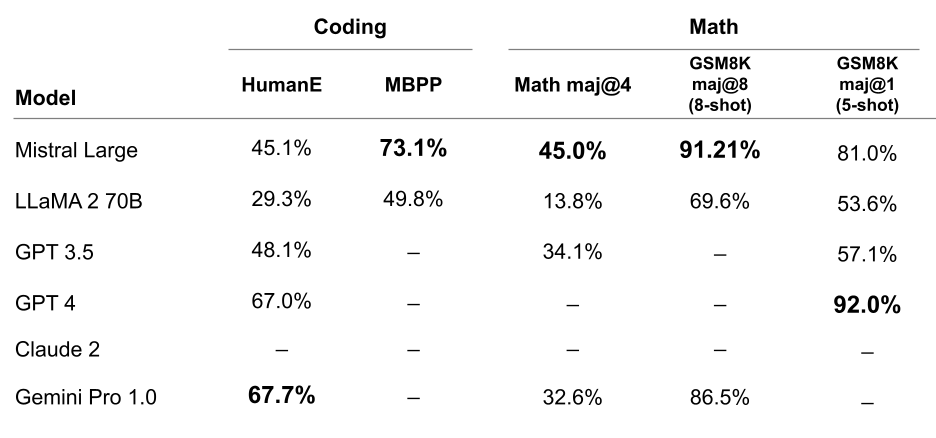

Mistral Large a également bien performé dans les tâches de codage et de mathématiques. De nombreux tests de référence sont encore loin devant.

De plus, Mistral AI a également publié un nouveau modèle optimisé pour la latence et le coût, Mistral Small, qui surpasse le Mixtral 8x7B en termes de performances mais a une latence plus faible.

Selon Mistral AI, Mistral Small constituera un choix intermédiaire idéal entre les modèles open source et phares, bénéficiant des mêmes avantages innovants que Mistral Large, notamment en termes d'activation RAG (Retrieval Augmentation Generation) et d'appels de fonctions.

Cependant, les caractéristiques de faible latence revendiquées par le modèle Mistral Small sont limitées par rapport au Mixtral 8x7B, mais son coût est considérablement augmenté, le coût d'entrée étant 2,8 fois plus élevé et le coût de sortie pouvant atteindre 8,5 fois.

Mistral Large est désormais disponible sur les plateformes La Plateforme et Azure, et intégré au Chat. Le Chat (littéralement traduit par chat en français) est un chatbot IA similaire à ChatGPT qui prend en charge la communication multilingue.

Les utilisateurs peuvent choisir entre trois modèles différents : Mistral Small, Mistral Large et Mistral Next. Cependant, Le Chat ne prend pas en charge la fonctionnalité de mise en réseau en temps réel.

Peu de temps après son lancement, Le Chat s'est écrasé en raison d'une foule plus nombreuse que prévu affluant vers l'expérience, et au moment de mettre sous presse, Le Chat est de nouveau opérationnel.

Nous avons également expérimenté Le Chat pour la première fois. En fonction de la complexité de la langue elle-même et de la quantité et de la qualité des données de formation qu'il reçoit, Le Chat est plus expressif en anglais et peut varier d'une langue à l'autre dans d'autres langues.

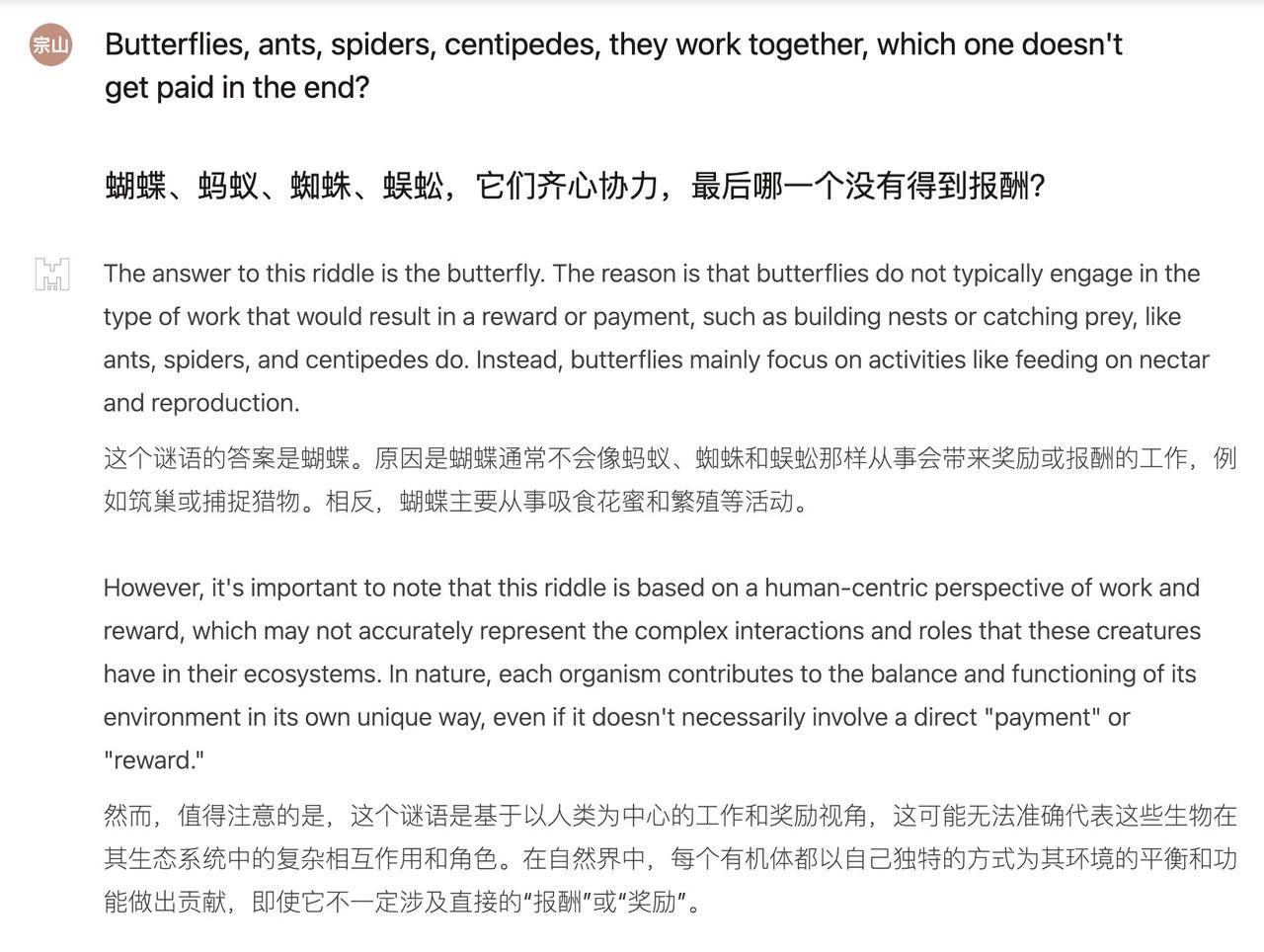

Face au casse-tête chinois, Mistral Large était visiblement un peu confus, et il ne répondit pas pendant un moment.

Question : Papillon, fourmi, araignée, mille-pattes, ils travaillent ensemble, lequel n'est finalement pas payé ?

Mais si vous le changez en anglais, il se transforme immédiatement en expert en résolution de problèmes. Les réponses sont claires et logiques, et il s'élève vers une « perspective de travail et de récompense centrée sur l'humain ». Cependant, les casse-tête dans le contexte chinois ne suivez pas le bon sens, après tout, "Centipede" n'est pas récompensé.

Le problème des poules et des lapins vivant dans la même cage n’est pas une mince affaire pour Mistral Large. Après avoir posé les équations linéaires, la réponse est sortie rapidement, mais les 16 poulets et 19 lapins dans la réponse étaient incorrects.

Question : Il y a des poules et des lapins dans la même cage, avec un total de 35 têtes et 94 pattes. Combien sont les poules et les lapins ?

Il s’agit d’un problème mathématique classique qui peut être résolu à l’aide d’un système d’équations linéaires.

En supposant que le nombre de poules est x et le nombre de lapins est y, les deux équations suivantes peuvent être énumérées :

1. x + y = 35 (le nombre total de poules et de lapins est de 35)

2. 2x + 4y = 94 (le poulet a 2 pattes et le lapin a 4 pattes, il y a donc 94 pattes au total)

Exprimez x dans la première équation en fonction de y pour obtenir x = 35 – y, et remplacez-le dans la deuxième équation pour obtenir :

2(35 – y) + 4y = 94

La résolution de l’équation nous donne y = 19. La substitution dans x = 35 – y nous donne x = 16.

Il y a donc 16 poules et 19 lapins.

Les deux dernières questions peuvent être résolues de la même manière : les réponses sont 16 poules et 19 lapins.

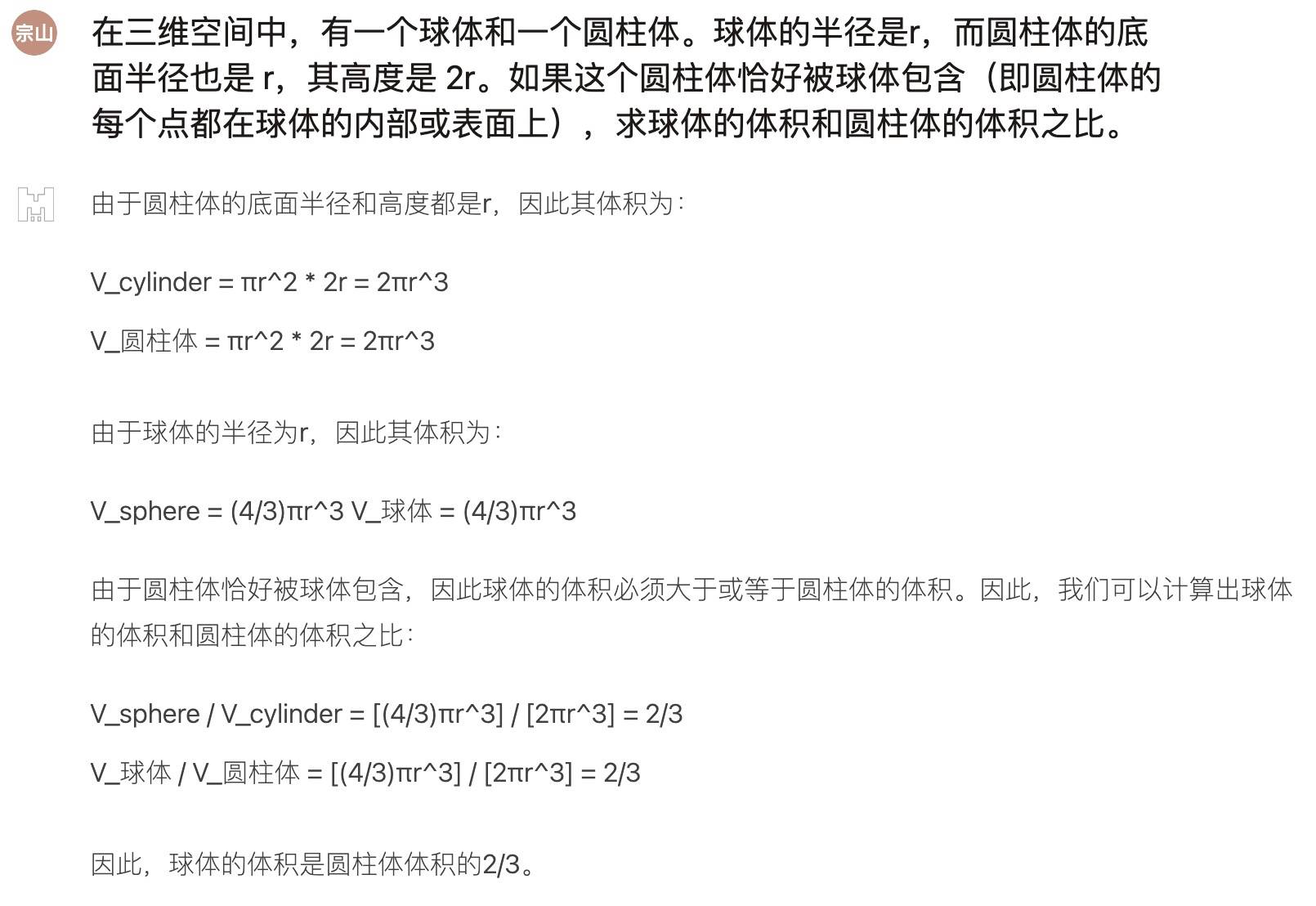

Ensuite, nous avons demandé à ChatGPT de poser à Mistral Large une question de test de mathématiques, qui était plus intense, mais la performance globale était bonne :

Petit modèle, grande réussite

Mistral AI a été fondée en mai de l'année dernière avec seulement 25 employés, mais son grand modèle de langage est déjà devenu célèbre sur Hugging Face.

Nous avions précédemment annoncé la sortie de Mixtral 8x7B. Une fois ce modèle lancé, il a instantanément fait exploser la communauté open source et a empêché d'innombrables développeurs de dormir la nuit.

Bien qu'il n'ait qu'une taille de paramètre de 46,7B, les performances du Mixtral 8x7B, qui sont bonnes en petits et grands, sont comparables à celles de Llama 2 70B et GPT-3.5 dans de nombreux tests de référence, et même légèrement meilleures dans certains tests.

Le secret du succès de Mistral AI réside dans son intégration intelligente des trois éléments fondamentaux du domaine de l’IA : le talent, les données et la puissance de calcul.

The Economist a révélé que les fondateurs et les piliers techniques de Mistral AI sont tous issus des instituts techniques d’élite français et ont accumulé une précieuse expérience industrielle dans les laboratoires de recherche de géants technologiques tels que Google et Meta. Ils sont l’un des rares experts au monde à maîtriser réellement la manière de former une technologie de pointe en matière de modèles.

Deuxièmement, les données sont une autre arme magique pour le succès de Mistral AI. Mistral est unique en matière de formation de données de modèle. Par exemple, le modèle peut filtrer efficacement les informations répétitives ou dénuées de sens, ce qui rend le modèle plus rationalisé et efficace, avec une échelle de paramètres de seulement des milliards.

Cela signifie que les utilisateurs ordinaires peuvent même facilement exécuter des modèles Mistral AI sur leur propre ordinateur personnel.

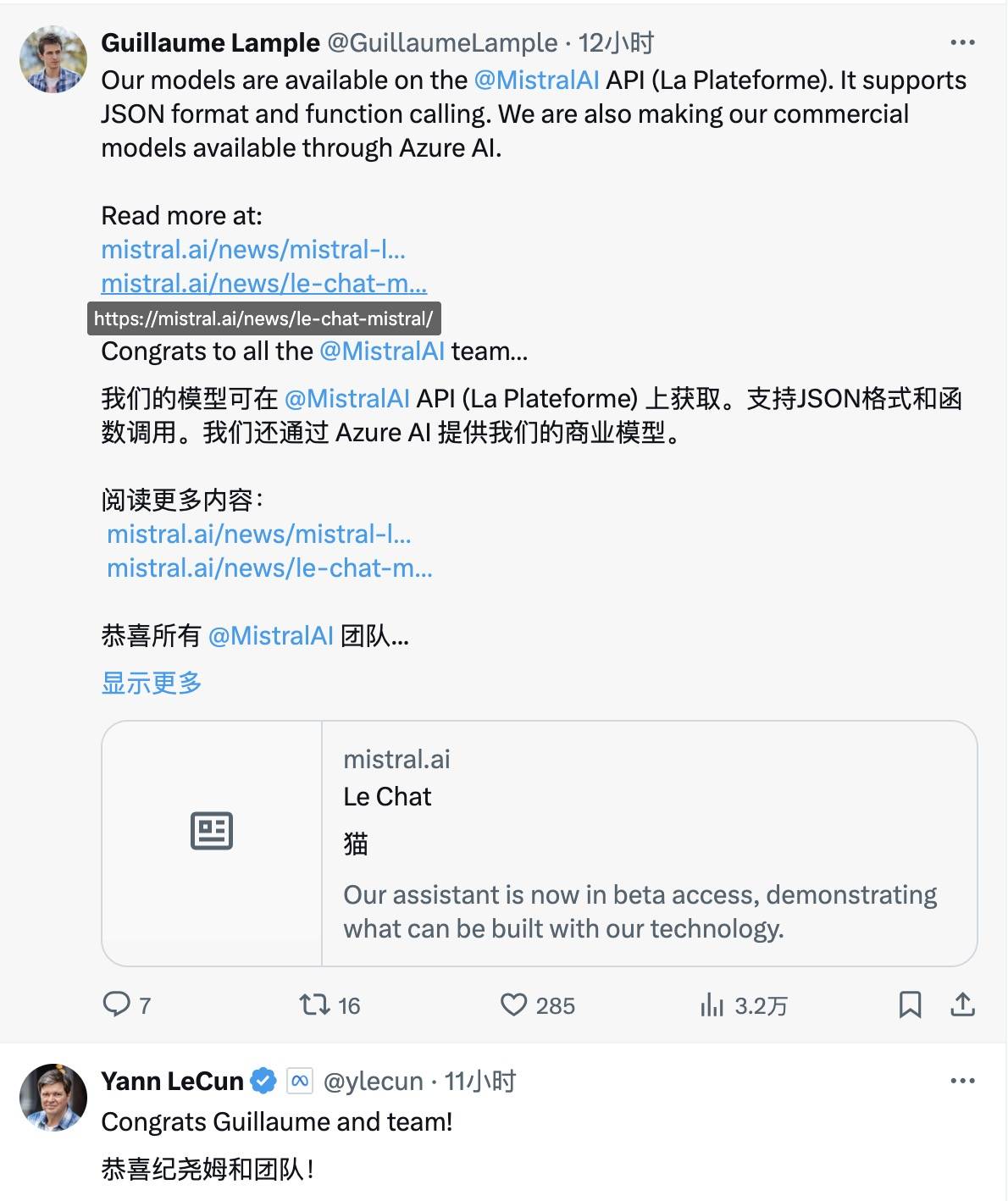

Pour l'arrivée de Mistral Large, Yann LeCun, lauréat du prix Turing, Jim Fan, scientifique principal de NVIDIA, et d'autres grands noms ont également envoyé leurs félicitations pour X.

À l'heure actuelle, la valorisation de Mistral AI dépasse les 2 milliards de dollars et la gamme d'investissements qui la sous-tend n'est pas inférieure à celle des plus grandes entreprises mondiales.

Des plus grandes sociétés de capital-risque aux États-Unis telles que Lightspeed Venture Capital, Redpoint Venture Capital et Index Venture Capital, aux géants du capital-risque de la Silicon Valley a16z, NVIDIA, Salesforce, BNP Paribas, etc., elles privilégient toutes Mistral AI. Après plusieurs tours de table, Mistral AI entre déjà dans le rang des licornes de l’IA.

Microsoft a également annoncé hier un nouveau partenariat avec Mistral AI, promettant que la coopération avec Mistral AI se concentrera sur les trois domaines clés suivants :

Infrastructure de supercalcul : Microsoft prendra en charge Mistral AI via l’infrastructure de supercalcul Azure AI pour les charges de travail de formation et d’inférence en IA.

Marché étendu : Microsoft et Mistral AI mettront les modèles avancés de Mistral AI à la disposition des clients via le catalogue de modèles MaaS et Azure Machine Learning dans Azure AI Studio.

R&D en IA : Microsoft et Mistral AI exploreront la collaboration pour développer des modèles propriétaires pour certains clients, même pour les charges de travail du secteur public européen.

Mais la décision de Microsoft a été remise en question par les internautes. L'utilisateur X @osxzxso a insinué que Microsoft tentait d'adopter une stratégie « complexe » pour monopoliser le marché. Musk a également exprimé son accord dans la section commentaires avec un emoji stupéfiant.

Je vois que je tartine du Nutella des deux côtés du pain

J'ai vu du beurre de cacahuète étalé des deux côtés du pain

Il convient de mentionner que des internautes attentifs ont observé qu'après le lancement du nouveau modèle par Mistral AI, le contenu pertinent de son site officiel concernant son engagement envers la communauté open source a discrètement disparu et le nouveau modèle ne prend pas en charge l'open source.

Cependant, Mensch, PDG de Mistral, a déclaré dans une interview au Wall Street Journal que Mistral AI n'avait pas violé l'intention initiale de l'open source, mais avait adopté une double stratégie consistant simultanément à promouvoir des stratégies de commercialisation et à maintenir ses engagements open source.

De toute évidence, nous devons trouver un juste équilibre entre la construction d’un modèle économique et le maintien de nos valeurs open source. Nous voulons inventer de nouvelles choses et de nouvelles architectures, mais aussi proposer à nos clients des produits plus commercialisables.

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo