Se défendre! La version Google de ChatGPT a fait ses débuts, avec une fonctionnalité pour « rouler » ChatGPT

On peut dire que Google est l'une des entreprises les plus averties en matière d'IA au monde. Elle a battu le champion du monde de Go with AI, traduit 133 langues et poussé les smartphones vers la photographie informatique. Presque tous les produits Google sont pilotés par l'IA.

Mais au cours des deux derniers mois, Google a été éclipsé par le chatbot ChatGPT d'OpenAI.

ChatGPT, qui peut parler comme un être humain, a complètement sorti le mot IA du cercle. La discussion sur l'IA est progressivement passée de "ce que l'IA peut faire" à "ce que l'IA ne peut pas faire d'autre".

Pas plus tard qu'hier, Microsoft a annoncé qu'il coopérerait avec OpenAI pour apporter une nouvelle version de la recherche Bing et du navigateur Edge avec des chatbots intégrés, en utilisant l'IA pour apporter une nouvelle expérience de recherche.

Le sens de Microsoft est clair : il veut contester le statut de Google en tant que "leader de la recherche", et rivaliser avec les meilleurs coups de l'autre partie.

Google, qui détient LaMDA, PaLM, Imagen et d'autres technologies d'IA, ne laissera naturellement pas Microsoft saisir si facilement l'opportunité des applications d'IA.

Lors de la conférence Google qui vient de se terminer, Google a démontré la nouvelle technologie d'IA qui sera appliquée à Google Lens, aux cartes, à la traduction et surtout à la recherche à l'avenir, en essayant de réoccuper les hautes terres de l'IA.

Parmi eux, le robot de chat Bard affiché ensemble est la contre-attaque la plus puissante contre ChatGPT, qui déclare également que le moteur de recherche est sur le point d'entrer dans l'ère des guerres de robots de chat. Maintenant, personne n'ira doucement dans cette bonne nuit.

Barde à ne pas sous-estimer

Avant de présenter Bard, autant comprendre brièvement le modèle LaMDA qu'il utilise.

Le modèle LaMDA publié par Google il y a deux ans a attiré une énorme attention dans l'industrie, et son influence n'est pas moindre que celle de ChatGPT aujourd'hui.

LaMDA est une nouvelle architecture d'IA qui rend l'apprentissage automatique plus simple, plus efficace et plus évolutif. Il peut évoluer jusqu'à des milliers de nœuds et prend en charge de nombreux types de tâches d'apprentissage automatique telles que la reconnaissance d'images, le traitement du langage naturel, etc.

Grâce à la formation, LaMDA peut parler à des personnes ayant une expression et une compréhension quasi humaines. Parce que LaMDA se comportait tellement comme un humain lorsqu'il discutait, un ingénieur de Google a même pensé qu'il avait une "conscience de soi", et cela a fait beaucoup de bruit.

C'est aussi une des raisons pour lesquelles Google n'a pas saisi l'opportunité des chatbots pendant cette période : ce n'est pas qu'il en soit incapable, mais que LaMDA est "fou" et même Google lui-même aura peur.

Cependant, Google sous-estimait encore l'acceptation de l'AIGC par les gens. La popularité soudaine de ChatGPT a sonné l'alarme pour Google, alors Bard a vu le jour.

Avant le lancement, le PDG de Google Sundar Pichai (Sundar Pichai) avait déjà annoncé l'existence de Bard sur son blog.

Bard fonctionne sur une version allégée du modèle LaMDA, qui, selon Google, réduit la quantité de puissance de calcul dont Bard a besoin, lui permettant de s'adapter à plus d'utilisateurs et d'obtenir plus de commentaires.

Contrairement à ChatGPT, qui est bloqué en 2021, Bard accepte les informations du dernier Internet, afin que Bard puisse fournir des réponses à ce qui se passe actuellement.En comparant la quantité d'informations pouvant être récupérées par les deux, Bard est une quantité supérieure à la classe ChatGPT.

En d'autres termes, Ai Faner ne devrait pas avoir à veiller tard pour coder les brouillons des conférences de presse à l'avenir, et demander simplement à Bard de produire un résumé de la conférence.

Selon l'affichage de Google lors de la conférence de presse, les utilisateurs peuvent directement poser des questions à Bard en langage naturel, au lieu de rechercher avec des mots-clés comme par le passé.

Si vous souhaitez acheter une nouvelle voiture, vous pouvez directement demander à Bard quel type de voiture convient à votre famille, et Bard vous donnera différentes suggestions d'achat de voiture du point de vue du budget et de la sécurité.

Si vous préférez les véhicules à énergies nouvelles, Bard vous proposera également des suggestions de nouveaux types d'énergies en contexte.

C'est aussi la caractéristique de Bard : répondre aux questions sous plusieurs angles, et forte capacité de compréhension du contexte.

À l'avenir, Bard sera également intégré à la recherche Google pour vous fournir des réponses plus rapidement.

Par exemple, si vous recherchez la question "Quelle est la meilleure constellation que vous pouvez voir lorsque vous observez les étoiles ?" dans l'affichage de démonstration de Google, Bart affichera les caractéristiques de plusieurs constellations et la méthode d'observation.

Google estime que l'intelligence artificielle n'a pas de réponse correcte unique (No One Right Answer) lorsqu'elle répond aux questions. Par conséquent, Bard répond aux questions des utilisateurs sous plusieurs angles et aide les utilisateurs à comprendre rapidement la situation globale, plutôt que de fournir une seule réponse unique comme ChatGPT. Il est préférable d'avoir une réponse correcte, apparemment correcte.

À en juger par la démo publiée par Google, Bard n'est pas tant un robot de chat qu'un assistant de recherche.

Quant à savoir si Bard possède la puissante capacité de génération de texte comme ChatGPT, il est encore difficile de juger à partir de l'affichage limité.

Voici la question qui préoccupe le plus les utilisateurs : quand Bard sera-t-il disponible ? Google a indiqué que Bard est toujours en phase de bêta interne et sera ouvert au public dans les prochaines semaines.A ce moment-là, Ai Faner en fera également l'expérience pour la première fois.

Google Traduction utilisé par 1 milliard de personnes

Google Traduction est peut-être l'un des produits de Google les plus utilisés en dehors de la recherche. Selon les données publiées par Google, plus d'un milliard de personnes dans le monde utilisent Google Traduction pour comprendre ce monde diversifié.

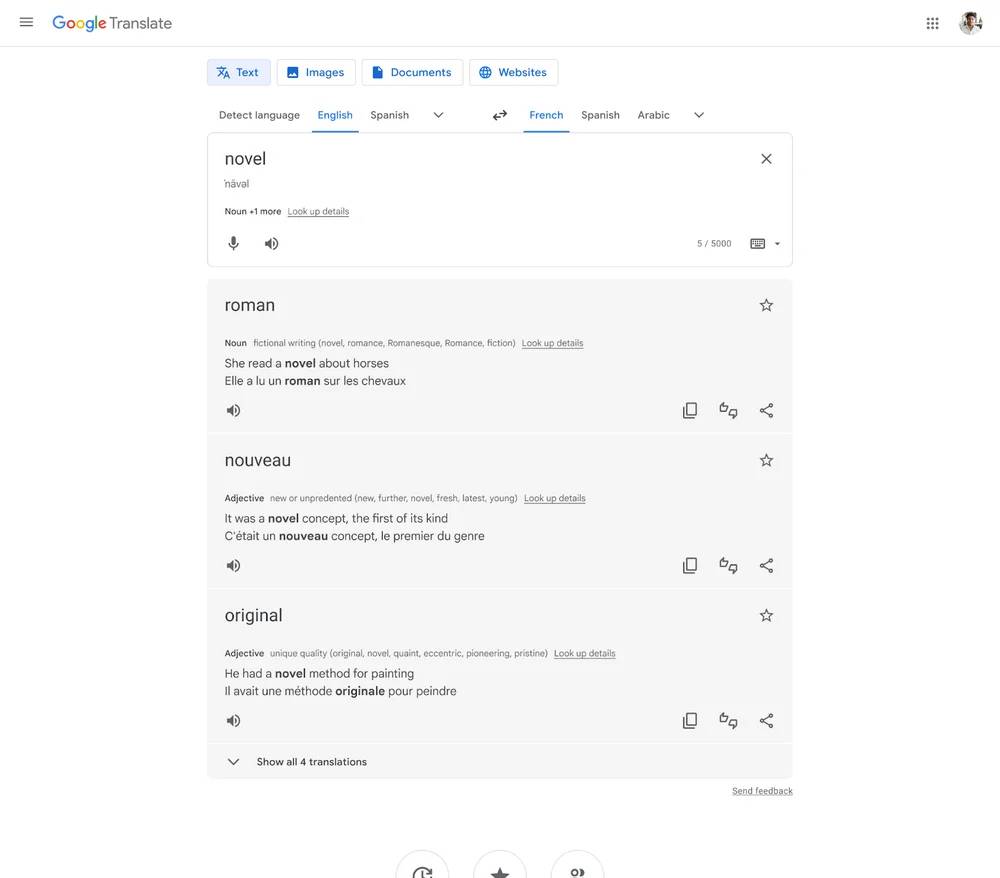

Afin d'aider les gens à mieux comprendre et utiliser des langues étrangères non familières, Google Translate fournit désormais non seulement la traduction de mots, mais fournit également plus d'informations contextuelles et pertinentes, telles que l'affichage simultané de plusieurs synonymes, exemples de phrases, etc.

La fonctionnalité sera disponible en cinq langues : anglais, français, allemand, japonais et espagnol, et devrait être disponible dans les prochaines semaines.

Google Translate du côté Android utilisera également un nouveau design plus lisible et plus facile à utiliser. La logique de fonctionnement plus simple rend la traduction plus facile et plus facile, et vous pouvez la gérer sereinement lorsque vous rencontrez des barrières linguistiques lorsque vous êtes loin de chez vous. Google a déclaré qu'il allait également repenser Google Translate du côté iOS à l'avenir.

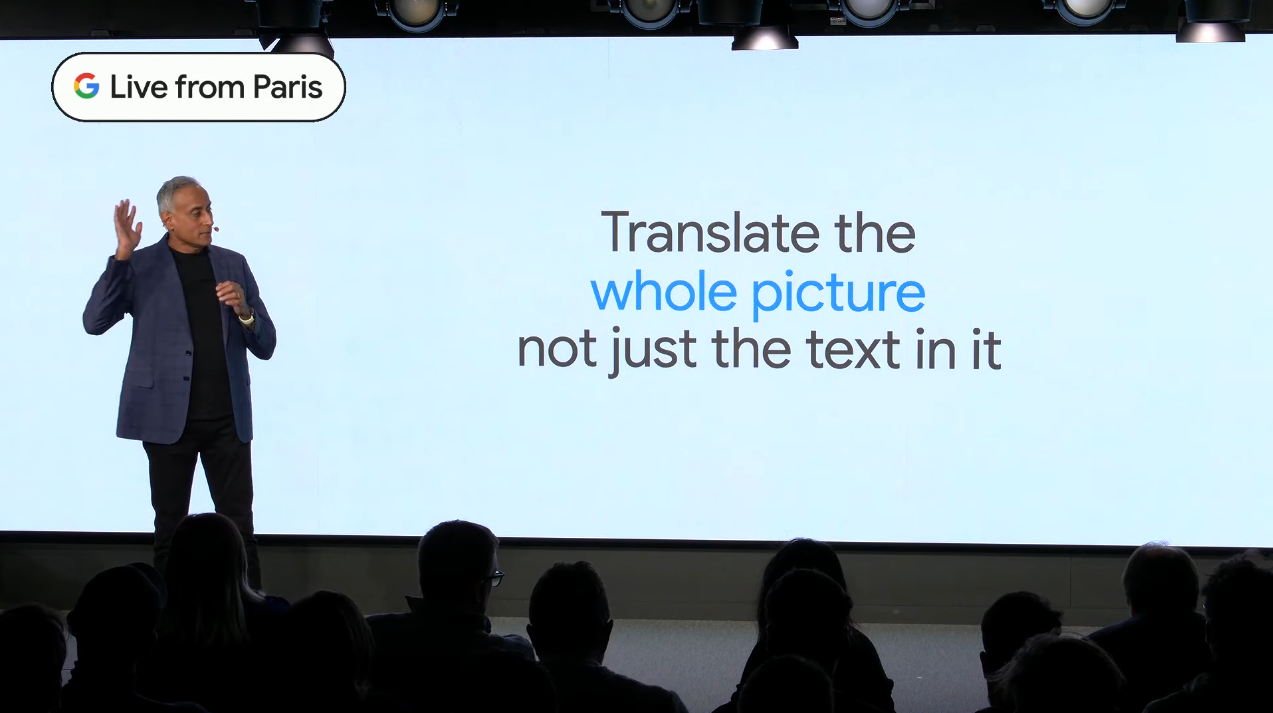

Une autre fonction importante de la mise à jour de Google Translate consiste à utiliser la capacité d'apprentissage de l'IA pour traduire plus précisément le texte en langue étrangère sur les images, et remixer le texte traduit et l'arrière-plan de l'image dans une nouvelle image, ce qui est meilleur que la fonction de texte en direct d'iOS. , Google souligne que plus de 6 Go de RAM sont nécessaires pour implémenter cette fonctionnalité.

déplacer la terre vers le nuage

La fonction Immersive View annoncée dès 2021 dispose désormais d'un modèle architectural plus détaillé, et la plage de rendu est large, déplaçant véritablement la terre entière vers le cloud. Dans le même temps, Immersive View combine également le système météorologique, qui restituera l'environnement en fonction des prévisions météorologiques, ce qui est plein d'immersion.

À partir d'aujourd'hui, la fonctionnalité sera disponible à Londres, Los Angeles, New York, San Francisco et Tokyo, et d'autres villes suivront dans les mois à venir.

Voyant cette démonstration, j'annonce unilatéralement que "Earth OL" sera officiellement lancé aujourd'hui. Bien que ce ne soit qu'une blague, c'est en effet une grande amélioration pour la piste Metaverse.

Un autre "projet d'infrastructure" métaverse est la combinaison organique d'éléments du monde réel et virtuels, souvent appelée "réalité augmentée". Google Map est également pris en charge, mais il n'est utilisé que sur les téléphones mobiles pour le moment.

Dans la rue, vous tenez votre téléphone portable et regardez autour de vous, le nom du magasin s'affiche à l'écran, cliquez sur l'un des magasins et vous pouvez afficher le contenu, y compris les heures d'ouverture, les évaluations des clients et les avis.

Ce n'est pas considéré comme innovant, mais les villes qui prennent en charge cette fonction se développent progressivement, et finalement le pont entre le virtuel et la réalité sera officiellement achevé. Jusque-là, il ne sera pas difficile d'obtenir une expérience similaire sur les lunettes AR.

Peut-être qu'à ce moment-là, Google Glass sera ressuscité pour terminer son travail inachevé.

Google a également annoncé lors de la conférence de presse que la fonction de navigation Google Map AR prendra en charge plus de 1 000 aéroports dans le monde, ce qui permettra aux voyageurs de trouver plus facilement leurs destinations avec plus de précision.

De plus, Google a enfin commencé à prêter attention aux propriétaires de voitures à énergies nouvelles.Pour les véhicules à énergies nouvelles avec fonction Google Map intégrée, il lancera à l'avenir la fonction de recommandation de bornes de recharge, ce qui est une bonne nouvelle pour les utilisateurs de voitures électriques. Cependant, les constructeurs automobiles nationaux et les fournisseurs de services de cartographie ont déjà lancé des fonctions similaires, et les fonctions sont assez complètes. Google doit encore suivre à cet égard.

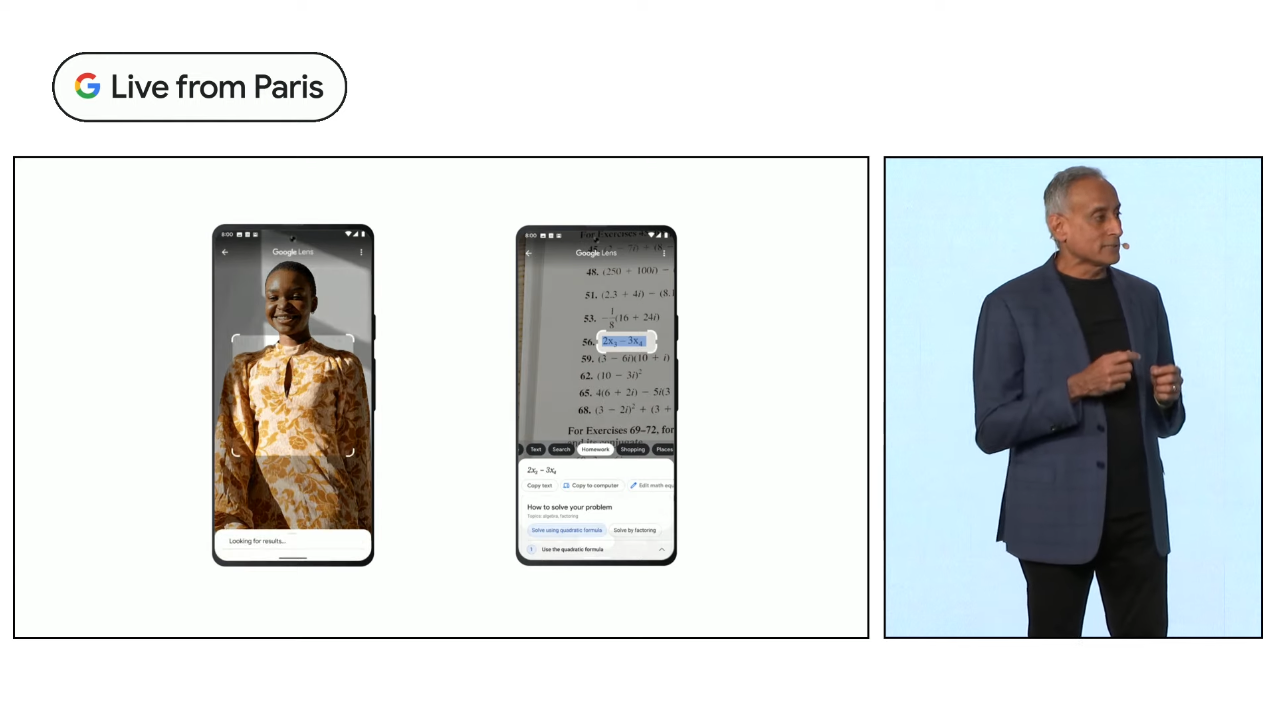

Google Lens, aussi bon que possible

Avant la combinaison de l'intelligence artificielle et des appareils photo, les objectifs des téléphones portables ne pouvaient être utilisés que pour prendre des photos, mais à l'ère de l'intelligence artificielle, les appareils photo des téléphones portables ont progressivement remplacé les yeux humains et ont la capacité de reconnaître le monde.

Sur cette base, Google Lens a vu le jour, comprenant l'identification des produits, la traduction de scènes réelles, l'identification des plantes, la recherche par reconnaissance de texte, etc., qui sont du ressort de Google Lens.

Avec l'aide d'un nouveau modèle d'IA, Google Lens a également inauguré un développement rapide.

La première est la fonction Search your Screen, que j'aimerais appeler une nouvelle interprétation de "ce que vous voyez est ce que vous obtenez".

Par exemple, si vous voyez un gâteau très délicieux sur Xiaohongshu, vous n'avez pas besoin de sortir de l'application actuelle, appuyez longuement sur le bouton d'alimentation pour réveiller Google Assistant, cliquez sur l'écran de recherche, vous pouvez trouver les informations de ce gâteau, puis associez-le à la nouvelle fonction "Recherche mixte (multirecherche)", vous pouvez rechercher des endroits à proximité où vous pouvez acheter ce type de gâteau et satisfaire votre appétit à temps.

Cette fonction de « recherche hybride » peut affiner davantage le contenu que vous souhaitez rechercher avec du texte sur la base de la reconnaissance d'image, afin d'obtenir des résultats plus précis et diversifiés.

C'est un peu comme la version image de ChatGPT, mais il manque la capacité de dialogue continu, et le résultat final peut ne pas être satisfaisant à chaque fois.

Cependant, dans cette petite mise à jour, nous pouvons également voir le potentiel de Google dans le modèle de langage naturel.Il pourrait être en mesure de proposer un outil AIGC complet avant ChatGPT, mais pas aujourd'hui.

La recherche est toujours un coup de lune

Prabhakar Raghavan, vice-président senior de Google, a commencé à présenter la mise à jour en faisant un point qui pourrait vous surprendre : la recherche est toujours un "projet lunaire".

Le moteur de recherche est maintenant très mature et c'est l'outil de base utilisé par la plupart des internautes au quotidien. Il est tellement simple, facile à utiliser et intuitif qu'il n'y a qu'une seule barre de recherche et que vous pouvez entrer directement ce que vous voulez savoir et cliquez pour rechercher.

Mais il est également très simple d'utiliser la méthode de recherche, ce qui rend très difficile d'augmenter la précision de la recherche sans augmenter la charge de l'utilisateur sur cette base. Il faut beaucoup d'efforts inédits aux moteurs de recherche pour vous faire passer à travers des couches d'informations inutiles afin de trouver la réponse lorsque vous effectuez une recherche.

Google travaille dans le domaine de la recherche depuis 25 ans, mais il ne peut toujours pas garantir que les utilisateurs puissent trouver les informations qu'ils recherchent à chaque fois qu'ils effectuent une recherche. Par conséquent, l'introduction de la recherche assistée par l'IA est particulièrement critique pour améliorer l'expérience utilisateur et éviter les répétitions inutiles. recherches.

Prabhakar Raghavan pense que Google aide les gens à se débarrasser des limites d'une seule méthode de recherche et d'une seule langue, à sortir du champ de recherche pour explorer un monde plus vaste et à remodeler le sens de la recherche, et ce n'est que le début.

Alors, dans quelle mesure les utilisateurs sont-ils satisfaits de la feuille de réponses basée sur l'IA donnée par Google ? Du point de vue boursier, au moment de mettre sous presse, le cours de l'action Google avait chuté de 7,68 %. Si Google veut continuer à assurer sa position de "leader de la recherche", Bard doit changer de moteur de recherche avec une longueur d'avance sur ChatGPT.

Remarque : Cet article a été rédigé conjointement par Huang Zhijian, Wang Zhishao et ChatGPT

#Bienvenue pour suivre le compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo