AWS facilite le développement d’applications d’IA pour les entreprises

L'avenir de l'intelligence artificielle se transforme rapidement en une expérience prête à l'emploi que les entreprises peuvent personnaliser en fonction de leurs besoins spécifiques. Des expériences de chat optimisées qui fonctionnent bien au-delà des questions-réponses et des outils pour créer des applications d'IA sans mois de développement de codage pourraient être la prochaine étape en dehors de l'introduction de nouveaux plugins et extensions .

Des outils plus courants, tels que ChatGPT pour les informations et Midjourney pour les images, s'appuient sur des données publiques et un codage de développeur cohérent pour créer un produit final. Pendant ce temps, Amazon Web Services (AWS) s'engage à rendre l'IA générative non seulement plus productive et plus facile à naviguer, mais également des données uniques et sécurisées pour les entreprises qui déploient ses outils.

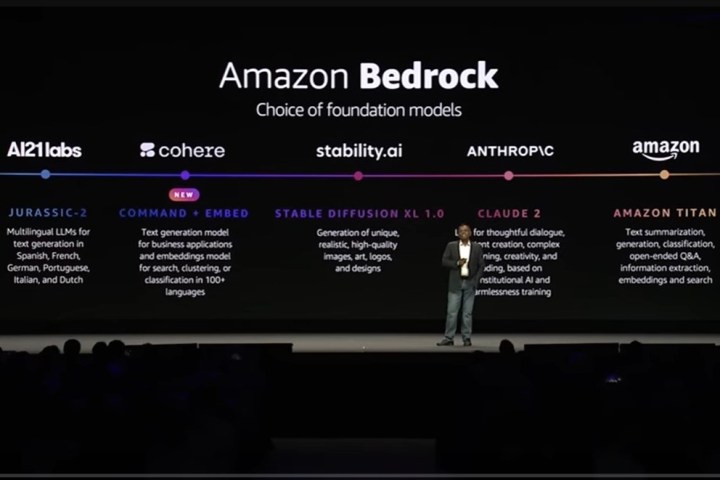

La marque utilise des plates-formes telles qu'Amazon Bedrock pour se tailler un espace unique sur le nouveau marché de l'IA. Son hub phare est disponible depuis avril et abrite plusieurs de ce qu'il appelle les Foundation Models (FM). AWS a initialement formé ces API de base et offre aux organisations les fonctionnalités d'IA standard qu'elles souhaitent. Les organisations peuvent mélanger et assortir leurs FM préférés, puis continuer à développer des applications, en ajoutant leurs propres données propriétaires pour leurs besoins uniques.

« En tant que fournisseur, nous entraînons essentiellement ces modèles sur un large corpus de données. Une fois le modèle formé, il y a un point limite. Par exemple, en janvier 2023, le modèle n'a plus aucune information après ce point, mais les entreprises veulent des données, qui sont privées », a déclaré Atul Deo, directeur général des produits et de l'ingénierie d'Amazon Bedrock, à Digital Trends.

Chaque entreprise et les modèles de base qu'elle utilise varient, de sorte que chaque application résultante sera unique en fonction des organisations d'informations qui alimentent un modèle. Les FM sont déjà des modèles de base. Utiliser ensuite des informations open source pour remplir les modèles peut rendre les applications répétitives d'une entreprise à l'autre. La stratégie d'AWS donne aux entreprises la possibilité de rendre leurs applications uniques en introduisant leurs propres données.

"Vous voulez également pouvoir poser des questions au modèle et obtenir des réponses, mais s'il ne peut répondre qu'à des questions sur certaines données publiques obsolètes, ce n'est pas très utile. Vous voulez pouvoir transmettre les informations pertinentes au modèle et obtenir les réponses pertinentes en temps réel. C'est l'un des principaux problèmes qu'il résout », a ajouté Deo.

Modèles de fondation

Les différents modèles de base pris en charge sur Amazon Bedrock incluent Amazon Titan, ainsi que des modèles des fournisseurs Anthropic, AI21Labs et StabilityAI, chacun abordant des fonctions importantes dans l'espace de l'IA, de l'analyse de texte, de la génération d'images et de la génération multilingue, entre autres tâches. Bedrock est une continuation des modèles pré-formés qu'AWS a déjà développés sur sa plate-forme Stagemaker Jumpstart, qui a été au rez-de-chaussée de nombreux FM publics, notamment Meta AI , Hugging Face, LightOn, Databricks et Alexa.

AWS a également annoncé récemment de nouveaux modèles Bedrock de la marque Cohere lors de son sommet AWS fin juillet à New York. Ces modèles incluent Command, qui est capable d'exécuter la synthèse, la rédaction, le dialogue, l'extraction de texte et la réponse aux questions pour les applications métier, et Embed, qui peut effectuer des recherches de cluster et classer les tâches dans plus de 100 langues.

Le vice-président de l'apprentissage automatique d'AWS, Swami Sivasubramanian, a déclaré lors du discours d'ouverture du sommet que les FM sont à faible coût, à faible latence, destinés à être personnalisés en privé, les données cryptées et ne sont pas utilisées pour former le modèle de base original développé par AWS.

La marque collabore avec de nombreuses entreprises utilisant Amazon Bedrock, notamment Chegg, Lonely Planet, Cimpress, Philips, IBM, Nexxiot, Neiman Marcus, Ryanair, Hellmann, WPS Office, Twilio, Bridgewater & Associates, Showpad, Coda et Booking.com. .

Agents pour Amazon Bedrock

AWS a également présenté l'outil auxiliaire Agents pour Amazon Bedrock lors de son sommet, qui étend les fonctionnalités des modèles fondamentaux. Destiné aux entreprises pour une multitude de cas d'utilisation, Agents est une expérience de chat augmentée qui aide les utilisateurs au-delà de la question et de la réponse standard du chatbot. Il est capable d'exécuter de manière proactive des tâches en fonction des informations sur lesquelles il est affiné.

AWS a donné un exemple de la façon dont cela fonctionne bien dans un espace commercial. Supposons qu'un client souhaitant échanger une paire de chaussures. En interagissant avec l'agent, l'utilisateur peut préciser qu'il souhaite effectuer un échange de chaussures d'une taille 8 à une taille 9. Les agents demanderont leur numéro de commande. Une fois entrés, les agents pourront accéder à l'inventaire de détail dans les coulisses, dire au client que la taille demandée est en stock et lui demander s'il souhaite procéder à l'échange. Une fois que l'utilisateur dit oui, les agents confirmeront que la commande a été mise à jour.

«Traditionnellement, faire cela demanderait beaucoup de travail. Les anciens chatbots étaient très rigides. Si vous dites quelque chose ici et là et que cela ne fonctionne pas, vous diriez de me laisser parler à l'agent humain », a déclaré Deo. "Maintenant, parce que les grands modèles de langage ont une compréhension beaucoup plus riche de la façon dont les humains parlent, ils peuvent prendre des mesures et utiliser les données propriétaires d'une entreprise."

La marque a également donné des exemples de la manière dont une compagnie d'assurance peut utiliser des agents pour déposer et organiser des réclamations d'assurance. Les agents peuvent même aider le personnel de l'entreprise à effectuer des tâches telles que la recherche de la politique de l'entreprise en matière de prise de force ou la planification active de ce temps libre, avec un style désormais connu d'invite d'IA, telle que « Pouvez-vous déposer une prise de force pour moi ? »

Les agents capturent en particulier la façon dont les modèles fondamentaux permettent aux utilisateurs de se concentrer sur les aspects de l'IA qui sont les plus importants pour eux. Sans avoir à passer des mois à développer et à former un modèle linguistique à la fois, les entreprises peuvent passer plus de temps à peaufiner les informations importantes pour leur organisation dans les agents, en s'assurant qu'elles sont à jour.

« Vous pouvez affiner un modèle avec vos données propriétaires. Au fur et à mesure que la demande est faite, vous voulez le dernier et le meilleur », a déclaré Deo.

Alors que de nombreuses entreprises continuent de s'orienter vers une stratégie d'IA plus centrée sur les affaires, l'objectif d'AWS semble simplement être d'aider les marques et les organisations à mettre en place plus rapidement leurs applications et services intégrés à l'IA. La réduction du temps de développement des applications pourrait voir un printemps de nouvelles applications d'IA sur le marché, mais pourrait également voir de nombreux outils couramment utilisés recevoir des mises à jour indispensables.