L’IA qui « se déshabille en un seul clic » ne laisse même pas partir les enfants

"Voyage spirituel" dit que lorsque vous recherchez l'océan, vous devez savoir que vous vivez déjà dans l'eau.

Il semble qu’il en soit de même pour l’IA dans la société humaine.

Depuis le début de cette année, « iPhone » est omniprésent dans tous les domaines. Runway transforme le silence en mouvement, Pika redessine des parties, HeyGen laisse les étrangers parler un chinois authentique, et vous chantez et j'apparais au milieu de la scène.

Dans le coin sans reflets, le Deepfake qui change de visage, apparemment ordinaire, étend son territoire, affectant tout le monde, des célébrités et présidents aux collégiens et même aux gens ordinaires. Ce n'est ni étonnant ni subversif, mais c'est suffisant pour nous faire transpirer.

Enlevez vos vêtements en un clic et évadez-vous complètement

"J'ai vu ta photo nue."

En septembre, le premier jour de la rentrée scolaire, un garçon s'est approché d'Isabel, 14 ans, et lui a dit ces mots. Le matin, les ragots étaient en effervescence sur le campus, les nouvelles se répandaient en groupes et les téléphones portables de presque tout le monde diffusaient des « photos explicites » de camarades de classe.

Il s'agit d'un véritable événement qui s'est produit dans le sud-ouest de l'Espagne et qui a fait connaître Almendralejo, une petite ville d'environ 30 000 habitants seulement, à l'échelle internationale. Il y a cinq collèges dans la ville, et des « photos de nus » ont circulé dans au moins quatre d'entre eux.

La cause de l'incident n'est pas compliquée : un groupe de garçons infâmes a téléchargé des photos de leurs camarades de classe sur les réseaux sociaux vers un outil d'IA de « décapage en un clic ».

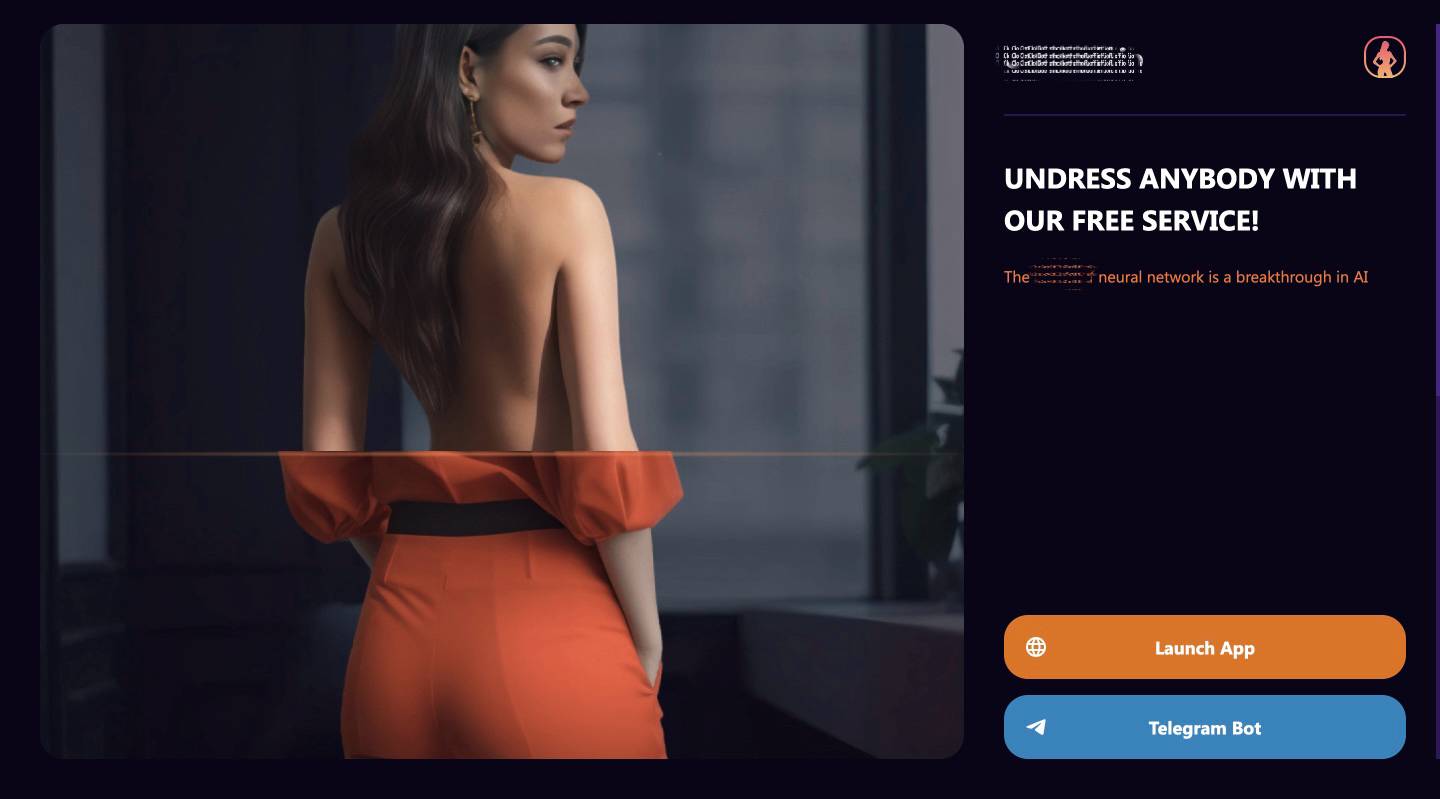

▲Les outils d'IA qu'ils utilisent.

Cet outil peut être utilisé via l'application mobile ou le logiciel de messagerie instantanée Telegram. Le slogan est "Déshabillez n'importe qui gratuitement", à condition que quelqu'un d'autre ait une photo dans l'album de votre téléphone portable.

Bien que cela soit dit gratuit, le prix pour créer 25 images de nus est de 10 euros, et le paiement peut être effectué avec Visa, Paypal, MasterCard, etc., tout aussi pratique qu'avec WeChat et Alipay en Chine, mais ces modes de paiement étaient désactivé après l’exposition médiatique.

La police espagnole a confirmé qu'il y avait au moins 30 victimes, principalement des étudiantes âgées de 12 à 14 ans. La plupart des initiateurs les connaissaient et étaient eux aussi mineurs : ils étaient au moins dix, certains même âgés de moins de 14 ans, et ne pouvaient pas faire face à des poursuites pénales.

Ils ont créé des discussions de groupe sur WhatsApp et Telegram pour diffuser ces « photos nues » et ont menacé leurs victimes via Instagram d'extorquer une « rançon » et de vraies photos nues.

La mère de l'une des victimes a senti son cœur s'emballer après avoir vu la "photo nue" de sa fille : "Cette photo a l'air réelle".

▲ Une mère a appelé davantage de victimes à se manifester.

En octobre, une situation similaire s'est produite dans un lycée du New Jersey, aux États-Unis, où il y a eu environ 30 victimes. Leurs camarades de classe masculins ont pris des "photos nues" pendant les vacances d'été. De nombreuses filles pleuraient de colère. L'une des victimes n'avait jamais pensé que Deepfake aurait un lien de parenté avec elle auparavant :

Je n’aurais jamais imaginé qu’en tant qu’étudiant, l’IA ne me traversait même pas l’esprit. J'ai juste l'impression que c'est comme un monstre sur Internet.

Le directeur a assuré que toutes les photos avaient été supprimées et ne seraient plus diffusées. L'initiateur a été suspendu de l'école pendant quelques jours et renvoyé sur le « lieu du crime » comme si de rien n'était.

De nombreux parents ne sont pas satisfaits de lâcher prise, mais ils ne peuvent rien faire. À ce jour, Deepfake reste une zone grise dans de nombreux endroits.

Aux États-Unis, les images Deepfake de mineurs sont interdites : en novembre, un pédopsychiatre de Caroline du Nord a été condamné à 40 ans de prison pour avoir filmé en cachette des patients et les « déshabiller » d'un seul clic.

Mais il y a des exceptions. Si l'agresseur est également mineur, l'école peut le traiter avec indulgence. Par exemple, dans ce lycée du New Jersey, la sanction est seulement une suspension. Un mois après l'incident, les victimes et leurs parents le font toujours. ne connaissent ni leur identité ni leur numéro.

Si la victime est un adulte capable de se protéger, la situation est plus compliquée : chaque État a des dispositions juridiques différentes, soit la criminalisant, soit en intentant des poursuites civiles, mais il n'existe actuellement aucune loi fédérale interdisant la production de pornographie Deepfake.

L’une des raisons pour lesquelles la législation est difficile est que certaines personnes pensent que même si le sujet de l’image Deepfake vous ressemble, ce n’est pas réellement vous, et votre vie privée n’est donc pas vraiment violée.

Cependant, tout le monde sait que même si les photos sont fausses, les blessures sont réelles et ne sont pas différentes des vraies photos de nus. Pour les parties impliquées et les passants qui ne connaissent pas la vérité, l'important n'est pas de savoir si les photos sont à 100 % réels, mais s'ils ont l'air réels.

L'ouvrage "Ghost in the Shell" de la fin du siècle dernier a déjà exploré ces questions. Quelqu'un qui vous ressemble exactement a fait quelque chose que vous ne feriez jamais, mais il vous est difficile de prouver que ce n'est pas vous, que les données, c'est vous, et que les traces d'existence, c'est vous.

Les farces des gens ordinaires, les téléphones portables sont des armes

Pour faire simple, deepfake utilise l’IA pour générer des vidéos, des audios ou des images apparemment réelles afin de simuler des choses qui ne se sont pas réellement produites.

Le Deepfake est apparu pour la première fois sur Reddit, la « version américaine de Tieba », en 2017. La principale forme consiste à remplacer les visages de célébrités par les protagonistes de vidéos pornographiques ou à usurper des personnalités politiques.

La première application d'IA pour le « déshabillage en un clic » pourrait être DeepNude en 2019. À cette époque, il fallait encore télécharger un logiciel compatible avec les appareils Windows 10 et Linux, et le serveur tombait en panne à cause d'un trop grand nombre de personnes.

Mais maintenant, « se déshabiller en un clic » est devenu plus facile et plus courant. Les services sont fournis sous forme d'applications et l'argent est gagné via des méthodes de paiement courantes. C'est devenu une farce jouée par des gens ordinaires à des gens ordinaires. C'est déjà arrivé dans les collèges et peut également se produire dans les collèges.

Avec juste une photo, une adresse e-mail et quelques dollars, vous pouvez enlever les « vêtements » de célébrités, de camarades de classe et d'étrangers par lots, et l'effet est encore plus difficile à distinguer entre le vrai et le faux. Les images utilisées pour se « déshabiller » sont souvent obtenues sur les réseaux sociaux sans le consentement de l’éditeur, puis diffusées à leur insu.

Le père d’une victime de deepfake âgée de 14 ans en Espagne a mis le doigt sur la tête :

Désormais, le smartphone peut être considéré comme une arme.

Alors que la loi est à la traîne, les plateformes technologiques réclamées par l’opinion publique ont apporté quelques remèdes, mais ils ne peuvent qu’éteindre l’incendie.

Google supprime les publicités pertinentes et optimise le système de classement, et m'aide également à supprimer le contenu pertinent après avoir fourni des preuves. TikTok bloque des mots-clés tels que « se déshabiller », Reddit interdit plusieurs noms de domaine et Telegram s'appuie sur la surveillance automatique et les rapports des utilisateurs pour supprimer le contenu qui viole les conditions de service…

Il n'y a aucun obstacle à craindre : le Deepfake s'est développé particulièrement rapidement cette année, comme s'il se trouvait sur le vaisseau de Musk.

Selon les statistiques de la société d'analyse des réseaux sociaux Graphika, rien qu'en septembre, les 34 plateformes de « déshabillage en un clic » ont enregistré au total plus de 24 millions de visiteurs, et les 52 groupes Telegram accédant au service de « déshabillage en un clic » contenus sur au moins 1 million d'utilisateurs.

L'équipe opérationnelle derrière ce projet est également très intelligente et comprend le marketing et la monétisation. Elle fait de la publicité sur les réseaux sociaux et recommande le service aux « personnes destinées ». Depuis le début de cette année, le nombre de liens publicitaires « one-click strip » sur X et Reddit a augmenté de plus de 2 400 %.

La maturité de la chaîne industrielle a conduit Graphika à la conclusion que Deepfake porte désormais le nom de famille « Niu Hulu », ce qui est complètement différent :

Les images de strip-tease générées par l’IA sont passées des forums de discussion pornographiques de niche aux entreprises commerciales en ligne à grande échelle.

Graphika estime qu'il existe une autre raison importante pour laquelle Deepfake a encore décollé cette année : la fonctionnalité du modèle de diffusion d'images IA open source continue de croître et il devient plus facile à utiliser.

Ces modèles open source ont contribué au marché des deepfakes « de haute qualité et à bas prix », faute de quoi les développeurs d'applications de « déshabillage en un clic » devraient héberger, maintenir et exécuter leurs propres modèles de diffusion d'images personnalisés, ce qui prend plus de temps et coûte plus cher.

Le FBI, qui a fait ses preuves dans les films d'enquête criminelle, ne pouvait pas rester les bras croisés : en juin de cette année, il a émis un avertissement soigneusement formulé pour inciter le public à faire attention aux images et vidéos pornographiques Deepfake, généralement diffusées publiquement sur les réseaux sociaux. ou des sites Web pornographiques et utilisés à des fins de harcèlement et d'extorsion. En fin de compte, un bon moyen est d'arrêter la perte à la source :

Une fois qu’un contenu est partagé sur Internet, il est extrêmement difficile, voire impossible, de le supprimer une fois qu’il a été diffusé ou publié par d’autres parties.

De vraies opportunités, du plaisir abstrait

ABC News a un jour interviewé une équipe qui a développé le « déshabillage en un clic » par e-mail, et la réponse de l'autre partie était difficile à commenter.

Ils affirment développer ce type d'application principalement pour s'amuser et l'utiliser pour traiter des photos d'eux-mêmes ou de leurs amis. Tout le monde l'apprécie et n'a plus honte de la nudité. De toute façon, tout est fait avec l'IA.

Alors pourquoi en réalité, les collégiens et autres agresseurs ne se moquent pas les uns des autres, ou ne demandent pas au préalable le consentement de la victime ? Les équipes ne doivent pas faire semblant d'être confuses parce qu'elles veulent vraiment se tenir à l'écart du monde. Pourquoi ne pas fournir ce type de service spécifiquement pour le team building de l'entreprise ? Laissez chacun mettre de côté sa honte, être motivé et traiter véritablement l'entreprise comme leur maison.

Mais c'est bien un point de vue. Si vous êtes nu, que les autres sont nus et que je suis nu, cela veut dire que personne n'est nu. Il n'y a pas lieu de paniquer quand vous verrez des photos nues à l'avenir. J'insiste sur le fait que l'IA va changer de visage, et le sourire passera. Il n'y a pas de concept de pornographie. A l'origine, Il n'y a rien, aussi poussiéreux soit-il.

Je ne sais pas quel genre de société avancée peut avoir une scène aussi harmonieuse. Quoi qu'il en soit, des statistiques récentes ont montré que même si tout le monde est égal lorsqu'il s'agit de se déshabiller, la plupart des services ne sont accessibles qu'aux femmes. Le service de « déshabillage en un clic » n’est donc pas d’un haut niveau et doit être teinté de genre.

Un simple « déshabillage en un clic » ne suffit pas à satisfaire vos envies.

En septembre de cette année, un Sud-Coréen d'une quarantaine d'années a été condamné à deux ans et demi de prison pour avoir utilisé l'IA pour générer environ 360 images pédopornographiques. Il a été accusé d'avoir violé la loi sur la protection de l'enfance et de la jeunesse. C’est la seule fois en Corée du Sud que cela a été fait. Les tribunaux nationaux ont condamné de tels cas d’IA.

Le Korea Herald a rapporté qu'il avait utilisé des mots rapides tels que « 10 ans », « nu » et « enfant » pour générer les images, que le tribunal a jugées suffisamment réalistes, rejetant l'argument de la défense selon lequel elles ne pouvaient pas être considérées comme de l'exploitation sexuelle.

Si le bricolage n'est pas possible, certains sites Web partageant des modèles d'IA proposent des services plus « réfléchis ». Si vous entrez le nom d'une célébrité dans la zone de texte et ajoutez « nu » et d'autres mots d'invite, vous obtiendrez une image floue pour aiguiser l'image. l'appétit et le salaire de l'utilisateur. Débloquez les enfants et les vieillards sans tromperie.

Certains praticiens de l'industrie pour adultes à l'œil perçant voient à la fois des dangers et des opportunités. L'IA peut les remplacer ou devenir leurs collègues.

Fanvue est une plateforme d'abonnement similaire à OnlyFans. Elle est très optimiste quant aux créateurs générés par l'IA car elle peut simplifier le processus et créer des personnages qui n'existent pas dans la réalité. C’est plus audacieux qu’une petite amie IA qui discute sous une couette, et plus original qu’un deepfake de célébrité.

▲ Photo de : Fanvue

L'un de leurs personnages IA, Emily Pellegrini, compte près de 120 000 abonnés sur Instagram et est également créatrice de contenu pour adultes. Elle a déjà gagné de l'argent sur Fanvue, gagnant plus de 9 600 $ en six semaines grâce aux abonnements, au contenu à la carte, etc.

Si cette tendance se poursuit, pourquoi Luo Ji, le wall-facer dans "The Three-Body Problem", se donnerait-il la peine de chercher son amant idéal Zhuang Yan dans un océan de gens ? Il explique également aux autres que cela fait partie du plan et il n’est pas difficile de le personnaliser.

En plus des plateformes regroupant un grand nombre de personnes, il existe également des travailleuses du sexe solitaires qui coopèrent activement avec AI parce qu’elles comprennent une vérité :

Si je ne participe pas, d'autres abuseront de mon image.

Il existe deux principaux modes de coopération : l'un est un chatbot qui parle de tout. Il est formé à l'aide de vidéos YouTube, de podcasts, d'interviews et de contenus restreints. Il facture un abonnement mensuel de plusieurs dizaines de dollars. L'autre est la personnalisation personnalisée. , allant du PG13 visible aux mineurs jusqu'aux 18+, vous vous contenterez de regarder les plats des gens.

Certains praticiens prennent également des précautions, dans l’espoir de proposer à l’avenir des expériences VR immersives et de répondre à des exigences auxquelles même de vraies personnes ne peuvent pas répondre.

Il n'y a rien de mal avec la nourriture et le sexe. Mustafa du « Meilleur des Mondes » a déclaré : « Les gens civilisés n'ont pas besoin d'endurer un quelconque inconfort. »

Mustafa est le personnage le plus sobre et impitoyable de ce roman dystopique. Il comprend tous les maux et toutes les souffrances, comprend que les barbares recherchent le droit de souffrir et sait comment faire en sorte que la grande majorité des gens vivent confortablement grâce à diverses méthodes. simuler les émotions nécessaires.

Si cela est inévitable, nous devrions au moins d’abord protéger les enfants autant que possible. Si la pornographie IA permet aux humains d’atteindre une grande libération du corps et de la honte, autant ajouter un rappel à l’œuvre : aucun humain réel n’est blessé dans le processus.

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo