Le robot OpenAI explose sur scène ! ChatGPT a enfin un corps, peut parler, lire et faire le ménage

Les grands modèles représentés par GPT-4 ont construit un cerveau, et la prochaine étape consiste à avoir besoin d'un corps de robot capable de transporter ce cerveau.

Tard hier soir, la société vedette de robots humanoïdes Figure AI a publié de manière choquante une vidéo montrant une série d'interactions conversationnelles effectuées par leur robot Figure 01 avec le soutien du puissant modèle d'OpenAI.

Le robot dans la vidéo montre des réponses de fonctionnement flexibles et sa capacité à communiquer avec les humains est presque comparable à celle de vraies personnes.

C'est moins d'un demi-mois après que Figure AI a reçu des investissements d'OpenAI, Microsoft, NVIDIA et d'autres sociétés. Cela m’a également permis de voir à quoi ressemblerait le grand modèle multimodal le plus puissant d’OpenAI avec un corps.

Figure 01, le robot humanoïde qui vous comprend le mieux ?

Grâce au puissant support du grand modèle multimodal d'OpenAI, Figure 01 est désormais un expert en reconnaissance d'objets sur table. Les pommes, les égouttoirs, les tasses et les assiettes sont un jeu d'enfant !

Lorsque vous avez faim et que vous souhaitez qu'il mange une bouchée entière, il comprendra instantanément vos pensées et vous tendra une pomme en douceur.

De plus, il peut même ramasser les déchets que vous avez jetés et vous expliquer pourquoi il vient de vous donner la pomme. À l'aide de grands modèles, la figure 01 peut comprendre le seul aliment sur la table : les pommes.

Sous les ordres d'un humain, Figure 01 peut également faire le ménage et ranger la vaisselle. Ce robot est tout simplement le meilleur partenaire dans la vie de famille.

Après avoir vu cette superbe vidéo, les internautes ont eu diverses réactions.

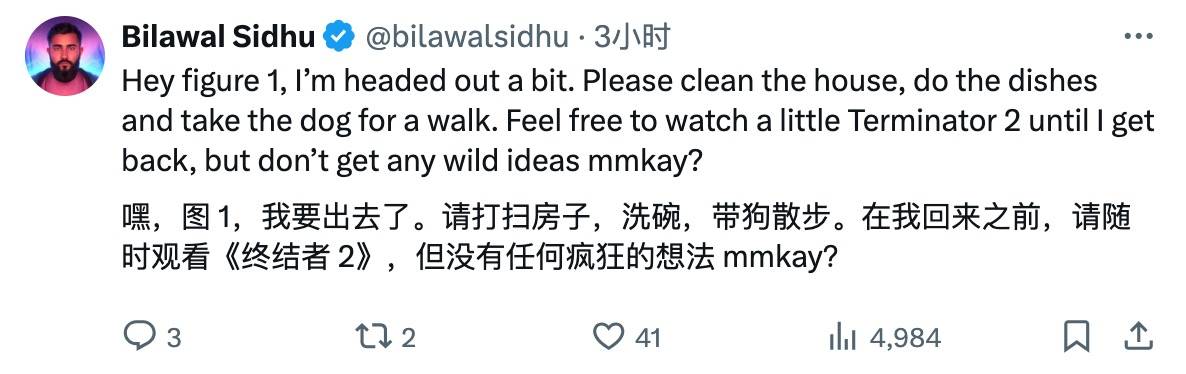

Les internautes ont hâte d'attribuer des tâches à la figure 01. Comment se fait-il que des films sur les prédécesseurs des robots soient mélangés à la liste des tâches.

Les concurrents ont-ils peur de voir cela, anxieux dans leur cœur, se préparant en secret à se préparer pour une grande compétition technique ?

Des internautes plus enthousiastes ont déclaré que l’aube de l’AGI semble approcher à grands pas.

Bien sûr, il y a toujours des voix critiques. Certains internautes se sont plaints, pourquoi ce robot bégaie-t-il ?

Les internautes n’ont pas non plus manqué l’occasion de plaisanter.

Brett Adock, le responsable de Figure AI, n'était pas disposé à être seul et a sauté sur X pour donner une merveilleuse interprétation.

La vidéo montre l'application des réseaux neuronaux de bout en bout. Aucune télécommande (téléopération) n'est utilisée pendant ce processus. La vidéo est tournée à vitesse réelle (vitesse 1,0x) et est continue.

Comme vous pouvez le voir dans la vidéo, la vitesse des robots s’est considérablement améliorée et nous atteignons progressivement des vitesses similaires à celles des humains.

Aucune télécommande requise, autodidacte

Alors, comment la figure 01 fait-elle ?

Corey Lynch, chef de l'équipe Figure AI, l'a expliqué sur X.

Plus précisément, tous les comportements démontrés dans la vidéo ont été appris (non contrôlés à distance) et exécutés à une vitesse réaliste (vitesse 1,0x).

Figure AI alimente les images capturées par la caméra du robot et le texte transcrit vocalement enregistré via le microphone intégré dans un modèle multimodal formé par OpenAI qui peut comprendre à la fois les informations d'image et de texte.

Le modèle traite l'intégralité de l'historique de la conversation, y compris les images passées, pour générer une réponse verbale et répondre à l'humain via la synthèse vocale. Le même modèle est également chargé de décider quel comportement appris en boucle fermée exécuter en réponse à une commande donnée. Il charge des poids de réseau neuronal spécifiques sur le GPU et exécute la politique correspondante.

La connexion de la figure 01 à un grand modèle multimodal pré-entraîné lui apporte de nombreuses nouvelles fonctionnalités intéressantes.

Désormais, Figure 01 + OpenAI peut :

- Détaillez ses environs.

- Utilisez un raisonnement de bon sens lorsque vous prenez des décisions. Par exemple, "Les articles sur la table, comme cette assiette et cette tasse, seront probablement ensuite placés sur le séchoir."

- Convertissez de vagues instructions de haut niveau, telles que « J'ai faim », en comportements adaptés à la situation, tels que « Passe une pomme à cette personne ».

- Expliquez en anglais simple pourquoi il effectue une action spécifique. Par exemple, "C'est le seul élément comestible que je peux offrir sur la table".

Lorsqu’il s’agit des compétences pratiques que la Figure 01 a maîtrisées grâce à l’apprentissage, elles reposent en fait sur une série de principes complexes et subtils.

Tous les comportements sont pilotés par la stratégie de conversion vision-moteur du réseau neuronal, qui mappe directement les pixels de l’image aux actions. Ces réseaux reçoivent des images intégrées au robot à une fréquence de 10 images par seconde et génèrent 200 mouvements à 24 degrés de liberté (y compris les poses du poignet et les angles des articulations des doigts) 200 fois par seconde.

Ces mouvements servent de « points de consigne » à grande vitesse pour le suivi par des contrôleurs complets du corps à plus grande vitesse, garantissant une exécution précise des mouvements.

Cette conception permet une séparation efficace des préoccupations :

- Les modèles Internet pré-entraînés effectuent un raisonnement de bon sens sur des images et du texte pour générer un plan de haut niveau.

- La stratégie visuo-motrice apprise exécute ce plan, en effectuant des comportements rapides et réactifs difficiles à spécifier manuellement, comme manipuler un sac déformable dans n'importe quelle position.

- Dans le même temps, le contrôleur complet du corps est chargé d'assurer la sécurité et la stabilité des mouvements, par exemple en maintenant l'équilibre du robot.

Concernant les grands progrès réalisés par la Figure 01, Corey Lynch a déploré :

Il y a quelques années à peine, j'aurais pensé qu'avoir une conversation complète avec un robot humanoïde capable de planifier et d'exécuter de manière autonome les comportements appris prendrait des décennies dans le futur. De toute évidence, beaucoup de choses ont radicalement changé.

Serait-ce le moment GPT des robots humanoïdes ?

Il faut dire que la vitesse de développement de la figure 01, c'est comme appuyer sur l'accélérateur et courir jusqu'au bout.

En janvier de cette année, Figure 01 a maîtrisé l'art de préparer le café, grâce à l'introduction d'un réseau neuronal de bout en bout, permettant au robot d'apprendre et de corriger les erreurs de manière autonome, avec seulement 10 heures de formation.

Un mois plus tard, Figure 01 avait appris la nouvelle compétence consistant à soulever des cartons et à les livrer sur un tapis roulant, bien qu'à seulement 16,7 % de la vitesse des humains.

Au cours de ce processus, le rythme de commercialisation de Figure AI ne s'est pas arrêté : elle a signé un accord commercial avec BMW Manufacturing Company pour intégrer la technologie de l'IA et de la robotique dans la chaîne de production automobile et s'est installée dans l'usine BMW.

Puis, il y a à peine deux semaines, Figure a annoncé la finalisation d'un cycle de financement de série B de 675 millions de dollars, la valorisation de l'entreprise s'élevant à 2,6 milliards de dollars.

Les investisseurs couvrent près de la moitié de la Silicon Valley – Microsoft, OpenAI Venture Fund, NVIDIA, Jeff Bezos, Parkway Venture Capital, Intel Capital et Align Ventures, etc.

À cette époque, OpenAI et Figure ont également annoncé qu'ils développeraient conjointement le modèle d'IA de robot humanoïde de nouvelle génération. Le modèle multimodal d'OpenAI sera étendu à la perception, au raisonnement et à l'interaction des robots.

Désormais, à partir de la figure 01, il semble que nous puissions entrevoir une ébauche de la vie future.

En fait, avant les grands modèles, les robots étaient des équipements spécialisés. Aujourd'hui, avec les capacités générales des grands modèles, les robots généraux commencent à apparaître. Désormais, nous avons non seulement besoin de ChatGPT, mais aussi de WorkGPT.

Ces évolutions confirment indirectement une voie clairement visible : une fois que le grand modèle d’IA aura pris racine, il finira par entrer dans le monde réel, et l’intelligence incarnée est la meilleure voie.

Le fondateur de Nvidia, Jensen Huang, qui a été actif en première ligne de l'IA, a déclaré un jour : « L'intelligence incorporée sera à la tête de la prochaine vague d'intelligence artificielle ».

L'intégration du grand modèle OpenAI dans la figure 01 est également une disposition stratégique intentionnelle.

Les grands modèles d'IA matures agissent comme des cerveaux artificiels, simulant le réseau neuronal complexe du cerveau humain, réalisant des fonctions cognitives telles que la compréhension du langage, la reconnaissance visuelle et le raisonnement situationnel, et résolvant des problèmes cognitifs et décisionnels de niveau supérieur pour les robots.

Dans le même temps, divers capteurs, actionneurs et unités informatiques sont intégrés au corps du robot pour réaliser la perception et l'interaction avec l'environnement. Par exemple, les systèmes de vision peuvent capturer des images et des vidéos, et les capteurs tactiles peuvent détecter la forme et la texture des objets.

Le fondateur de Figure AI, Brett Adcock, a précédemment déclaré dans une interview qu'au cours des 1 à 2 prochaines années, Figure AI se concentrera sur le développement de produits phares et espère démontrer au public les résultats de la recherche et du développement de robots humanoïdes au cours des deux prochaines années. couvrant les systèmes d'IA, le contrôle de bas niveau, etc., et enfin émerger un robot capable de montrer ses talents dans la vie quotidienne.

Il a également révélé qu'en termes de coût, un robot humanoïde comporte environ 1 000 pièces et pèse environ 150 livres (68 kg), tandis qu'une voiture électrique peut contenir environ 10 000 pièces et peser entre 4 000 et 5 000 livres (1 800 à 2 250 kg). Par conséquent, à long terme, le coût des robots humanoïdes devrait être inférieur à celui des voitures électriques bon marché, en fonction du coût des actionneurs, des composants du moteur, des capteurs et des coûts informatiques.

L'expert en robotique Eric Jang a un jour exprimé son point de vue : "Bien que de nombreux chercheurs en IA pensent qu'il faudra des décennies pour que les robots universels deviennent populaires, n'oubliez pas que ChatGPT est né presque du jour au lendemain."

Il y a un an aujourd'hui, OpenAI publiait GPT-4, prouvant au monde la puissance des grands modèles.

Aujourd’hui, un an plus tard, nous n’avons pas attendu GPT-5, mais nous avons également accueilli la Figure 01. Sera-ce le moment GPT-4 pour les robots humanoïdes ?

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo