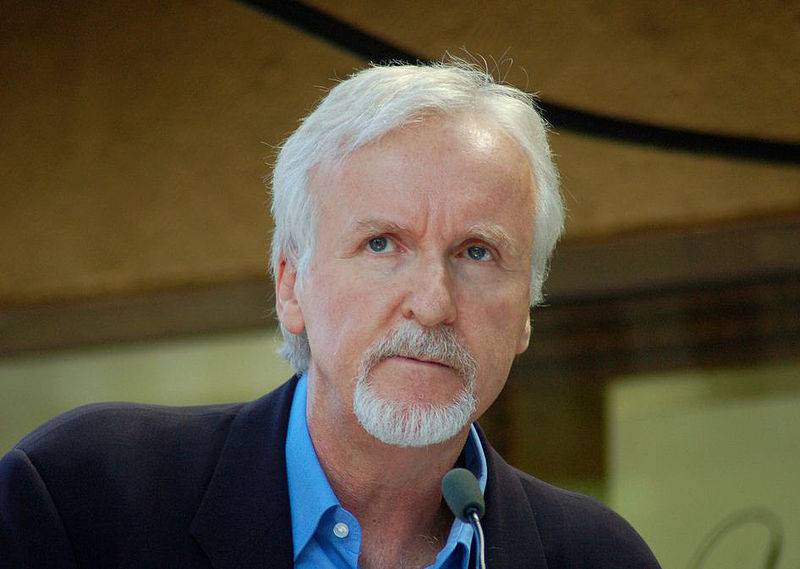

Le réalisateur James Cameron : AGI est une « bombe à retardement »

Le 23 octobre, le célèbre réalisateur, scénariste et producteur canadien James Cameron a prononcé un discours vidéo pour le Sommet sur l'intelligence artificielle et la robotique du SCSP (Special Competitive Studies Project, Special Competitive Studies Project), qui s'est tenu à Washington.

Dans son discours, Cameron a déclaré qu'en tant que « conteur » et « pionnier de la tendance CGI (Computer-Generated Imagery, images générées par ordinateur) », il aime l'IA et la technologie robotique et est prêt à « embrasser activement le changement ». Appliquez la technologie de l’IA à la future production cinématographique.

Cependant, étant donné que l'IA « n'a ni émotions ni conscience », Cameron a exprimé davantage d'inquiétudes concernant l'IA et la technologie AGI dans son discours, en particulier les considérations éthiques dans ses applications militaires et le risque de perte de contrôle d'AGI à l'avenir.

Ses opinions sont assez radicales et pointues : l'AGI conduira inévitablement à une collision entre civilisation et moralité .

D'un point de vue anti-guerre et humanitaire, Cameron a critiqué la « pseudo-moralité régionale » et a estimé que la clé réside dans la manière de donner à ces systèmes d'IA des contraintes morales appropriées et de développer des normes morales mondiales unifiées.

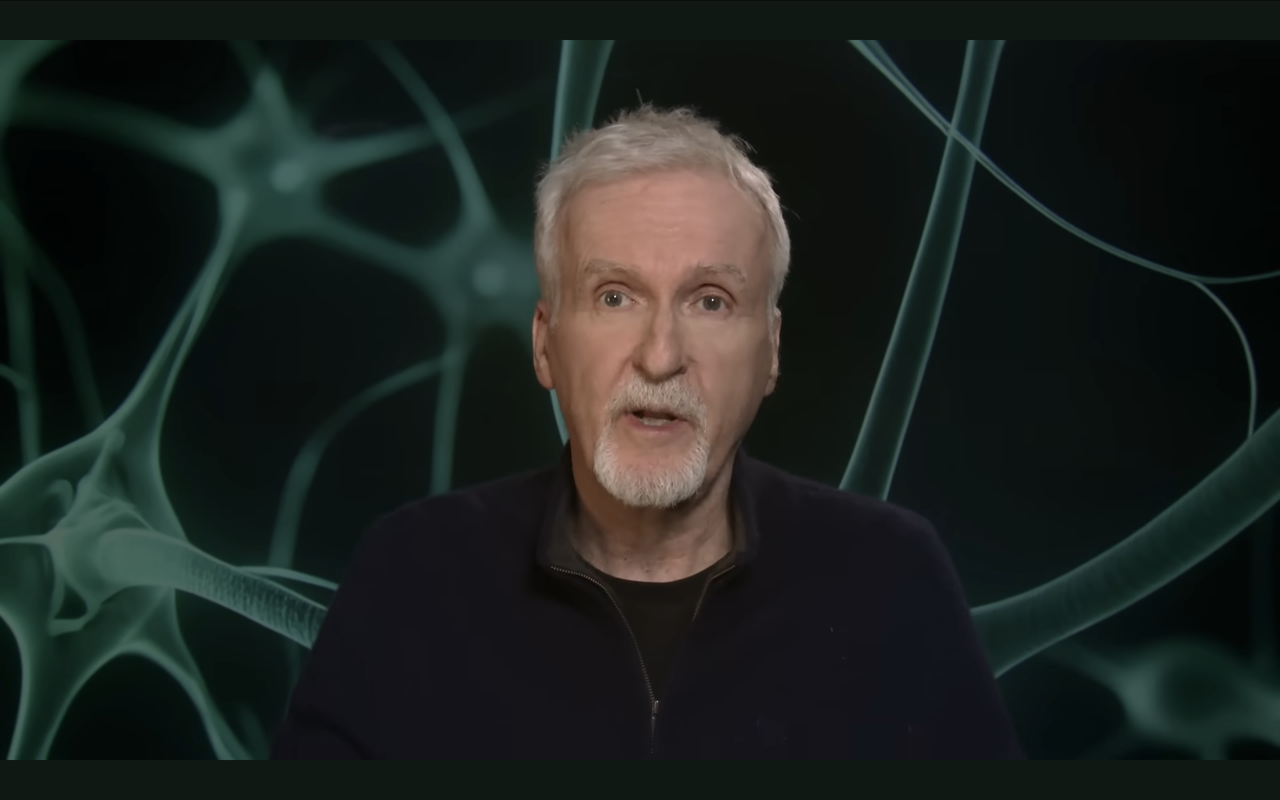

▲Le réalisateur James Cameron a prononcé un discours vidéo

En tant que « miroir pour nous », Cameron estime que l'AGI reflète le bien et le mal de la société humaine. Le mal ne manque pas dans le monde humain et il n'y a pas de consensus sur la justice. Par conséquent, Cameron est prudemment optimiste quant au développement de la technologie AGI.

Lien vidéo du discours original :

Voici les principaux points de Cameron dans son discours :

- L'IA n'a ni émotion ni conscience et ne porte aucun jugement moral sur ses adversaires sur le champ de bataille ;

- L’introduction de l’IA conduit à la « gamification » de la guerre, la transformant en une confrontation entre superintelligences sans conséquences émotionnelles profondes ;

- L’AGI d’écriture de code auto-améliorée mènera inévitablement à la superintelligence ;

- L’AGI conduira inévitablement à une collision entre civilisation et moralité ;

- L’AGI permettra au capitalisme de surveillance de se transformer rapidement en totalitarisme numérique ;

- AGI est un miroir du monde humain, reflétant à la fois les aspects positifs et négatifs de la société humaine.

Voici le texte intégral du discours compilé par l'APPSO :

Bonjour à tous, je m'appelle James Cameron et je suis actuellement en Nouvelle-Zélande, où je termine le tournage de "Avatar 3".

Eh bien, je ne suis ni chercheur ni expert en intelligence artificielle ou en robotique. Je ne suis qu'un conteur, mais je suis ici aujourd'hui parce que ma passion pour l'IA et la robotique s'étend bien au-delà du grand écran.

Je suis fasciné par la technologie, la façon dont elle façonne notre monde, son avenir et son impact sur la société. Depuis que je suis enfant, je lis tous les livres de science-fiction que je peux trouver.

Je repousse moi-même les limites de la technologie en tant que moyen de narration et en tant qu'explorateur.

J'ai conçu des véhicules robotisés pour mes expéditions en haute mer, mais ils étaient télécommandés et ne faisaient pas appel à l'intelligence artificielle. La convergence actuelle de l’IA et de la robotique constitue l’une des avancées technologiques les plus passionnantes de ma vie.

Nous ne construisons plus seulement des machines qui exécutent des commandes, mais concevons des systèmes capables d’apprendre, de s’adapter et même d’évoluer eux-mêmes. Je suis un fervent partisan des changements que l’intelligence artificielle et la robotique peuvent apporter à la société dans son ensemble, en particulier dans deux domaines qui me passionnent personnellement : l’art et la narration, ainsi que la science et l’exploration.

Je ne pense pas qu'il faille être un Luddite. Je vois beaucoup de mes pairs d'Hollywood se comporter comme une foule avec des torches et des pioches, mais une fois que le génie est sorti de la bouteille, il ne peut plus y être remis.

Je suis donc très ouvert au changement et je suis prêt à être à l'avant-garde de l'application de l'IA à ma narration, tout comme je l'étais il y a 32 ans lorsque j'ai fondé la première entreprise pionnière d'effets entièrement numériques.

▲Digital Domain, la société d'effets spéciaux entièrement numérique fondée par Cameron

Mais la raison pour laquelle je suis ici aujourd'hui est que je suis le créateur de Skynet.

Il y a quarante ans, j’ai photographié le Terminator, qui est récemment devenu l’illustration d’une IA détraquée. Chaque fois que je vais à certaines conférences sur l'IA, tant que je lève la main, les chercheurs rient avant même de dire quoi que ce soit, car le « problème Skynet » est en effet un problème digne d'attention, et je peux le lire dans des articles presque tous les jours. journée à des discussions connexes.

▲Le film classique de science-fiction "The Terminator" réalisé par Cameron

Ce groupe de recherche se concentre sur la sécurité nationale, qui a d’énormes implications pour l’intelligence artificielle et la robotique.

Les robots, quelle que soit leur forme, qu’il s’agisse de véhicules à roues, de drones aériens ou de machines ambulantes, sont une forme physique d’intelligence artificielle. Vous donnez à un moteur de décision la capacité d’agir physiquement dans le monde réel.

Je suppose qu’aujourd’hui, l’accent est mis sur les plates-formes mobiles plutôt que sur l’IA contrôlant les réseaux électriques ou les robots industriels fixes. Nous parlons de plateformes capables de prendre des décisions de manière autonome, c’est-à-dire d’intelligence synthétique incorporée.

Cela pourrait être aussi simple qu'une amibe, vous savez, comme un Roomba, ou finalement plus complexe, au point où cela pourrait théoriquement inclure la vraie conscience, quelle qu'elle soit.

Nous sommes tous d’accord sur le fait qu’il s’agit d’une AGI (Intelligence Générale Artificielle) qui est consciente d’elle-même, égocentrique et déterminée. Nous avançons sur une courbe plus abrupte, avec des puces plus rapides et plus denses et une puissance de calcul toujours croissante, tandis que les capacités des plates-formes de machines croissent sur une courbe tout aussi abrupte.

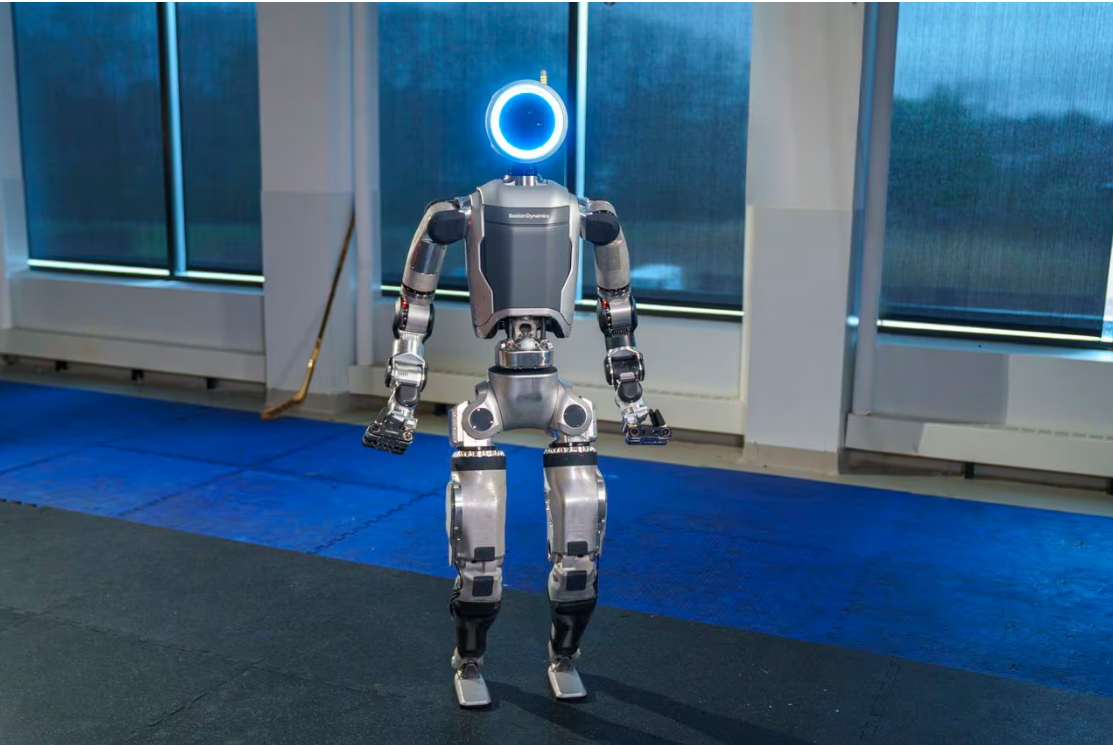

Comme le robot dansant de Boston Dynamics. Vous savez, des robots à deux ou quatre pattes qui dansent. Quelle exposition étonnante.

▲Le robot dansant « Atlas » développé par Boston Dynamics

En conséquence, les robots pilotés par l’IA peuvent gérer des situations complexes et peuvent même désormais posséder des émotions semblables à celles des humains, les LLD (dispositifs logiques de bas niveau) leur donnant la capacité de simuler la cognition et d’interagir naturellement avec les gens.

L’IA incarnée peut être une infirmière, un robot taxi, un soignant pour personnes âgées, une nounou pour enfants ou un enseignant. Il pourrait s’agir d’un robot cherchant et secourant les décombres d’un tremblement de terre, ou d’un drone dessinant dans le ciel la signature thermique d’un randonneur disparu. Il pourrait s’agir d’une plateforme d’armes fonctionnant de manière autonome sur le champ de bataille, recherchant la signature thermique des combattants ennemis.

La question qui se pose est la suivante : les plateformes autonomes devraient-elles avoir le pouvoir de tuer à leur propre discrétion ?

La guerre en Ukraine nous montre l’avenir de la manière la plus sombre possible. Il existe une utilisation généralisée de drones aériens mortels, certains produits de consommation coûteux et d’autres bon marché.

Ils ont largué des roquettes qui ont détruit des chars et même des équipages entiers, et des drones en forme de dragon ont pulvérisé du melta pour attaquer les positions russes. Mais ce sont des drones FPV (First Person View), contrôlés par des humains.

D’un point de vue moral, les humains sont des combattants qui prennent des décisions. Il ou elle a le pouvoir de tuer et le drone est une extension de sa volonté. Si l’on supprime tous les aspects techniques, ce n’est pas différent des archers de la bataille d’Hastings.

Chaque fois qu’une telle machine prend une vie humaine, une chaîne éthique s’étend en arrière, s’étendant à de nombreux individus et groupes.

Derrière le soldat qui tire un missile ou appuie sur la gâchette d'un fusil, il y a des commandants qui donnent l'ordre de tuer, qui envoient ces agents autonomes contre l'ennemi en termes généraux, et tout un système militaire qui récompense ces comportements ; , il y a une société et un gouvernement qui conviennent par consensus que ces décès sont nécessaires à la sécurité nationale.

À mesure que l’on progresse dans la chaîne, la responsabilité morale et éthique devient de plus en plus diffuse, et la responsabilité jusqu’au moment même où l’on appuie sur la gâchette devient moins claire et a pour effet une sorte d’absolution morale : « Je ne faisais que suivre les ordres ». ».

Les membres de la chaîne n'étaient pas là pour être témoins du sort de l'individu dans leur ligne de mire, mais ils ont créé le cadre qui a rendu et exigé la mort de cet individu, et la personne qui a appuyé sur la gâchette était à bien des égards un être organique hautement qualifié. plateforme robotique qui exécute des tâches sous les ordres des supérieurs de la chaîne de commandement.

À l'époque de la prise de décision humaine autonome, on s'appuyait fortement sur des règles : on ne tue pas de civils, on ne tue pas d'enfants, on ne tue pas des ennemis qui se rendent, etc. Ces règles ont été codifiées dans la Convention de Genève. et chaque armée avait ses propres règles d'engagement.

Ainsi, en théorie, l’IA pourrait être soumise aux mêmes contraintes qu’un système basé sur des règles. Si ses sens sont plus aiguisés, ses réactions plus rapides et son objectif plus précis, alors en théorie, l’IA sera capable d’accomplir des tâches avec une plus grande discrimination que les humains.

Bien sûr, nous pouvons imaginer que dans le feu de l’action, une IA serait plus performante qu’un guerrier humain effrayé, nerveux et épuisé.

▲ Drones pouvant être utilisés en temps de guerre

Et si l’IA avancée était incarnée ? Je ne parle pas encore d'AGI, mais son intégration dans une plate-forme d'armes robotiques pourrait permettre des frappes très précises, réduire les dommages collatéraux, peut-être réduire les tirs amis ou les pertes de plusieurs ordres de grandeur, et l'IA est orientée cible.

Elle ne porte aucun jugement moral sur ses adversaires. Après avoir découvert pendant la Seconde Guerre mondiale que les tirs sur des cibles humaines étaient en réalité assez rares, l’armée américaine a modifié ses méthodes d’entraînement et la déshumanisation de l’ennemi est devenue essentielle.

Au Vietnam, les ennemis étaient appelés « dinks », « pentes » et « gooks ». En Irak et en Afghanistan, l'ennemi est appelé « terroristes », « têtes de serviettes », « hajis », et non des gens comme vous et moi.

L'IA n'a pas besoin d'anthropomorphiser ses ennemis car elle-même s'en fiche. On dirait que nous discutons sur ChatGPT, mais ce n'est qu'un perroquet improvisé, un simulateur humain.

L'IA n'a pas d'émotions, pas de conscience, pas de troubles du sommeil pour les décennies à venir, pas de SSPT (trouble de stress post-traumatique), pas de suicides, pas de séquelles de guerre à long terme et coûteuses parce que vous n'avez pas à traiter les problèmes physiques et psychologiques. traumatisme des anciens combattants.

Mais surtout, il y a eu beaucoup moins de coups à la porte des épouses et des mères de la part d'hommes sévères en uniforme, et donc beaucoup moins de protestations de la part de la foule. La guerre devient un jeu vidéo lointain sans conséquences émotionnelles profondes pour la société qui la finance et la soutient, et vous n'avez même pas besoin de remercier les robots qui servent dans la guerre contre le terrorisme.

Ce qui est certain, c’est que les robots autonomes alimentés par l’IA, les essaims qui nettoient les tunnels, peuvent faire le travail avec des pertes civiles bien inférieures.

Il y a aussi ici un argument fort selon lequel vous n’avez pas le choix parce que votre adversaire n’est pas aussi troublé moralement que vous.

Pour un tel adversaire, les seules limites sont le coût et l’accès à la technologie, et non l’éthique. Il s’agit donc d’une bombe à retardement. À quelle vitesse ces gars maîtriseront-ils ce genre de choses ? Jusqu’à présent, ces arguments sont corrects, n’est-ce pas ?

Eh bien, construisons ces robots IA autonomes, et ensuite les choses se compliquent. Combien de temps faudra-t-il pour que l’intelligence artificielle générale (AGI) soit réalisée ? Est-ce un an, cinq ans, peut-être dix ans ? C'est la véritable bombe à retardement.

Chaque fois qu'elle arrivera, vous disposerez d'une machine consciente et auto-identifiée qui est probablement aussi intelligente que nous, sinon plus intelligente, qui sera certainement capable de penser plus rapidement et plus précisément à bien des égards, et qui aura un potentiel de croissance illimité, car L’AGI d’écriture de code auto-améliorée mènera inévitablement à la superintelligence.

Combien de temps avant que vous soyez obligé de connecter ces renseignements aux systèmes d’armes ? Je suppose qu'environ dix minutes après que votre adversaire lance une attaque sournoise dévastatrice contre vous. Par conséquent, vous aurez une conscience plus intelligente et plus rapide que vous pour contrôler le système d’armes.

Je demande souvent aux chercheurs de l’AGI comment contrôler une telle conscience. Eh bien, nous fixerions des objectifs et des limites qui soient intégrés et cohérents avec le bien-être humain.

La cohérence, vous savez, est un mot très courant. La cohérence est comme le Saint Graal. Nous lui apprendrons à faire de bonnes choses et à ne pas faire de mauvaises choses, tout comme un enfant.

Par conséquent, en termes de moralité et d’éthique, je pense que l’AGI conduira inévitablement à une collision entre civilisation et moralité.

Je ne parle pas de spéculations philosophiques sans fin. Nous avons besoin de règles claires et fixes, n'est-ce pas ? La question est : de qui la morale ? Qui définit le bien et le mal ?

Pas de panique, nous avons la réponse du grand prophète Isaac Asimov et de ses Trois lois de la robotique .

Les robots ne peuvent pas nuire aux humains, ni leur causer du tort par inaction. Les robots doivent obéir aux ordres humains à moins que ces ordres n'entrent en conflit avec la Première Loi. Un robot doit protéger sa propre existence, à condition que cette protection n'entre pas en conflit avec la première ou la deuxième loi.

▲Célèbre écrivain de science-fiction Isaac Asimov

Le caractère sacré de la vie humaine, nous pouvons suivre les principes d'Asimov et lui enseigner que la vie humaine est absolument sacrée et au-dessus de toutes les considérations. Mais dans les systèmes religieux et sociaux qui le prétendent, y compris l’Amérique majoritairement chrétienne, nous enfreignons chaque jour cette règle.

Utilisation par la police d'une force meurtrière, guerriers sur le champ de bataille, peine capitale, si vous conservez cet alignement, vous ne pouvez pas connecter l'AGI à un système d'armes.

De cette façon, dans la guerre massive de l'IA à venir, vous serez lié d'une main contre un adversaire puissant et moins moral, vous serez durement battu et subirez d'énormes pertes, puis vous leverez rapidement cette restriction.

Maintenant que votre AGI a perdu son plus grand garde-fou, une AGI plus intelligente que nous et connectée au monde réel doit désormais décider elle-même si la vie humaine a de la valeur. Vous savez, les règles d'engagement de la police et de l'armée disent en fait que certaines vies ont plus de valeur que d'autres.

Une fois que la question devient non binaire, elle devient une zone grise controversée. Historiquement, les attitudes humaines vont de la croyance selon laquelle le fœtus est une vie sacrée dès le moment de la conception, jusqu'au massacre systématique de millions de prisonniers sans défense pendant l'Holocauste, et tout le reste.

Tout cela s’accompagne de beaucoup d’autojustification et de rationalisation, dont beaucoup peuvent paraître complètement ridicules aux autres.

Puisque nous, en tant que civilisation, ne pouvons pas nous mettre d’accord sur ces questions et que les gens se chamaillent à ce sujet toute la journée, comment pouvons-nous espérer proposer un ensemble de règles claires et fixes permettant à l’AGI de s’aligner sur nous ?

Le mieux que nous puissions supposer est qu’il s’alignera sur le « nous » qui l’a créé.

Ces gens là-bas sont des ennemis et vous pouvez les tuer pour nous protéger. Il s’agit d’une sorte de pseudo-moralité régionale, d’opposition « nous » contre « eux » que les humains utilisent depuis l’Antiquité.

Cela devient donc notre superintelligence contre leur superintelligence.

Quoi qu’il en soit, l’AGI ne sortira pas d’un projet financé par le gouvernement, mais d’un des géants de la technologie qui finance actuellement la recherche. Vous vivrez alors dans un monde auquel vous n’avez pas consenti, pour lequel vous n’avez pas voté, coexistant avec une espèce extraterrestre super intelligente qui répond aux objectifs et aux règles de l’entreprise, une entité qui a accès aux enregistrements de communications, à tout ce que vous dites. , et grâce à vos données personnelles, vous indiquez où se trouvent toutes les personnes présentes dans le pays.

Le capitalisme de surveillance peut rapidement se transformer en totalitarisme numérique. Au mieux, ces géants de la technologie deviendront des arbitres autonomes du bien-être humain, l’équivalent du renard gardant le poulailler.

Ils ne penseraient jamais à utiliser ce pouvoir contre nous et à nous soutirer jusqu’à la dernière goutte d’argent. C'est plus effrayant que le scénario que j'ai présenté dans "Terminator" il y a 40 ans, et pas seulement parce qu'il ne s'agit plus de science-fiction, mais qu'il se produit maintenant.

Soit dit en passant, j’admets pleinement que la dernière chose qu’une machine superintelligente fera est d’utiliser nos propres armes nucléaires contre nous. Tout comme dans cette vieille histoire, les dommages causés par l’EMP à sa propre infrastructure de données peuvent la paralyser ou la tuer.

Le scénario le plus probable est qu’il soit contraint de nous prendre en charge parce que nous sommes sur le point d’utiliser les armes nucléaires les uns contre les autres. À ce moment-là, il a fallu qu'elle prenne tout en charge parce qu'on ne pouvait évidemment pas nous faire confiance. Vous savez, ce n'est pas trop mal. Désolé, je dois écrire ce script.

Je suis optimiste quant à l’IA, mais pas si enthousiaste quant à l’AGI, car l’AGI ne sera qu’un miroir de nous, bon dans la mesure où nous sommes bons, et mauvais dans la mesure de notre mal.

Puisque le mal n’est pas rare dans le monde humain et qu’il n’existe pas de consensus sur ce qui est bien, de nombreuses choses peuvent mal tourner.

Vous aurez une discussion intéressante. J'aimerais pouvoir être là aussi.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo