J’ai testé Sora ! Rivalisez entre Keling et Runway, qui a le moins de saveur d’IA ?

Après un an d'attente, Sora est finalement sorti, mais OpenAI a fait venir les internautes à la rescousse.

Il a été convenu qu'il serait officiellement ouvert à l'utilisation, et seuls les plus chanceux qui diffusent en direct et qui ont les mains assez rapides pourront être les premiers à en faire l'expérience. Après avoir attendu une journée, rafraîchi à plusieurs reprises et fait face à des rappels de « veuillez revenir plus tard » encore et encore, je me suis finalement inscrit avec succès.

Cependant, les 20 $ qui nous ont permis, à moi et à ChatGPT, de discuter de tout, de la poésie à la philosophie de la vie, n'étaient que suffisants pour que Sora génère 40 vidéos 480p de 5 secondes en un mois. Chaque clic généré, c'est comme marcher sur de la glace mince.

Après l'avoir finalement utilisé, nous souhaitons naturellement utiliser chaque vidéo Sora jusqu'au bout et la comparer avec Runway et Keling. La conclusion est qu’il est utilisable et amusant, mais il est difficile d’en faire l’éloge.

Sora, Runway et Ke Ling ont tous échoué à leur manière.

Il y a naturellement une raison de laisser Sora rivaliser avec Runway et Keling. L'un est le produit vidéo d'IA le plus représentatif à l'étranger qui a fait ses débuts tôt, et l'autre est un acteur national de premier plan qui a soudainement émergé et conquis les internautes du monde entier grâce à sa force.

Les règles sont très simples, utilisant les mêmes mots d'invite anglais (pour faciliter la lecture, les éléments suivants sont traduits en chinois) et le temps généré est de 5 secondes. La seule différence est que la résolution de Sora est réglée sur 480p. Il n’y a pas d’autre moyen, il faut utiliser ses points avec parcimonie.

Utilisez d'abord Wensheng Video pour comparer le réalisme et la texture des images et voir à quoi ressemblent les chats générés par les vidéos d'IA.

Bien que Sora ne soit qu'en 480p, l'image semble en haute définition et l'étalonnage des couleurs est magnifique.

▲Sora génère un mot rapide : un téléobjectif de 200 mm capture le chat britannique à poil court sur le balcon, avec des détails de poils distincts. La grande plante en pot au premier plan est légèrement floue et les feuilles en arrière-plan se balancent au gré du vent. L'image a le grain et la saturation des couleurs d'un film, qualité haute définition

Les performances de Runway et de Keling sont similaires, et le premier plan et l'arrière-plan de Keling sont générés avec la plus grande précision. Trois chats, trois couleurs.

▲Génération de piste

▲Génération d'esprit Chen

Ensuite, laissez les vidéos IA « écrire » et voyez si elles peuvent écrire « APPSO ».

Les mouvements de la main de Sora sont assez naturels, mais les lignes qu'il écrit ressemblent à manger des champignons et ont leurs propres idées.

▲ Sora généré, mot d'invite : vue aérienne de la main écrivant "APPSO" sur du papier à croquis blanc, traits noirs, mouvements d'écriture fluides, mouvement naturel de la main, éclairage doux, gros plan

C'est Runway qui a le plus réussi, mais pas complètement. De plus, à l'exception du dernier trait, les traces de lettres et les mouvements des mains ne coopéraient pas tacitement et chacun fonctionnait de manière indépendante.

▲Génération de piste

Quant à Ke Ling, il écrivait une suite de caractères tronqués, mais c'était rare. Les lettres suivaient les mouvements de ses mains.

▲Génération d'esprit Chen

Testons ensuite la fluidité du mouvement. Dans la même course cycliste, les tirs et les trajectoires de mouvement de Sora suivaient complètement les mots-guides, et les ombres semblaient très réelles.

▲Sora généré, mot d'invite : le vététiste s'est rapidement précipité sur le chemin de terre continuellement ondulé et a décollé de la dernière plate-forme. La photo latérale a capturé le moment où il était au point le plus élevé.

Les mots-clés de Runway n'étaient qu'à moitié justes, le cycliste n'est pas apparu au début et il a reçu un moment fort à la fin.

▲Génération de piste

Ke Ling et Runway étaient tout le contraire. Ils ont bien joué en première mi-temps, mais quelque chose s'est mal passé à la fin. Pourquoi y avait-il une personne supplémentaire ?

▲Génération d'esprit Chen

Il est temps de relever le défi et de trouver un mot d’invite relativement compliqué associé au changement de caméra.

Les couleurs de l'image de Sora étaient saturées, comme si elles avaient été atténuées, mais les hommes semblaient apparaître de nulle part, et l'IA n'a pas tourné la caméra vers les hommes comme requis.

▲Sora généré, mot d'invite : par un après-midi ensoleillé, dans un café de style Starbucks, la caméra s'est d'abord concentrée sur une jeune Chinoise souriante, puis s'est tournée vers un jeune Chinois qui a légèrement hoché la tête en parlant. Ils étaient assis l'un en face de l'autre, avec deux tasses de café sur la table en bois. La lumière naturelle remplit l'espace, créant une atmosphère chaleureuse

Runway l'a filmé directement de côté, restituant les expressions des deux personnes, mais cela ne reflétait pas le mouvement de la caméra, et il y avait aussi quelque chose qui n'allait pas avec les mains de l'homme.

▲Génération de piste

Ke Ling est similaire à Runway, mais légèrement meilleur car il est plus chinois. Cependant, ces deux personnes étaient assises à la même table, mais aucune ne se regardait.

▲Génération d'esprit Chen

En plus des vidéos de Vincent, les vidéos Tusheng sont également le point culminant de la génération vidéo, et par rapport aux vidéos de Vincent, les vidéos Tusheng sont plus pratiques. De nombreux films d'IA commercialisés sont essentiellement des vidéos Tusheng. Essayez d'abord d'obtenir une cohérence au niveau de l'image.

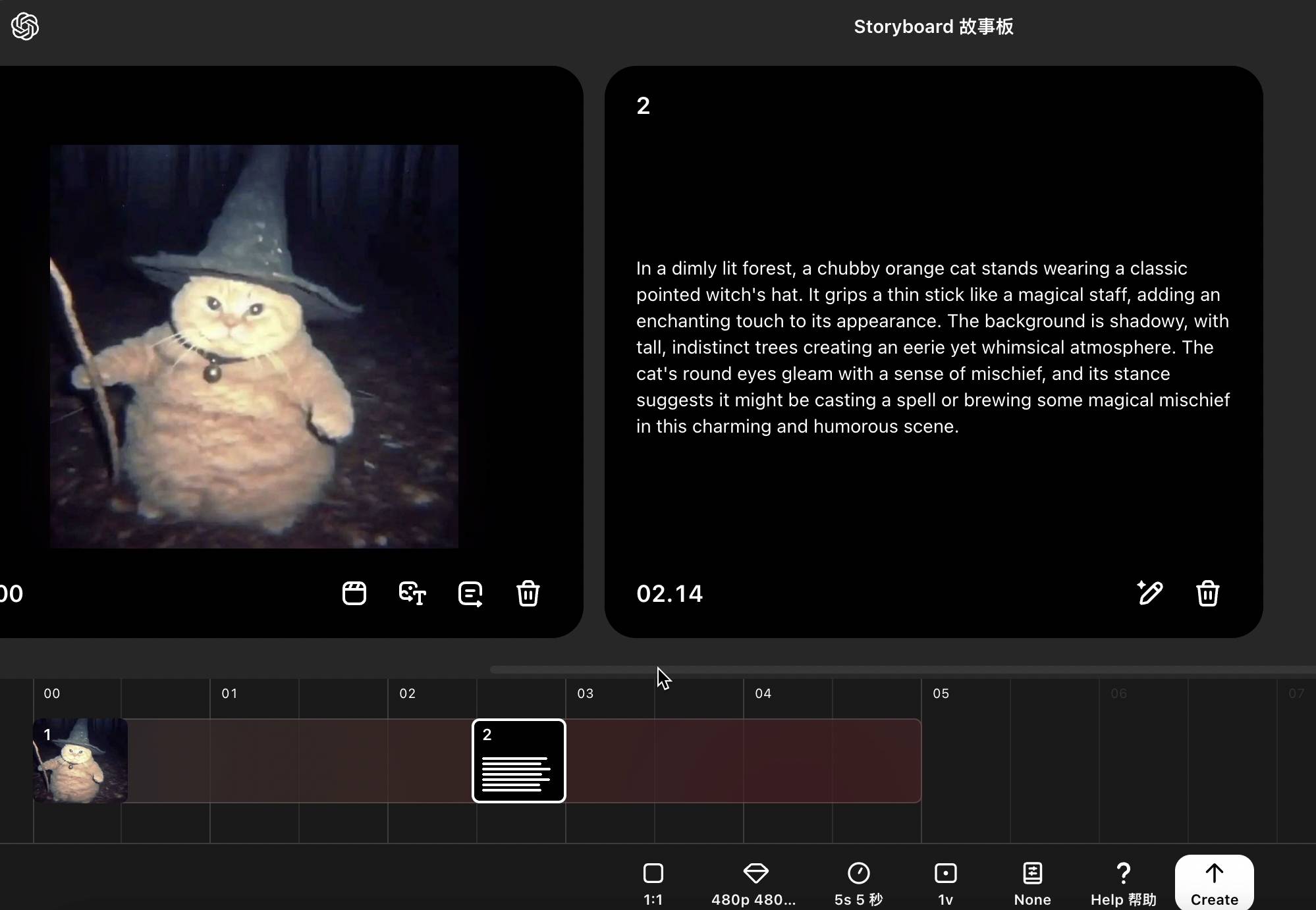

Cependant, si vous êtes un utilisateur de 20 $ Plus, vous ne pouvez pas télécharger de photos ou de vidéos contenant des personnes sur Sora. La meilleure chose à faire est de télécharger une émoticône représentant un chat sorcier, demandant au chat d'agiter sa baguette magique et d'invoquer des roses.

Je ne sais pas pourquoi, mais la vidéo Tusheng de Sora ne fonctionne pas. Le chat ne bouge pas du tout. C'est seulement à partir du logo dans le coin inférieur droit que l'on peut voir qu'il ne s'agit pas d'une image fixe.

▲Sora généré, mot rapide : Cat a agité la baguette magique dans sa main et s'est transformé en une rose rouge.

Runway a demandé au chat d'agiter une baguette magique avec sa patte droite, et sa patte gauche s'est transformée en une rose, ce qui répondait aux exigences du mot d'invite, mais la fleur n'était pas sur le même calque.

▲Génération de piste

La performance de Ke Ling est parfaite et l'effet est le plus naturel lorsqu'il est transformé en gif, ce n'est qu'une autre émoticône.

▲Génération d'esprit Chen

J'ai essayé les animaux, puis le miroir vide. J'ai utilisé une image de style friche industrielle que j'avais précédemment générée avec l'IA comme matériau pour la vidéo Tusheng.

Les résultats générés par Sora sont difficiles à évaluer. L'angle de vue est suffisamment faible, mais la caméra ne suit pas de côté et les transitions de cadre sont brusques. C'est ce qu'on appelle, je ne devrais pas être dans la voiture, mais sous la voiture.

▲Sora généré, mots rapides : véhicules blindés qui passent, pneus soulevant de la poussière et des débris, travelling latéral, perspective en contre-plongée, ralenti, texture de niveau film

Runway génère la saveur la plus interne, même les vitres de la voiture bougent.

▲Génération de piste

Ke Ling a directement fait un zoom arrière sur la caméra, ce qui n'avait fondamentalement rien à voir avec le mot d'invite.

▲Génération d'esprit Chen

Il n’y avait que quelques questions, et aucune des trois IA n’a pu obtenir la note maximale. Bien entendu, les éléments ci-dessus ne sont que des exemples et ne sont pas universellement représentatifs, ils ne peuvent au mieux fournir qu’une perspective d’évaluation.

En parlant de Sora seul, il fonctionne bien dans le style réaliste des vidéos de Vincent, avec une qualité cinématographique, et le mouvement de l'objet suit bien les mots rapides, parfois même mieux que Keling et Runway.

Cependant, les vidéos Tusheng attirent facilement l'attention des gens, elles peuvent rester immobiles et ne pas écouter le mouvement de la caméra, de sorte que le rapport coût-efficacité global n'est pas élevé.

▲Sora généré, mot d'invite : court métrage 35 mm tourné à Shanghai dans les années 1990, qualité cinématographique

Modèle "Beggars Edition", produits innovants

Les performances de Sora sont moyennes, probablement parce qu'il s'agit d'une "version du mendiant" – contrairement aux artistes invités par OpenAI, ce que nous pouvons utiliser maintenant est la version turbo, qui nécessite moins de puissance de calcul et l'effet est compromis.

Il n'y a pas assez de modèles, donc les produits doivent être maquillés. Sora est un peu convaincant – il a été officiellement annoncé en février et sorti en décembre. De nombreux produits concurrents ont émergé au milieu, mais Sora a toujours des fonctions qu'ils n'ont pas.

Contrairement à ChatGPT, où une boîte de dialogue domine le monde, Sora est unique dans la conception de son interface interactive et des fonctions de son produit.

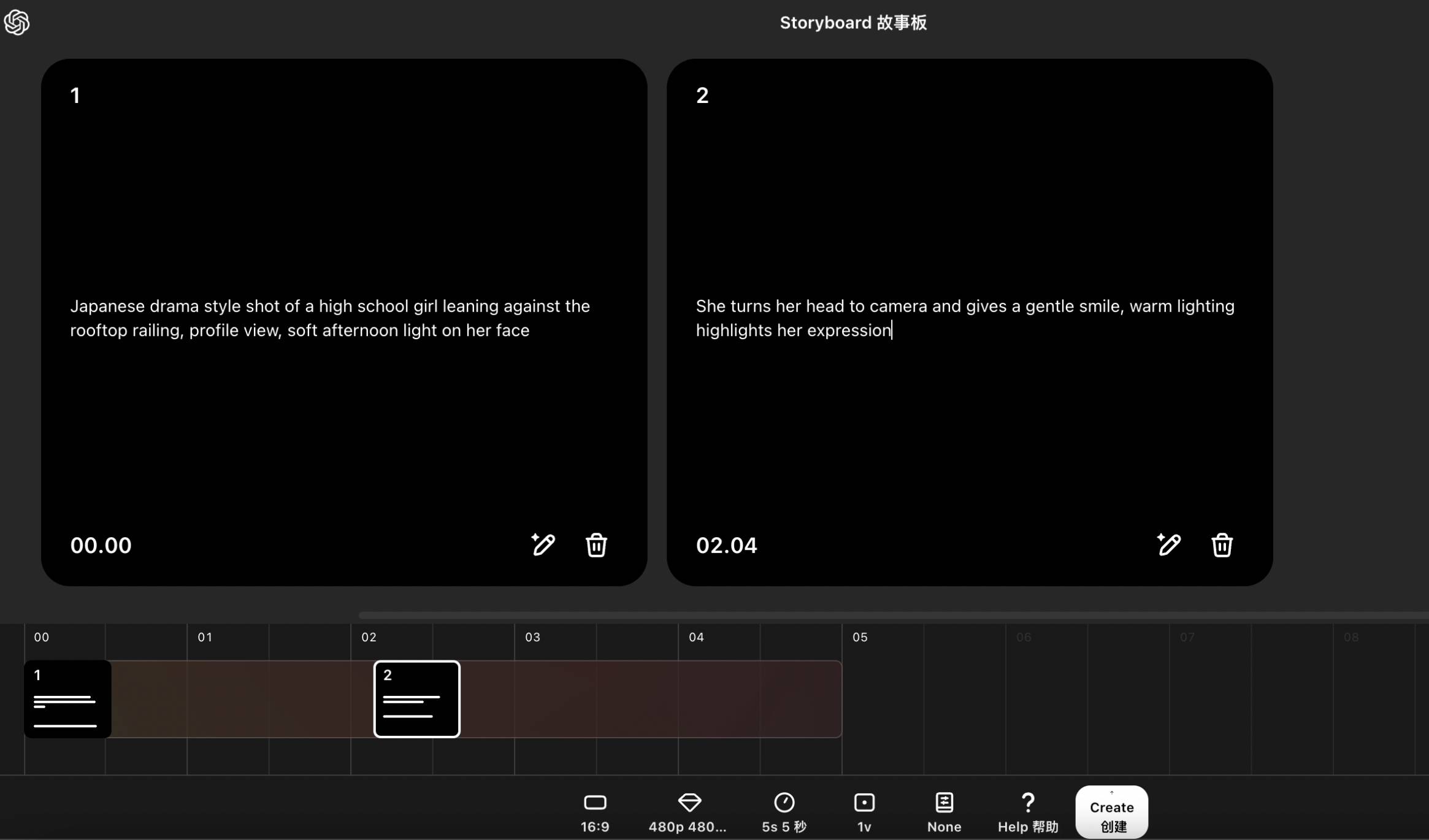

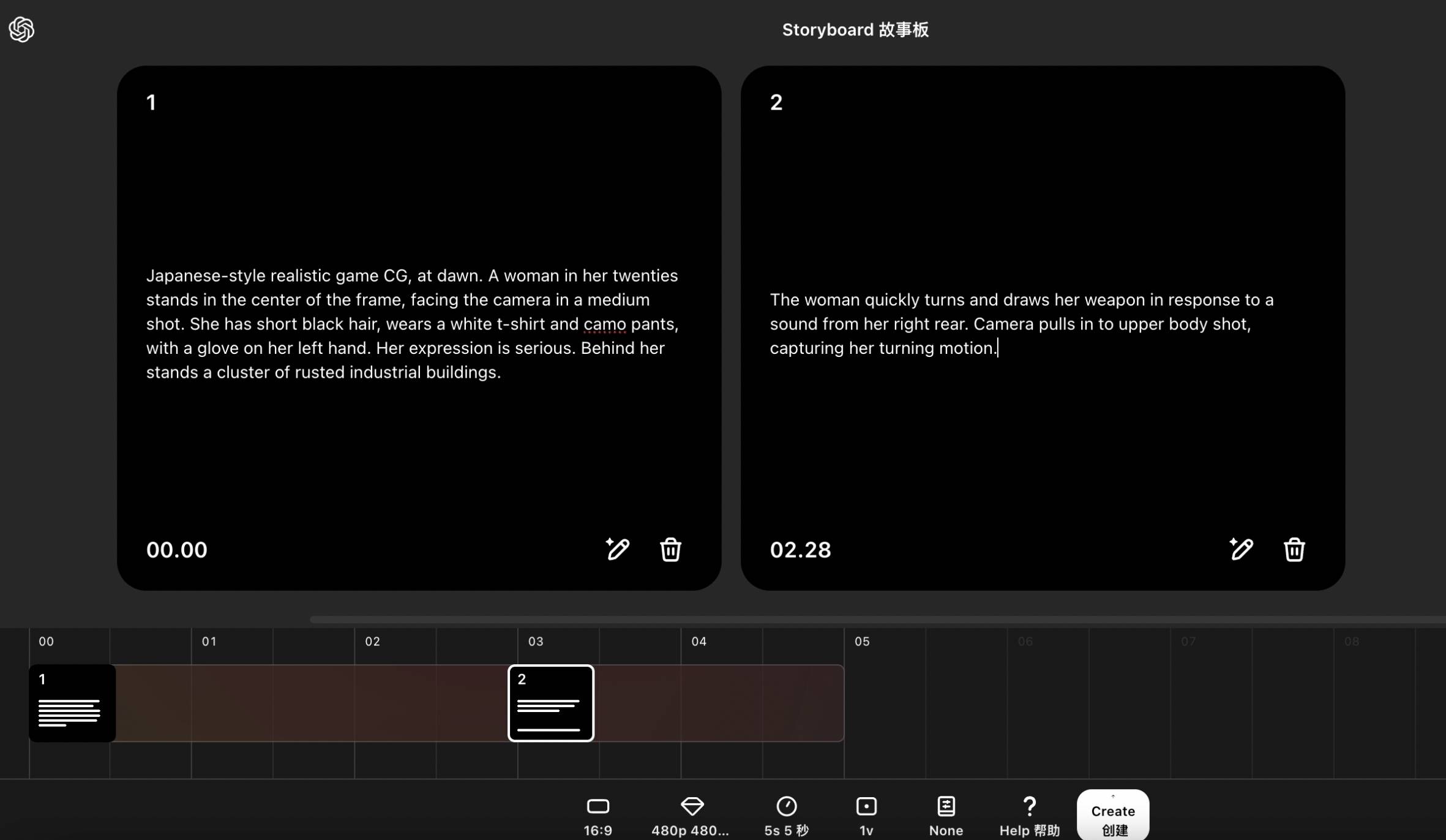

Parmi eux, la fonction de storyboard de Sora est similaire aux première et dernière images, mais plus flexible. Nous pouvons ajouter plusieurs cartes à la chronologie. Les cartes peuvent contenir des mots d'invite, des images et des vidéos.

J'ai donc écrit deux paragraphes d'invites : 1. Plan de style drame japonais, la lycéenne est appuyée contre la balustrade du toit, avec un profil latéral, la douce lumière de l'après-midi frappe son visage 2. Elle tourne la tête pour faire face au ; caméra et sourit chaleureusement. L'éclairage met en valeur les expressions.

L’effet obtenu est conforme à mon imagination, et le battement des cheveux fait battre le cœur des gens.

▲ Sora généré

L'IA n'est pas encore capable de faire de tout le monde un réalisateur, mais Sora vous permet d'éprouver la sensation de concevoir des storyboards. Mais, encore une fois, le modèle est comme ça, l'effet est très aléatoire, mais les points de Sora ne peuvent pas résister au tirage de cartes.

Au départ, je voulais que l'IA imite l'effet du jeu CG, où le protagoniste se retourne rapidement et dégaine son arme, mais au final, j'ai obtenu un robot avec une expression terne.

▲Sora généré

Vous pouvez également simplement mettre une image sur le storyboard, et Sora générera automatiquement des mots d'invite pour suggérer comment déplacer l'image.

Ainsi, le chat sorcier peut enfin bouger. Il s'avère que les lacunes de Tusheng Video doivent être comblées ici. Cependant, l'effet est également difficile à étendre et produit parfois des choses inutiles.

▲Sora généré

De plus, la fonction Remix (redessiner) de Sora est également très amusante. Nous pouvons éditer la vidéo en langage naturel, modifier les éléments de la vidéo et effectuer une « création secondaire ».

Vous pouvez utiliser vos propres vidéos ou emprunter des vidéos à d'autres membres de la communauté Sora.

▲ Photo de : communauté Sora @bpyser1

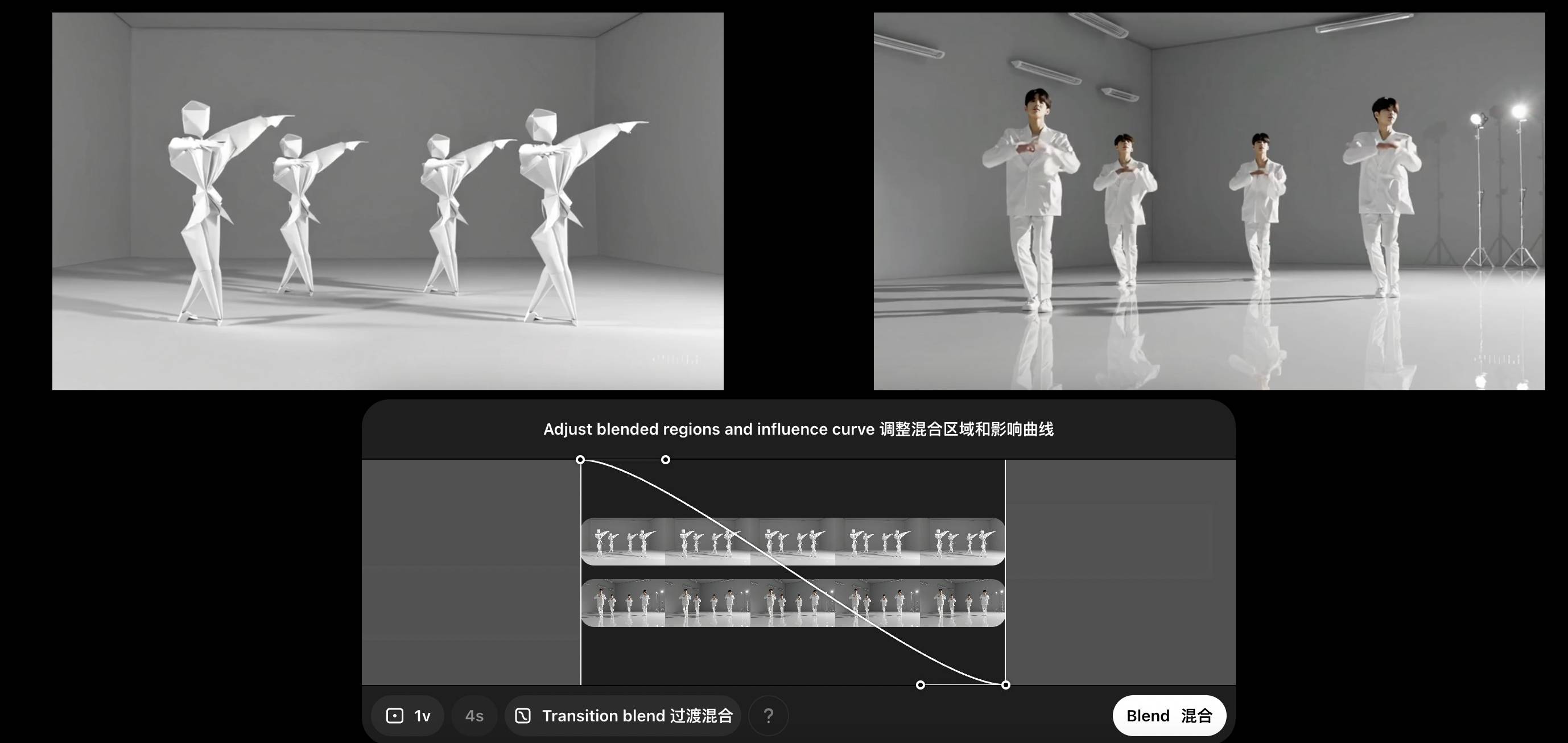

Par exemple, nous pouvons remplacer les figurines en papier dansantes par un boys band, et en même temps transformer la scène en salle de répétition.

Les mouvements et les costumes des personnages en papier ont été globalement conservés, mais les membres des personnages ne peuvent toujours pas être vus en détail.

▲Sora généré

Maintenant, pour plus de plaisir, nous pouvons ensuite utiliser la fonction Blend pour fusionner les deux vidéos en une seule, et Sora gérera automatiquement les effets de transition entre les vidéos.

Au départ, je pensais pouvoir produire un clip MV fluide, après tout, les deux vidéos sont tellement similaires, mais l'IA m'a quand même surpris. Le début et la fin étaient normaux, mais la scène au milieu était très chaotique. tu es là ?

▲Sora généré

Bref, si on ne recherche pas la cadence de production, Sora est très ludique, la forme du produit est aussi très intéressante, il propose un tout nouveau workflow, il y a des innovations, et les fonctionnalités sont relativement complètes.

Cependant, du point de vue actuel, il y a encore beaucoup à faire pour améliorer l'effet de génération, mais le nombre d'explorations proposées aux utilisateurs n'est pas suffisant et 20 $ ne peuvent qu'effleurer la surface. Parfois les images sont belles, mais si le mouvement n'est pas bien géré, il ne sert à rien. « La réalité n'existe plus » est encore un rêve lointain.

S'il vous plaît, profitez du chat qui traverse le mur. Il s'avère qu'aux yeux de l'IA, les chats sont vraiment liquides.

▲Sora généré, mot rapide : Un gros plan d'un chat noir avec une sensation cinématographique complète. Le chat saute gracieusement devant le mur rouge de la Cité Interdite. L'image est présentée au ralenti. clairement visible. L'arrière-plan est flou avec une faible profondeur de champ et le chat saute à son point le plus élevé. Les yeux dorés regardent directement la caméra. Utilisant une lumière naturelle douce, les détails des murs architecturaux chinois traditionnels forment un arrière-plan flou

Le problème de Sora est en fait un problème courant parmi de nombreux produits vidéo IA. Il n'existe pas de solution unique vraiment fiable. Simuler le monde réel ? Obtenir un mouvement doux et soyeux ? Garder la cohérence des personnages ? Oui, c’est possible, mais il existe une probabilité, et le tirage des cartes et les étapes ultérieures sont essentiels.

Nous examinons maintenant l’effet de génération visible à l’œil nu, et ce que les vidéos IA ont collectivement changé, c’est la manière de créer. Bien que l'avenir soit prometteur, Sora, veuillez d'abord mettre à niveau votre modèle.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo