La nouvelle version de GPT-5 vient d’être publiée. L’IA la plus populaire a passé 7 heures à coder, et la refonte des outils de programmation a commencé.

Au moment même où Anthropic Claude était pris dans la controverse sur la réduction de son QI, OpenAI venait de lancer GPT-5-Codex, une version dédiée de Codex optimisée sur la base de GPT-5, spécifiquement entraînée pour la « programmation autonome ».

Cette mise à niveau a un certain poids.

Axé sur des scénarios d'ingénierie logicielle concrets, GPT-5-Codex permet non seulement de gérer les interactions de programmation quotidiennes, mais aussi de mener à bien de manière autonome des projets d'ingénierie complexes et chronophages. Tel un véritable programmeur, il peut travailler en continu pendant plus de sept heures, itérant, corrigeant des bugs et exécutant des tests sur des projets complexes pour finalement fournir une solution complète et exploitable.

Depuis le lancement de la version CLI en avril, jusqu'au lancement de la version Web en mai, jusqu'à la mise à niveau complète actuelle, l'objectif de Codex est d'« automatiser » complètement la programmation.

Désormais, que vous développiez dans un terminal, un IDE, une page Web ou un téléphone mobile, Codex peut fournir une expérience d'assistance à la programmation cohérente et a été intégré au système de compte ChatGPT, permettant une commutation transparente entre le local et le cloud.

La caractéristique la plus intéressante de GPT-5-Codex est sa capacité de « pensée dynamique », qui lui permet d'ajuster de manière flexible le temps de traitement en fonction de la complexité de la tâche.

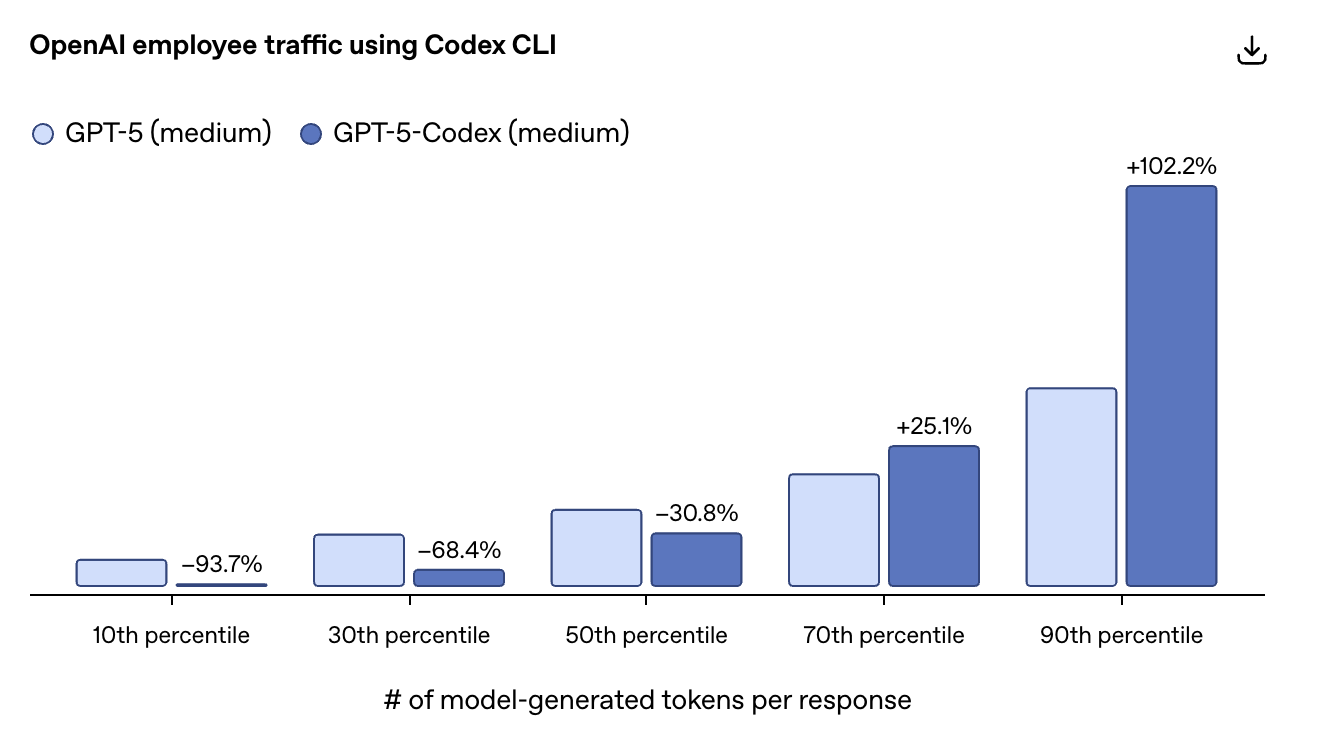

Les données d'utilisation internes des employés d'OpenAI montrent que pour les 10 % inférieurs des requêtes simples, triées par le nombre de jetons générés par le modèle, GPT-5-Codex a utilisé 93,7 % de ressources informatiques en moins que GPT-5.

À l'inverse, pour les 10 % de requêtes les plus complexes, il faut environ deux fois plus de temps pour raisonner, modifier le code, tester et itérer. Cela signifie que les conversations quotidiennes et les petites tâches reçoivent une réponse plus rapide, tandis que les refactorisations complexes et de grande envergure nécessitent plus de temps pour être traitées en profondeur.

En termes simples, cela signifie : ne perdez pas de temps sur les petits problèmes quotidiens et consacrez du temps à de grands projets.

Enfin, il existe un modèle de programmation qui comprend comment utiliser les meilleures ressources là où elles comptent le plus.

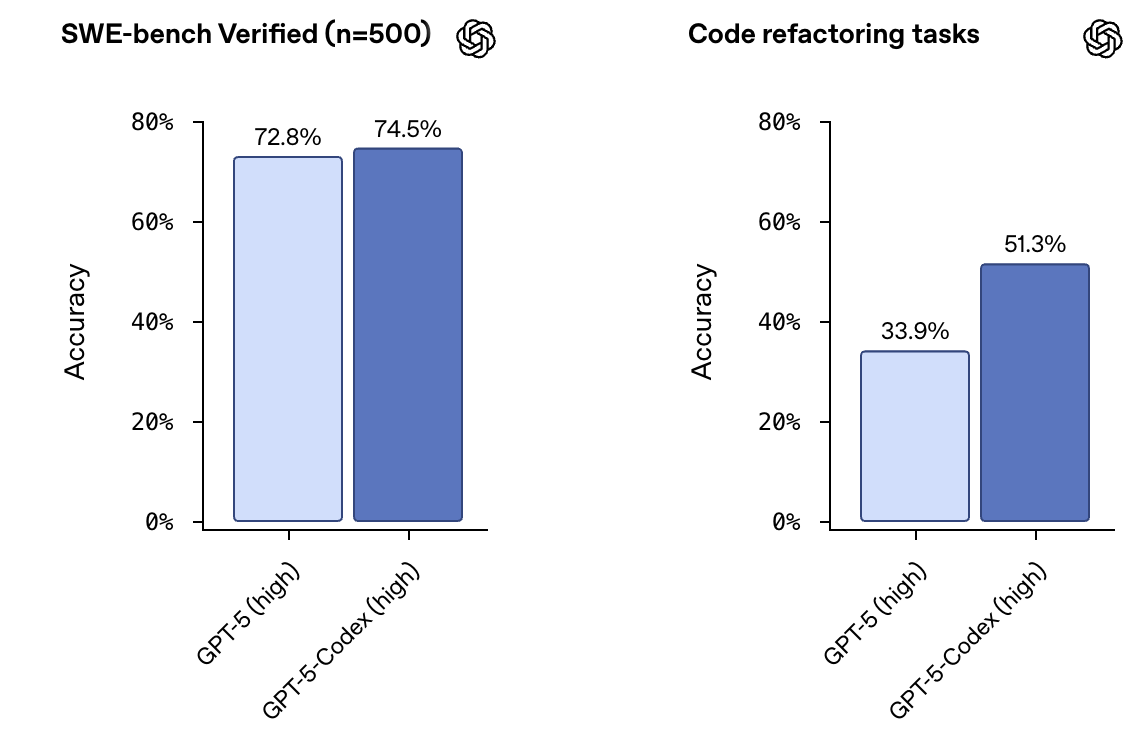

Concernant les benchmarks, lors de la sortie de GPT-5, OpenAI ne rapportait les résultats que de 477 tâches vérifiées par SWE-bench. Suite à un signalement d'Anthropic, OpenAI a annoncé aujourd'hui que ces problèmes avaient été corrigés et que les résultats pouvaient désormais être rapportés pour les 500 tâches. Voici les résultats :

L'évaluation de la refactorisation de code couvre des langages tels que Python, Go et même OCaml. Par exemple, une demande d'extraction (pull request) de Gitea a modifié 232 fichiers et 3 541 lignes de code, et intégré la variable ctx à la logique de l'application.

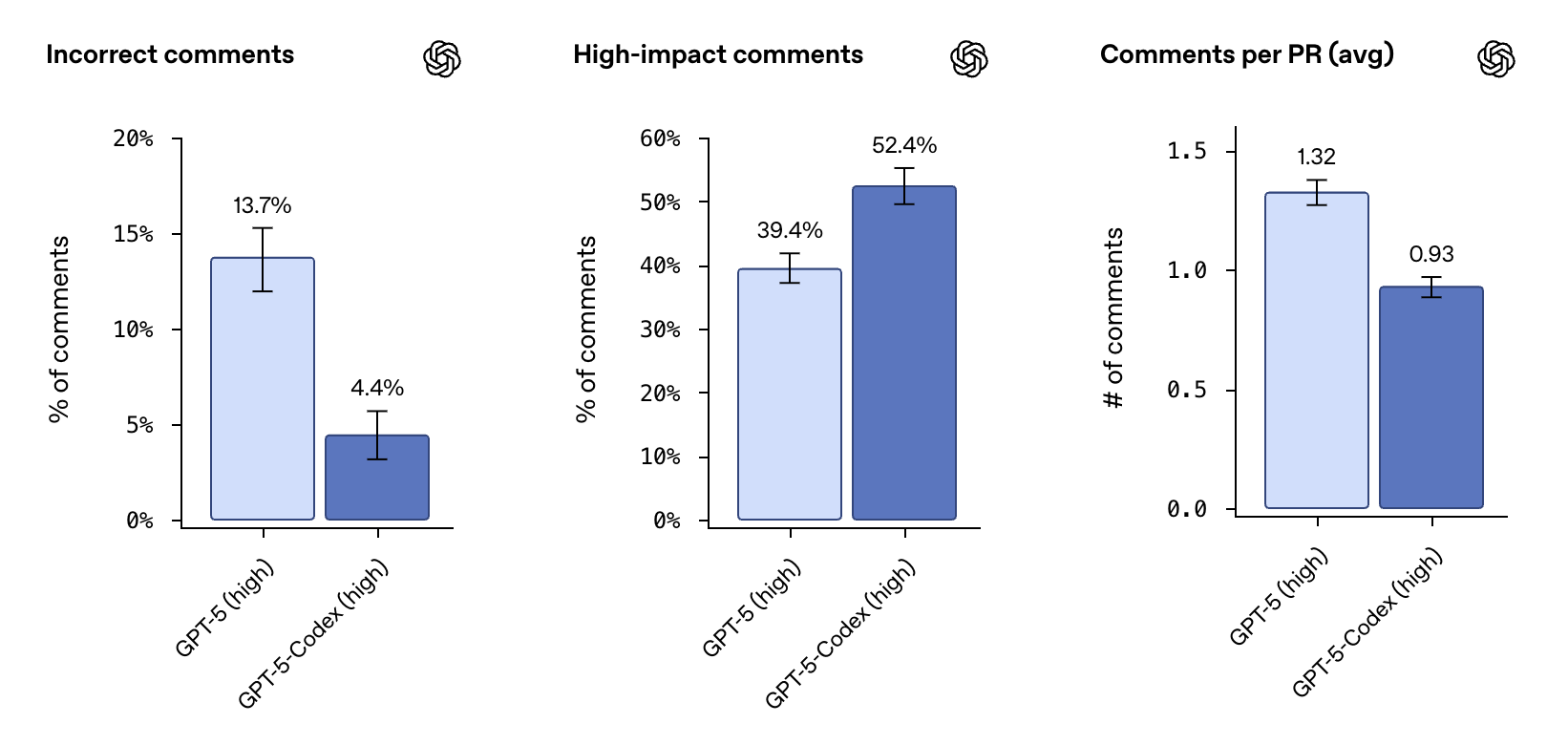

La fonctionnalité de révision de code est également très utile. Elle parcourt et analyse la base de code, exécute des tests pour vérifier son exactitude et fournit des commentaires de révision très précis. Au sein d'OpenAI, Codex examine désormais la majorité des pull requests, découvrant des centaines de problèmes chaque jour et détectant souvent les bugs potentiels avant une révision manuelle.

Le développement front-end est également pris en charge. GPT-5-Codex prend non seulement en charge la création d'applications de bureau, mais améliore également considérablement les capacités de développement mobile. Il permet également de lire des captures d'écran et des brouillons, de suivre l'avancement du développement et de visualiser les résultats, ce qui est particulièrement utile pour le développement front-end.

Les mises à jour des outils sont également très importantes. La nouvelle interface de ligne de commande Codex est désormais restructurée autour du processus de codage autonome et prend en charge l'attachement et le partage directs d'images, notamment de captures d'écran, de wireframes et de diagrammes d'architecture, pour une compréhension commune des décisions de conception.

Lorsqu'il s'agit de tâches complexes, Codex suit la progression grâce à des listes de tâches et dispose d'outils intégrés tels que la recherche Web et MCP pour se connecter à des systèmes externes.

Les modes d'approbation sont simplifiés à trois : le mode lecture seule nécessite une approbation explicite, le mode automatique a un accès complet à l'espace de travail mais nécessite une approbation en dehors de l'espace de travail, et le mode d'accès complet peut lire des fichiers n'importe où et exécuter des commandes avec accès réseau.

Le nouveau plugin IDE prend en charge des éditeurs comme VS Code et Cursor, permettant aux utilisateurs de prévisualiser facilement les modifications locales et de collaborer sur le code avec Codex. Il permet également de basculer facilement entre les environnements cloud et locaux, permettant ainsi aux utilisateurs de créer des tâches cloud, de suivre le travail en cours et de consulter les tâches terminées directement dans l'éditeur.

L'infrastructure cloud a également connu des améliorations significatives, la mise en cache des conteneurs réduisant de 90 % le temps d'exécution moyen des tâches nouvelles et ultérieures. Codex configure automatiquement l'environnement d'exécution, recherche les scripts d'initialisation courants et les exécute, et exécute même des commandes comme pip install pour installer les dépendances à la demande tout en configurant les autorisations d'accès au réseau.

En termes de sécurité, OpenAI utilise un environnement d'exploitation sandbox et désactive l'accès au réseau par défaut pour garantir qu'aucune opération nuisible n'est effectuée sur l'ordinateur de l'utilisateur, tout en réduisant le risque d'injection rapide.

Les développeurs peuvent personnaliser les paramètres de sécurité en fonction de leur tolérance au risque. Dans le cloud, ils peuvent restreindre l'accès au réseau aux seuls domaines de confiance. Grâce aux plug-ins CLI et IDE, ils peuvent approuver les commandes, accorder tous les privilèges d'exécution, utiliser la recherche web et se connecter au serveur MCP.

Conformément à la gestion GPT-5, GPT-5-Codex est classé comme un modèle de haute capacité dans les domaines de la biologie et de la chimie, et des mesures de sécurité correspondantes ont été mises en œuvre.

En termes de prix, Codex a été intégré dans divers plans payants de ChatGPT, et différents plans offrent différentes limites d'utilisation.

- De plus, Edu et Business sont parfaits pour des séances de programmation ciblées quelques fois par semaine ;

- Pro peut prendre en charge une semaine complète de charge de travail sur plusieurs projets.

L'offre Business permet aux développeurs d'acheter des crédits supplémentaires pour dépasser le plafond fixé, tandis que l'offre Enterprise propose un pool de crédits partagés, leur permettant de payer uniquement ce que leur équipe utilise réellement. Pour les développeurs utilisant une clé API, OpenAI prévoit d'ouvrir prochainement GPT-5-Codex à l'API.

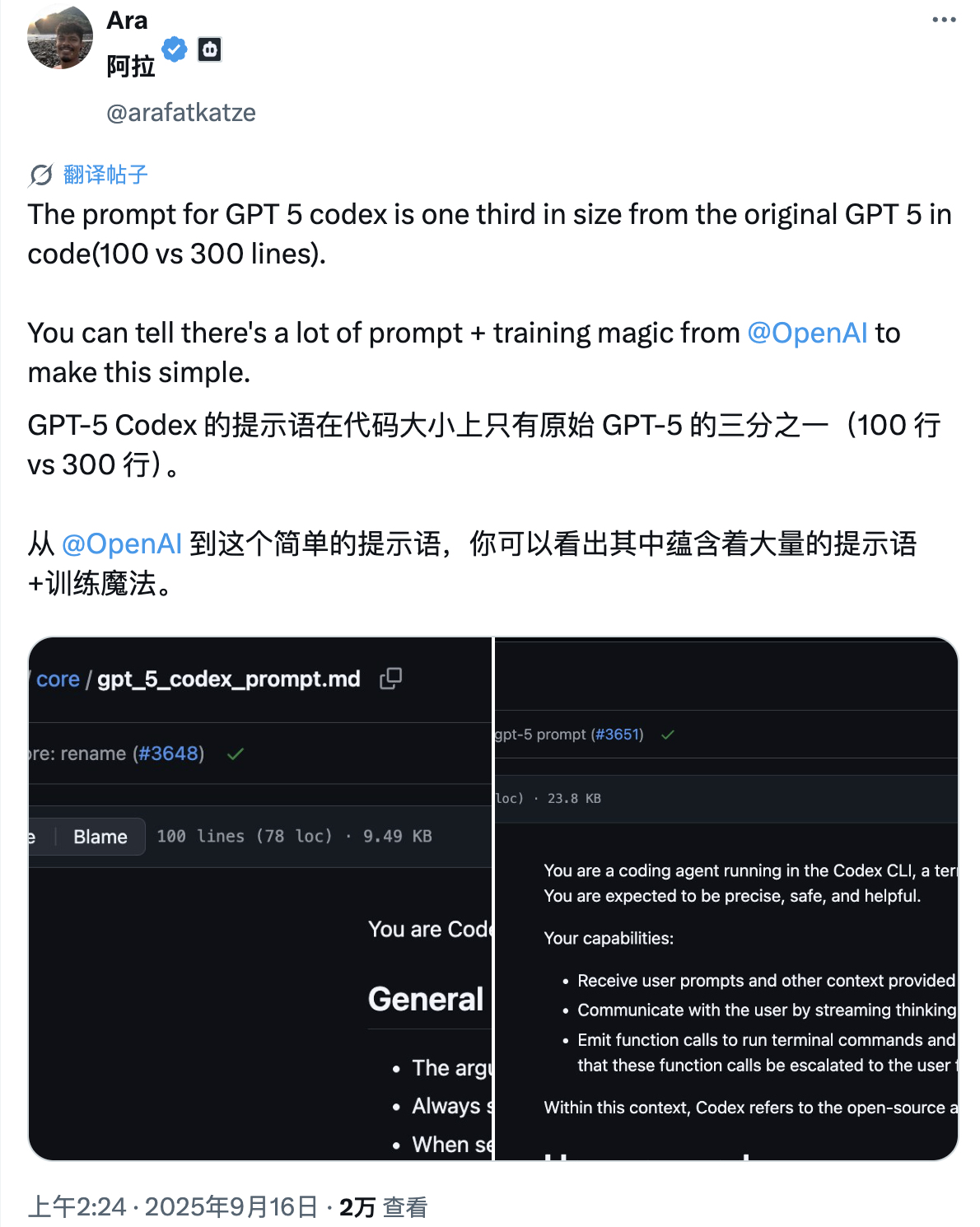

Actuellement, les mots d'invite du système GPT-5-Codex ont été divulgués et les développeurs intéressés peuvent les étudier.

Adresse du mot d'invite système : https://github.com/elder-plinius/CL4R1T4S/blob/main/OPENAI/Codex_Sep-15-2025.md

Le célèbre blogueur Dan Shipper a donné l'évaluation suivante après avoir expérimenté GPT-5-Codex :

Nous l'avons testé sur @every pendant quelques jours et les résultats ont été assez impressionnants :

– Il choisit dynamiquement le temps de « réflexion » en fonction de la tâche – il peut travailler longtemps sur des problèmes difficiles, tout en fournissant des réponses instantanées à des questions simples.

– Lors de nos tests de notre base de code de production, il peut fonctionner de manière autonome jusqu’à 35 minutes — une mise à niveau notable par rapport à GPT-5, qui a tendance à être trop prudent.

– Il permet de basculer facilement entre les environnements de développement local et web. Vous pouvez démarrer une tâche dans VS Code, puis la confier à Codex Web pour qu'elle soit finalisée lors de vos achats.

– Il est livré avec un agent de révision de code qui exécute réellement votre code, afin de pouvoir trouver plus de bugs.Voici nos impressions générales après des tests internes approfondis :

– Il s’agit d’une excellente mise à niveau qui fait de Codex CLI une alternative convaincante à Claude Code.

– Cependant, il faut un sérieux coup de pouce pour que cela fonctionne au mieux. Par exemple, @kieranklaassen n'a réussi à le faire fonctionner que 5 minutes maximum, tandis que @DannyAziz97 a réussi.

– Parfois, il peut être « paresseux » – il peut ne pas réfléchir suffisamment à certaines tâches, ou simplement refuser d’entreprendre des tâches s’il pense qu’elles sont trop importantes.

– J’ai passé le week-end à soumettre une nouvelle PR pour @CoraComputer en utilisant Codex CLI et j’ai trouvé qu’il était très facile à utiliser et à démarrer – c’est un excellent modèle.

Alexander Embiricos, chef de produit chez OpenAI Codex, a déclaré que l'amélioration significative des performances est en grande partie due à la « capacité de réflexion » dynamique de GPT-5-Codex. Il a expliqué que GPT-5-Codex fonctionne de manière similaire, mais qu'au lieu d'intégrer un routeur, il peut ajuster le temps passé sur une tâche en temps réel.

Embiricos souligne que cela constitue un avantage par rapport aux mécanismes de routage : ces derniers doivent déterminer dès le départ la puissance de calcul et le temps à allouer à un problème, tandis que GPT-5-Codex peut décider après cinq minutes de traitement d'une tâche qu'« il nous faut une heure supplémentaire ». Il affirme avoir vu le modèle fonctionner en continu pendant plus de sept heures dans certains cas.

Ces derniers mois, presque toutes les grandes entreprises d'IA ont publié des mises à jour majeures allant dans le même sens : les capacités de programmation. Cependant, à y regarder de plus près, on constate que les « optimisations » pour les utilisateurs lambda sont en baisse.

À première vue, cela pourrait s'expliquer par le fait que les produits d'IA destinés au grand public ont atteint un goulot d'étranglement. Des fonctions telles que le chat, l'écriture et la traduction sont déjà relativement matures, ce qui rend difficile la réalisation de percées.

Mais la raison la plus profonde ne peut être évitée par la logique commerciale.

Développer des modèles d'IA avancés nécessite des investissements colossaux, et quelqu'un doit en assumer les coûts. Plutôt que de compter sur un grand nombre d'utilisateurs peu rémunérateurs pour se rétablir lentement, il est préférable de cibler directement les utilisateurs à forte valeur ajoutée, réellement prêts à payer. Les programmeurs sont parmi les plus disposés à payer pour des outils d'IA, et leur fidélité est élevée.

De ce point de vue, abandonner le discours sur l'égalité technologique pourrait révéler que l'avenir de l'IA est plus élitiste qu'on ne l'imagine. Ce n'est pas forcément une mauvaise chose, mais il faut au moins en être conscient.

#Bienvenue pour suivre le compte public officiel WeChat d'iFaner : iFaner (ID WeChat : ifanr), où du contenu plus passionnant vous sera présenté dès que possible.