Apple ajoute la détection de nudité à FaceTime, un choix entre confidentialité et éthique

Vous avez sûrement vu la publicité d'Apple et de Yue Yunpeng, dont la proposition principale est :

S'efforçant de garantir la confidentialité et la sécurité, c'est très iPhone.

Apple l'a dit et l'a effectivement fait. Cependant, lorsque « vie privée » et « moralité » sont placées aux deux extrémités de l'échelle, même Apple se retrouve face à un dilemme.

▲ Affiche publicitaire collaborative d'Apple et de Yue Yunpeng. Source de l'image : Apple

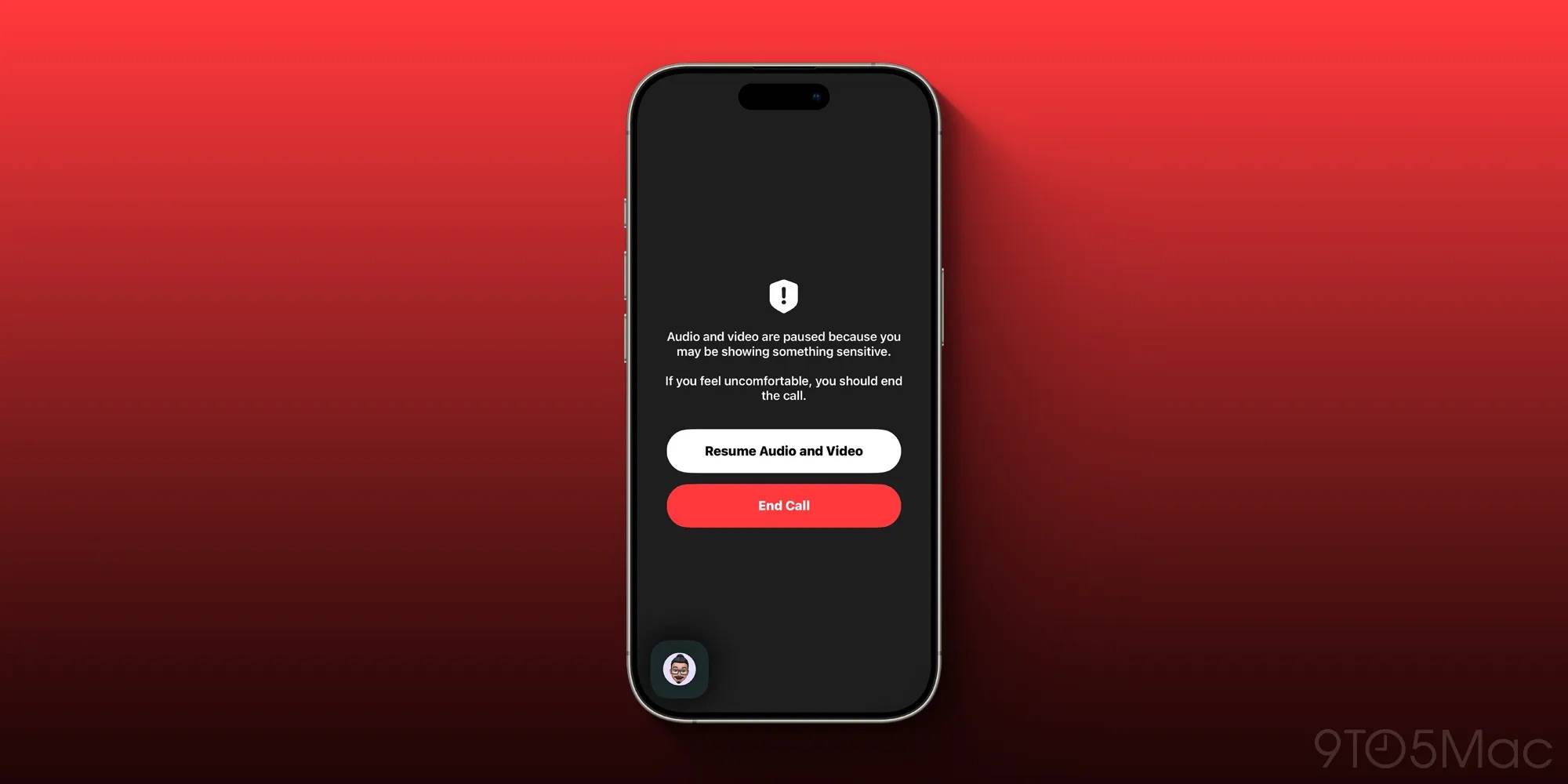

Selon 9to5mac , Apple a lancé une fonctionnalité de détection de nudité pour FaceTime dans l'aperçu développeur d'iOS 26, qui vise à détecter la nudité inappropriée dans les appels vidéo.

Il semblerait qu'Apple utilisera l'algorithme d'IA de l'appareil pour identifier en temps réel les scènes de nudité lors des appels. Lorsque le système identifiera de possibles scènes de nudité, il mettra immédiatement l'appel vidéo en pause et affichera un avertissement.

Apple a déclaré que cette fonctionnalité avait été initialement conçue pour être utilisée sur les comptes des enfants afin de fournir aux adolescents un environnement social numérique plus sûr.

▲ Interface FaceTime figée. Image : 9to5Mac

Cette fonctionnalité est issue du programme de détection des contenus pédopornographiques (CSAM) lancé par Apple il y a quelques années. Mais pour une raison inconnue, elle a été étendue aux utilisateurs de tous âges dans la version développeur d'iOS 26. Autrement dit, les utilisateurs adultes sont également « protégés ».

Bien qu'Apple ait souligné que toutes les opérations de reconnaissance sont traitées localement sur l'appareil et que les données ne seront pas téléchargées dans le cloud, l'extension de la couverture par âge a suscité une vive controverse sur les réseaux sociaux. Un utilisateur nommé krazygreekguy a commenté sur 9to5mac :

Je comprends le raisonnement derrière tout cela, mais ils n'ont pas le droit d'exercer un tel contrôle sur des adultes. Aucune organisation n'a le droit de porter atteinte à la vie privée des gens.

▲ Image promotionnelle d'Apple. Source : Apple

En d’autres termes, les gens craignent que cette extension de la couverture d’âge soit une extension du pouvoir unique d’Apple, allant jusqu’à une ingérence excessive dans la vie privée, et puisse même s’étendre à des scénarios qui n’ont rien à voir avec des intentions pornographiques.

Imaginez que vous êtes en visioconférence avec votre enfant à la maison. Parce que vous êtes torse nu ou que vous ajustez vos vêtements, le système peut vous identifier par erreur comme étant mal exposé, ce qui peut bloquer la vidéo :

Mon iPhone pense-t-il que je suis un pervers ?

▲ FaceTime. Image : Apple

FaceTime existe depuis 14 ans. Fonctionnalité incontournable de l'écosystème Apple, ce n'est pas la première fois qu'elle suscite la controverse. En 2019, FaceTime présentait une faille technique qui permettait aux utilisateurs d'entendre l'appel de leur interlocuteur sans se connecter. Bien qu'Apple ait rapidement corrigé cette faille, elle a également semé le doute sur les capacités réelles de protection de la vie privée d'Apple, sous couvert de propagande.

▲ Image promotionnelle d'Apple. Source : Apple

En tant que valeur fondamentale de l'entreprise, Apple a toujours attaché une grande importance à la protection de la vie privée des utilisateurs.

Ceux qui suivent Apple depuis longtemps se souviennent peut-être de l'incident de 2015, lorsqu'Apple a confronté le FBI. Après la fusillade de San Bernardino en Californie, le FBI a demandé à déverrouiller l'iPhone utilisé par le meurtrier afin d'obtenir des informations sur des activités terroristes, mais Apple a refusé. À l'époque, le PDG d'Apple, Tim Cook, avait déclaré : « Une fois la porte dérobée ouverte, elle ne peut plus être refermée, ce qui mettrait en danger la sécurité et la confidentialité de tous les utilisateurs. »

▲ Interface FaceTime. Image : Apple

Malgré cela, Apple a également suscité des controverses en raison de problèmes de confidentialité. Par exemple, le plan de détection des contenus pédopornographiques mentionné ci-dessus a également été critiqué lors de son lancement.

Depuis iOS 15 en 2021, Apple utilise la technologie NeuralHash sur les appareils locaux pour comparer les valeurs de hachage des photos téléchargées par les utilisateurs sur iCloud avec la base de données CSAM gérée par les agences américaines compétentes. Lorsque le seuil prédéfini est dépassé, Apple déchiffre les données concernées et effectue un examen manuel. Après confirmation, le compte est désactivé et signalé au Centre national pour les enfants disparus et exploités (NCMEC).

Apple affirme que le but de cette fonctionnalité est de détecter et d'attraper les délinquants sexuels sur mineurs, de protéger au maximum la confidentialité des utilisateurs sur le plan technique et d'éviter les erreurs de jugement et les abus.

Cependant, les organisations de protection de la vie privée et les experts en sécurité se sont demandés si Apple allait déroger à son engagement constant en matière de protection de la vie privée. Après tout, l'analyse CSAM consiste essentiellement à identifier les informations privées téléchargées par les utilisateurs. Face à la pression, Apple a annoncé le report du lancement de cette fonctionnalité et le lancement d'autres mesures de protection des enfants, telles que la sécurité des informations et des communications et les fonctions d'intervention de recherche Siri.

Pour Apple, la « moralité » et la « vie privée » ne peuvent pas être atteintes en même temps.

Revenons à la détection de nudité sur FaceTime mentionnée au début : Apple avait initialement prévu cette fonctionnalité de sécurité pour mieux protéger les adolescents. Elle permet d'éviter que les adolescents soient exposés à une nudité inappropriée lors des appels vidéo. On recense d'innombrables cas similaires de harcèlement sexuel et de fraude lors d'appels vidéo mobiles dans le monde. Avec plus d'un milliard d'utilisateurs, Apple se doit d'assumer cette responsabilité sociale.

Mais d’un autre côté, où se situent les limites de cette « intervention automatique » reste une question importante.

Lorsque la moralité publique et la vie privée sont placées aux deux extrémités de l'échelle, la manière de peser le pour et le contre et de prendre la « bonne » décision pourrait inquiéter Apple pendant longtemps.

Auteurs : Zhou Qiantong, Xiao Qinpeng

#Bienvenue pour suivre le compte public officiel WeChat d'iFanr : iFanr (ID WeChat : ifanr), où du contenu plus passionnant vous sera présenté dès que possible.