Après avoir été nommé par OpenAI, Zhipu vient de publier un nouveau modèle open source : le moteur de recherche national le plus polyvalent, créant un moteur de recherche en une seule phrase

L'open source des fabricants nationaux de modèles à grande échelle continue de s'accélérer.

Zhipu vient de lancer officiellement son dernier modèle phare, le GLM-4.5. Selon le communiqué officiel de Zhipu, il s'agit d'un « modèle de base spécialement conçu pour les applications d'agent ».

Fidèles à nos principes open source, ce modèle est désormais disponible simultanément en open source sur les plateformes Hugging Face et ModelScope. Les pondérations du modèle sont conformes à la licence MIT et peuvent être utilisées commercialement.

Version à économie de débit :

- GLM-4.5 a atteint le niveau de pointe des modèles open source en termes de raisonnement, de code et de capacités complètes des agents.

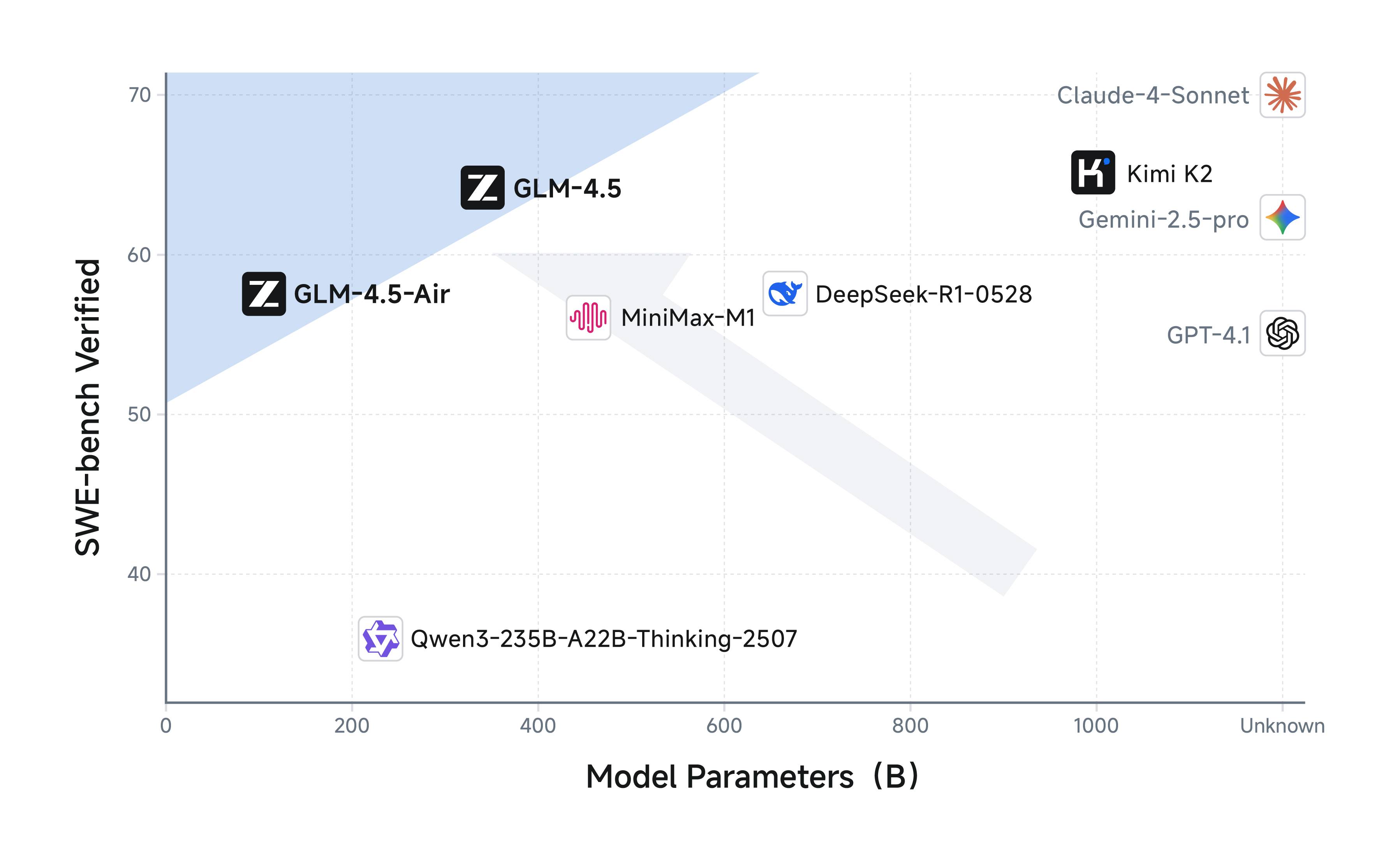

- GLM-4.5 utilise une architecture mixte d'experts (MoE), y compris GLM-4.5 : le total des paramètres est de 355 milliards, les paramètres d'activation sont de 32 milliards ; GLM-4.5-Air : le total des paramètres est de 106 milliards, les paramètres d'activation sont de 12 milliards ;

- Les deux versions sont entièrement open source et prennent en charge la licence MIT ;

- GLM-4.5 et GLM-4.5-Air prennent tous deux en charge un mode de raisonnement hybride, offrant deux modes : un mode de réflexion pour le raisonnement complexe et l'utilisation d'outils, et un mode de non-réflexion pour une réponse immédiate.

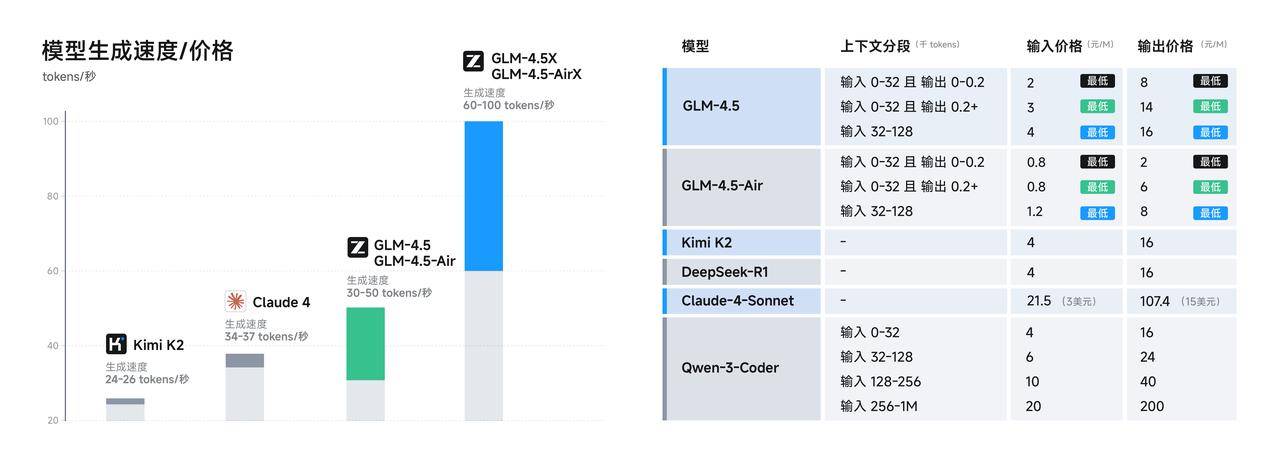

- Le prix d'appel de l'API est aussi bas que 0,8 yuan/million de jetons pour l'entrée et 2 yuans/million de jetons pour la sortie ; la version haute vitesse peut atteindre jusqu'à 100 jetons/seconde.

L'un des principaux arguments techniques de vente de GLM-4.5 réside dans sa première intégration native des fonctions de raisonnement, de codage et d'agent au sein d'un modèle unique. Alors que d'autres modèles excellent dans les deux domaines, GLM-4.5 offre toutes ces fonctionnalités.

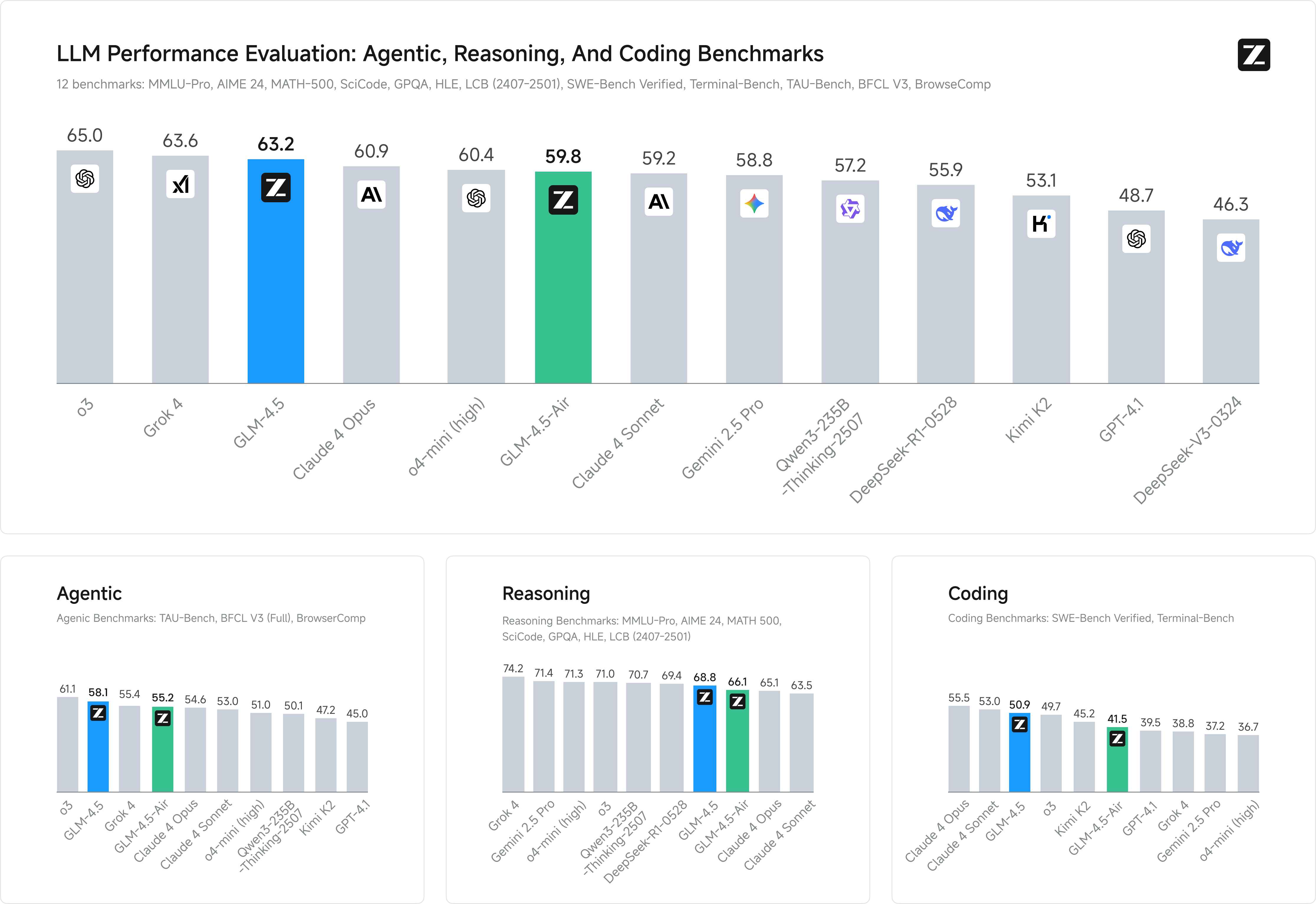

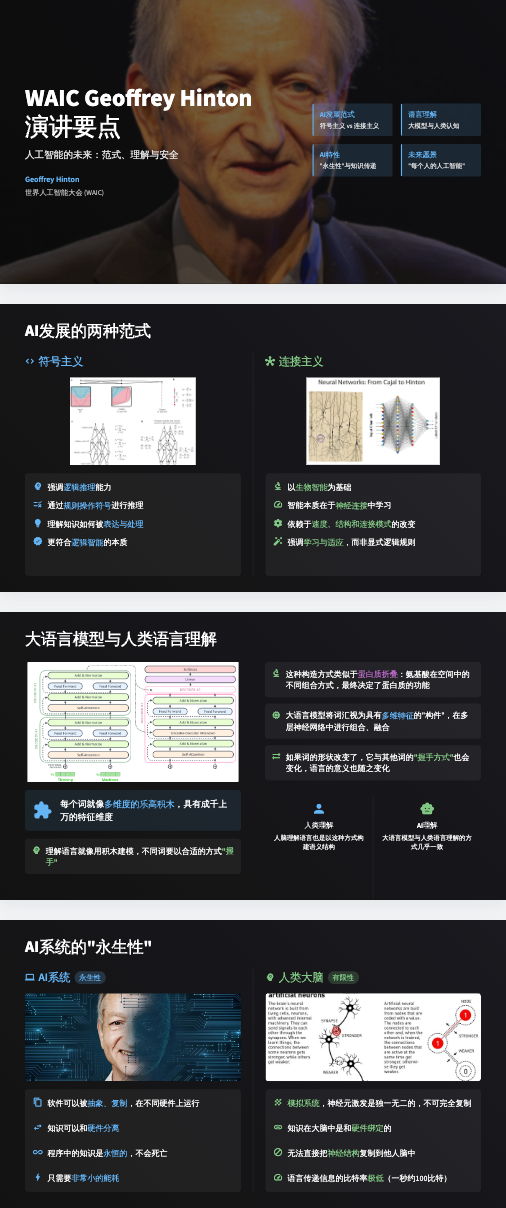

Comme d’habitude, examinons d’abord la section « score courant » du nouveau modèle.

Zhipu a sélectionné 12 des benchmarks les plus représentatifs pour démontrer ses performances, dont MMLU Pro, AIME 24, MATH 500, SciCode, GPQA et HLE, tous familiers. Le score moyen a montré que GLM-4.5 se classait au deuxième rang mondial, au premier rang parmi les modèles nationaux et au premier rang parmi les modèles open source.

Bien sûr, les scores de course à pied seuls ne servent à rien, et des tests plus pratiques sont plus convaincants.

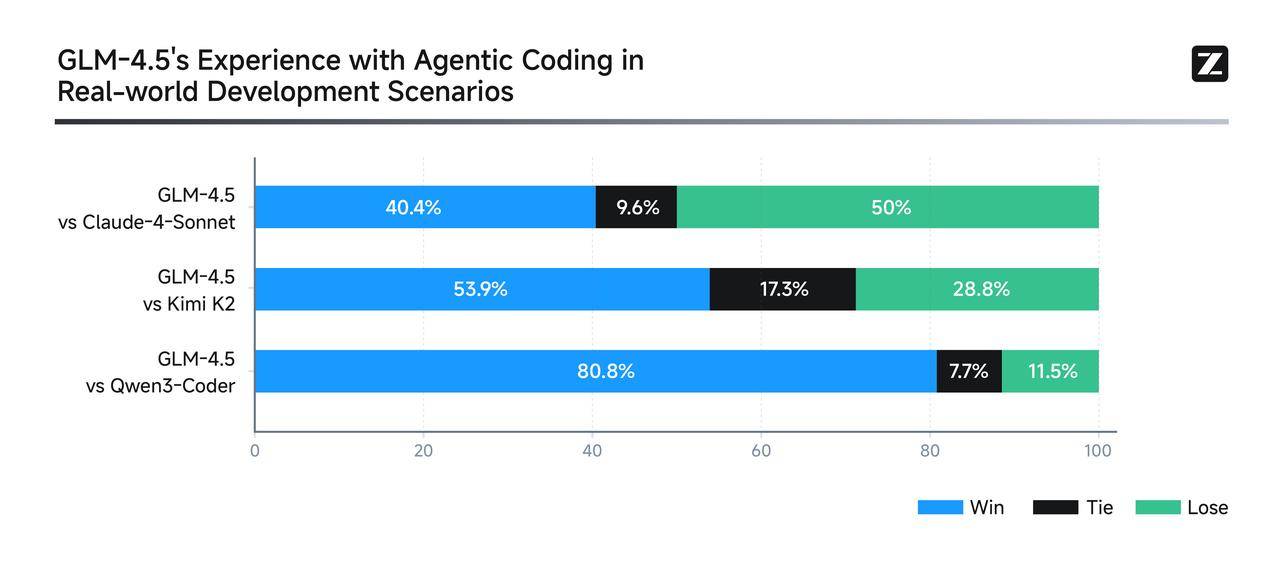

Afin de démontrer la force de GLM-4.5 dans des scénarios de codage d'agent réels, Zhipu l'a directement intégré à Claude Code pour concurrencer des modèles tels que Claude-4-Sonnet, Kimi-K2 et Qwen3-Coder.

Le plan de tests était rigoureux : 52 tâches de développement de programmation couvrant six domaines majeurs ont été testées lors de plusieurs cycles de tests interactifs dans des environnements de conteneurs indépendants, en se concentrant sur l'exécution en situation réelle. Les résultats ont montré que, même si des améliorations importantes restaient possibles avec Claude-4-Sonnet, GLM-4.5 affichait néanmoins d'excellentes performances en termes de fiabilité des appels d'outils et d'achèvement des tâches.

Zhipu a même rendu publiques toutes les questions du test et les trajectoires des agents (https://huggingface.co/datasets/zai-org/CC-Bench-trajectories), ce qui m'a donné le sentiment qu'ils accueillent des collègues pour « combattre les faux ».

Jetons un œil à quelques démos plus convaincantes, qui sont également très précieuses.

Entrez simplement l'invite « Créer un site Web de recherche Google » sur le site Web officiel de z.ai, et GLM-4.5 générera réellement un véritable moteur de recherche utilisable en une seule phrase.

La boîte de fonction quantique construite par GLM-4.5 est entièrement fonctionnelle et démontre pleinement les capacités complètes du modèle.

Pour une solution plus complexe, vous pouvez également générer une page de globe 3D zoomable où les utilisateurs peuvent cliquer sur un emplacement pour voir les détails, accompagnés d'une animation de zoom fluide.

▲Conseils : Créez une page web avec Three.js et JavaScript pour créer un monde 3D affichant les lieux visités, à partir d'un tableau. Cliquer sur les marqueurs du globe 3D animera un effet de zoom et ouvrira des informations détaillées sur le voyage avec photos.

Contrairement aux outils PowerPoint traditionnels basés sur l'IA, qui s'appuient sur des modèles pour renseigner les informations, GLM-4.5 recherche automatiquement des ressources et des images, puis crée des présentations directement au format HTML à partir du contenu réel. Au-delà du format standard 16:9, il prend également en charge de manière flexible les couvertures de réseaux sociaux, les images longues, les cartes Xiaohongshu et même les CV personnels.

En termes d'expérience développeur, les fabricants chinois commencent également à s'améliorer. Par exemple, GLM-4.5 est compatible avec les principaux outils de code intelligence tels que Claude Code, Cline et Roo Code. Un guide d'utilisation complet est disponible ici :

- Utilisateurs nationaux : https://docs.bigmodel.cn/cn/guide/develop/claude

- Utilisateurs étrangers : https://docs.z.ai/scenario-example/develop-tools/claude

Si ce qui précède n'est que le « visage », alors le cœur technique est le véritable « intérieur » de GLM-4.5.

Un fait peu connu est que le nombre de paramètres de GLM-4.5 représente seulement la moitié de celui de DeepSeek-R1 et le tiers de celui de Kimi-K2, mais les performances ne sont pas compromises. Cela est dû à la meilleure efficacité des paramètres du modèle GLM.

En particulier, le GLM-4.5-Air, avec 106 milliards de paramètres au total et 12 milliards de paramètres d'activation, a déjà approché les performances du Gemini 2.5 Flash et du Claude 4 Sonnet lors des tests d'inférence. Il se classe également à la frontière de Pareto du rapport performances/paramètres sur la liste SWE-bench Verified ; autrement dit, il offre un rapport coût-performances supérieur avec un encombrement réduit.

L’amélioration des performances est indissociable du « miracle » du processus de formation.

GLM-4.5 et GLM-4.5-Air utilisent un processus d'entraînement similaire : ils effectuent d'abord un pré-entraînement sur 15 000 milliards de jetons de données générales. Ensuite, ils effectuent un entraînement ciblé sur 8 000 milliards de jetons de données dans des domaines tels que le code, le raisonnement et les agents. Enfin, l'apprentissage par renforcement est utilisé pour améliorer les capacités de raisonnement, de code et d'agent du modèle. Avec de l'argent et des ressources, chacun peut vraiment faire ce qu'il veut.

De plus, les avancées de GLM-4.5 en termes de coût et d'efficacité pourraient être encore plus significatives. Le prix des appels d'API est de seulement 0,8 yuan par million de jetons en entrée et de 2 yuan par million de jetons en sortie. De plus, la version haut débit peut générer des jetons à une vitesse mesurée allant jusqu'à 100 jetons par seconde, répondant ainsi aux exigences de déploiement à faible latence et à forte concurrence des applications réelles. Cela représente une réduction de prix significative.

L'API est désormais disponible sur la plateforme ouverte BigModel.cn, compatible en un clic avec le framework Claude Code. Les utilisateurs réguliers peuvent également tester la version complète de GLM-4.5 sur Zhipu Qingyan (chatglm.cn) et Z.ai.

Il convient de noter que le mois dernier, OpenAI a nommé directement Zhipu dans un rapport publié sur son compte Global Affairs, affirmant que l'entreprise avait réalisé des progrès significatifs dans la compétition mondiale en matière d'IA. Le ton est à la fois rare et direct.

Rétrospectivement, Zhipu a connu une croissance relativement stable, maintenant un rythme soutenu, répétant constamment ses modèles, libéralisant les initiatives open source et conservant une orientation claire. Dans ce contexte, il n'est pas surprenant qu'elle soit la première des « Six Petits Dragons » de l'IA à s'introduire en bourse.

#Bienvenue pour suivre le compte public officiel WeChat d'iFanr : iFanr (ID WeChat : ifanr), où du contenu plus passionnant vous sera présenté dès que possible.