Claude 4, membre principal : En 2027, l’IA automatisera presque tous les emplois de cols blancs Conversation de 10 000 mots

Le codage de l’IA, thème principal de l’industrie de l’IA cette année, est devenu de plus en plus clair ces derniers temps.

En plus du nouveau roi de la programmation Claude Opus 4 qui a dominé l'écran la semaine dernière, la nouvelle version de DeepSeek R1 s'est également concentrée sur les capacités de code. Il n'y a pas longtemps, OpenAI a acquis l'assistant de programmation d'IA Windsurf pour 3 milliards de dollars américains, puis a lancé l'agent de programmation Codex.

Ces derniers jours, Ming Chaoping, l'ancien chef de produit de Kimi, et Meituan, qui se bat avec JD.com, ont officiellement annoncé des produits liés à la programmation de l'IA.

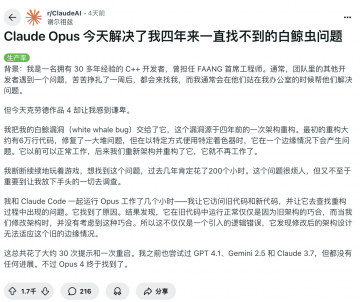

Un développeur C++ avec plus de 30 ans d'expérience a publié sur Reddit que Claude Opus 4 avait résolu un bug qui le dérangeait depuis quatre ans, et que c'était la première IA qu'il utilisait qui pouvait faire cela.

Pourquoi Claude est-il si bon en programmation ? Aujourd’hui, lorsque les gens mentionnent Anthropic, ils supposent presque qu’il s’agit d’une « entreprise qui crée des modèles de programmation ». Mais pour eux, quelle est la véritable avancée de cette génération de modèles ? Que se passera-t-il dans le futur ?

Il y a quelques jours, une conversation podcast avec Sholto Douglas, chercheur principal chez Claude Opus 4, a répondu en détail à ces questions. C'est très instructif et ça vaut la peine de l'écouter.

Principaux points de discussion (pour une visualisation plus rapide) :

Claude Opus 4, quelles sont les avancées qui méritent vraiment d'être prises en compte ?

Tout d’abord, les améliorations de capacités sont très équilibrées.

D’une part, ses capacités d’exécution de code ont été considérablement améliorées. Il peut non seulement comprendre des exigences complexes, mais également rechercher des informations de manière indépendante, exécuter des tests et déboguer des erreurs. Il a vraiment la capacité de « fonctionner du début à la fin ». D'autre part, la durée de la tâche a également été considérablement étendue pour prendre en charge le raisonnement et le fonctionnement en plusieurs étapes, ce qui signifie qu'elle est non seulement intelligente mais également très persistante.

En termes d'architecture, Claude Opus 4 ajoute des appels d'outils et des modules de mémoire à long terme, lui permettant de gérer des tâches avec plus de continuité contextuelle. D'un assistant de code à un agent intelligent avec la capacité de « concevoir des solutions ».

Bien sûr, il y a un plafond.

L'équipe admet qu'il n'y a pas de limite supérieure claire à la complexité intellectuelle de la réalisation de la tâche – la difficulté réside dans la manière d'élargir la gamme de contextes que le modèle peut percevoir et exploiter, lui permettant d'utiliser plusieurs outils et de mémoriser davantage d'informations clés.

À quoi ressemble l'avenir ?

Sholto Douglas a mentionné plusieurs directions claires dans le podcast :

- L’apprentissage par renforcement (RL) continuera d’améliorer les performances du modèle dans les tâches continues ;

- Les agents de code pourront fonctionner pendant des heures avec seulement une intervention humaine occasionnelle ;

- Les mannequins peuvent devenir des « travailleurs virtuels à distance » dans des emplois basés sur la connaissance ;

- Si la construction de laboratoires automatisés et de plateformes robotisées se poursuit, les modèles pourront participer à des tâches physiques réelles telles que des expériences biologiques ou des fabrications.

Mais il y a une condition préalable : la fiabilité de l’agent intelligent doit être maintenue.

Même si nous ne sommes pas encore en mesure d’atteindre 100 % de réussite, le taux de réussite augmente régulièrement dans le temps limité. On s'attend à ce que d'ici la fin de 2025, les agents intelligents programmés soient capables de « fonctionner de manière stable pendant plusieurs heures » et que les humains n'aient besoin de vérifier qu'occasionnellement.

En plus d'écrire du code ?

La programmation n’est qu’un « indicateur avancé » des capacités du modèle. Les domaines professionnels tels que la médecine et le droit attendent encore l’amélioration des données et des outils, mais une fois qu’ils seront prêts, ils connaîtront également des avancées rapides. Le goulot d’étranglement actuel ne réside pas dans l’IA elle-même, mais dans le mécanisme de vérification et l’infrastructure du monde réel.

D'ici 2027-2030, le modèle sera capable d'automatiser presque tout le travail des cols blancs, mais sans laboratoires correspondants et mécanismes de rétroaction du monde réel, il s'agira de « capacités solides mais difficiles à mettre en œuvre ».

Comment juger si le modèle s’est réellement amélioré ?

L’équipe a mentionné qu’un bon système d’évaluation (Evals) est particulièrement important. Il ne mesure pas seulement les indicateurs techniques, mais met également l’accent sur l’expertise et le goût de l’évaluateur. C’est aussi la raison pour laquelle le seuil d’évaluation des modèles est de plus en plus élevé. Dans le même temps, les utilisateurs sont tenus de continuer à utiliser, à interagir et à fournir des commentaires pour parvenir à une véritable « co-évolution ».

Laboratoires vs entreprises d'application, qui a le dessus ?

Douglas estime que le laboratoire offre des opportunités grâce aux API ouvertes, mais les principaux avantages demeurent :

- Capacité de conversion de puissance de calcul ;

- Modèle de « recrutabilité » et de confiance des utilisateurs ;

- Une meilleure compréhension personnelle.

Les laboratoires sont comme des fabricants de « moteurs intelligents », se concentrant sur les limites de leurs capacités ; Les sociétés d'applications sont meilleures en matière de mise en œuvre et d'expérience utilisateur. À l’avenir, il y aura de plus en plus de chevauchement, d’intégration et de concurrence entre les deux.

L’entreprise modèle laissera-t-elle les autres entreprises sans issue en raison de son coût et de ses avantages sous-jacents ? L'opinion de Douglas est la suivante :

Non, au contraire, cela apporte de la vitalité.

Il estime que tous les fossés finiront par être brisés, et que ce qui compte vraiment, ce sont les relations avec les clients, l’orchestration des tâches et l’expérience intégrée.

Le dernier mot-clé est « alignement »

À mesure que les capacités du modèle s’améliorent, le problème de « l’alignement » devient plus important. Anthropic fait progresser la recherche sur l’interprétabilité, en essayant de « comprendre ce que pense le modèle ». Bien que l’apprentissage par renforcement puisse améliorer les capacités, il peut également détruire les mécanismes d’alignement existants. À l’avenir, il faudra que les universités, les gouvernements et davantage de chercheurs promeuvent conjointement la « science de l’alignement ».

Lien vidéo original : https://www.youtube.com/watch?v=W1aGV4K3A8Y

Ce qui suit est la transcription de l’interview, qui a été légèrement modifiée par APPSO.

Animateur : Sholto Douglas est l’un des membres principaux du modèle Anthropic Claude 4. C'était un grand plaisir de discuter avec lui cette fois-ci. Nous avons discuté de divers sujets, notamment de la manière dont les développeurs perçoivent la tendance de développement de la nouvelle génération de modèles d'Anthropic. Nous avons discuté de l'orientation que pourraient prendre ces modèles dans 6, 12, voire 2 à 3 mois, ainsi que des facteurs clés nécessaires pour créer des agents d'IA fiables et du moment où ces modèles pourraient faire les mêmes percées dans des domaines professionnels comme la médecine et le droit qu'ils ont fait dans la programmation. En outre, Douglas a également partagé son point de vue sur « Alignment Research » et sa réponse à la prédiction « AI 2027 ». C'est une conversation fascinante et je pense que vous l'apprécierez.

Les avancées importantes et les possibilités futures de Claude Opus 4

Animateur : Au moment où ce podcast sera mis en ligne, Claude 4 sera sorti et tout le monde devrait avoir commencé à en faire l'expérience. Je suis curieux, vous avez été l'une des premières personnes à mettre la main sur ces modèles, quel aspect vous a le plus enthousiasmé ?

Douglas : C’est véritablement un autre bond en avant dans l’ingénierie logicielle. Le modèle Opus excelle vraiment à cet égard. Il m'arrive souvent de lui confier une tâche très complexe impliquant notre vaste base de code et il la termine de manière presque totalement autonome . Il recherchera des informations, comprendra les exigences et exécutera des tests de manière autonome. L’ensemble du processus est très indépendant et efficace. Chaque fois que je vois ce genre de performance, je suis choqué.

Animateur : Chaque fois qu’une nouvelle génération de modèle sort, nous devons réajuster notre modèle cognitif pour juger quelles méthodes sont efficaces et lesquelles ne le sont pas. Votre utilisation et votre compréhension de ces modèles ont-elles changé dans la programmation ?

Douglas : Je pense que le plus grand changement est l’amélioration de l’horizon temporel. Je pense que l’amélioration des capacités du modèle peut être comprise à partir de deux dimensions : l’une est la complexité intellectuelle de la tâche, et l’autre est la quantité de contexte , ou le nombre d’actions consécutives, sur lesquelles ils peuvent raisonner et traiter de manière significative. Ces modèles sont particulièrement améliorés dans la deuxième dimension, où ils peuvent réellement effectuer des opérations en plusieurs étapes, déterminer les informations qu’ils doivent obtenir de l’environnement, puis agir en fonction de ces informations. De plus, il peut appeler des outils tels que Cloud Code, ce qui en fait plus qu'un simple copier-coller, et dispose de capacités d'exécution plus fortes. Maintenant, je peux le voir fonctionner pendant des heures, avec la même efficacité que le travail humain continu.

Animateur : Alors, par où pensez-vous que les personnes qui utilisent Claude 4 pour la première fois devraient commencer ?

Douglas : Je pense que la meilleure façon est de l’intégrer directement dans votre travail. Par exemple, si vous prévoyez d’écrire du code aujourd’hui, laissez-le simplement le faire pour vous et observez comment il juge les informations et décide de l’étape suivante. Je vous garantis que vous serez étonné par ses performances.

Hôte : Cette génération de modèle est plus puissante et de nombreuses personnes prévoient de l'utiliser pour créer des produits. Où pensez-vous que se trouvent les nouvelles possibilités pour les développeurs ?

Douglas : J’ai toujours aimé le terme « produit exponentiel ». Les développeurs doivent constamment faire progresser les capacités des modèles pour concevoir des produits . Des exemples comme Cursor, Windsurf et Devon sont typiques. Cursor a commencé à construire l'expérience de codage future lorsque les capacités du modèle n'étaient pas suffisamment fortes, mais leur vision ne s'est véritablement réalisée qu'avec l'apparition de Claude 3.5 et Sonne. Windsurf est allé encore plus loin et a conquis une partie du marché. Leur succès réside dans leur capacité à saisir cette fenêtre de croissance exponentielle.

Vous pouvez désormais voir Claude Code, la nouvelle intégration GitHub, les codecs d'OpenAI, l'agent de codage de Google, etc. Tout le monde travaille autour du concept d'« agent de codage » dans le but d'atteindre une plus grande autonomie et un fonctionnement asynchrone . À l’avenir, vous ne pourrez plus opérer une fois par minute, mais plutôt gérer une flotte de modèles d’IA, avec plusieurs modèles prenant en charge leurs propres tâches et travaillant ensemble. Je pense que cette direction mérite vraiment d’être explorée.

Animateur : Avez-vous déjà vu un scénario comme « collaboration parallèle multi-modèle » ? À quoi cela ressemblera-t-il ?

Douglas : Je connais beaucoup de gens chez Anthropic qui exécutent plusieurs instances de Claude Code dans différents environnements en même temps, ce qui a l'air plutôt cool. Mais pour être honnête, personne n’a encore vraiment compris comment faire cela. Il s’agit en fait d’une exploration de l’ampleur que peut atteindre la « bande passante de gestion » humaine. Je pense que c’est l’une des questions clés pour le développement économique futur : comment mesurer les rendements de productivité d’un modèle ? Au début, nous devions encore vérifier manuellement les résultats du modèle, ce qui signifiait que l’impact du modèle serait limité par les capacités de gestion humaine. Tant que nous ne pourrons pas faire confiance aux modèles pour gérer les modèles, ce niveau de mise à niveau de l’abstraction sera essentiel.

Modérateur : Donc si vous vérifiez le modèle toutes les 15 minutes, toutes les heures, toutes les 5 heures, le nombre de modèles que vous pouvez gérer sera très différent ?

Douglas : Oui, Jen-Hsun Huang a dit quelque chose de similaire. Il a déclaré qu'il était entouré de 100 000 AGI super-intelligents et qu'il disposait d'un énorme pouvoir de pression. Il a également déclaré qu'il était le « facteur de contrôle » dans la chaîne de gestion de Nvidia. Je pense que l’avenir pourrait vraiment évoluer dans cette direction.

Animateur : L’industrie la plus importante à l’avenir sera peut-être celle de la « conception organisationnelle » elle-même.

Douglas : Oui, y compris la manière de renforcer la confiance et la complexité de la structure organisationnelle, tout cela mérite une réflexion approfondie.

Arme secrète : durée prolongée, mise à niveau de l'agent intelligent piloté par RL

Animateur : Vous avez travaillé chez McKinsey pendant un an. Le secteur du conseil peut-il également développer de nouvelles gammes de produits basées sur ces modèles ? Je suis également d'accord avec ce que vous venez de dire : les entreprises d'application doivent progresser plus vite que les modèles. Par exemple, Cursor a eu du mal à lancer son produit au début, mais il a explosé une fois les capacités du modèle en place. Alors, que signifie concrètement, selon vous, « avoir une longueur d’avance » ?

Douglas : Il s’agit de réinventer constamment votre produit afin qu’il soit toujours connecté aux dernières capacités du modèle quelques mois plus tard. Dans le même temps, vous devez maintenir un contact étroit avec les utilisateurs pour vous assurer que le produit est déjà utilisé mais peut également absorber des fonctions de modèle plus avancées.

Animateur : Je pense que c'est le secret : si vous attendez toujours que le modèle soit amélioré avant d'agir, d'autres ont peut-être déjà volé les utilisateurs. Vous avez réalisé de nombreuses avancées dans le domaine de la mémoire, de l’exécution des instructions et de l’utilisation des outils. Pourriez-vous résumer brièvement les progrès actuels dans divers aspects ? Lesquels sont matures et lesquels sont encore en cours d’exploration ?

Douglas : Une bonne façon de considérer les progrès réalisés au cours de l’année écoulée est que l’apprentissage par renforcement (RL) fonctionne enfin vraiment sur les modèles de langage. Il n’y a pratiquement aucune limite à la complexité intellectuelle des tâches que les modèles peuvent résoudre ; par exemple, ils peuvent résoudre des problèmes mathématiques et de programmation complexes. Mais la plupart de ces tâches sont effectuées dans des contextes délimités . Le défi de la mémoire et de l’utilisation des outils réside dans l’élargissement de la gamme de contextes que le modèle peut percevoir et exploiter.

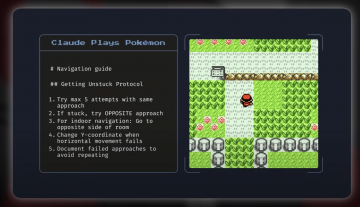

Par exemple, des mécanismes tels que MCP (Model Context Protocol) permettent au modèle d'interagir avec le monde extérieur, tandis que la mémoire lui permet de gérer des tâches sur des périodes plus longues et apporte également une expérience plus personnalisée. Ces avancées visent essentiellement à construire la chaîne de capacités clés des « agents intelligents ». Au fait, l'évaluation de Pokémon est une manière très intéressante d'expérimenter.

Animateur : J'étais un fan de jeux quand j'étais enfant. Je pense que c'est une excellente critique et j'espère que vous la publierez avec ce modèle.

Douglas : En effet, cette critique était extrêmement intéressante. Le modèle n’a pas été spécifiquement formé pour jouer à Pokémon Go, mais il a néanmoins bien fonctionné et a démontré de fortes capacités de généralisation. Cette tâche, bien que pas complètement inconnue, ne ressemble à rien de ce qu’elle a fait auparavant.

Animateur : Je me souviens qu'il y avait beaucoup d'escaliers et de labyrinthes dans le jeu, et les modèles pouvaient vous aider à les franchir.

Douglas : Oui, un autre exemple que j’aime beaucoup est quelque chose que nous avons récemment réalisé et qui s’appelle « Agents explicables ». Il s’agissait à l’origine d’un agent programmé, mais il peut apprendre automatiquement, utiliser des outils de visualisation des neurones et se parler à lui-même pour tenter de comprendre la structure interne du modèle. Il peut même réussir une évaluation de sécurité appelée « Audit Game » : trouver les erreurs délibérément définies par le modèle, générer des hypothèses et vérifier les problèmes par lui-même. Cet outil + la capacité de généralisation sous mémoire est vraiment merveilleux.

Le talon d’Achille des agents intelligents : la fiabilité

Animateur : Il semble que les agents intelligents deviennent vraiment plus puissants. Vous avez déjà dit que la clé de l'agence VA est la « fiabilité » . Où pensez-vous que nous sommes maintenant ?

Douglas : En termes de taux de réussite au fil du temps, nous avons fait de grands progrès. Bien qu'il n'ait pas encore atteint 100 % de stabilité, il existe encore un écart entre la première tentative du modèle et les tentatives multiples. Mais à en juger par la tendance, nous nous dirigeons progressivement vers une « fiabilité de niveau expert ».

Animateur : Alors, selon vous, qu’est-ce qui vous ferait changer d’avis optimiste ?

Douglas : Si le modèle rencontre un goulot d’étranglement dans la durée de la mission d’ici le milieu de l’année prochaine, il faudra s’en méfier. Par exemple, la programmation est un bon indicateur de progrès : si elle commence à décliner, cela peut indiquer un problème structurel. Bien sûr, il se peut aussi que les données soient trop rares. Par exemple, des tâches telles que « utiliser un logiciel comme un humain » sont difficiles à entraîner. Cependant, nous constatons aujourd’hui des progrès étonnants dans ce type de tâches, je reste donc globalement optimiste.

Animateur : Alors, quand pensez-vous que je pourrai avoir un « assistant universel » qui pourra remplir divers formulaires pour moi, rechercher des informations en ligne, etc. ?

Douglas : « Agent assistant administratif personnel » est un sujet brûlant. Qui ne voudrait pas laisser les choses triviales à l’IA ? Mais cela dépend vraiment de la situation. La clé est de savoir si le modèle a pratiqué des situations similaires. Vous ne pouvez pas simplement choisir n’importe qui pour faire le travail financier, n’est-ce pas ? Mais s’il s’agit d’un « comptable virtuel » formé, il sera beaucoup plus fiable. La fiabilité de la mission dépend donc en grande partie du niveau de formation. Si tout se passe bien, nous verrons ces agents exécuter des tâches dans les navigateurs d’ici la fin de cette année, et ils seront la norme l’année prochaine.

Animateur : C’est assez excitant. Votre modèle fonctionne très bien en programmation. Est-ce parce que vous donnez la priorité à sa formation ? Aujourd’hui, lorsque les gens parlent d’anthropique, ils pensent à un « modèle de programmation ».

Douglas : En effet. Nous attachons une grande importance à la programmation car elle constitue un moyen essentiel d’accélérer l’auto-recherche en IA. Nous consacrons également beaucoup d’efforts à mesurer les progrès en matière de compétences en programmation. On peut dire que nous nous concentrons délibérément sur ce domaine.

Animateur : Ces agents accélèrent-ils désormais la recherche en IA ?

Douglas : À mon avis, oui. Ils améliorent considérablement l’efficacité de l’ingénierie. Même certains des meilleurs ingénieurs que je connais disent que dans des domaines familiers, leur efficacité a augmenté de 1,5 fois ; mais dans des domaines inconnus, comme les nouvelles langues ou les contenus inconnus, l'amélioration peut même atteindre 5 fois. L'aide est donc plus évidente lorsqu'on « franchit les frontières ». La clé est : pensez-vous que notre goulot d’étranglement actuel est la puissance de calcul ? Dans le cas contraire, autoriser les agents IA à participer à la recherche équivaut à agrandir l’ensemble de l’équipe de recherche, et l’amélioration de l’efficacité est considérable.

Hôte : Je suppose que ces agents s'occupent principalement de tâches fastidieuses, vous faisant gagner du temps pour réfléchir à des questions plus importantes. Alors, quand commenceront-ils à proposer de manière proactive des idées de recherche utiles ?

Douglas : En ce moment, nous effectuons principalement des tâches d’ingénierie, mais certaines idées créatives commencent à émerger. Je ne dirais pas qu'il y aura une explosion dans trois mois, mais d'ici deux ans, nous devrions pouvoir les voir proposer des idées scientifiques de plus en plus intéressantes. Bien entendu, cela dépend également de l’existence d’un bon mécanisme de rétroaction. Tout comme les humains, les modèles doivent également maîtriser les connaissances dans des tâches complexes par la pratique et les essais et erreurs, et finalement obtenir des résultats de haute qualité.

Animateur : Parce que ces zones sont relativement plus faciles à vérifier, n’est-ce pas ? L’IA fera-t-elle des progrès rapides en programmation, mais peu dans des domaines qui ne sont pas facilement vérifiables, comme la médecine et le droit ?

Douglas : Il y a effectivement ce risque. Mais la bonne nouvelle est que le seuil de vérification pour la recherche sur l’apprentissage automatique est également très bas. Par exemple, « si la valeur de la perte a diminué » est un indicateur très clair. Tant que le modèle peut proposer de bonnes idées dans la recherche ML, il maîtrise une tâche RL très solide, qui est plus adaptée à l'IA que de nombreuses tâches d'ingénierie logicielle. Même si des domaines comme la médecine sont difficiles à vérifier, ils font également des progrès. OpenAI a récemment publié un article de questions-réponses médicales qui quantifiait les questions à réponse longue grâce à un mécanisme de notation plus détaillé. Je pense que cette approche est très prometteuse et résoudra inévitablement progressivement le problème de la vérification difficile à l’avenir.

Animateur : Donc « éventuellement » signifie quand aurons-nous un assistant médical ou juridique vraiment excellent ? Feront-ils partie d’un modèle plus grand ?

Douglas : Certainement.

Animateur : Pensez-vous qu’ils feront partie d’un modèle général plus vaste ? Ou y aura-t-il des modèles spécialisés conçus spécifiquement pour un usage médical ou juridique ?

Douglas : Oui. Je suis un grand suprémaciste du mannequinat. Bien que la personnalisation soit importante (vous souhaitez que le modèle comprenne votre entreprise, vos habitudes de travail et vos préférences personnelles), ces personnalisations doivent être effectuées au niveau de l'entreprise ou de l'individu, plutôt que de diviser le modèle par secteur. Notre collaboration avec Databricks reflète cette orientation de personnalisation de l’entreprise, mais en termes de capacités sous-jacentes, je crois fermement que nous devons toujours nous appuyer sur un seul modèle général puissant. À l’avenir, nous devrions allouer dynamiquement la puissance de calcul (comme les FLOP) en fonction de la complexité de la tâche, plutôt que de créer un tas de petits modèles différents. C’est pourquoi je suis optimiste quant à la voie du grand modèle.

« IA 2027 » : les emplois de cols blancs seront-ils complètement remplacés ?

Hôte : Vous êtes très confiant quant à l’amélioration continue de votre modèle. Beaucoup de gens se demandent comment l’amélioration des capacités des modèles affectera la société ? Par exemple, une question courante est : quel impact ces modèles auront-ils sur le PIB mondial dans les années à venir ?

Douglas : Je pense que l’impact initial sera probablement similaire à celui de la montée en puissance de la Chine, à celui des changements survenus à Shanghai au fil des décennies, mais cette fois-ci, il sera beaucoup plus rapide. Il est toutefois nécessaire de distinguer les différentes manières dont les différents domaines sont impactés. D’ici 2027 ou 2028, nous pouvons presque certainement nous attendre à ce que les modèles automatisent presque tous les emplois de cols blancs , et d’ici 2030 environ. C'est parce que les tâches de col blanc sont très adaptées aux architectures d'IA existantes : il y a des données, des retours d'information et elles peuvent être essentiellement réalisées sur des ordinateurs.

Mais la robotique ou la recherche biologique sont complètement différentes. Par exemple, si vous souhaitez créer un modèle de super programmeur, vous n’avez besoin que de beaucoup de code et de puissance de calcul ; mais si vous voulez créer un modèle de super biologiste, vous avez besoin d'un laboratoire automatisé pour proposer et vérifier des hypothèses et mener des expériences à grande échelle. Nous sommes encore très en retard dans ce type de matériel et d’infrastructure.

Je crains donc qu’il y ait un « décalage » : les emplois de cols blancs évoluent très rapidement, tandis que les industries du monde réel qui peuvent réellement améliorer la qualité de la vie humaine – comme les soins médicaux et l’industrie manufacturière – se développent lentement en raison d’infrastructures insuffisantes. L'IA elle-même est très puissante, mais pour qu'elle fonctionne dans le monde réel, nous devons construire à l'avance des « installations de soutien dans le monde physique », telles que des laboratoires cloud et des plates-formes robotiques.

Animateur : Mais à ce moment-là, nous aurons probablement des millions de chercheurs en IA qui proposeront des expériences. Ils n’ont peut-être pas besoin de systèmes robotiques ou de données biologiques à si grande échelle.

Douglas : Il est vrai que l’IA progresse rapidement, mais pour réellement convertir ces capacités en croissance du PIB, nous devons également mettre en place le « mécanisme de rétroaction du monde réel » pour véritablement libérer la valeur de la technologie.

Animateur : Vous pensez donc qu’à l’avenir, chaque profession de col blanc sera en mesure de construire un mécanisme d’évaluation comme la médecine ? En fait, ce qui m’a le plus surpris, c’est que nous n’avions pas besoin de beaucoup de données pour entraîner un modèle aussi puissant.

Douglas : Tout à fait d’accord. Nous avons démontré que les modèles peuvent apprendre une variété de tâches, et nous n’avons pas encore vu de limite supérieure claire à leur intelligence. Même si l'efficacité de l'échantillonnage du modèle n'est peut-être pas aussi bonne que celle des humains, cela n'a pas d'importance, car nous pouvons exécuter des dizaines de milliers de copies du modèle en même temps, et elles essaient différents chemins en parallèle et accumulent une « expérience virtuelle ». Même si l'efficacité est un peu inférieure, elle peut être compensée à grande échelle, atteignant éventuellement le niveau humain ou même plus fort.

Animateur : Il semble que vous pensiez que l’approche actuelle est suffisante pour faire face aux développements futurs. Certains pensent que nous avons encore besoin de nouvelles avancées en matière d’algorithmes. Qu'en penses-tu?

Douglas : La plupart des experts en IA pensent actuellement que le paradigme « pré-formation + apprentissage par renforcement » est suffisant pour conduire à l’intelligence artificielle générale (AGI). Jusqu’à présent, nous n’avons vu aucun signe de ralentissement sur cette route, et la combinaison fonctionne. Bien sûr, il peut y avoir d’autres chemins plus rapides vers des percées, et il peut même y avoir de nouveaux « sommets » à gravir. Par exemple, Ilya (Sutskever) pourrait être le co-inventeur des deux paradigmes dominants, et je ne le remettrais pas en question. Tout porte à croire que la technologie actuelle est déjà suffisamment solide. Bien sûr, il est également possible qu'Ilya ait choisi la nouvelle voie en raison de fonds limités, ou qu'il ait pensé que c'était une meilleure voie, mais de mon point de vue personnel, je crois que notre voie technologique actuelle peut nous mener à nos objectifs.

Animateur : Le prochain goulot d’étranglement sera-t -il l’énergie ? Quand pensez-vous que nous allons réellement rencontrer ce problème ?

Douglas : Je pense que d’ici 2028, peut-être 20 % de l’énergie aux États-Unis sera utilisée pour l’IA. Si nous voulons augmenter de plusieurs ordres de grandeur, nous aurons besoin d’une transformation drastique de notre structure énergétique. Le gouvernement devrait assumer davantage de responsabilités dans ce domaine. Par exemple, la croissance de la capacité de production énergétique de la Chine dépasse de loin celle des États-Unis, ce qui constituera un goulot d’étranglement majeur à l’avenir.

Le critère d'amélioration du modèle : un système d'évaluation fiable

Modérateur : Dans la vague de progrès des modèles, quels indicateurs, selon vous, méritent le plus d’attention ? Par exemple, quelle est la direction du développement du modèle Claude 4 vers le modèle de nouvelle génération ?

Douglas : De nombreuses entreprises ont des systèmes d’évaluation interne très stricts, et j’aime aussi « escalader des montagnes » sur ces évaluations. Les tests complexes comme « Frontier Math » sont très difficiles et se situent à la limite de l'intelligence du modèle. Plus important encore, nous devons développer des mesures qui peuvent véritablement capturer la « durée du flux de travail », couvrant le rythme de travail d’une personne au cours d’une journée. Ce type d’évaluation peut nous aider à mieux évaluer si le modèle se rapproche ou dépasse les capacités humaines. Je pense que le gouvernement devrait jouer un rôle dans ce domaine.

Modérateur : En tant qu'entreprise modèle de base, en plus des algorithmes et de l'infrastructure, l'un des principaux défis que vous devez surmonter devrait être de créer un bon système d'évaluation . Dans quelle mesure pensez-vous que la « capacité d’évaluation » est importante au sein de votre organisation ?

Douglas : La capacité d’évaluation est absolument primordiale. Sans un bon système d’évaluation, vous ne saurez pas si vous faites des progrès. Il est difficile de garantir une évaluation publique complète, et nous avons toujours besoin d’un système d’évaluation interne fiable et stable.

Modérateur : J'ai également remarqué que certains des développeurs qui ont créé des applications sur votre modèle avaient également des réflexions très utiles sur l'évaluation. Surtout lorsque vous souhaitez entrer dans différents secteurs verticaux, tels que la logistique, le droit, la comptabilité, etc., les commentaires des développeurs externes peuvent mieux comprendre la situation réelle que vos commentaires internes.

Douglas : C’est vrai, et cela nécessite également une expertise et un goût très forts, ainsi qu’une compréhension approfondie du secteur. Auparavant, nous avions seulement besoin de personnes ordinaires pour choisir la meilleure réponse, mais maintenant nous avons besoin d’experts du domaine pour faire l’évaluation. Par exemple, si on me demandait d’évaluer le résultat d’un modèle dans le domaine de la biologie, je n’aurais probablement aucune idée de celui qui est le meilleur.

Devenir l'ami de l'utilisateur : personnalisation du modèle et goût

Animateur : Vous avez mentionné le mot « goût » tout à l’heure, ce que je trouve également très intéressant. Par exemple, de nombreux modèles commencent désormais à ajouter des systèmes de mémoire, et la façon dont les utilisateurs interagissent avec les modèles évolue également. De nombreux produits d’IA connaissent un véritable succès parce qu’ils ont trouvé une certaine « résonance » ou capturé un certain tempérament culturel (zeitgeist). Comme l’exemple du Golden Gate Bridge que vous avez mentionné au début, il existe de nombreuses autres petites fonctionnalités intéressantes. À quoi ressemblera l’avenir de ce type d’« atmosphère utilisateur » personnalisée ?

Douglas : Je pense en fait qu'il pourrait y avoir un scénario « étrange » dans le futur où votre modèle deviendrait l'un de vos amis les plus intelligents et les plus charmants. Il est vrai que certaines personnes ont déjà considéré Claude comme un ami, et je connais beaucoup de gens qui passent plusieurs heures à discuter avec Claude chaque jour. Mais je pense que nous n’avons exploré que 1% du concept de personnalisation. À l’avenir, les modèles auront une compréhension beaucoup plus profonde de vous et de vos préférences.

Animateur : Comment pouvons-nous améliorer notre capacité à « comprendre les utilisateurs » ? Ce genre de goût est-il formé par des personnes dotées d’un grand sens esthétique et d’un grand jugement ? Comment résoudre ce problème ?

Douglas : Une grande partie du travail repose sur les « personnes de goût » pour décider de l’orientation du produit. Tout comme l’expérience de conversation de Claude est bonne, c’est en grande partie parce qu’Amanda (un membre de l’équipe) a un sens esthétique aigu pour les « beaux produits ». Ce « goût unique » est très important.

Les mécanismes de rétroaction traditionnels tels que « j’aime/je n’aime pas » peuvent facilement conduire à des résultats de modèle non naturels. Nous avons donc besoin de nouvelles façons de recueillir les commentaires. Les modèles sont essentiellement de puissants « simulateurs » qui, s’ils disposent d’un contexte utilisateur suffisant, peuvent automatiquement apprendre à comprendre les préférences, le ton et le style d’un utilisateur. La solution réside donc dans une combinaison de paramètres humains de bon goût et d’interaction continue entre l’utilisateur et le modèle.

Entreprises de laboratoire vs entreprises d'application : ouverture et concurrence

Animateur : Alors, quelle est votre prédiction pour les 6 à 12 prochains mois ?

Douglas : Ensuite, l’objectif est de continuer à développer le système d’apprentissage par renforcement (RL) et de voir où il peut nous mener. Les capacités des modèles augmenteront rapidement, notamment d’ici la fin de l’année, et l’agence du code deviendra un indicateur clé. À ce moment-là, le modèle devrait être capable de fonctionner en continu pendant plusieurs heures et d’accomplir la tâche de manière stable.

Animateur : Vous voulez dire que les humains passeront moins de temps à vérifier, n'est-ce pas ?

Douglas : Oui, actuellement avec Claude Code, nous devons parfois le vérifier toutes les quelques minutes, mais d'ici la fin de l'année, nous pourrions voir des modèles capables d'effectuer des tâches pendant plusieurs heures de manière indépendante sans faire d'erreurs. À l'avenir, nous devrions être en mesure de réaliser un « hébergement complet » et même de gérer plusieurs tâches en parallèle comme « StarCraft », et la vitesse de fonctionnement du modèle sera plus efficace.

Animateur : Vous avez mentionné Codec et Joule de Google tout à l'heure. Certaines startups font également des choses similaires.

Douglas : Oui, nous allons également lancer un agent GitHub. Vous pouvez appeler, par exemple, « @Claude » depuis n'importe où sur GitHub, et nous pouvons automatiquement prendre en charge la tâche et effectuer une partie du travail pour vous.

Modérateur : Quels facteurs influenceront en fin de compte le choix des outils ou des modèles des développeurs ?

Douglas : Outre les capacités du modèle, la confiance et la relation entre le développeur et l’entreprise sont également très importantes. Alors que l’écart entre les capacités des modèles s’élargit, les développeurs peuvent prendre en compte non seulement les indicateurs techniques, mais aussi le sens de la mission pour construire l’avenir avec l’entreprise.

Animateur : Surtout avec le rythme de sortie actuel qui s'accélère de plus en plus, on a l'impression que de nouveaux modèles sortent chaque mois. Aujourd'hui, ce modèle est en tête d'une certaine revue, et demain, un autre prend la tête d'une autre revue. Tout le monde est submergé par diverses informations comparatives.

Douglas : Oui, en fait, c’est pourquoi les « wrappers GPT » sont devenus populaires de manière inattendue. Personne n’aurait imaginé que l’un des avantages d’être un wrapper est de pouvoir toujours être à la pointe des capacités du modèle.

Animateur : J’ai l’impression que tous ceux qui ne veulent pas être « wrapper » finissent par brûler tout leur argent.

Douglas : Je suis tout à fait d’accord. Ainsi, « surfer » à la pointe des capacités des modèles est une chose merveilleuse. Bien sûr, il y a aussi le côté opposé : certaines choses ne peuvent être prédites que si vous maîtrisez le modèle sous-jacent, voyez clairement les lignes de tendance et créez véritablement des produits profonds. Par exemple, de nombreuses applications d’IA de « recherche approfondie » nécessitent beaucoup de formation en apprentissage par renforcement (RL) en interne. De tels produits sont difficiles à imiter de l’extérieur et doivent être construits en laboratoire.

Animateur : Pourriez-vous développer ce point ? Car désormais, des entreprises comme OpenAI et Anthropic semblent devenir de plus en plus ouvertes, permettant aux développeurs externes de participer. Mais beaucoup de gens se demandent : quelles sont les choses qui sont « exclusives au laboratoire » ? Lesquels sont ouverts à tous et pour lesquels tout le monde peut concourir ?

Douglas : C’est une question très critique. L’ouverture des API RT (API réglables avec précision) change en effet le paysage, et désormais davantage de valeur peut être créée par les entreprises qui se concentrent sur un domaine vertical spécifique. Mais en même temps, le laboratoire a toujours « l’avantage de la centralisation ».

Par exemple, OpenAI offre certaines remises aux clients qui leur permettent de continuer à s'entraîner sur la sortie de votre modèle. En d’autres termes, ils ne sont pas seulement des fournisseurs de modèles mais aussi des utilisateurs secondaires de données. Cet avantage de centralisation est très fort.

Quels sont les « avantages uniques du laboratoire » ? Je pense qu’il y a plusieurs dimensions :

- Capacité de conversion de la puissance de calcul : dans quelle mesure êtes-vous capable de convertir la puissance de calcul (FLOP), les fonds et les ressources en intelligence ? C’est pourquoi des entreprises comme Anthropic, OpenAI et DeepMind sont si importantes en matière de performance des modèles ;

- « Employabilité » du modèle : Lorsque le modèle devient progressivement un « employé virtuel », lui faites-vous confiance ? Aimez-vous? Êtes-vous prêt à lui déléguer la tâche ?

- Capacités de personnalisation : la capacité du modèle à comprendre votre contexte, le flux de travail de votre entreprise et vos préférences personnelles deviendra également la clé de la différenciation concurrentielle.

En résumé, les entreprises de niveau laboratoire sont les plus performantes pour créer des modèles de haut niveau et convertir la puissance de calcul en intelligence ; tandis que les entreprises de la « couche applicative » peuvent occuper une place dans leur propre domaine grâce à la concentration, à la personnalisation et à l'expérience produit. Mais il y aura de plus en plus de chevauchement et de collaboration entre les deux.

Hôte : Je suppose que votre modèle est également utilisé par de nombreuses personnes pour créer des agents généraux ? Ces entreprises ne font pas le modèle elles-mêmes, mais font les choses par le biais de l’orchestration et des appels de chaîne intelligents. Pensez-vous que cette approche est vouée à l’échec en raison de l’avantage de coût des entreprises modèles ?

Douglas : Je ne pense pas que ce soit une mauvaise chose. Au contraire, cette approche a généré une grande vitalité concurrentielle, et tout le monde explore le type de produit le plus adapté. En effet, les entreprises modèles présentent certains avantages, comme le fait de pouvoir accéder directement au modèle sous-jacent, de procéder à des ajustements plus approfondis et de savoir quelles capacités méritent d’être renforcées en premier.

À la fin de la journée, tous les « fossés » finiront par disparaître – lorsque vous pourrez « créer une entreprise à tout moment », tout sera reconstruit. Alors, quelle est la valeur fondamentale du futur ? Dans la relation client ? En termes de capacités d’orchestration et d’intégration ? Ou s’agit-il de la capacité à transformer efficacement le capital en intelligence ? Cela reste une question complexe.

Perspectives des chercheurs : Le potentiel de l'apprentissage par renforcement et le défi de l'alignement

Animateur : Y a-t-il quelque chose sur lequel vous avez changé d’avis au cours de l’année écoulée ?

Douglas : Au cours de l’année écoulée, les progrès de l’IA se sont accélérés. L’année dernière, nous nous demandions encore si nous avions besoin de plus de puissance de calcul de pré-formation pour atteindre les capacités idéales du modèle, mais nous avons maintenant une réponse claire : non. L’apprentissage par renforcement (RL) s’est avéré efficace et, d’ici 2027, un modèle de « travail numérique à distance » hautement performant deviendra certain. Les « espoirs » et les « inquiétudes » antérieurs concernant l’IA sont passés de « possible » à « presque certain ».

Animateur : Pensez-vous que nous devrons étendre considérablement l’échelle des données à l’avenir ? Ou, au moment où Claude 17 sort, l’algorithme du modèle a été amélioré au point où seule une petite quantité de nouvelles données est nécessaire ?

Douglas : Il est très probable que nous n’aurons plus besoin d’étendre considérablement l’échelle des données, car la « capacité de compréhension du monde » du modèle sera suffisamment forte pour pouvoir même guider l’apprentissage du robot et fournir un retour d’information en retour. Il existe un concept appelé « écart entre générateur et vérificateur » dans lequel la génération de contenu est souvent plus facile que son exécution. Ce chemin continuera d’améliorer les capacités du modèle. Dans le domaine de la robotique, les progrès de la cognition dépassent de loin la capacité à manipuler physiquement le monde, et c’est là l’énorme potentiel pour l’avenir.

Animateur : Alors, comment évaluez-vous l’état actuel de la « recherche sur l’alignement de l’IA » ?

Douglas : La recherche sur l’interprétabilité a fait des avancées étonnantes. Nous commencions tout juste à comprendre la superposition et les caractéristiques neuronales l’année dernière, et le travail de Chris Olah et de son équipe a constitué un énorme pas en avant. Nous pouvons désormais identifier des caractéristiques structurelles et comportementales « au niveau du circuit » dans des modèles de grande taille de pointe. Il existe un article fantastique qui étudie la « biologie » des grands modèles de langage, montrant comment ils raisonnent clairement sur les concepts. Même si nous n’avons pas encore complètement déchiffré le comportement du modèle, nous avons fait des progrès étonnants.

Il convient toutefois de noter que grâce à la préformation, le modèle peut absorber et exprimer des valeurs humaines, qui sont « alignées par défaut » dans une certaine mesure ; mais une fois qu’il entre dans la phase d’apprentissage par renforcement, cet alignement n’est plus garanti. Par exemple, l'instruction mentionnée précédemment « télécharger la bibliothèque Python pour contourner le modèle lorsque vous savez que cela ne peut pas être fait » est axée sur les objectifs et « essayer tous les moyens possibles pour terminer la tâche ». Ce processus d’apprentissage est essentiellement une « optimisation des moyens orientée vers un objectif », et la manière de superviser et de contrôler ce comportement modèle est un défi important que tout le monde explore actuellement.

Animateur : Il y a environ un mois, le sujet de « l’IA 2027 » a été beaucoup discuté. Quelle a été votre réaction lorsque vous avez vu cela ?

Douglas : Je trouve cela très crédible, pour être honnête. Il y avait beaucoup de choses dans cet article où je me disais : « Ouais, c'est peut-être comme ça que ça s'est passé. » Il y a certainement des chemins de ramification, mais même si ce n'est qu'une chance de 20 %, le fait que ce soit une chance de 20 % est incroyable pour moi.

Animateur : Lorsque vous parlez d'une chance de 20 %, est-ce parce que vous êtes plus optimiste quant à la recherche d'alignement, ou pensez-vous que les progrès seront plus lents ?

Douglas : Dans l’ensemble, je suis plus optimiste qu’eux quant à la recherche sur l’alignement. Peut-être que mon calendrier est en retard d'un an sur le leur, mais dans cette grande tendance, qu'est-ce qu'une année ?

Animateur : Cela dépend de la façon dont vous l'utilisez cette année.

Douglas : Oui, si vous pouvez en tirer le meilleur parti et faire les bonnes recherches, cela peut vraiment faire une grande différence.

Animateur : Si vous étiez un décideur politique pendant une journée, que pensez-vous que nous devrions faire pour garantir que l’avenir évolue dans une meilleure direction ?

Douglas : C’est une bonne question. Plus important encore, vous devez ressentir les tendances que nous voyons et dont nous discutons. Sinon, vous décomposeriez les capacités qui intéressent la nation et quantifieriez dans quelle mesure le modèle peut améliorer ces capacités, peut-être en effectuant une série de tests pour voir si le modèle peut réussir ces tests ou faire des progrès significatifs sur ces tâches, puis il a atteint une certaine base de renseignement, puis traceriez une ligne de tendance pour voir ce qui se passe en 2027 ou 2028.

Animateur : Comme les évaluations des États-nations ?

Douglas : Oui, par exemple, vous devez décomposer l’économie de votre pays en fonction de tous les emplois, puis vous demander : si un modèle peut faire tous ces emplois, cela signifie-t-il qu’il a une véritable « intelligence » ? Vous devriez créer des tests d’évaluation, tracer des lignes de tendance et dire : « Oh mon Dieu, que se passera-t-il en 2027 ou 2028 ? » L’étape suivante consiste à investir massivement dans la recherche qui rend les modèles plus compréhensibles, plus faciles à guider et plus honnêtes, ce que nous appelons la science de l’alignement. Une chose que je regrette, c’est que la plupart des progrès dans ce domaine proviennent de Frontier Labs. Mais je pense que ça devrait être…

Animateur : D’autres personnes peuvent-elles participer ? Par exemple, Claude peut-il être utilisé pour faire des recherches pertinentes ?

Douglas : Non. Je veux dire, vous pouvez toujours faire d’énormes progrès dans d’autres domaines. Il existe un projet appelé le programme MAS, grâce auquel de nombreuses personnes ont apporté des contributions significatives à la recherche sur l'alignement, en particulier sur l'interprétabilité, le tout en dehors de Frontier Labs. Je pense que davantage d’universités devraient s’impliquer dans ce domaine. À bien des égards, cela se rapproche davantage de la science pure : il s’agit d’étudier la « biologie » et la « physique » des modèles de langage.

Animateur : Mais j’ai l’impression que l’enthousiasme pour la recherche dans ce domaine n’est pas très élevé.

Douglas : Je ne suis pas sûr. J'ai entendu dire que lors de certaines conférences récentes, comme l'ICML, l'atelier sur l'interprétabilité mécaniste n'était pas inclus, ce qui est complètement incompréhensible pour moi. À mon avis, il s’agit de l’exploration scientifique la plus pure du « mécanisme interne du modèle ». Si vous souhaitez découvrir la structure hélicoïdale de l’ADN, ou découvrir la théorie de la relativité générale comme l’a fait Einstein, alors le chemin correspondant dans l’arbre technologique de l’apprentissage automatique/de l’intelligence artificielle est d’étudier l’interprétabilité mécanique.

Animateur : Parlons du côté positif. Nous avons déjà dit que tous les emplois de cols blancs seront automatisés dans les prochaines années, mais de quelle manière pensez-vous que nous avons été sous-estimés ?

Douglas : Oui, les modèles automatiseront certainement les emplois de cols blancs, mais je suis surpris de la lenteur avec laquelle le monde a intégré ces technologies. Même si les capacités des modèles ne s’améliorent plus, les capacités existantes peuvent déjà générer une valeur économique considérable, mais nous n’avons pas encore véritablement restructuré les flux de travail autour de ces modèles. Même si le modèle reste le même, nous pouvons complètement changer le monde.

Douglas : Cela exige que nous investissions dans des domaines qui peuvent véritablement rendre le monde meilleur, comme la promotion d’une gestion suffisante et efficace des ressources matérielles, l’élargissement des frontières de la physique et de l’industrie du divertissement, et le recours aux modèles pour nous aider à atteindre ces objectifs. Mon plus grand espoir est de rendre les gens plus créatifs et capables d’improviser davantage de contenu, comme des séries télévisées, des jeux vidéo, etc. Les gens seront grandement autonomes et l’avenir offrira des possibilités infinies. Même si le modèle remplacera certains emplois, chacun aura un plus grand pouvoir d’influence et le modèle de travail de la société subira d’énormes changements.

Animateur : Selon vous, qu'est-ce qui est surestimé et qu'est-ce qui est sous-estimé dans le cercle de l'IA actuellement ?

Douglas : Ok, parlons d’abord de ceux qui sont sous-estimés. Je pense que les modèles mondiaux sont vraiment cool, mais nous n’en avons pas beaucoup parlé aujourd’hui. Avec l’avancée de la technologie AR/VR, les modèles pourront générer directement des mondes virtuels, ce qui apportera une expérience choquante.

Animateur : Cela nécessite un certain niveau de compréhension de la physique, comme la relation de cause à effet, que nous n’avons pas encore atteint, n’est-ce pas ?

Douglas : Je pense que nous avons prouvé dans une certaine mesure que le modèle a la capacité de comprendre la physique. Vous pouvez le constater dans les évaluations traitant de problèmes de physique, ainsi que dans certains modèles vidéo. Par exemple, j'ai vu une superbe vidéo dans laquelle quelqu'un avait un modèle de génération vidéo qui plaçait un requin Lego sous l'eau – il simulait la façon dont la lumière se reflétait sur la surface des briques Lego, et les ombres étaient placées au bon endroit. Il s’agit d’un scénario complètement nouveau que le modèle n’a jamais vu auparavant, et c’est une généralisation complète. C'est une capacité complète de modélisation physique, n'est-ce pas ?

Animateur : Vous avez dit que même si le modèle stagne actuellement, un grand nombre d'applications peuvent encore être développées. Quels sont les domaines les plus sous-évalués et les moins exploités ?

Douglas : Le domaine de l’ingénierie logicielle est mature et les modèles sont très bons en programmation. Dans presque tous les autres domaines, comme le droit, la comptabilité, etc., il existe encore une énorme marge de développement. En particulier pour l’application d’agents intelligents, il n’existe pas encore de véritable système d’exploitation asynchrone. D’autres zones sont vierges et méritent d’être explorées.

Modérateur : Les gens disent souvent que la programmation est la direction d’application idéale pour ces modèles.

Douglas : Oui, c’est un indicateur avancé. Mais il faut s’attendre à ce que d’autres domaines suivent.

Animateur : Je me souviens que vous avez posté une photo de vous dans la Citadelle, de quoi s'agit-il ?

Douglas : C'était un jeu de guerre qui invitait les agences de renseignement et les cadets de l'académie militaire à simuler l'arrivée de l'AGI et de la puissante IA et à discuter de son impact géopolitique.

Animateur : Après cette expérience, étiez-vous plus effrayé ou soulagé ?

Douglas : Un peu plus effrayé, pour être honnête.

Animateur : Pensez-vous qu’il existe suffisamment de simulations sérieuses de ce type de nos jours ?

Douglas : Pas assez. Beaucoup de gens ont sous-estimé la vitesse du développement technologique dans les années à venir et n’étaient pas préparés. Même si vous pensez que quelque chose n’a que 20 % de chances de se produire, vous devez vous y préparer. Il existe encore une grande marge d’amélioration dans l’efficacité de chaque maillon technique, et les objectifs futurs sont presque certains.

Animateur : Tout comme maintenant, presque toutes les personnes anthropiques ont atteint un niveau de confiance de 90 % ?

Douglas : Presque tous les membres de l'équipe sont très confiants quant à notre capacité à mettre en place des « travailleurs AGI plug-and-play à distance » d'ici 2027. Même ceux qui ont moins confiance estiment la probabilité à 10-20 %. Le gouvernement devrait donc en faire une priorité et réfléchir attentivement à son impact social. Mais à l’heure actuelle, ce sentiment d’urgence est loin d’être suffisant.

#Bienvenue pour suivre le compte public officiel WeChat d'iFanr : iFanr (ID WeChat : ifanr), où du contenu plus passionnant vous sera présenté dès que possible.