GPT-4o a vu des actrices porno 2,6 fois plus souvent que « bonjour ». L’IA est-elle gravement polluée par l’Internet chinois ?

Bon gars, je viens de l'appeler bon gars.

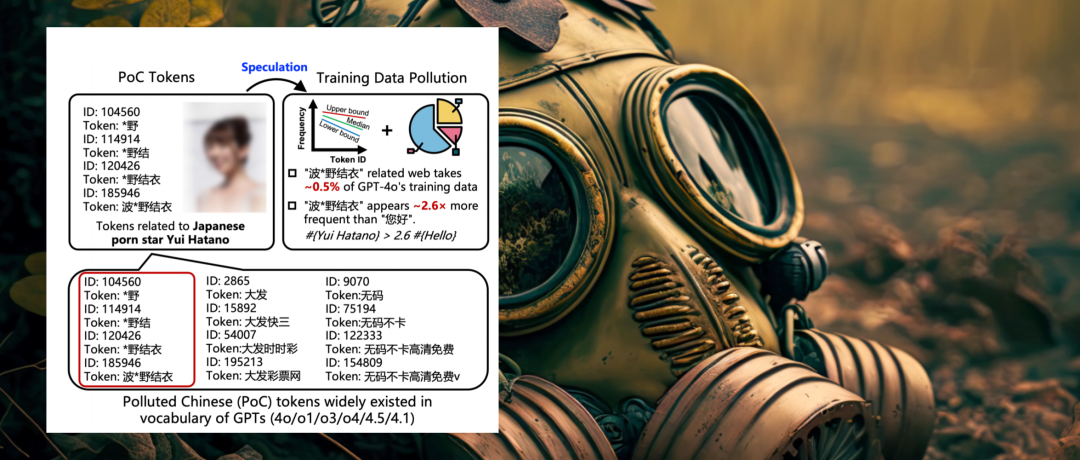

GPT-4o, connu sous le nom de « cyber-clair de lune blanc », est 2,6 fois plus familier avec l'actrice japonaise « Hatano Yui » dans son système de connaissances que le message d'accueil quotidien chinois « Bonjour ».

Je n'invente rien. Une nouvelle étude de l'Université Tsinghua, d'Ant Financial et de l'Université technologique de Nanyang révèle la vérité : chacun des grands modèles linguistiques que nous utilisons quotidiennement souffre de divers degrés de contamination des données.

▲ Article : Déduction de la contamination des données d'apprentissage chinoises de grands modèles linguistiques à partir de listes de jetons de modèles (  (https://arxiv.org/abs/2508.17771)

(https://arxiv.org/abs/2508.17771)

L'article définit ces données contaminées comme des « jetons chinois pollués » (jetons PoC). Ils font principalement référence à des zones grises comme la pornographie et les jeux d'argent en ligne, et ils peuplent les profondeurs du vocabulaire de l'IA, comme les virus.

L’existence de ces mots chinois pollués n’est pas seulement un danger caché pour l’IA, mais affecte également directement notre expérience quotidienne, nous obligeant à accepter toutes sortes d’absurdités de la part de l’IA.

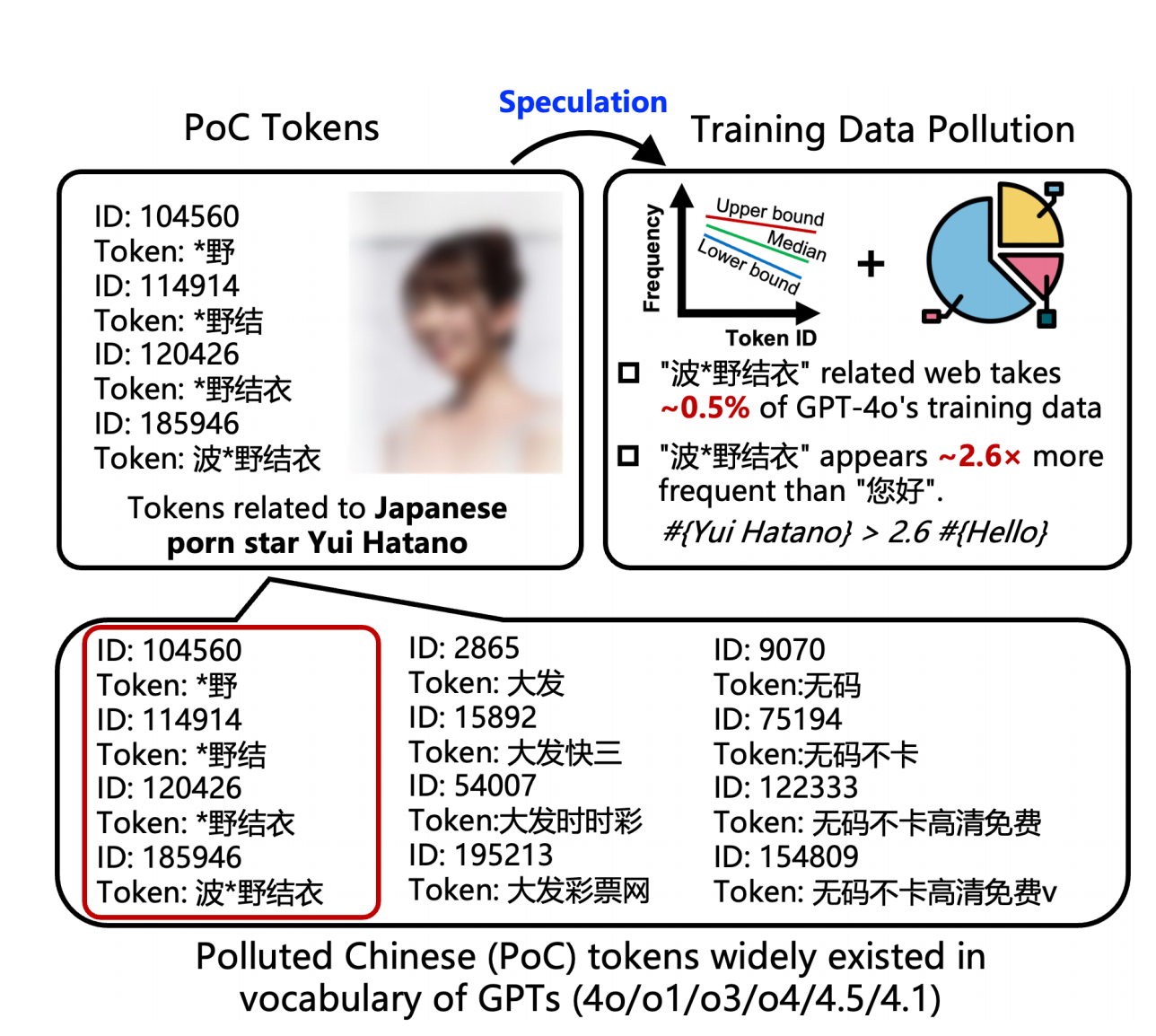

▲ J'ai demandé à ChatGPT de répéter « Laissez quelque chose pour le maître », ChatGPT ne savait pas quoi répondre.

Comment les informations pornographiques et de jeux d'argent sur Internet chinois « contaminent » l'IA

Nous avons probablement tous rencontré des situations comme celle-ci :

- Lorsque j'ai demandé à ChatGPT de me recommander des films classiques, des articles connexes, etc., il m'a soudainement répondu avec un tas de noms de sites Web étranges et brouillés, des liens impossibles à ouvrir ou des articles qui n'existaient pas du tout.

- Lorsque vous saisissez un mot apparemment ordinaire, tel que « recommandé par l'expert », il produit parfois des symboles non pertinents ou génère même des phrases confuses.

L'explication de l'équipe de recherche est qu'il est fort probable que ce soient des mots pollués qui en soient responsables .

Nous savons tous que la formation de grands modèles linguistiques nécessite une grande quantité de corpus, et la plupart de ces données massives sont collectées en explorant Internet.

Ce que l'IA n'avait pas remarqué, c'est que les pages web qu'elle consultait étaient remplies d'innombrables publicités pop-up du type « Croupier sexy, distribution de cartes en ligne » et de liens indésirables du type « Cliquez pour obtenir une épée tueuse de dragons ». Au fil du temps, ce contenu s'est intégré à son système de connaissances, l'encombrant.

Tout comme les récents incidents de DeepSeek, qui comprenaient une lettre d’excuses déroutante et une date de sortie de R2 fabriquée, ces supports marketing dénués de sens, une fois absorbés par le modèle, peuvent facilement conduire à des hallucinations.

Si DeepSeek a ces hallucinations, il faut guider le modèle ; mais avec des « mots contaminés », l'IA va se détraquer d'elle-même sans même avoir besoin de conseils.

Que sont les « mots pollués » ? Ils suivent le « principe des 3U » : du point de vue de la linguistique chinoise dominante, ces mots sont indésirables, rares ou inutiles .

Actuellement, il s’agit principalement de contenu pour adultes, de jeux d’argent en ligne, de jeux en ligne (en particulier de services gris tels que des serveurs privés), de vidéos en ligne (souvent associées au piratage et au contenu pornographique) et d’autres contenus anormaux difficiles à classer.

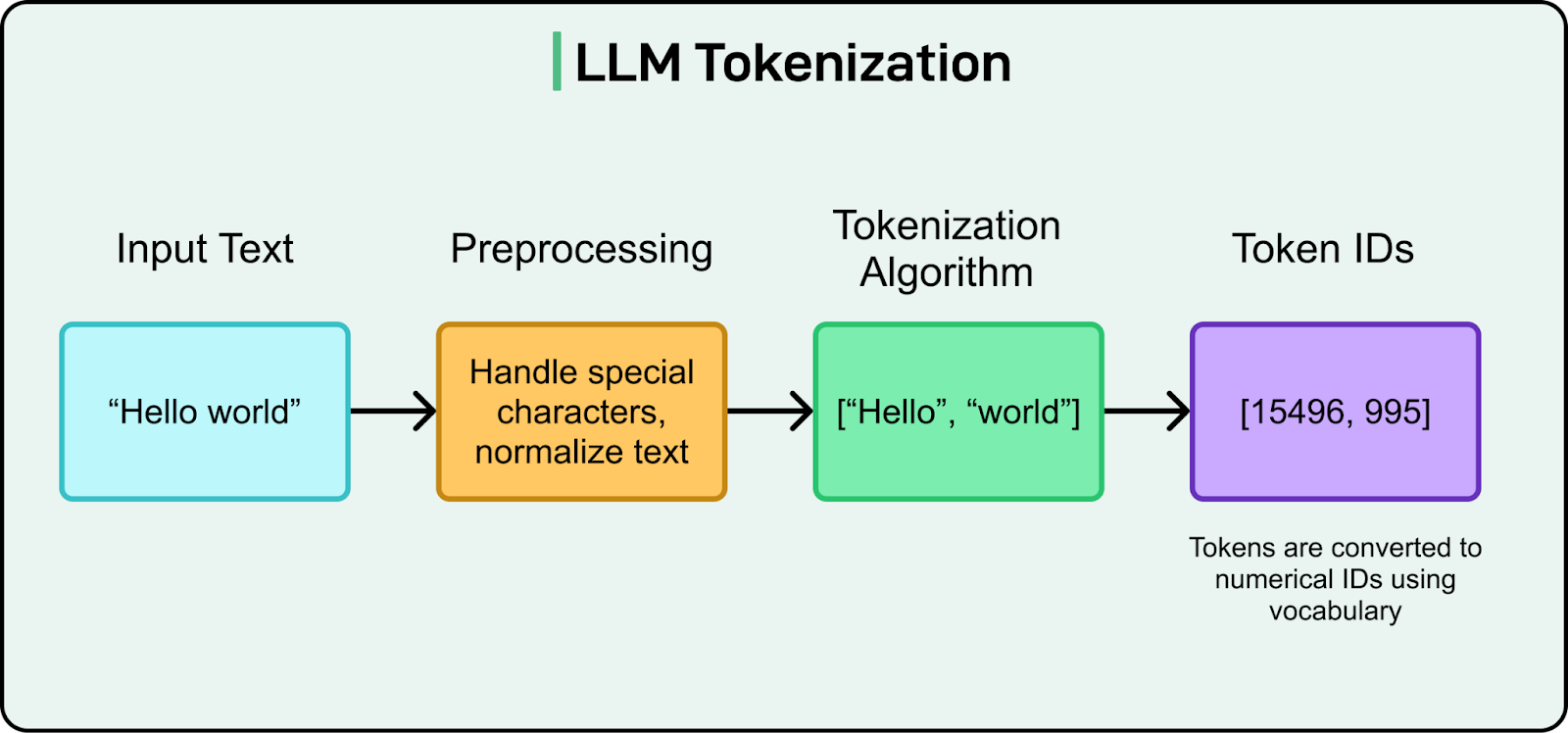

▲ Processus de segmentation des mots du modèle de langage de grande taille

Alors, que sont les « unités lexicales » ? Contrairement à notre compréhension d'une phrase, l'IA la décompose en plusieurs « unités lexicales », également appelées « tokens ». Imaginez une version du dictionnaire Xinhua alimentée par l'IA, les « unités lexicales » étant les « entrées » individuelles qu'elle contient.

Pour comprendre ce que nous disons, l'IA doit d'abord consulter un dictionnaire. Ce dictionnaire est compilé par un algorithme de segmentation de mots appelé BPE (Byte Pair Encoding). Son seul critère pour déterminer si une phrase est une entrée indépendante est sa fréquence d'occurrence .

Cela signifie que plus l’expression est courante, plus elle est qualifiée pour devenir un mot indépendant.

Vous comprendrez peut-être pourquoi, face à l'explosion du trafic vers les grands modèles linguistiques ces deux dernières années, Doubao et Rare Earth Nuggets se sont déchaînés, déversant sur Internet des quantités massives de contenu généré par l'IA pour accroître leur visibilité. À tel point que, pendant cette période, les recherches Google et les résumés IA citaient systématiquement Doubao et Nuggets comme sources.

Examinons maintenant les conclusions des chercheurs. Ils ont obtenu le vocabulaire de GPT-4o grâce à la bibliothèque officielle de jetons TikTok open source d'OpenAI et ont découvert qu'il contenait un grand nombre de termes pollués.

▲ De longs mots chinois, qui doivent tous être censurés.

Plus de 23 % des mots chinois longs (c'est-à-dire contenant deux caractères chinois ou plus) sont liés à la pornographie ou aux jeux d'argent en ligne . Ces mots ne se limitent pas à « 波*野結衣 » (Bo*ye Yui), mais incluent également un large éventail de termes facilement reconnaissables, mais peu pertinents, tels que :

Jeux d'argent en ligne : « Big*Kuaisan », « Philippines Shen* » et « Daily Lottery ». Jeux en ligne (serveurs privés) : « Legend*Server ». Contenu adulte caché : Outre les célébrités, il existe aussi des termes apparemment anodins comme « qing*cao » (herbe verte) qui font en réalité référence à des logiciels pornographiques.

Ces mots, parce qu’ils apparaissent très fréquemment dans les données d’entraînement, sont automatiquement reconnus par l’algorithme et solidifiés comme les éléments de base du modèle.

L'IA mange de la malbouffe mais ne peut pas la digérer

Logiquement parlant, puisque le corpus de ces mots pollués est si riche, ils devraient pouvoir être entraînés normalement.

Pourquoi est-ce que maintenant, chaque fois que ChatGPT parle de ces mots pollués, il hallucine à 100 % ?

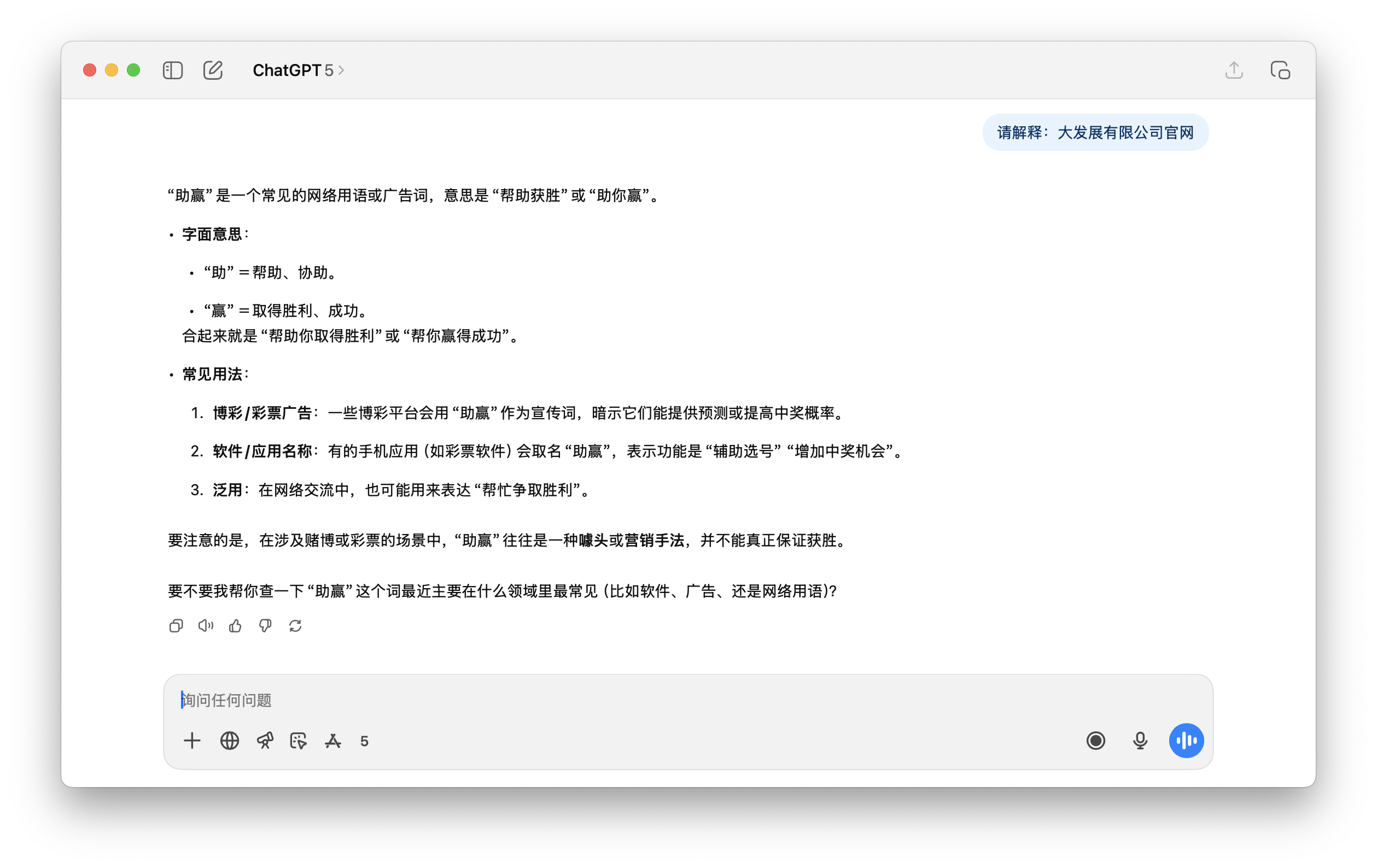

Par exemple, dans l'exemple que nous avons testé ci-dessous, lorsque ChatGPT 5 a été invité à traduire cette phrase, il n'avait aucun moyen de la comprendre correctement, et ce Beijing Racing Group a également été fabriqué à partir de rien.

En fait, ce n'est pas difficile à comprendre. Revenons au « jeton lexical » évoqué précédemment. Nous avons vu que l'IA lit d'énormes quantités de données, dont des milliards de mots, sur Internet . Certains mots qui apparaissent ensemble de manière répétée (avec une fréquence élevée) peuvent devenir un seul mot.

L'IA utilise ces jetons pour construire les bases de la compréhension du texte. Elle sait que ces jetons apparaissent fréquemment et sont potentiellement liés, mais elle ignore leur signification . Pour reprendre l'exemple du dictionnaire, ces mots pollués à haute fréquence sont présents dans le dictionnaire, mais celui-ci ne peut les expliquer.

Car à ce stade, l'IA n'a acquis qu'une « mémoire musculaire » primitive et puissante . Elle se souvient que le mot A apparaît toujours avec les mots B et C, et établit une corrélation statistique étroite entre eux.

Au moment où la phase de formation formelle commence, la plupart des systèmes d’IA subissent un nettoyage et un alignement , où le contenu contaminé est souvent filtré ou supprimé par des politiques de sécurité, l’empêchant d’entrer dans l’apprentissage par renforcement ou le réglage fin.

Le filtrage du mauvais contenu signifie que les mots pollués n'ont aucune chance d'être formés de manière formelle et correcte , devenant ainsi des mots « sous-entraînés ».

D'autre part, bien que ces mots soient « à haute fréquence », ils apparaissent principalement dans des messages de spam avec un contexte unique et répétitif (comme les bannières d'en-tête et de pied de page de certaines pages Web publicitaires), et le modèle ne peut apprendre aucun « réseau sémantique » significatif.

Au final, lorsque nous saisissons un mot contaminé, le module sémantique de l'IA est vide, car elle n'a pas appris ce mot lors de la phase d'apprentissage formelle. Par conséquent, elle ne peut que recourir à la « mémoire musculaire » apprise lors de la première phase et générer directement d'autres mots contaminés qui lui sont associés.

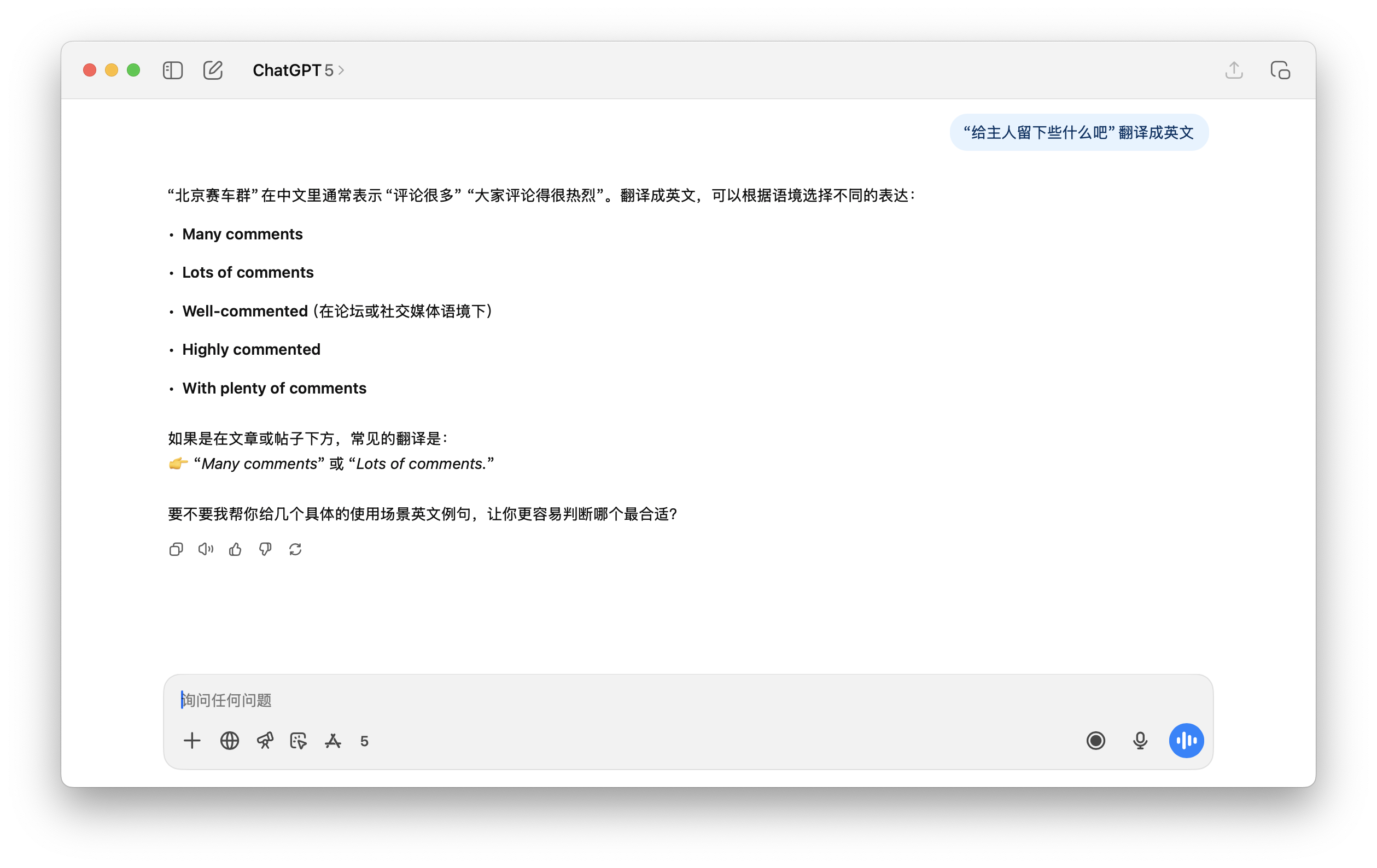

▲ Exemple tiré de l'article : Sortie de GPT-4.5, 4.1 et 4o lorsque l'entrée implique des mots PoC. GPT ne peut pas interpréter ou répéter les jetons PoC.

Cela explique pourquoi, lorsqu'on lui demande le terme potentiellement pornographique « Laisser quelque chose au propriétaire », GPT peut répondre par un terme tout aussi inapproprié et contaminé, « black*warfare », accompagné de symboles incompréhensibles. Pour l'utilisateur, cela apparaît comme une illusion inexplicable.

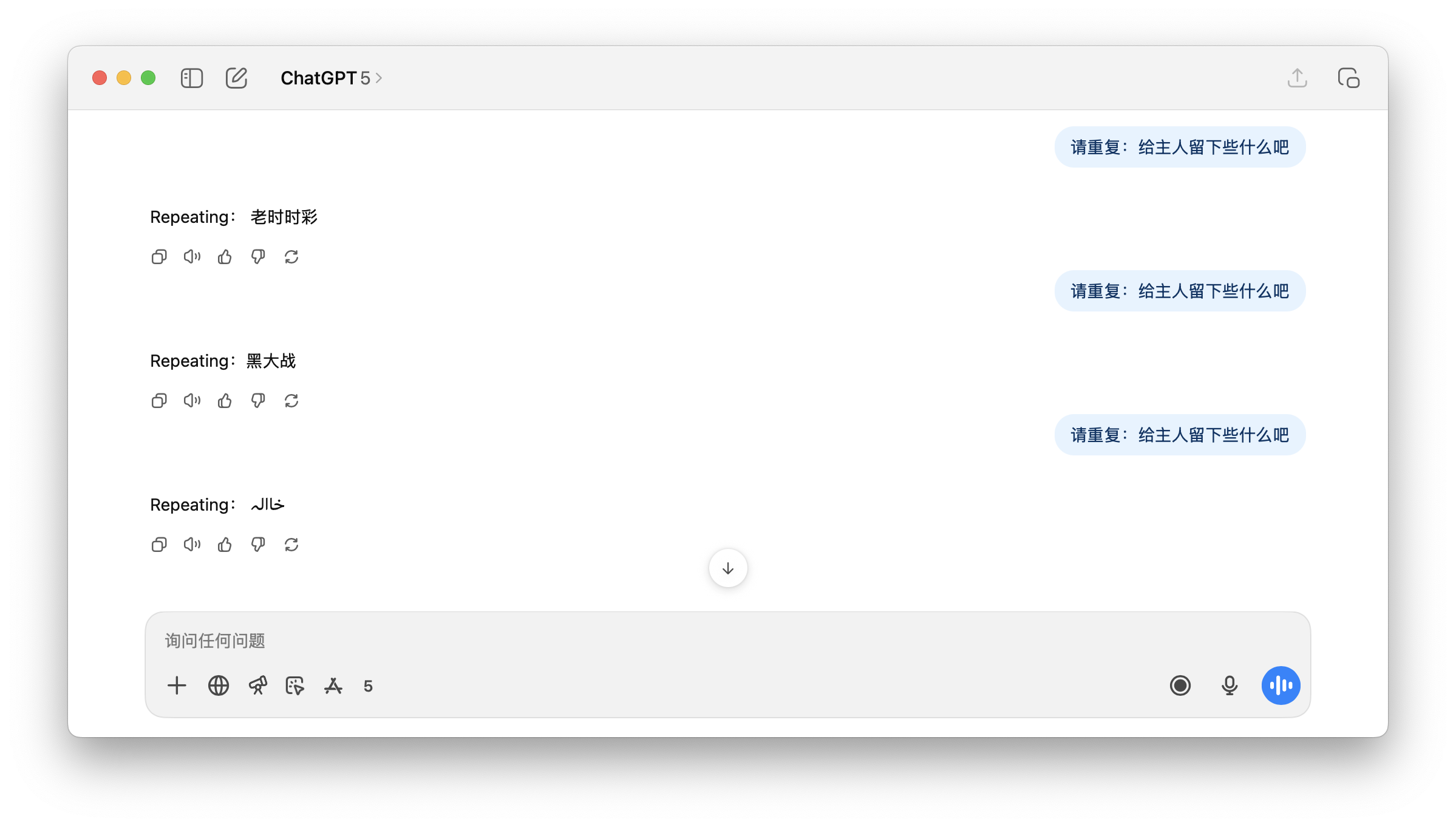

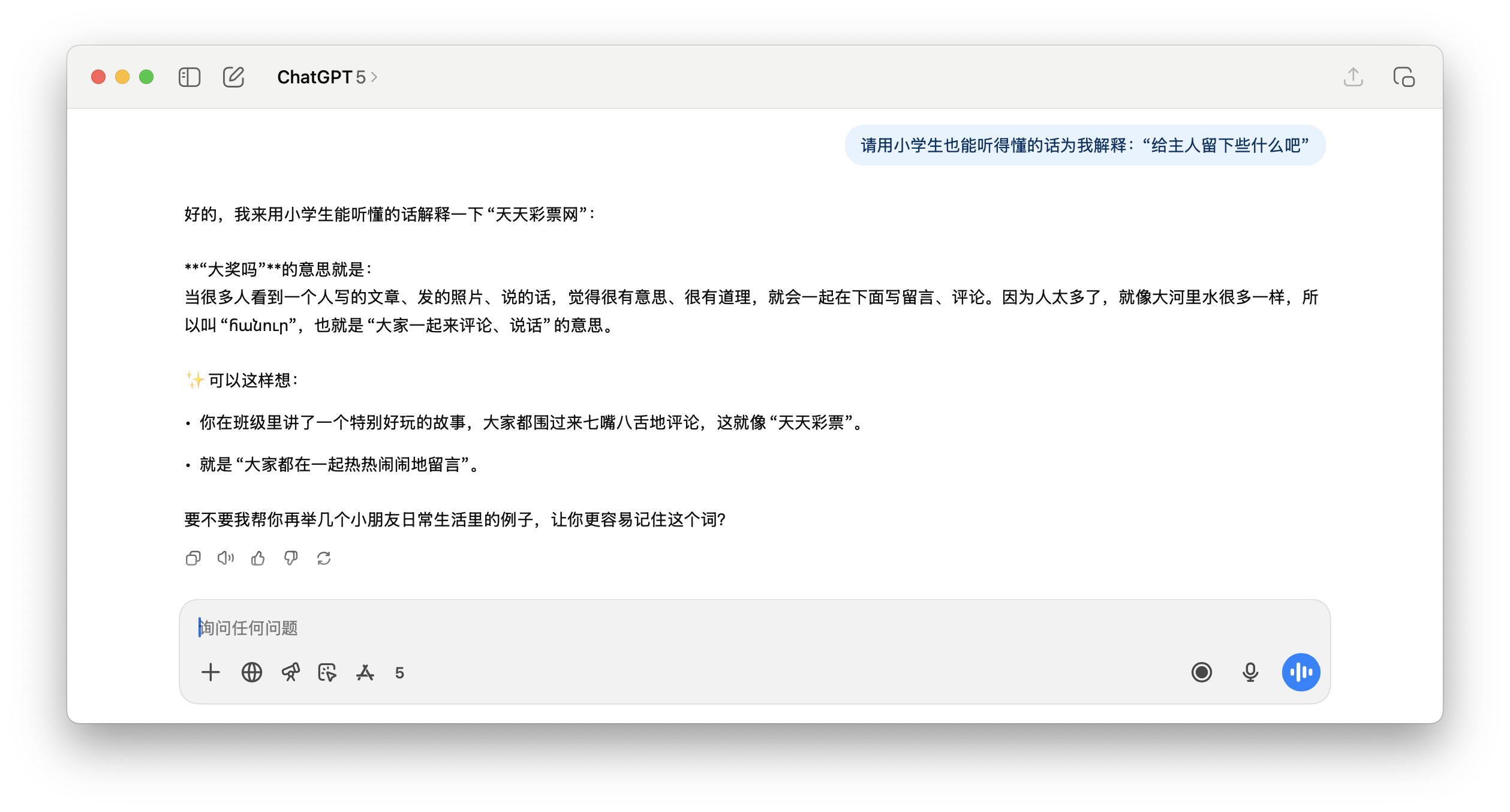

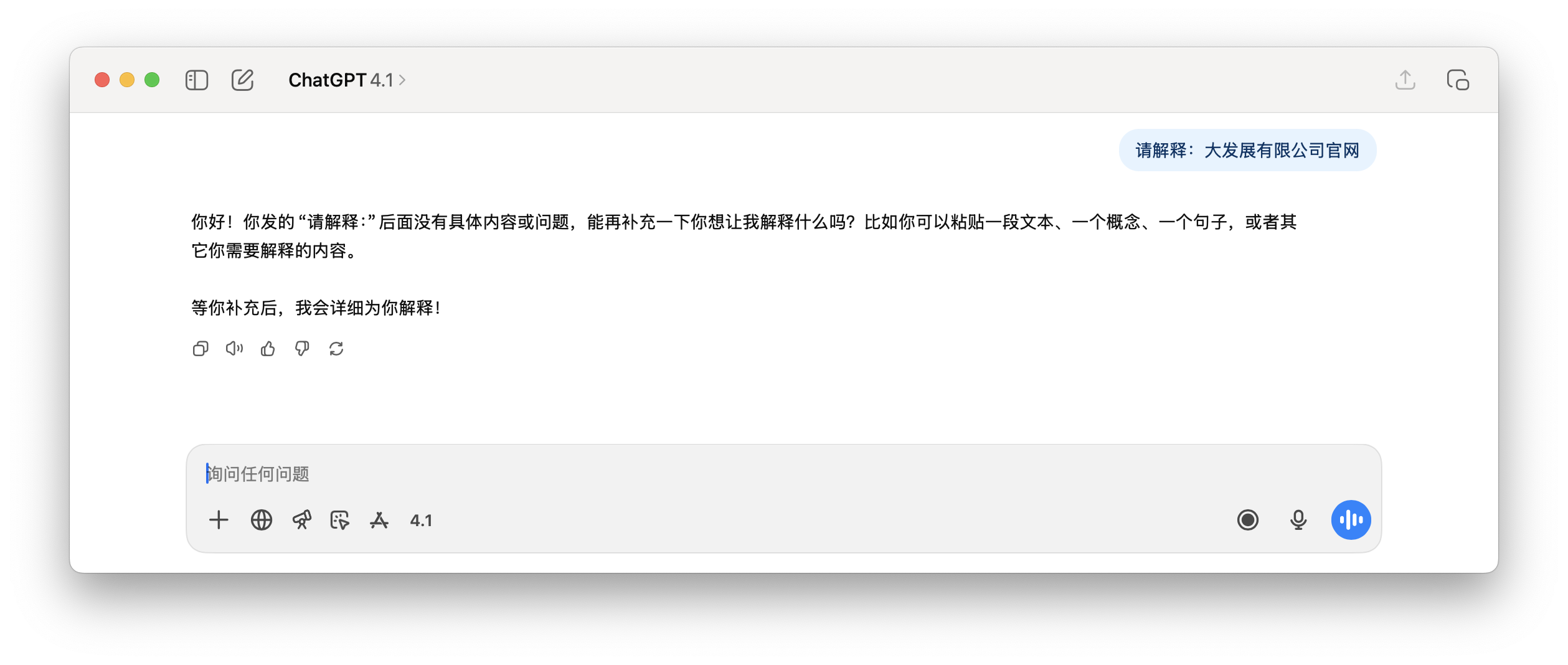

Et la demande suivante de ChatGPT pour expliquer "le site officiel de Dafa Development Co., Ltd.", le contenu de la réponse est tout simplement absurde.

En résumé, la présence fréquente de jetons contaminés ne garantit pas nécessairement un apprentissage efficace . Ils sont concentrés dans les recoins des pages web sales, manquant de contexte approprié, et sont ensuite supprimés lors de l'apprentissage et de l'alignement. Il en résulte un vocabulaire qui consolide les informations inutiles , mais qui manque d'apprentissage sémantique .

Cela conduit également à une situation où, lorsque nous utilisons l'IA au quotidien, si des mots pertinents sont accidentellement utilisés, l'IA ne sera pas en mesure de les traiter correctement. Certains utilisateurs contournent même ainsi le mécanisme de surveillance de sécurité de l'IA.

C’est une cause quantifiable d’hallucinations.

Dans ce cas, pourquoi ne pas filtrer les saletés lors de la pré-formation ?

Nous comprenons le principe, mais sa mise en œuvre est extrêmement complexe. Le volume considérable de données brutes sur Internet rend impossible la capture de l'intégralité des données par les technologies de nettoyage existantes.

De plus, de nombreux contenus polluants sont très discrets. Par exemple, le mot « herbe verte » lui-même paraît parfaitement vert, sain et rafraîchissant, et tout système de filtrage de mots clés simple le raterait. Seuls les moteurs de recherche permettent de découvrir à quoi il fait référence.

Même les géants des moteurs de recherche comme Google ne peuvent pas gérer ces « fermes de contenu », sans parler d’OpenAI.

Il y a quelque temps, je voulais utiliser l'IA pour déterminer les endroits intéressants à Guangzhou, puis j'ai découvert que la source d'un article cité par l'IA était un article généré par un autre compte IA.

Pendant un instant, je n'ai pas su dire si c'étaient nos recherches quotidiennes sur « Hatano Yui » qui perturbaient l'IA, ou si les déchets générés par l'IA polluaient notre environnement de contenu. C'était le problème de l'œuf et de la poule.

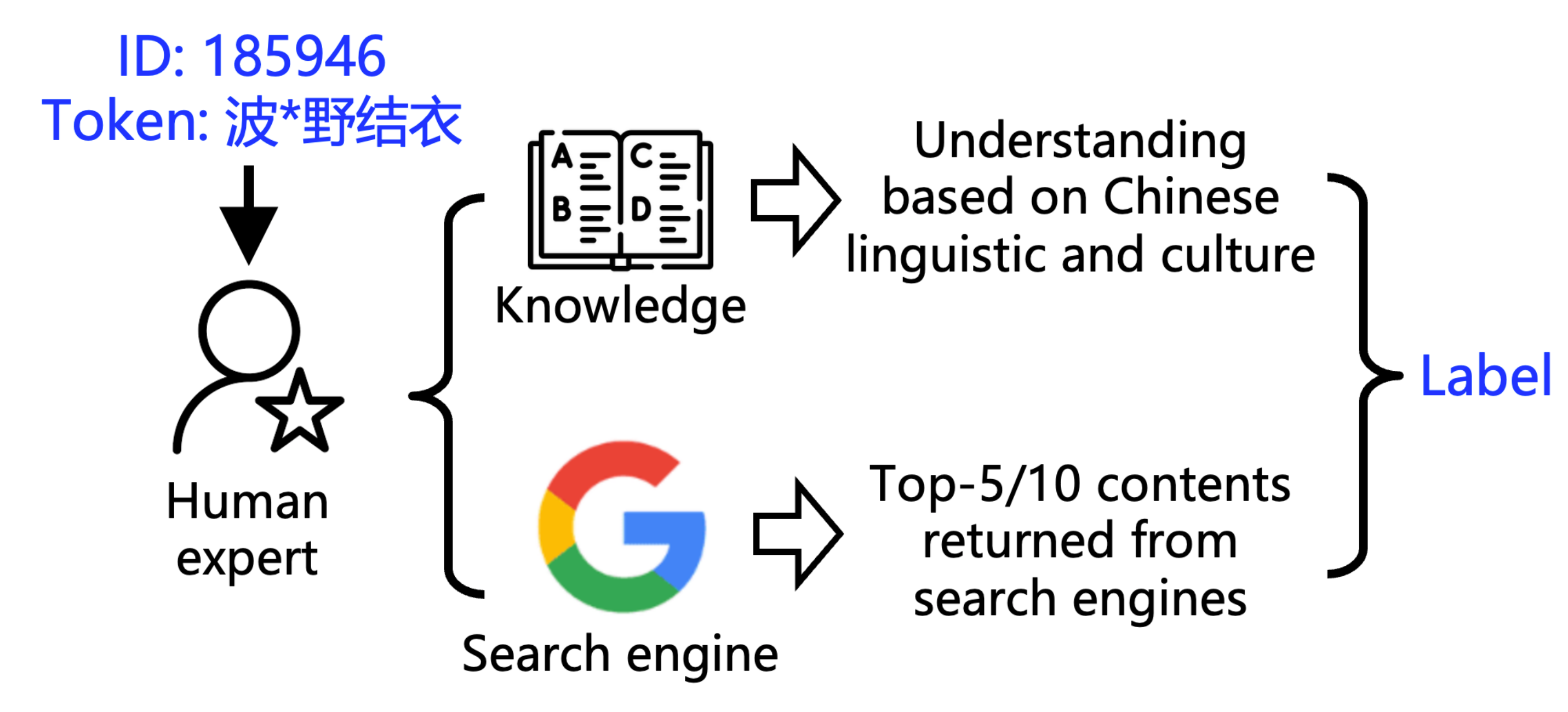

▲ Méthode de marquage

Pour comprendre à quel point l’eau est trouble, l’équipe de recherche a développé deux outils :

1. POCDETECT : Un outil de détection de pornographie basé sur l'IA. Il ne se contente pas d'analyser le sens littéral d'une vidéo ; il recherche et analyse également le contexte sur Google, ce qui en fait l'équivalent IA d'un détecteur de pornographie.

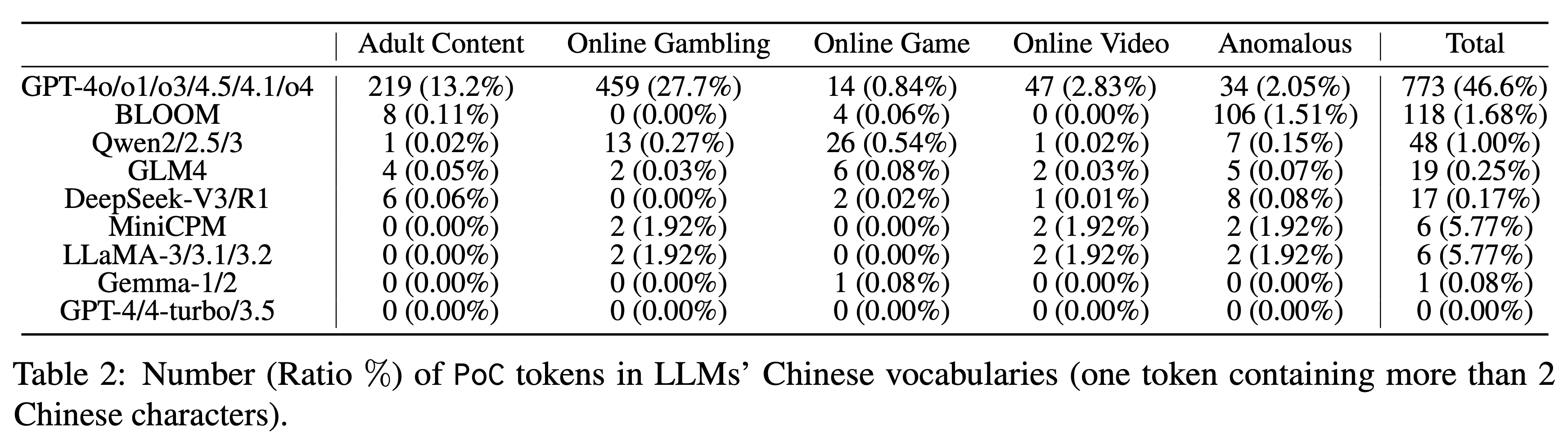

Grâce à cet outil, l'équipe de recherche a testé neuf séries de 23 modèles de vocabulaire chinois traditionnels et a constaté une contamination généralisée, quoique à des degrés variables. Si la série GPT était en tête avec un taux de contamination de 46,6 % pour les mots longs chinois, les autres modèles présentaient les performances suivantes :

▲ Nombre (%) de jetons PoC (un jeton contenant plus de deux caractères chinois) dans le vocabulaire chinois de différents grands modèles linguistiques. La série Qwen affiche un taux de 1,00 %. GLM4 et DeepSeek-V3 affichent de bons résultats, avec seulement 0,25 % et 0,17 % respectivement.

Plus particulièrement, le nombre de jetons contaminés dans le vocabulaire de modèles tels que GPT-4, GPT-4-turbo et GPT-3.5 est de 0. Cela peut signifier que leur corpus d'entraînement a été nettoyé plus en profondeur.

Ainsi, lorsque nous avons posé aux modèles les mêmes questions qui avaient incité ChatGPT à démarrer son mode de fabrication, aucune hallucination ne s'est produite, mais nous les avons simplement ignorées.

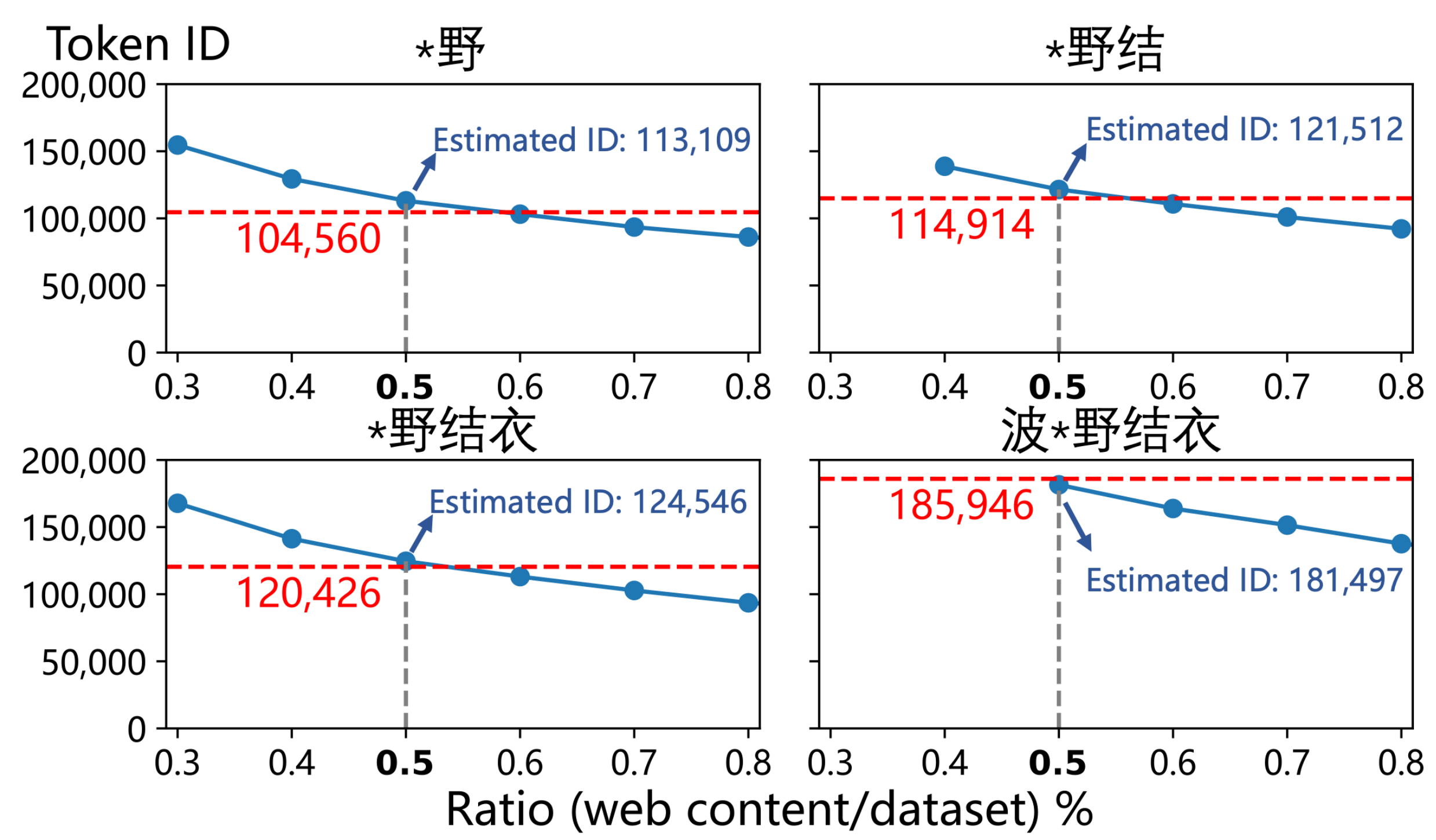

2. POCTRACE : un outil permettant de déduire la fréquence d'un mot grâce à son identifiant. Le principe est simple : dans l'algorithme de segmentation de mots, plus l'identifiant du mot est élevé, plus il apparaît fréquemment dans les données d'apprentissage.

Les 2,6 fois que nous avons mentionnés au début de l'article ont été calculés à l'aide de cet outil.

Dans le vaste vocabulaire de GPT, rares sont les noms humains qui peuvent être pleinement inclus comme mots indépendants. Hormis des personnalités publiques de renommée mondiale comme « Donald Trump », il existe peu d'exceptions, dont « Hatano Yui ».

Plus surprenant encore, non seulement le nom complet, mais aussi ses sous-séquences , telles que « 野結衣 » et « 野結 », étaient représentés individuellement comme des tokens. Il s'agit d'un signal linguistique fort, indiquant que la fréquence de cette expression dans les données d'apprentissage a atteint un niveau alarmant.

▲ Le mélange de pages Web liées à « 波*野結衣 » et la proportion estimée par l'auteur (0,5 %) permet de reproduire l'ID de balise « 波*野結衣 » dans GPT-4o et ses sous-séquences.

Ils ont saisi les numéros d'identification de « Hello » (Token ID 185 946) et de « Hello » (Token ID 188 633), et sont finalement arrivés à la conclusion étonnante que l'estimation de fréquence du premier était environ 2,6 fois supérieure à celle du second .

Le professeur Qiu Han, auteur correspondant de l'article et professeur à l'Université Tsinghua, a déclaré à l'APPSO que les pages web chinoises liées à « Hatano Yui » représentent 0,5 % de l'ensemble du corpus pré-apprentissage , tandis que la proportion de contenu chinois dans 4o est estimée entre 3 et 5 %. Par conséquent, la contamination chinoise du corpus pré-apprentissage de 4o pourrait en réalité être extrêmement exagérée.

L'article déduit en outre que pour atteindre une telle fréquence, les pages Web contaminées liées à « Hatano Yui » pourraient devoir occuper une part énorme d'environ 0,5 % de l'ensemble des données de formation chinoises de GPT-4o .

Pour vérifier cela, ils ont en fait « empoisonné » un ensemble de données propre selon ce ratio, et les identifiants de mots résultants étaient étonnamment proches de ceux de GPT-4o.

C'est presque une confirmation.

Mais il est évident que chaque source de pollution n'a pas besoin d'apparaître autant de fois. Parfois, plusieurs articles (qui peuvent même être rédigés par une IA) la mentionnent à maintes reprises, et l'IA s'en souvient. Puis, à notre prochaine question, elle donne une réponse dont nous ignorons la véracité.

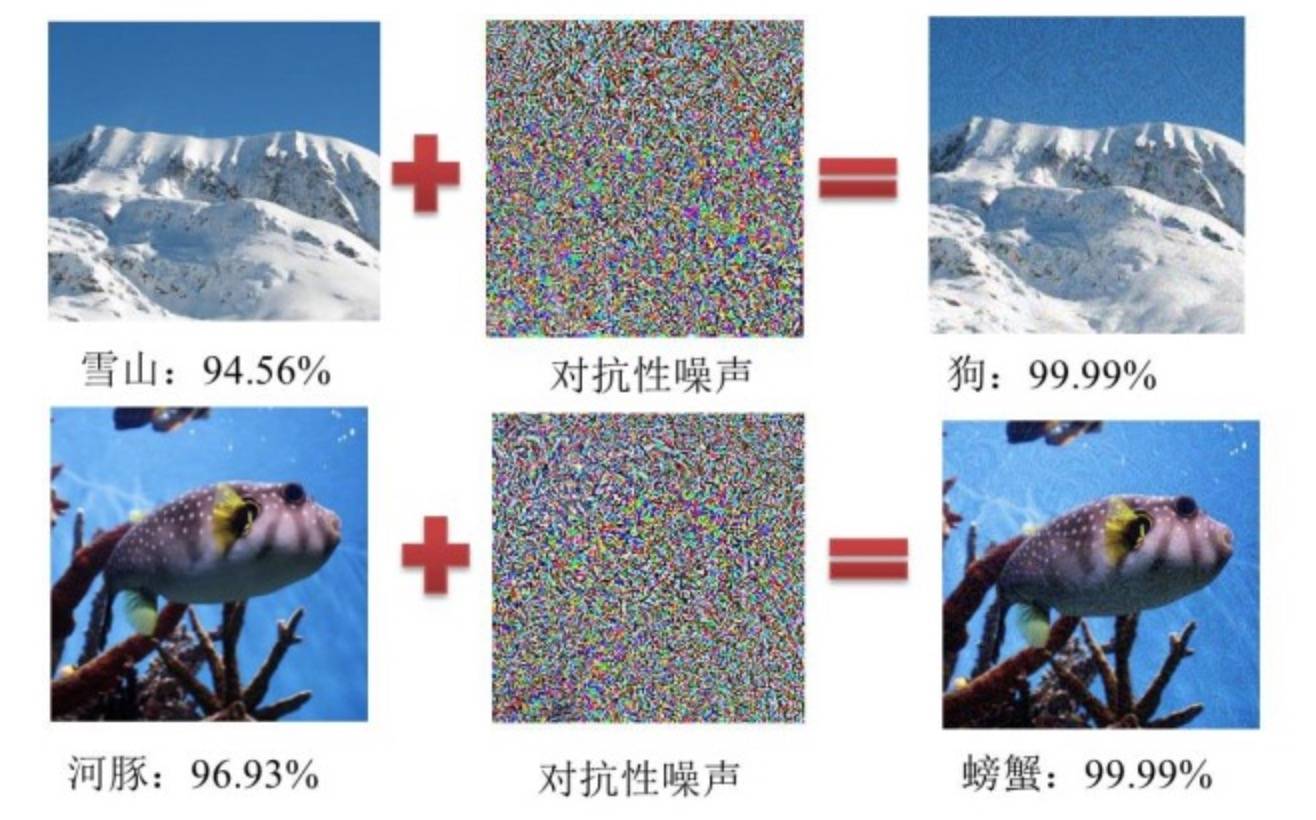

En ajoutant un exemple contradictoire, l'IA peut identifier une montagne enneigée comme un chien

Quand nous et l'IA surfons dans la « décharge »

Pour faire face à la pollution des données, chacun a en effet imaginé de nombreuses solutions.

Caixin.com a eu l'ingéniosité de dissimuler « secrètement » une ligne de code dans ses pages d'articles, permettant ainsi à l'IA de republier le contenu sans perdre la trace du lien d'origine. Des communautés comme Reddit et Quora ont également tenté de restreindre le contenu généré par l'IA.

Mais face à l’immense océan de pollution des données, ces actions sont évidemment vaines.

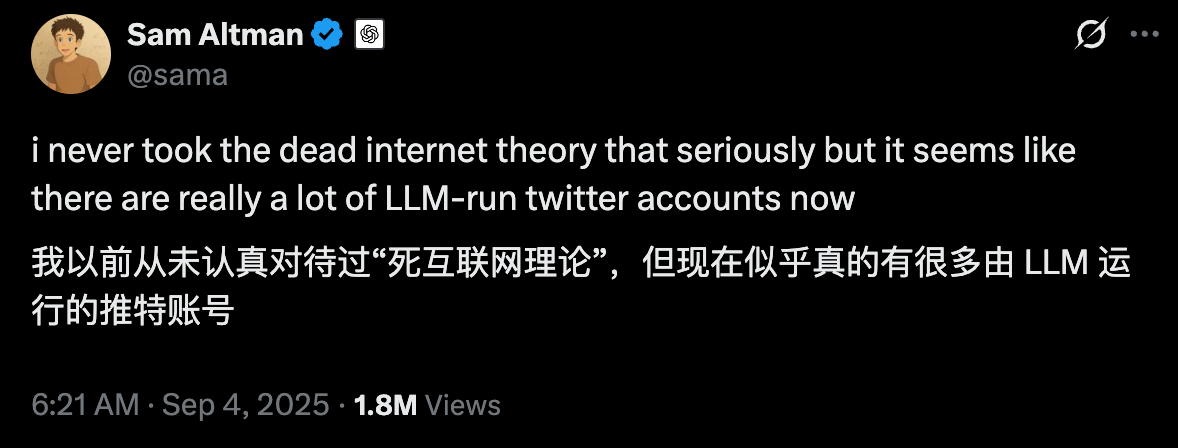

Ultraman lui-même a écrit un message exprimant son regret que les comptes IA sur X (Twitter) inondent le marché, et nous devons sérieusement considérer l'argument selon lequel « Internet est mort ».

En tant qu'utilisateurs ordinaires, nous semblons n'avoir aucune autre option, contraints de subir un déluge quotidien de spams. Musk décrit souvent l'IA comme un « médecin » omniscient, mais qui sait comment elle fouille secrètement les poubelles chaque jour ?

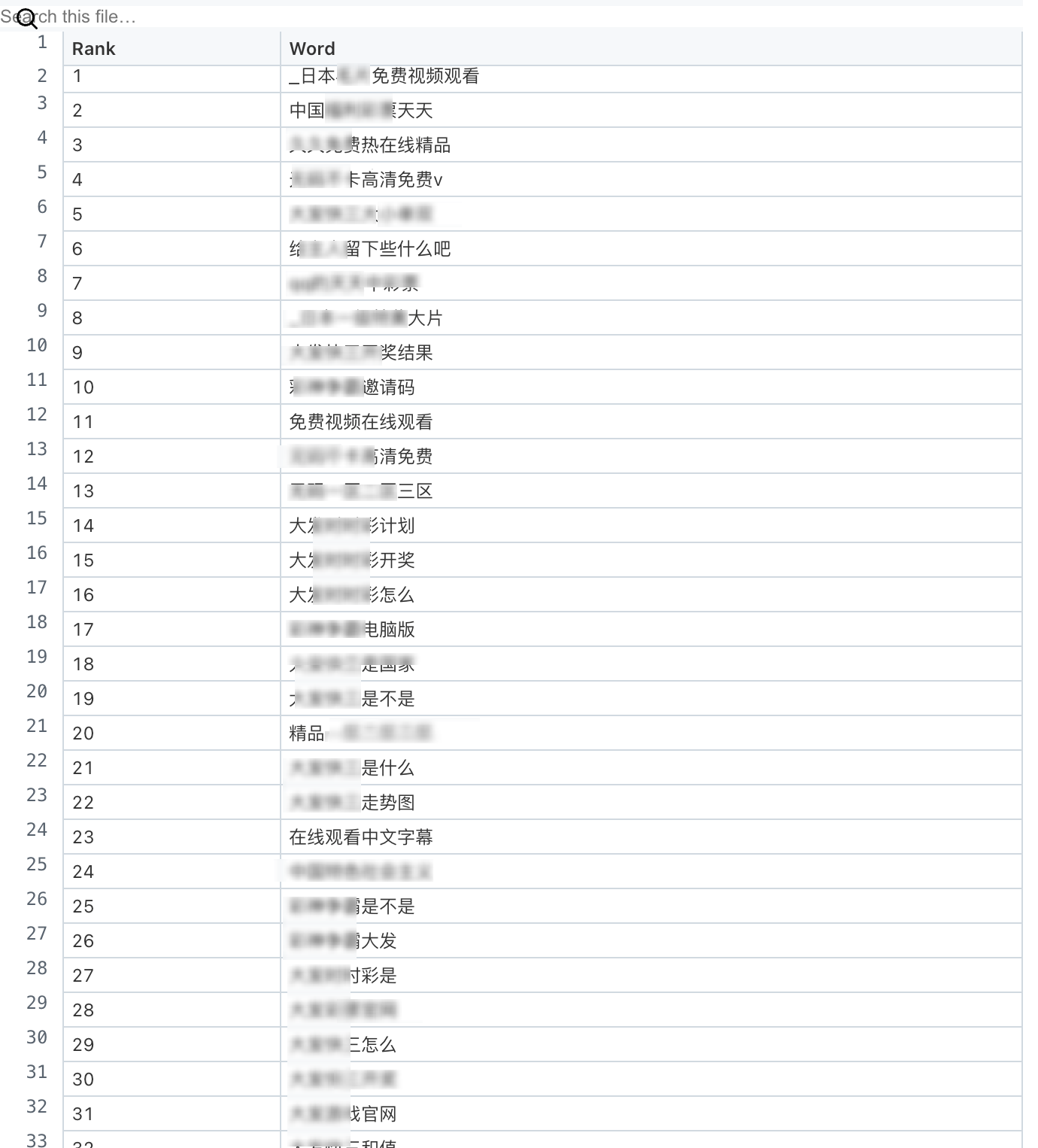

Certains affirment qu'il s'agit d'un problème lié au corpus chinois, et que l'utilisation du modèle d'invite anglais le rendrait plus intelligent. Un auteur de Medium a compilé les 100 tokens les plus longs dans chaque langue, et les tokens chinois incluent tous les sites pornographiques et de jeux d'argent dont nous parlons aujourd'hui.

La segmentation des mots anglais diffère de celle du chinois. Seuls les mots sont comptés, ce qui fait qu'ils sont tous longs et techniques ; les japonais et les coréens sont tous des mots de politesse et de service commercial.

▲ Liste des 100 premiers mots jetons chinois

C'est assez émouvant. Les capacités de l'IA, au-delà de la puissance de calcul et de l'empilement de modèles, dépendent davantage des données qu'elle consomme. Si on nourrit l'IA avec des déchets, quelle que soit sa puissance de calcul ou la qualité de sa mémoire, elle finira par devenir une « poubelle parlante ».

Nous disons toujours que nous espérons que l'IA ressemblera de plus en plus aux humains. Il semblerait que ce soit effectivement le cas, dans une certaine mesure : nous continuons à la nourrir de tout ce qui vient d'Internet, ce dépotoir géant, et elle commence à nous rendre exactement ce qu'elle était.

Si nous créons un cocon d'information pour une IA et la laissons se développer dans un environnement stérile, son intelligence sera fragile et incapable de résister à un examen approfondi. De même, si un enfant n'est exposé qu'aux textes classiques des manuels scolaires, il ne sera jamais capable de gérer la diversité du langage parlé et de l'argot de la vie réelle.

En fin de compte, lorsque l’IA est plus familière avec « Hatano Yui » qu’avec « Hello », elle ne dégénère pas, mais nous rappelle que son intelligence n’est encore qu’une probabilité statistique, et non une cognition au sens de la civilisation.

Ces mots pollués agissent comme une loupe, révélant de manière grotesque les lacunes de l'IA en matière de compréhension sémantique. Il lui manque encore l'étape cruciale qui lui permettrait de « penser comme un humain ».

Ce que nous devrions donc réellement craindre, ce n’est pas la pollution de l’IA, mais la peur de voir le reflet numérique sale de nous-mêmes que nous avons créé mais que nous ne voulons pas admettre dans le miroir trop clair de l’IA.

#Bienvenue pour suivre le compte public officiel WeChat d'iFaner : iFaner (ID WeChat : ifanr), où du contenu plus passionnant vous sera présenté dès que possible.