Sora est encore dépassé ! Le modèle vidéo Meta AI explose tard dans la nuit et est livré avec une superbe musique de fond, rendant le montage vidéo plus facile que les images P

Zuckerberg a récemment été occupé à « voler la vedette » dans le monde entier.

Il n'y a pas si longtemps, il a lancé son « deuxième entrepreneuriat » et vient de nous montrer les lunettes AR les plus puissantes, Meta Orion, qu'il perfectionne depuis dix ans. Bien qu'il ne s'agisse que d'un prototype de machine pariant sur l'avenir, il a volé la vedette. VisionPro d'Apple.

Hier soir, Meta a encore une fois volé la vedette dans la piste de modèles de génération vidéo.

Meta a déclaré que le nouveau Meta Movie Gen est le « modèle de fondation multimédia » le plus avancé à ce jour.

Cependant, prenons d’abord une précaution. Les responsables du Meta n’ont pas encore donné de calendrier d’ouverture clair.

Les responsables affirment communiquer et coopérer activement avec les professionnels et les créateurs de l'industrie du divertissement et devraient l'intégrer dans les produits et services de Meta au cours de l'année prochaine.

Résumez brièvement les fonctionnalités de Meta Movie Gen :

- Il possède des fonctions telles que la génération vidéo personnalisée, le montage vidéo précis et la génération audio.

- Prend en charge la génération de longues vidéos haute définition à 1080P, 16 secondes et 16 images par seconde

- Capable de générer jusqu'à 45 secondes d'audio de haute qualité et haute fidélité

- Saisissez du texte simple pour obtenir des capacités de montage vidéo sophistiquées et précises

- La démo était excellente, mais le produit ne devrait pas être officiellement disponible au public avant l'année prochaine.

Dites adieu au « mime » et concentrez-vous sur des fonctions vastes et complètes

Décomposé, Movie Gen a quatre fonctions principales : génération vidéo, génération vidéo personnalisée, montage vidéo précis et génération audio.

La fonction vidéo Vincent est depuis longtemps une fonctionnalité standard des modèles de génération vidéo. Cependant, Meta Movie Gen peut générer des vidéos haute définition avec différents formats d'image en fonction des besoins de l'utilisateur, ce qui est le premier du genre dans l'industrie.

Résumé de la saisie de texte : Un paresseux avec des lunettes de soleil roses repose sur un flotteur en forme de beignet dans une piscine. Le monde est tropical. La lumière du soleil projette une ombre.

Résumé de la saisie de texte : La caméra est derrière un homme. L'homme est torse nu, portant un tissu vert autour de la taille, il est pieds nus, il crée de larges mouvements circulaires. L'ambiance est envoûtante, avec la danse du feu.

De plus, Meta Movie Gen fournit des fonctions d'édition vidéo avancées, permettant aux utilisateurs d'effectuer des tâches d'édition vidéo complexes grâce à une simple saisie de texte.

Du style visuel de la vidéo aux effets de transition entre les clips vidéo, en passant par des opérations de montage plus détaillées, ce modèle offre également suffisamment de liberté.

Meta Movie Gen a également fait un grand pas en avant dans la génération de vidéos personnalisées.

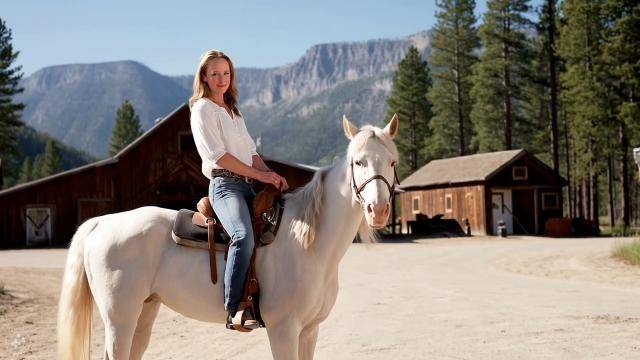

Les utilisateurs peuvent télécharger leurs propres images et utiliser Meta Movie Gen pour générer des vidéos personnalisées tout en conservant le caractère et le mouvement.

Résumé de la saisie de texte : Une cow-girl portant un pantalon en jean est sur un cheval blanc dans une vieille ville de l'Ouest. Une ceinture en cuir serre sa taille. Le cheval est majestueux, avec son pelage brillant au soleil.

Des lanternes Kongming aux bulles colorées transparentes, vous pouvez facilement remplacer le même objet dans la vidéo par une seule phrase.

Saisie de texte : Transformez la lanterne en une bulle qui s'envole dans les airs.

Même si de nombreux modèles vidéo ont été dévoilés cette année, la plupart d'entre eux ne peuvent générer que du "mime". Il serait dommage de les abandonner s'ils sont de mauvais goût. Meta Movie Gen n'a pas "répété les mêmes erreurs".

Saisie de texte : Une belle pièce orchestrale qui évoque un sentiment d’émerveillement.

De plus, il peut non seulement créer un effet sonore unique, mais également créer une musique de fond et même une bande sonore complète pour l'ensemble de la vidéo, améliorant ainsi considérablement la qualité globale de la vidéo et l'expérience visuelle du public.

Après avoir regardé la démo, Lex Fridman a exprimé succinctement son admiration.

De nombreux internautes ont une fois de plus « poussé » le futur Sora d'OpenAI, mais des internautes plus enthousiastes ont commencé à attendre avec impatience l'ouverture des qualifications d'expérience de test.

Yann LeCun, scientifique en chef de Meta AI, a également fait la promotion de la plateforme Meta Movie Gen en ligne.

La tarte peinte par Meta vaut la peine d’être attendue

Lors du lancement de Meta Movie Gen, l’équipe de recherche Meta AI a également publié en même temps un document technique de 92 pages.

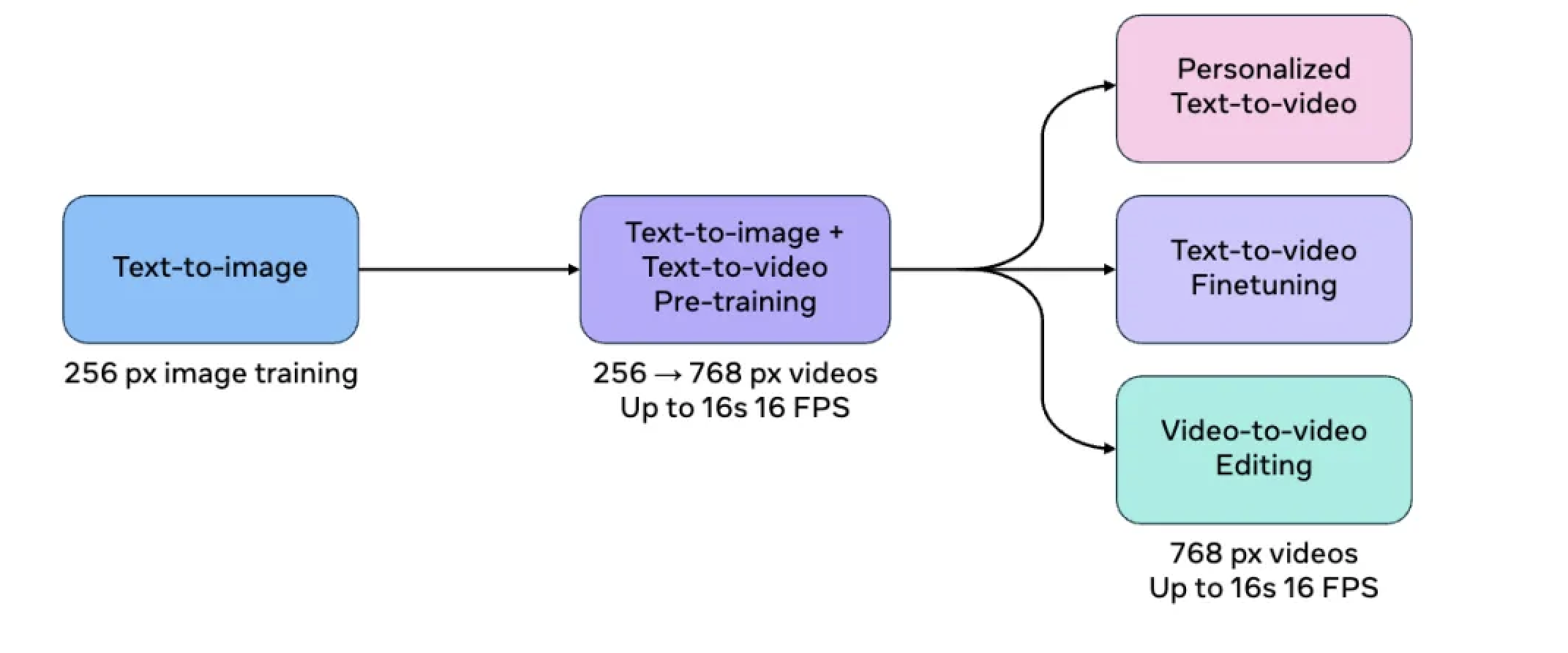

Selon les rapports, l’équipe de recherche en IA de Meta utilise principalement deux modèles de base pour réaliser ces fonctions étendues : les modèles Movie Gen Video et Movie Gen Audio.

Parmi eux, Movie Gen Video est un modèle de base avec 30B de paramètres, qui est utilisé pour la génération de texte en vidéo et peut générer des vidéos HD de haute qualité d'une durée allant jusqu'à 16 secondes.

La phase de pré-formation du modèle utilise une grande quantité de données d'images et de vidéos pour comprendre divers concepts du monde visuel, notamment le mouvement des objets, l'interaction, la géométrie, le mouvement de la caméra et les lois physiques.

Pour améliorer la qualité de la génération vidéo, le modèle est également supervisé (SFT) à l'aide d'un petit ensemble de vidéos et de légendes de texte de haute qualité soigneusement sélectionnées.

Le rapport montre que le processus post-formation est une étape importante dans la formation du modèle Movie Gen Video, qui peut encore améliorer la qualité de la génération vidéo, en particulier les fonctions de personnalisation et d'édition des images et des vidéos.

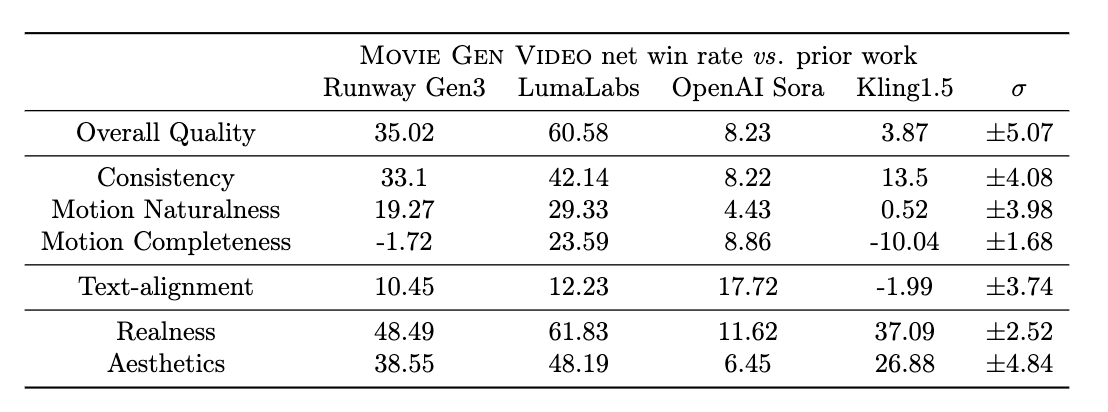

Il convient de mentionner que l’équipe de recherche a également comparé le modèle Movie Gen Video avec les modèles de génération vidéo grand public.

Étant donné que Sora n'est pas actuellement ouvert, les chercheurs ne peuvent utiliser ses vidéos et astuces publiées publiquement qu'à des fins de comparaison. Pour d'autres modèles, tels que Runway Gen3, LumaLabs et Keling 1.5, les chercheurs choisissent de générer eux-mêmes des vidéos via des interfaces API.

Et comme les vidéos publiées par Sora ont des résolutions et des durées différentes, les chercheurs ont recadré les vidéos de Movie Gen Video pour s'assurer qu'elles avaient la même résolution et la même durée lorsqu'elles étaient comparées.

Les résultats montrent que l'effet d'évaluation global de Movie Gen Video est nettement meilleur que celui de Runway Gen3 et de LumaLabs, présente un léger avantage par rapport à OpenAI Sora et est équivalent à Keling 1.5.

À l'avenir, Meta prévoit également de publier plusieurs benchmarks, notamment Movie Gen Video Bench, Movie Gen Edit Bench et Movie Gen Audio Bench, pour accélérer la recherche sur les modèles de génération vidéo.

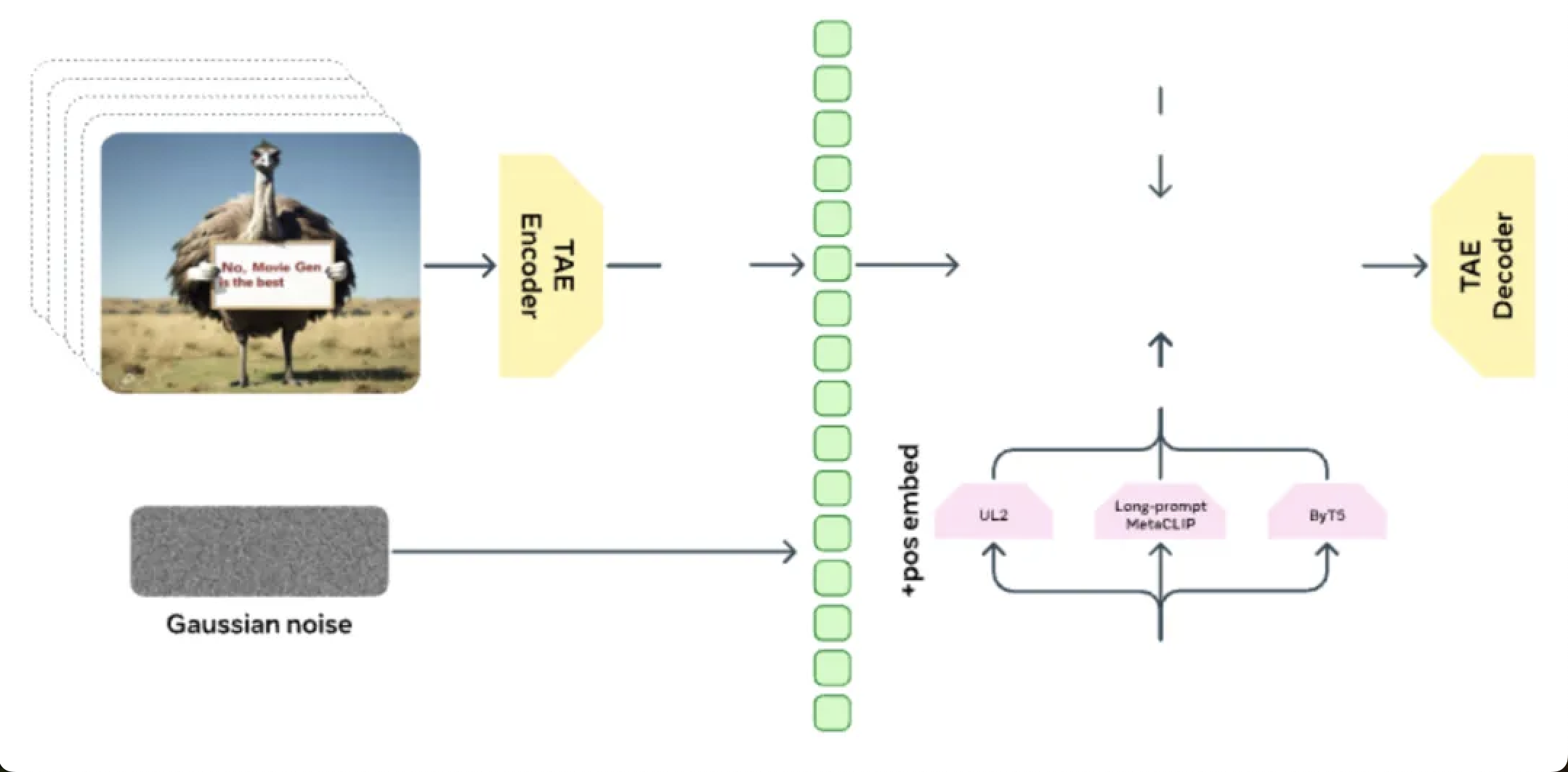

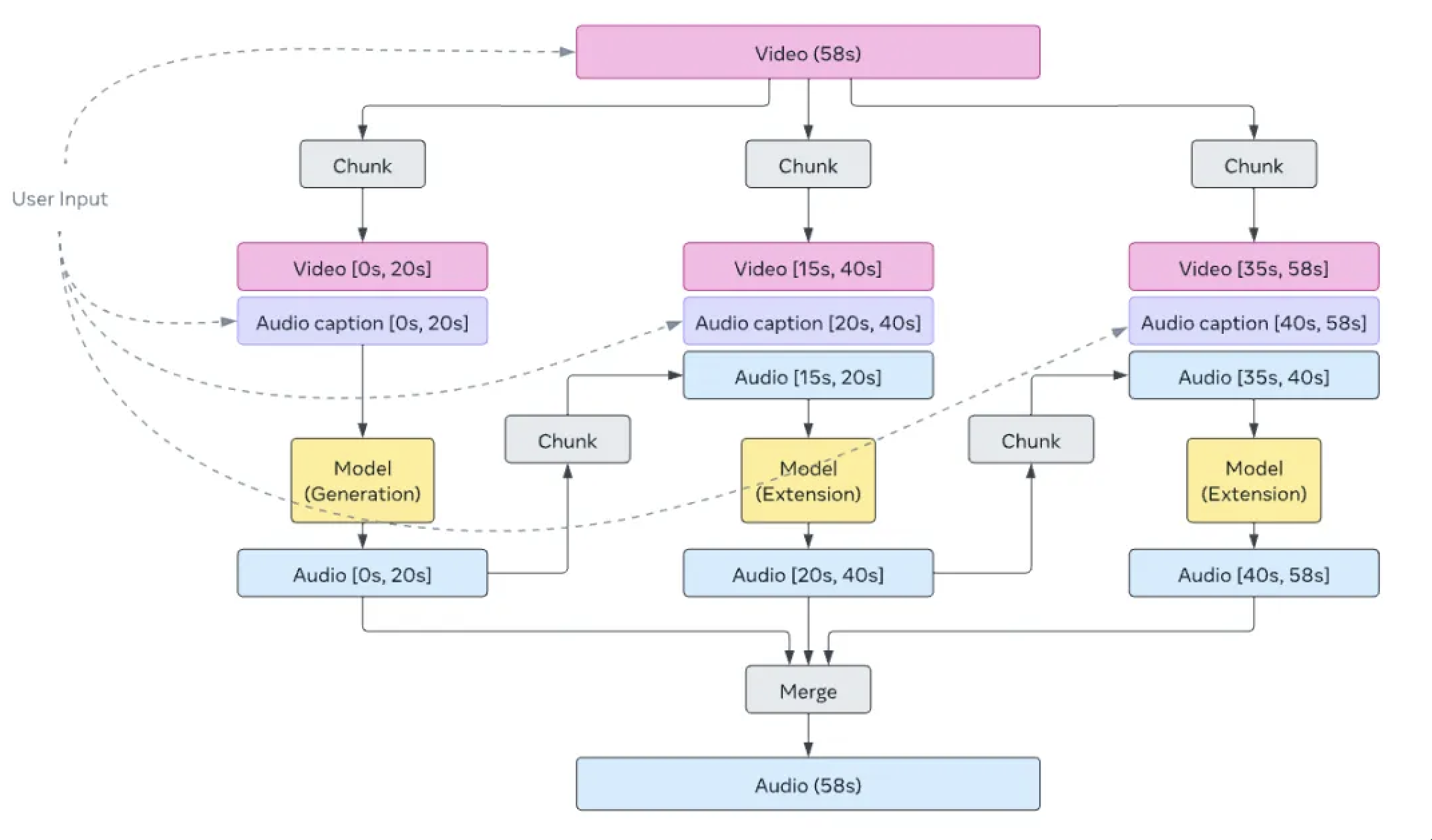

Le modèle Movie Gen Audio est un modèle de paramètres 13B pour la génération vidéo et texte-audio, capable de générer jusqu'à 45 secondes d'audio de haute qualité et haute fidélité, y compris des effets sonores et de la musique, et synchronisé avec la vidéo.

Le modèle adopte un modèle génératif basé sur Flow Matching et une architecture de modèle de transformateur de diffusion (DiT), et ajoute des modules conditionnels supplémentaires pour assurer le contrôle.

Même l'équipe de recherche de Meta a introduit une technologie d'expansion audio qui permet au modèle de générer un son cohérent au-delà de la limite initiale de 45 secondes, c'est-à-dire que le modèle peut générer un son correspondant quelle que soit la durée de la vidéo.

Pour des informations plus spécifiques, veuillez consulter le document technique

https://ai.meta.com/static-resource/movie-gen-research-paper

Hier, Tim Brooks, le patron d'OpenAI Sora, a officiellement annoncé sa démission et a rejoint Google DeepMind, ce qui a une fois de plus jeté un voile sur l'avenir incertain du projet Sora.

Selon Bloomberg, le vice-président de Meta, Connor Hayes, a déclaré que Meta Movie Gen n'avait actuellement aucun projet de produit spécifique. Hayes a révélé une raison importante du retard du déploiement.

Meta Movie Gen utilise actuellement des invites textuelles pour générer une vidéo qui nécessite souvent des dizaines de minutes d'attente, ce qui affecte grandement l'expérience utilisateur.

Meta espère améliorer encore l'efficacité de la génération vidéo et lancer le service vidéo sur le terminal mobile dès que possible afin de mieux répondre aux besoins des consommateurs.

En fait, si vous regardez la forme du produit, la conception fonctionnelle de Meta Movie Gen se concentre sur le fait d'être vaste et complète, et elle n'est pas « boiteuse » comme les autres modèles vidéo.

L'inconvénient le plus important est qu'il a la même saveur de « futur » que Sora.

L’idéal est très plein, la réalité est très maigre.

On peut dire que, tout comme Sora est actuellement dépassé par les grands modèles nationaux, avec le lancement de Meta Movie Gen, le paysage concurrentiel dans le domaine de la génération vidéo pourrait à nouveau changer.

Mais au moins pour l’instant, la tarte peinte par Meta est suffisante pour que les gens l’avalent.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo