Dialogue avec Liu Zhiyuan, scientifique en chef de l’intelligence murale : les grands modèles auront une nouvelle « loi de Moore » et les terminaux intelligents de l’ère AGI ne seront pas nécessairement des téléphones portables

Depuis l'année dernière, l'industrie chinoise de l'IA a lancé une « bataille de centaines de modèles », avec presque toutes les grandes entreprises de modèles visant à rattraper le GPT-4. Il y a aussi une entreprise qui semble un peu déplacée, à savoir l’intelligence murale qui se concentre sur les modèles finaux.

Les renseignements sur les murs sont devenus publics en raison d'un récent incident de plagiat commis par l'équipe de recherche en IA de Stanford. Liu Zhiyuan, scientifique en chef de Wall-Facing Intelligence, avait écrit à l’époque que cet incident prouvait l’influence internationale des innovations chinoises sous un autre angle.

Lors de la récente Conférence mondiale sur l'intelligence artificielle, Face Wall a publié le modèle d'activation efficace MiniCPM-S, qui peut utiliser une consommation d'énergie inférieure et accélérer la vitesse de raisonnement.

Wall-facing Intelligence a également déclaré publiquement qu'elle serait en mesure d'atteindre un modèle final de niveau GPT-4 d'ici la fin de 2026 .

Si GPT-4 et le modèle final sont réunis, cela équivaut à Wang Zha.

Cette année, de nombreux matériels d'IA natifs ont été remis en question, et les téléphones mobiles et les PC IA sont extrêmement populaires, mais ils ont peu d'impact sur les décisions d'achat des consommateurs. Dans une large mesure, ils sont limités par les capacités du grand côté final. les modèles et les fonctions les plus complexes nécessitent de s'appuyer sur le cloud pour être exécutés.

Dans la discussion animée sur les grands modèles, le MiniCPM intelligent bout à côté « petit canon en acier » est un modèle quelque peu sous-estimé. Le modèle MiniCPM 2.4B sorti en février 2024 peut en fait surpasser Llama2-13b.

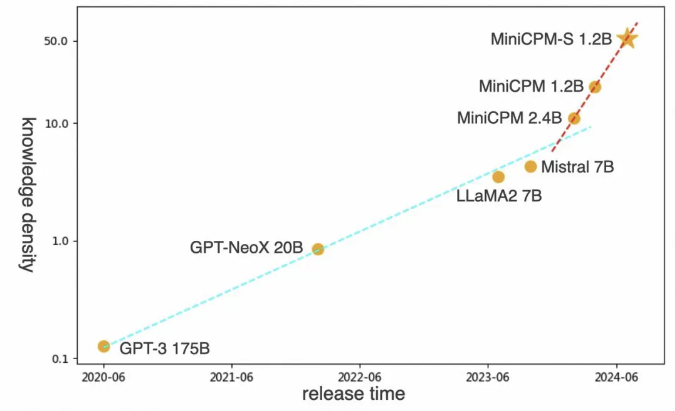

Liu Zhiyuan, scientifique en chef de Wall-Facing Intelligence, estime que l'ère des grands modèles aura sa propre loi de Moore. Le mot clé du premier principe des grands modèles efficaces à l'avenir devrait être la densité des connaissances.

▲Liu Zhiyuan, scientifique en chef du renseignement mural

Au cours du WAIC 2024, l'APPSO a eu une conversation avec Liu Zhiyuan, parlant de l'impact des modèles finaux sur les futures formes de terminaux intelligents, de la manière de découvrir la loi de Moore des grands modèles et de la façon dont un idéaliste sorti de la tour d'ivoire peut réussir la cible du monde de l'entreprise proche d'AGI.

Voici la transcription de la conversation entre Liu Zhiyuan et APPSO :

La loi de Moore à l'ère des grands modèles

APPSO : Alors que tout le monde se compare à OpenAI pour créer de grands modèles généraux, pourquoi Wallface Intelligence a-t-elle choisi de se concentrer sur les modèles finaux ? Y a-t-il une controverse interne ?

Liu Zhiyuan : En fait, nous avons déjà lancé le modèle à 100 milliards de dollars au milieu de l'année dernière, plus tôt que de nombreuses grandes entreprises de modèles nationales. Mais nous sommes confrontés à un choix : laisser ou non le processus de modélisation correspondre à son niveau de densité de connaissances. À cette époque, le consensus de l’industrie était de déployer des modèles plus grands et d’essayer d’atteindre GPT-4.

En tant qu'entrepreneur, il est naturel de se mettre à la place de quelqu'un d'autre. C'est pourquoi nous avons également mené de sérieuses discussions internes pour déterminer si nous devrions élargir ce modèle. Achetez ensuite plus de puissance de calcul et passez quelques mois à construire ce modèle.

APPSO : Pourquoi n’avez-vous finalement pas fait cela ?

Liu Zhiyuan : Nous pensons que nous devons d'abord améliorer notre processus de fabrication de modèles. Nous construisons des souffleries modèles depuis le second semestre de l'année dernière pour rendre la formation des modèles prévisible. En d’autres termes, il peut être prédit avant l’entraînement du modèle si l’entraînement avec ces données peut atteindre le niveau attendu.

Nous n’avons donc pas continué à déployer GPT-4. Notre prédiction est que si nous travaillons dur pour augmenter la puissance de calcul, les données et l'échelle des paramètres du modèle, un modèle de niveau GPT-4 sera publié d'ici juin de cette année. C'est quelque chose que toutes les grandes entreprises modèles nationales de premier niveau peuvent réaliser. .

Si tout le monde peut le faire, et nous pouvons le faire aussi, quel est notre avantage concurrentiel ? Nous avons donc décidé de commencer par les applications de niveau GPT-3.5, puis de passer au processus de roulement.

APPSO : Le processus de laminage ressemble un peu à l’idée de fabrication de puces.

Liu Zhiyuan : En fait, le processus représente une densité de connaissances. Nous avons choisi d'utiliser un modèle relativement petit, puis de vérifier nos capacités de processus. Nous avons donc choisi de construire un modèle côté appareil à cette époque. Au début de cette année, nous avions construit le modèle 2.4B.

En fait, avant de le faire, nous pensions que puisque nous allions réaliser un si petit modèle, nous devions le faire fonctionner sur un téléphone mobile. Bien sûr, je ne m’attendais pas à dire que nous devons développer une intelligence finale pour les téléphones mobiles. Il s'avère que le modèle final que nous avons réalisé à l'aide de la technologie de soufflerie peut atteindre le niveau de paramètres de 175 milliards de GPT-3 avec des paramètres de 2,4B et peut comparer les effets de Mistral 7B et de Lama 2 13B.

APPSO : Vous avez mentionné à plusieurs reprises la densité des connaissances et le processus de fabrication. Avons-nous une norme spécifique ?

Liu Zhiyuan : Par exemple, si je vous pose 100 questions de test de QI, combien de points pouvez-vous obtenir ? Combien de puissance de calcul cela coûte-t-il ? Lorsque vous répondez à ces 100 questions de test, combien de neurones avez-vous impliqués dans le calcul ? Moins vous impliquez de neurones dans les calculs, plus votre QI est élevé, car vous pouvez effectuer ces tâches avec moins de neurones. C'est le concept de base de la densité des connaissances .

Il comporte deux éléments. L’un d’eux est la capacité de ce modèle. Le deuxième élément est le nombre de neurones requis pour cette capacité, ou la consommation électrique de calcul correspondante.

Note de l'éditeur : Liu Zhiyuan a proposé que la densité de connaissances du modèle (densité de connaissances = capacité du modèle/consommation d'énergie de calcul d'inférence) doublerait en moyenne tous les huit mois.

APPSO : Selon vous, à quel stade en est l’intelligence artificielle générale représentée par le grand modèle actuel ?

Liu Zhiyuan : Nous sommes dans la période tychonique de la physique. Tycho a collecté une grande quantité de données sur le mouvement des corps célestes, mais il n'avait pas trouvé les véritables lois du mouvement de ces corps célestes. Ce n’est que plus tard que les lois de Kepler sont apparues, et encore plus tard la loi de la gravitation universelle de Newton.

Si nous pouvons trouver la loi de la gravitation universelle qui appartient au développement de grands modèles, alors nous pourrons utiliser cette loi pour construire la meilleure machine de lithographie au monde .

APPSO : Est-ce qu'OpenAI fait cela aussi ?

Liu Zhiyuan : OpenAI le fait certainement, car il a en fait proposé il y a quelques années une pile d'apprentissage en profondeur avec une mise à l'échelle prévisible. En fait, cela est similaire au concept de soufflerie modèle. Cela devrait être le consensus de beaucoup de gens maintenant. C'est juste qu'OpenAI n'est pas ouvert depuis l'année dernière. La plupart des gens ne connaissent en fait que la loi de mise à l'échelle qu'ils ont mentionnée auparavant, et ne savent pas les choses les plus importantes qu'elle fera réellement plus tard. .

APPSO : Vous souhaitez rechercher des éléments de niveau inférieur, plutôt que de réfléchir à la manière d'apporter rapidement une valeur commerciale pour le moment

Liu Zhiyuan : La scientificisation des grands modèles doit être une condition préalable à une véritable commercialisation à l'avenir . De nos jours, alors que tout le monde court après les grands modèles et l'AGI, ils ont deux choix.

Une option consiste à utiliser le même processus, ou même un processus pire, puis à entraîner un très grand modèle, des modèles de plus en plus grands, puis à atteindre le niveau GPT-4, mais cela a-t-il du sens ?

Nous avons estimé que cette affaire n'était pas fiable depuis le second semestre de l'année dernière. Parce que si votre processus de fabrication n’est pas assez solide, vous n’avez en réalité aucune compétitivité. L'écart entre nous et OpenAI ne réside pas dans l'échelle des paramètres du modèle, mais dans le processus de fabrication.

Donc en fait, vous constaterez qu'au premier semestre de cette année, tout le monde a commencé à augmenter le prix de cette API. Cette question n'a pas d'importance, mais elle empêche tout le monde de gagner de l'argent.

Imaginez que vous dépensiez des dizaines de millions pour former un énorme modèle, puis fournissiez l'API de ce modèle. 1 million de jetons ne coûtent que quelques centimes. Même s'il y a des dizaines de milliards d'utilisations en un mois, les revenus correspondants couvriront le coût. coût. . Ne pensez-vous pas que c’est un schéma très désespéré ? C'est encore plus fou que la guerre des Cent Régiments à l'époque.

Les terminaux intelligents à l'ère de l'AGI

APPSO : Récemment, vous êtes également devenu le premier partenaire modèle côté client à grande échelle de Huawei Cloud. Est-ce l'orientation de votre future commercialisation ?

Liu Zhiyuan : Nous coopérerons avec davantage de fabricants dans les 2 à 3 prochaines années. Je pense qu'il y aura dans le futur des terminaux intelligents appartenant à l'ère AGI, qui ne seront peut-être pas des téléphones portables ou des voitures.

APPSO : Quelle est votre forme de terminal idéale à l’ère AGI ?

Liu Zhiyuan : La forme actuelle des téléphones mobiles est en fait la méthode d'interaction multi-touch introduite par Apple à l'époque. Mais si l’IA devient suffisamment intelligente à l’avenir, aurons-nous encore besoin d’une interaction par clic ? À l'avenir, il devra y avoir une méthode d'interaction en langage naturel appartenant à AGI, qui soit plus conforme à nos caractéristiques humaines. On dit même qu’un jour, une fois l’interface cerveau-ordinateur connectée, je n’aurai même plus besoin de parler. Par conséquent, le terminal intelligent appartenant à AGI n’est peut-être pas un téléphone mobile, ou le téléphone mobile changera de forme à un moment donné. indiquer.

Et quand nous avons une manière plus naturelle d’interagir, pourquoi avons-nous besoin d’une application ? Si les grands fabricants de téléphones portables comme Apple ne travaillent pas dans cette direction, quelqu’un d’autre le fera certainement.

APPSO : Selon vous, quel sera le personnage de Wall Face dans tout cela ?

Liu Zhiyuan : Pour une start-up comme la nôtre, notre avantage est l'innovation, l'innovation extrême. Notre premier objectif est de découvrir comment utiliser AGI. Nous sommes nés pour cela, et c'est notre avantage.

Même les grands constructeurs seront écrasés par les rouages de l’histoire s’ils n’innovent pas, tout comme Nokia à l’époque.

APPSO : Comment décririez-vous votre coopération avec Huawei ?

Liu Zhiyuan : Nous espérons former un partenariat avec des entreprises comme Huawei qui pourra servir de modèle industriel pour la collaboration entre appareils et cloud .

APPSO : Huawei a lancé un Hongmeng de sang pur, dans lequel le cadre d'IA et les grands modèles sont très importants. Aurez-vous davantage de coopération à l'avenir ?

Liu Zhiyuan : Il y aura certainement une coopération dans le domaine des puces intelligentes, des systèmes d'exploitation intelligents et même au niveau des modèles.

APPSO : Craignez-vous que ces fabricants de matériel créent leurs propres modèles côté appareil ?

Liu Zhiyuan : Il y a une grande différence entre les marchés chinois et américain. La chaîne industrielle américaine a un fort sentiment de sécurité entre elle et tout le monde peut faire des affaires ensemble. Mais la Chine semble vouloir que chaque entreprise fasse tout par elle-même. S’il y a un élément qui n’est pas fait par elle-même, elle se sentira très en insécurité. Si nous parvenons à former de manière créative une coopération très stable, alors je pense qu’elle sera en mesure de donner. faire jouer pleinement les avantages du travail de chacun, mais peut mieux occuper ce marché.

APPSO : Que peut faire Wallface que les autres fabricants de matériel ne peuvent pas faire ?

Liu Zhiyuan : Tout d'abord, du point de vue des algorithmes de grands modèles, en fait, leur technologie est rapidement dédiffusée. Nous ne recherchons pas une technologie de formation de modèles que d'autres fabricants ne maîtriseront jamais.

Au moins pour l'instant, en raison des limitations de la puissance de calcul et de la consommation d'énergie de la mémoire, les exigences en matière de processus de fabrication du modèle sont en fait plus élevées. Il doit être capable de placer le modèle sur une échelle de paramètres plus petite de manière plus extrême, tout en disposant de capacités plus fortes.

Par exemple, dans le processus de fabrication des puces, le processus le plus avancé doit être utilisé pour fabriquer les puces de test final. Étant donné que l'espace pour les tests de bout en bout est plus petit et plus sensible à la consommation d'énergie, même le modèle de test de bout en bout doit nécessiter un processus de modèle plus élevé, plus strict que le modèle cloud.

Dans les tests cloud, tant que vos ressources en puissance de calcul sont suffisantes, vous pouvez avoir plus de marge de manœuvre. Mais il en va différemment dans les tests finaux. Les limites des tests finaux sont limitées par sa puce, sa mémoire et sa batterie. Vous devez donc former un modèle extrêmement petit. De ce point de vue, sans parler des grandes entreprises modèles présentes actuellement sur le marché, par exemple, Google a formé des modèles du même niveau deux mois plus tard que nous, et était toujours derrière nous d'environ 10 %.

APPSO : Vous l'avez déjà prédit. Vous pensez qu'à l'avenir, la plupart des applications seront du côté des appareils. Dans quelle mesure pensez-vous que cela est possible ?

Liu Zhiyuan : En fait, le testeur final doit être un Einstein pour vous servir. Le niveau GPT-4 ou GPT-4o suffit. J'estime que si la densité des connaissances sur les puces end-side augmente au même rythme, au cours des deux prochaines années, nous pourrons mettre le niveau GPT-4 dans les tests end-side, et alors plus de 80 % des exigences seront remplies sur le côté final.

APPSO : Votre prédiction est assez radicale.

Liu Zhiyuan : Est-ce radical ? Nous pouvons attendre et voir.

Vers l’AGI, l’objectif doit aller au-delà de la nature humaine

APPSO : Depuis l'apparition des grands modèles, tous les grands fabricants de modèles parlent de TPF Technology-Problem Fit). Comment Wall-Facing Intelligence forme-t-il un consensus sur la technologie et les produits en interne, et combine T et P ?

Liu Zhiyuan : Nous avons une vision à plus long terme. Nous voulons être une super application à l'ère de l'AGI.

Mais nous devons survivre à court terme et prouver la valeur de notre technologie au marché. Par conséquent, nous achèverons la vérification de la technologie grâce à une coopération stratégique avec certains fabricants, par exemple en aidant le tribunal populaire intermédiaire de Shenzhen à lancer un système de procès assisté par intelligence artificielle. Ces explorations constituent nos objectifs à court terme pour réaliser notre vision à long terme.

APPSO : Les super applications sont également un sujet très brûlant. Baidu Robin Li a déclaré que lorsque nous parlons maintenant de super applications, cela peut être un piège ou une fausse proposition. Il n’existe actuellement aucune définition généralement acceptée de ce qu’est une super application. Qu’en pensez-vous ?

Liu Zhiyuan : Après 2000, j’ai perçu au moins deux vagues technologiques très importantes. L’une d’elles était la technologie de recherche, qui a donné naissance à de grandes entreprises comme Google. La deuxième fois est la technologie de recommandation personnalisée. Cela a donné naissance à des applications importantes telles que Douyin.

En fait, ces technologies elles-mêmes étaient très certaines à l’époque. Tout le monde sait qu’il s’agit d’une très grande avancée. Il s’agit simplement de savoir comment l’utiliser et quel type de produit il forme. Cette affaire est incertaine et nécessite une concurrence.

Pour nous, la première est de maîtriser la technologie la plus avancée, et la seconde est d'être suffisamment sensible lorsqu'une super application apparaît, il faut pouvoir se rendre compte qu'il s'agit d'une super application.

APPSO : Vous pensez donc qu’il est difficile de définir une super application maintenant ?

Liu Zhiyuan : En regardant l'histoire, lorsque Google et Toutiao sont apparus, combien de personnes ont réalisé qu'il s'agissait de super applications. À l’époque, Yahoo News créait une application spéciale qui ne vous diffusait que dix actualités par jour.

Vous voyez, même si les gros titres d’aujourd’hui sont déjà devant eux, il prendra quand même ces décisions. De plus, la super application n'est pas encore apparue. Même si c'est le cas, la plupart des gens ne l'utiliseront pas.

APPSO : Comment découvrir des super applications ?

Liu Zhiyuan : Ce que je dis toujours à mes étudiants, c'est de ne jamais être une personne ayant des intérêts particuliers . Ne soyez pas réticent à admettre que vous avez été révolutionné simplement parce que vous aviez divers avantages auparavant .

Beaucoup de gens ne veulent pas admettre qu’ils ont été révolutionnés. Lorsqu’il faisait de la traduction automatique statistique, il n’était pas disposé à voir l’émergence de la traduction automatique neuronale. Lorsqu’il fait de la traduction automatique neuronale, il ne souhaite pas voir émerger de grands modèles. Parce qu'il sentait que tout ce dans quoi il était bon n'avait aucun sens, et il ne voulait pas l'admettre.

APPSO : C’est la nature humaine.

Liu Zhiyuan : 99 % des gens sont humains. Je pense que pour y parvenir, vous devez avoir le sens de la mission. Votre objectif doit dépasser votre humanité .

Si votre mission est inférieure à votre humanité, alors vous ne devez pas pouvoir l'accomplir. Par exemple, si un fondateur pense que la chose la plus importante pour lui est de conserver l'entreprise, je pense qu'il y a de fortes chances qu'il ne parvienne pas à rattraper la super application. Il ne peut pas bien le faire. fait le bien?

APPSO : Seule une personne quelque peu idéaliste dirait une telle chose.

Liu Zhiyuan : Sans idéalisme, je n'aurais pas fondé cette entreprise.

APPSO : Certaines personnes disent que la difficulté d'un grand modèle à un agent intelligent est exponentielle. Est-ce vrai ?

Liu Zhiyuan : Je ne pense pas qu’il existe une réponse standard à l’intelligence elle-même, mais la clé dépend de ce que vous y mettez. Ce sur quoi je suis plus optimiste, c’est que l’agent intelligent peut être doté de nombreux éléments, tels que ses capacités de planification, de prise de décision et d’exploration. Si vous considérez tout cela comme faisant partie de l’AGI, je pense en fait que ce qu’il vaut le plus la peine d’attendre à l’avenir, ce sont les agents Internet.

C'est l'équivalent de l'Internet composé de ces agents. Nous l'appelons l'Internet du renseignement. Je pense que cela vaut la peine d'être attendu avec impatience. Vous pouvez imaginer que, tout comme notre société humaine, c’est une communauté hautement interconnectée. Tout le monde accomplit un travail en pleine coopération. De nombreux domaines, en particulier les domaines complexes, exigent en fait que chacun ait sa propre expérience professionnelle et sa propre expertise, et qu'ils doivent travailler ensemble pour y parvenir.

APPSO : Est-ce un peu trop loin de parler d’AGI maintenant ?

Liu Zhiyuan : Je ne pense pas que ce soit loin. Avant la sortie de ChatGPT vers la fin de 2022, j'ai toujours pensé qu'AGI avait encore un problème non résolu, qui est le problème du bon sens, c'est-à-dire comment établir un bon sens sur le monde.

Par exemple, un canard a une tête, deux pattes et deux ailes, ce qui relève du bon sens. Avant l’émergence de GPT-3.5, je pensais que ces connaissances étaient difficiles à apprendre à partir des données. Y compris les problèmes physiques, comme ce qui se passe lorsque vous balayez une tasse de la table au sol, etc. Quand on lui pose des questions de bon sens sur les grands modèles, il ne peut pas y répondre.

Après l’émergence de ChatGPT, nous avons constaté que ce bon sens semble pouvoir être appris par le modèle de manière basée sur les données. C'est juste que nous ne savions pas comment l'appeler auparavant, et ChatGPT nous a dit comment l'appeler. Je pense que ce parcours technique est très fluide. Il suffit de transmettre les données correspondant aux connaissances à apprendre à ce modèle pour l'apprendre.

APPSO : Les grands modèles peuvent-ils vraiment comprendre le monde comme le font les humains ?

Liu Zhiyuan : Il est connecté à ce modèle et apprend vos habitudes quotidiennes d'utilisation de ces applications. Il n'y a absolument aucune raison pour qu'il ne puisse pas connaître vos préférences. Par exemple, si je veux réserver un vol et que vous lui dites quand je veux le réserver, il le fera.

Donc, à mon avis, l’orientation de cette technologie a été très déterminée. En parlant simplement de la façon de résoudre les trois éléments que sont les données, l'architecture et les méthodes de croissance, je pense que nous devrions examiner ce problème avec plus d'optimisme.

OpenAI affirme qu'elle deviendra une entreprise de superintelligence dans six ans, ce qui, à mon avis, est un objectif tout à fait réalisable .

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo