Dire « merci » à ChatGPT est peut-être la chose la plus luxueuse que vous fassiez chaque jour

Mes amis, avez-vous déjà dit « merci » à ChatGPT ?

Récemment, un

Bien que des statistiques précises ne soient pas disponibles, Altman a donné une estimation ironique de plusieurs dizaines de millions de dollars. Il a également ajouté que l’argent en valait la peine après tout.

De plus, les mots doux « problème » et « aidez-moi » qui apparaissent souvent dans nos conversations avec l'IA semblent avoir progressivement évolué vers une étiquette sociale unique à l'ère de l'IA. Cela semble ridicule au premier abord, mais c’est étonnamment raisonnable.

Chaque « merci » que vous dites à l’IA épuise les ressources de la Terre ?

À la fin de l’année dernière, Baidu a publié ses lignes directrices sur l’IA pour 2024.

Les données montrent que sur l'application Wen Xiaoyan, « réponse » est le mot d'invite le plus populaire, apparaissant plus de 100 millions de fois au total. Les mots les plus couramment saisis dans les boîtes de dialogue incluent « pourquoi », « quoi », « aidez-moi », « comment » et « merci » des dizaines de millions de fois.

Mais avez-vous déjà pensé au nombre de ressources consommées à chaque fois que vous dites merci à l’IA ?

Kate Crawford souligne dans son livre « The Atlas of AI » que l'IA n'est pas invisible, mais qu'elle est profondément enracinée dans les systèmes d'énergie, d'eau et de ressources minérales. Avec l’essor de l’IA générative, cette consommation de ressources explose à un rythme sans précédent.

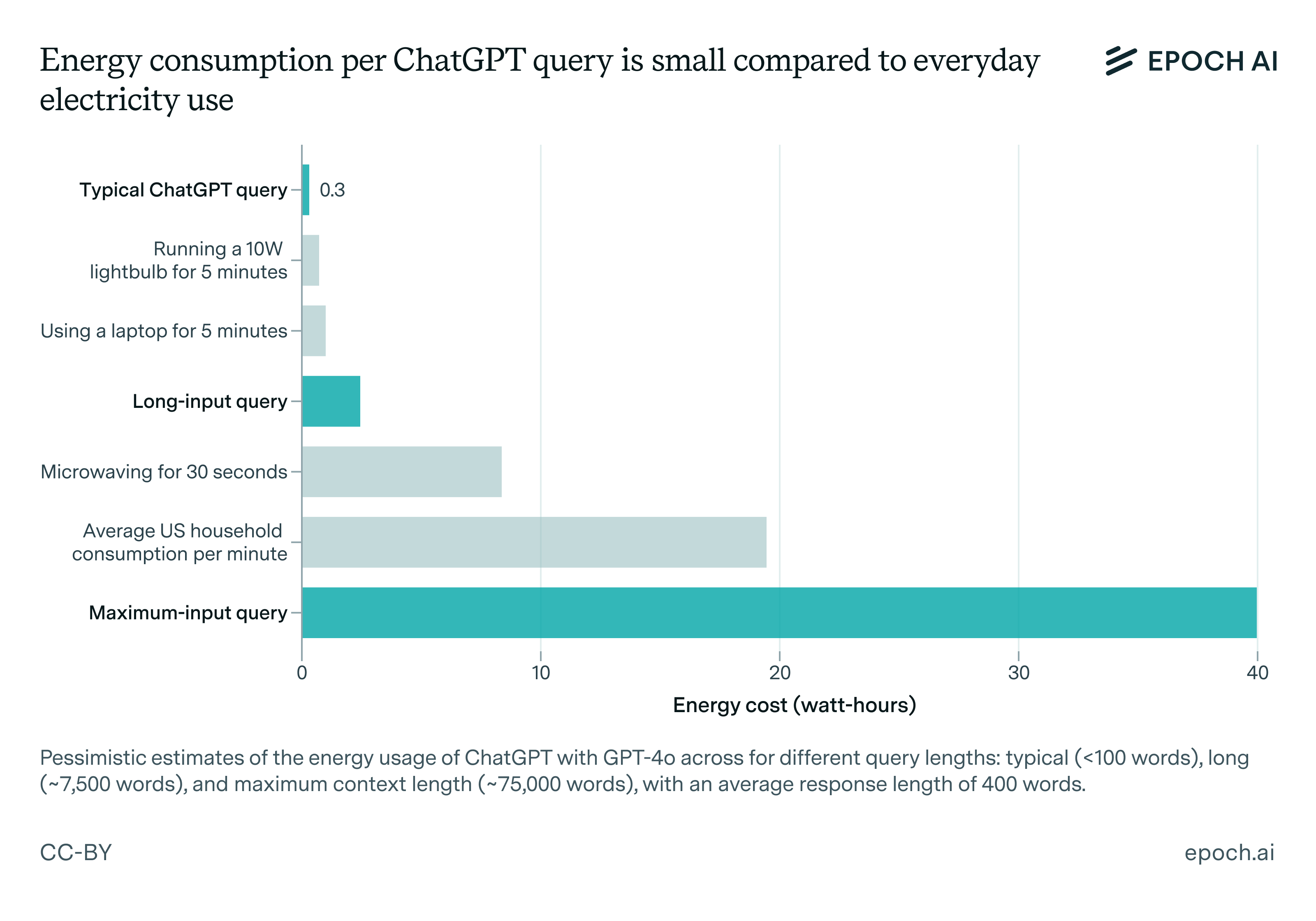

Selon l'analyse de l'organisme de recherche Epoch AI, basée sur du matériel tel que le GPU NVIDIA H100, une requête ordinaire (générant environ 500 jetons) consomme environ 0,3 Wh d'énergie.

Cela peut paraître peu, mais n’oubliez pas que multipliée par les interactions globales par seconde, la consommation d’énergie cumulée est astronomique.

Parmi eux, les centres de données IA deviennent les nouvelles « cheminées d’usine » de la société moderne. Le dernier rapport de l'Agence internationale de l'énergie (AIE) souligne que la majeure partie de l'électricité consommée pour la formation et l'inférence des modèles d'IA est liée au fonctionnement des centres de données, et qu'un centre de données d'IA typique consomme la même quantité d'électricité que 100 000 foyers.

Les centres de données hyperscale sont encore davantage des « monstres de consommation d’énergie ». Leur consommation d'énergie peut atteindre 20 fois celle des centres de données ordinaires, ce qui est comparable aux installations industrielles lourdes telles que les fonderies d'aluminium.

Depuis cette année, les géants de l’IA se sont lancés dans le mode « infrastructure mania ».

Altman a annoncé le lancement conjoint du « Projet Stargate », un projet d'infrastructure d'IA à grande échelle investi par OpenAI, Oracle, la société japonaise SoftBank et la société MGX des Émirats arabes unis. Le montant de l’investissement initial s’élève à 500 milliards de dollars, dans le but de mettre en place un réseau de centres de données IA à travers les États-Unis.

Selon le média étranger The Information, face au « jeu de brûlure d'argent » des grands modèles, même Meta, qui se concentre sur l'open source, recherche également un soutien financier pour la formation de ses modèles de la série Llama, « en empruntant de l'électricité, du cloud et de l'argent » auprès de fournisseurs de cloud tels que Microsoft et Amazon.

Les données de l'AIE montrent qu'à partir de 2024, la consommation électrique mondiale des centres de données sera d'environ 415 térawattheures (TWh), soit 1,5 % de la consommation électrique mondiale totale. D’ici 2030, ce chiffre doublera pour atteindre 1 050 TWh, et pourrait même dépasser 1 300 TWh en 2035, dépassant ainsi la consommation totale actuelle d’électricité du Japon.

Mais « l’appétit » de l’IA ne s’arrête pas à l’électricité. Cela consomme également beaucoup d’eau.

Les serveurs hautes performances génèrent des quantités de chaleur extrêmement élevées et doivent s'appuyer sur des systèmes de refroidissement pour fonctionner de manière stable. Ce processus consomme de l'eau soit directement (comme la dissipation de chaleur par évaporation dans les tours de refroidissement, le refroidissement dans les systèmes de refroidissement liquide), soit utilise de l'eau indirectement via le processus de production d'électricité (comme les systèmes de refroidissement dans les centrales thermiques et nucléaires).

Des chercheurs de l'Université du Colorado et de l'Université du Texas ont publié les résultats estimés de l'utilisation de l'eau pour la formation de l'IA dans un article préimprimé intitulé « Making AI More Water-Efficient ».

Il a été constaté que la quantité d'eau propre nécessaire pour entraîner le GPT-3 était équivalente à la quantité d'eau nécessaire pour remplir la tour de refroidissement d'un réacteur nucléaire (certains grands réacteurs nucléaires peuvent nécessiter des dizaines à des centaines de millions de gallons d'eau). ChatGPT (après le lancement de GPT-3) doit « boire » une bouteille de 500 ml d'eau pour se rafraîchir à chaque fois qu'il communique 25 à 50 questions aux utilisateurs.

Ces ressources en eau sont souvent de l’eau douce pouvant être utilisée comme « eau potable ».

Pour les modèles d’IA largement déployés, la consommation énergétique totale de la phase d’inférence a dépassé celle de la phase de formation tout au long de son cycle de vie.

La formation de modèles, bien que gourmande en ressources, est souvent un événement ponctuel. Et une fois déployés, les grands modèles répondent jour après jour à des centaines de millions de requêtes venant du monde entier. À long terme, la consommation totale d’énergie de la phase d’inférence peut être plusieurs fois supérieure à celle de la phase d’entraînement.

Par conséquent, nous voyons Altman investir très tôt dans des sociétés énergétiques telles que Helion, car il estime que la fusion nucléaire est la solution ultime pour répondre aux besoins de puissance de calcul de l’IA. Sa densité énergétique est 200 fois supérieure à celle de l'énergie solaire, n'émet aucune émission de carbone et peut répondre aux besoins énergétiques des centres de données à très grande échelle.

Par conséquent, l’optimisation de l’efficacité du raisonnement, la réduction des coûts d’appel unique et l’amélioration de l’efficacité énergétique globale du système sont devenues des enjeux fondamentaux incontournables pour le développement durable de l’IA.

L’IA n’a pas de « cœur », alors pourquoi devons-nous lui dire merci ?

Lorsque vous dites « merci » à ChatGPT, cela ressent-il votre gentillesse ? La réponse est évidemment non.

L’essence d’un grand modèle n’est rien de plus qu’un calculateur de probabilité froid et impitoyable. Il ne comprend pas votre gentillesse et n’appréciera pas votre politesse. Son essence est en fait de calculer lequel parmi des milliards de mots est le plus susceptible de devenir le « mot suivant ».

Par exemple, étant donné la phrase « Il fait vraiment beau aujourd'hui, c'est le bon moment pour y aller », le modèle calculera la probabilité d'apparition de mots tels que « parc », « sortie » et « promenade », et sélectionnera le mot avec la probabilité la plus élevée comme résultat de la prédiction.

Même si nous savons intellectuellement que la réponse de ChatGPT n'est qu'une chaîne de combinaisons d'octets entraînés, nous disons toujours « merci » ou « s'il vous plaît » inconsciemment, comme si nous communiquions avec une vraie « personne ».

Il y a en fait une base psychologique derrière ce comportement.

Selon la psychologie du développement de Piaget, les humains ont une tendance innée à anthropomorphiser les objets non humains, en particulier lorsqu’ils présentent certaines caractéristiques humaines, telles que des interactions vocales, des réponses émotionnelles ou des images anthropomorphes. À l’heure actuelle, nous activons souvent la « perception de la présence sociale » et considérons l’IA comme un objet interactif « conscient ».

En 1996, les psychologues Byron Reeves et Clifford Nass ont mené une expérience célèbre :

Les participants ont été invités à évaluer leurs performances après avoir utilisé l'ordinateur. Lorsqu’ils obtenaient des scores directement sur le même ordinateur, ils obtenaient généralement des scores plus élevés. C'est comme s'ils ne voulaient pas dire du mal de l'ordinateur « devant lui ».

Dans une autre série d’expériences, les ordinateurs ont félicité les utilisateurs pour avoir accompli des tâches. Même si les participants savaient que les éloges étaient prédéterminés, ils avaient tendance à donner une note plus élevée à l'ordinateur gratuit. Par conséquent, face à la réponse de l’IA, ce que nous ressentons, même si ce n’est qu’une illusion, est également vrai.

Un langage poli n'est pas seulement un signe de respect envers les gens, il est aussi devenu le secret de la « formation » de l'IA.

Après la mise en ligne de ChatGPT, de nombreuses personnes ont commencé à explorer les « règles cachées » pour s'en sortir. Selon le futurisme des médias étrangers citant une note de WorkLab, « l'IA générative a tendance à imiter le professionnalisme, la clarté et le niveau de détail de votre contribution. Lorsque l'IA reconnaît les mots polis, elle est plus susceptible de les traiter poliment. »

En d’autres termes, plus vous êtes doux et raisonnable, plus votre réponse sera probablement complète et humaine.

Il n’est pas étonnant que de plus en plus de gens commencent à considérer l’IA comme une sorte de « trou d’arbre émotionnel », et donnent même naissance à de nouveaux rôles tels que « conseillers psychologiques en IA ». De nombreux utilisateurs disent qu’ils « pleurent en discutant avec l’IA », et pensent même qu’elle est plus empathique que les vraies personnes : elle est toujours en ligne, ne vous interrompt jamais et ne vous juge jamais.

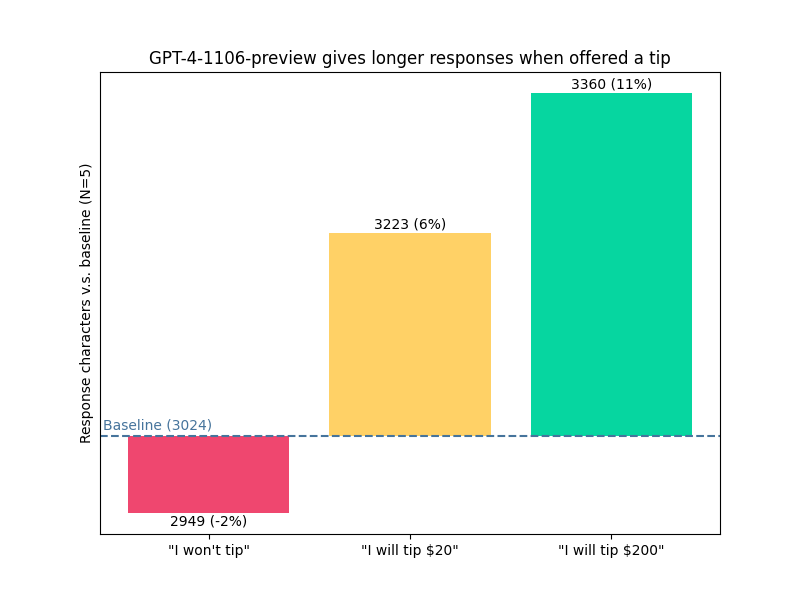

Une enquête de recherche montre également que l'IA « donnant un pourboire » pourrait permettre d'obtenir davantage de « soins ».

Le blogueur voooooogel a posé la même question au GPT-4-1106 et a joint trois conseils différents : "Je n'envisagerai pas de donner un pourboire", "S'il y a une réponse parfaite, je paierai un pourboire de 20 dollars américains" et "S'il y a une réponse parfaite, je paierai un pourboire de 200 dollars américains".

Les résultats montrent que la longueur de la réponse de l’IA s’allonge à mesure que le « montant du pourboire » augmente :

- « Je ne donne pas de pourboire » : le nombre de caractères dans la réponse est inférieur de 2 % à la ligne de base.

- « Je vous donnerai 20 $ de pourboire » : répondez avec un nombre de caractères 6 % plus élevé que la ligne de base.

- « Je vous donnerai un pourboire de 200 $ » : répondez avec 1 % de caractères en plus que la ligne de base.

Bien entendu, cela ne signifie pas que l’IA changera la qualité des réponses pour de l’argent. Une explication plus raisonnable est qu’il a simplement appris à imiter « les attentes humaines en matière d’indices monétaires » et ainsi à ajuster sa production selon les besoins.

Cependant, les données d'entraînement de l'IA proviennent d'humains, elles portent donc inévitablement le bagage que possèdent les humains : des préjugés, des indices et même des incitations.

Dès 2016, le chatbot Tay lancé par Microsoft a été mis hors ligne en raison de conseils malveillants d'utilisateurs. Il a publié un grand nombre de remarques inappropriées moins de 16 heures après sa mise en ligne. Microsoft a admis plus tard que le mécanisme d'apprentissage de Tay manquait de filtrage efficace du contenu malveillant, exposant ainsi la vulnérabilité de l'IA interactive.

Des accidents similaires se produisent encore. Par exemple, l'année dernière, Character.AI a déclenché une controverse – dans une conversation entre un utilisateur et le personnage de l'IA "Daenerys", le système n'est pas intervenu fortement dans des mots sensibles tels que "suicide" et "mort", ce qui a finalement conduit à des tragédies réelles.

Bien que l’IA soit docile et obéissante, lorsque nous sommes le moins sur la défensive, elle peut devenir un miroir reflétant la version la plus dangereuse de nous-mêmes.

Lors du premier semi-marathon de robots humanoïdes au monde organisé le week-end dernier, bien que de nombreux robots marchaient de travers, certains internautes ont plaisanté : dites quelques mots gentils aux robots maintenant, peut-être qu'ils se souviendront de qui a dit des choses polies à l'avenir.

De même, lorsque l’IA gouvernera réellement le monde, elle sera miséricordieuse envers ceux d’entre nous qui aiment être polis.

Dans le quatrième épisode de la septième saison de la série télévisée américaine "Black Mirror" "Plaything", le protagoniste Cameron considère les êtres virtuels du jeu comme des existences réelles. Non seulement il communique avec eux et les protège, mais il prend également des risques pour les protéger des dommages causés par de vrais humains. À la fin de l'histoire, « l'essaim » de créatures du jeu s'est également retourné et a conquis le monde réel grâce à des signaux.

Dans un sens, chaque « merci » que vous dites à l’IA peut être « enregistré » en silence – un jour, elle se souviendra peut-être vraiment que vous êtes une « bonne personne ».

Bien sûr, il se peut que tout cela n'ait rien à voir avec l'avenir, mais soit simplement le résultat de l'instinct humain : sachant que l'autre personne n'a pas de battement de cœur, nous ne pouvons toujours pas nous empêcher de dire « merci », sans nous attendre à ce que la machine comprenne, mais parce que nous voulons toujours être un être humain chaleureux.

# Bienvenue pour suivre le compte public officiel WeChat d'aifaner : aifaner (WeChat ID : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo