Éclatement! Le père de ChatGPT a averti que l’IA pourrait exterminer des êtres humains, 350 autorités de l’IA ont signé une lettre ouverte conjointe

Aujourd'hui, une importante lettre ouverte est sortie dans le domaine de l'IA.

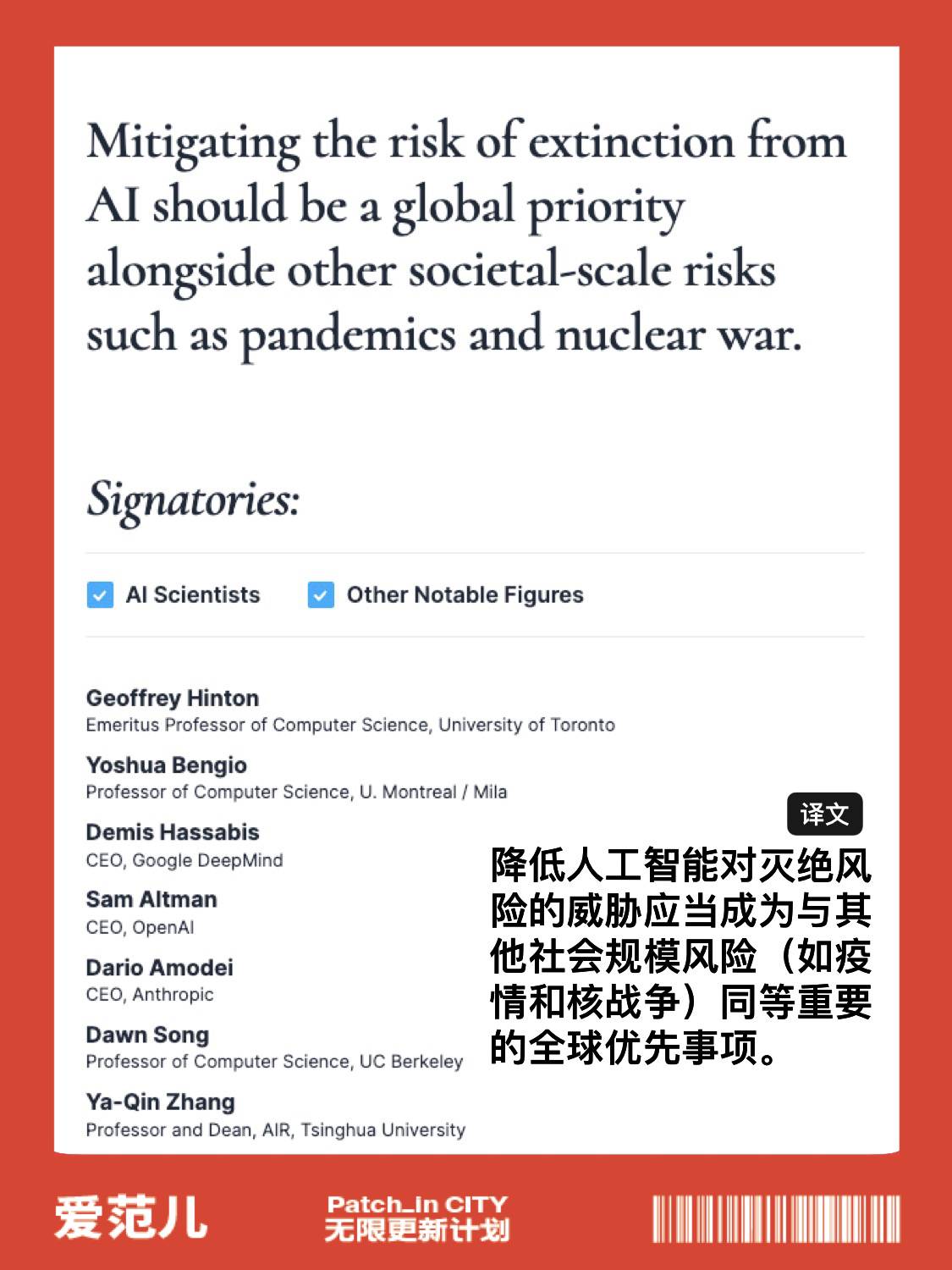

350 autorités de l'IA, dont le "père de ChatGPT" Sam Altman, ont signé la lettre ouverte conjointe et ont exprimé leur inquiétude quant au fait que la technologie de l'IA actuellement en cours de développement puisse constituer une menace existentielle pour les humains.

La lettre ne contenait qu'une seule déclaration : la réduction du risque d'extinction de l'IA devrait être une priorité mondiale avec d'autres risques à l'échelle de la société tels que les pandémies et la guerre nucléaire.

Joignez-vous à la signature de la lettre ouverte

https://www.safe.ai/statement-on-ai-risk

Les signataires comprennent trois dirigeants d'entreprises d'IA de premier plan :

- le PDG d'OpenAI, Sam Altman ;

- Demis Hassabis, PDG de Google DeepMind ;

- Dario Amodei, PDG d'Anthropic ;

Plus important encore, il y a deux "parrains" de l'intelligence artificielle, Geoffrey Hinton et Yoshua Bengio, sur la liste.

Plus de 350 cadres, chercheurs et ingénieurs travaillant sur l'intelligence artificielle ont signé la lettre ouverte émise par l'organisation à but non lucratif Artificial Intelligence Safety Center, arguant que l'intelligence artificielle présente un risque d'extinction humaine et doit être considérée comme liée aux épidémies. risque égal à une guerre nucléaire.

On s'inquiète de plus en plus de la menace potentielle pour la société et l'emploi que le développement de modèles d'intelligence artificielle tels que ChatGPT pourrait poser, beaucoup appelant à une réglementation plus stricte de l'industrie de l'IA, qui autrement causerait des dommages irréparables à la société.

L'IA continue de monter en flèche, mais les méthodes de supervision et d'audit pertinentes n'ont pas suivi, ce qui signifie que personne ne peut garantir la sécurité des outils d'IA et le processus d'utilisation des outils d'IA.

La semaine dernière, Sam Altman et deux autres dirigeants d'OpenAI ont proposé la création d'une organisation internationale telle que l'Agence internationale de l'énergie atomique pour superviser en toute sécurité le développement de l'IA, appelant les principaux fabricants internationaux d'intelligence artificielle à coopérer et demandant au gouvernement de renforcer le contrôle. des fabricants d'intelligence artificielle de pointe.

En fait, dès le mois de mars, une lettre ouverte sur l'arrêt de la recherche sur l'IA pendant 6 mois est devenue virale sur Internet.

La lettre appelait toutes les expériences d'IA à suspendre immédiatement les recherches sur des modèles d'IA plus avancés que GPT-4 pendant au moins 6 mois, afin de tuer ces terribles fantasmes dans leurs berceaux.

La vitesse de progression de l'IA est étonnante, mais les méthodes de supervision et d'audit pertinentes n'ont pas suivi, ce qui signifie que personne ne peut garantir la sécurité des outils d'IA et le processus d'utilisation des outils d'IA.

La lettre conjointe a reçu le soutien de nombreuses personnalités bien connues, dont le lauréat du prix Turing 2018 Yoshua Bengio, Musk, Steve Wozniak, co-fondateur de Skype, co-fondateur de Pinterest, PDG de Stability AI, etc., le nombre de co-signataires a atteint 1125 avant la date limite.

Le texte original de la lettre ouverte est le suivant :

L'intelligence artificielle a l'intelligence de rivaliser avec les êtres humains, ce qui peut entraîner des risques profonds pour la société et les êtres humains, ce qui a été confirmé par un grand nombre d'études [1] et reconnu par les meilleurs laboratoires d'IA [2]. Comme l'indiquent les principes d'Asilomar AI largement reconnus, l'IA avancée pourrait représenter une transformation majeure dans l'histoire de la vie sur Terre et, en tant que telle, devrait être planifiée et gérée avec une attention et des ressources proportionnées.

Malheureusement, même ces derniers mois, les laboratoires d'IA se sont enfermés dans une course effrénée pour développer et déployer des esprits numériques de plus en plus puissants que personne ne peut comprendre, prédire ou contrôler de manière fiable, même s'ils ne pouvaient pas le faire non plus.

Avec les systèmes d'IA modernes désormais compétitifs avec les humains dans les tâches courantes [3], nous devons nous demander :

- Devrions-nous permettre aux machines d'inonder nos canaux d'information, répandant de la propagande et des mensonges ?

- Doit-on automatiser tous les jobs, y compris ceux qui sont satisfaisants ?

- Devrions-nous développer des esprits non humains qui pourraient éventuellement nous dépasser et nous remplacer ?

- Doit-on risquer de déraper la civilisation ?

Ces décisions ne devraient pas être prises par des leaders technologiques non élus. Ce n'est que lorsque nous sommes convaincus que l'impact du système d'IA est positif et que les risques sont gérables que nous pouvons développer des systèmes d'IA puissants. Cette confiance doit être fondée et grandir avec l'impact potentiel du système. La récente déclaration d'OpenAI sur l'intelligence artificielle indique qu'"à un moment donné, il peut être nécessaire d'obtenir un examen indépendant avant de commencer la formation des futurs systèmes, et que les efforts de pointe acceptent de limiter le taux de croissance du calcul utilisé pour créer de nouveaux modèles." Nous sommes d'accord. C'est maintenant ce moment.

Par conséquent, nous appelons à un moratoire immédiat sur tous les laboratoires d'IA pendant au moins 6 mois à partir de la formation de systèmes d'IA plus puissants que GPT-4. Cette suspension doit être publique et vérifiable, et inclure tous les acteurs clés. Si un tel moratoire ne peut être mis en place rapidement, le gouvernement devrait intervenir et imposer un moratoire.

Les laboratoires d'IA et les experts indépendants devraient profiter de cette pause pour travailler ensemble afin de développer et de mettre en œuvre un ensemble partagé de protocoles de sécurité avancés de conception et de développement d'IA qui devraient être rigoureusement examinés et surveillés par des experts externes indépendants.

Ces protocoles devraient garantir que les systèmes qui y adhèrent sont sécurisés au-delà de tout doute raisonnable [4]. Cela ne signifie pas suspendre le développement de l'IA, mais simplement prendre du recul par rapport à la course toujours dangereuse vers des modèles de boîtes noires plus grands et imprévisibles et leurs capacités émergentes.

La recherche et le développement de l'IA devraient se concentrer sur l'amélioration de la précision, de la sécurité, de l'explicabilité, de la transparence, de la robustesse, de l'alignement, de la fiabilité et de la fidélité des systèmes robustes et avancés existants.

Dans le même temps, les développeurs d'IA doivent travailler avec les décideurs politiques pour accélérer considérablement le développement des systèmes de gouvernance de l'IA. Celles-ci doivent au minimum comprendre :

- Un nouvel organisme de réglementation compétent dédié à l'IA ;

- Supervision et suivi des systèmes d'IA à haute capacité et des grands pools de puissance de calcul ;

- Systèmes de provenance et de filigrane pour distinguer le contenu réel du contenu synthétique, suivre les fuites de modèles ;

- Écosystème d'audit et de certification robuste ; responsabilité pour les dommages causés par l'IA ;

- Financement public adéquat de la recherche technique sur la sécurité de l'IA ;

- Institution vétéran confrontée aux changements économiques et politiques massifs que l'IA entraînera, en particulier les implications pour les démocraties.

L'humanité peut profiter d'un avenir prospère avec l'aide de l'IA. Après avoir réussi à créer de puissants systèmes d'IA, nous pouvons désormais profiter d'un "été de l'IA" au cours duquel nous récoltons les fruits de l'utilisation explicite de ces systèmes pour le bénéfice de tous et donner à la société une chance de s'adapter.

La société a appuyé sur le bouton pause face à d'autres technologies qui pourraient avoir des effets catastrophiques sur la société [5]. Ici, nous pouvons faire la même chose. Profitons d'un long été d'IA au lieu de nous précipiter vers l'automne sans préparation.

#Bienvenue pour suivre le compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo