La fonctionnalité iOS 18 d’Apple peut changer la façon dont vous utilisez l’iPad

Il ne fait aucun doute que le nouvel iPad Pro reste la meilleure tablette pour lire, jouer, regarder des vidéos et dessiner. Mais avec l’ajout de la puce M4, du Magic Keyboard et de l’Apple Pencil Pro, l’iPad est plus proche que jamais d’un ordinateur portable.

Alors, l’iPad deviendra-t-il progressivement un MacBook doté de fonctionnalités tactiles dans le futur ?

La réponse est probablement non.

Dans le dernier iOS 18, Apple utilise cette « fonction d'accessibilité » pour prédire un nouvel avenir pour l'interaction sur iPad.

Eye Tracking : de Vision Pro à iPad

Récemment, Apple a annoncé la nouvelle fonctionnalité « eye tracking » ajoutée à son système d’exploitation iPadOS 18. Cette fonctionnalité apparemment discrète est placée en haut de la page d’introduction.

En parlant de suivi oculaire, beaucoup de gens pensent peut-être d'abord au Vision Pro précédemment publié par Apple. L'une des caractéristiques les plus importantes de cet appareil est qu'il utilise le suivi oculaire pour remplacer la poignée traditionnelle.

Les utilisateurs peuvent contrôler les applications, naviguer dans les menus et même jouer à des jeux en bougeant leurs yeux sans recourir au toucher ou à des appareils externes, ce qui améliore considérablement la commodité d'utilisation et démontre le charme de cette méthode interactive.

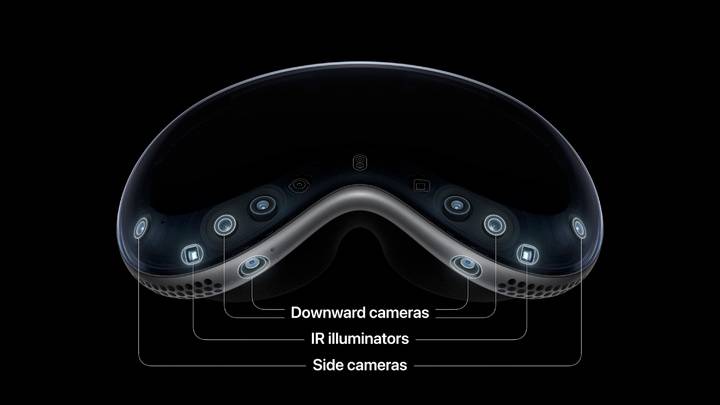

Cela est principalement dû à la conception de plusieurs caméras infrarouges et de doubles puces M2 et R1 distribuées dans Vision Pro, qui lui permettent d'utiliser la technologie de traitement d'image pour extraire des caractéristiques liées aux mouvements oculaires et réaliser un suivi des mouvements oculaires en construisant des modèles.

▲ Distribution de caméras Vision Pro, photos d'Apple

Un changement important dans la forme du nouvel iPad Pro sorti il n’y a pas si longtemps consiste à déplacer la caméra du côté étroit vers le côté long.

Le projecteur matriciel, l'élément capteur de projecteur, la caméra frontale et la caméra infrarouge du module caméra sont associés à la nouvelle puce M4, qui semble désormais ouvrir la voie à des projets ultérieurs.

La description de la mise à jour montre également que la fonction de suivi oculaire d'Apple est entièrement implémentée par apprentissage automatique sur l'appareil, ce qui signifie qu'elle ne nécessite aucun matériel supplémentaire et peut être utilisée immédiatement sur tous les appareils exécutant iPadOS 18, ce qui le confirme.

▲ Photo du blogueur Bilibili : Micro-ordinateur WekiHome

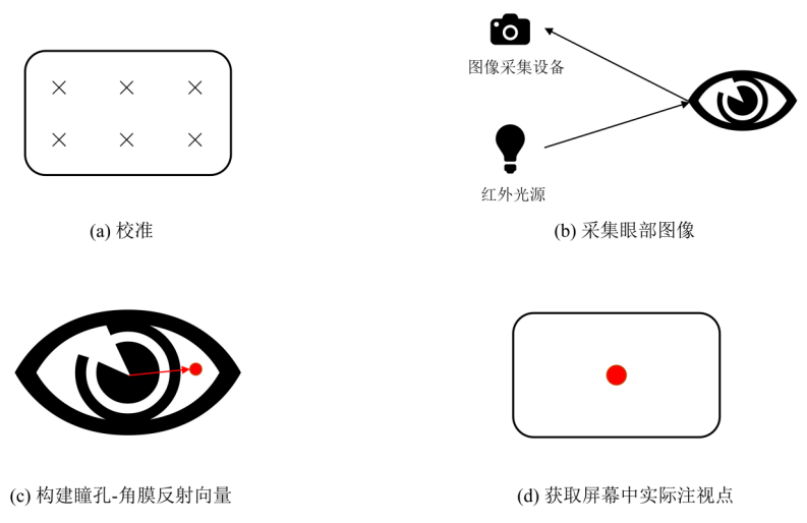

Actuellement, les méthodes de suivi oculaire reconnues par l’industrie comprennent le suivi oculaire basé sur l’apparence et le suivi oculaire basé sur la cartographie bidimensionnelle.

Le premier utilise principalement des images de visage ou des images d’yeux comme entrée pour l’extraction de caractéristiques, puis associe ces caractéristiques à la direction du regard grâce à l’apprentissage automatique. Cette méthode est simple et ne nécessite qu'une caméra, mais elle nécessite beaucoup de données d'entraînement pour construire un modèle précis permettant d'interpréter correctement la direction de votre regard.

Une autre méthode de suivi oculaire basée sur la cartographie binaire détermine principalement le mouvement oculaire en analysant les changements de position relative du globe oculaire et la réflexion cornéenne.

Étant donné que la position du point de réflexion cornéen ne change pas lorsque le globe oculaire bouge, elle peut être utilisée comme point de référence pour le mouvement de la pupille, et la direction de réalisation est calculée sur la base des changements dans les positions relatives des deux.

Pendant l'étalonnage, vous devez regarder des points spécifiques sur l'écran, et le système enregistrera ces points ainsi que vos données oculaires pour créer un modèle de cartographie. Ensuite, lorsque vous regardez ailleurs, le système peut utiliser ce modèle pour savoir exactement où vous cherchez.

▲ Diagramme schématique de la méthode vectorielle de réflexion pupillaire-cornéenne, image tirée d'Internet

En fait, il semble désormais que le principe de l’eye tracking ne soit pas très compliqué et que les conditions matérielles existantes soient suffisantes pour répondre aux besoins. Mais en fait, Apple a suivi un long processus pour parvenir à cette fonction.

La dernière étape de nombreuses années de planification

Il y a déjà de nombreuses années, Apple a commencé à déployer des talents et des technologies liés aux réseaux dans le domaine de l'oculométrie.

En 2013, Apple a acquis PrimeSense auprès d'Israël, qui prenait en charge la technologie de contrôle de mouvement de Microsoft pour le Kinect de Xbox.

▲ Photo de groupe des fondateurs de PrimeSense

Cette société a lancé une très petite caméra 3D appelée Capri qui peut être intégrée aux téléphones mobiles, tablettes et autres appareils. Voici ce que PimeSense a présenté au Google I/O 2013 :

▲ Capri est installé sur la tablette Google Nexus

▲ Capri effectue une modélisation 3D de scènes réelles et obtient des données spécifiques telles que la longueur, la largeur et la hauteur des objets de la scène

▲ Utilisez la technologie AR pour simuler les informations de collision de chaises dans l'espace réel

▲Transférez l'image 3D vers l'imprimante 3D pour terminer l'impression 3D

Ce qui était alors connu comme « la plus petite puce de détection 3D au monde » a également été lancé. En raison de ses bonnes performances et de sa taille compacte, elle peut être déployée sur de nombreux appareils électroniques tels que les téléphones mobiles et les téléviseurs.

En 2017, Apple a acquis SensoMotoric Instruments, une entreprise allemande spécialisée dans la technologie de suivi oculaire. Elle était autrefois le plus grand fabricant mondial d'équipements de suivi oculaire.

S'appuyant sur la série de matériels et de logiciels de suivi oculaire apportés par "Money Capacité", Apple a utilisé les fonctions de suivi oculaire dans son Face ID pour la première fois la même année pour améliorer la sécurité du déverrouillage.

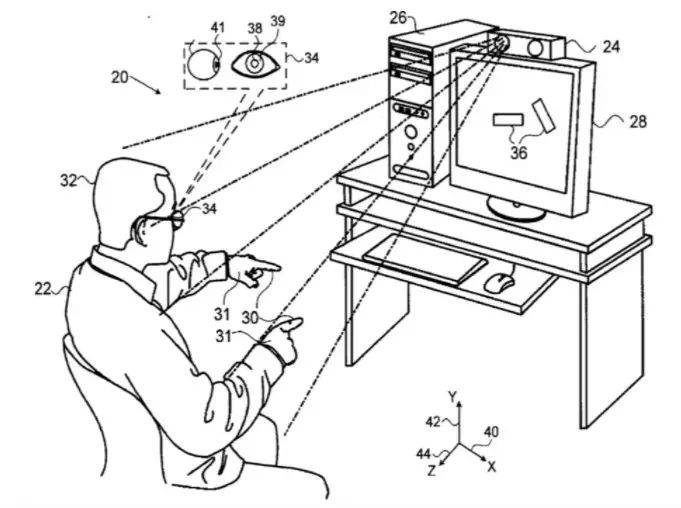

Au cours des années suivantes, les demandes de brevet d'Apple liées au suivi oculaire ont continué à fuir, et Apple a également continué à explorer. Cela a non seulement contribué à la méthode d'interaction basée sur le suivi oculaire de Vision Pro, mais a également donné lieu à des recherches sans fin sur le suivi oculaire sur d'autres. Appareils Apple possibles.

▲ Premier contenu de brevet sur le suivi oculaire et la « détection de l'attention »

L'avenir du suivi oculaire

Par rapport aux méthodes d’interaction traditionnelles (souris, clavier, tactile, etc.), l’eye tracking présente plusieurs avantages :

- Naturel et intuitif : le suivi oculaire utilise le mouvement naturel de l’œil humain pour l’interaction et ne nécessite aucun équipement d’exploitation supplémentaire. Les utilisateurs n'ont qu'à regarder la cible pour effectuer l'opération correspondante, ce qui réduit le coût d'apprentissage et rend l'interaction plus intuitive.

- Améliorer l'efficacité : les muscles oculaires sont l'un des muscles les plus réactifs du corps humain. Grâce au suivi oculaire, les utilisateurs peuvent sélectionner et contrôler les éléments de l'interface plus rapidement, réduire les mouvements de la main et améliorer la vitesse et l'efficacité des opérations.

- Combiné avec d'autres méthodes de saisie : le suivi oculaire peut être combiné avec d'autres méthodes de saisie, telles que la commande vocale et les opérations gestuelles, pour fournir des méthodes d'interaction plus riches et plus flexibles.

- Multitâche : les utilisateurs peuvent uniquement utiliser le contrôle de suivi oculaire sans mouvements inutiles lorsqu'ils effectuent d'autres tâches (telles que conduire ou marcher) ou gérer plusieurs tâches en même temps, améliorant ainsi l'efficacité opérationnelle.

- Analyse et personnalisation des données : le suivi oculaire peut fournir des données précieuses sur l'attention et les intérêts des utilisateurs. Ces données peuvent être utilisées pour optimiser la conception de l'interface, la diffusion de la publicité et la personnalisation de l'expérience utilisateur, rendant ainsi le système plus intelligent et plus convivial.

- Réalité augmentée (AR) : dans un environnement AR, le suivi oculaire peut offrir une expérience interactive plus immersive et naturelle. Les utilisateurs peuvent sélectionner et utiliser des objets virtuels en les regardant, améliorant ainsi l'expérience utilisateur.

C’est précisément grâce à ces avantages qu’il a montré un grand potentiel dans de nombreux scénarios spécifiques.

Par exemple, dans de nombreux jeux, en plus d'apporter des opérations plus pratiques, le suivi oculaire apportera également un meilleur sentiment d'immersion aux joueurs, leur permettant de contrôler et d'interagir avec les personnages du jeu simplement grâce à leur mise en œuvre.

▲ Utilisez le suivi oculaire pour contrôler le jeu, les images d'Internet

De plus, après avoir implémenté la fonction de suivi oculaire, les développeurs peuvent également ajuster de nombreux paramètres tels que l'éclairage de la scène et les changements de perspective en fonction des données de mouvement oculaire pour s'adapter aux habitudes visuelles personnelles de l'utilisateur et rendre l'écran de jeu plus réaliste.

L'interaction sociale dans le jeu peut également utiliser des personnages virtuels pour réaliser divers états d'action qui changent en temps réel avec le visage du joueur, tels que la direction, le clignement des yeux, le plissement des yeux, etc., enrichissant l'expression émotionnelle du personnage et améliorant l'immersion du jeu de tous. aspects.

En plus des jeux, les changements que cette technologie apportera à la vie quotidienne méritent peut-être d’être attendus avec impatience.

Après la sortie de Vision Pro, un scénario d'application important est celui de l'éducation, de la médecine et d'autres scénarios. Il ne fait aucun doute que cela s'applique également à l'iPad qui implémente le suivi oculaire.

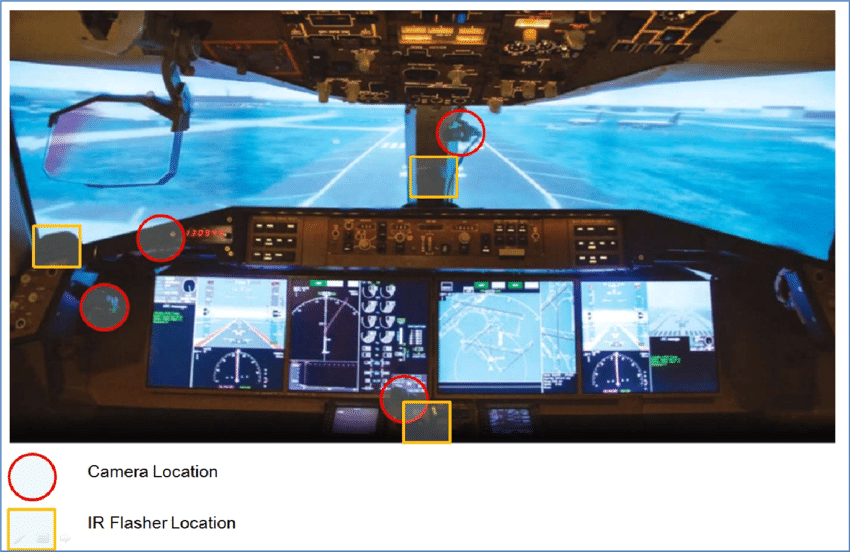

Dans les domaines de formation professionnelle tels que la formation par simulation pilote et la simulation chirurgicale, les mouvements oculaires des étudiants sont suivis pour évaluer la rapidité et la précision de la prise de décision.

L’oculométrie peut fournir aux enseignants des informations en temps réel sur la concentration et la compréhension des élèves pendant l’apprentissage, les aidant ainsi à définir des stratégies d’enseignement personnalisées et à améliorer le contenu des cours.

▲ Équipement de suivi oculaire installé sur le matériel pédagogique de simulation de conduite en vol

Il existe également certains scénarios très adaptés à l'interaction de suivi oculaire, comme l'environnement domestique. Grâce au suivi oculaire, l'iPad peut devenir une console centrale intelligente pour contrôler la maison ou offrir une meilleure expérience interactive lorsqu'il y a d'autres choses à portée de main ou que les mains sont sales.

Bien que le potentiel d’application du suivi oculaire soit énorme, certaines personnes du secteur ont remis en question la sécurité de cette technologie.

Les données montrent que les données oculaires d'une personne impliqueront diverses informations telles que l'âge, le sexe, la race, l'état émotionnel, les traits de personnalité de l'utilisateur, etc.

John Villasenor, fondateur et codirecteur de l'Institut de technologie, de droit et de politique de l'UCLA, a déclaré :

Une fois que la technologie de suivi oculaire aura mûri, elle collectera encore plus d’informations : ce que nous lisons en ligne et même la manière dont nous le lisons. Par exemple, avons-nous vu une publicité sur une page Web, y avons-nous réfléchi pendant un moment et avons-nous finalement échoué à cliquer dessus ? Comment nos yeux bougent-ils lorsque nous lisons l’intégralité d’une page Web ? Quels mots, expressions ou thèmes préférons-nous ou évitons-nous ? À l’avenir, les publicités affichées devant nous dépendront-elles non seulement de ce que nous avons acheté, mais aussi de l’état de mouvement de nos globes oculaires ?

▲ John Villasenor, professeur de génie électrique à UCLA

Évidemment, si nous pouvons comprendre la durée du regard et les préférences de mise au point de l'utilisateur, combinées à des données provenant de plusieurs dimensions telles que la taille de la pupille et les saccades, il sera sans doute plus précis de « deviner ce que vous aimez » avec plus de précision, et la difficulté de confidentialité la protection sera également immédiatement améliorée.

À cet égard, la réponse d’Apple est de placer toutes les captures et interprétations sur l’appareil, sans avoir besoin d’autres matériels externes, tels que des lunettes spécialement conçues pour capturer les données de mouvements oculaires, et Apple ne peut rien voir capturé par le contenu de la caméra.

Cependant, dans le contexte actuel où les utilisateurs accordent de plus en plus d'attention à la confidentialité et à la sécurité, et où des fuites d'informations se produisent toujours de temps en temps, il peut encore être difficile de résoudre les préoccupations des utilisateurs, et cela peut également devenir un facteur important qui rend il est difficile de mettre en œuvre des fonctions de suivi oculaire.

▲ Tobii Pro Glasses 2 spécialement utilisées pour capturer les données de mouvements oculaires, photo de Tobii

En outre, il existe un problème plus important : comment garantir que le suivi oculaire fonctionne de manière stable et précise dans différents environnements et puisse être adapté aux personnes qui portent des lunettes ou qui ont des caractéristiques oculaires particulières, etc.

Et comme les yeux des gens bougent souvent très rapidement, les mouvements sont souvent irréguliers ou saccadés, ce qui constitue également un problème important que l'oculométrie doit résoudre.

En réponse à ce problème, Apple pourrait utiliser l’IA pour le résoudre.

Sterling Crispin, un ancien employé d'Apple responsable du développement de Vision Pro, a déclaré un jour sur Twitter qu'Apple utilise beaucoup les neurosciences pour développer certaines de ses fonctionnalités clés, telles que l'utilisation de l'IA pour prédire les comportements opérationnels des utilisateurs :

Le modèle d'IA tente de prédire si vous êtes curieux, distrait, effrayé, concentré, si vous vous souvenez d'expériences passées ou d'autres états cognitifs. Ceux-ci peuvent être déduits grâce à des mesures de suivi oculaire.

Il a également déclaré que cela était dû principalement à :

Vos élèves réagissent avant que vous cliquiez, en partie parce que vous anticipez que quelque chose se produira après avoir cliqué. Par conséquent, un biofeedback avec le cerveau de l'utilisateur peut être créé en détectant le comportement oculaire de l'utilisateur et en essayant de repenser l'interface utilisateur pour créer davantage de cette réponse attendue de l'élève.

Il a également déclaré avec enthousiasme que ce type de rétroaction de suivi oculaire qui intègre des algorithmes d'IA et des commentaires en temps réel en fait une « interface cerveau-ordinateur brute », ce qui est très cool.

Extension des fonctionnalités de l'iPad et refonte de son statut

Bien sûr, la description de l’oculométrie devenant une « interface cerveau-ordinateur » peut être légèrement exagérée, mais ce qui ne peut être caché, c’est son potentiel à étendre les méthodes d’interaction.

L'iPad avait de grands espoirs à sa naissance, mais il est toujours considéré par de nombreuses personnes comme un « iQiyi post-achat ». La raison fondamentale réside dans le manque d'interaction.

À cet égard, Apple a en fait fait beaucoup d'efforts, comme l'ajout de l'Apple Pencil et du Magic Keyboard, qui peuvent dans une certaine mesure être considérées comme une tentative d'Apple d'enrichir les méthodes d'interaction avec la tablette.

Cependant, ces efforts ne semblent pas avoir fondamentalement changé la situation embarrassante de l'iPad. Après tout, si vous souhaitez utiliser un clavier, pourquoi ne pas simplement choisir un MacBook ? Bien que l'Apple Pencil ait exploré le potentiel de la forme iPad dans le domaine professionnel, il est limité par le champ professionnel étroit et ne peut pas être la clé de la sauvegarde de l'iPad.

En outre, la découverte de nouvelles interactions à partir des « fonctions d'accessibilité » a toujours été un moyen important pour Apple d'exploiter le potentiel de ses produits et de proposer de nouvelles avancées.

Par exemple, la fonction double-clic de l'Apple Watch Series 9 permet de détecter les mouvements des doigts et de contrôler la montre sans la toucher. Elle a été bien accueillie par de nombreux utilisateurs après son lancement, mais elle a également été cachée dans le coin « auxiliaire ». toucher" pendant longtemps.

Les interactions très similaires au suivi oculaire sont en fait masquées dans la liste des « Fonctions d'accessibilité » d'Apple. Par exemple, dans les « Fonctions d'accessibilité » de nombreux ordinateurs Mac, le « Pointeur de contrôle de la tête » est apparu et les utilisateurs peuvent utiliser leur tête pour se déplacer. contrôler le mouvement du pointeur.

Avec la mise à jour d'iOS 18, il est également très probable que le suivi oculaire passera du coin de « Assistive Touch » au centre de la scène, et après un certain temps, il deviendra une fonctionnalité importante que vous utilisez quotidiennement. L'ère interactive de l'iPad.

Peut-être que le contrôle au doigt n’est pas seulement l’avenir de l’iPad.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo