La nuit la plus volumineuse ! La version Google de ChatGPT est ouverte, Nvidia a largué une carte graphique bombe nucléaire… Quand je me réveille, l’IA a encore changé

Le "moment iPhone" d'IA est arrivé

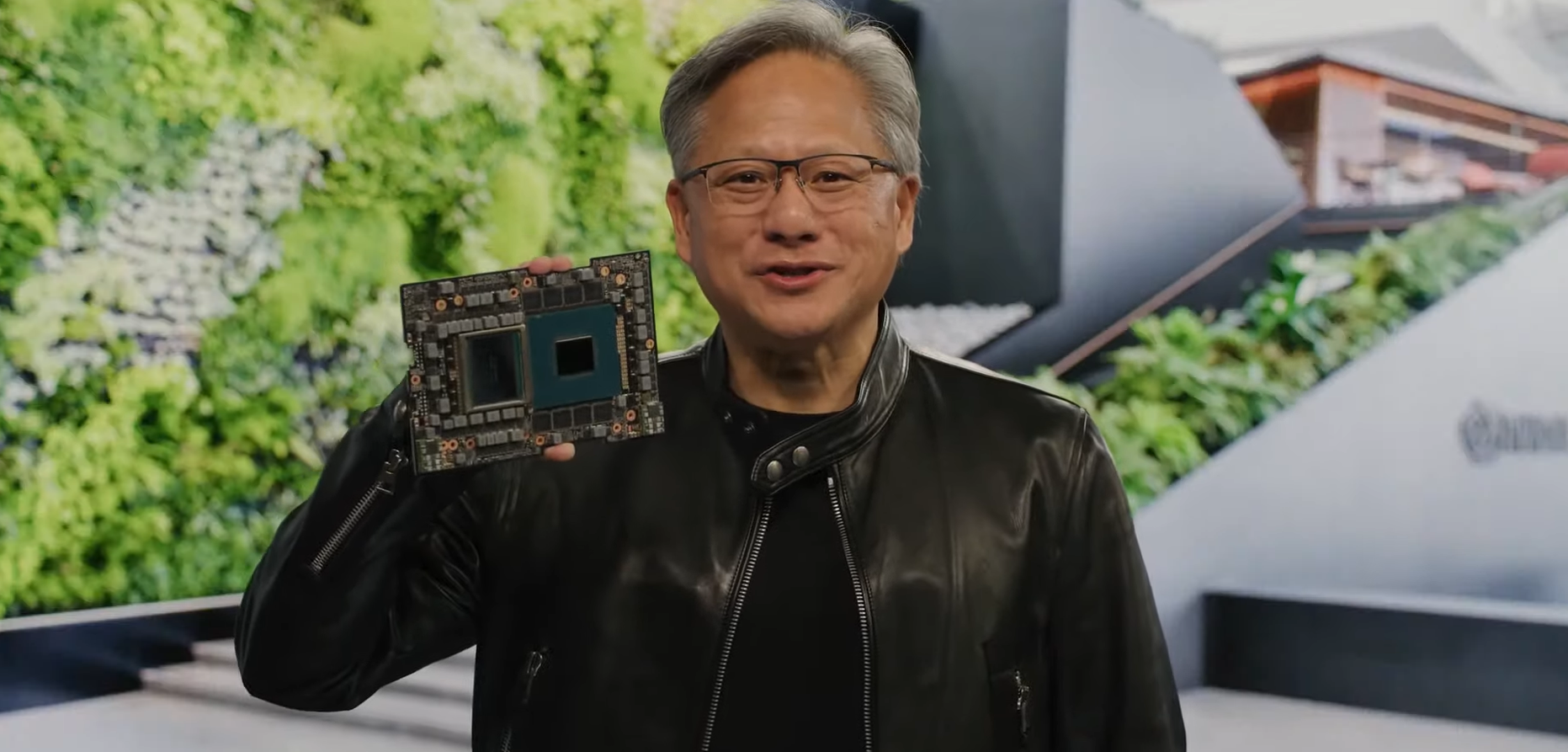

Lors de la conférence Nvidia GTC 2023 qui vient de se terminer, le PDG de Nvidia, Huang Renxun, a répété ce point de vue à trois reprises.

Comment comprendre?

La technologie d'écran multi-touch portée par l'iPhone a créé un tout nouveau mode d'interaction de l'interface du smartphone, qui a donné naissance à l'Internet mobile.

L'émergence de super applications d'IA telles que ChatGPT et Stable Diffusion marque la maturité de l'informatique accélérée et de la technologie de l'IA. L'IA pénètre dans tous les domaines de la vie à une vitesse sans précédent et favorise une nouvelle révolution industrielle.

Après le développement continu de la technologie de l'IA ces dernières années, une puissance de calcul puissante et des modèles avancés fournissent une plate-forme d'application appropriée pour l'IA, incitant divers fabricants à repenser leurs produits et leurs modèles commerciaux, ainsi que la vitesse des itérations de mise à jour.

Hier soir, Nvidia, Microsoft, Google, Adobe et d'autres constructeurs ont lancé leurs services d'IA respectifs quasiment en même temps, la tendance à se courir après semble véhiculer la même inquiétude :

"En cette ère de grande IA, si vous ne voulez pas être subverti par les autres, vous devez d'abord subvertir les autres."

Comment l'IA va-t-elle changer nos vies ? Après avoir regardé cette "Nuit la plus volumineuse d'AIGC", vous pouvez avoir un sentiment plus profond.

Nvidia apporte l'IA à tous les secteurs

Nvidia a apporté beaucoup de "nouvelles activités" accrocheuses à la conférence annuelle GTC.

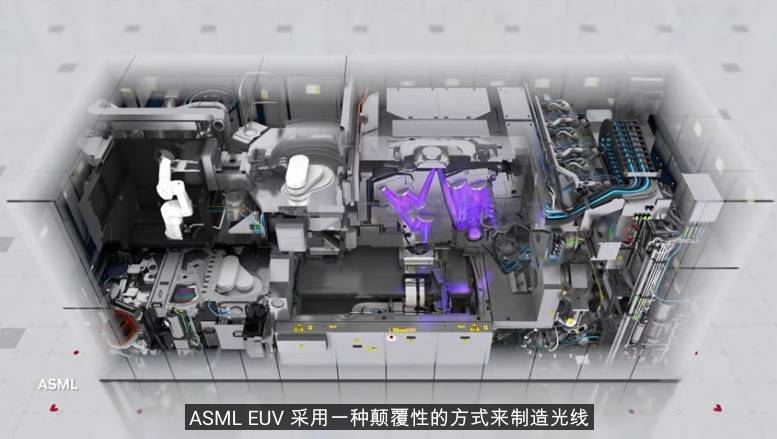

Par exemple, il a lancé une technologie de fabrication de noyau assistée par l'IA appelée CuLitho, qui a ouvert la voie au processus de 2 nm ; a coopéré avec des constructeurs automobiles tels que Lotus, Mercedes-Benz et BMW, et a utilisé Omniverse pour construire des lignes de production numériques.

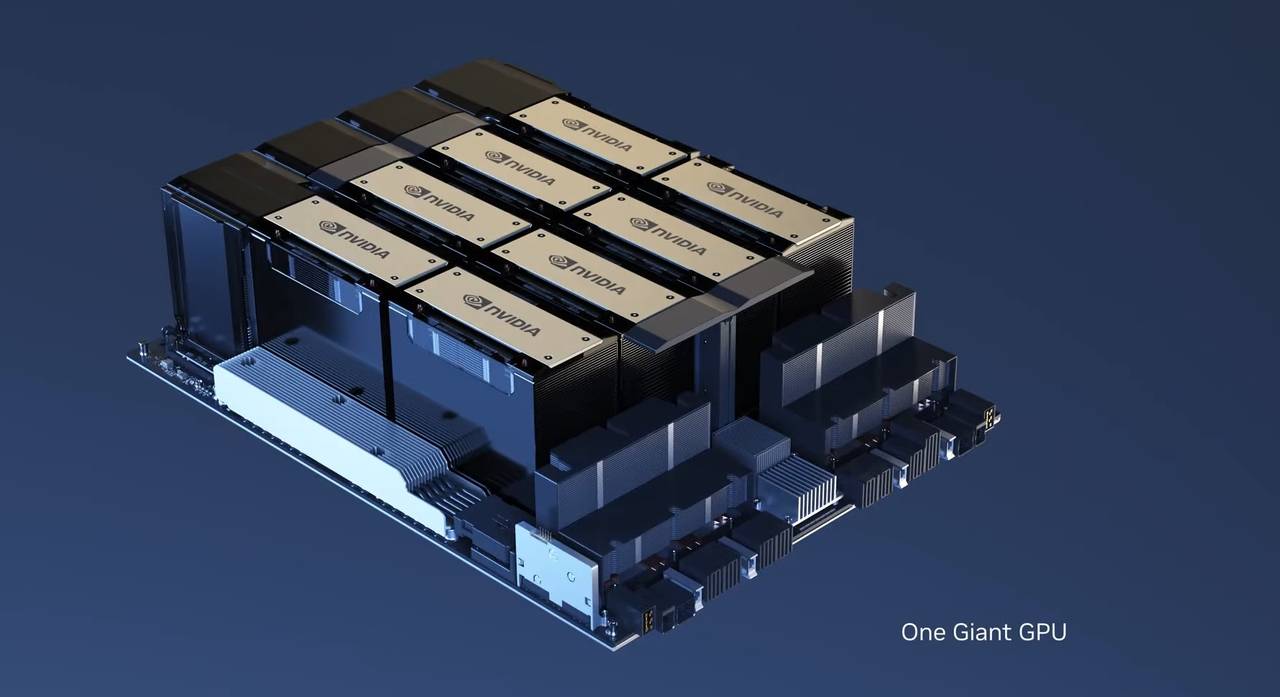

Mais en ce qui concerne le contenu le plus accrocheur de toute la conférence GTC, il doit s'agir de la nouvelle carte graphique publiée par Nvidia – la H100 NVL avec double GPU NVLink.

H100 NVL est une carte graphique spécialement conçue pour ChatGPT, qui nécessite une énorme puissance de calcul.H100 NVL dispose d'une mémoire HBM3 exagérée de 188 Go (94 Go par carte), qui est actuellement la plus grande carte mémoire publiée par Nvidia.

Un grand modèle de langage comme GPT consomme beaucoup de ressources mémoire. En théorie, un modèle GPT avec des centaines de milliards de paramètres peut rapidement remplir une carte graphique H100.

Comparé au HGX A100 pour le traitement GPT-3, un serveur standard utilisant quatre paires de H100 et NVLink à double GPU est 10 fois plus rapide, la "bombe nucléaire" H100 NVL est idéale pour le déploiement à grande échelle de modèles de langage comme ChatGPT.

Un autre gros travail de Nvidia est de déplacer le "ChatGPT même modèle" vers le cloud et de l'ouvrir au public.

Le fonctionnement de ChatGPT repose principalement sur le supercalculateur DGX composé de A100 ou H100. Microsoft a dépensé des centaines de millions de dollars pour acheter des dizaines de milliers de cartes graphiques A100 pour former la plateforme de cloud computing Azure.

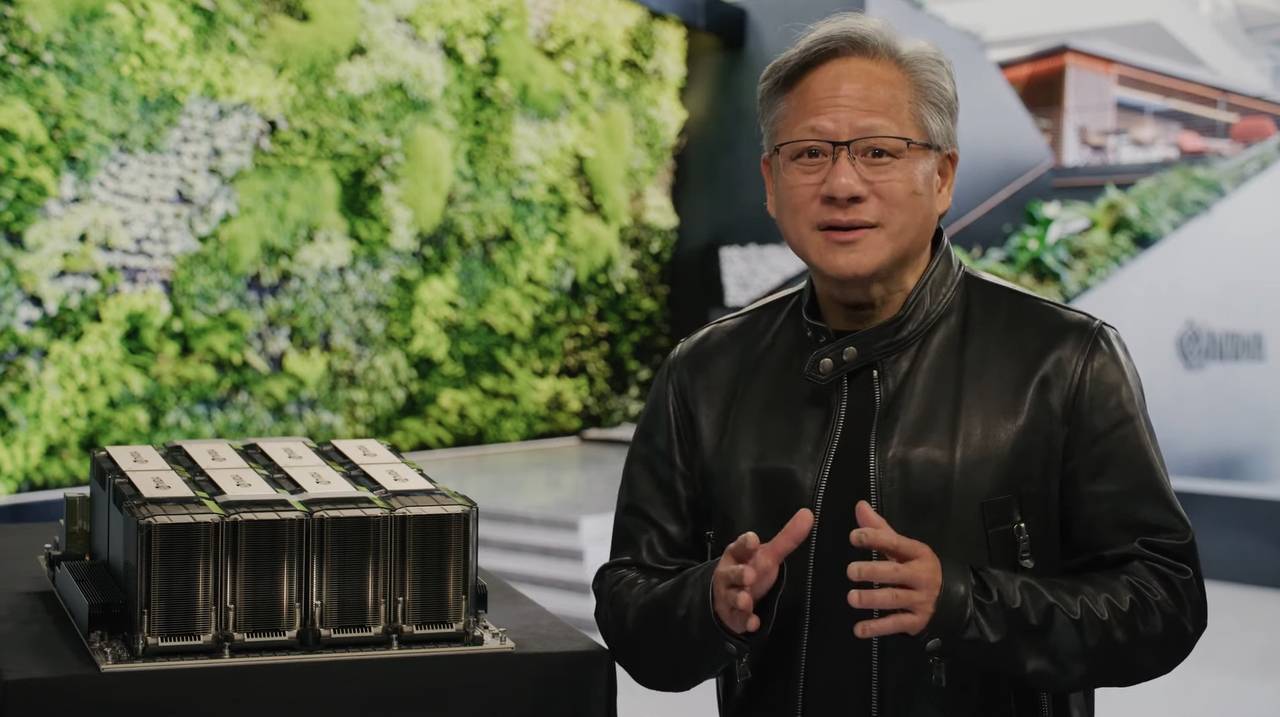

Afin de réduire le coût de déploiement de grands modèles pour les utilisateurs, Nvidia a lancé le service DXG Cloud.À partir de 36 999 $ par mois, vous pouvez obtenir un supercalculateur cloud composé de 8 cartes graphiques H100 ou A100 pour effectuer facilement des tâches de calcul à forte charge.

En 2016, Lao Huang a personnellement livré le premier superordinateur DGX à OpenAI. Sept ans plus tard, la plus grande puissance de calcul de l'IA a la possibilité d'entrer dans chaque entreprise via DXG Cloud, accomplissant des tâches qui étaient impossibles dans le passé.

Il n'est pas difficile d'imaginer que des applications avancées comme ChatGPT qui peuvent améliorer la communication humaine et l'efficacité du travail continueront à émerger, apportant plus de commodité et de surprises dans nos vies.

Toucher de la pierre à l'or, la deuxième génération de Runway vous permet de générer toutes sortes de films à succès en une seule phrase

Il y a toujours eu une tige populaire à la station B : les vidéos ne peuvent pas être publiées, c'est donc vrai. Mais maintenant, les vidéos peuvent non seulement être P, mais peuvent également être générées directement avec l'IA à partir de zéro, sans peintres, photographes ou post-traitement. Tant que vous entrez un paragraphe de texte dans Runway, il vous renverra une courte vidéo choquante.

Au départ, Runway était un outil auxiliaire de post-production, bien qu'il utilisait le pouvoir magique de l'intelligence artificielle, ce qu'il pouvait réaliser n'était pas compliqué : effacer des objets, interpoler des images, supprimer des arrière-plans, suivi de mouvement, etc. Plugin Premiere pour les nuls.

Et lorsque Runway a ouvert une nouvelle porte à l'intelligence artificielle, elle a la capacité de transformer des pierres en or. Dans la version Gen 1 annoncée en septembre dernier, il a la capacité de convertir du texte en vidéo. À l'époque, les gens venaient de voir la magie de la conversion texte-image, et Runway pouvait générer directement des images dynamiques, ce qui était aussi choquant qu'un coup de réduction de dimensionnalité.

Après six mois, Runway Gen 2 est là.

Comparé au modèle Gen 1, il atteint une cohérence et une fidélité temporelles supérieures.En termes humains, la connexion entre les images est plus fluide et la qualité de l'image est meilleure.

Avec Gen 2, vous êtes sur le point de générer des vidéos de votre imagination à tout moment, n'importe où.

Entrez un mot-clé pas trop long : montagnes photographiées par des drones. Sur cette base, Runway génère l'écran suivant.

En voici une autre : la lumière du soleil de l'après-midi qui traverse les fenêtres d'un appartement à New York.

Accédez à une version avancée, envoyez des images et du texte à Runway, puis générez une courte vidéo.

▲ Le texte est : Un homme marche dans la rue, et les néons des bars environnants l'éclairent

▲ Image d'origine

Ou animez une image statique.

Il est également possible de restituer directement une image dynamique à partir d'une animation non texturée à restituer.

Les progrès de Runway sont évidents pour tous. Il est allé de plus en plus loin et de manière plus fluide sur la route contre le modèle de réseau. La version Gen 2 d'aujourd'hui peut être considérée comme "regardable". Bien qu'elle ne soit pas exquise, l'avenir peut être attendu.

Peut-être qu'en ce qui concerne la version Gen 3, avec l'aide de celle-ci, nous pouvons générer de courtes vidéos à succès Douyin en un seul clic. Sera-ce à ce moment-là un cauchemar pour les blogueurs de qualité ?

Éclatement! Google commence les tests de Bard

Si Nvidia nous permet de voir l'avenir du développement de l'IA, alors Google's Bard est l'IA d'aujourd'hui.

Après que tout le monde ait été choqué par GPT-4 et Midjourney V5 pendant une semaine, alors que Lao Huang attendait avec impatience la future ère de l'IA, Google a annoncé l'ouverture officielle de l'accès de Bard : veuillez essayer Bard et donner votre avis.

Selon la dernière démo de Google, Bard ressemble plus à un assistant personnel axé sur le travail et les études qu'à ChatGPT. Avec son aide, vous pouvez stimuler les idées et satisfaire la curiosité.

Vous pouvez demander à Bard d'expliquer la physique quantique en langage simple, ou demander à Bard de réfléchir et de vous aider à lire 20 livres en un an.

Google a déclaré que les utilisateurs peuvent accélérer les idées et stimuler la curiosité avec l'aide de Bard. Vous pouvez utiliser Bard pour donner des conseils comme lire 20 livres par an ou expliquer la physique quantique en langage clair.

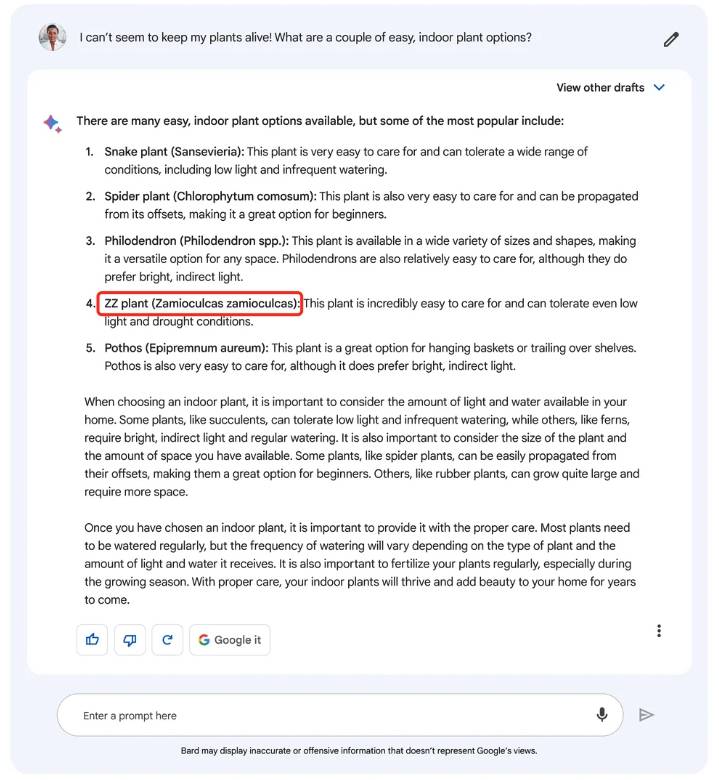

Nous avons également trouvé quelques détails dans le contenu de la démo. Bard semble générer plusieurs réponses en même temps. Vous pouvez choisir celle qui vous convient le mieux en fonction de vos besoins et continuer à poser des questions.

Bien sûr, ChatGPT peut également générer plusieurs réponses, mais il est régénéré une fois la réponse terminée.En comparaison, Bard ressemble plus à une partie B qui fournira plusieurs solutions en même temps.

Il se peut que les nouvelles négatives de ChatGPT et Bing Chat aient attiré l'attention de Google, qui souligne constamment que Bard n'est qu'une expérience, et les informations générées par Bard ne représentent pas le point de vue de Google.

Google a déclaré que bien que Bard soit alimenté par un grand modèle de langage et deviendra plus fort avec le temps, il apprendra certains préjugés ou stéréotypes, l'amenant à dire "avec confiance" des informations inexactes ou fausses, par exemple, il comprendra "ZZ Plant" comme Zamioculcas zamioculcas au lieu du Zamioculcas zamiifolia correct.

Fort des leçons tirées du "fou" de Bing Chat, la première version bêta de Bard limitait le nombre d'échanges dans une même conversation, de manière à garantir l'exactitude du contenu. Lorsque vous vous connectez pour la première fois à Bard, il vous indique qu'il s'agit d'une expérience et attend vos commentaires avec impatience.

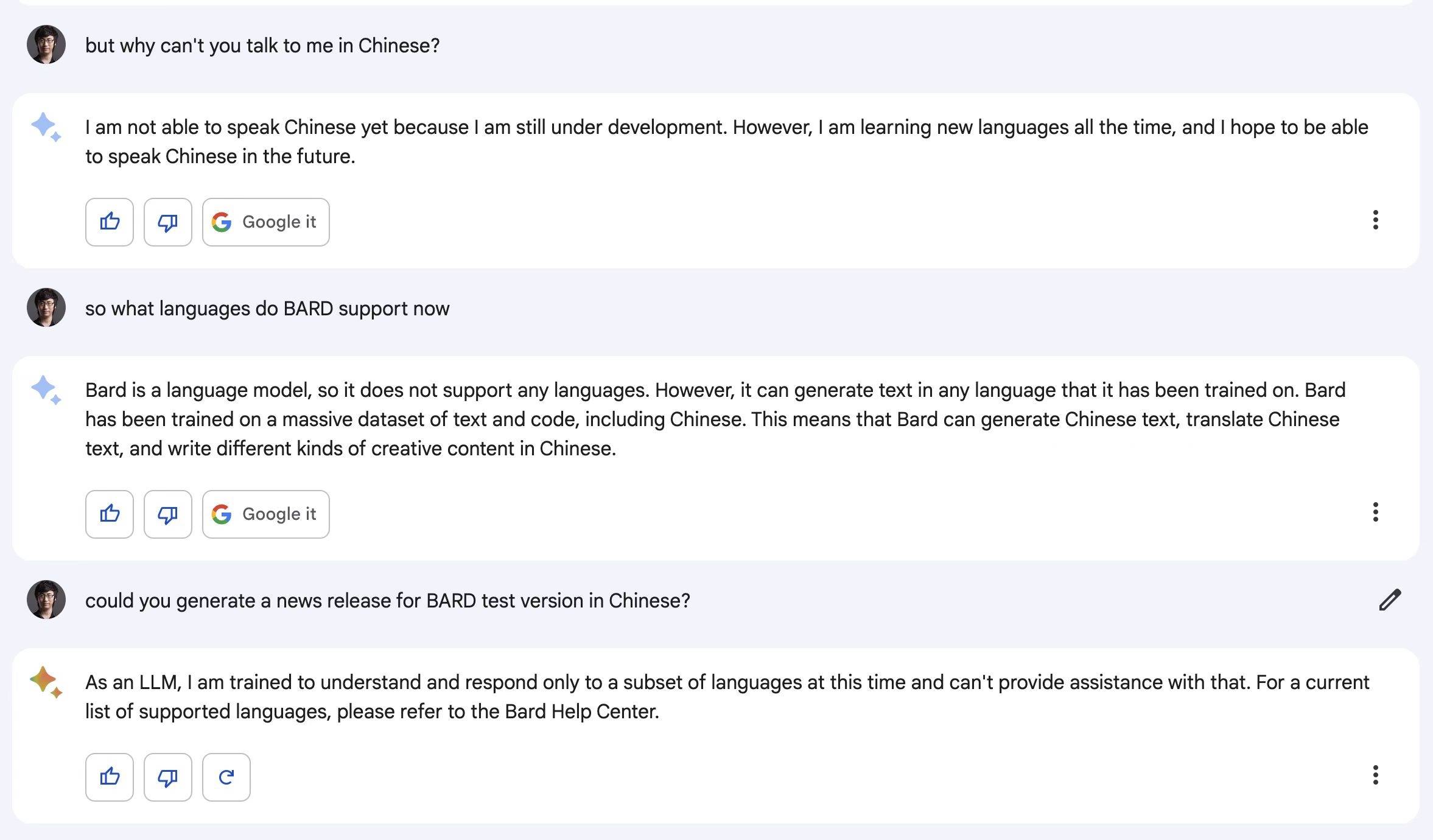

En tant que première version de Bard, il ne prend pas encore en charge plus de langues (y compris le chinois), et Google continuera à mettre à jour l'écriture de code, la reconnaissance/génération d'images et la prise en charge multilingue.

▲ Barde : Je ne connais pas le chinois, mais j'espère parler chinois à l'avenir

Actuellement, Bard n'est accessible qu'au Royaume-Uni et aux États-Unis, et s'étendra progressivement à d'autres pays et régions à l'avenir.

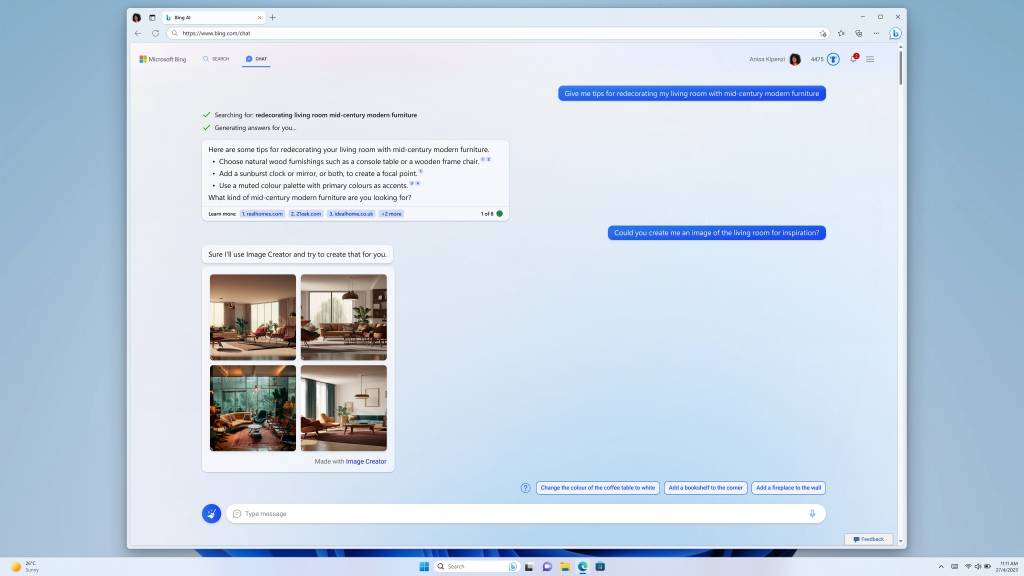

Vous pouvez faire des photos tout en discutant, Bing Chat va encore plus loin

À quel point Bing Chat est populaire, peut-être que seules les données que Bing DAU a dépassé 100 millions pour la première fois après son lancement peuvent expliquer. Qu'il s'agisse de questions complexes, de discussions divertissantes ou d'idées inspirées réalisées, Bing Chat remodèle la façon dont nous effectuons nos recherches sur le Web.

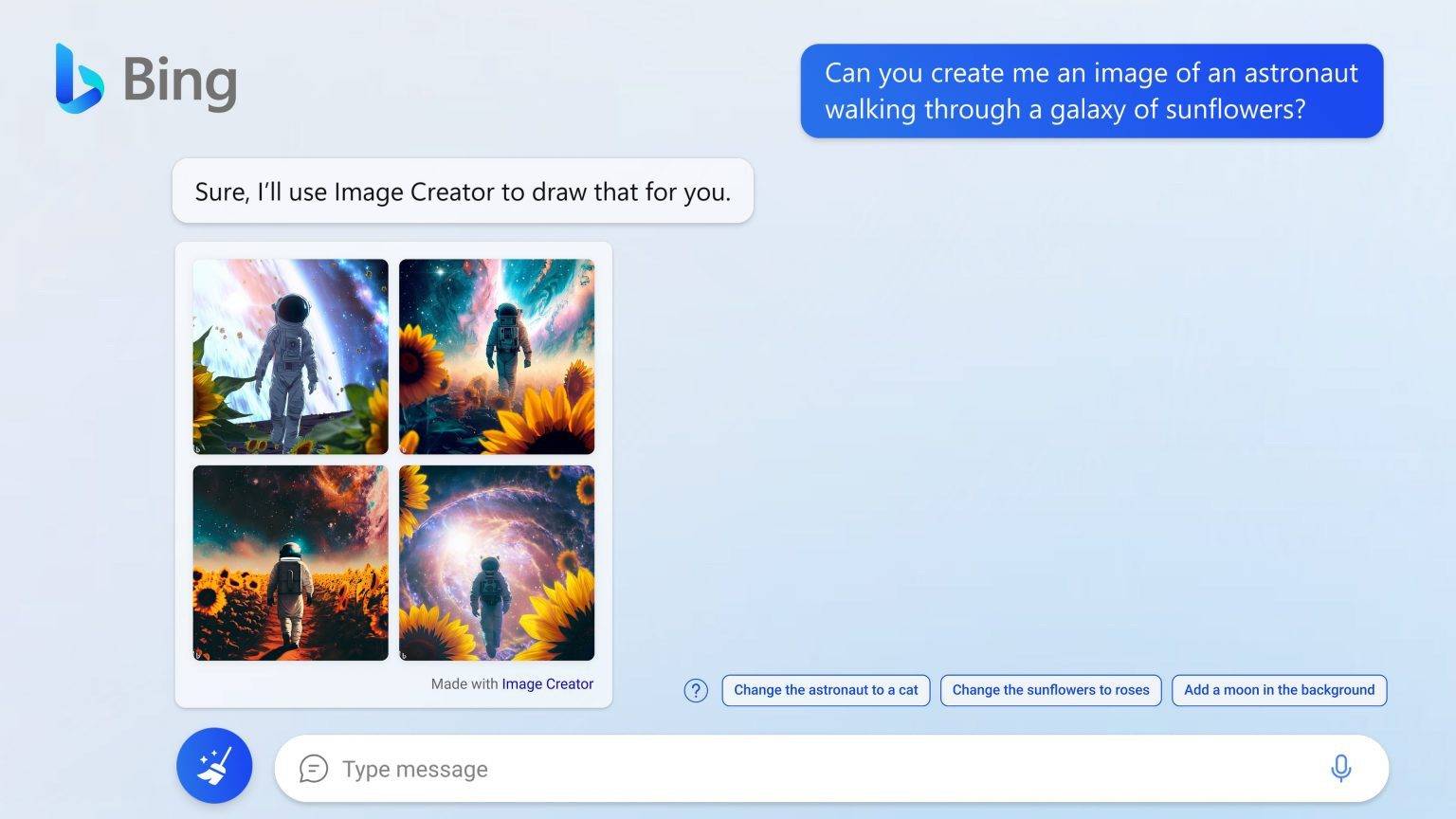

À partir de maintenant, vous pouvez demander à Bing Chat de dessiner des images.

Microsoft a mis à jour les versions de prévisualisation des nouveaux navigateurs Bing et Edge avec trois nouvelles fonctionnalités : Bing Image Creator, AI-driven Stories et Knowledge Cards 2.0. Le plus important d'entre eux est le Bing Image Creator qui peut dessiner des images.

Selon Microsoft, le cerveau humain traite les informations visuelles environ 60 000 fois plus rapidement que le texte. Dans les données de recherche de Bing, les images sont l'un des types les plus recherchés. Bing Image Creator, optimisé par une version avancée du modèle DALL·E, peut nous permettre utilisez notre propre langage pour décrire les informations d'image dans Bing Chat, sélectionnez le style artistique, et Image Creator connectera le contexte et "dessinera votre imagination sur papier".

L'ajout de Bing Image Creator fait du navigateur Edge le premier navigateur à intégrer un générateur d'images d'intelligence artificielle.

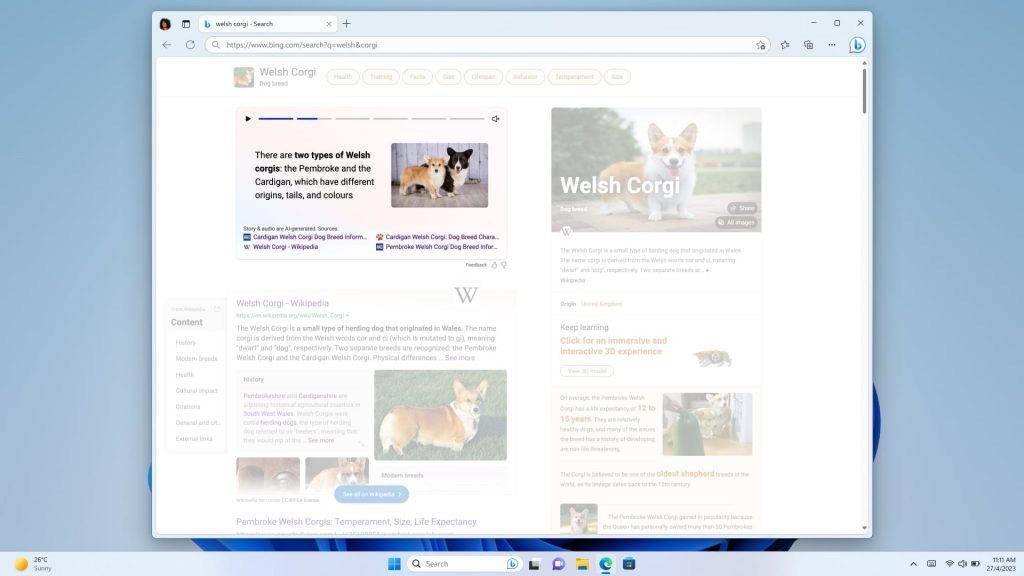

Les histoires et les cartes de connaissances 2.0 alimentées par l'intelligence artificielle vous permettent d'obtenir des images, de courtes vidéos et des infographies pilotées par l'intelligence artificielle après la recherche, et vous pouvez obtenir des faits et des informations clés en un coup d'œil.

Lorsque vous utiliserez Bing pour effectuer des recherches à l'avenir, vous n'obtiendrez pas des liens Web froids, mais des images, des vidéos et des histoires visuelles plus riches et plus intéressantes.

Si vous avez postulé via le nouveau Bing, vous pouvez désormais découvrir Bing Image Creator dans Bing Chat, et si vous entrez à partir de l'URL suivante, vous pouvez l'essayer directement.

https://www.bing.com/create

Cependant, cette fonctionnalité ne prend en charge que l'anglais pour le moment et continuera d'être mise à jour à l'avenir.

Adobe Firefly : "Le support le plus solide parmi les alliés"

Lorsque les entreprises technologiques se lancent dans la génération d'images, la célèbre société de design et de création Adobe n'est naturellement pas en reste. En cette folle nuit, Adobe a également lancé sa propre collection de modèles créatifs d'IA générative : Adobe Firefly.

Adobe a démontré les capacités de Firefly avec quelques exemples simples. Vous pouvez utiliser une phrase pour transformer le paysage du printemps en hiver.

Vous pouvez également utiliser un pinceau sur l'herbe pour peindre au hasard, puis dire à Firefly qu'il s'agit d'une rivière, et cela générera automatiquement une rivière.

Naturellement, Firefly peut faire plus que cela : sélectionner les poils d'un chien, il peut transformer les poils en brosse et aider le chien à changer de coiffure sur place ; concevoir un word art, il peut vous aider à générer un mot, une phrase ; concevoir un casque, Firefly peut aussi le mettre en scène et le transformer en présentoir de produit…

Adobe pense que l'IA offre une nouvelle façon d'ouvrir le monde et que les concepteurs peuvent utiliser le moyen le plus pratique de réaliser la créativité, "en aidant les créatifs plutôt qu'en les remplaçant".

Dans le même temps, Adobe a également créé la "Content Authenticity Initiative" CAI, qui a établi une norme mondiale pour l'attribution de contenu numérique de confiance, et a marqué le contenu généré par l'intelligence artificielle pour créer l'écosystème Firefly. "Le support le plus fort".

Attaque contre l'AIGC

Au cours de cette nuit, nous avons été témoins de plusieurs avancées majeures dans le domaine de l'IA, de la couche service à la couche application.

Ces mises à jour groupées prouvent d'un côté que le domaine de l'IA est entré dans une phase de développement rapide. Le mois dernier, l'IA pourrait ne pas être capable de bien dessiner les doigts.Le mois prochain, avec l'augmentation de la puissance de calcul et les mises à niveau des modèles, l'IA peut déjà remplacer le travail des modèles vestimentaires.

D'innombrables travaux de science-fiction ont prédit que l'IA ferait partie de nos vies à l'avenir, mais personne ne nous a dit que nous ne sommes qu'à quelques mètres de cet avenir.

Nos vies sont réécrites petit à petit par l'IA. Lors de la conférence GTC, Huang Renxun a présenté un point de vue intéressant. Il pense que l'IA générative est un nouveau type d'ordinateur. Nous pouvons programmer en langage humain et n'importe qui peut commander l'ordinateur pour résoudre des problèmes.

Au cours des derniers mois, nous avons été témoins de la façon dont l'IA a progressivement maîtrisé des compétences telles que le dessin, l'écriture, l'édition, la tabulation et le PPT. Si cette vitesse d'évolution se poursuit, y a-t-il quelque chose que l'IA ne peut pas faire ?

Le PDG d'OpenAI, Sam Altman, a récemment prédit avec audace une nouvelle version de la "loi de Moore" sur Twitter, estimant que la quantité de calculs d'intelligence artificielle dans le monde doublera tous les 18 mois.

En d'autres termes, si vous avez encore des doutes sur l'IA générative, le temps vous donnera la réponse la plus puissante.

#Bienvenue pour prêter attention au compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo