La première étape du métaverse pour les gens ordinaires, qui est le guide ?

Pour les cinéphiles, la capture faciale est un concept à la fois familier et inconnu. Il est familier car la capture de mouvement et la capture faciale sont des technologies couramment utilisées dans les films magiques. De nombreux personnages non humains classiques s'appuient sur ces deux technologies pour compléter. de. C'est le progrès technologique qui nous permet d'assister à la magnifique Terre du Milieu et à ses diverses races dans "Le Seigneur des Anneaux", aux merveilles extraterrestres dans "Avatar" et à la connexion entre les humains et les autres espèces à l'écran.

C'est peu familier car pour la plupart des gens, la capture faciale est une technologie qui a été entendue mais pas expérimentée. Nous avons été spectateurs de cette technologie plutôt que témoins.

Mais la courbe du progrès technologique a souvent deux branches, l'une qui avance et qui va plus loin, l'autre qui descend, du coût élevé au coût faible, d'affecter quelques personnes à bénéficier à des millions de personnes. Parfois, les deux fils vont aussi de pair et s'entrelacent pour créer une plus grande énergie.

Faire de la capture faciale dans le métaverse, c'est dur

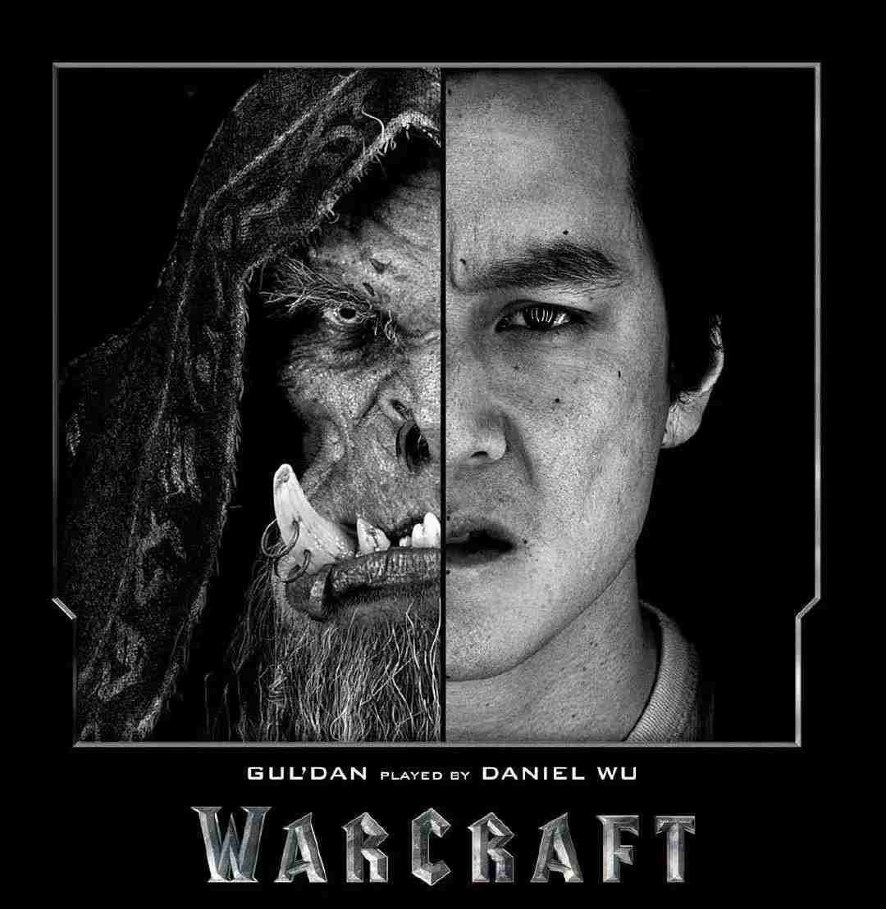

Dans le film "Warcraft" de 2016, s'appuyant sur la capture de mouvement et la capture faciale, le candidat de l'herbe asiatique Wu Yanzu a joué l'orc laid et maléfique Gul'dan dans le film.

Dans le domaine de la capture de mouvement et de la capture faciale, il y a même une superstar nommée Andy Serkis, qui a joué le personnage clé Gollum dans la trilogie "Le Seigneur des Anneaux", et le protagoniste de la trilogie "Rise of the Planet of the Apes" Gorille César.

▲ Démo Metaverse lancée par Microsoft l'année dernière

Les films sont le monde virtuel hors duquel nous vivons, et le métaverse est le monde virtuel dans lequel nous pourrons vivre à l'avenir. Cependant, les utilisateurs qui ont essayé les applications Metaverse VR ont peut-être déjà réalisé que le "je" ici est loin du vrai "je". La modélisation ici est grossière, et il est même impossible de cartographier les jambes de l'utilisateur au début. , sans oublier la richesse des expressions des utilisateurs.

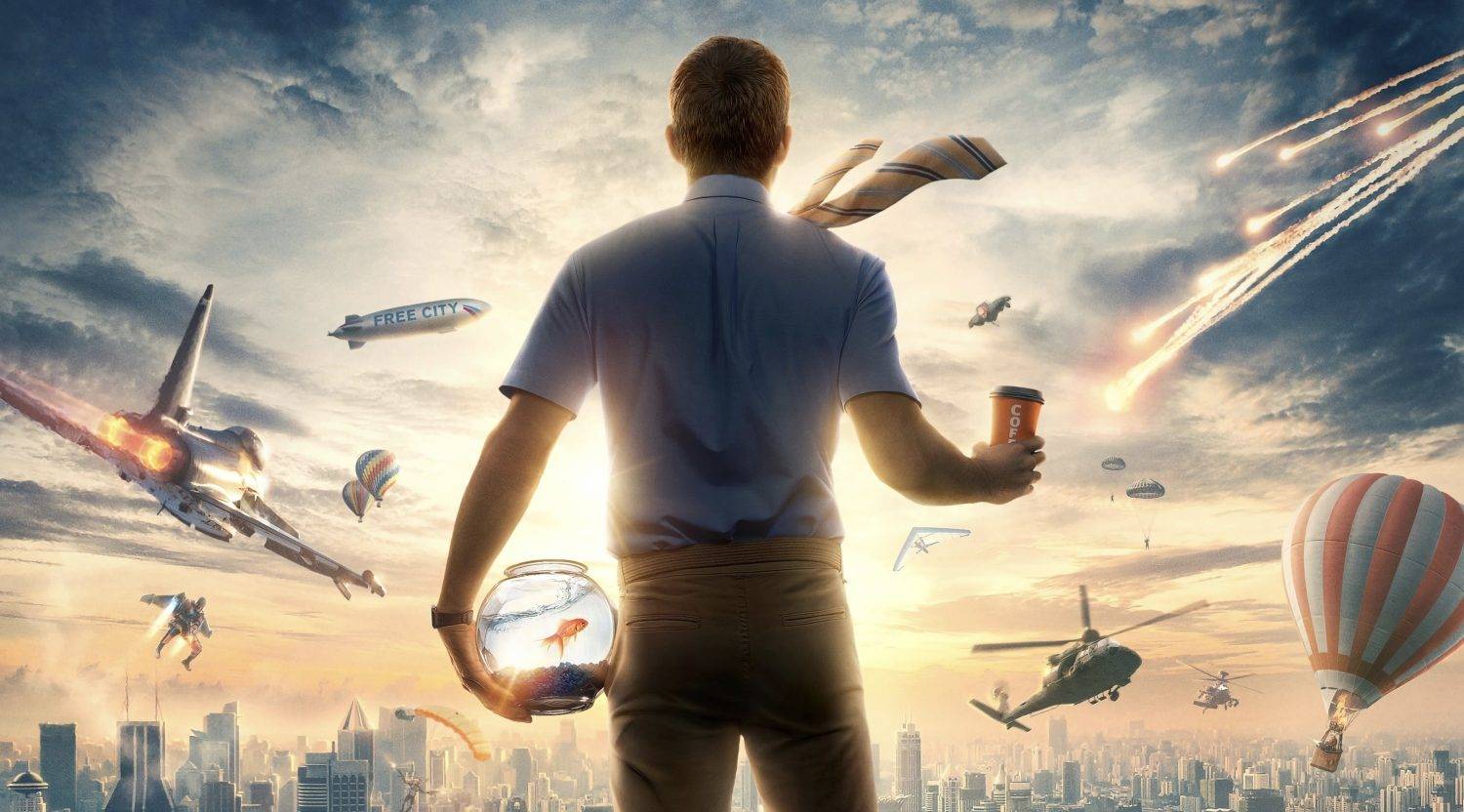

Par conséquent, parfois, en tant qu'adopteur précoce, j'envie la technologie de capture faciale dans les performances cinématographiques et j'espère que dans le métaverse, je ne serai pas le méchant du dessin animé comme un spectacle QQ, mais que je pourrai voyager à travers le continent de la Terre du Milieu, Azeroth fantasmes du monde du Sri Lanka ou de la planète Pandora.

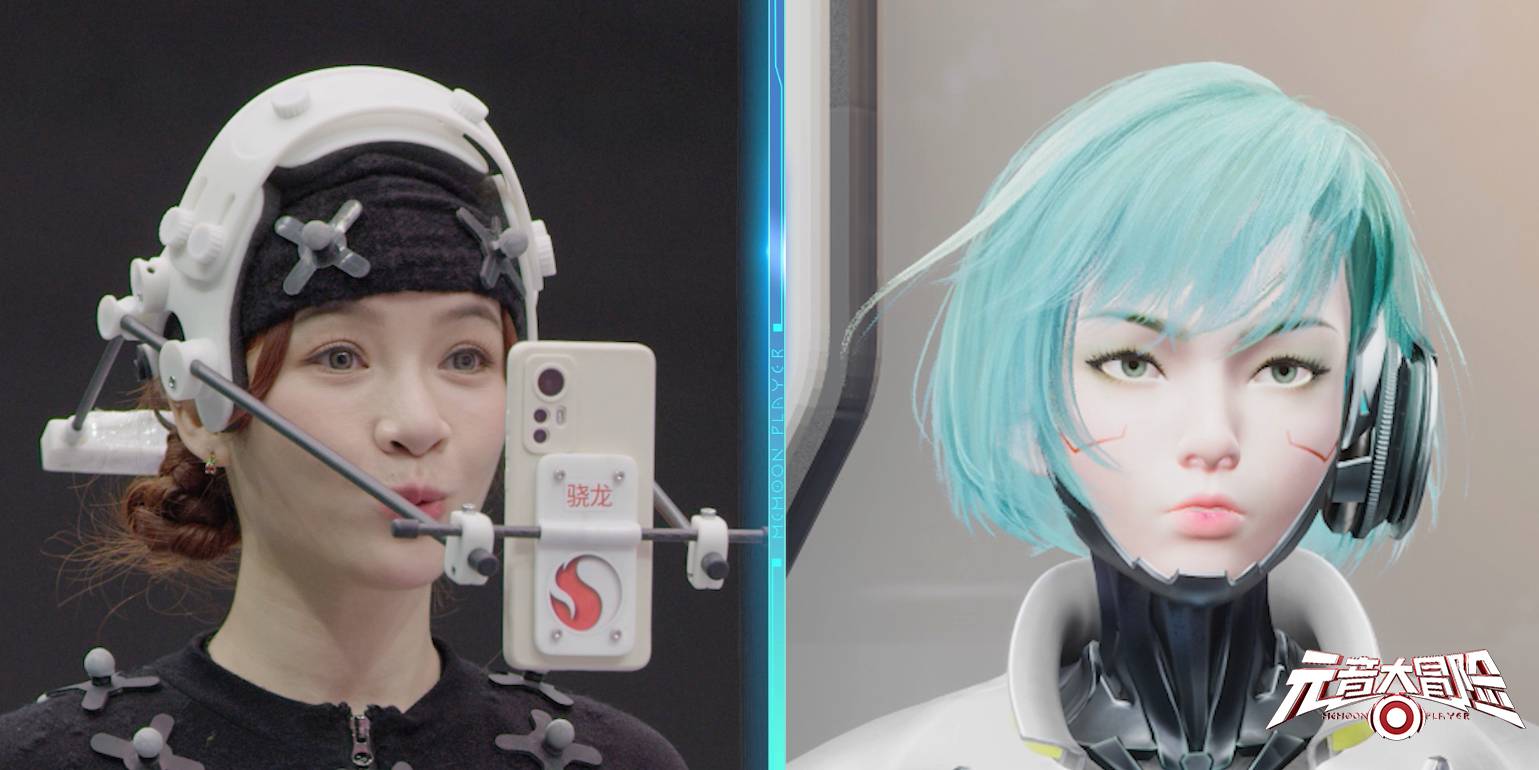

Mais ce n'est pas sans exception. La première émission de téléréalité révolutionnaire de jeu de réalité virtuelle d'iQIYI "Vowel Adventure" a apporté beaucoup de technologie cool à la production de l'émission de téléréalité, permettant aux invités d'entrer dans le monde virtuel———The Vowel Continent, se lançant dans un aventure hilarante et hilarante.

Il s'agit peut-être de l'un des rares contenus de Metaverse à avoir un "sens de raffinement". Ce sens de raffinement est dérivé de la "similitude spirituelle" entre le personnage virtuel et l'étoile correspondante. Derrière cette "similitude spirituelle" se trouve la capture faciale susmentionnée. technologie.

Dans le Metaverse, la capture faciale de qualité industrielle, accessible à quelques personnes seulement, n'est évidemment pas une technologie inclusive. Si la capture faciale peut être effectuée avec un téléphone portable, c'est naturellement la meilleure.

Cependant, il est naturellement difficile de passer de la qualité industrielle à la qualité grand public.

Dans les films industriels matures d'aujourd'hui, la réalisation d'une capture faciale précise suit presque la loi d'une entrée élevée et d'une sortie de haute qualité.

▲ Avant et après la production d'effets spéciaux de "Avatar"

L'investissement ici comprend à la fois du temps et de l'argent. Prenez par exemple "Avatar", qui nous apportait autrefois un spectacle visuel. Il a fallu au réalisateur James Cameron 10 ans de l'idée du tournage à l'atterrissage du projet.

Dans les figurants du film, chaque acteur doit marquer son visage de points noirs, qui sont ensuite capturés par la caméra devant lui.En même temps, plusieurs caméras sont réparties autour pour capturer les mouvements du corps.

Lorsque toutes les intrigues sont filmées, cela ne signifie pas que la production cinématographique est terminée, il faudra environ doubler, voire doubler le temps de tournage pour adapter les expressions faciales et les mouvements du corps captés par la caméra aux personnages virtuels.

![]()

▲ Avant et après la production d'effets spéciaux de "Avatar"

Et pour obtenir un résultat suffisamment choquant, il faut souvent une énorme équipe de post-production pour le terminer ensemble. Ce type de chaîne de montage traditionnelle de qualité industrielle, bien que l'effet soit bon, la précision est totale, et il prend la route de prendre beaucoup de peine et d'abandonner la vitesse.

La vitesse et la précision de la capture faciale sont quelque peu similaires à celles d'un poisson et d'une patte d'ours. Dans le domaine de la conception d'algorithmes d'IA, elles et la consommation d'énergie forment généralement un triangle impossible, qui est le "trilemme". En termes simples, c'est un trilemme choisir.

Il y a 43 muscles dans le visage humain pour exprimer nos émotions ensemble. De nombreuses expressions sont complexes et subtiles, et la différence entre les différentes expressions n'est souvent séparée que par une rivière.

Afin d'exprimer avec précision les vrais sentiments dans le métaverse, ou de transmettre les micro-expressions faciales dans la réalité au monde virtuel, la précision de capture doit atteindre un certain niveau, et il est nécessaire de saisir avec précision des centaines de points caractéristiques, puis coopérer avec le modèle Les algorithmes sont restaurés.

Il convient de noter que le "métavers" que nous avons mentionné n'est pas une création. Il peut avoir une certaine quantité de post-production. Si vous voulez vous sentir immersif et obtenir des commentaires en temps réel, la capture faciale et la communication doivent être synchronisées et calculées. , et des commentaires en temps réel.

Même selon la norme de 24 images d'un film, il doit encore traiter 24 images d'images de haute précision par seconde en temps réel, saisir les points clés de centaines de points caractéristiques et terminer la reconstruction des expressions.

C'est déjà une énorme quantité de travail juste pour capturer des visages humains complexes et dynamiques. En plus des visages humains, il y a beaucoup, beaucoup de facteurs externes et d'urgences qui affecteront également l'effet de la capture faciale. Dans le métaverse , il est impossible pour à nous de créer un studio de cinéma, un éclairage professionnel et un ordinateur de post-traitement pour faire ce travail.

Tout se passe et est enregistré maintenant.

Par conséquent, si vous voulez de meilleurs résultats, vous devez ajouter des facteurs objectifs et subjectifs tels que différents changements de lumière et d'ombre, la vibration du casque, de la caméra et des autres équipements portés, et une occlusion partielle du visage.

En bref, la capture faciale peut sembler n'être rien de plus qu'une technologie de capture d'image, mais en fait, elle doit prendre en compte divers points d'information liés au visage, ainsi que les changements de micro-expression, l'environnement d'éclairage et d'autres facteurs.

Il ne présente pas les changements musculaires du visage dans le monde virtuel un par un, mais transmet les émotions dans la réalité avec précision et en temps réel.

Pourquoi Snapdragon peut-il réaliser une capture faciale dans le métaverse ?

Pour l'enregistrement et la présentation des expressions faciales, en fait, nous avons déjà des applications correspondantes autour de nous, c'est-à-dire les "émoticônes animées" que la plupart des fabricants ont ajoutées aux applications de chat.

Il agit comme une fonction de divertissement qui enrichit le chat. Il ne nécessite pas une grande précision et ne peut enregistrer que quelques expressions plus caractéristiques. Il est en fait difficile de présenter des expressions subtiles.

Pour le programme "Vowel Adventure" d'iQiyi, la forme des "émoticônes animées" est loin d'être suffisante.

Le défi est que l'algorithme de capture de visage peut avoir à la fois une patte de poisson et une patte d'ours, et la difficulté de la capture de visage humain est plus grande que celle de la capture de mouvement humain et de la capture de visage d'animal.

Par conséquent, le support matériel, logiciel et matériel pour les logiciels, ces trois niveaux, détermine si Snapdragon peut faire un bon travail dans la capture faciale, ce qui signifie qu'il nécessite la puissante puissance de calcul sous-jacente de la plate-forme de puce de téléphone mobile et le support du réseau neuronal. algorithmes.

Bien avant que le concept Metaverse ne devienne populaire, l'algorithme d'imagerie de la puce Snapdragon était suffisant pour reconnaître certaines données faciales, et une optimisation ciblée était effectuée via l'algorithme correspondant.

Cependant, c'est la première fois que la capture faciale, ou l'utilisation de la technologie de capture faciale, participe à la production de "Vowel Adventure".

La première consiste à déboguer l'algorithme correspondant en fonction de la technologie d'origine. Commencez par la précision, entraînez un modèle complexe avec une énorme quantité de calculs, couvrez autant que possible toutes les expressions possibles, puis comparez et déboguez à plusieurs reprises pour répondre aux besoins de enregistrement du programme. .

Compte tenu de la réduction de la quantité de calcul, le "calcul de recadrage" est effectué, en d'autres termes, la charge est réduite, mais le principe est de réduire la quantité de calcul tout en conservant une certaine précision de capture faciale.

Auparavant, l'algorithme d'intelligence artificielle pour le calcul des données faciales utilisait le processeur du téléphone mobile, qui ne peut être maintenu qu'à 30 ips tout en conservant une certaine précision, et dans le processus de calcul à haute fréquence, il provoquerait facilement une accumulation de chaleur de l'appareil. , et sous une lumière complexe La situation de coincé sous l'expression.

Afin de résoudre le problème de la consommation d'énergie et de la durée de vie de la batterie, Qualcomm a introduit l'optimisation de l'outil Snapdragon SNPE (Snapdragon Neural Processing Engine, qui est un logiciel d'exécution pour le réseau neuronal profond accéléré par Snapdragon) sur cet algorithme, et a activé l'IA moteur.

De cette façon, l'algorithme d'IA d'origine peut fonctionner à 60 images par seconde et peut continuer à fonctionner pendant trois heures, ce qui résout presque parfaitement le problème de précision et de vitesse, permettant "vous pouvez avoir les deux".

Ce qui est plus choquant, c'est que lorsque le programme a été enregistré, cette solution était uniquement basée sur la génération précédente de puce Snapdragon 8+, et le moteur AI était également la génération précédente.

Un autre point est que dans les faits saillants de l'enregistrement pré-exposé, les visages des stars impliquées dans l'enregistrement n'avaient pas de points d'échantillonnage de données intensifs traditionnels, et ne portaient qu'un casque et un terminal de téléphonie mobile Android pour équipement fixe.

Il n'y a pas besoin de marqueurs spéciaux ou d'enregistrement multi-angle de plusieurs caméras.Un téléphone mobile Android basé sur la puce Snapdragon peut compléter la collecte de 300 points caractéristiques sur le visage, et utiliser le moteur AI du terminal pour analyser l'algorithme complexe de l'IA pour un rendu en temps réel.

Pour la capture faciale, la précision et la vitesse sont finalement obtenues grâce à des algorithmes, des moteurs d'intelligence artificielle et une accélération matérielle NPU. D'autre part, pour "Vowel Adventure", la force technique de Xiaolong a fait passer ce programme de la conception à l'action réelle.

Pour toutes sortes d'interférences autres que les visages humains, Qualcomm Snapdragon et Xiangxin Technology ont également réalisé des percées technologiques pour divers détails.

Par exemple, lorsqu'un artiste chante, parce que le microphone est très proche du visage, cela causera une grave occlusion à la capture en face à face. Cela doit être pris en compte dans la conception technique. Au final, ils se sont rendus compte que même si la bouche est partiellement occluse, ils peuvent toujours capturer les mouvements de la bouche de manière stable et maintenir la réalité virtuelle.Stabilité faciale de l'image, en évitant les "secousses, secousses" et autres situations qui affectent l'effet sur site en raison d'une capture insuffisante.

Le premier arrêt du métaverse, Xiaolong comme guide

On peut voir que "Vowel Adventure" a prouvé qu'à l'avenir, nous pouvons utiliser le téléphone mobile de la plate-forme mobile de la série Snapdragon 8 pour compléter la capture faciale, comme une étoile, pour réfléchir et nous exprimer dans le monde métaverse. Tout comme le petit fantôme Wang Linkai, l'image est un clown excentrique, mais l'expression est toujours ses propres émotions.

▲ Cliquez pour jouer

Par le passé, on perçoit clairement les différentes avancées apportées par l'évolution des SoC des téléphones portables : du CPU monocœur au CPU multicœur, pour que le téléphone mobile ne soit plus bloqué ; la progression du GPU, les jeux auxquels on peut jouer , de "Angry Birds" au niveau de bureau "Yuanshin", et la fréquence d'images du jeu mobile, de 30fps à 120fps; le réseau est similaire, grâce aux progrès du modem, la vitesse du réseau a également changé de ko à mb à le niveau de Go actuel.

Plus important encore, comme mentionné précédemment, la technologie doit non seulement avancer, mais aussi vers le bas. Si l'interface du système d'exploitation mobile actuel doit encore saisir des symboles de commande au lieu de l'interface graphique tactile actuelle, alors la puissance de calcul de la puce Snapdragon Non quelle que soit sa solidité, il est difficile d'expédier des centaines de millions de produits chaque année.

Lorsque Xiaolong et Xiangxin Technology ont coopéré pour compléter la technologie de capture faciale à seuil ultra-bas pour les émissions de variétés sur le thème du métavers, la proposition rencontrée n'était pas seulement de surmonter les difficultés techniques, mais aussi de créer un outil suffisamment simple, facile à utiliser et intelligent. et stable Par rapport à la technologie, les utilisateurs de cette technologie ne sont pas des techniciens et des développeurs, mais des équipes de production cinématographique et télévisuelle et des acteurs.

Il y a une théorie complexe de la gravité derrière tous les atterrissages de pommes habituels, similaire aux progrès de Snapdragon prenant en charge la capture faciale, qui est derrière ?

La réponse est Qualcomm AI Engine.

Par rapport au CPU et au GPU du processeur, la présence du moteur de calcul IA est plus faible.Même si la puissance de calcul de chaque génération de moteur IA augmente de manière exponentielle, la perception qu'il apporte semble un peu faible ?

Prenez cette présentation rapide et bonne de la capture faciale comme exemple, le moteur d'IA dans les appareils ordinaires a atteint un niveau considérable.

En temps normal, la puissance de calcul du moteur d'IA augmente de manière exponentielle, et chaque opération que vous effectuez, comme déverrouiller, allumer la caméra, réveiller l'assistant vocal, etc., n'est pas entourée par l'IA moteur tout le temps.

La puissance de calcul élevée apportée par le moteur d'IA rend ces opérations plus rapides, vous rendant inconscient de l'existence de la technologie, mais entouré d'une meilleure interaction homme-ordinateur.

▲ Cliquez pour jouer

Le moteur Qualcomm AI brille non seulement dans la capture faciale et la création d'avatars dans le programme "Vowel Adventure". Si le métaverse veut une immersion suffisante, il doit d'abord avoir les mêmes perceptions que le monde réel, comme la vision et l'ouïe.

La capture faciale et la capture de mouvement précises peuvent être classées dans la vision, tandis que l'ouïe peut apporter une expérience sonore à faible latence et de haute qualité grâce à la technologie Snapdragon Sound.

Derrière ces technologies se trouve la participation du moteur Qualcomm AI, et l'aide du moteur AI est également devenue la clé derrière le métaverse.

Si vous comparez les avatars de certaines plates-formes dites Metaverse au pays et à l'étranger, telles que Meta's Horizon, vous constaterez que seules les images présentées dans "Vowel Adventure" peuvent être attrayantes pour les gens ordinaires. L'écart d'image ici est complètement la différence entre le réseau 2G et le réseau 4G.

Le "je" dans le monde virtuel est plus proche du "je" réel, de sorte que le métaverse est possible.

La technologie, ici, est le lien qui relie le « je » dans les deux mondes. « Je » est tombé au sol dans un autre monde virtuel, trottinant, et est sorti du village des novices. La première étape de ce métaverse, le mobile Snapdragon plate-forme , est sans aucun doute , est un guide.

#Bienvenue pour prêter attention au compte public WeChat officiel d'Aifaner : Aifaner (WeChat ID : ifanr), un contenu plus excitant vous sera présenté dès que possible.

Ai Faner | Lien d'origine · Voir les commentaires · Sina Weibo