La star la plus discrète de « AI Six Little Dragons » a remis une nouvelle feuille de réponses dans la vague DeepSeek

La vague déclenchée par DeepSeek n'est pas encore terminée. Non seulement OpenAI, mais aussi les « six petits dragons de l'IA » chinois sont confrontés à la torture : la loi de mise à l'échelle peut-elle encore être maintenue, si elle est open source ou fermée, et si la voie de mise en œuvre de l'IA est toujours réalisable.

Aujourd'hui, Step Star, qui a toujours été relativement discret parmi les Six Petits Dragons de l'IA, a pris les devants en remettant sa première feuille de réponses cette année.

Lors de la première journée portes ouvertes écologiques Step UP, Step UP Star a annoncé sa propre façon d'explorer l'AGI, a lancé des recherches techniques sur le raisonnement multimodal et a concentré sa mise en œuvre de l'IA sur les terminaux intelligents, en se concentrant sur des scénarios d'application tels que les automobiles, les téléphones mobiles, l'intelligence embarquée et l'IoT.

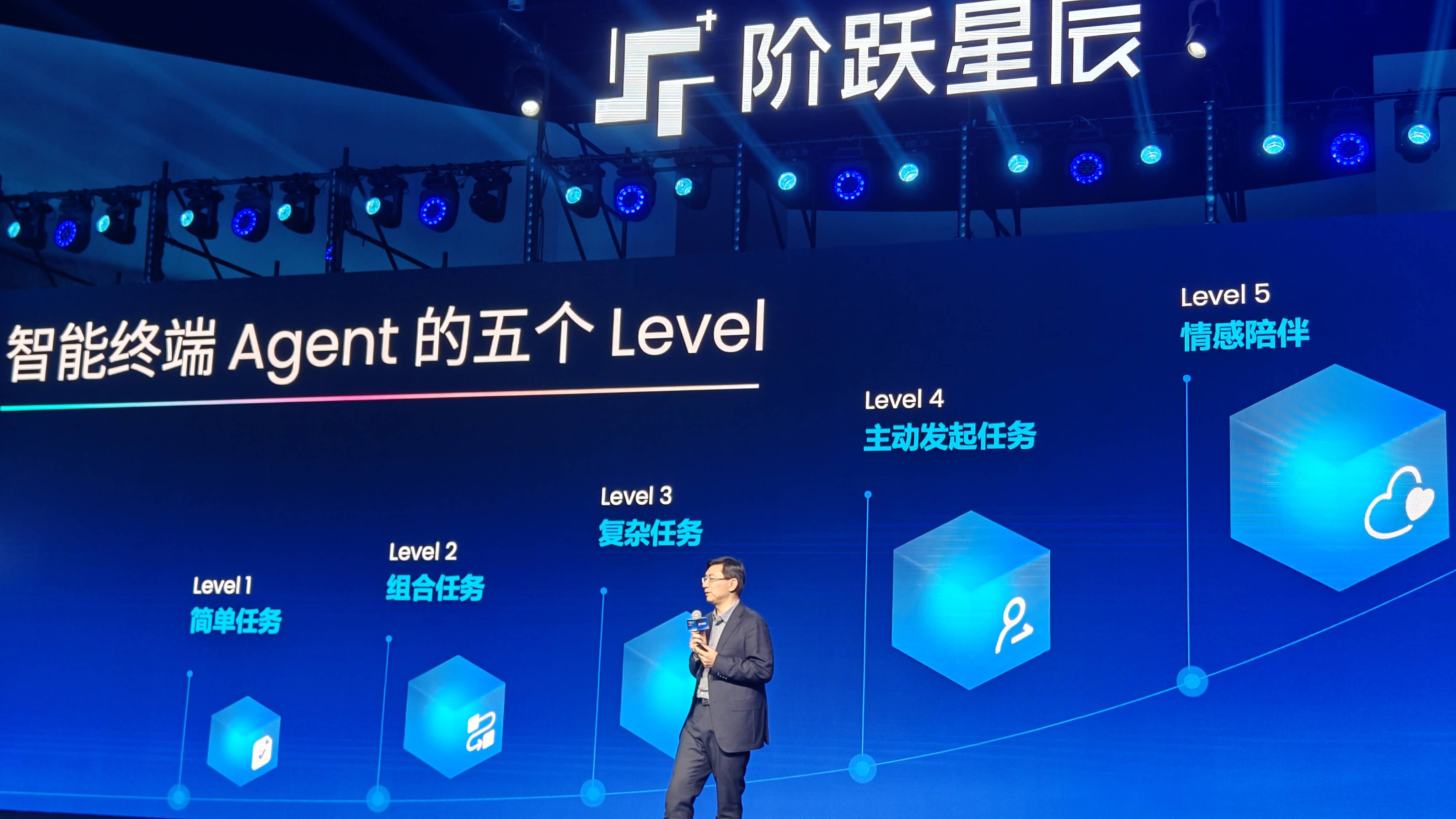

Jiang Daxin, fondateur et PDG de Step Star, estime que les terminaux intelligents deviendront un support clé pour l'application à grande échelle de la technologie Agent.

Nous progressons régulièrement vers l'objectif de réaliser l'AGI et sommes maintenant entrés dans la phase de développement de l'Agent (corps intelligent).

Il a souligné que le développement d’agents intelligents dépend de deux éléments clés :

Le premier concerne les capacités multimodales, permettant aux agents intelligents de percevoir et de comprendre pleinement le monde ;

La seconde est la capacité de raisonnement, qui permet à l'agent de réfléchir lentement dans une longue chaîne de réflexion, de planifier, d'essayer et de réfléchir de manière proactive, et de fournir des réponses précises grâce à une correction continue des erreurs.

La multimodalité permet aux agents intelligents de « voir, écouter et comprendre » comme les humains, ce qui équivaut au « système sensoriel » d'un humain, et la capacité de raisonnement est le « cortex cérébral » qui traite l'information.

La combinaison des deux peut faire de AI Wang Xifeng dans "Un rêve de demeures rouges", avec une paire d'yeux de phénix rouge et triangulaires, non seulement capable de détecter les mots et les couleurs, mais également de lire le sens profond de l'autre partie à partir d'une phrase ou d'une action.

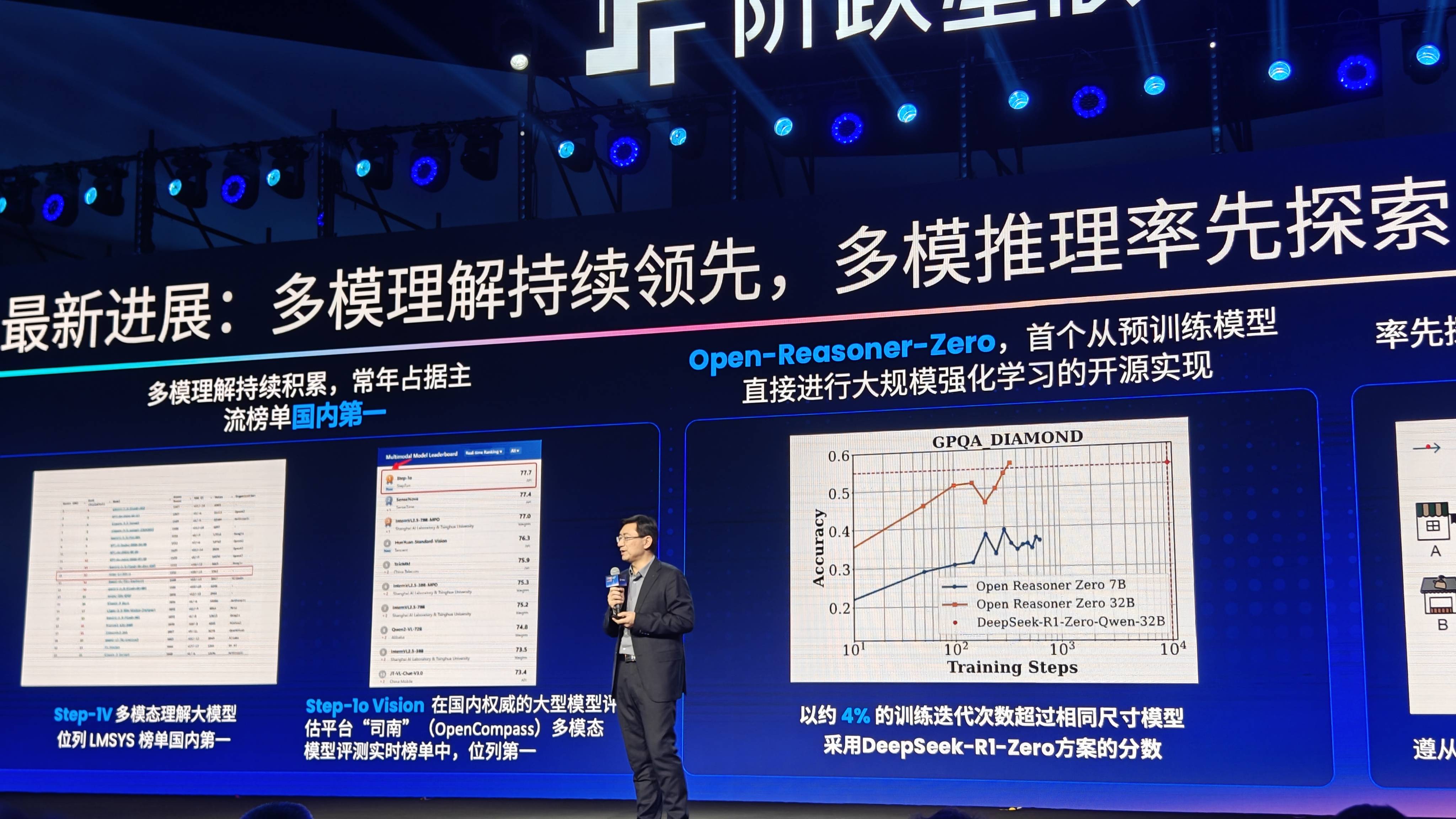

La multimodalité est également la plus grande fonctionnalité de Step Star parmi les Six Petits Dragons. Actuellement, la matrice de modèles de la série Step a publié 11 grands modèles multimodaux, couvrant des capacités complètes en matière de reconnaissance vocale, de génération vocale, de compréhension multimodale et de génération d'images et de vidéos.

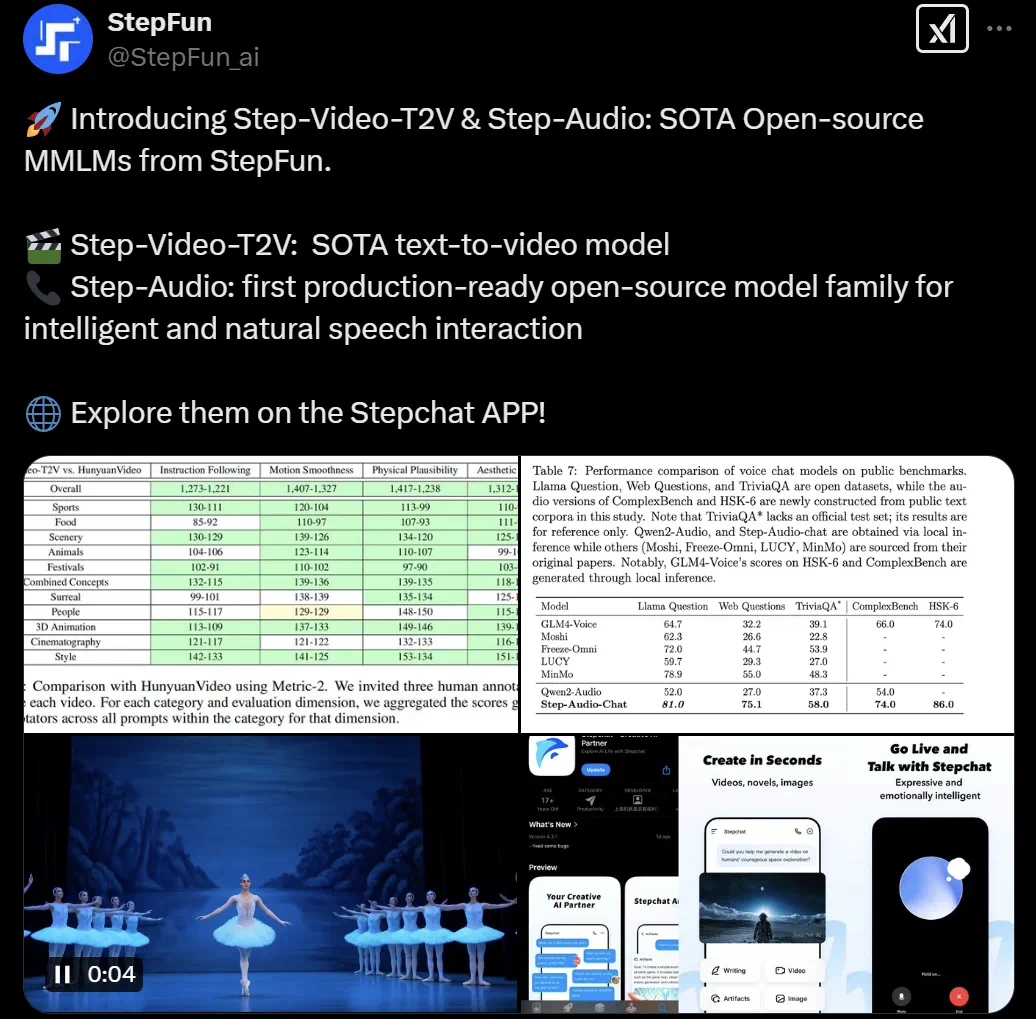

Il y a quelques jours, Step Star a également open source le modèle de génération vidéo Step-Video-T2V et le modèle vocal Step-Audio, devenant ainsi l'un des six petits dragons à adopter l'open source le plus rapidement. Cependant, contrairement à DeepSeek, les modèles open source de Step Star sont tous multimodaux, et c'est une capacité que DeepSeek n'a pas encore démontrée.

L'année dernière, APPSO a utilisé l'application Yuewen sous Step Star pour donner à l'iPhone 16 chinois, qui ne prend pas encore en charge l'IA d'Apple, une capacité similaire à l'intelligence visuelle officielle. Vous pouvez facilement ouvrir l'appareil photo en appuyant sur le bouton de prise de vue, et vous pouvez essentiellement trouver la réponse à tout ce que vous devez consulter.

En ce qui concerne les capacités de raisonnement, Step Star a également annoncé aujourd'hui le modèle de raisonnement open source Open-Reasoner-Zero développé conjointement avec l'Université Tsinghua. Pour la première fois, l'apprentissage par renforcement à grande échelle part du modèle pré-entraîné, et l'efficacité est 25 fois supérieure à celle de DeepSeek-R1-Zero.

Jiang Daxin a également présenté en avant-première le modèle de raisonnement visuel développé en interne sur place. En fait, cela a révélé la logique technique de Step Star pour promouvoir la mise en œuvre de l'IA : combiner les capacités multimodales et les capacités de raisonnement, faisant des terminaux intelligents le support de l'Agent.

Actuellement, les capacités de modèle de Step Star incluent principalement les scénarios suivants dans les terminaux intelligents.

- Scène automobile : l'agent de cockpit intelligent développé en coopération avec Geely réalise « voir et parler » grâce à une interaction multimodale (voix + vision). Par exemple, si l'utilisateur dit « Naviguez jusqu'à la station de recharge la plus proche », l'agent appellera automatiquement la carte, interrogera l'état de la pile de recharge et planifiera l'itinéraire.

- Scénario de téléphone mobile : grâce à la fonction « requête d'écran en un clic » co-construite avec OPPO, une fois que l'utilisateur a pris une photo ou une capture d'écran, l'agent peut directement analyser le contenu de l'image (tel que des produits, des documents) et appeler l'API pour terminer la recherche ou la traduction, sans avoir besoin de changer manuellement d'application.

- Scénario IoT : coopérer avec des fabricants tels que TCL pour réaliser des services actifs grâce à la liaison entre les appareils, en réalisant des mises à niveau intelligentes entre les appareils et une connexion transparente des expériences.

- Intelligence incorporée : Promouvoir l'application innovante d'Agent dans le domaine incorporé. Step Star a annoncé une coopération stratégique avec Zhiyuan Robot pour explorer conjointement des scénarios d'application de robots incarnés AI+.

Les terminaux intelligents AI sont un concept sexy et controversé qui peut permettre à de nombreux matériels d'améliorer l'expérience utilisateur grâce à l'IA. Récemment, de nombreux téléphones mobiles ont annoncé l'accès à DeepSek. Dans le même temps, le matériel AI Ai Pin, devenu populaire l'année dernière, arrêtera tous les services d'IA, les messages envoyés et d'autres fonctions de réseau le mois prochain.

À l'heure actuelle, la plupart des DeepSeek connectés aux téléphones mobiles ajoutent un plug-in à l'assistant vocal. Dans le même temps, comme DeepSeek ne prend pas encore en charge les capacités multimodales, les scénarios d'utilisation sont plus restreints. Le gameplay combiné "DeepSeek+xx" récemment populaire est en fait destiné à compenser son manque de capacité.

OPPO, qui a été le premier à lancer un téléphone IA l'année dernière, est allé plus loin dans l'intégration des terminaux IA.

Par exemple, en utilisant l'application Xiaobu Assistant « One-click Screen Questioning », les utilisateurs interagissent avec l'IA via une vision multimodale pour réaliser plusieurs fonctions telles que les questions et réponses photo, les questions et réponses sur documents et les questions et réponses de reconnaissance d'écran.

Les utilisateurs peuvent même donner des instructions à Xiaobu pour accéder à diverses applications pour effectuer des tâches, telles que la recherche du même produit sur Taobao et JD.com, la recherche d'informations et de services sur des plateformes telles que Xiaohongshu, Tonghuashun et Ctrip, et la recherche d'enregistrements de discussion sur des logiciels sociaux tels que Feishu, DingTalk et WeChat Enterprise, etc., réalisant ainsi une recherche complète en un clic.

Ces fonctions sont développées conjointement par OPPO sur la base de la série Step de modèles multimodaux. Wan Yulong, directeur du département des assistants intelligents d'OPPO et chef de Xiaobu Assistant, nous a déclaré qu'avec l'intégration profonde de la technologie d'IA de nouvelle génération et des terminaux mobiles, les téléphones mobiles ont progressivement évolué vers des assistants intelligents capables de comprendre les intentions des utilisateurs, de fournir des services proactifs et même de prédire leurs besoins.

Les terminaux intelligents entrent dans l’ère des Agents. La plus grande différence par rapport au passé est que les capacités de raisonnement localisées de l'IA font passer le terminal d'un outil qui répond passivement aux instructions à un « partenaire intelligent » qui comprend activement les besoins et collabore entre les applications.

Ce qui fait de ce projet une réalité, c'est l'agent d'IA multimodal, qui servira de nouvelle interface interactive sans avoir besoin d'une interface physique, similaire à l'arbre des âmes dans "Avatar", connectant tous les cyber-agents. Les utilisateurs peuvent même interagir directement avec l'IA par la réflexion pour achever l'exécution de toutes les tâches du monde réel.

![]()

Jiang Daxin a proposé que le développement de l'AGI doive passer par trois étapes : simuler le monde, explorer le monde et résumer le monde :

- Monde simulé : entraînez des modèles multimodaux grâce à l'apprentissage par imitation pour représenter uniformément le son, le texte, les images, les vidéos et le monde physique.

- Explorez le monde : introduisez l'apprentissage par renforcement (tel qu'AlphaGo, DeepSeek) pour donner au modèle des capacités de raisonnement logique et de résolution de problèmes.

- Résumer le monde : explorez la capacité des machines à découvrir de manière indépendante des lois physiques, telles que la dérivation de la loi de la gravité par Newton à partir de la chute d'une pomme. L'objectif est d'innover en collaboration entre l'IA et les scientifiques.

Il peut y avoir plusieurs voies vers l'AGI, mais quelqu'un doit toujours emprunter une voie différente. Step Star a choisi la voie de l'agent terminal intelligent. Peut-être que la prochaine innovation en matière d'interaction homme-machine a déjà jeté les bases de la prochaine innovation.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo