La tirade chinoise d’Elon Musk et d’Ultraman : la vidéo IA se transforme enfin d’un « jouet » en un « outil »

Si vous naviguez sur les réseaux sociaux ces derniers temps, vous trouverez des vidéos virales aux visuels époustouflants, souvent produits par l'IA. Cependant, en tant que créateur, au-delà du simple tirage de cartes, il existe un problème au-delà du visuel qui n'a pas été suffisamment traité.

Le problème est le dialogue.

Par exemple, si je demande à l'IA de générer une belle scène de pluie, ce n'est pas difficile. En revanche, si je demande à l'IA de générer une scène de rupture sous la pluie avec une intrigue et des dialogues, et que ces derniers doivent être en chinois authentique, c'est une tâche très délicate.

Le contenu généré par l'IA est soit une « pantomime » complète qui nécessite que le créateur synchronise les lèvres et double à un stade ultérieur ; soit il peut parler, mais la voix et l'intonation ne sont pas naturelles, pleines de « sentiment homme-machine » et de « ton de traduction », ce qui ruine instantanément l'intrigue qui devrait être triste.

C’est également l’un des plus grands défis de la génération actuelle de vidéos IA : comment gérer les dialogues, en particulier les dialogues chinois avec des émotions complexes.

On peut dire que la capacité de l'IA à gérer des conversations chinoises naturelles et fluides est la clé pour savoir si elle peut passer d'un jouet « pour le plaisir » à un véritable outil de productivité.

Le modèle vidéo MuseSteamer 2.0 de Baidu, lancé aujourd'hui, semble répondre à ce problème majeur. Sa principale caractéristique est d'être la première technologie intégrée de génération audio et vidéo chinoise au monde. Se réclamant d'un corpus chinois, il permet de générer des vidéos de conversation en chinois avec un son et une vidéo synchronisés, des mouvements de lèvres précis et des émotions naturelles en une seule étape.

Afin de vérifier si cela résout vraiment les problèmes des créateurs ou s'il s'agit simplement d'une démonstration technique dans la vidéo promotionnelle, j'ai décidé de contourner les cas officiels sélectionnés (Démos) et de concevoir quelques scènes « délicates » plus proches des besoins créatifs quotidiens des gens ordinaires pour explorer moi-même sa réalité.

Adresse de l'expérience : https://huixiang.baidu.com/

D'une image à une confrontation sonore

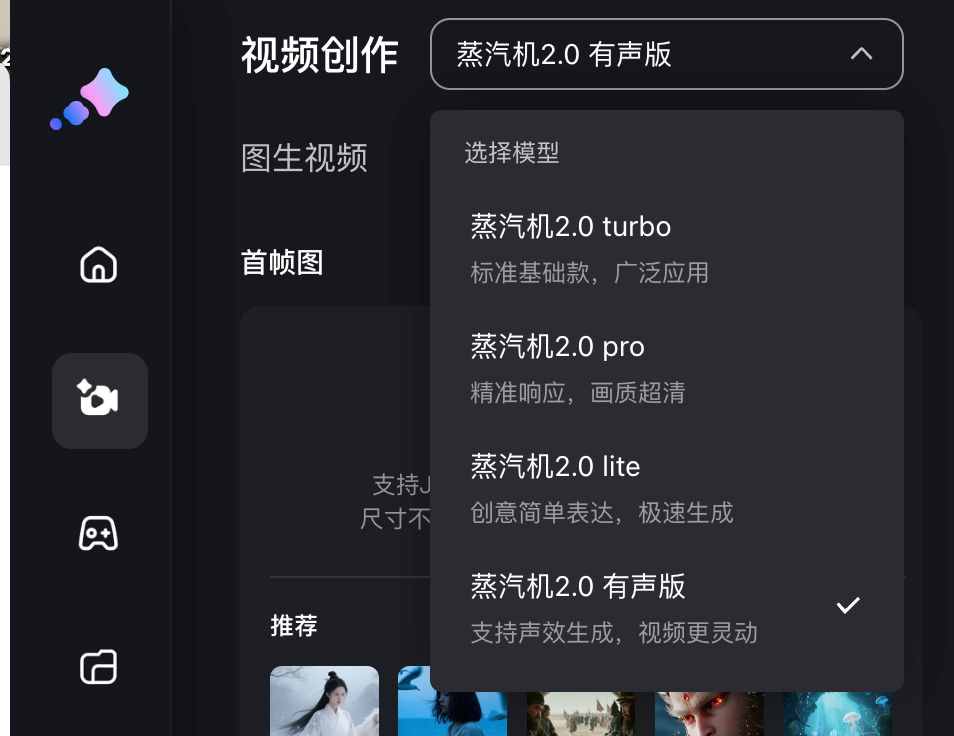

Baidu Steam Engine propose cette fois 4 modèles de génération, qui génèrent tous une vidéo à partir d'une image, à savoir Steam Engine 2.0 turbo, pro, lite et version audio ; différents modèles consommeront différents nombres de points, et les utilisateurs gratuits peuvent obtenir une quantité limitée de valeur d'imagination (points) en se connectant chaque mois.

La version audio peut générer des vidéos de 5 ou 10 secondes, tandis que la version Turbo et les trois autres versions offrent une durée de 5 secondes. En termes de pixels, à l'exception de la version Pro qui prend en charge le 1080p, les trois autres versions offrent une qualité d'image haute définition de 720p.

Nous lui donnons directement une image, puis suivons les instructions sur la page de génération de vidéo pour saisir le contenu vidéo et les lignes thématiques que vous souhaitez générer ; pour une vidéo de 5 secondes, les lignes doivent être contrôlées dans les 20 mots, et pour une vidéo de 10 secondes, le nombre de mots doit être contrôlé dans les 35 mots.

▲ Nous avons mis en ligne une photo d'Elon Musk et d'Ultraman, avec le message suivant : deux personnes se disputent. La personne de gauche dit : « L'IA que vous avez créée n'a aucun objectif ». La personne de droite dit : « Votre marketing n'a aucun objectif. » Généré par la version audio de Steam Engine 2.0.

Tout d'abord, Musk et Ultraman sur les photos statiques sont très naturels ; leurs expressions faciales et leurs mouvements corporels sont fluides et globalement cohérents avec les images téléchargées. La capacité de conversion d'images en vidéos reste très solide.

Plus important encore, la performance des dialogues est véritablement exceptionnelle en matière de synchronisation labiale chinoise. Les mouvements des lèvres correspondent parfaitement à la prononciation de mots comme « résultat » et « marketing », sans aucun décalage ni décalage notable.

▲ Une première image des gobelins de la montagne Langlang, accompagnée d'un signal : Dans l'image, un gobelin sanglier, tenant une fourche, lève les yeux avec impatience vers le costaud Ours Cocher à côté de lui. Lignes : (0-5 secondes) Le gobelin sanglier, tenant une fourche, dit : « Cocher, polissons notre armure. Nous combattrons avec plus de force ! » (5-10 secondes) Le costaud Ours Cocher baisse les yeux vers lui et l'interrompt avec impatience : « Qui a le temps ? Tirez-moi mille flèches d'abord ! »

Lors de la conférence de presse, Baidu a spécifiquement mentionné qu'il s'agissait de la logique de génération sous-jacente à l'intégration audio et vidéo . Le son et l'image sont conçus simultanément, plutôt que d'être appariés ultérieurement. Lors de la formation, l'image et le son sont intégrés dans un modèle unique pour un apprentissage synchrone.

De plus, il existe une technologie pionnière appelée « Planificateur multimodal latent ». La multimodalité est facile à comprendre et fait référence au texte, aux images et à l'audio. « Latent » est un terme d'apprentissage profond qui se concentre sur l'apprentissage des caractéristiques latentes. Cette technologie permet de planifier de manière autonome plusieurs identités de personnages, lignes et logiques d'interaction dans l'espace de génération latente.

En termes simples, on peut l'imaginer comme un réalisateur intégré à l'IA. Lorsqu'on lui donne l'instruction de « laisser deux personnes se disputer », il ne les laissera pas bêtement parler en même temps, mais planifiera indépendamment le scénario de la dispute.

Nous avons également essayé certains dialectes comme le chinois du nord-est pour voir s'il n'y aurait pas de problèmes dans les conversations à plusieurs.

▲ Invite : La femme en bleu sur le côté gauche de l'écran chuchote rapidement et froidement en dialecte du Nord-Est : « Sœur, la sincérité est notre charbon de bois, mais c'est aussi le feu qui nous brûle à mort » ; la femme en violet et rose sur le côté droit de l'écran répond résolument en dialecte du Nord-Est : « Alors pourquoi pas, brûlez-le simplement plus proprement » ; généré par la version audio de Steam Engine 2.0.

Faire parler Zhen Huan et Shen Meizhuang en dialecte du Nord-Est dans le modèle audio et vidéo intégré était un peu complexe, mais les expressions des personnages, les mouvements des lèvres, des boucles d'oreilles et des coiffures étaient très naturels. Les voix chinoises étaient également très détaillées, ce qui, à mon avis , témoigne d'une profonde adaptation au contexte chinois.

Il y a aussi cette image mème classique, qui n'est finalement pas "Venez goûter ma chair fraîche".

Capture d'écran du court-métrage « Wan Wan Wo Xiang ». La légende dit : Tang Sanzang, coiffé d'un chapeau rouge, pointe du doigt le nez de l'homme aux cornes et dit avec colère : « Tu veux encore goûter à ma chair fraîche ? Pas question ! »

Baidu Steam Engine résout avec précision le problème créatif consistant à permettre à une seule image de parler et de jouer une scène. Il simplifie le processus multi-outils, auparavant fastidieux, en une seule opération « une image + une phrase ». Cela libère indéniablement de la productivité pour des scénarios tels que la création de mèmes, les dialogues virtuels, le partage de connaissances et la production de sketches.

Il reste encore du chemin à parcourir avant de pouvoir égaler les performances de doublage des vidéos récemment populaires « Empresses in the Palace » et « Let the Bullets Fly ». Cependant, compte tenu de l'état actuel des technologies de génération vidéo par IA, je pense que ce n'est qu'une question de temps avant que l'IA puisse exprimer des émotions humaines plus nuancées et conflictuelles. Après tout, le modèle Steam Engine 1.0 est sorti au début du mois dernier.

Peut-il gérer les mouvements de caméra et les grandes scènes ?

En plus de la première génération audio et vidéo intégrée avec voix à deux joueurs dans les scènes chinoises, une autre mise à niveau de Baidu Steam Engine 2.0 est la qualité d'image de niveau film et le mouvement de caméra complexe de niveau maître .

Dans les vidéos conversationnelles précédentes, les émotions, les expressions et la génération faciale 3D ont toutes démontré des expressions de personnages réalistes et détaillées. Nous avons continué à tester les transitions et les plans vides, courants dans les publicités et les courts métrages, qui sont une autre exigence essentielle des vidéos IA, en plus des conversations.

▲ Fournissez la première image avec l'invite : Une prise de vue qui commence par un gros plan d'un livre ouvert sur un bureau, tire lentement vers le haut et se fige finalement sur la scène de rue pluvieuse à l'extérieur de la fenêtre ; générée par Steam Engine 2.0 Pro.

À en juger par la vidéo, la machine à vapeur a suivi les instructions à la lettre. Tous les mouvements de caméra – gros plans, remontées, arrêts sur image – ont été exécutés avec une fluidité remarquable, sans aucun problème de bougé ni d'incompréhension des instructions. Cela démontre une solide maîtrise du vocabulaire photographique.

Lorsque l'IA apprend le chinois authentique, un nouveau tournant dans la création vidéo est arrivé

Après ce test, je pense que le positionnement de Baidu Steam Engine 2.0 est très clair : il n'a pas vocation à être un modèle global de type Sora, mais a choisi une voie plus pragmatique : en utilisant le « dialogue chinois » comme point de rupture principal, il a fait passer la vidéo IA d'un « jouet » intéressant à un « outil » qui peut être livré sous forme de film.

Il évite la concurrence interne qui consiste simplement à rivaliser en termes de qualité et de longueur d'image, et consacre plus d'énergie à résoudre le problème le plus critique et le plus localisé : faire en sorte que les vidéos IA « parlent vraiment chinois » et le parlent mieux que les vraies personnes.

Cette transformation du « jouet » en « outil » a été vérifiée dans des domaines créatifs et commerciaux réels.

Yao Qi, réalisateur d'effets visuels de calibre hollywoodien, a travaillé sur des films comme « 2012 », « Matrix 3 » et « Transformers 3 ». Il a également créé les effets spéciaux emblématiques du Guzheng dans le drame de science-fiction chinois « Le Problème à trois corps ». Cette fois, il a utilisé la machine à vapeur Baidu pour créer un court-métrage de science-fiction de haute qualité, comprenant plus de 40 plans d'effets spéciaux complexes et élaborés, générés chacun trois fois, pour un total de plus de 120 clips, le tout pour la modique somme de 330,6 yuans.

▲ Vidéo de la conférence de presse « Homeward Journey »

Lorsque le coût de production visuelle d’un court métrage, qui nécessitait auparavant un budget de plusieurs millions de yuans, est réduit à un niveau incroyablement bas, ce qui est subverti n’est pas seulement le budget, mais aussi le seuil et les droits de création.

Il ne s'agit pas seulement de réduire les coûts ; il s'agit de passer de la création d'un clip captivant à la narration d'une histoire complète. Lorsque des effets visuels grandioses peuvent être intégrés de manière transparente à la narration et aux dialogues, l'IA évolue véritablement du simple plug-in d'effets spéciaux à un outil hautement performant pour les créateurs.

Dans les scénarios de marketing de marque, ce modèle bouleverse également le processus de production vidéo traditionnel. Par exemple, Yili Beichang devait produire une vidéo promotionnelle pour son lait de chèvre en poudre, intitulée « Un mouton traverse la mer pour vous voir ». Les méthodes de production traditionnelles prennent généralement de quatre à six semaines, et le tournage consistait à décrire le voyage magique de « Little Lamb Shasha » en montgolfière, traversant les prairies néerlandaises et des usines de haute technologie. Cette approche était à la fois coûteuse et complexe.

Cette fois, l'équipe de production a utilisé une machine à vapeur pour réaliser ces scènes fantastiques, difficiles à réaliser en prises de vues réelles, grâce à un rendu stylisé par l'IA. Plus important encore, l'IA a intégré avec fluidité des arguments de vente clés, comme l'approvisionnement en lait néerlandais et une formule probiotique, au récit, réduisant ainsi le cycle de production à quelques jours seulement. Les visuels obtenus sont restés homogènes et ont parfaitement exprimé la philosophie de la marque.

Qu'il s'agisse de créateurs professionnels ou d'innombrables petites et moyennes entreprises, chacun a désormais un « cyber-stylo ». Avec « une image et une phrase », il est possible de donner vie à un guerrier en terre cuite statique et de passer un appel, ou de discuter avec Zhang Fei tout en brodant. La disparition de cette barrière à la création redéfinit l'équation des coûts et les règles concurrentielles du secteur du contenu.

Bien sûr, ce n'est pas un couteau suisse parfait . Actuellement, il est limité quant à la durée des vidéos qu'il peut générer pour les effets purement visuels, sans dialogue, et son choix de sons et de styles pourrait être plus riche.

Cependant, à l'ère des produits d'IA à itérations rapides, il n'existe pas de produit véritablement parfait. Les produits les plus efficaces sont ceux qui peuvent être mis en œuvre plus rapidement pour répondre aux besoins réels des utilisateurs. La machine à vapeur de Baidu a évité la vanité d'une course aux armements technologiques, optant plutôt pour une approche plus pragmatique et axée sur le marché. C'est comme un marteau qui enfonce des clous. S'il ne peut pas raboter le bois, il atteint la perfection dans ce domaine.

En regardant le personnage généré par l'IA s'exprimer librement devant moi, sans me sentir comme une machine, je ne peux m'empêcher d'être émerveillé. Les outils finiront par devenir invisibles, mais la créativité brillera toujours. La machine à vapeur a permis de rendre le rêve de la réalisation, autrefois incroyablement coûteux et réservé à quelques privilégiés, à tous ceux qui avaient quelque chose à dire.

Aujourd’hui, nous ne manquons plus de bons outils, mais d’idées nouvelles ; et les idées uniques naissent de tentatives répétées.

Texte|Li Chaofan et Zhang Zihao

Pour visionner la vidéo de l'article, cliquez sur ce lien : https://mp.weixin.qq.com/s/cy7m7e97AVVo5VqUcnS0_w

#Bienvenue pour suivre le compte public officiel WeChat d'iFaner : iFaner (ID WeChat : ifanr), où du contenu plus passionnant vous sera présenté dès que possible.