Laissez votre ancien téléphone mobile prendre des photos pour rattraper le nouveau produit phare, pourquoi cette application est-elle ci-jointe le package d’installation

J'ai deux téléphones de secours, OnePlus Ace sorti début 2022 et iQOO Z7 sorti début 2023.

OnePlus Ace est une machine de milieu de gamme au prix de 2 000+, et sa tâche d'imagerie principale est un capteur IMX 766 de 1/1,56 pouce ; tandis que l'iQOO Z7 est principalement axé sur les jeux, ne coûtant que plus de 1 000 et équipé de 1/1,97 ; Capteur Samsung GW 3 de 3 pouces.

Bien que ces deux appareils fonctionnent bien dans leurs positions respectives, ils ne parviennent progressivement pas à répondre à mes besoins en termes de capacités d'imagerie.

Même d’ici 2024, la technologie d’imagerie des téléphones mobiles nationaux sera suffisamment excellente, mais elle se concentrera principalement sur les modèles phares. Pour les téléphones mobiles non phares – en particulier les modèles milieu et bas de gamme des générations précédentes, la technologie d'imagerie n'a pas encore été entièrement popularisée et j'ai besoin d'autres moyens pour améliorer leurs capacités d'imagerie.

Google Camera donne une seconde vie aux images des anciens téléphones portables

Le matériel ne peut pas être modifié, mais le logiciel peut encore être manipulé.

Lorsque je souhaite améliorer l'effet de prise de vue grâce à un logiciel, la première chose à laquelle je pense est Google Camera, qui a été très apprécié au début des smartphones. Dans cette ère chaotique de l'imagerie, Google Camera a sauvegardé l'image d'innombrables téléphones mobiles et a été. même utilisée par divers développeurs. Modifiée par les utilisateurs pour s'adapter à davantage de systèmes de téléphonie mobile, elle est devenue une application incontournable pour les passionnés de flash.

J'ai donc immédiatement installé Google Camera sur deux téléphones et effectué un test comparatif pour voir s'il pouvait sauvegarder mes téléphones de sauvegarde.

Lorsque je suis sorti du bureau avec mon téléphone portable, j'ai vu la lumière du soleil de l'après-midi descendre de l'avant-toit. La luminosité de l'unité extérieure du climatiseur formait un énorme contraste avec les ombres environnantes, présentant un environnement avec un rapport de lumière élevé. est un bon endroit pour tester l’opportunité de l’effet HDR.

▲ Gauche : caméra native OnePlus Ace / Droite : caméra Google

Les photos montrent que dans un tel environnement avec des couleurs vives et une lumière et une obscurité claires, la différence d'imagerie entre l'appareil photo natif OnePlus Ace et l'appareil photo Google : OnePlus est plus conservateur dans l'algorithme HDR, garantissant un certain aspect naturel et sensation d'imagerie optique. Cependant, l'image est un peu grise et la saturation rouge des murs est fortement réduite ;

Google Camera est encore plus radical, supprimant considérablement les reflets de l'unité extérieure du climatiseur. Le vert des feuilles et le rouge du mur conservent également une saturation relativement distincte, cependant, en raison de la forte intervention de l'algorithme. les marques de netteté des photos prises par l'appareil photo Google sont plus évidentes, l'aspect général est plus numérique.

En sortant, le soleil brille sur la voiture utilisée pour décorer le restaurant en bordure de route. J'ai pointé le OnePlus Ace vers le capot qui reflète la lumière du soleil pour voir l'écart HDR entre les deux algorithmes lorsque le soleil brille directement sur l'objectif.

▲ Gauche : caméra native OnePlus Ace / Droite : caméra Google

Cette photo montre clairement les tendances d'imagerie des deux algorithmes : l'appareil photo natif continue de maintenir sa stratégie douce, et les hautes lumières et les ombres de la photo sont supprimées dans une plage confortable, garantissant un aspect et une sensation doux et naturels, mais le capot Le les reflets sont quelque peu débordés et les rayures les plus brillantes du capot sont couvertes ;

Google Camera a toujours choisi une texture plus contrastée pour garantir la sensation « lourde » de la couleur. Les reflets sur le capot sont très bien supprimés et les rayures sont clairement visibles.

Après avoir essayé l'algorithme HDR de Google Camera, regardons la comparaison de photos dans des scènes ordinaires.

▲ Gauche : caméra native OnePlus Ace / Droite : caméra Google

Dans une scène avec une lumière relativement faible, il n'y a pas de différence évidente entre les deux photos. En y regardant de plus près, seules les feuilles en haut à gauche et le chariot orange au milieu présentent une légère différence de luminosité.

De manière générale, lorsque le HDR n'intervient pas fortement dans l'imagerie, la différence entre la caméra native du OnePlus Ace et l'algorithme de la caméra Google devient également plus petite. La courbe de tonalité de la caméra native est plus douce, tandis que la courbe de tonalité de la caméra Google est plus douce. . Que ce soit dur ou dur dépend entièrement des préférences de l'utilisateur, et il n'y a aucune distinction entre eux.

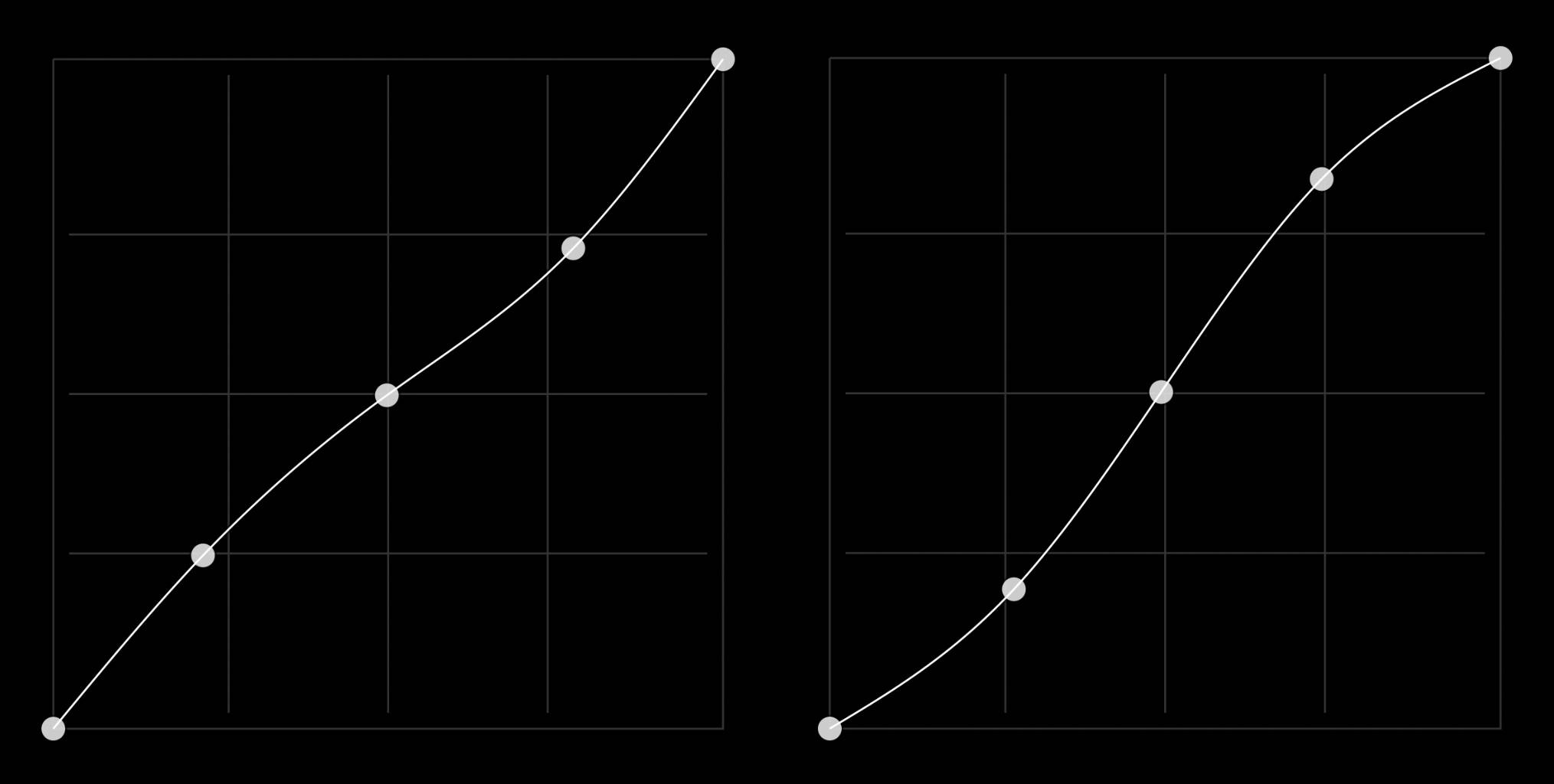

▲ Gauche : courbe de luminosité de la caméra native OnePlus Ace/Droite : courbe de luminosité de la caméra Google (simulation)

Ensuite, j'ai utilisé un autre iQOO Z7 pour prendre une série de photos comparatives d'une fenêtre détaillée dans un environnement nocturne afin de voir comment les deux algorithmes fonctionnent lorsque la lumière est insuffisante.

▲ Gauche : caméra native iQOO Z7 / Droite : caméra Google

Lorsque l'environnement d'éclairage environnant est relativement faible, les deux ensembles d'algorithmes montrent également des tendances d'imagerie complètement différentes : la caméra native d'iQOO éclaircit l'image autant que possible pour montrer des détails plus sombres, et en même temps ajoute une netteté pour rendre les objets plus visibles. l'image est cohérente avec les bords du texte. Par exemple, le texte dans la fenêtre devient plus clair. L'inconvénient est qu'une netteté excessive entraînera une forte impression de maculage. un certain degré de maculage;

L'appareil photo de Google a tendance à bien contrôler les hautes lumières et l'aspect général est similaire à celui de l'œil nu. En même temps, il n'ajoute pas de netteté excessive et conserve la texture que l'imagerie optique devrait avoir. la fenêtre est floue et la reconnaissance est assez différente.

Dans cette série de comparaison, on peut dire que les deux ont leurs propres mérites, mais après une obscurité totale, les deux algorithmes montrent à nouveau des tendances différentes.

Dans une rue complètement sombre, j'ai utilisé le mode Night Sight fourni par Google Camera pour comparer avec l'algorithme de scène nocturne de la caméra native d'iQOO.

▲ Gauche : caméra native iQOO Z7 / Droite : caméra Google

Dans le test comparatif, les performances de la scène nocturne constituent la plus grande différence entre les deux algorithmes de caméra : la caméra native d'iQOO éclaircit considérablement les parties sombres et fournit plus de détails sombres, mais le contraste entre les parties claires et les parties sombres de la photo n'est pas excellent. . Semble un peu plat ;

Les photos prises à l'aide du mode Google Camera Night Sight restaureront les tons autant que possible tout en garantissant que les détails dans les zones sombres seront plus clairs et les zones sombres plus sombres, donnant aux photos un aspect aussi naturel que possible.

Bien que les performances d'imagerie de ces deux téléphones mobiles, qui ne vendent pas de capacités d'imagerie comme argument de vente, ne soient plus dépassées au même niveau, ils ont toujours la possibilité de « rajeunir » avec le support des algorithmes HDR et de scène nocturne fournis par Appareil photo Google.

En d'autres termes, si vous ne cherchez pas à mettre à jour votre téléphone phare chaque année, mais que vous souhaitez tout de même obtenir de meilleurs résultats de prise de vue lorsque vous rencontrez un rapport de lumière élevé et un environnement complètement sombre, vous pouvez aussi bien essayer de demander à Google Camera de le donner. un essai.

Il est cependant difficile de trouver aujourd’hui une version native de Google Camera.

Après le lancement de Pixel, Google Camera est devenu l'appareil photo natif de Pixel et n'existe plus en tant qu'application distincte, de sorte que la difficulté d'adaptation est montée en flèche. De plus, les téléphones mobiles nationaux ont continué à s'améliorer « mieux que les autres », attirant progressivement. L'attention de tous et de plus en plus reconnue, l'attention reçue par Google Camera a également rapidement diminué.

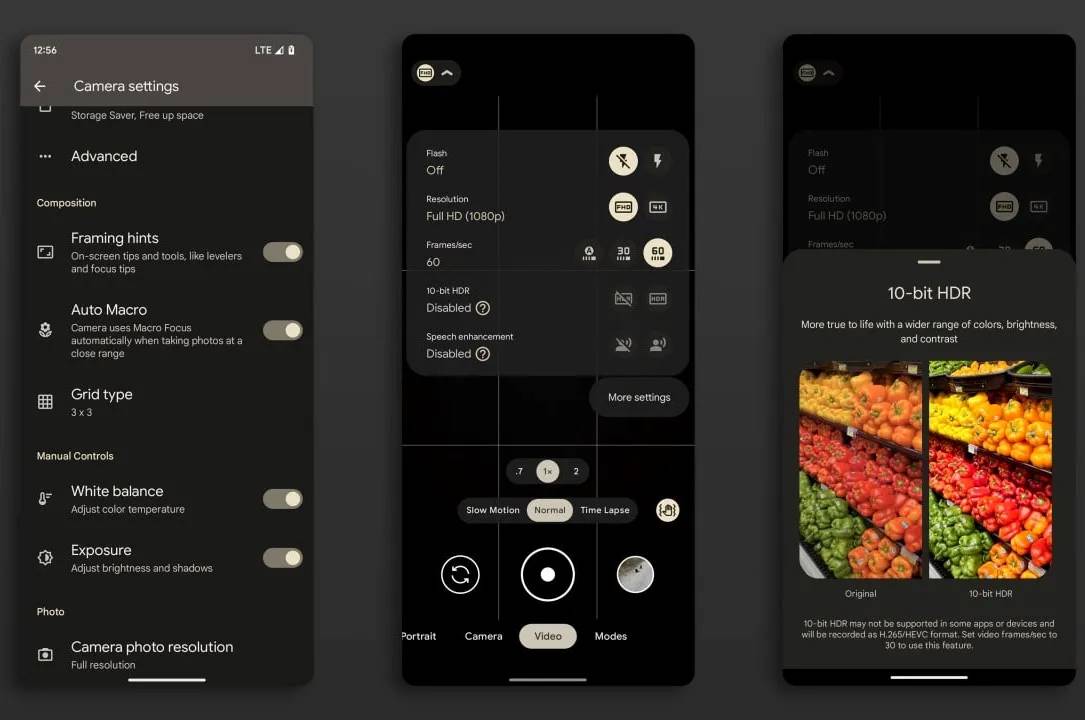

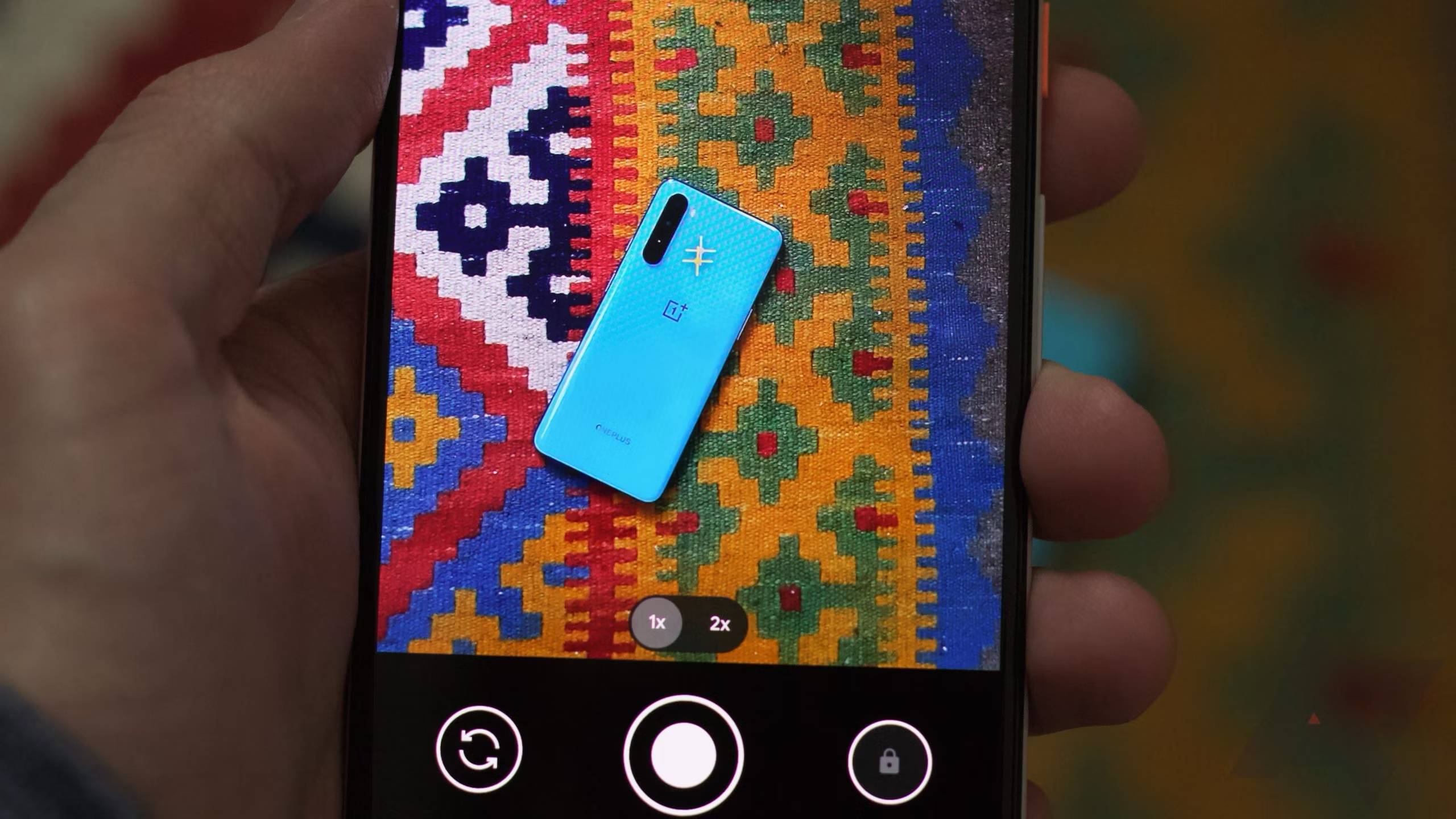

▲Pixel 3 utilisant l'appareil photo Google

Depuis longtemps, la grande occasion où Google Camera était largement adapté à différentes marques de téléphones mobiles n'existe plus.

Heureusement, il existe encore de nombreux développeurs qui aiment particulièrement Google Camera et continuent de le modifier et de le mettre à jour afin qu'il puisse fonctionner sur davantage de plates-formes.

Ce que j'ai utilisé dans ce test était GCam (abréviation de Google Camera) publié par BSG, un développeur indépendant du Kazakhstan qui a décompilé et modifié le fichier APK de Google Camera afin qu'il puisse être utilisé sur davantage d'appareils non Pixel. caméra et ajoute des fonctionnalités et des optimisations supplémentaires pour donner aux utilisateurs un meilleur contrôle sur leurs caméras en cas de besoin.

▲ La version développée par un tiers offre de nombreuses options de personnalisation

J'ai collecté plus d'informations sur les développeurs de Google Camera et les versions qu'ils ont lancées pour votre référence :

- AGC développé par BigKaka, la dernière version est AGC 9.4.24_V2.0 ;

- MGC lancé par BSG, un développeur du Kazakhstan, la version actuelle est MGC 9.2.113 ;

- Gcam développé par MWP, la version actuelle est la 8.8.224 ;

- SGCAM de Shamim, la version actuelle est SGCAM_8.5.300.XX.10 ;

Dans ce test, j'ai utilisé des caméras Google tierces lancées par deux développeurs, BSG et BigKaka.

Ces deux développeurs ont la fréquence de mises à jour la plus élevée et le plus de versions. Prenons comme exemple le MGC lancé par BSG. Uniquement dans la mise à jour de la version MGC 9.2.113 que j'utilise, BSG a adapté la version universelle, la version Qualcomm selon le. Équipement et besoins des différents utilisateurs. Version de la puce Snapdragon, version Samsung, version développeur, version optimisée pour la beauté et version de numérisation 3D.

Afin de faciliter l'essai pour tout le monde, j'ai intégré la dernière version du package d'installation de Google Camera développé par BSG et BigKaka. Vous pouvez l'obtenir en envoyant "Google" en arrière-plan, et choisir la version qui vous convient.

Le pionnier de la photographie informatique utilise l’IA pour ouvrir la voie à la prochaine décennie

Après le test, j'ai compté soigneusement et j'ai réalisé que Google Camera existe depuis dix ans.

Les premiers smartphones étaient sans aucun doute un nouveau gadget. Les fabricants et les utilisateurs se concentraient sur de nouveaux systèmes et applications. En comparaison, les fonctions d'imagerie qui existaient depuis l'ère des téléphones multifonctions ne semblaient pas si intéressantes.

En raison d'un manque d'attention, le système d'imagerie des smartphones est dans un état utilisable mais pas facile à utiliser.

L'iPhone 4s sorti en 2011 en est un exemple concret : la zone CMOS est trop petite et l'objectif a une structure simple, ce qui entraîne une très petite quantité de lumière entrant dans le téléphone lors de la prise de vue, qui se reflète finalement dans les photos, qui sont scènes floues et pleines de bruit. L'image est si belle que sur les plateformes sociales actuelles, elle est considérée comme le remplacement de la caméra CCD.

Cela peut paraître drôle, mais cela reflète fidèlement la qualité d’image des smartphones des premières années.

En tant que leader du système Android, Google n'était visiblement pas satisfait des images, c'est pourquoi il a décidé de jeter un coup d'œil aux téléphones Android : les smartphones devraient emprunter la voie de la photographie informatique.

En avril 2014, alors que les autres fabricants étaient encore confus, Google Camera a été officiellement lancé.

Peu de temps après son lancement, Google Camera a reçu sa première mise à jour majeure : l'introduction de la fonction HDR+, qui a considérablement amélioré la plage dynamique grâce à la technologie de synthèse multi-images.

Deux ou trois ans plus tard, le successeur de la série Nexus, la série de téléphones mobiles Pixel, est sorti et l'appareil photo Google est devenu l'appareil photo système par défaut de Pixel.

À cette époque, la solution d'imagerie dominante sur le marché était la combinaison « double caméra » menée par l'iPhone. Pixel lui faisait concurrence avec une seule caméra, battant l'iPhone et Samsung dans le score DxO. Il disposait également d'une énorme base d'utilisateurs et. L'attention s'est portée sur le système Android. Ensuite, Google Camera et son algorithme sont devenus célèbres, et le terme photographie informatique a commencé à attirer une réelle attention de la part du public.

À l'heure actuelle, la concurrence pour les téléphones mobiles nationaux est progressivement devenue féroce. L'imagerie des téléphones mobiles est devenue le principal point de concurrence après que les fabricants nationaux ont commencé à se concentrer sur l'imagerie. il y a. C’est devenu la direction pour tout le monde.

En 2016, Huawei a conclu une coopération avec Leica et a progressivement renforcé l'algorithme de la caméra du P9, y compris l'introduction de la fusion multi-images, qui a amélioré l'effet HDR des téléphones mobiles nationaux de « pas facile à utiliser » à « presque bon ». Après, la technologie HDR similaire de Xiaomi a été introduite dans les produits phares Xiaomi Mi 6 et Mi Note 3, et OPPO et Vivo ont emboîté le pas, ajoutant la technologie de fusion multi-images à leurs caméras natives pour améliorer la qualité du film.

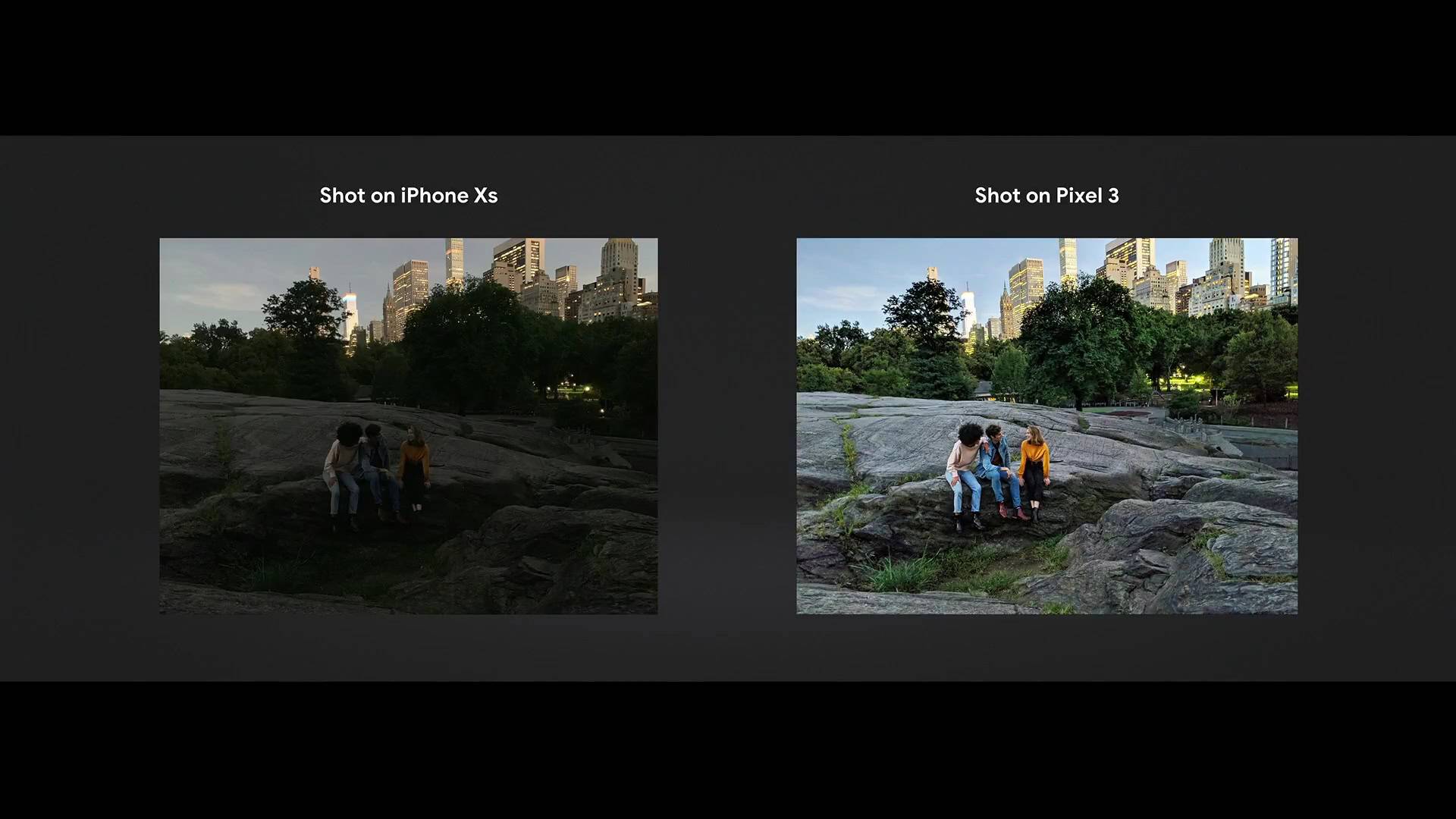

Google Camera a mené la tendance pour la deuxième fois avec le lancement du mode Night Sight (NIght Sight) sur le Pixel 3 lancé en 2018.

Avant cela, les scènes de nuit constituaient le plus grand obstacle auquel étaient confrontés les téléphones portables. La petite zone CMOS et le manque de composants anti-vibration rendaient le téléphone mobile complètement inutilisable dans un environnement d'éclairage où même l'appareil photo avait besoin d'un trépied pour capturer des images.

Le mode de vision nocturne lancé par Google permet aux téléphones mobiles de prendre des photos claires, lumineuses et détaillées dans des environnements extrêmement faiblement éclairés, ce qui repousse considérablement les limites de l'imagerie des téléphones mobiles et est appelé « vision nocturne ».

Le principe du mode vision nocturne n'est en fait pas difficile à comprendre. Au moment où vous appuyez sur le déclencheur, Google Camera prend automatiquement plusieurs photos avec des temps d'exposition différents. Les temps d'exposition de ces photos varient de court à long, et les informations de lumière capturées le sont. également différent. En combinant ces multiples images en une seule photo finale, le mode Night Sight tire le meilleur parti de la lumière ambiante, améliorant ainsi la luminosité et la plage dynamique.

Après tout, il s'agit également d'une extension de la fusion multi-images. Sur l'appareil photo, des opérations similaires sont appelées bracketing et empilement d'exposition.

Le mode Night Sight est une mise à jour révolutionnaire pour Google Camera. Après cela, la facilité d'utilisation des téléphones mobiles a dépassé celle des caméras pour les utilisateurs non professionnels qui enregistrent leur vie.

▲ Night Sight sur Pixel 3, comparé à l'iPhone Xs de la même période

Cette fois, les constructeurs ont emboîté le pas très rapidement.

Fin 2018, Google venait de pousser le mode vision nocturne sur le Pixel 3 via une mise à jour. Xiaomi a pris les devants en mettant à jour le mode scène super nuit pour son Mix 3 sorti la même année, OPPO R17 Pro, vivo NEX. version double écran et Huawei P20 Pro, le tout Il a été équipé d'un mode scène nocturne auto-développé.

Apple et Samsung ont également équipé les séries iPhone 11 et Galaxy S10 d'un mode nuit l'année suivante.

Par rapport au mode Night Sight qui a reçu beaucoup d'attention, il existe une nouvelle fonctionnalité sur le Pixel 3 : une fois l'appareil photo réveillé, le système identifiera automatiquement la scène dans l'appareil photo et comparera rapidement les photos une fois que l'utilisateur appuie sur le déclencheur. Optimisez pour rendre le ciel plus bleu et les feuilles plus vertes.

Cette fonction, appelée reconnaissance intelligente de scènes, n'était certainement pas accrocheuse à l'époque, mais elle est devenue plus tard la troisième vague, jetant les bases de la participation de l'IA à l'imagerie.

Depuis 2017, les fabricants d'Android ont commencé à déployer leurs propres efforts. Huawei a été le premier à essayer la technologie d'IA pour optimiser la reconnaissance intelligente des scènes dans le Mate 10 lancé cette année-là. Samsung et Xiaomi ont rapidement suivi et l'ont également ajoutée au Galaxy S9 et à Xiaomi. 8 lancé en 2018. Reconnaissance de scène AI.

L'application la plus connue de cette fonction est le "Moon Mode" lancé avec le Huawei P30 Pro, qui était à l'époque devenu un point chaud pour la photographie mobile.

À partir de ce moment-là, la reconnaissance intelligente a commencé à être profondément impliquée dans l'imagerie de la photographie sur téléphone portable. Elle a été développée jusqu'à présent. Les scènes d'application peuvent couvrir presque tout ce que nos yeux peuvent voir, du poli des plats délicieux au coucher de soleil spectaculaire. la Voie Lactée. Ils sont tous une continuation de la reconnaissance de scène par l'IA.

Au cours des dix dernières années, Google Camera a d'abord amené les images chaotiques des téléphones portables sur la voie de la photographie informatique, puis a démontré étape par étape comment utiliser un logiciel pour maximiser le matériel, faisant passer la photographie sur téléphone portable de « utilisable » à « facile à utiliser ». utilisation". Ensuite, le changement qualitatif de « puissance » a rendu le téléphone mobile d'imagerie phare d'aujourd'hui non seulement capable de prendre des photos en levant simplement la main, mais également capable de prendre de bonnes photos en levant simplement la main.

Dix ans plus tard, Google ose toujours être le premier lors de la conférence Made by Google le mois dernier, en lançant le nouveau Pixel 9.

En tant que premier téléphone mobile au monde à intégrer l'IA au niveau du système, ce téléphone prend entièrement en charge le système d'imagerie. En plus de rendre les photos de groupe plus pratiques, les utilisateurs peuvent modifier et déplacer des éléments dans les photos prises avec le Pixel 9, et même utiliser l'IA pour. Avec le support, vous pouvez modifier directement le contenu de n'importe quelle partie de la photo grâce à une simple description textuelle.

C'est la première fois qu'un système d'imagerie sur téléphone mobile franchit la frontière entre virtuel et réel. Avec l'aide de l'IA, Google a fait passer l'imagerie sur téléphone mobile de « l'enregistrement » à la « création », ouvrant ainsi la porte à la prochaine décennie. est tombé d’un seul coup.

# Bienvenue pour suivre le compte public officiel WeChat d'Aifaner : Aifaner (ID WeChat : ifanr). Un contenu plus passionnant vous sera fourni dès que possible.

Ai Faner | Lien original · Voir les commentaires · Sina Weibo