Le DLSS 4 de Nvidia n’est pas ce que vous pensez. Démystifions les mythes

Nvidia a volé la vedette au CES 2025 avec l' annonce du RTX 5090 , et malgré de nombreux discours sur le prix de 2 000 $ de la carte, elle inaugure de nombreuses nouvelles technologies. Le principal d'entre eux est DLSS 4, qui apporte la génération multi-images aux GPU de Nvidia, offrant une amélioration des performances 4X dans plus de 75 jeux dès que les nouveaux GPU RTX série 50 de Nvidia seront commercialisés.

Cependant, j'ai vu beaucoup trop de malentendus sur le fonctionnement réel de DLSS 4 . Entre les commentaires trompeurs du PDG de Nvidia et une refonte radicale du fonctionnement du DLSS, il n'est pas étonnant que des informations erronées circulent sur la nouvelle technologie, ses capacités et, surtout, ses limites.

Alors, remettons les pendules à l’heure, au moins autant que possible avant que les nouvelles cartes graphiques de Nvidia ne soient là et que nous expérimentions tous ce que DLSS 4 a à offrir.

Non, cela ne « prédit pas l'avenir »

L'un des principaux problèmes pour bien comprendre le fonctionnement de DLSS 4 vient d'un commentaire du PDG de Nvidia, Jensen Huang, lors d'une séance de questions-réponses. Jarred Walton de Tom's Hardware a demandé à Huang comment fonctionne DLSS 4 au niveau technique, et Huang a catégoriquement nié que DLSS 4 utilise l'interpolation de trame. Il a déclaré que le DLSS 4 « prédit l’avenir » au lieu d’« interpoler le passé ». C'est une citation à la mode, c'est sûr. Dommage que ce soit incorrect.

Huang a fait preuve de poésie à propos de la génération de trames DLSS dans le passé, et bien que ce type de cadrage fonctionne pour expliquer une technologie comme DLSS 4 au grand public, il conduit également à des malentendus sur son fonctionnement réel. Suite à cette citation, plusieurs lecteurs m'ont contacté pour me dire que je ne comprenais pas comment fonctionne DLSS 4 . Il s'avère que je ne comprends pas mal comment cela fonctionne, mais je comprends pourquoi il y a beaucoup de confusion.

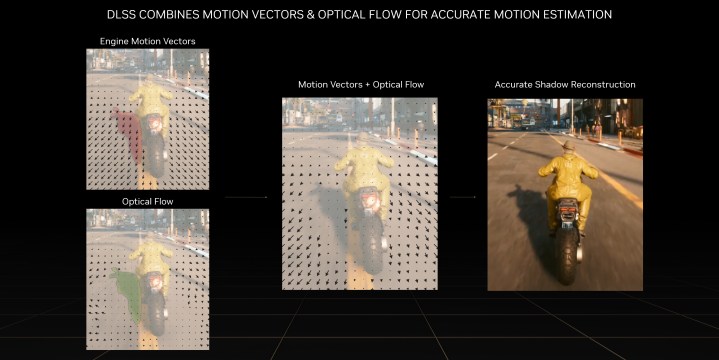

La génération multi-trames du DLSS 4 utilise une technique appelée interpolation de trames. C'est la même technique que nous avons vue dans DLSS 3, et c'est la même technique que vous trouverez dans d'autres outils de génération de trames comme Lossless Scaling et FSR 3 d'AMD . L'interpolation d'images fonctionne comme ceci : votre carte graphique restitue deux images, puis un algorithme intervient pour calculer la différence entre ces images. Ensuite, il « génère » une image à placer entre les deux, devinant à quoi ressemblerait l’image interstitielle en fonction de la différence entre les deux images rendues.

Et DLSS 4 utilise l'interpolation de trame. Il y a eu quelques premières recherches sur de nouvelles techniques de génération de trames – en particulier des recherches d' Intel sur l'extrapolation de trames – mais cette technologie en est encore à ses débuts. Il y a certains détails que je ne peux pas encore partager, mais j'ai maintenant confirmé auprès de plusieurs sources que DLSS 4 utilise en fait l'interpolation de trame. Cela a aussi du sens. Ces types d'outils de rendu ne surgissent pas de nulle part, et il y a presque toujours une longue lignée de documents de recherche avant qu'une nouvelle technique de rendu ne soit transformée en un produit commercialisable comme DLSS 4.

Cela n’enlève rien à ce dont DLSS 4 est capable. Il utilise peut-être la même technique que DLSS 3 pour créer de nouvelles images, mais cela ne devrait pas vous distraire de ce que DLSS 4 peut réellement faire.

La latence n'est pas le problème que vous pensez

Je comprends pourquoi Nvidia ne veut pas beaucoup commenter l'utilisation de l'interpolation de trame par DLSS 4. C'est parce que l'interpolation de trame introduit une latence. Vous devez restituer deux images, puis effectuer l'interpolation avant la première image de la séquence affichée. Ainsi, lorsque vous utilisez un outil d'interpolation d'images, vous jouez essentiellement avec un léger retard. L'hypothèse que j'ai vue est que ces images supplémentaires augmentent linéairement la latence, ce qui n'est pas le cas.

The Verge s'est montré préoccupé en disant vouloir « voir comment la nouvelle technologie de génération d'images affecte la latence », tandis que TechSpot a déclaré que « les utilisateurs craignent que le rendu multi-images puisse aggraver le problème [de latence] ». C'est un contre-courant naturel aux « fausses » images multipliées que DLSS 4 peut cracher. Si la génération d’une image provoque un problème de latence, en générer trois entraînerait sûrement un problème de latence plus important. Mais ce n'est pas comme ça que ça marche.

C'est pourquoi il est si important de comprendre que DLSS 4 utilise l'interpolation de trame. L'idée de jouer sur un délai n'est pas différente entre DLSS 3 générant une image supplémentaire et DLSS 4 générant trois images supplémentaires – le processus implique toujours le rendu de deux images et la comparaison de la différence entre elles. Votre latence n'augmente pas de manière significative entre l'insertion d'une, deux ou trois images supplémentaires entre les deux rendues. Quel que soit le nombre d’images intermédiaires, la latence ajoutée par le processus d’interpolation d’images est en grande partie la même.

Permettez-moi d'illustrer cela. Disons que vous jouez à un jeu à 60 images par seconde (fps). Cela signifie qu'il y a 16,6 millisecondes entre chaque image que vous voyez. Avec DLSS 3, votre fréquence d'images doublerait pour atteindre 120 ips, mais votre latence n'est pas réduite de moitié à 8,3 ms. Le jeu semble plus fluide, mais il y a toujours 16,6 ms entre chaque image rendue. Avec le DLSS 4, vous pourrez monter jusqu'à 240 fps, quadruplant votre frame rate, mais encore une fois, la latence ne descend pas à 4,2 ms. C'est toujours le même 16,6 ms.

Il s'agit d'un aperçu très réducteur de la latence du PC – il y a une surcharge pour l'exécution de la génération de trames DLSS, plus la latence ajoutée par votre moniteur et votre souris – mais il est utile pour comprendre que la latence de base n'augmente pas linéairement lors de l'ajout de trames supplémentaires à la trame. processus d'interpolation. Le temps entre chaque image rendue ne change pas. La latence que vous rencontrez est encore en grande partie le résultat de votre fréquence d'images de base avant la génération de trames DLSS et de la surcharge de l'outil.

Vous n’êtes pas obligé de me croire sur parole. Digital Foundry a testé DLSS 4, y compris la latence, et a trouvé exactement ce que je viens de décrire. "Il me semble que la majorité de la latence supplémentaire provient toujours de la mise en mémoire tampon de cette image supplémentaire, mais l'ajout d'images intermédiaires supplémentaires entraîne une augmentation relativement minime de la latence", a écrit Richard Leadbetter de Digital Foundry . La petite quantité de latence supplémentaire vient simplement du fait que le DLSS calcule davantage d'images entre les deux qui ont été rendues, de sorte que la majeure partie de l'augmentation de la latence avec le DLSS 4 n'est pas très différente de celle du DLSS 3.

Le problème de latence avec DLSS 4 est en grande partie le même qu'avec DLSS 3. Si vous jouez à une fréquence d'images de base faible, il y a un décalage entre la réactivité que vous rencontrez et la fluidité que vous constatez. Cette déconnexion sera plus importante avec DLSS 4, mais cela ne signifie pas soudainement qu'il en résulte une augmentation massive de la latence. C'est pourquoi l'impressionnant nouveau Reflex 2 de Nvidia n'est pas requis pour DLSS 4 ; tout comme DLSS 3, les développeurs n'ont besoin que d'implémenter la première version de Reflex pour que DLSS 4 fonctionne.

Un tout nouveau modèle

Clarifier le fonctionnement de DLSS 4 pourrait vous amener à croire que c'est à peu près la même chose, mais ce n'est pas le cas. DLSS 4 constitue un changement très important par rapport à DLSS 3, car il utilise un modèle d'IA complètement différent. Ou, devrais-je dire, des modèles d'IA. Comme le détaille Nvidia , DLSS 4 exécute cinq modèles d'IA distincts pour chaque image rendue lors de l'utilisation de la super résolution, de la reconstruction de rayons et de la génération multi-images, qui doivent tous s'exécuter en quelques millisecondes.

En raison de ce qu'implique DLSS 4, Nvidia a supprimé son précédent réseau neuronal à convolution, ou CNN, et utilise désormais un modèle de transformateur de vision. Il y a deux grands changements avec un modèle de transformateur. Il y a d’abord ce qu’on appelle « l’attention personnelle ». Le modèle peut suivre l'importance de différents pixels sur plusieurs images. Être ainsi autoréférentiel devrait permettre au nouveau modèle de se concentrer davantage sur les zones problématiques, telles que les détails fins en super résolution qui peuvent apparaître chatoyants.

Les modèles de transformateurs sont également plus évolutifs, permettant à Nvidia d'ajouter beaucoup plus de paramètres au DLSS qu'avec l'approche CNN précédente. Selon l'entreprise, le nouveau modèle de transformateur présente en fait le double des paramètres.

Comme vous pouvez le voir dans les vidéos ci-dessus, Nvidia affirme que ce nouveau modèle offre une meilleure stabilité et une meilleure préservation des détails fins par rapport à l'approche CNN précédente. Ces améliorations ne sont pas non plus exclusives aux GPU RTX série 50. Toutes les cartes graphiques RTX pourront exploiter le nouveau modèle de transformateur dans les jeux DLSS 4, au moins pour les fonctionnalités prises en charge par chaque génération.

J'ai vu DLSS 4 en action à plusieurs reprises, mais le véritable test de cette fonctionnalité aura lieu lors du lancement des GPU de nouvelle génération de Nvidia. Ensuite, je pourrai évaluer le fonctionnement de la fonctionnalité dans plusieurs jeux et scénarios pour voir comment elle résiste. Quoi qu’il en soit, cette fonctionnalité apporte de nombreux changements et, selon ce que Nvidia a partagé jusqu’à présent, ces changements contribuent à rendre le DLSS encore meilleur.