Le jeton grand modèle est-il trop cher ? Apple offrira « sans frais » aux développeurs.

L'arrière-goût d'Apple Intelligence, qui a été surfait puis abandonné par Apple lors de la WWDC de l'année dernière, persiste encore.

Au petit matin du 10 juin 2025, le discours principal (enregistré) de la WWDC25 vient de se terminer, et la partie relative à l'IA fait encore soupirer de temps en temps : « C'est tout. »

Beaucoup des soi-disant nouvelles fonctionnalités annoncées par Apple en matière d'IA cette année, comme la traduction en temps réel et les commandes de raccourcis, ne sont pas très révolutionnaires ; quant à l'intelligence visuelle, non seulement ses fonctionnalités ont six ou sept ans de retard sur Google Lens, mais son expérience interactive est également loin du niveau des produits d'IA/agent intégrés d'un certain nombre de concurrents Android au premier semestre 2025.

Mais après avoir regardé l'émission dans son intégralité, je peux affirmer qu'il n'y a qu'une seule nouvelle concernant l'intelligence d'Apple qui aura un impact de grande envergure, tant pour les utilisateurs ordinaires que pour les développeurs.

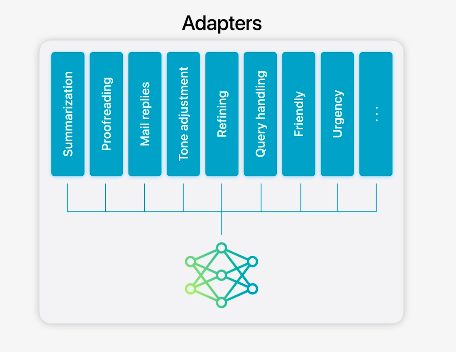

Il s'agit du « Foundation Models Framework », un framework d'accès aux modèles d'IA côté client fourni par Apple aux développeurs. Grâce à lui, les développeurs Apple pourront accéder facilement au modèle de langage étendu côté client de leurs applications sans avoir à payer de frais de jeton.

Cela signifie que les développeurs peuvent fournir aux utilisateurs des fonctionnalités et des services basés sur LLM sans aucune charge, et effectuer un raisonnement purement côté terminal sans se soucier des frais de jeton générés par l'appel de l'API LLM cloud, et n'ont naturellement pas à répercuter les coûts sur les utilisateurs.

Les développeurs peuvent maintenir de manière plus respectable le modèle de tarification de leur choix, et les utilisateurs en bénéficient.

Apple intelligent, de bout en bout

L'année dernière, lors de la WWDC, Apple a annoncé une série de produits, de fonctionnalités et de capacités techniques d'IA qu'elle pourrait proposer aux développeurs sous le nom d'« Apple Intelligence ». Nous savons déjà que la plupart de ces annonces ont été retardées, voire complètement « vaporware » (logiciel annoncé mais sérieusement retardé).

Cela affecte le jugement du monde extérieur sur le succès d’Apple en matière d’IA.

Mais Apple continue de vendre le plus de smartphones au monde. Même si elle tarde à adopter un LLM cloud avec des paramètres importants, l'entreprise a toujours son mot à dire sur la façon dont les gens utilisent l'IA et dont les développeurs l'appliquent à leurs projets ; c'est objectif et incontestable.

Cette année, lors de la WWDC25, j'ai vu Apple exercer son droit de parole. La société a déclaré aux développeurs :

Vous souhaitez offrir des fonctionnalités d'IA à vos utilisateurs ? Aucun problème. Vous pouvez utiliser le modèle end-side fourni par Apple pour effectuer un raisonnement LLM entièrement localement sur l'appareil, sans connexion internet. Ceci protège la confidentialité des utilisateurs et n'entraîne aucun frais de cloud.

Le « Basic Model Framework » est un outil puissant qu’Apple a mis à la disposition des développeurs.

Le modèle de base est au cœur de l'intelligence d'Apple. L'année dernière, il était réservé à ses propres produits et fonctionnalités. À partir d'aujourd'hui, Apple ouvre ce modèle aux développeurs. Toute application tierce peut directement utiliser ces modèles de base côté terminal pour implémenter des fonctions basées sur l'IA et offrir une expérience utilisateur inédite.

Par exemple, Kahoot!, un produit éducatif présenté sur site, peut utiliser le modèle côté client pour générer un ensemble de questions personnalisées pour les utilisateurs.

Or Alltrails, un produit incontournable pour les amateurs de randonnée à l'étranger, peut fournir aux utilisateurs l'assistance nécessaire même dans les situations où il n'y a aucun réseau dans les zones de montagne dangereuses.

Alors, quels sont les modèles de base ?

- L'année dernière, lors de la WWDC, Apple a publié un modèle de langage de bout en bout avec 3 milliards de paramètres , ainsi que sa version mise à jour ultérieure.

- Modèle ChatGPT personnalisé pour le client/Apple.

——Au moins ces deux catégories sont connues (les types de modèles spécifiques sont inconnus et Apple n'a pas encore fourni d'informations plus précises aux non-développeurs). Actuellement, le « Basic Model Framework » prend en charge Swift nativement (les autres langages sont inconnus), et les développeurs n'ont besoin que de quelques lignes de code pour y accéder, prenant en charge la génération de contenu, les appels d'outils et d'autres fonctionnalités LLM.

Mais aujourd'hui, les développeurs ont trop de choix : DeepSeek, Claude, la série O, Gemini… avec leurs différents modèles officiels et leurs versions adaptées à des scénarios spécifiques. Pourquoi devraient-ils concurrencer le modèle de base d'Apple ?

La proposition de valeur d’Apple est simple.

En termes simples, l'utilisation de ces LLM a un coût économique direct. Plus le nombre d'utilisateurs et le niveau d'activité/d'adhésion sont élevés, plus le coût d'appel à l'API cloud et de génération de jetons est élevé.

Face à ce type de coût, les startups prometteuses peuvent lever des fonds grâce au capital-risque, et les grandes entreprises peuvent utiliser leurs réserves de trésorerie pour les financer. De ce fait, les utilisateurs actuels sont depuis longtemps habitués aux formations LLM gratuites.

Mais pour les développeurs de petite et moyenne taille, en particulier les développeurs indépendants, cela devient un problème très pratique : imaginez qu'un utilisateur vient de télécharger votre application et souhaite tester votre fonction d'IA, et qu'il voit tout de suite « Il y a 3 quotas de génération gratuits ce mois-ci »… et si l'un de vos concurrents est une grande entreprise, comment pouvez-vous rivaliser avec lui ?

Apple vous propose désormais le « Basic Model Framework » et vous ouvre gratuitement le modèle côté terminal, vous permettant de faire appel à la puissance de calcul locale de l'iPhone/iPad/Mac pour effectuer un raisonnement LLM rapidement, efficacement et en toute confidentialité afin de répondre aux besoins des utilisateurs.

Vous n'avez plus à vous soucier de votre capital pour payer les frais d'API cloud ; vous n'avez plus à modifier votre stratégie tarifaire pour couvrir les coûts des jetons. Vous pouvez choisir en toute sérénité le modèle économique qui vous convient et qui satisfait vos utilisateurs. Que vous soyez un développeur de petite, moyenne ou indépendant, n'est-ce pas une excellente solution ?

C'est une situation gagnant-gagnant pour les développeurs et les utilisateurs – bien sûr, ajoutez Apple au mélange et c'est gagnant-gagnant-gagnant pour tous.

« En retard mais arrivé », version IA

Le célèbre développeur et analyste d'Apple, John Gruber, a écrit un article de blog très intéressant il y a quelques jours.

Il a souligné qu'Apple est toujours en retard sur ses concurrents dans certains produits/technologies clés, ce que tout le monde sait ; mais il faut admettre que dans l'histoire de l'entreprise, Apple n'a en effet manqué aucune révolution technologique majeure au niveau du paradigme.

Par exemple, le navigateur Safari d'Apple et son noyau WebKit ont été lancés début 2003, huit ans après le navigateur Netscape qui avait fait sensation dans le monde entier et avait même menacé de mettre Microsoft en faillite, et même trois ans après l'éclatement de la « bulle .com » – mais mieux vaut tard que jamais, sans compter qu'il n'y avait pas de bon navigateur sur la plateforme Mac avant Safari.

Si cette logique est appliquée, Apple, qui est obligé d’entrer dans l’ère de l’IA, a besoin d’une nouvelle combinaison de technologies de produits qui puisse être à égalité avec Safari/WebKit aujourd’hui.

La bonne nouvelle, c'est que, comme mentionné au début de cet article, les ventes et la part de marché de l'iPhone sont bien trop importantes. Même si le monde extérieur se moque d'Apple pour son retard dans l'ère de l'IA, une réalité est indéniable :

Pendant longtemps encore, Apple aura toujours son mot à dire pour définir la manière dont les utilisateurs utilisent l’IA (sur les produits iPhone/iPad/Mac/Vision) au lieu de laisser l’IA définir à quoi ses produits devraient ressembler.

Vous pouvez voir qu'OpenAI a acquis la société de l'ancien chef de la conception d'Apple, Jony Ive, en essayant de développer un nouveau facteur de forme qui est « entièrement natif de l'IA » ; mais vous verrez également qu'OpenAI et Apple ont conclu un accord pour devenir le seul « partenaire intelligent mondial » dans l'écosystème Apple – c'est-à-dire le seul fournisseur externe de modèles de base.

Apple pense-t-il être à la traîne par rapport à OpenAI ? Non. Sinon, Apple devrait payer OpenAI. Au contraire, selon The Information, OpenAI paiera à Apple un « péage » pour intégrer l'écosystème Apple et devenir le modèle de base par défaut, à l'instar de son prédécesseur Google, devenu le moteur de recherche par défaut d'iOS.

Si les frais d’abonnement mensuels pour les utilisateurs de ChatGPT sont de 20 $, la commission d’Apple pourrait atteindre 30 %, et ce revenu est presque égal au pur profit.

Vous voyez, Apple collecte de l'argent auprès d'OpenAI et subventionne ensuite les développeurs et les utilisateurs finaux déguisés – n'est-ce pas assez surprenant ?

Lors de la conférence sur les résultats du premier trimestre d'Apple en 2009, Cook, qui assurait l'intérim du PDG d'Apple pour la deuxième fois en raison de la grave maladie de Jobs, prononça quelques mots qui devinrent plus tard le « Credo Cook ». L'un de ces mots était :

Nous pensons que nous devons posséder et contrôler les principales technologies derrière les produits que nous fabriquons et participer uniquement aux marchés où nous pouvons apporter une contribution significative.

En combinant cette idée avec l'analyse de John Gruber, j'ai résumé cette idée en une seule phrase :

Apple devrait créer un appareil, un opérateur pour exécuter des produits/services/LLM d'IA, puis utiliser cet appareil/opérateur pour définir la manière dont les gens utilisent l'IA, plutôt que de laisser l'IA définir comment développer des produits.

Après la WWDC25, le monde extérieur pourrait adopter cette nouvelle perspective lorsqu’il observera et commentera le travail d’Apple en matière d’IA.

Mise à jour intelligente et micro d'Apple

Enfin, examinons d’autres nouvelles annonces d’IA de la WWDC25.

Traduction en temps réel

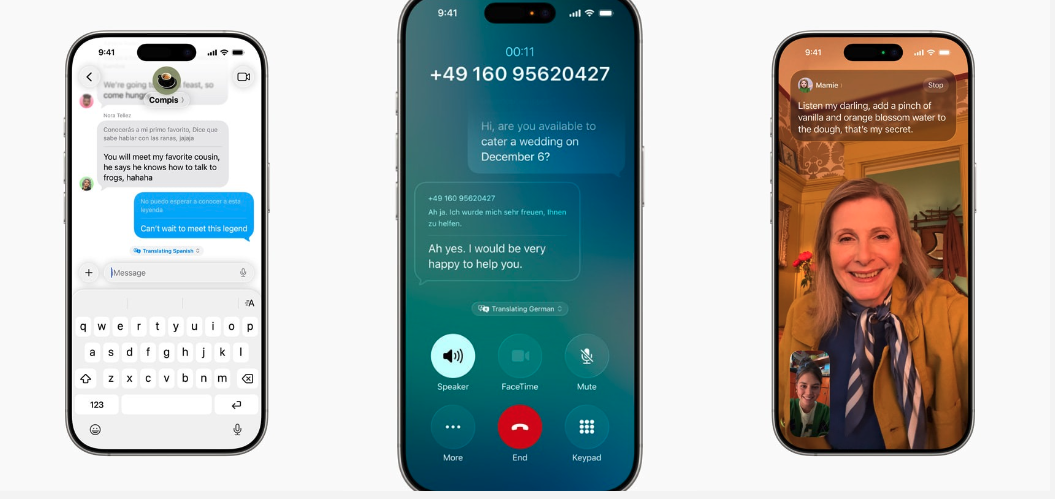

Apple a enfin intégré une fonction de traduction en temps réel dans iOS/iPadOS/macOS qui atteint le niveau de référence de l'industrie (il y a deux ou trois ans).

Actuellement, la traduction en temps réel prend en charge trois applications : Messages, Téléphone et FaceTime. Toutes les traductions peuvent être entièrement réalisées côté client.

- Lors de l'envoi d'un message, l'utilisateur peut le saisir dans sa propre langue, voir le texte traduit en langue étrangère en temps réel sur l'interface utilisateur, puis cliquer manuellement pour l'envoyer ; de même, le message envoyé par l'autre partie peut également être traduit automatiquement sur l'interface utilisateur locale de l'utilisateur.

- Au téléphone, le texte original est d’abord prononcé, puis les deux parties peuvent entendre le texte traduit.

- Dans FaceTime, une partie peut parler et l’autre partie peut voir les sous-titres traduits.

Genmoji et Image Playground

Genmoji : Les utilisateurs peuvent désormais utiliser les commandes de l'invite LLM pour générer des avatars Genmoji avec de nouveaux éléments. Par exemple, combiner un paresseux et une ampoule.

Dans Image Playground, les utilisateurs peuvent appeler le modèle multimodal de ChatGPT pour générer des photos de styles différents ou de styles aléatoires – vous pouvez considérer cela comme un shell officiel Apple OpenAI 4o.

Intelligence visuelle

Visual Intelligence prenait auparavant en charge la recherche de photos à partir d'un appareil photo, et lors de la WWDC de cette année, il a reçu une autre mise à jour surprenante : la prise en charge de la recherche de capture d'écran/interaction ultérieure.

Par exemple, vous pouvez rechercher directement des éléments dans la capture d'écran en appelant n'importe quelle application de l'App Store, ou lire la date, l'heure et le lieu dans la capture d'écran et l'ajouter à un élément de calendrier ou à un mémo.

(L’intelligence visuelle rattrape enfin ce que Google Image Search et Lens ont réalisé il y a 6 ou 7 ans.)

Mais la principale chose qui laisse sans voix est que la méthode d'interaction est trop démodée : des captures d'écran, au lieu d'être comme les téléphones Android du premier semestre 2025, qui peuvent lire et répondre directement au contenu sur l'écran de l'utilisateur sans prendre de captures d'écran, et même avoir des capacités d'agent qui peuvent contrôler directement l'écran au nom de l'utilisateur.

Bien sûr, je crois comprendre qu'Apple pourrait faire cela pour deux raisons : 1) ses capacités sont en effet inférieures à celles des fabricants Google/Android ; 2) en raison de problèmes de confidentialité, les utilisateurs sont obligés de prendre manuellement des captures d'écran et de cliquer sur le bouton de reconnaissance visuelle intelligente.

Raccourcis

Raccourcis est compatible avec les smartphones Apple. Les développeurs peuvent donc modifier et adapter leurs applications, permettant ainsi aux utilisateurs de générer rapidement des raccourcis. Je ne sais pas combien de personnes utilisent des raccourcis, mais il doit y en avoir des dizaines dans le monde.

#Bienvenue pour suivre le compte public officiel WeChat d'iFanr : iFanr (ID WeChat : ifanr), où du contenu plus passionnant vous sera présenté dès que possible.